ComfyUI 是一個基于節點流程式的stable diffusion AI 繪圖工具WebUI, 你可以把它想象成集成了stable diffusion功能的substance designer, 通過將stable diffusion的流程拆分成節點,實現了更加精準的工作流定制和完善的可復現性。但節點式的工作流也提高了一部分使用門檻。

同時,因為內部生成流程做了優化,生成圖片時的速度相較于webui又10%~25%的提升(根據不同顯卡提升幅度不同),生成大圖片的時候不會爆顯存,只是圖片太大時,會因為切塊運算的導致圖片碎裂。

下載安裝

https://github.com/comfyanonymous/ComfyUI![]() https://github.com/comfyanonymous/ComfyUI

https://github.com/comfyanonymous/ComfyUI

配置模型

將checkpoint模型放入ComfyUI\models\checkpoints目錄

ComfyUI與WebUI之間共享模型

在ComfyUI目錄中將extra_model_paths.yaml.example文件復制一份,重命名為將extra_model_paths.yaml

修改a111的base_path路徑為WebUI路徑

啟動

運行run_nvidia_gpu.bat啟動ComfyUI

更新

如果后面需要更新ComfyUI,可以直接使用update_comfyui.bat,就不需要重新下載和配置了

使用

鼠標右鍵呼出節點目錄,可以直接在目錄中選擇節點。

鼠標雙擊呼出節點搜索窗口,知道節點名稱的話,直接搜索比較快。

連接好節點網絡,通過點擊面板右側的工具欄中的 Queue Prompt,就能開始圖片生成了。

通過使用鼠標點擊拖動節點上的輸出輸入點,即可創建連線。

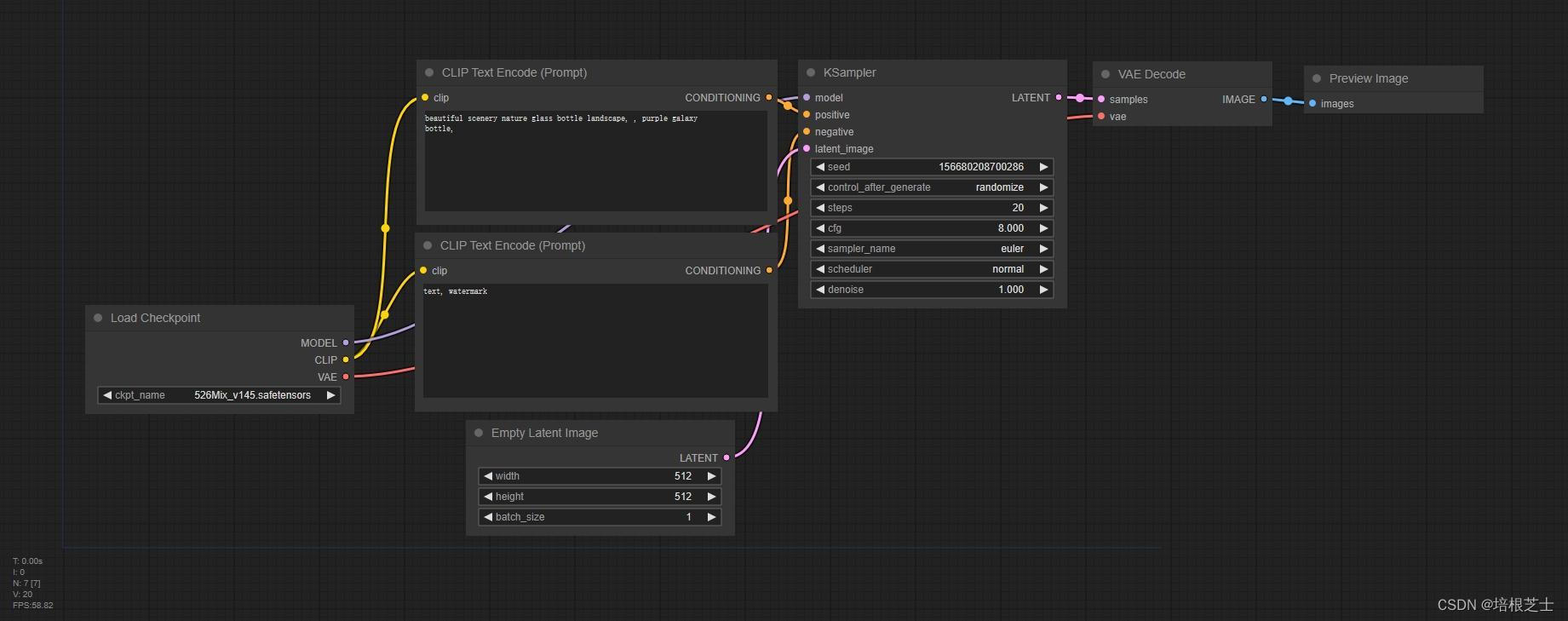

一般的的節點網絡包括:

- 輸入階段:模型輸入,圖片輸入等。負責載入模型和圖片。

- Clip階段:clip跳過,clip編碼器,lora,controlnet都在這個階段。

- Unet階段:ksampler節點,負責在潛空間生成圖片。參數和webui中的生成參數基本上相同。

- Vae解碼階段:將生成的圖片從潛空間轉換成RGB色彩空間。Vae解碼節點可以鏈接不同的VAE來得到不同的解碼結果。

- 保存和后處理階段:預覽,保存,后處理

?

)

)

:備忘錄接口)

:ListModelMixin可以使用的通用分頁器)