因果發現(Causal Discovery)是一個復雜的過程,其目標是從大量的數據中確定變量之間的因果關系。這個過程通常涉及到的是如何從紛繁復雜的數據中發現其中隱含的因果關系。有時,研究者可以通過隨機實驗進行干預來發現因果關系,但由于開銷、道德考慮等原因有時無法進行這樣的實驗,通常只有觀測數據,而缺乏干預數據。

因此,如何有效地進行因果發現,成為了一個非常具有挑戰性的問題。目前,有許多研究者正在努力開發新的方法。而在已有的方法中,也有許多成果很值得我們學習。

我這次就幫大家整理了31種使用觀測數據/觀測和干預數據混合進行結構發現的方法,主要分為2大類:基于組合/搜索的算法和基于連續優化的算法。篇幅原因只做簡單介紹,建議同學們收藏了仔細學習。

方法原文及源碼需要的同學看文末

基于組合/搜索的算法

1.Distinguishing cause from effect using quantiles: Bivariate quantile causal discovery

二元分位數因果發現

算法簡述:論文通過最小描述長度原則,將因果關系與分位數回歸聯系起來,開發了一種新方法,稱為二元分位數因果發現(bQCD),它假設沒有混淆、選擇偏見或反饋,并使用多個分位數水平來區分因果關系。這種方法不僅適應于加法,還適應于乘法或位置-尺度產生機制。在合成和真實數據集上的實證比較表明,bQCD在各種實現中表現出穩健性,計算效率高,優于現有方法。

2.Learning DAGs without imposing acyclicity

在不強加非周期性的情況下學習DAG

算法簡述:論文探討是否有可能在不顯式施加無環性約束的情況下從數據中學習一個有向無環圖(DAG)。 作者將結構性學習作為稀疏矩陣分解問題來解決,并通過經驗表明解決 ?1-penalized optimization 可以很好地恢復真實圖,而且通常可以恢復幾乎所有DAG圖。 此外,這種方法計算效率高,并且不會像經典結構性學習算法那樣受到組合復雜性爆炸的影響。

3.Learning directed graphical models from Gaussian data

從高斯數據中學習有向圖形模型

算法簡述:本文介紹了一種新的有向圖形模型——高斯圖形交互模型(GGIM),它基于圖上平穩高斯過程和拉普拉斯矩陣的方程。通過簡單理論,作者解釋了圖形模型中的邊代表的含義。當限制在無向圖上時,GGIM的拉普拉斯矩陣相當于標準逆協方差矩陣,表示條件依賴關系。作者還定義了平穩高斯過程中兩個元素之間的有向條件獨立性。學習稀疏GGIM的問題可以轉化為LASSO問題。

4.Chacterizing distribution equivalence and structure learning for cyclic and acyclic directed graphs

循環和非循環有向圖的分布等價性和結構學習的特征

算法簡述:這篇文章提出了一個通用、統一的等價性概念,用于線性高斯因果定向圖形模型。在這個概念中,兩個結構被視為等價,如果它們可以生成相同的數據分布。此外,作者還提出了一個較弱的等價性概念quasi-equivalence,它表示從觀察數據中可以識別的程度。文章還提出了分析和圖形方法來表征兩個結構的等價性,并提出了一個基于得分的從觀察數據中學習結構的方法,可以成功地處理不同類型的結構。

5.Causal structure learning from time series: large regression coefficients may predict causal links better in practice than small p-values

從時間序列中學習因果結構

算法簡述:論文考察了如何將現有思想結合起來,在具有現實世界地球科學數據常見挑戰的半現實和現實時間序列數據上取得具有競爭力的性能。作者還討論了a)利用線性方法識別非線性系統中因果聯系的原理,b)基于模擬的解釋,說明為什么大的回歸系數在實踐中可能比小的p值更好地預測因果聯系,以及為什么歸一化數據有時會妨礙因果結構學習。

-

6.Bayesian causal structure learning with zero-inflated Poisson Bayesian networks

-

7.Causal learning with sufficient statistics: an information bottleneck approach

-

8.Causal discovery from heterogeneous/nonstationary data with independent changes

-

9.Causal discovery from soft interventions with unknown targets: characterization and learning

-

10.A simultaneous discover-identify approach to causal inference in linear models

基于連續優化的算法

1.Disentangled generative causal representation learning

解耦生成式因果表征學習

算法簡述:本文提出了一種解耦生成式因果表示學習(DEAR)方法,用于處理潛在變量之間存在因果關系的情況。該方法使用結構因果模型作為雙向生成模型的先驗,并通過GAN損失和監督信息進行聯合訓練。實驗證明,DEAR方法在因果可控生成和下游任務中具有有效性和優勢。

2.Causal adversarial network for learning conditional and interventional distributions

用于學習條件分布和干預分布的因果對抗網絡

算法簡述:論文提出了一種新的因果對抗網絡(CAN),它可以從數據中學習因果關系,并根據條件或干預生成樣本。與現有的因果GAN不同,CAN不需要預先給出的因果圖。CAN包括兩個部分:標簽生成網絡(LGN)和條件圖像生成網絡(CIGN)。LGN學習并從標簽的因果模型中采樣,然后將這些標簽提供給CIGN,它學習標簽與像素之間的關系,并根據這些關系生成圖像。這個框架還具有一個干預機制,使模型能夠從干預分布中生成樣本。

3.DAGs with No Fears: A closer look at continuous optimization for learning Bayesian networks

深入了解貝葉斯網絡學習的連續優化

算法簡述:論文重新審視了一個名為NOTEARS的連續優化框架,用于學習貝葉斯網絡。文章首先將現有循環性的代數特征推廣到一類矩陣多項式,重點關注每條邊只有一個參數的情況,證明了NOTEARS公式中Karush-Kuhn-Tucker(KKT)最優條件無法滿足,除非在特殊情況下。然后為等價改寫的問題求得了KKT條件,并證明了它們確實是必要的,并將它們與圖中某些邊缺失的顯式約束聯系起來。如果得分函數是凸的,那么這些KKT條件對于局部最小性也是充分的,盡管約束是非凸的。在KKT條件的啟發下,作者提出了一種局部搜索后處理算法,并證明它通常可以將所有測試算法的結構Hamming距離提高2倍或更多。

4.On the role of sparsity and DAG constraints for learning linear DAGs

稀疏性和DAG約束對學習線性DAG的作用

算法簡述:論文研究了如何學習DAG(有向無環圖)的結構。由于DAG的搜索空間很大,這使得學習其結構非常具有挑戰性。以前的方法使用了最小二乘目標和DAG的代數特征,但需要硬性DAG約束,這可能會導致優化困難。作者提出了一種新的方法,它考慮了稀疏性和DAG約束在學習DAG模型中的作用。

在理論和實驗中,作者證明了軟稀疏性和DAG約束可以用來學習DAG,還提出了一種基于似然的評分函數,它不需要硬性DAG約束,可以更容易地解決優化問題。

5.Differentiable causal discovery under unmeasured confounding

可微分的未測量混雜因素下的因果發現

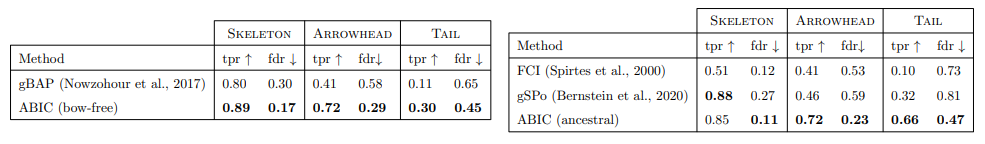

算法簡述:本文提出了一種基于不同微分代數約束的因果發現方法,用于處理混雜系統中由于未測量變量的存在而導致的數據混雜問題。該方法使用離散搜索過程選擇編碼觀察變量之間普通條件獨立約束的無環有向混合圖(ADMGs),特別是祖傳ADMGs。通過推導出完全表征祖傳ADMGs空間的不同微分代數約束,并將因果發現問題轉化為連續優化問題,設計了可微程序來尋找最佳擬合的ADMG。

-

6.DYNOTEARS: Structure learning from time-series data

-

7.Learning neural causal models from unknown interventions

-

8.A critical view of the structural causal model

-

9.Causal discovery with reinforcement learning

-

10.Amortized learning of neural causal representations

-

11.Amortized causal discovery: Learning to infer causal graphs from time-series data

-

12.Causal discovery in physical systems from videos

-

13.CASTLE: regularization via auxiliary causal graph discovery

-

14.Gradient-based neural DAG learning

-

15.Masked gradient-based causal structure learning

-

16.CausalVAE: disentangled representation learning via neural structural causal models

-

17.Causal autoregressive flows

-

18.Learning DAGs without imposing acyclicity

-

19.Learning sparse nonparametric DAGs

-

20.Causal discovery from incomplete data: a deep learning approach

-

21.Efficient and scalable structure learning for Bayesian networks: Algorithms and Applications

關注下方《學姐帶你玩AI》🚀🚀🚀

回復“因果發現”領取方法原文及源碼

碼字不易,歡迎大家點贊評論收藏!

+ BaseAdapter -簡單應用)

)

)

)

+BaseExpandableListAdapter-簡單應用)

![[個人筆記] Windows的IT運維筆記](http://pic.xiahunao.cn/[個人筆記] Windows的IT運維筆記)