?? 核心目標:找到最佳w和b!

上期咱們聊了神經網絡就是復雜的"線性變換+激活函數套娃",今天的重頭戲就是:怎么算出讓模型完美擬合數據的w(權重)和b(偏置)!先從最簡單的線性函數說起,一步步揭開神秘面紗

那么如何計算w和b呢?首先明確我們需要的w和b能夠讓函數的結果更接近真實數據。

?? 什么樣的參數才算"好"?

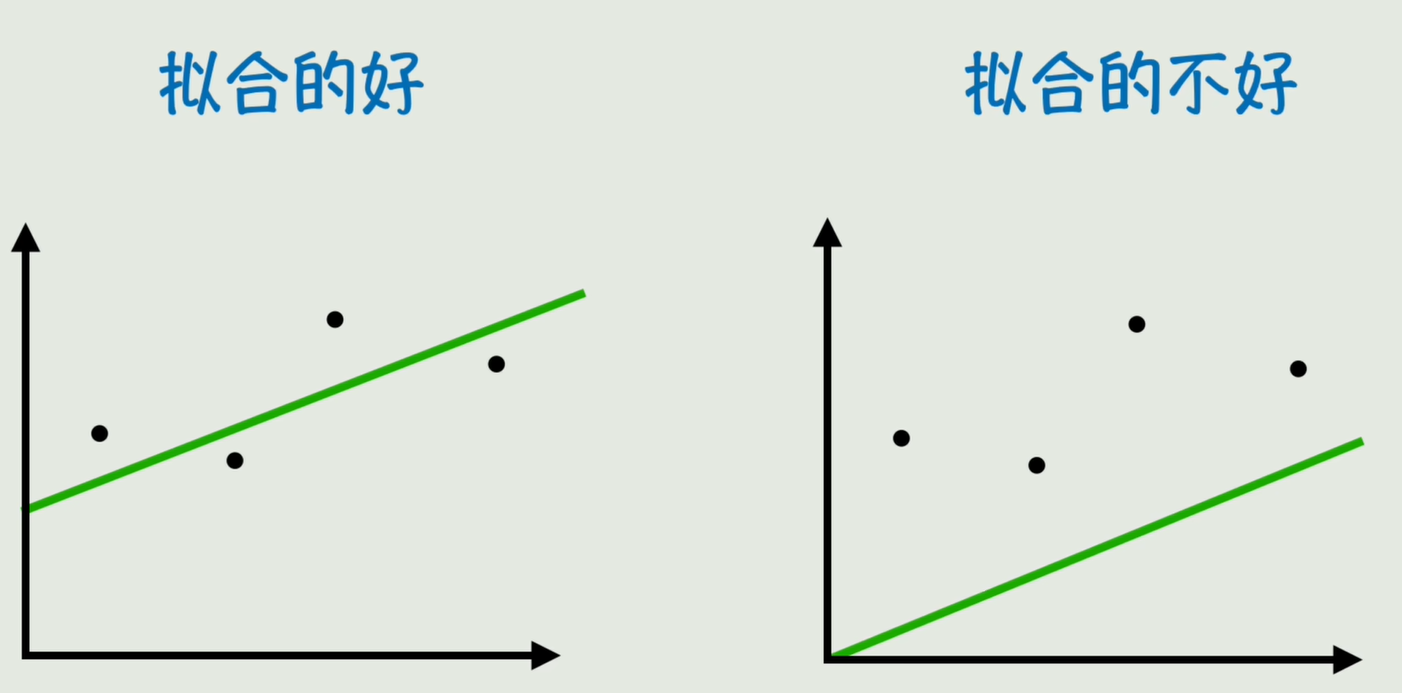

答案超簡單:預測值(yhat)越接近真實值(y)越好!就像畫一條直線穿過散點,直覺上"貼得越近"的線肯定擬合得更好嘛

對于以下數據,我們可以看出顯然第一個擬合的更好。

真實數據值為

與節流(Throttle))

:策略模式)

)

——前世今生)