目錄

前言

一、微調過程的目標:優化模型表現

二、微調需要多久?

微調時間無法確定

三、如何判斷微調何時收斂?

3.1?觀察Loss的下降趨勢

3.2?損失值趨于平穩,意味著收斂

如何識別收斂?

3.3?驗證Loss的波動:繼續訓練的權衡

四、是否可以繼續訓練?——延續訓練與效果權衡

4.1?繼續訓練的效益

4.2?早停(Early Stopping)

五、微調周期的實用建議

六、訓練示例圖

6.1?執行代碼

6.2 訓練效果?

總結:微調時間不是關鍵,收斂與效果更重要

前言

在大模型的應用中,微調(Fine-tuning)是一項至關重要的技術。通過微調,企業和研究者可以使通用大模型在特定任務上表現得更加出色。然而,很多人在進行模型微調時,都有一個常見的問題:“微調應該持續多久?”

答案并不是那么簡單,但本文將深入探討模型微調的時間、收斂狀態以及如何判斷何時終止訓練,幫助你更好地掌控微調過程。

▲一句話講明白:

模型微調時間因任務、數據、模型規模和硬件而異,通常通過監控損失函數loss趨平(如600輪次)判斷收斂,可根據場景需求選擇終止或基于檢查點繼續訓練。

一、微調過程的目標:優化模型表現

微調的目標是讓模型在特定任務上表現得更好。這個任務可能是情感分析、語音識別、文檔分類、或者任何其他行業特定任務。

在微調過程中,模型會基于一個預先訓練好的模型(如LLaMA、GPT等),使用新的數據集進行二次訓練。這個過程可以使模型從“通用能力”轉向“特定任務能力”,以便更加準確地理解特定領域的語言和任務。

二、微調需要多久?

微調時間無法確定

微調的時間并沒有固定標準,它取決于多個因素:

數據量的大小:大數據集需要更多的訓練時間。

模型的大小:更大的模型(如LLaMA 13B、GPT-3)訓練時間會更長。

硬件配置:訓練設備的性能(如GPU型號、數量、顯存等)直接影響訓練速度。

任務的復雜性:如果是高復雜度的任務,如深度推理或跨領域知識遷移,訓練可能需要更多時間。

因此,無法簡單地給出“微調多長時間才算完成”的答案。微調的時長需要根據實際情況進行調整和監控。

三、如何判斷微調何時收斂?

微調的核心在于優化損失函數(Loss),即通過最小化誤差來提升模型的準確性和表現。一個模型的損失函數值反映了其在特定任務上的表現。

3.1?觀察Loss的下降趨勢

在訓練過程中,模型的損失值(Loss)應該逐漸下降。通常情況下,Loss值的下降趨勢是判斷訓練是否有效的主要依據。

-

快速下降階段:剛開始的訓練階段,模型的Loss通常會快速下降,表示模型正在從數據中學習并改進。

-

趨于平穩階段:隨著訓練的深入,Loss值逐漸趨于平穩,說明模型在不斷改進,但提升空間越來越小。

3.2?損失值趨于平穩,意味著收斂

當Loss下降到一定程度后,通常會進入收斂狀態。這時,Loss下降的幅度變得非常小,甚至接近于平穩。這表明,模型已經學會了大部分任務內容,進一步訓練的效果非常有限。

如何識別收斂?

如果訓練曲線的Loss下降速度明顯變慢,并且開始趨于平穩,可以考慮終止訓練。

另外,**訓練過程中的驗證損失(Validation Loss)**也是一個重要參考指標。如果驗證Loss持續下降,說明模型在訓練集和驗證集上都能保持較好的表現。

參考圖:六、訓練示例圖

3.3?驗證Loss的波動:繼續訓練的權衡

有時在繼續訓練時,驗證集上的損失會出現短暫上升,然后再次下降。這是因為訓練過程中,模型可能會在某些數據點上進行過擬合(overfitting)或欠擬合(underfitting)。這時候,繼續訓練可能會提高模型的魯棒性和穩定性。

注意:如果驗證Loss不斷上升,訓練時就應考慮停止。這通常表示模型在訓練集上過擬合了,失去了泛化能力。

四、是否可以繼續訓練?——延續訓練與效果權衡

4.1?繼續訓練的效益

微調過程中,模型可能在一段時間內進入“趨于平穩”階段,此時,繼續訓練仍然可以緩慢下降Loss,但效果逐漸變得微弱。一般來說:

-

繼續訓練可能帶來極小的性能提升,特別是在任務較為簡單或訓練數據質量較高時。

-

逐步學習(Incremental Learning):如果在微調過程中,某些特定領域的樣本訓練效果不佳,繼續訓練會幫助模型逐步學會特定領域的語言。

但這個效益是逐步遞減的,過度訓練可能會導致過擬合,甚至使模型性能下降。

4.2?早停(Early Stopping)

為了避免過度訓練,很多微調任務采用早停法。早停法會在驗證損失開始上升時自動停止訓練,從而避免無效的訓練并節省時間。

**Tip:**如果你使用的是LLaMAFactory或其他微調框架,可以設置早停條件。通過監控驗證集的損失和性能來控制訓練時長。

五、微調周期的實用建議

根據訓練時的觀察和經驗,以下是一些常見的微調訓練時長的參考值:

-

小型模型(如7B參數):訓練時間通常為幾小時到幾天,具體取決于數據量和硬件條件。

-

中型模型(如13B、30B參數):訓練可能需要數天到數周,特別是在數據量較大的情況下。

-

大型模型(如70B+參數):訓練時間通常為數周甚至更長,尤其是如果硬件資源有限時。

**Tip:**可以使用分布式訓練、混合精度訓練等技術來加速微調過程。?

六、訓練示例圖

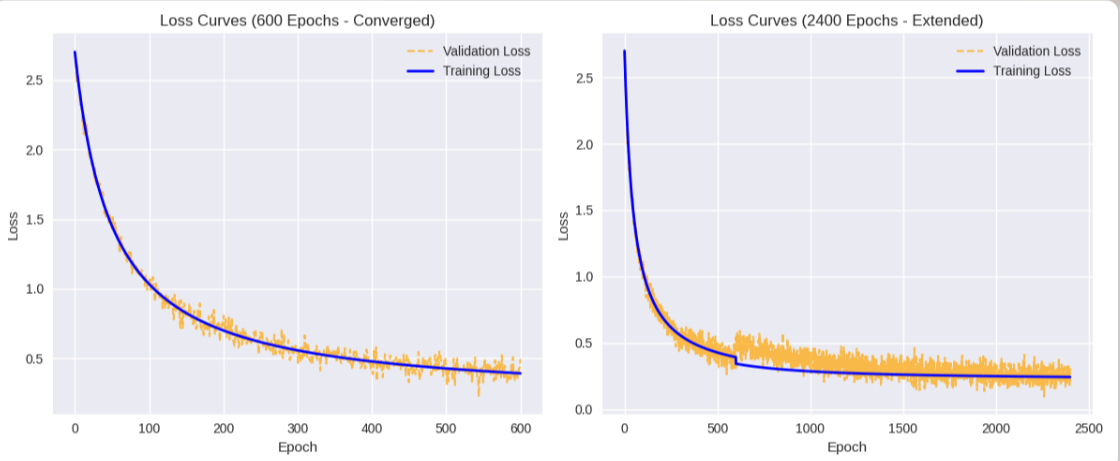

以下通過代碼的顯示來呈現一個訓練600輪次和2400輪次loss的變化。600輪次時loss的下降趨勢逐漸趨于平緩,也就意味著收斂,訓練可以終止。如果是面對需要與訓練數據的回復標簽非常接近的情況,那可以適當考慮再繼續往下訓練,隨著訓練輪次的疊加,模型的回復效果會逐漸趨近于訓練數據的回復標簽,到這里一定得注意一個問題,如果模型回復的東西與訓練數據的回復標簽100%接近,那就不能叫做人工智能了,而是檢索器。

小結:在訓練的過程中,訓練的輪次一定得適當,主要把握的點就是看loss的變化趨勢,loss的下降趨勢基本處于平緩的狀態,就可以考慮終止訓練。如果面對回復標準比較嚴謹的場景(如:法律,醫療)就可以考慮在此基礎上繼續訓練一段時間,訓練時間越長,越接近于訓練標簽,但需要適當控制,避免過擬合。

6.1?執行代碼

import numpy as np

import matplotlib.pyplot as plt# Function to simulate loss curves

def generate_loss_data(epochs, converged=True):# Simulate training loss: rapid initial drop, then slow declinex = np.linspace(0, epochs, epochs)train_loss = 2.5 / (1 + x / 50) + 0.2 # Asymptotic decay to ~0.2val_loss = train_loss + np.random.normal(0, 0.05, epochs) # Validation loss with noiseif not converged:# For 2400 epochs, add slight validation loss increase after convergenceval_loss[600:] += 0.1 * np.exp(-(x[600:] - 600) / 500) # Temporary rise then declinetrain_loss[600:] -= 0.05 * np.exp(-(x[600:] - 600) / 1000) # Slower declinereturn x, train_loss, val_loss# Generate data for 600 epochs (converged)

epochs_600 = 600

x_600, train_loss_600, val_loss_600 = generate_loss_data(epochs_600, converged=True)# Generate data for 2400 epochs (extended training)

epochs_2400 = 2400

x_2400, train_loss_2400, val_loss_2400 = generate_loss_data(epochs_2400, converged=False)# Plotting

plt.figure(figsize=(12, 5))# Plot for 600 epochs

plt.subplot(1, 2, 1)

plt.plot(x_600, val_loss_600, label='Validation Loss', color='orange', linestyle='--', alpha=0.7, linewidth=1.5)

plt.plot(x_600, train_loss_600, label='Training Loss', color='blue', linestyle='-', linewidth=2, zorder=10)

plt.title('Loss Curves (600 Epochs - Converged)')

plt.xlabel('Epoch')

plt.ylabel('Loss')

plt.legend()

plt.grid(True)# Plot for 2400 epochs

plt.subplot(1, 2, 2)

plt.plot(x_2400, val_loss_2400, label='Validation Loss', color='orange', linestyle='--', alpha=0.7, linewidth=1.5)

plt.plot(x_2400, train_loss_2400, label='Training Loss', color='blue', linestyle='-', linewidth=2, zorder=10)

plt.title('Loss Curves (2400 Epochs - Extended)')

plt.xlabel('Epoch')

plt.ylabel('Loss')

plt.legend()

plt.grid(True)plt.tight_layout()

plt.savefig('loss_curves_fixed.png')

plt.show()6.2 訓練效果?

?該示意圖展示LLaMA-Factory微調中訓練損失(藍色實線)和驗證損失(橙色虛線)的趨勢,分600輪次(已收斂)和2400輪次(延長訓練)兩子圖:

- 600輪次(左圖):損失從2.5快速下降,約400輪次后趨平(約0.2),表明模型收斂,適合終止訓練。

- 2400輪次(右圖):前600輪次類似,后訓練損失緩慢下降(至0.15),驗證損失在600-1000輪次短暫上升(模擬過擬合),后穩定(約0.2)。

總結:微調時間不是關鍵,收斂與效果更重要

總結來說,微調的持續時間并沒有固定答案,關鍵在于以下幾個方面:

-

Loss的下降趨勢:通過觀察Loss的變化,你可以判斷模型是否已經收斂。

-

訓練與驗證的權衡:要注意驗證集上的Loss變化,避免過擬合。

-

繼續訓練的收益遞減:繼續訓練雖可能帶來微小改進,但訓練時間過長可能導致無效訓練。

最重要的是,根據實際應用的效果來決定微調的持續時間和停止點。對于企業來說,最核心的目標是通過微調讓模型在特定任務中具備更強的處理能力,而不是單純追求更低的損失值。

)

![[數據結構]#7 哈希表](http://pic.xiahunao.cn/[數據結構]#7 哈希表)

)