目錄

第一部分:思想與基石——萬法歸宗,筑基問道

第1章:初探智慧之境——機器學習世界觀

- 1.1 何為學習?從人類學習到機器智能

- 1.2 機器學習的“前世今生”:一部思想與技術的演進史

- 1.3 為何是Python?——數據科學的“通用語”

- 1.4 破除迷思:AI是“神”還是“器”?

第2章:工欲善其事——Python環境與核心工具鏈

- 2.1 “乾坤在握”:Anaconda與Jupyter Notebook的安裝與配置

- 2.2 “數據之舟”:NumPy數值計算基礎

- 2.3 “數據之魂”:Pandas數據分析利器

- 2.4 “眼見為實”:Matplotlib與Seaborn數據可視化

第3章:數據的心法——預處理與特征工程

- 3.1 “相數據”:理解你的數據

- 3.2 “凈數據”:數據清洗的修行

- 3.3 “點石成金”:特征工程的科學與藝術

第4章:模型的羅盤——評估與選擇

- 4.1 “度量衡”:分類、回歸與聚類模型的評估指標

- 4.2 “執其兩端而用中”:偏差與方差的權衡

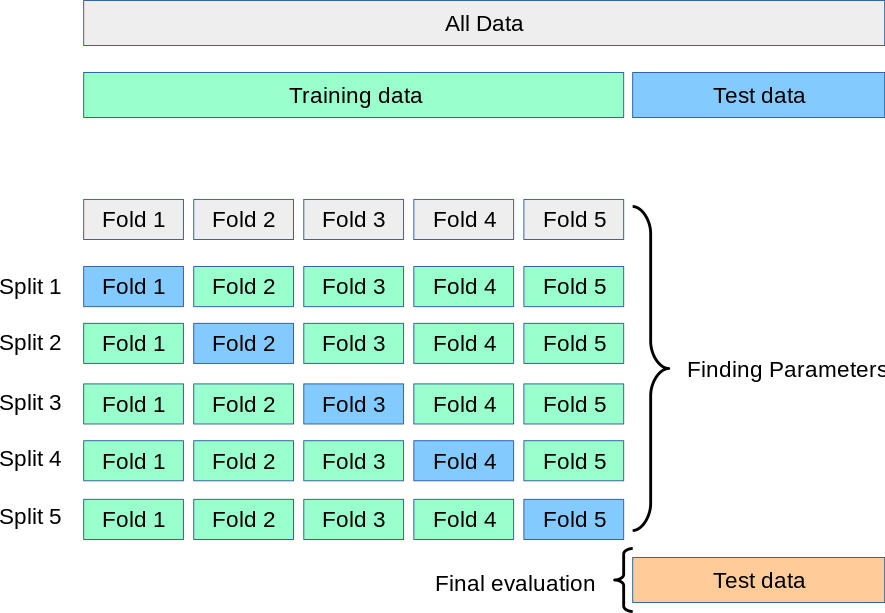

- 4.3 “他山之石”:交叉驗證的智慧

- 4.4 “尋路”:網格搜索與超參數調優

第二部分:術法萬千——主流機器學習模型詳解

第5章:監督學習之“判別”——分類算法

- 5.1 邏輯回歸:看似回歸,實為分類的智慧

- 5.2 K-近鄰(KNN):“物以類聚,人以群分”的樸素哲學

- 5.3 支撐向量機(SVM):“一劃開天”的數學之美

- 5.4 決策樹與隨機森林:“集思廣益”的集成智慧

- 5.5 樸素貝葉斯:“執果索因”的概率思維

第6章:監督學習之“預測”——回歸算法

- 6.1 線性回歸:從簡單到多元,探尋變量間的線性關系

- 6.2 嶺回歸與Lasso回歸:正則化下的“中庸之道”

- 6.3 多項式回歸:用曲線擬合復雜世界

- 6.4 回歸樹與集成回歸模型(例如 GBDT, XGBoost)

第7章:無監督學習之“歸納”——聚類與降維

- 7.1 K-均值聚類(K-Means):尋找數據中的“引力中心”

- 7.2 層次聚類:構建數據的“家族譜系”

- 7.3 DBSCAN:基于密度的“社區發現”

- 7.4 主成分分析(PCA):在紛繁中見本質的降維之道

第8章:集成學習——從“三個臭皮匠”到“諸葛亮”

- 8.1 Bagging思想:隨機森林的再思考

- 8.2 Boosting思想:從AdaBoost到梯度提升樹(GBDT)

- 8.3 Stacking/Blending:模型的“圓桌會議”

- 8.4 XGBoost與LightGBM:工業界的“大殺器”詳解

第9章:神經網絡入門——通往深度學習的橋梁

- 9.1 從生物神經元到感知機模型

- 9.2 多層感知機(MLP)與反向傳播算法

- 9.3 激活函數:為神經網絡注入“靈魂”

- 9.4 使用Scikit-Learn與Keras/TensorFlow構建你的第一個神經網絡

第三部分:登堂入室——高級專題與實戰演練

第10章:實戰項目一:金融風控——信用卡欺詐檢測

- 10.1 問題定義與數據探索:理解不平衡數據

- 10.2 特征工程與采樣技術(SMOTE)

- 10.3 模型選擇、訓練與評估

- 10.4 解釋性分析:模型為何做出這樣的決策? (SHAP/LIME)

第11章:實戰項目二:自然語言處理——文本情感分析

- 11.1 文本數據的預處理:分詞、停用詞與向量化(TF-IDF, Word2Vec)

- 11.2 從傳統模型到簡單神經網絡的情感分類

- 11.3 主題模型(LDA):挖掘文本背后的隱藏主題

第12章:模型部署與工程化——讓模型“活”起來

- 12.1 模型持久化:序列化與保存

- 12.2 使用Flask/FastAPI構建API服務

- 12.3 Docker容器化:為模型打造一個“家”

- 12.4 MLOps初探:自動化、監控與再訓練

第13章:超越經典——未來展望與進階路徑

- 13.1 深度學習概覽:CNN、RNN的世界

- 13.2 強化學習:與環境交互的智能體

- 13.3 圖神經網絡、聯邦學習等前沿簡介

- 13.4 “知行合一”:如何持續學習與成長

附錄

- A. 數學基礎回顧(線性代數、微積分、概率論核心概念)

- B. 常用工具與庫速查手冊

- C. 術語表(中英對照)

- D. 推薦閱讀與資源列表

第一部分:思想與基石——萬法歸宗,筑基問道

核心目標: 建立學習者的宏觀認知,不僅知其然,更要知其所以然。將機器學習置于科學、哲學乃至東方智慧的廣闊背景下,培養學習者的“數據直覺”與“模型思維”。

第一章:初探智慧之境——機器學習世界觀

- 1.1 何為學習?從人類學習到機器智能

- 1.2 機器學習的“前世今生”:一部思想與技術的演進史

- 1.3 為何是Python?——數據科學的“通用語”

- 1.4 破除迷思:AI是“神”還是“器”?

歡迎您,未來的數據探索者。在您正式踏入這個由數據、算法與代碼構成的迷人世界之前,我們希望與您一同稍作停留,登高望遠。本章并非一本技術手冊的常規開篇,它不急于展示紛繁的代碼或深奧的公式。相反,它是一張地圖,一幅星圖,旨在為您建立一個宏大的時空坐標,讓您清晰地看到“機器學習”這片新大陸在人類智慧版圖中的位置。

我們將從最本源的問題開始:何為“學習”?我們將借助嬰兒認知世界的過程,以及自然界演化的宏偉篇章,來類比機器學習的三種基本范式。隨后,我們將穿越時空,回顧這段波瀾壯闊的技術思想史,從圖靈的深邃構想,到今日深度學習的璀璨成就,并向那些推動時代前行的巨匠們致敬。我們還將探討為何Python能夠成為這門“新學問”的通用語言,并深入其設計哲學與強大的生態系統。

最后,也是至關重要的一點,我們將共同思辨:人工智能究竟是無所不能的“神”,還是我們手中強大的“器”?我們將直面其能力邊界與深刻的倫理挑戰,并提出一種“以出世之心,做入世之事”的從業心法。

這不僅是知識的鋪陳,更是一場思想的洗禮。當您建立起這樣的世界觀后,未來學習道路上的每一個技術細節,都將不再是孤立的碎片,而是這幅宏大畫卷中和諧的一部分。

現在,讓我們一同啟程!

1.1 何為學習?從人類學習到機器智能

“學習”一詞,于我們而言再熟悉不過。從呱呱墜地到白發蒼蒼,我們的一生便是學習的一生。我們學習語言、學習騎車、學習一門手藝、學習與人相處。但我們是否曾靜心深思,這個過程的本質是什么?

從信息論的角度看,學習是一個系統(如人類大腦)通過與環境的交互,獲取信息并優化自身內部模型,以期在未來更好地完成特定任務或適應環境的過程。 這個定義中包含幾個關鍵要素:系統、環境、交互、信息、模型優化、未來任務。這恰恰構成了機器學習的核心框架。機器,作為我們創造的“系統”,通過我們提供的“數據”(源于環境的信息),進行“訓練”(交互與模型優化),最終目的是為了在新的、未見過的數據上做出精準的“預測”或“決策”(完成未來任務)。

因此,理解機器學習的最佳途徑,便是回溯我們自身最熟悉、最本源的學習過程。

1.1.1 嬰兒如何認識世界?——類比監督、無監督、強化學習

想象一個嬰兒,她/他認識世界的過程,正是機器學習三大范式最生動、最本源的體現。

1. 監督學習(Supervised Learning):有“標簽”的教導

當父母指著一個紅色的、圓圓的物體,對嬰兒說:“寶寶,這是‘蘋果’。”然后又指著一個黃色的、彎彎的物體說:“這是‘香蕉’。”這個過程在不斷重復。每一次,嬰兒都接收到兩樣東西:一個感官輸入(物體的形狀、顏色、氣味)和一個明確的標簽(它的名字叫“蘋果”)。

- 感官輸入,在機器學習中被稱為“特征(Features)”。

- 明確的標簽,被稱為“標簽(Label)”或“目標(Target)”。

嬰兒的大腦在做什么?它在努力尋找“特征”與“標簽”之間的關聯。它會逐漸歸納出:“哦,紅色的、圓形的、有特定香味的,很可能就是‘蘋果’。”當父母下次拿出一個新的、她從未見過的蘋果時,她能夠根據已經建立的內部模型,正確地識別出:“蘋果!”

這就是監督學習的本質。我們為機器提供一大批已經“標注好”的數據(例如,一堆郵件,每封都標好了“是垃圾郵件”或“不是垃圾郵件”;一堆房產數據,每套都標好了“最終成交價格”),然后讓算法去尋找特征和標簽之間的映射關系。算法學成之后,我們給它一封新的郵件,它就能判斷是否為垃圾郵件;給它一套新的房產特征,它就能預測其可能的價格。

監督學習的核心在于“有答案的輸入”。 它主要解決兩類問題:

- 分類(Classification):預測一個離散的標簽。例如,判斷圖片是貓還是狗,判斷郵件是否為垃圾郵件。嬰兒認識水果,就是一個分類任務。

- 回歸(Regression):預測一個連續的數值。例如,預測明天的氣溫,預測房屋的價格。

2. 無監督學習(Unsupervised Learning):無言的探索

現在,想象一下,沒有人明確告訴嬰兒每樣東西的名字。桌上放著一堆玩具:一些是積木(方的、硬的、彩色的),一些是毛絨娃娃(軟的、形狀不規則的),還有一些是塑料小球(圓的、光滑的)。

嬰兒會做什么?她會自己去探索。她會發現,這些東西可以分成幾堆。她可能會把所有硬邦邦、有棱有角的東西放在一起,把所有軟綿綿的東西放在另一邊,把所有能滾來滾去的東西歸為一類。她并不知道這些類別叫“積木”、“娃娃”或“球”,但她通過觀察物體自身的特性,自發地完成了“聚類(Clustering)”。

這就是無監督學習的精髓。我們只給機器一堆數據,沒有任何標簽,然后讓算法自己去發現數據中隱藏的結構、模式或關系。

無監督學習的核心在于“發現內在結構”。 它的典型應用包括:

- 聚類(Clustering):將相似的數據點分組。例如,根據用戶的購買行為,將他們劃分為不同的客戶群體,以便進行精準營銷。

- 降維(Dimensionality Reduction):在保留大部分信息的前提下,減少數據的特征數量。好比我們描述一個人,與其羅列上百個細節,不如抓住“高、瘦、戴眼鏡”這幾個核心特征,這便是降維的思想。

- 關聯規則挖掘(Association Rule Mining):發現數據項之間的有趣關系。經典的“啤酒與尿布”的故事,就是通過挖掘購物籃數據發現,購買尿布的顧客很可能同時購買啤酒。

3. 強化學習(Reinforcement Learning):試錯與獎懲

再來看嬰兒學習走路的過程。這個過程沒有人能給她一個明確的“標簽”。沒有一個“正確”的姿勢可以一步到位地教會她。

她只能自己嘗試。她試著晃晃悠悠地站起來,邁出一步,然后“啪”地摔倒了。這次嘗試的結果是“摔倒”,這是一個負向的反饋(懲罰)。她的大腦接收到這個信號:“剛才那樣做,結果不好。” 于是,她下次會微調自己的策略,可能身體更前傾一點,或者腿邁得小一點。某一次,她成功地走了兩步而沒有摔倒,內心充滿了喜悅和成就感。這是一個正向的反饋(獎勵)。她的大腦會記住:“這樣做,結果是好的!”

通過無數次的“嘗試-反饋-調整策略”循環,她最終學會了如何平穩地行走。在這個過程中,她不是被動地接收知識,而是作為一個意識體/智能體,在與環境的互動中,通過試錯,來學習一套能讓自己獲得最大累積獎勵的策略。

這就是強化學習。它與監督學習的關鍵區別在于,反饋信號不是一個正確的“標簽”,而是一個評價性的“獎勵”或“懲罰”信號,并且這個信號往往是延遲的(摔倒是邁出那一步之后的結果)。

強化學習的核心在于“通過與環境交互學習最優策略”。 它的應用場景極具魅力:

- 游戲AI:AlphaGo擊敗人類頂尖棋手,其核心就是強化學習。它通過自我對弈,不斷探索能贏得棋局的策略。

- 機器人控制:控制機械臂抓取物體,讓無人機自主飛行。

- 資源調度:優化數據中心的能源消耗,智能調度城市交通信號燈。

小結:三種學習范式的關系

學習范式 | 數據形式 | 學習目標 | 核心思想 | 人類類比 |

|---|---|---|---|---|

監督學習 | (特征, 標簽) | 學習從特征到標簽的映射 | 有師指導,模仿范例 | 父母教嬰兒識物 |

無監督學習 | 只有特征 | 發現數據內在的結構與模式 | 無師自通,歸納總結 | 嬰兒自己給玩具分類 |

強化學習 | (狀態, 動作, 獎勵) | 學習在環境中最大化獎勵的策略 | 實踐出真知,趨利避害 | 嬰兒學走路 |

這三種范式并非涇渭分明,現實世界的問題往往需要融合多種思想。例如,半監督學習(Semi-supervised Learning)就結合了監督和無監督學習,利用少量有標簽數據和大量無標簽數據進行學習。但理解這三大支柱,是理解整個機器學習大廈的基石。

1.1.2 道法自然:從自然界的演化看學習的本質

如果說嬰兒學步是“個體學習”的縮影,那么地球生命長達數十億年的演化史,則是“群體學習”最宏偉、最深刻的篇章。《道德經》有云:“人法地,地法天,天法道,道法自然。” 機器學習的許多深刻思想,尤其是那些被稱為“遺傳算法”、“進化策略”的分支,其靈感正是源于對自然演化這一“終極學習過程”的模擬。

1. 適應度函數(Fitness Function):環境的選擇壓力

在自然界,不存在一個絕對的“最優”生物。在冰河世紀,長毛象的厚皮毛是巨大的生存優勢;而當氣候變暖,這身皮毛反而成了累贅。環境,就是那個最終的“裁判”,它通過生存和繁衍的壓力,來“評估”每一個生物體對其的適應程度。這種適應程度,在進化計算中被稱為適應度(Fitness)。一個物種能否將基因傳遞下去,取決于其適應度的高低。

這與機器學習中的損失函數(Loss Function)或目標函數(Objective Function)異曲同工。我們定義一個函數來評估我們的模型“好不好”。例如,在預測房價時,損失函數可能就是“預測價與真實價的差距”,差距越小,模型的“適應度”就越高。整個模型訓練的過程,就是不斷調整參數,以期在損失函數上取得最優值的過程,正如生物演化是在環境的適應度函數下,不斷“優化”自身基因的過程。

2. 遺傳與變異(Inheritance and Mutation):探索與利用的平衡

演化有兩個核心驅動力:

遺傳(Inheritance):父母的優秀性狀(高適應度的基因)通過繁殖傳遞給后代。這保證了已經獲得的成功經驗不會輕易丟失。在機器學習中,這類似于一種“利用(Exploitation)”策略——我們傾向于在當前已知效果好的模型參數附近進行微調,希望能獲得更好的結果。

變異(Mutation):基因在復制過程中會發生隨機的、微小的錯誤,即基因突變。絕大多數突變是有害或無意義的,但極少數突變可能會帶來意想不到的生存優勢(例如,某種蛾子產生了更接近樹皮的保護色)。這種不確定性,為物種提供了跳出局部最優、適應全新環境的可能性。這正是一種“探索(Exploration)”策略。

機器學習算法,尤其是強化學習和優化算法,也必須精妙地平衡“利用”與“探索”。如果一個算法只懂得“利用”,它可能會很快陷入一個“局部最優解”(比如一個只會在家附近找食物的原始人,他可能永遠發現不了遠處食物更豐富的山谷)。如果一個算法只懂得“探索”,它將永遠在隨機嘗試,無法收斂到一個有效的解決方案。遺傳算法通過模擬交叉、變異等操作,在解空間中進行高效的探索和利用,尋找問題的最優解。

3. 物競天擇(Natural Selection):迭代優化的過程

“物競天擇,適者生存。”這八個字精準地描述了演化的核心機制。每一代生物中,適應環境的個體有更大的概率存活下來并繁殖后代,不適應的個體則被淘汰。經過一代又一代的篩選,整個種群的基因庫會朝著越來越適應環境的方向“進化”。

這不就是機器學習中迭代優化(Iterative Optimization)的過程嗎?以梯度下降算法為例,我們從一組隨機的初始參數開始,計算當前參數下的“損失”(不適應度),然后沿著能讓損失下降最快的方向(梯度方向)微調參數。然后,在新的參數位置上,重復這個過程。一步一步,一次一次迭代,模型參數就像生物種群的基因一樣,被不斷“選擇”和“優化”,最終達到一個損失極小(適應度極高)的狀態。

因此,當我們思考機器學習時,不妨將視野拉遠。我們所做的,無非是借鑒了宇宙間最古老、最強大的學習法則——演化。我們創造的算法,是我們對“道法自然”的一次次笨拙而又充滿敬意的模仿。理解了這一點,我們便能以更謙卑、更宏大的視角,看待我們即將學習的每一個模型和技術。

1.2 機器學習的“前世今生”:一部思想與技術的演進史

任何一門學科的誕生,都不是一蹴而就的,它必然是思想的河流長期沖刷、積淀的結果。機器學習的發展史,更是一部交織著數學、計算機科學、神經科學、哲學乃至運籌學等多個領域的英雄史詩。了解這段歷史,能讓我們明白今日的技術從何而來,為何如此,以及未來可能走向何方。

1.2.1 從圖靈的構想到今天的深度學習:關鍵里程碑

這段歷史猶如一條奔騰的河流,有涓涓細流的源頭,有波瀾壯闊的轉折,也有過冰封潛行的低谷。

源頭與古典時期(20世紀40-60年代):思想的播種

1943年,麥卡洛克-皮茨神經元(MCP Neuron):神經生理學家沃倫·麥卡洛克和邏輯學家沃爾特·皮茨,首次提出了一個形式化的神經元數學模型。它接收多個二進制輸入,通過一個閾值函數,產生一個二進制輸出。這雖然是一個極其簡化的模型,但它第一次從計算的角度,建立了連接生物大腦與機器智能的橋梁。它是神經網絡大廈的第一塊磚。

1950年,圖靈測試與《計算機器與智能》:艾倫·圖靈,這位計算機科學的奠基人,在他劃時代的論文中,沒有直接定義“機器能否思考”,而是提出了一個可操作的測試——“模仿游戲”,即后人所稱的“圖靈測試”。他將焦點從哲學的思辨轉向了行為的判斷,并預言了“學習機器”的可能性。這篇文章,是人工智能領域的思想“開山之作”。

1952年,亞瑟·薩繆爾的跳棋程序:IBM的工程師亞瑟·薩繆爾編寫了一個可以學習下西洋跳棋的程序。這個程序可以通過自我對弈來提升棋力,其水平最終甚至超過了薩繆爾本人。這是機器學習的第一個廣為人知的成功案例,它生動地展示了“讓計算機自己學習”是可行的。薩繆爾也是第一個提出并普及“Machine Learning”這個詞的人。

1957年,感知機(Perceptron):弗蘭克·羅森布拉特基于MCP模型,提出了“感知機”。與MCP不同,感知機模型的權重參數是可以通過學習算法自動調整的。他甚至制造了硬件“Mark I Perceptron”,用于圖像識別。這引發了第一次AI熱潮,人們對“會思考的機器”充滿了樂觀的幻想。

第一次AI寒冬(20世紀70-80年代):理性的沉淀

1969年,《感知機》一書的沖擊:AI領域的兩位領軍人物馬文·明斯基和西摩爾·派普特,出版了《感知機》一書。書中通過嚴謹的數學證明,指出了單層感知機無法解決“異或(XOR)”這類線性不可分問題。這一結論雖然是針對單層結構的,但在當時被許多人誤讀為整個神經網絡方法的根本性缺陷。這本著作如一盆冷水,澆滅了當時過于狂熱的期望,直接導致了神經網絡研究的資金被大量削減,AI進入了第一個“冬天”。

寒冬中的火種:盡管神經網絡研究進入低谷,但其他機器學習流派仍在悄然發展。決策樹算法(如ID3)、專家系統等符號主義AI方法在這一時期取得了重要進展。寒冬并未熄滅所有火種,反而促使研究者們進行更深刻的理性和基礎性思考。

復興與連接主義的回歸(20世紀80年代末-90年代):柳暗花明

1986年,反向傳播算法(Backpropagation)的重新發現:雖然反向傳播的思想早已存在,但由戴維·魯姆哈特、杰弗里·辛頓和羅納德·威廉姆斯等人的工作,使其得到了廣泛傳播和應用。該算法有效地解決了多層神經網絡的權重訓練問題,攻克了《感知機》一書中提出的核心難題,讓神經網絡研究重獲新生。

20世紀90年代,統計學習的崛起:在神經網絡復興的同時,另一股強大的力量正在形成。以弗拉基米爾·瓦普尼克等人提出的支撐向量機(SVM)為代表的,基于嚴格統計學習理論(VC維理論)的方法論開始大放異彩。SVM以其優美的數學理論、出色的泛化能力和高效的凸優化求解,在許多中小型數據集的分類和回歸任務上,其表現常常優于當時的神經網絡。同時期,決策樹的集成方法,如隨機森林(Random Forest)和梯度提升機(Gradient Boosting Machine)也開始嶄露頭角。這個時代,是“統計機器學習”的黃金時代,各種精巧的淺層模型百花齊放。

第二次AI寒冬(2000年前后):瓶頸與醞釀

進入21世紀初,盡管機器學習在特定領域應用廣泛,但其發展似乎又遇到了瓶頸。當時的神經網絡雖然理論上可以很深,但實際訓練中面臨著梯度消失/爆炸等問題,導致深層網絡的訓練極為困難。而SVM等模型雖然理論優美,但在處理如圖像、語音這類擁有海量、高維原始特征的任務時,顯得力不從心。整個領域似乎在等待一次新的突破。

深度學習革命(2006年至今):王者歸來

2006年,深度信念網絡與逐層預訓練:杰弗里·辛頓等人提出了“深度信念網絡(DBN)”,并開創性地使用了“無監督逐層預訓練+有監督微調”的方法。這種方法像搭積木一樣,先讓網絡的每一層自己進行無監督學習,理解數據的基本特征,然后再用有標簽的數據對整個網絡進行精調。這巧妙地緩解了深度網絡訓練的困難,為“深度學習”一詞的誕生拉開了序幕。

2012年,AlexNet在ImageNet競賽中取得歷史性突破:由辛頓的學生亞歷克斯·克里熱夫斯基設計的深度卷積神經網絡AlexNet,在當年的ImageNet大規模視覺識別挑戰賽(ILSVRC)中,以遠超第二名(基于傳統方法)的驚人準確率奪冠。這一事件的沖擊力,不亞于深藍計算機戰勝卡斯帕羅夫。它無可辯駁地證明了,在處理復雜模式識別任務時,深度學習(特別是卷積神經網絡CNN)的強大威力。這一勝利,點燃了延續至今的深度學習革命之火。

至今:黃金時代:自2012年以來,我們見證了技術的爆炸式發展。從用于序列數據的循環神經網絡(RNN)及其變體LSTM,到解決其長程依賴問題的Transformer架構;從生成以假亂真圖像的生成對抗網絡(GAN),到驅動AlphaGo和ChatGPT的深度強化學習與大規模預訓練語言模型。深度學習不僅統一了人工智能的諸多領域,更以前所未有的深度和廣度,滲透到我們生活的方方面面。

這段歷史告訴我們,科學的發展從不是一條直線。它充滿了螺旋式的上升和周期性的起伏。思想的火花可能需要數十年的沉寂才能燎原,而看似不可逾越的瓶頸,也終將被新的智慧所突破。

1.2.2 群星閃耀時:那些塑造了AI紀元的大師們

技術史的宏大敘事,最終是由一個個鮮活的人來書寫的。在AI的殿堂里,有幾位巨匠的名字,我們必須銘記。他們的思想與貢獻,如北極星般指引著整個領域的前行。

艾倫·圖靈(Alan Turing):如前所述,他是計算機科學與人工智能的“思想教父”。他提出的圖靈機模型定義了“可計算”的邊界,而圖靈測試則開啟了“機器智能”的哲學與實踐探索。

杰弗里·辛頓(Geoffrey Hinton):被譽為“深度學習之父”之一。從80年代共同推廣反向傳播算法,到21世紀初用深度信念網絡開啟深度學習革命,再到培養出AlexNet的作者等一眾英才,辛頓以其數十年的堅持和洞察力,將神經網絡從寒冬帶入了盛夏。他因在深度學習領域的開創性貢獻,與另外兩位學者共同獲得了2018年的圖靈獎。

楊立昆(Yann LeCun):另一位2018年圖靈獎得主,卷積神經網絡(CNN)的締造者。早在上世紀90年代,他就開發了LeNet-5,成功應用于銀行的支票手寫數字識別。CNN架構模擬了生物的視覺皮層機制,其“局部連接”和“權值共享”的設計,對于處理圖像等網格狀數據具有天然的優勢,是當今計算機視覺領域的基石。

約書亞·本吉奧(Yoshua Bengio):2018年圖靈獎的第三位得主。他在深度學習的多個領域都做出了奠基性貢獻,尤其是在語言模型、注意力機制等方面。他與團隊的工作,為后來Transformer架構的誕生和自然語言處理的革命性突破鋪平了道路。同時,他也是一位極具人文關懷的科學家,持續關注AI的社會影響與倫理問題。

這三位學者常被并稱為“深度學習三巨頭”,他們的合作與良性競爭,共同塑造了我們今天所知的深度學習版圖。

- 弗拉基米爾·瓦普尼克(Vladimir Vapnik):統計學習理論的巨擘,支撐向量機(SVM)的發明人。他的工作為機器學習提供了堅實的理論基礎(VC維理論),強調了控制模型復雜度、追求泛化能力的重要性。在深度學習浪潮之前,SVM是學術界和工業界最受推崇的監督學習算法之一。他的思想提醒我們,即使在經驗主義大行其道的今天,深刻的數學理論依然是指引我們前行的燈塔。

當然,群星閃耀,遠不止于此。從“人工智能”一詞的提出者約翰·麥卡錫,到決策樹算法的先驅羅斯·昆蘭,再到強化學習領域的泰斗理查德·薩頓……正是這一代代研究者的智慧接力,才匯聚成了今日人工智能的滔滔江河。向他們致敬的最好方式,就是站在他們的肩膀上,繼續探索這片智慧的星辰大海。

1.3 為何是Python?——數據科學的“通用語”

在開啟具體的編程學習之前,一個自然的問題是:為什么是Python?在眾多編程語言中,為何Python能夠脫穎而出,成為機器學習和數據科學領域事實上的“標準語言”?這并非偶然,而是其內在哲學與外在生態共同作用的結果。

1.3.1 Python的哲學:“禪”與“道”

任何一門成功的語言,背后都有一種獨特的設計哲學。Python的哲學,被精煉地總結在“Python之禪(The Zen of Python)”中。你可以在任何安裝了Python的環境中,通過在解釋器里輸入import this來一睹其真容。其中幾條,與數據科學的精神內核不謀而合:

- 優美勝于丑陋(Beautiful is better than ugly.)

- 明了勝于晦澀(Explicit is better than implicit.)

- 簡單勝于復雜(Simple is better than complex.)

- 可讀性很重要(Readability counts.)

這不僅僅是編程美學,更是科學研究的方法論。機器學習項目往往不是一次性的“代碼沖鋒”,而是一個需要反復實驗、迭代、驗證和與他人協作的探索過程。

可讀性與簡潔性:Python的語法非常接近自然語言,這使得代碼的閱讀和編寫都變得異常輕松。對于科學家、分析師這些可能并非計算機科班出身的使用者來說,學習曲線極為平緩。他們可以將更多的精力聚焦于問題本身和算法思想,而不是糾結于繁瑣的語法細節(如C++的指針或Java的樣板代碼)。一段Python代碼,往往更像是在描述解決問題的“偽代碼”,這使得團隊協作和知識分享變得極為高效。

“膠水語言”的特質:Python被譽為“膠水語言”,因為它能輕易地將其他語言(特別是C/C++)編寫的高性能模塊“粘合”在一起。機器學習的核心計算,如圖形處理、大規模矩陣運算,對性能要求極高。這些計算通常由底層的、用C++或CUDA編寫的高性能庫來完成。Python則扮演了一個優雅的“指揮官”角色:我們用Python來定義模型結構、組織數據流、進行實驗管理,而將真正的計算密集型任務交給后臺的C++引擎。這就實現了“開發效率”與“運行效率”的完美結合。我們享受著Python的簡潔,卻沒有犧牲關鍵任務的性能。

這種設計哲學,使得Python成為一座理想的橋梁,它連接了思想與實現,連接了研究與工程,連接了專家與初學者。

1.3.2 生態系統概覽:為何它能成為最優選擇

如果說哲學是Python的“靈魂”,那么其無與倫比的開源生態系統,就是它強健的“體魄”。圍繞著數據科學和機器學習,Python社區自發地構建起了一套完整、強大且高度協同的“工具鏈”。這套工具鏈覆蓋了從數據獲取、清洗、分析、建模到可視化的整個工作流。

讓我們來巡禮一下這個生態中的幾顆璀璨明珠,這些也是我們后續章節將會深入學習的核心工具:

NumPy (Numerical Python):數據科學的基石。它提供了一個強大的N維數組對象(

ndarray),以及對這些數組進行操作的大量高效函數。幾乎所有Python中的高級數據分析和機器學習庫,其底層都構建在NumPy之上。它將Python從一門通用腳本語言,變成了能夠與MATLAB等專業科學計算軟件相媲美的強大工具。Pandas:數據分析與處理的瑞士軍刀。Pandas提供了兩種核心數據結構:

Series(一維)和DataFrame(二維)。DataFrame可以被想象成一個內存中的、功能極其強大的Excel表格。它使得數據的讀取、清洗、轉換、篩選、聚合、分組等操作變得異常簡單直觀。可以說,在機器學習項目中,80%的時間花在數據預處理上,而Pandas正是讓這80%的時間變得高效而愉快的關鍵。Matplotlib & Seaborn:數據可視化的雙璧。Matplotlib是Python中最基礎、最靈活的可視化庫,它提供了強大的底層繪圖接口,讓你可以定制幾乎任何類型的靜態、動態、交互式圖表。而Seaborn則是基于Matplotlib構建的更高級的統計圖形庫,它提供了更多美觀且面向統計分析的圖表模板,用更少的代碼就能生成信息含量豐富的可視化結果。“一圖勝千言”,這兩個庫是我們洞察數據、展示模型結果的“眼睛”。

Scikit-learn:傳統機器學習的集大成者。Scikit-learn是進入機器學習領域最重要、最友好的庫。它用一套高度一致、簡潔優雅的API,實現了絕大多數經典的機器學習算法(分類、回歸、聚類、降維等)。無論是初學者學習算法,還是從業者快速搭建基線模型,Scikit-learn都是不二之選。它的文檔極為完善,堪稱技術文檔的典范。本書的第二部分將重點圍繞Scikit-learn展開。

深度學習框架:TensorFlow & PyTorch:當問題復雜度超越了傳統機器學習的范疇,我們就需要進入深度學習的世界。在這個世界里,TensorFlow(由Google開發)和PyTorch(由Facebook開發)是兩大主流框架。它們提供了構建、訓練和部署大規模神經網絡所需的全部工具,包括自動微分、GPU加速、豐富的預置模型層等。雖然它們在設計哲學上有所不同(TensorFlow 2.x后也采納了PyTorch的動態圖思想),但都已成為驅動當今AI革命的核心引擎。

Jupyter Notebook / Lab:交互式科學計算的理想環境。Jupyter提供了一個基于Web的交互式計算環境,允許你將代碼、文本(Markdown)、數學公式(LaTeX)、可視化結果等組合在一個文檔中。這種“文學編程”的范式,極大地促進了探索性數據分析和研究過程的記錄與分享。它是數據科學家和機器學習研究者的“數字實驗室”和“工作臺”。

這套生態系統的力量在于其“網絡效應”:每一個庫都構建在其他庫之上,彼此無縫集成。你用Pandas清洗數據,得到的DataFrame可以直接喂給Scikit-learn進行建模,然后用Matplotlib將結果畫出來。這種流暢的體驗,是其他任何語言生態都難以比擬的。正是這個原因,最終使得Python戰勝了R、MATLAB、Java等競爭者,成為了數據科學的“通用語”。

1.4 破除迷思:AI是“神”還是“器”?

隨著AlphaGo的勝利和ChatGPT的驚艷表現,人工智能(AI)以前所未有的姿態進入了公眾視野。媒體的渲染、科幻作品的想象,使得AI的形象在人們心中變得模糊、甚至兩極分化:一些人視之為無所不能、即將取代人類的“神”;另一些人則憂心忡忡,將其視為可能失控的“潘多拉魔盒”。

作為即將踏入這個領域的實踐者,我們必須建立一個清醒、理性的認知:在可預見的未來,我們今天所談論和實踐的AI,本質上是一種“器”,而非“神”。 它是一種由人類設計,基于數學和數據,用于放大人類智慧、解決特定問題的強大工具。

1.4.1 機器學習的能力邊界與倫理挑戰

承認AI是“器”,意味著我們要清醒地認識到它的能力邊界。

數據依賴性:機器學習模型的能力,完全取決于其“喂養”的數據。模型的“智慧”是數據中蘊含模式的反映,其“偏見”也是數據中固有偏見的折射。如果訓練數據存在偏差(例如,在招聘模型中,歷史數據里男性工程師遠多于女性),那么模型就會學習并放大這種偏差,做出歧視性的判斷。模型無法創造數據中不存在的知識。

泛化能力的局限:模型在訓練數據上表現好,不代表在全新的、分布差異巨大的現實世界數據上依然表現好。這種從已知到未知的推廣能力,被稱為泛化(Generalization)。提升泛化能力是機器學習的核心挑戰之一。一個在加州房價數據上訓練得很好的模型,直接拿到中國市場來用,結果幾乎必然是災難性的。

缺乏常識與因果推理:目前的機器學習,尤其是深度學習,本質上是一種基于相關性的“模式匹配”。它擅長發現“A和B經常一起出現”,但通常無法理解“是不是因為A導致了B”。它缺乏人類與生俱來的大量背景知識和常識。一個能識別圖片中“馬”的模型,并不知道馬是一種動物,不能穿過墻壁。這種能力的缺失,使其在需要深度理解和推理的復雜決策場景中,依然非常脆弱。

可解釋性(Interpretability)的挑戰:特別是對于深度神經網絡這類復雜的“黑箱”模型,我們往往很難理解它為什么會做出某個具體的決策。一個模型拒絕了你的貸款申請,但它無法像人類信貸員那樣,給你一個清晰、合乎邏輯的理由。這種“知其然,而不知其所以然”的特性,在金融、醫療、司法等高風險領域,是不可接受的。

認識到這些邊界,自然會引出我們必須面對的倫理挑戰:

偏見與公平性(Bias and Fairness):如何確保算法不會對特定人群產生系統性的歧視?這不僅僅是技術問題,更是社會正義問題。我們需要開發能夠檢測、量化并緩解偏見的算法,并在模型設計之初就將公平性作為核心目標之一。

隱私(Privacy):在利用海量個人數據訓練模型的同時,如何保護用戶的隱私權?像聯邦學習(Federated Learning)和差分隱私(Differential Privacy)這樣的技術正在為此努力,它們旨在讓模型在不接觸原始敏感數據的情況下完成學習,或者在數據發布時加入數學上可保證的“噪聲”來保護個體信息。

責任(Accountability):當一個自動駕駛汽車發生事故,或一個AI醫療診斷系統出現誤診時,責任該由誰來承擔?是用戶、開發者、公司,還是AI本身?這需要建立清晰的法律法規和問責框架,確保技術的每一個環節都有明確的責任主體。

安全與魯棒性(Safety and Robustness):如何防止AI系統被惡意攻擊(例如,通過在停車標志上貼一個不起眼的貼紙,就讓自動駕駛的識別系統將其誤判為限速標志)?研究模型的“脆弱性”,發展“對抗性訓練”等防御技術,是確保AI系統在現實世界中安全可靠的關鍵。

失業與社會結構:AI自動化將在多大程度上取代人類工作,我們應如何應對由此帶來的社會結構性變遷?這需要政策制定者、教育家和全社會共同思考,如何進行教育改革、建立社會保障體系,以及創造新的工作崗位,以適應人機協作的新時代。

這些挑戰提醒我們,機器學習的實踐者,絕不能僅僅是一個埋頭于代碼和模型的“技術工匠”。我們必須成為一個負責任的“思考者”,時刻審視我們創造的技術可能帶來的深遠影響。

1.4.2 心法:以“出世”之心,做“入世”之事

面對機器學習的強大能力與深刻挑戰,我們應秉持怎樣的心態和原則來從事這項事業?在此,奶奶想與你分享一種“心法”,一種融合了東方智慧與科學精神的從業態度——以“出世”之心,做“入世”之事。

何為“出世”之心?

“出世”,并非消極避世,而是指一種超越具體事務、追求事物本源和規律的超然心態。它要求我們在精神層面保持高度的清醒、客觀與謙卑。

保持對知識的敬畏:要認識到我們所學的不過是滄海一粟。機器學習領域日新月異,沒有任何人能宣稱自己掌握了全部。保持空杯心態,持續學習,對未知保持好奇與敬畏,這是避免技術傲慢的根本。

追求真理,而非迎合指標:在項目中,我們常常會為了提升某個評估指標(如準確率)而無所不用其極。但“出世”之心提醒我們,要時刻反思這個指標是否真正反映了我們想要解決的現實問題。有時,0.1%的準確率提升可能伴隨著對某一群體公平性的巨大損害。我們的目標是解決問題,而不僅僅是優化數字。

旁觀者清,審視全局:在埋頭于特征工程和模型調優的“入世”狀態中,要時常抽離出來,像一個“出世”的旁觀者一樣審視自己的工作。問自己:我做的事情是否有潛在的負面影響?我的模型是否可能被濫用?我是否考慮了所有相關的利益方?這種自我審視,是技術倫理的第一道防線。

不執于“我”:不執著于“我”的模型、“我”的方法。科學的進步在于開放與協作。要樂于分享,敢于承認自己方法的局限,并積極吸收他人的智慧。一個算法、一個模型的價值,在于它能解決問題,而不在于它屬于誰。

何為“入世”之事?

“入世”,就是積極地投身于現實世界,用我們所學的知識去解決具體、實際的問題,創造真實的價值。它要求我們腳踏實地,精益求精。

問題驅動,而非技術驅動:要從真實的需求出發,而不是拿著“錘子”(某個炫酷的新模型)到處找“釘子”。深刻理解業務場景,與領域專家緊密合作,讓技術真正服務于目的。

動手實踐,精益求精:機器學習終究是一門實踐科學。“紙上得來終覺淺,絕知此事要躬行。” 必須親手處理數據,編寫代碼,訓練模型,分析結果。在每一個細節上追求卓越,代碼要清晰,實驗要嚴謹,結果要可復現。這是工匠精神的體現。

創造價值,勇于擔當:我們的最終目標,是利用機器學習技術,在醫療、教育、環保、科研等領域做出積極的貢獻。同時,也要勇于為自己創造的技術成果負責。如果發現它帶來了意想不到的負面后果,要有勇氣站出來承認并努力修正。

“出世”與“入世”的辯證統一

“出世”之心是“體”,是我們的世界觀和價值觀,它為我們指明方向,設定底線,讓我們不迷失在技術的洪流中。“入世”之事是“用”,是我們的方法論和行動力,它讓我們將理想轉化為現實,將智慧落地為價值。

只“出世”而無“入世”,則易流于空談,成為“坐而論道”的清談客。只“入世”而無“出世”,則易陷于“術”而忘了“道”,成為一個高效但可能盲目的“工具人”,甚至可能在不經意間“作惡”。

因此,真正的大家,必然是“出世”與“入世”的完美結合。他們既有仰望星空的深邃思考,又有腳踏實地的精湛技藝。

結語

親愛的讀者,本章即將結束。我們一同探討了學習的本質,回顧了AI的壯闊歷史,明確了Python的生態優勢,并最終落腳于從業者的內心修為。

希望這番“務虛”的討論,能為您接下來的“務實”學習,打下堅實的地基。因為最高明的技術,永遠由最清醒的頭腦和最正直的心靈所駕馭。

從下一章開始,我們將正式卷起袖子,進入Python與機器學習工具的實踐世界。請帶著這份對全局的認知和內心的準則,開始我們真正的筑基之旅。

第二章:工欲善其事——Python環境與核心工具鏈

- 2.1 “乾坤在握”:Anaconda與Jupyter Notebook的安裝與配置

- 2.2 “數據之舟”:NumPy數值計算基礎

- 2.3 “數據之魂”:Pandas數據分析利器

- 2.4 “眼見為實”:Matplotlib與Seaborn數據可視化

在上一章,我們探討了機器學習的宏大世界觀。現在,我們要將這些思想付諸實踐。實踐的第一步,便是構建一個穩定、可靠且功能強大的工作環境。本章將引導您完成從環境安裝到核心工具掌握的全過程,為您后續的學習掃清障礙。

我們將首先介紹并安裝Anaconda,這個被譽為數據科學“全家桶”的發行版,它能一站式解決Python環境管理和包安裝的難題。接著,我們將學習使用Jupyter Notebook,一個交互式的“數字實驗室”,它將成為我們探索、實驗和展示工作的主要平臺。

隨后,我們將深入學習三個數據科學的“奠基石”庫:

- NumPy:我們的“數據之舟”,它為Python提供了強大的多維數組和高效的數值計算能力。

- Pandas:我們的“數據之魂”,它提供了靈活的數據結構,讓處理和分析結構化數據變得輕而易舉。

- Matplotlib & Seaborn:我們的“眼睛”,它們能將枯燥的數據轉化為富有洞察力的可視化圖表。

請務必對本章內容投入足夠的時間和耐心。熟練掌握這些工具,您會發現后續的學習將事半功倍。

2.1 “乾坤在握”:Anaconda與Jupyter Notebook的安裝與配置

在編程世界里,環境配置往往是勸退新手的“第一道坎”。不同項目可能需要不同版本的Python或依賴庫,如果將所有東西都裝在系統的主Python環境中,很快就會導致版本沖突和混亂,猶如一個堆滿了各種工具、零件卻雜亂無章的車庫。

為了解決這個問題,我們需要一個專業的“車庫管理員”——Anaconda。

什么是Anaconda?

Anaconda并不僅僅是Python,它是一個專注于數據科學的Python發行版。你可以把它理解為一個“大禮包”,里面包含了:

- 特定版本的Python解釋器。

- Conda:一個強大的包管理器和環境管理器。

- 預裝好的數百個常用科學計算包:如NumPy, Pandas, Matplotlib, Scikit-learn等。你無需再一個個手動安裝,省去了大量的配置麻煩。

為何選擇Anaconda?——環境管理的智慧

Anaconda最核心的價值在于其附帶的conda工具,它能讓我們輕松創建相互隔離的虛擬環境(Virtual Environments)。

想象一下,你要同時進行兩個項目:

- 項目A,是一個老項目,需要使用Python 3.7和一個舊版的庫X (版本1.0)。

- 項目B,是一個新項目,你想使用最新的Python 3.11和庫X的新版本 (版本2.0)。

如果沒有環境隔離,這兩個項目根本無法在同一臺電腦上共存。而有了conda,你可以:

- 創建一個名為

project_a_env的環境,在里面安裝Python 3.7和庫X 1.0。 - 再創建一個名為

project_b_env的環境,在里面安裝Python 3.11和庫X 2.0。

這兩個環境如同兩個獨立的平行宇宙,互不干擾。你可以隨時通過一條簡單的命令在它們之間切換。這種“分而治之”的智慧,是專業開發實踐的基石。

安裝Anaconda

安裝過程非常直觀,與安裝普通軟件無異。

- 訪問官網:在瀏覽器中打開Anaconda的官方下載頁面 (anaconda.com/download)。網站通常會自動檢測你的操作系統(Windows, macOS, Linux)并推薦合適的版本。

- 選擇版本:選擇與你操作系統對應的最新Python 3.x版本的圖形化安裝包(Graphical Installer)進行下載。

- 執行安裝:

- 雙擊下載好的安裝包。

- 按照提示點擊“Next”或“Continue”。

- 在許可協議頁面,同意協議。

- 安裝類型選擇“Just Me”即可(除非你有特殊需求為電腦所有用戶安裝)。

- 關鍵步驟(Windows):在“Advanced Options”界面,建議不要勾選“Add Anaconda to my PATH environment variable”(將Anaconda添加到系統環境變量)。雖然勾選看似方便,但長期來看容易引起與其他Python安裝的沖突。官方推薦使用“Anaconda Prompt”來啟動和管理conda。另一個選項“Register Anaconda as my default Python”可以勾選。

- 選擇安裝路徑(通常保持默認即可),然后開始安裝。過程可能需要幾分鐘。

- 驗證安裝:

- Windows: 在開始菜單中找到并打開“Anaconda Prompt (anaconda3)”。

- macOS/Linux: 打開你的終端(Terminal)。

- 在打開的命令行窗口中,輸入?

conda --version?并回車。如果成功顯示出conda的版本號(如?conda 23.7.4),則證明Anaconda已安裝成功。

使用Conda創建和管理環境

現在,讓我們來實踐一下環境管理的威力。打開你的Anaconda Prompt或終端。

創建一個新的環境: 我們為本書創建一個專屬的學習環境,命名為

ml_book,并指定使用Python 3.9(一個穩定且兼容性好的版本)。conda create --name ml_book python=3.9Conda會詢問你是否要安裝一些基礎包,輸入

y并回車。激活環境: 創建好后,需要“進入”這個環境才能使用它。

conda activate ml_book激活后,你會發現命令行提示符前面多了

(ml_book)的字樣,這表示你當前正處于這個獨立的環境中。在環境中安裝庫: 現在,我們在這個環境中安裝本書需要的核心庫。由于Anaconda的base環境已經自帶,我們這里僅作演示。例如,安裝

seaborn。conda install seabornConda會自動處理依賴關系,一并安裝好所有需要的其他庫。

查看已安裝的庫:

conda list退出環境: 當你完成工作,可以退回到基礎環境。

conda deactivate提示符前面的

(ml_book)會消失。

Jupyter Notebook:你的交互式實驗室

環境搭好了,我們還需要一個好用的“工作臺”。Jupyter Notebook就是這樣一個理想的工具。它是一個基于Web的應用程序,允許你創建和共享包含實時代碼、公式、可視化和敘述性文本的文檔。

啟動Jupyter Notebook

- 確保你已經激活了你的工作環境(

conda activate ml_book)。 - 在命令行中輸入:

jupyter notebook - 執行后,你的默認瀏覽器會自動打開一個新標簽頁,地址通常是

http://localhost:8888/tree?。這就是Jupyter的文件瀏覽器界面。命令行窗口不要關閉,因為它是Jupyter服務的后臺。

Jupyter Notebook核心概念

- Notebook文件 (

.ipynb):你創建的每一個Jupyter文檔都是一個.ipynb文件,它用一種特殊格式(JSON)保存了你所有的代碼、文本和輸出。 - 單元格(Cell):Notebook由一個個單元格組成。單元格主要有兩種類型:

- Code Cell(代碼單元格):用來編寫和執行代碼(如Python代碼)。

- Markdown Cell(文本單元格):用來編寫格式化的文本,就像你現在正在閱讀的這些文字一樣,可以包含標題、列表、鏈接、圖片等。

- 內核(Kernel):每個Notebook都有一個獨立的“內核”在后臺運行。這個內核是你激活的conda環境的體現,它負責接收你在Code Cell中寫的代碼,執行它,然后將結果返回并顯示在單元格下方。

基本操作

- 新建Notebook:在Jupyter的文件瀏覽器頁面,點擊右上角的“New”,然后選擇“Python 3 (ipykernel)”或類似選項,即可創建一個新的Notebook。

- 切換單元格類型:在選中一個單元格后,可以在頂部的工具欄下拉菜單中選擇

Code或Markdown。 - 執行單元格:選中一個單元格,按下?

Shift + Enter,Jupyter會執行該單元格,并自動跳轉到下一個單元格。這是最常用的快捷鍵。 - 保存:點擊左上角的保存圖標,或使用快捷鍵

Ctrl + S?(Windows/Linux) /?Cmd + S?(macOS)。

現在,請你親手嘗試:

- 創建一個新的Notebook。

- 在第一個單元格中,輸入?

print("Hello, Machine Learning World!"),然后按Shift + Enter執行。 - 將第二個單元格的類型改為Markdown,輸入

# 這是我的第一個Notebook標題,然后按Shift + Enter渲染文本。

恭喜!你已經成功搭建了專業的開發環境,并掌握了與它交互的基本方式。這個環境如同一片沃土,我們接下來要學習的NumPy、Pandas等工具,就是將要在這片土地上茁壯成長的參天大樹。

2.2 “數據之舟”:NumPy數值計算基礎

如果說數據是海洋,那NumPy (Numerical Python) 就是我們在這片海洋上航行的第一艘堅固快船。它是Python科學計算生態的絕對核心,幾乎所有上層庫(包括Pandas和Scikit-learn)都構建于它之上。

Python原生的列表(list)雖然靈活,但對于大規模數值運算,其性能不堪一擊。NumPy的核心是其ndarray(N-dimensional array)對象,這是一個由相同類型元素組成的多維數組。它的優勢在于:

- 性能:

ndarray在內存中是連續存儲的,并且其核心運算由C語言編寫的底層代碼執行,速度遠超Python原生列表。 - 便捷:提供了大量用于數組操作的數學函數和線性代數運算,語法簡潔。

安裝NumPy

如果你遵循了上一節使用Anaconda,那么NumPy已經被預裝好了。如果沒有,只需在激活的環境中運行:

conda install numpy

導入NumPy

在代碼中,我們遵循一個廣泛接受的慣例,將NumPy導入并簡寫為np。

import numpy as np

2.2.1 從標量到張量:維度的哲學

在NumPy中,我們用不同的術語來描述不同維度的數據,這與物理學和深度學習中的“張量(Tensor)”概念一脈相承。理解維度,是理解數據結構的第一步。

標量(Scalar):一個單獨的數字,如

7。在NumPy中,它是一個0維數組。s = np.array(7) print(s) print("維度:", s.ndim) # ndim屬性查看維度數量 # 輸出: # 7 # 維度: 0向量(Vector):一列有序的數字,如

[1, 2, 3]。它是一個1維數組。v = np.array([1, 2, 3]) print(v) print("維度:", v.ndim) print("形狀:", v.shape) # shape屬性查看每個維度的大小 # 輸出: # [1 2 3] # 維度: 1 # 形狀: (3,)矩陣(Matrix):一個二維的數字表格,如

[[1, 2], [3, 4]]。它是一個2維數組。m = np.array([[1, 2, 3], [4, 5, 6]]) print(m) print("維度:", m.ndim) print("形狀:", m.shape) # 輸出: # [[1 2 3] # [4 5 6]] # 維度: 2 # 形狀: (2, 3) (代表2行3列)張量(Tensor):一個超過二維的數組。例如,一張彩色圖片可以表示為一個3維張量(高度,寬度,顏色通道RGB)。

t = np.array([[[1, 2], [3, 4]], [[5, 6], [7, 8]]]) print(t) print("維度:", t.ndim) print("形狀:", t.shape) # 輸出: # [[[1 2] # [3 4]] # # [[5 6] # [7 8]]] # 維度: 3 # 形狀: (2, 2, 2)

ndim(維度數)、shape(形狀)和dtype(數據類型)是ndarray最重要的三個屬性。在處理數據時,時刻關注這三個屬性,能幫你避免很多錯誤。

創建數組的常用方法

除了直接從列表創建,NumPy還提供了多種便捷的創建方式:

# 創建一個3行4列,所有元素為0的數組

zeros_arr = np.zeros((3, 4))# 創建一個2x3x2,所有元素為1的數組

ones_arr = np.ones((2, 3, 2))# 創建一個從0到9的數組(不包含10)

range_arr = np.arange(10)# 創建一個從0到1,包含5個等間距元素的數組

linspace_arr = np.linspace(0, 1, 5)# 創建一個3x3的單位矩陣

eye_arr = np.eye(3)# 創建一個2x3,元素為隨機數的數組(0到1之間)

rand_arr = np.random.rand(2, 3)# 創建一個2x3,元素為符合標準正態分布的隨機數

randn_arr = np.random.randn(2, 3)

2.2.2 核心操作:索引、切片、廣播機制

1. 索引與切片(Indexing and Slicing)

這與Python列表類似,但擴展到了多維。

# 以一個1維數組為例

a = np.arange(10) # [0, 1, 2, 3, 4, 5, 6, 7, 8, 9]# 獲取單個元素

print(a[5]) # 輸出: 5# 切片:獲取從索引2到索引7(不含)的元素

print(a[2:7]) # 輸出: [2 3 4 5 6]# 以一個2維數組為例

m = np.array([[1, 2, 3], [4, 5, 6], [7, 8, 9]])# 獲取單個元素:第1行(索引從0開始),第2列

print(m[1, 2]) # 輸出: 6# 獲取整行

print(m[0, :]) # 輸出: [1 2 3] (:代表該維度的所有元素)

# 或者簡寫為

print(m[0])# 獲取整列

print(m[:, 1]) # 輸出: [2 5 8]# 獲取子矩陣:第0、1行,和第1、2列

print(m[0:2, 1:3])

# 輸出:

# [[2 3]

# [5 6]]

布爾索引(Boolean Indexing) 這是一個極其強大的功能,允許我們根據條件來選擇元素。

data = np.array([[1, 2], [3, 4], [5, 6]])# 找到data中所有大于3的元素

bool_idx = data > 3

print(bool_idx)

# 輸出:

# [[False False]

# [False True]

# [ True True]]# 使用這個布爾數組來索引,會返回所有對應位置為True的元素

print(data[bool_idx]) # 輸出: [4 5 6]# 也可以直接寫成一行

print(data[data > 3])

2. 數組運算

NumPy的數組運算是按元素進行的,這使得代碼非常簡潔。

x = np.array([[1, 2], [3, 4]])

y = np.array([[5, 6], [7, 8]])# 按元素加法

print(x + y)

# [[ 6 8]

# [10 12]]# 按元素乘法

print(x * y)

# [[ 5 12]

# [21 32]]# 矩陣乘法(點積)

print(np.dot(x, y))

# 或者使用@符號 (Python 3.5+)

print(x @ y)

# [[19 22]

# [43 50]]

NumPy還提供了全套的通用函數(ufunc),如np.sqrt(), np.sin(), np.exp()等,它們也都按元素作用于整個數組。

3. 廣播機制(Broadcasting)

廣播是NumPy最神奇也最重要的特性之一。它描述了NumPy在處理不同形狀的數組進行算術運算時的規則。簡單來說,如果兩個數組的形狀不完全匹配,NumPy會嘗試“廣播”那個較小的數組,將其“拉伸”以匹配較大數組的形狀,從而使運算成為可能。

規則:從兩個數組的尾部維度開始逐一比較它們的size:

- 如果兩個維度size相同,或其中一個為1,則該維度兼容。

- 如果所有維度都兼容,則運算可以進行。

- 如果任一維度不兼容(size不同且沒有一個是1),則會報錯。

示例:

# 一個2x3的矩陣

a = np.array([[1, 2, 3], [4, 5, 6]])# 一個1x3的向量(或說行向量)

b = np.array([10, 20, 30])# a的形狀是(2, 3),b的形狀是(3,)。

# NumPy會將b廣播,想象成把它復制了一遍,變成了[[10, 20, 30], [10, 20, 30]]

# 然后再與a進行按元素加法

print(a + b)

# 輸出:

# [[11 22 33]

# [14 25 36]]# 另一個例子:給矩陣的每一列加上一個不同的值

# a的形狀是(2, 3)

# c的形狀是(2, 1)

c = np.array([[100], [200]])# NumPy會將c的第1維(列)進行廣播,變成[[100, 100, 100], [200, 200, 200]]

print(a + c)

# 輸出:

# [[101 102 103]

# [204 205 206]]

廣播機制極大地提升了代碼的簡潔性和效率,避免了我們手動寫循環去擴展數組。理解并善用廣播,是衡量一個NumPy使用者是否熟練的重要標志。

2.3 “數據之魂”:Pandas數據分析利器

Pandas的名字來源于“Panel Data”(面板數據),這是一個計量經濟學術語,指多維度的結構化數據集。這個庫由Wes McKinney在2008年開發,初衷是為了解決金融數據分析中的實際問題。如今,它已成為Python數據分析的代名詞。

Pandas的核心價值在于,它提供了一套直觀、靈活且功能強大的數據結構,專門用于處理表格型(tabular)和異構(heterogeneous)數據。在真實世界中,我們遇到的大部分數據,如Excel表格、數據庫查詢結果、CSV文件,都是這種形式。

安裝Pandas

同樣,如果你使用Anaconda,Pandas已為你準備就緒。否則,請運行:

##########################

### 導入Pandas

### 社區慣例是將其導入為`pd`

##########################

conda install pandasimport pandas as pd

2.3.1 Series與DataFrame:結構化數據的“陰陽”

Pandas有兩個核心的數據結構,理解它們是掌握Pandas的關鍵。

1. Series:帶標簽的一維數組

你可以將Series想象成一個加強版的NumPy一維數組。它與ndarray的主要區別在于,Series有一個與之關聯的標簽數組,稱為索引(Index)。

# 從列表創建一個基本的Series

s = pd.Series([10, 20, 30, 40])

print(s)

# 輸出:

# 0 10

# 1 20

# 2 30

# 3 40

# dtype: int64

左邊的一列(0, 1, 2, 3)是默認生成的整數索引。右邊是我們的數據值。

Series的強大之處在于我們可以自定義索引:

# 創建一個帶有自定義索引的Series

sales = pd.Series([250, 300, 450], index=['北京', '上海', '深圳'])

print(sales)

# 輸出:

# 北京 250

# 上海 300

# 深圳 450

# dtype: int64# 可以像字典一樣通過標簽進行索引

print(sales['上海']) # 輸出: 300# 也可以像NumPy數組一樣進行切片和布爾索引

print(sales[sales > 280])

# 輸出:

# 上海 300

# 深圳 450

# dtype: int64

Series的index和values屬性可以分別訪問其索引和值(值為一個NumPy數組)。

2. DataFrame:二維的“超級表格”

DataFrame是Pandas最核心、最常用的數據結構。你可以把它看作:

- 一個共享相同索引的

Series的集合。 - 一個帶有行索引(index)和列索引(columns)的二維表格。

- 一個功能極其強大的Excel電子表格或SQL數據表。

####################

# 從字典創建DataFrame,字典的key會成為列名

####################data = {'城市': ['北京', '上海', '廣州', '深圳'],'年份': [2020, 2020, 2021, 2021],'人口(萬)': [2154, 2428, 1867, 1756]

}

df = pd.DataFrame(data)

print(df)

# 輸出:

# 城市 年份 人口(萬)

# 0 北京 2020 2154

# 1 上海 2020 2428

# 2 廣州 2021 1867

# 3 深圳 2021 1756####################

# DataFrame

# 既有行索引(左邊的0, 1, 2, 3),也有列索引('城市', '年份', '人口(萬)')

########################################

# 查看DataFrame基本信息

# 在進行任何分析前,先“體檢”一下數據是個好習慣:

##################### 查看前5行

print(df.head())# 查看后5行

print(df.tail())# 查看索引、列名和數據類型

print(df.info())

# <class 'pandas.core.frame.DataFrame'>

# RangeIndex: 4 entries, 0 to 3

# Data columns (total 3 columns):

# # Column Non-Null Count Dtype

# --- ------ -------------- -----

# 0 城市 4 non-null object

# 1 年份 4 non-null int64

# 2 人口(萬) 4 non-null int64

# dtypes: int64(2), object(1)

# memory usage: 224.0+ bytes# 獲取描述性統計信息(對數值列)

print(df.describe())

# 年份 人口(萬)

# count 4.000000 4.000000

# mean 2020.500000 2051.250000

# std 0.577350 302.491322

# min 2020.000000 1756.000000

# 25% 2020.000000 1839.250000

# 50% 2020.500000 2010.500000

# 75% 2021.000000 2222.500000

# max 2021.000000 2428.000000

2.3.2 數據的“增刪改查”與“聚合分離”

Pandas的威力體現在它對數據進行復雜操作的簡潔性上。

1. 查(選擇數據)

這是最頻繁的操作。Pandas提供了兩種主要的索引方式:

.loc:**基于標簽(label)**的索引。.iloc:**基于位置(integer position)**的索引。

# 假設我們給df設置一個更有意義的索引

df.index = ['BJ', 'SH', 'GZ', 'SZ']# --- 使用 .loc ---

# 選擇單行 (返回一個Series)

print(df.loc['SH'])# 選擇多行 (返回一個DataFrame)

print(df.loc[['BJ', 'SZ']])# 選擇行和列

print(df.loc['GZ', '人口(萬)']) # 輸出: 1867# 選擇多行多列

print(df.loc[['SH', 'GZ'], ['城市', '人口(萬)']])# --- 使用 .iloc ---

# 選擇第2行(索引為1)

print(df.iloc[1])# 選擇第0行和第3行

print(df.iloc[[0, 3]])# 選擇第2行、第1列的元素

print(df.iloc[2, 1]) # 輸出: 2021# --- 條件選擇 ---

# 選擇年份為2020的所有行

print(df[df['年份'] == 2020])# 選擇人口超過2000萬的城市名

print(df[df['人口(萬)'] > 2000]['城市'])

記住.loc用名字,.iloc用數字,是避免混淆的關鍵。

2. 增(添加數據)

# 添加新列

df['GDP(萬億)'] = [3.6, 3.9, 2.5, 3.0]

print(df)# 添加新行 (使用.loc)

df.loc['HZ'] = ['杭州', 2022, 1200, 1.8]

print(df)

3. 刪(刪除數據)

使用.drop()方法。它默認返回一個新對象,不修改原始DataFrame。

# 刪除列 (axis=1代表列)

df_no_gdp = df.drop('GDP(萬億)', axis=1)# 刪除行 (axis=0代表行)

df_no_hz = df.drop('HZ', axis=0)

4. 改(修改數據)

可以直接通過索引賦值來修改。

# 修改單個值

df.loc['BJ', '人口(萬)'] = 2189# 修改整列

df['年份'] = 2022# 根據條件修改

df.loc[df['城市'] == '上海', '人口(萬)'] = 2487

5. 聚合與分組(Groupby)

這是Pandas的“大殺器”,對應于SQL中的GROUP BY操作。它實現了“分離-應用-合并”(Split-Apply-Combine)的強大模式。

過程:

- 分離(Split):根據某個或某些鍵將數據拆分成組。

- 應用(Apply):對每個組獨立地應用一個函數(如求和、求平均)。

- 合并(Combine):將結果合并成一個新的數據結構。

# 按“年份”分組,并計算每年的平均人口

avg_pop_by_year = df.groupby('年份')['人口(萬)'].mean()

print(avg_pop_by_year)# 按“年份”分組,并應用多個聚合函數

stats_by_year = df.groupby('年份')['人口(萬)'].agg(['mean', 'sum', 'count'])

print(stats_by_year)

groupby操作是探索性數據分析的核心,能幫助我們快速發現不同類別數據之間的關系。

Pandas的功能遠不止于此,還包括處理缺失數據、合并/連接多個DataFrame、時間序列分析等高級功能,我們將在后續章節的實戰中不斷遇到和學習。

2.4 “眼見為實”:Matplotlib與Seaborn數據可視化

數據分析的最終目的之一是獲得洞察(Insight)。而人類的大腦天生就對圖形信息比對數字表格更敏感。“一圖勝千言”,數據可視化正是連接數據與洞察的橋梁。

在Python生態中,Matplotlib是“教父”級別的可視化庫,它功能強大、可定制性極高。而Seaborn則是基于Matplotlib構建的、更側重于統計圖形的“美顏相機”,它能用更簡潔的代碼生成更美觀、信息更豐富的圖表。

導入

import matplotlib.pyplot as plt

import seaborn as sns# 在Jupyter Notebook中,通常會加上這行魔法命令,讓圖像直接內嵌在Notebook中顯示

%matplotlib inline

2.4.1 從點線圖到熱力圖:選擇合適的“畫筆”

不同的數據關系,需要用不同的圖表類型來呈現。

1. 折線圖(Line Plot):最適合展示數據隨連續變量(尤其是時間)變化的趨勢。

# 假設我們有一周的銷售數據

days = np.arange(1, 8)

sales = np.array([50, 55, 47, 62, 60, 70, 68])plt.figure(figsize=(8, 4)) # 創建一個8x4英寸的畫布

plt.plot(days, sales, marker='o', linestyle='--') # marker是數據點的樣式,linestyle是線的樣式

plt.title("周銷售額趨勢") # 添加標題

plt.xlabel("天數") # 添加x軸標簽

plt.ylabel("銷售額") # 添加y軸標簽

plt.grid(True) # 顯示網格

plt.show() # 顯示圖像

2. 散點圖(Scatter Plot):用于探索兩個數值變量之間的關系。

# 假設我們有房屋面積和價格的數據

area = np.random.randint(50, 150, size=100)

price = area * 1.2 + np.random.randn(100) * 20# 使用Seaborn繪制散點圖,更美觀

sns.scatterplot(x=area, y=price)

plt.title("房屋面積與價格關系")

plt.xlabel("面積 (平方米)")

plt.ylabel("價格 (萬元)")

plt.show()

3. 柱狀圖(Bar Plot):用于比較不同類別的數據。

# 使用我們之前的城市人口DataFrame

sns.barplot(x='城市', y='人口(萬)', data=df)

plt.title("主要城市人口對比")

plt.show()

4. 直方圖(Histogram):用于觀察單個數值變量的分布情況。

# 觀察價格數據的分布

sns.histplot(price, kde=True) # kde=True會同時繪制一條核密度估計曲線

plt.title("房價分布直方圖")

plt.show()

5. 熱力圖(Heatmap):用顏色深淺來展示一個矩陣的值,非常適合展示變量之間的相關性。

# 計算df中數值列的相關系數矩陣

corr_matrix = df[['年份', '人口(萬)', 'GDP(萬億)']].corr()sns.heatmap(corr_matrix, annot=True, cmap='coolwarm') # annot=True在格子上顯示數值, cmap是顏色主題

plt.title("特征相關性熱力圖")

plt.show()

2.4.2 可視化之道:美學、信息與洞察

一幅好的數據可視化作品,應遵循幾個原則:

數據-墨水比(Data-Ink Ratio):由可視化大師愛德華·塔夫特提出。核心思想是,一幅圖中絕大部分的“墨水”都應該用來展示數據本身,而應刪去所有無益于理解數據的裝飾性元素(如花哨的背景、3D效果等)。追求簡約和清晰。

選擇正確的圖表:明確你要表達的關系——是比較、分布、構成還是聯系?然后選擇最適合的圖表類型。用折線圖去比較類別數據,或者用餅圖去展示超過5個類別的構成,都是常見的錯誤。

清晰的標注:一幅圖必須是自包含的。它應該有明確的標題、坐標軸標簽(包含單位)、圖例等,讓讀者無需閱讀正文就能理解圖表的基本含義。

利用視覺編碼:除了位置(x, y坐標),我們還可以利用顏色、形狀、大小、透明度等視覺元素來編碼更多的信息維度。但要避免過度使用,以免造成視覺混亂。

講一個故事(Tell a Story):最好的可視化不僅僅是呈現數據,它還在講述一個故事,引導讀者發現模式、得出結論。你的標題、注解和高亮顯示,都應該服務于這個故事。

結語

本章,我們從零開始,搭建了堅實的Python數據科學環境,并掌握了NumPy、Pandas、Matplotlib和Seaborn這四大金剛。這套工具鏈,是您未來探索廣闊數據世界的“標準裝備”。

請務必花時間親手實踐本章的所有代碼。嘗試讀取你自己的CSV文件,用Pandas進行清洗和分析,再用Matplotlib/Seaborn將其可視化。當你能自如地運用這些工具時,你就已經完成了從門外漢到數據科學“準入者”的蛻變。

從下一章開始,我們將正式進入機器學習的核心地帶,開始學習如何利用這些工具,去構建、訓練和評估真正的機器學習模型。我們的地基已經打好,是時候開始建造大廈了。

第三章:數據的心法——預處理與特征工程

- 3.1 “相數據”:理解你的數據

- 3.2 “凈數據”:數據清洗的修行

- 3.3 “點石成金”:特征工程的科學與藝術

在機器學習的宏偉藍圖中,數據預處理與特征工程扮演著承前啟后的關鍵角色。它們是連接原始數據與機器學習模型的橋梁,其質量直接決定了模型最終所能達到的高度。一個經過精心處理和設計的特征,其價值往往勝過一個復雜模型的微小調優。

本章,我們將秉持一種“格物致知”的精神,深入數據的內在肌理。我們將學習:

- “相數據”:如何通過探索性數據分析(EDA)與數據進行初次“對話”,理解其脾性。

- “凈數據”:如何像一位耐心的工匠,清理數據中的“雜質”——缺失值與異常值。

- “點石成金”:如何施展特征工程的“魔法”,從現有數據中創造出更具信息量的特征,并將其轉化為模型能夠“消化”的格式。

這個過程,既有章法可循的科學,也有依賴經驗直覺的藝術。它是一場修行,考驗的是我們的耐心、細致與創造力。

3.1 “相數據”:理解你的數據

在拿到一個數據集后,最忌諱的就是不假思索地直接將其扔進模型。這好比醫生不經問診,就給病人開藥,是極其危險和不負責任的。我們的第一步,永遠是理解數據。這個過程,我們稱之為探索性數據分析(Exploratory Data Analysis, EDA)。

3.1.1 探索性數據分析(EDA):與數據對話的藝術

EDA是由統計學大師約翰·圖基(John Tukey)提倡的一種數據分析方法論。它的核心思想是,在進行任何正式的假設檢驗之前,通過多種手段(主要是可視化和匯總統計)對數據進行開放式的探索,以發現其結構、異常、模式和關系。

這是一種偵探般的工作,我們的目標是回答關于數據的基本問題:

- 這個數據集中有多少行(樣本)和多少列(特征)?

- 每個特征是什么數據類型(數值型、類別型、文本、日期)?

- 數據中是否存在缺失值?比例如何?

- 數據的分布是怎樣的?(是正態分布,還是偏態分布?)

- 不同特征之間是否存在關聯?(例如,身高和體重是否正相關?)

讓我們以一個經典的“泰坦尼克號幸存者”數據集為例,來演示EDA的基本流程。首先,加載數據并進行初步檢視。

import pandas as pd

import numpy as np

import matplotlib.pyplot as plt

import seaborn as sns# 加載數據 (Seaborn自帶了這個數據集)

df = sns.load_dataset('titanic')# 1. 查看數據維度

print("數據形狀:", df.shape)# 2. 查看前幾行,對數據有個直觀印象

print(df.head())# 3. 查看各列的數據類型和非空值數量

print(df.info())

從df.info()的輸出中,我們能立刻獲得大量信息:

- 共有891個樣本(行),15個特征(列)。

age(年齡)、deck(甲板號)、embarked(登船港口)等列存在缺失值(因為它們的非空計數少于891)。survived,?pclass,?sex,?embarked?等是類別型特征,而?age,?fare?是數值型特征。

這就是與數據的第一輪“對話”,我們已經對它的“家底”有了大致了解。

3.1.2 描述性統計與分布可視化

接下來,我們要更深入地探查數據的內在特征。

1. 描述性統計

對于數值型特征,describe()方法是我們的得力助手。

print(df.describe())

這會輸出數值列的計數、平均值、標準差、最小值、四分位數和最大值。從中我們可以快速發現:

- 年齡(age):乘客平均年齡約29.7歲,但年齡跨度很大(從0.42歲到80歲),且存在缺失值(count為714)。

- 票價(fare):票價分布極不均勻,75%的乘客票價低于31美元,但最高票價竟達512美元,這暗示可能存在極端值(異常值)。

對于類別型特征,我們可以使用value_counts()來查看其取值分布。

# 查看性別分布

print(df['sex'].value_counts())# 查看生還情況分布

print(df['survived'].value_counts(normalize=True)) # normalize=True顯示比例

我們發現,乘客中男性遠多于女性,且總體生還率只有約38.4%。

2. 分布可視化

數字是抽象的,圖形是直觀的。我們將使用Matplotlib和Seaborn將統計結果可視化。

觀察單個數值變量的分布(直方圖/核密度圖)

sns.histplot(df['age'].dropna(), kde=True) # dropna()去掉缺失值 plt.title('乘客年齡分布') plt.show()從圖中可以看到,乘客以年輕人為主,呈右偏態分布。

觀察單個類別變量的分布(計數圖/柱狀圖)

sns.countplot(x='pclass', data=df) plt.title('各船艙等級人數') plt.show()三等艙乘客數量最多。

探索特征與目標變量的關系 這是EDA的核心目的之一。例如,我們想知道“船艙等級”和“生還率”有何關系。

sns.barplot(x='pclass', y='survived', data=df) plt.title('各船艙等級的生還率') plt.ylabel('生還率') plt.show()一目了然,船艙等級越高(1等艙),生還率越高。這是一個極具信息量的發現。

探索兩個數值變量的關系(散點圖)

sns.scatterplot(x='age', y='fare', data=df) plt.title('年齡與票價的關系') plt.show()探索多個變量間的關系(熱力圖/配對圖)

# 計算數值特征的相關性矩陣 corr = df[['survived', 'pclass', 'age', 'sibsp', 'parch', 'fare']].corr() sns.heatmap(corr, annot=True, cmap='coolwarm') plt.title('特征相關性熱力圖') plt.show() ``` 熱力圖顯示,`pclass`和`survived`有顯著的負相關(-0.34),`fare`和`survived`有正相關(0.26),這與我們之前的發現一致。

通過這一系列“望、聞、問、切”,我們對數據的特性、潛在的問題(缺失值、異常值)以及特征間的關系有了深刻的理解。這份理解,將指導我們下一步的“凈數據”和“點石成金”工作。

3.2 “凈數據”:數據清洗的修行

現實世界的數據是“骯臟”的。數據錄入錯誤、傳感器故障、用戶不愿填寫……種種原因導致了數據中充滿了缺失值(Missing Values)和異常值(Outliers)。數據清洗,就是將這些“雜質”處理掉的過程,它是一項細致且關鍵的修行。

3.2.1 缺失值的“舍”與“得”:刪除、插補與預測

處理缺失值,我們需要權衡利弊,做出“舍”與“得”的決策。

1. 識別缺失值

# 查看每列的缺失值數量

print(df.isnull().sum())# 查看缺失值比例

print(df.isnull().sum() / len(df) * 100)

在泰坦尼克數據中,age缺失約19.8%,deck缺失高達77.4%,embarked只缺失2個。

2. 處理策略

刪除(Dropping):“舍”的決斷

- 刪除整列:如果一個特征的缺失比例過高(如

deck的77%),它所能提供的信息已經非常有限,強行填充反而可能引入噪聲。此時,可以考慮直接刪除該列。df_dropped_col = df.drop('deck', axis=1) - 刪除整行:如果某個樣本(行)缺失了多個關鍵特征,或者數據集非常大而缺失的行數很少(如

embarked只缺失2行),那么直接刪除這些行是簡單有效的做法。df_dropped_row = df.dropna(subset=['embarked'])

優點:簡單直接,不會引入偏誤。 缺點:會損失數據,如果缺失數據不是隨機的,可能會導致分析結果產生偏見。

- 刪除整列:如果一個特征的缺失比例過高(如

插補(Imputation):“得”的智慧 插補是用一個估算值來代替缺失值。這是更常用的方法。

- 用均值/中位數/眾數填充:這是最簡單的插補方法。

- 對于數值型特征,如果數據分布比較對稱,可以用**均值(mean)填充;如果數據存在偏態或有異常值,用中位數(median)**更為穩健。

- 對于類別型特征,可以用眾數(mode)(出現次數最多的值)來填充。

# 用年齡的中位數填充age列的缺失值 age_median = df['age'].median() df['age'].fillna(age_median, inplace=True) # inplace=True直接在原DataFrame上修改# 用登船港口的眾數填充embarked列 embarked_mode = df['embarked'].mode()[0] # mode()返回一個Series,取第一個 df['embarked'].fillna(embarked_mode, inplace=True) - 分組插補:簡單的全局均值/中位數忽略了數據內部的結構。我們可以做得更精細。例如,我們知道不同船艙等級的乘客年齡可能有差異,可以按

pclass分組,用各組的中位數來填充。# 偽代碼演示思想 # df['age'] = df.groupby('pclass')['age'].transform(lambda x: x.fillna(x.median()))

優點:保留了樣本,充分利用了數據。 缺點:可能會低估數據的方差,引入一定偏誤。

- 用均值/中位數/眾數填充:這是最簡單的插補方法。

預測模型插補 這是一種更高級的方法。我們可以將含有缺失值的列作為目標變量(y),其他列作為特征(X),訓練一個機器學習模型(如線性回歸、K近鄰)來預測缺失值。 優點:通常是最準確的插補方法。 缺點:實現復雜,計算成本高。

選擇哪種方法? 這取決于缺失的比例、特征的重要性、數據的內在關系以及你愿意投入的成本。沒有絕對的“最優解”,只有“最合適”的解。

3.2.2 異常值的“辨”與“融”:識別與處理

異常值(Outliers)是指那些與數據集中其余數據點顯著不同的數據點。它們可能是錄入錯誤,也可能是真實但極端的情況。

1. 識別異常值(“辨”)

可視化識別:**箱形圖(Box Plot)**是識別異常值的利器。箱體外的點通常被認為是潛在的異常值。

sns.boxplot(x=df['fare']) plt.show()泰坦尼克票價的箱形圖清楚地顯示了大量的高價異常點。

統計方法識別:

- 3σ法則(3-Sigma Rule):對于近似正態分布的數據,約99.7%的數據點會落在距離均值3個標準差的范圍內。超出這個范圍的點可被視為異常值。

- IQR法則(Interquartile Range):這是箱形圖背后的數學原理。IQR = Q3(上四分位數) - Q1(下四分位數)。通常將小于?

Q1 - 1.5 * IQR?或大于?Q3 + 1.5 * IQR?的點定義為異常值。

2. 處理異常值(“融”)

- 刪除:如果確定異常值是由于錯誤(如年齡輸入為200歲),可以直接刪除。但如果異常值是真實的(如CEO的超高薪水),刪除它們可能會丟失重要信息。

- 轉換(Transformation):對數據進行數學轉換,如對數轉換(log transform),可以“壓縮”數據的尺度,減小異常值的影響。這對于處理右偏分布(如收入、票價)的數據特別有效。

可以看到,對數轉換后的票價分布更接近正態分布。df['fare_log'] = np.log1p(df['fare']) # log1p(x) = log(1+x),避免log(0) sns.histplot(df['fare_log'], kde=True) plt.show() - 蓋帽(Capping/Winsorization):將超出特定閾值(如99百分位數)的異常值,替換為該閾值。這既限制了異常值的極端影響,又保留了它們作為“高值”的信息。

p99 = df['fare'].quantile(0.99) df_capped = df.copy() df_capped.loc[df_capped['fare'] > p99, 'fare'] = p99

處理異常值同樣需要審慎。要結合業務理解,判斷一個“異常”點究竟是噪聲還是有價值的信號。

3.3 “點石成金”:特征工程的科學與藝術

如果說數據清洗是“打掃屋子”,那么特征工程就是“精心裝修”。特征工程是指利用領域知識和技術手段,從原始數據中提取、創造出對預測模型更有用的新特征的過程。 它是決定機器學習項目成敗的最關鍵因素。

3.3.1 特征提取與創造:從原始數據中提煉真金

從現有特征組合: 在泰坦尼克數據中,有

sibsp(兄弟姐妹/配偶數)和parch(父母/子女數)兩個特征。它們都代表了親人。我們可以將它們組合成一個更有意義的新特征——family_size(家庭成員總數)。df['family_size'] = df['sibsp'] + df['parch'] + 1 # +1是加上自己我們還可以根據家庭規模,創造一個類別特征,如

is_alone(是否獨自一人)。df['is_alone'] = (df['family_size'] == 1).astype(int) # astype(int)將布爾值轉為0/1從復雜數據中提取:

- 日期時間:從一個日期

2025-07-18,可以提取出年份、月份、星期幾、是否為周末等多個特征。 - 文本數據:從一段文本中,可以提取詞頻(TF-IDF)、情感傾向、關鍵詞等。

- 乘客姓名(Name):看似無用,但仔細觀察,姓名中包含了

Mr.,?Mrs.,?Miss.,?Master.等稱謂(Title)。這些稱謂反映了乘客的性別、年齡、婚姻狀況和社會地位,可能是非常有用的特征。df['title'] = df['name'].str.extract(' ([A-Za-z]+)\.', expand=False) print(df['title'].value_counts())

- 日期時間:從一個日期

3.3.2 特征縮放與編碼:為模型準備“素食”

大多數機器學習模型都像“挑食的孩子”,它們無法直接“吃”下原始的、五花八門的數據。我們需要將所有特征都處理成它們喜歡的格式——數值型。

1. 類別特征編碼

獨熱編碼(One-Hot Encoding):這是處理名義類別特征(Nominal Feature)(類別間沒有順序關系,如“顏色”:紅、綠、藍)最常用的方法。它會為每個類別創建一個新的二進制(0/1)特征。

# 對'embarked'列進行獨熱編碼 embarked_dummies = pd.get_dummies(df['embarked'], prefix='embarked') df = pd.concat([df, embarked_dummies], axis=1)pd.get_dummies是Pandas中實現獨熱編碼的便捷函數。標簽編碼(Label Encoding)/ 序數編碼(Ordinal Encoding):用于處理有序類別特征(Ordinal Feature)(類別間有明確的順序,如“學歷”:學士、碩士、博士)。它將每個類別映射到一個整數。

# 假設有學歷特征 # mapping = {'學士': 1, '碩士': 2, '博士': 3} # df['education_encoded'] = df['education'].map(mapping)注意:絕對不能對名義類別特征使用標簽編碼,因為這會錯誤地給模型引入一個不存在的順序關系(例如,模型會認為“藍色”比“紅色”大)。

2. 數值特征縮放(Scaling)

許多模型(如線性回歸、SVM、神經網絡)對特征的尺度非常敏感。如果一個特征的范圍是0-10000(如薪水),另一個是0-100(如年齡),模型會不成比例地被薪水這個特征所主導。特征縮放就是將所有特征調整到相似的尺度。

標準化(Standardization / Z-score Normalization):將特征縮放到均值為0,標準差為1的分布。計算公式為

(x - mean) / std。這是最常用、最通用的縮放方法。from sklearn.preprocessing import StandardScaler scaler = StandardScaler() df['age_scaled'] = scaler.fit_transform(df[['age']])歸一化(Normalization / Min-Max Scaling):將特征縮放到一個固定的范圍,通常是****。計算公式為

(x - min) / (max - min)。當數據分布不符合高斯分布,或者你想保留0值時比較有用。from sklearn.preprocessing import MinMaxScaler scaler = MinMaxScaler() df['fare_scaled'] = scaler.fit_transform(df[['fare']])

3.3.3 特征選擇與降維:去蕪存菁,大道至簡

當我們創造了大量特征后,可能會引入冗余或不相關的特征,這會增加模型復雜度,降低泛化能力,甚至導致“維度災難”。因此,我們需要“去蕪存菁”。

1. 特征選擇(Feature Selection)

目標是從所有特征中,選出一個最優的子集。

- 過濾法(Filter Methods):獨立于模型,根據特征本身的統計特性(如相關系數、卡方檢驗、信息增益)來打分和排序,然后選擇得分最高的特征。速度快,但沒有考慮特征間的組合效應。

- 包裝法(Wrapper Methods):將特征選擇過程“包裝”在模型訓練中。它把特征子集的選擇看作一個搜索問題,用模型的性能作為評估標準來尋找最優子集。例如,遞歸特征消除(Recursive Feature Elimination, RFE)。效果好,但計算成本高。

- 嵌入法(Embedded Methods):將特征選擇嵌入到模型構建的過程中。例如,**L1正則化(如Lasso回歸)**在訓練時會自動將不重要特征的系數懲罰為0,從而實現了自動的特征選擇。這是目前非常推崇的方法。

2. 降維(Dimensionality Reduction)

降維不是簡單地“選擇”特征,而是通過線性或非線性變換,將高維數據投影到低維空間,同時盡可能多地保留原始數據的信息,創造出全新的、更少的特征。

- 主成分分析(Principal Component Analysis, PCA):這是最經典的線性降維方法。它的思想是,尋找一個新的坐標系,使得數據在第一個新坐標軸(第一主成分)上的方差最大,在第二個新坐標軸(第二主成分)上的方差次之,且與第一個正交,以此類推。然后我們只保留前k個方差最大的主成分,就實現了降維。 PCA在數據可視化(將高維數據降到2D或3D進行觀察)和消除多重共線性方面非常有用。我們將在后續章節中更詳細地學習和實踐它。

結語

本章,我們完成了一次從“原始數據”到“精煉特征”的完整修行。我們學會了如何與數據對話(EDA),如何為數據“沐浴更衣”(清洗),以及如何為其“梳妝打扮”(特征工程)。

請牢記,特征工程是機器學習中創造力和領域知識價值最大的體現。好的特征,能讓簡單的模型大放異彩;而差的特征,即使是再強大的模型也無力回天。

現在,我們的數據已經準備就緒,可以隨時“喂”給模型了。下一章,我們將正式開啟各類主流機器學習模型的學習之旅,將這些精心準備的“食材”,烹飪成一道道美味的“算法大餐”。

第四章:模型的羅盤——評估與選擇

- 4.1 “度量衡”:分類、回歸與聚類模型的評估指標

- 4.2 “執其兩端而用中”:偏差與方差的權衡

- 4.3 “他山之石”:交叉驗證的智慧

- 4.4 “尋路”:網格搜索與超參數調優

經過前三章的修煉,我們已經學會了搭建環境、駕馭工具,并掌握了數據的“心法”。我們手中已經有了經過精心提煉的“燃料”——干凈、規整的特征。現在,是時候將這些燃料注入各種強大的“引擎”——機器學習模型了。

但在我們一頭扎進形形色色的算法海洋之前,一個至關重要的問題擺在面前:我們如何判斷一個模型是好是壞?

在兩個模型之間,我們如何客觀地選擇那個更好的?一個模型在訓練數據上表現完美,我們就能相信它在未來的新數據上同樣出色嗎?如何為模型選擇最佳的“配置參數”,讓其發揮最大潛能?

本章,便是解答這些問題的“羅盤”。我們將系統地學習模型評估與選擇的完整框架。首先,我們會為不同類型的任務(分類、回歸、聚類)建立一套精確的“度量衡”,即評估指標。接著,我們將深入探討所有模型都無法回避的兩個核心矛盾——偏差與方差,并學習如何通過學習曲線來診斷它們。隨后,我們將掌握交叉驗證這一強大的技術,以獲得對模型性能更穩定、更可靠的評估。最后,我們將學習如何像一位經驗豐富的工程師一樣,系統地為模型尋找最優的超參數。

掌握本章內容,您將擁有一雙“慧眼”,能夠洞悉模型的內在狀態,科學地評估其優劣,并自信地做出選擇。這是從“會用模型”到“用好模型”的關鍵一步。

4.1 “度量衡”:分類、回歸與聚類模型的評估指標

沒有度量,就無法優化。評估指標,就是我們衡量模型性能的尺子。不同的任務,需要用不同的尺子來量。我們不能用量身高的尺子去量體重,同樣,我們也不能用回歸的指標去評估分類模型。

4.1.1 分類任務的“是非題”:混淆矩陣的深層解讀

分類任務是最常見的機器學習問題之一。其輸出是離散的類別,如“是/否”、“貓/狗/鳥”、“A/B/C類”。對于最基礎的二元分類問題(例如,判斷一封郵件是否為垃圾郵件),模型的所有預測結果可以歸入四種情況。這四種情況共同構成了一個名為**混淆矩陣(Confusion Matrix)**的表格,它是幾乎所有分類評估指標的基石。

基本概念:真正例(TP)、假正例(FP)、真負例(FN)、假負例(TN)

我們以一個“AI醫生”判斷病人是否患有某種疾病(“陽性”為患病,“陰性”為健康)的場景為例來理解這四個概念:

- 真正例 (True Positive, TP):病人確實患病(真實為正),AI醫生也正確地預測其為陽性(預測為正)。——?判斷正確

- 假正例 (False Positive, FP):病人其實很健康(真實為負),但AI醫生卻錯誤地預測其為陽性(預測為正)。這是“誤報”,也稱為第一類錯誤 (Type I Error)。——?判斷錯誤

- 真負例 (True Negative, TN):病人確實很健康(真實為負),AI醫生也正確地預測其為陰性(預測為負)。——?判斷正確

- 假負例 (False Negative, FN):病人其實患有該病(真實為正),但AI醫生卻錯誤地預測其為陰性(預測為負)。這是“漏報”,也稱為第二類錯誤 (Type II Error)。——?判斷錯誤

這四者可以用一個2x2的矩陣清晰地展示出來:

預測為正 (Predicted: 1) | 預測為負 (Predicted: 0) | |

|---|---|---|

真實為正 (Actual: 1) | TP (真正例) | FN (假負例) |

真實為負 (Actual: 0) | FP (假正例) | TN (真負例) |

在Scikit-learn中,我們可以輕松計算混淆矩陣:

from sklearn.metrics import confusion_matrix

from sklearn.linear_model import LogisticRegression

from sklearn.model_selection import train_test_split

import pandas as pd

import seaborn as sns

import matplotlib.pyplot as plt# 使用上一章處理過的泰坦尼克數據(假設已完成缺失值填充和編碼)

# 為了演示,我們簡化一下特征

df = sns.load_dataset('titanic')

# ... (此處省略上一章的數據清洗和特征工程代碼) ...

# 假設我們得到了一個可用的df_processed,包含特征X和目標y

# X = df_processed[['pclass', 'age_scaled', 'fare_scaled', 'is_alone', ...]]

# y = df_processed['survived']# 偽代碼演示流程

# X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.3, random_state=42)

# model = LogisticRegression()

# model.fit(X_train, y_train)

# y_pred = model.predict(X_test)# 假設我們有真實值y_test和預測值y_pred

y_test = pd.Series([1, 0, 0, 1, 0, 1, 0, 1, 1, 0]) # 真實標簽

y_pred = pd.Series([1, 0, 1, 1, 0, 0, 0, 1, 1, 0]) # 模型預測cm = confusion_matrix(y_test, y_pred)

print("混淆矩陣:\n", cm)# 可視化混淆矩陣

sns.heatmap(cm, annot=True, fmt='d', cmap='Blues')

plt.xlabel('Predicted Label')

plt.ylabel('True Label')

plt.show()

混淆矩陣本身信息量巨大,但不夠直觀,我們需要從中提煉出更易于比較的單一數值指標。

從混淆矩陣到核心指標:準確率、精確率、召回率、F1分數

準確率 (Accuracy)

- 定義:預測正確的樣本數占總樣本數的比例。

- 公式:

(TP + TN) / (TP + TN + FP + FN) - 解讀:這是最直觀的指標,衡量了模型“整體上做對了多少”。

- 陷阱:在數據不平衡的場景下,準確率具有極大的誤導性。例如,在一個99%的郵件都是正常郵件的數據集中,一個無腦地將所有郵件都預測為“正常”的模型,其準確率高達99%,但它毫無用處,因為它一個垃圾郵件都找不出來。

精確率 (Precision)

- 定義:在所有被預測為正例的樣本中,有多少是真正的正例。

- 公式:

TP / (TP + FP) - 解讀:它衡量的是模型的“查準率”。高精確率意味著“我預測你是正例,你大概率真的是正例”。它關心的是預測結果的質量。

- 應用場景:對“誤報”懲罰很高的場景。例如,垃圾郵件過濾,我們不希望把重要的正常郵件(如面試通知)錯誤地判為垃圾郵件(FP),此時精確率比召回率更重要。

召回率 (Recall / Sensitivity / True Positive Rate)

- 定義:在所有真實為正例的樣本中,有多少被模型成功地預測了出來。

- 公式:

TP / (TP + FN) - 解讀:它衡量的是模型的“查全率”。高召回率意味著“所有真實的正例,我基本都找出來了”。它關心的是對真實正例的覆蓋能力。

- 應用場景:對“漏報”懲罰很高的場景。例如,在疾病診斷或金融欺詐檢測中,我們寧可“誤報”一些健康人或正常交易(FP較高,精確率下降),也絕不希望“漏掉”一個真正的病人或欺詐行為(FN很低,召回率高)。

F1分數 (F1-Score)

- 定義:精確率和召回率的調和平均數。

- 公式:

2 * (Precision * Recall) / (Precision + Recall) - 解讀:它是一個綜合性指標,試圖在精確率和召回率之間找到一個平衡。只有當兩者都比較高時,F1分數才會高。

- 應用場景:當你希望同時關注精確率和召回率,或者當兩者存在矛盾時,F1分數是一個很好的參考。

在Scikit-learn中,這些指標都可以輕松計算:

from sklearn.metrics import accuracy_score, precision_score, recall_score, f1_score, classification_reportprint("Accuracy:", accuracy_score(y_test, y_pred))

print("Precision:", precision_score(y_test, y_pred))

print("Recall:", recall_score(y_test, y_pred))

print("F1 Score:", f1_score(y_test, y_pred))# 或者使用classification_report一次性輸出所有指標

print("\nClassification Report:\n", classification_report(y_test, y_pred))

精確率與召回率的權衡:在“寧可錯殺”與“絕不放過”之間

精確率和召回率通常是一對“矛盾”的指標。

想象一下,模型在內部并不是直接輸出“0”或“1”,而是輸出一個“是正例的概率”(0到1之間)。我們通過設定一個**閾值(Threshold)**來做出最終判斷,例如,默認閾值是0.5,概率>0.5就判為1,否則為0。

如果我們提高閾值(例如,提高到0.9),模型會變得非常“謹慎”。只有非常有把握的才判為正例。這樣,FP會減少,精確率會提高;但同時,很多“有點像但把握不大”的正例會被漏掉(FN增加),導致召回率下降。這對應了“寧可錯殺一千,絕不放過一個(敵人)”的反面,即“寧可放過(漏掉)一些可疑分子,也要保證抓到的都是鐵證如山的真兇”。

如果我們降低閾值(例如,降低到0.1),模型會變得非常“激進”。只要有一點點像正例,就判為正例。這樣,FN會減少,召回率會提高;但同時,很多負例會被誤判為正例(FP增加),導致精確率下降。這對應了“寧可錯殺一千,絕不放過一個”的策略。

理解這種權衡關系至關重要。在實際應用中,我們需要根據業務需求,選擇一個合適的閾值,來平衡精確率和召回率。而**精確率-召回率曲線(P-R Curve)**正是可視化這種權衡的工具。

精確率與召回率的權衡:在“寧可錯殺”與“絕不放過”之間

精確率和召回率通常是一對“矛盾”的指標,它們之間存在一種此消彼長的權衡關系。理解這種權衡,是做出有效業務決策的關鍵。

想象一下,大多數分類模型(如邏輯回歸、神經網絡)在內部并不是直接輸出“0”或“1”的硬性類別,而是輸出一個“樣本屬于正例的概率”,這是一個介于0和1之間的連續值。我們最終看到的“0”或“1”的預測結果,是這個概率值與一個我們設定的**決策閾值(Decision Threshold)**比較得來的。默認情況下,這個閾值通常是0.5。

- 如果?

模型輸出概率 > 閾值,則預測為正例(1)。- 如果?

模型輸出概率 <= 閾值,則預測為負例(0)。

現在,讓我們看看調整這個閾值會發生什么:

提高決策閾值(例如,從0.5提高到0.9):

- 影響:模型會變得非常“保守”或“挑剔”。只有當它“極度確信”一個樣本是正例時(概率高達90%以上),才會將其預測為正例。

- 結果:

- 大量的“疑似”正例會被劃為負例,導致假負例(FN)增加,從而召回率(Recall)急劇下降。

- 由于標準嚴苛,被預測為正例的樣本,其“含金量”會很高,假正例(FP)會減少,從而精確率(Precision)會提高。

- 類比:“寧可放過一千,不可錯殺一人”。適用于對誤報(FP)容忍度極低的場景,如向用戶推送高價值但打擾性強的廣告。

降低決策閾值(例如,從0.5降低到0.1):

- 影響:模型會變得非常“激進”或“敏感”。只要有一點點可能是正例的跡象(概率超過10%),它就會將其預測為正例。

- 結果:

- 大量的“疑似”正例會被成功捕獲,假負例(FN)會減少,從而召回率(Recall)會提高。

- 由于標準寬松,很多負例會被錯誤地劃入正例,假正例(FP)會增加,從而精確率(Precision)會下降。

- 類比:“寧可錯殺一千,不可放過一個”。適用于對漏報(FN)容忍度極低的場景,如癌癥篩查。

精確率-召回率曲線(Precision-Recall Curve, P-R Curve) 為了系統地觀察這種權衡關系,我們可以繪制P-R曲線。該曲線的橫坐標是召回率,縱坐標是精確率。它是通過從高到低移動決策閾值,在每個閾值下計算一組(Recall, Precision)值,然后將這些點連接而成。

from sklearn.metrics import precision_recall_curve# 假設model已經訓練好,并且可以輸出概率

# y_scores = model.predict_proba(X_test)[:, 1] # 獲取正例的概率# 偽代碼演示

y_test = pd.Series([1, 0, 0, 1, 0, 1, 0, 1, 1, 0])

y_scores = pd.Series([0.9, 0.4, 0.6, 0.8, 0.3, 0.45, 0.2, 0.85, 0.7, 0.1]) # 模型輸出的概率precisions, recalls, thresholds = precision_recall_curve(y_test, y_scores)plt.figure(figsize=(8, 6))

plt.plot(recalls, precisions, marker='.')

plt.xlabel('Recall')

plt.ylabel('Precision')

plt.title('Precision-Recall Curve')

plt.grid(True)

plt.show()

一根理想的P-R曲線會盡可能地靠近右上角(即在相同的召回率下,精確率盡可能高)。曲線下方的面積(AUC-PR)也可以作為一個綜合評估指標,面積越大,模型性能越好。

4.1.2 超越單一閾值:ROC曲線與AUC值的“全局觀”

P-R曲線非常適合評估在不平衡數據集上的模型性能。但還有一個更常用、更通用的評估工具——ROC曲線(Receiver Operating Characteristic Curve)。

ROC曲線的繪制:真正例率(TPR) vs. 假正例率(FPR)

ROC曲線描繪了兩個關鍵指標之間的關系:

- 真正例率 (True Positive Rate, TPR):這其實就是我們已經學過的召回率(Recall)。它衡量模型“抓住了多少真病人”。

TPR = TP / (TP + FN)

- 假正例率 (False Positive Rate, FPR):它衡量的是,在所有真實的負例中,有多少被模型錯誤地預測為了正例。

FPR = FP / (FP + TN)

ROC曲線的繪制過程與P-R曲線類似,也是通過不斷移動決策閾值,在每個閾值下計算一組(FPR, TPR)值,然后將這些點連接而成。

AUC的含義:模型整體排序能力的量化

ROC曲線解讀:

- 曲線上的每個點代表一個特定的決策閾值。

- 左下角(0,0)點:閾值設為1,模型將所有樣本都預測為負,TPR和FPR都為0。

- 右上角(1,1)點:閾值設為0,模型將所有樣本都預測為正,TPR和FPR都為1。

- 左上角(0,1)點:理想的完美模型,FPR為0(沒有誤報),TPR為1(沒有漏報)。

- 對角線(y=x):代表一個“隨機猜測”模型。一個有價值的模型,其ROC曲線必須在對角線上方。

- 曲線越靠近左上角,說明模型在相同的“誤報成本”(FPR)下,能獲得更高的“查全率”(TPR),性能越好。

AUC (Area Under the Curve): AUC值就是ROC曲線下方的面積。它是一個介于0和1之間的數值。

- AUC = 1:完美分類器。

- AUC = 0.5:隨機猜測模型。

- AUC < 0.5:模型性能差于隨機猜測(可能把標簽搞反了)。

- 0.5 < AUC < 1:模型具有一定的預測價值,值越大越好。

AUC有一個非常直觀的統計學解釋:它等于從所有正例中隨機抽取一個樣本,再從所有負例中隨機抽取一個樣本,該模型將正例的預測概率排在負例之前的概率。 因此,AUC衡量的是模型整體的排序能力,而不依賴于某個特定的決策閾值。

from sklearn.metrics import roc_curve, auc# y_scores 同樣是模型輸出的正例概率

fpr, tpr, thresholds = roc_curve(y_test, y_scores)

roc_auc = auc(fpr, tpr)plt.figure(figsize=(8, 6))

plt.plot(fpr, tpr, color='darkorange', lw=2, label=f'ROC curve (area = {roc_auc:.2f})')

plt.plot([0, 1], [0, 1], color='navy', lw=2, linestyle='--') # 繪制對角線

plt.xlim([0.0, 1.0])

plt.ylim([0.0, 1.05])

plt.xlabel('False Positive Rate')

plt.ylabel('True Positive Rate')

plt.title('Receiver Operating Characteristic')

plt.legend(loc="lower right")

plt.grid(True)

plt.show()

何時關注ROC/AUC,何時關注P-R曲線

- 當正負樣本分布相對均衡時,ROC/AUC是一個非常穩定且全面的評估指標。

- 當處理嚴重的數據不平衡問題時,P-R曲線通常能提供更多的信息。因為在極不平衡的數據中,FPR的分母(FP+TN)由于TN數量巨大,即使FP顯著增加,FPR的變化也可能不明顯,導致ROC曲線呈現出過于“樂觀”的結果。而P-R曲線的兩個指標(Precision和Recall)都聚焦于正例,對正例的預測變化更為敏感。

4.1.3 回歸任務的“度量尺”:衡量預測的“遠近”

回歸任務的目標是預測一個連續值,如房價、氣溫。評估回歸模型,就是衡量預測值與真實值之間的“距離”或“誤差”。

誤差的基本度量:MAE, MSE, RMSE

假設真實值為 y,預測值為 ?。

平均絕對誤差 (Mean Absolute Error, MAE)

- 公式:

1/n * Σ|y - ?| - 解讀:計算每個樣本的預測誤差的絕對值,然后取平均。它直接反映了預測誤差的平均大小,單位與目標變量相同,易于理解。

- 公式:

均方誤差 (Mean Squared Error, MSE)

- 公式:

1/n * Σ(y - ?)2 - 解讀:計算每個樣本的預測誤差的平方,然后取平均。由于平方的存在,MSE對較大的誤差(離群點)給予了更高的權重。如果你的業務場景中,大的誤差是不可接受的,那么MSE是一個很好的懲罰指標。但其單位是目標變量單位的平方,不易解釋。

- 公式:

均方根誤差 (Root Mean Squared Error, RMSE)

- 公式:

sqrt(MSE) - 解讀:它就是MSE開根號。這樣做的好處是,其單位與目標變量恢復一致,同時保留了MSE對大誤差敏感的特性。RMSE可能是回歸任務中最常用的評估指標。

- 公式:

from sklearn.metrics import mean_absolute_error, mean_squared_errory_true_reg = [3, -0.5, 2, 7]

y_pred_reg = [2.5, 0.0, 2, 8]mae = mean_absolute_error(y_true_reg, y_pred_reg)

mse = mean_squared_error(y_true_reg, y_pred_reg)

rmse = np.sqrt(mse)print(f"MAE: {mae}")

print(f"MSE: {mse}")

print(f"RMSE: {rmse}")

相對度量:R2 (決定系數)的解釋與誤區

- R2 (R-squared / Coefficient of Determination)

- 公式:

1 - (Σ(y - ?)2) / (Σ(y - ?)2)?,其中???是真實值的平均值。 - 解讀:R2衡量的是模型所解釋的因變量方差的比例。通俗地說,它表示你的模型在多大程度上“解釋”了數據的變動。

- R2 = 1:模型完美預測了所有數據。

- R2 = 0:模型的表現等同于一個“基準模型”,這個基準模型總是預測所有樣本的值為真實值的平均數。

- R2 < 0:模型表現比基準模型還差。

- 優點:提供了一個相對的性能度量(0%到100%),不受目標變量尺度的影響。

- 誤區:R2有一個致命缺陷——當你向模型中添加任何新的特征時,即使這個特征毫無用處,R2的值也幾乎總是會增加或保持不變,絕不會下降。這使得它在比較包含不同數量特征的模型時具有誤導性。為此,**調整R2 (Adjusted R-squared)**被提出,它對特征的數量進行了懲罰,是一個更公允的指標。

- 公式:

4.1.4 無監督任務的“內省”:聚類效果的評估

評估聚類(Clustering)這類無監督任務比監督學習更具挑戰性,因為我們通常沒有“正確答案”(真實標簽)。評估方法分為兩類:

有真實標簽時(外部評估)

在某些特殊情況(如學術研究或驗證算法),我們手頭有數據的真實類別。此時,我們可以比較聚類結果和真實標簽的吻合程度。

- 蘭德指數 (Rand Index, RI):衡量兩組聚類(預測的和真實的)中,所有“點對”分類一致性的比例。

- 互信息 (Mutual Information, MI):從信息論角度衡量兩組聚類共享的信息量。

無真實標簽時(內部評估)

這是更常見的情況。內部評估僅利用數據本身和聚類結果來進行。

輪廓系數 (Silhouette Coefficient):這是最常用、最直觀的內部評估指標。它為每一個樣本計算一個輪廓分數,該分數衡量:

a: 該樣本與其所在簇內其他所有點的平均距離(簇內凝聚度)。b: 該樣本與距離它最近的下一個簇內所有點的平均距離(簇間分離度)。- 輪廓分數 =?

(b - a) / max(a, b) - 解讀:

- 分數接近?+1:說明樣本遠離相鄰簇,很好地被分配到了當前簇(凝聚度和分離度都好)。

- 分數接近?0:說明樣本位于兩個簇的邊界上。

- 分數接近?-1:說明樣本可能被分配到了錯誤的簇。

- 整個數據集的輪廓系數是所有樣本輪廓分數的平均值。

Calinski-Harabasz指數 (CH Index):通過計算簇間散度與簇內散度的比值來評估。比值越大,意味著簇間分離得越遠,簇內凝聚得越緊,聚類效果越好。

from sklearn.metrics import silhouette_score

from sklearn.cluster import KMeans# 假設X_cluster是待聚類的數據

# kmeans = KMeans(n_clusters=3, random_state=42, n_init=10)

# labels = kmeans.fit_predict(X_cluster)

# score = silhouette_score(X_cluster, labels)

# print(f"Silhouette Score: {score}")

4.2 “執其兩端而用中”:偏差與方差的權衡

掌握了評估指標,我們就有了一把尺子。但有時我們會發現,模型在一個數據集上表現優異,換個數據集就一塌糊涂。這背后,是所有監督學習模型都必須面對的一對核心矛盾——偏差(Bias)與方差(Variance)。

4.2.1 模型的兩種“原罪”:偏差(Bias)與方差(Variance)

想象我們用不同的訓練數據集(來自同一數據源)多次訓練同一個模型,然后去預測同一個測試點。

- 偏差:描述的是模型所有預測值的平均值與真實值之間的差距。高偏差意味著模型系統性地偏離了真相。

- 方差:描述的是模型不同次預測值之間的離散程度或散布范圍。高方差意味著模型對訓練數據的微小變化極其敏感。

一個好的模型,應該既沒有系統性的偏離(低偏差),又對數據的擾動不那么敏感(低方差)。

偏差:模型對真相的“固有偏見”

高偏差的根本原因是模型過于簡單,無法捕捉數據中復雜的真實規律。它就像一個固執的“老學究”,腦子里只有幾條簡單的規則(如一條直線),試圖用它去解釋一個復雜的世界(如一條曲線)。無論給他多少數據,他都堅持自己的“偏見”。

方差:模型對數據的“過度敏感”

高方差的根本原因是模型過于復雜,它不僅學習了數據中普適的規律,還把訓練數據中的噪聲和隨機性也當作了“真理”來學習。它就像一個“書呆子”,把訓練集這本“教科書”背得滾瓜爛熟,每一個細節都記得清清楚楚,但缺乏舉一反三的能力。換一本“模擬試卷”(測試集),他就傻眼了。

4.2.2 欠擬合與過擬合:模型學習的“執念”與“妄念”

偏差和方差的概念,最終體現在模型的兩種常見狀態上:

欠擬合(Underfitting):學得太少,想得太簡單(高偏差)

- 表現:模型在訓練集上的表現就很差,在測試集上的表現同樣很差。

- 原因:通常是模型復雜度太低(如用線性模型去擬合非線性數據),或者特征太少。

過擬合(Overfitting):學得太細,想得太復雜(高方差)

- 表現:模型在訓練集上表現極好,甚至接近完美,但在測試集上的表現卻大幅下降。訓練集和測試集性能之間存在巨大鴻溝。

- 原因:通常是模型復雜度過高(如一個深度很深的決策樹),或者數據量相對于模型復雜度來說太少。

偏差-方差權衡(Bias-Variance Trade-off): 模型復雜度與這兩者之間存在一個U型關系。

- 非常簡單的模型:高偏差,低方差。

- 非常復雜的模型:低偏差,高方差。 我們的目標,是在這個U型曲線的谷底找到一個平衡點,使得總誤差(約等于 偏差2 + 方差)最小。

4.2.3 診斷之道:學習曲線的可視化解讀

如何判斷我們的模型正處于欠擬合、過擬合還是理想狀態?**學習曲線(Learning Curves)**是一個強大的診斷工具。

學習曲線展示的是,隨著訓練樣本數量的增加,模型的訓練集得分和驗證集得分如何變化。

繪制學習曲線:訓練集與驗證集得分隨樣本量變化的軌跡

from sklearn.model_selection import learning_curve# model = LogisticRegression() # 或其他任何模型

# train_sizes, train_scores, validation_scores = learning_curve(

# estimator=model,

# X=X, y=y,

# train_sizes=np.linspace(0.1, 1.0, 10), # 訓練樣本的比例

# cv=5, # 交叉驗證折數

# scoring='accuracy' # 評估指標

# )# # 計算均值和標準差

# train_scores_mean = np.mean(train_scores, axis=1)

# validation_scores_mean = np.mean(validation_scores, axis=1)# # 繪制曲線

# plt.plot(train_sizes, train_scores_mean, 'o-', color="r", label="Training score")

# plt.plot(train_sizes, validation_scores_mean, 'o-', color="g", label="Cross-validation score")

# plt.title("Learning Curve")

# plt.xlabel("Training examples")

# plt.ylabel("Score")

# plt.legend(loc="best")

# plt.grid()

# plt.show()

從曲線形態診斷模型是“欠”還是“過”

理想狀態:

- 隨著樣本增加,訓練得分和驗證得分都逐漸升高并最終收斂。

- 收斂時,兩條曲線靠得很近,且得分都很高。

高偏差(欠擬合):

- 兩條曲線很早就收斂了,且收斂到一個比較低的得分水平。

- 兩條曲線靠得很近。

- 解讀:模型太簡單了,即使給它再多的數據,它也學不到更多東西了。性能的瓶頸在于模型本身。

高方差(過擬合):

- 訓練得分一直很高,而驗證得分一直比較低。

- 兩條曲線之間存在明顯的、持續的差距(Gap)。

- 解讀:模型在訓練集上“死記硬背”,但泛化能力差。好消息是,隨著樣本量的增加,這個差距有縮小的趨勢,說明增加數據量可能有助于緩解過擬合。

4.2.4 應對之策:降低偏差與方差的常用策略

解決高偏差(欠擬合):

- 增加模型復雜度:換用更強大的模型(如從線性模型換到梯度提升樹或神經網絡)。

- 獲取或創造更多特征:讓模型有更多的信息來源來學習。

- 減少正則化:正則化是用來對抗過擬合的,如果模型已經欠擬合,應減小正則化強度。

解決高方差(過擬合):

- 增加數據量:這是最有效但往往也最昂貴的方法。

- 降低模型復雜度:使用更簡單的模型,或者減少現有模型的參數(如降低決策樹的深度)。

- 正則化(Regularization):在損失函數中加入一個懲罰項,對模型的復雜性(如大的權重)進行懲罰。L1和L2正則化是經典方法。

- 特征選擇/降維:移除不相關或冗余的特征。

- 集成學習(Ensemble Methods):如Bagging(隨機森林),通過平均多個不同模型的結果來降低方差。

- Dropout(主要用于神經網絡):在訓練過程中隨機“丟棄”一部分神經元,強迫網絡學習更魯棒的特征。

4.3 “他山之石”:交叉驗證的智慧

在診斷模型的過程中,我們反復提到了“驗證集”。一個常見的做法是將數據一次性劃分為訓練集、驗證集和測試集。但這種方法存在一個嚴重問題。

4.3.1 為何需要交叉驗證?簡單“訓練/測試集”劃分的陷阱

- 數據劃分的偶然性:你碰巧分到驗證集里的數據可能特別“簡單”或特別“困難”,導致你對模型性能的評估過于樂觀或悲觀。換一種隨機劃分方式,結果可能截然不同。

- 評估結果的不穩定:基于一次劃分的評估結果,其隨機性太大,不夠可靠。

- 數據浪費:在數據量本就不多的情況下,留出一部分數據只用于驗證,是一種浪費。

交叉驗證(Cross-Validation, CV)正是為了解決這些問題而生的智慧。

4.3.2 K-折交叉驗證(K-Fold Cross-Validation):讓每一份數據都發光

K-折交叉驗證是應用最廣泛的交叉驗證技術。

K-折的執行流程:分割、訓練、驗證、取平均

- 分割:將整個訓練數據集隨機地、不重復地劃分為K個大小相似的子集(稱為“折”,Fold)。

- 循環:進行K次循環,在每一次循環中:

- 取其中1個折作為驗證集。

- 取其余的K-1個折合并作為訓練集。

- 在該訓練集上訓練模型,并在該驗證集上進行評估,得到一個性能得分。

- 取平均:將K次循環得到的K個性能得分進行平均,得到最終的、更穩健的交叉驗證得分。

優點:

- 所有數據都參與了訓練和驗證,數據利用率高。

- 得到的評估結果是K次評估的平均值,大大降低了偶然性,更為穩定和可靠。

如何選擇合適的K值?

K的常用取值是5或10。

- K值較小(如3):每次訓練的數據量較少(2/3),驗證集較大(1/3)。偏差較高,方差較低,計算成本也低。

- K值較大(如10):每次訓練的數據量較多(9/10),更接近于在全部數據上訓練。偏差較低,但由于不同折的訓練集重合度高,K個模型會比較相似,導致最終評估結果的方差可能較高。計算成本也更高。

4.3.3 特殊場景下的變體:分層K-折與留一法

分層K-折(Stratified K-Fold):處理不平衡分類問題的利器

在分類問題中,如果直接用標準K-Fold,可能會出現某個折中正例或負例的比例與整體數據集差異很大的情況,甚至某個折中完全沒有某個類別的樣本。

分層K-折在進行數據劃分時,會確保每一個折中各個類別的樣本比例都與原始數據集中相應類別的比例大致相同。在處理不平衡分類問題時,這幾乎是必須使用的交叉驗證方法。

留一法(Leave-One-Out, LOO):K-折的極端形式及其優缺點

留一法是K-折交叉驗證的一個特例,即K=N(N為樣本總數)。每次只留下一個樣本作為驗證集,其余N-1個樣本都作為訓練集。

- 優點:數據利用率最高,評估結果的偏差最低。

- 缺點:計算成本極高(需要訓練N個模型),且評估結果的方差通常也較高。一般只在數據集非常小的情況下使用。

4.4 “尋路”:網格搜索與超參數調優

我們已經知道如何可靠地評估一個模型了。但一個模型的性能,還受到另一類參數的深刻影響——超參數。

4.4.1 參數 vs. 超參數:模型自身的“修行”與我們施加的“點化”

- 參數 (Parameters):模型從數據中學習得到的值。例如,線性回歸的權重

w和偏置b。我們無法手動設置它們,它們是訓練過程的結果。 - 超參數 (Hyperparameters):我們在模型訓練之前手動設置的參數。它們是模型的“配置選項”,控制著學習過程的行為。例如:

- K近鄰算法中的

K值。 - 決策樹的

max_depth(最大深度)。 - SVM中的懲罰系數

C和核函數kernel。 - 神經網絡的學習率

learning_rate。

- K近鄰算法中的

超參數調優(Hyperparameter Tuning)的目的,就是為我們的模型找到一組能使其性能最佳的超參數組合。

4.4.2 傳統的尋路者:網格搜索(Grid Search)

網格搜索是一種簡單粗暴但有效的超參數搜索方法。

定義參數網格與暴力搜索

- 定義網格:為每一個你想要調優的超參數,定義一個候選值列表。這些列表組合在一起,就形成了一個多維的“網格”。

- 暴力搜索:遍歷網格中每一個可能的超參數組合。對每一個組合,使用交叉驗證來評估其性能。

- 選擇最優:選擇那個在交叉驗證中平均得分最高的超參數組合。

網格搜索與交叉驗證的結合(GridSearchCV)

Scikit-learn提供了GridSearchCV這個強大的工具,將網格搜索和交叉驗證完美地結合在了一起。

from sklearn.model_selection import GridSearchCV

from sklearn.svm import SVC# 1. 定義模型

model = SVC()# 2. 定義超參數網格

param_grid = {'C': [0.1, 1, 10, 100],'gamma': [1, 0.1, 0.01, 0.001],'kernel': ['rbf', 'linear']

}# 3. 創建GridSearchCV對象

# cv=5表示使用5折交叉驗證

grid_search = GridSearchCV(estimator=model, param_grid=param_grid, cv=5, scoring='accuracy', verbose=2)# 4. 執行搜索 (在訓練數據上)

# grid_search.fit(X_train, y_train)# 5. 查看最佳參數和最佳得分

# print("Best Parameters:", grid_search.best_params_)

# print("Best Score:", grid_search.best_score_)# 6. 獲取最佳模型

# best_model = grid_search.best_estimator_

網格搜索的“維度詛咒”

網格搜索的主要缺點是計算成本高。如果超參數數量增多,或者每個超參數的候選值增多,需要嘗試的組合數量會呈指數級增長,這就是所謂的“維度詛咒”。

4.4.3 更聰明的探索者:隨機搜索(Random Search)

隨機搜索是對網格搜索的一個簡單而又常常更高效的替代方案。

從“地毯式”到“撒胡椒面式”的轉變

隨機搜索不再嘗試所有可能的組合,而是在指定的參數分布(如一個列表或一個連續分布)中,隨機地采樣固定數量(由n_iter參數指定)的超參數組合。

為何隨機搜索常常更高效?

研究表明,對于很多模型來說,其性能主要由少數幾個“關鍵”超參數決定。

- 網格搜索可能會在那些不重要的超參數上浪費大量時間進行精細的、不必要的嘗試。

- 隨機搜索則更有可能在相同的計算預算內,在那些“關鍵”超參數上探索到更多樣化的值,從而有更大幾率找到一個優秀的組合。

在Scikit-learn中,使用RandomizedSearchCV,其用法與GridSearchCV非常相似。

4.4.4 前沿的向導:貝葉斯優化等高級方法簡介

當超參數搜索的成本極高時(例如,訓練一個深度學習模型可能需要數天),網格搜索和隨機搜索這種“盲目”的探索就顯得效率低下了。

貝葉斯優化的思想:利用先驗信息指導下一次嘗試

貝葉斯優化是一種更智能的搜索策略。它將超參數與模型性能的關系看作一個需要學習的函數。

- 它首先嘗試幾個隨機點。

- 然后,它根據已有的(超參數組合,性能得分)結果,建立一個概率模型(代理模型),來“猜測”這個未知函數的樣子。

- 接著,它利用這個代理模型,去選擇下一個最有可能帶來性能提升的超參數組合進行嘗試(而不是隨機選)。

- 不斷重復2和3,直到達到預設的迭代次數。

它就像一個聰明的探礦者,會根據已經挖到的礦石信息,來判斷下一鏟子應該挖在哪里,而不是到處亂挖。

何時考慮使用更高級的調優方法

當單次模型評估的成本非常高昂,且超參數空間復雜時,就應該考慮使用貝葉斯優化(如hyperopt, scikit-optimize等庫)或其更先進的變體。

結語

本章,我們打造了一套完整的模型評估與選擇的“羅盤”。我們學會了如何用精確的“度量衡”來衡量模型,如何洞察“偏差與方差”這對核心矛盾,如何用“交叉驗證”的智慧獲得可靠的評估,以及如何用“網格/隨機搜索”的策略為模型找到最佳的“配置”。

這套框架是獨立于任何具體模型的通用方法論。掌握了它,您就擁有了在算法海洋中自信航行的能力。從下一章開始,我們將正式揚帆起航,逐一探索那些主流的機器學習模型。屆時,本章所學的一切,都將成為我們評估、診斷和優化這些模型的強大武器。

第二部分:術法萬千——主流機器學習模型詳解

核心目標: 深入剖析各類主流算法的原理、數學基礎和代碼實現。強調每個模型的適用場景、優缺點,并結合實例進行“庖丁解牛”式的講解。

第五章:監督學習之“判別”——分類算法

- 5.1 邏輯回歸:看似回歸,實為分類的智慧

- 5.2 K-近鄰(KNN):“物以類聚,人以群分”的樸素哲學

- 5.3 支撐向量機(SVM):“一劃開天”的數學之美

- 5.4 決策樹與隨機森林:“集思廣益”的集成智慧

- 5.5 樸素貝葉斯:“執果索因”的概率思維

歡迎來到機器學習的核心腹地。從本章開始,我們將學習具體的算法,將前幾章的理論、工具與方法論付諸實踐。我們將從監督學習中的**分類(Classification)**任務開始。分類,顧名思義,就是讓機器學會“分辨類別”,它旨在預測一個離散的目標變量。

生活中的分類問題無處不在:判斷一封郵件是否為垃圾郵件,識別一張圖片中的動物是貓還是狗,評估一筆交易是否存在欺詐風險,或者預測一位客戶是否會流失。這些都是分類算法大顯身手的舞臺。

本章將介紹五種最經典、最基礎、也是應用最廣泛的分類算法。它們各自代表了一種獨特的解決問題的哲學:邏輯回歸的概率建模、K-近鄰的類比推理、支撐向量機的幾何間隔、決策樹的邏輯規則以及樸素貝葉斯的概率推斷。

學習這些算法時,請重點關注:

- 它的核心思想是什么?

- 它是如何學習和預測的?

- 它的關鍵超參數有哪些,分別控制什么?

- 它的優缺點是什么,適用于哪些場景?

掌握了這些,您便能像一位經驗豐富的工匠,為不同的任務選擇最合適的工具。

5.1 邏輯回歸:看似回歸,實為分類的智慧

邏輯回歸(Logistic Regression)是您在分類領域遇到的第一個,也可能是最重要的算法之一。它的名字里雖然帶有“回歸”,但請不要被誤導,它是一個地地道道的分類算法。它因其簡單、高效、可解釋性強且輸出結果為概率而備受青睞,常常被用作解決實際問題的首選基線模型。

5.1.1 從線性回歸到邏輯回歸:跨越“預測值”到“預測概率”的鴻溝

要理解邏輯回歸,最好的方式是從我們熟悉的線性回歸出發。線性回歸的目標是擬合一條直線(或超平面)來預測一個連續值,其公式為: ? = w? + w?x? + w?x? + ... + w?x?

線性回歸的局限性 那我們能否直接用它來做分類呢?比如,我們規定 ? > 0.5 就判為類別1,否則為類別0。這樣做有兩個致命問題:

- 輸出范圍不匹配:線性回歸的輸出?

??是一個實數,范圍是?(-∞, +∞)。而我們想要的分類結果,最好是一個表示“概率”的、在?(0, 1)?區間內的值。直接比較???和0.5,物理意義不明確。 - 對離群點敏感:如果在數據中加入一個x值很大的離群點,線性回歸的擬合直線會被嚴重“拉偏”,可能導致原本正確的決策邊界發生巨大偏移,造成錯誤的分類。

我們需要一個“轉換器”,能將線性回歸 (-∞, +∞) 的輸出,優雅地“壓縮”到 (0, 1) 的概率區間內。

Sigmoid函數的引入 這個神奇的“轉換器”就是Sigmoid函數(也稱Logistic函數),它的數學形式如下: σ(z) = 1 / (1 + e??)

這里的 z 就是我們線性回歸的輸出 w? + w?x? + ...。Sigmoid函數具有非常優美的S型曲線形態:

- 無論輸入?

z?多大或多小,其輸出?σ(z)?始終在?(0, 1)?區間內。 - 當?

z = 0?時,σ(z) = 0.5。 - 當?

z -> +∞?時,σ(z) -> 1。 - 當?

z -> -∞?時,σ(z) -> 0。

通過將線性回歸的輸出 z 作為Sigmoid函數的輸入,我們就構建了邏輯回歸的核心模型: P(y=1 | X) = σ(z) = 1 / (1 + e?(w?X + b)) 這個公式的含義是:在給定特征 X 的條件下,樣本類別 y 為1的概率。

5.1.2 模型解讀:概率、決策邊界與損失函數

概率的解釋 邏輯回歸的輸出 P(y=1|X) 是一個真正的概率值,這極具價值。例如,一個癌癥預測模型輸出0.9,意味著它有90%的把握認為該病人患有癌癥。這個概率值本身就可以用于風險排序、設定不同的告警級別等。 有了概率,分類就變得順理成章:

- 如果?

P(y=1|X) > 0.5,則預測為類別1。 - 如果?

P(y=1|X) <= 0.5,則預測為類別0。

決策邊界(Decision Boundary) 決策邊界是模型在特征空間中將不同類別分開的那條“線”或“面”。對于邏輯回歸,當 P(y=1|X) = 0.5 時,分類結果處于臨界狀態。這對應于 σ(z) = 0.5,也就是 z = w?X + b = 0。 所以,邏輯回歸的決策邊界就是由 w?X + b = 0 這條方程所定義的線性邊界。

- 在二維空間中,它是一條直線。

- 在三維空間中,它是一個平面。

- 在高維空間中,它是一個超平面。

重要:邏輯回歸本身是一個線性分類器,它的決策邊界是線性的。如果數據的真實邊界是非線性的,基礎的邏輯回歸模型將表現不佳。(當然,通過特征工程,如添加多項式特征,可以使其學習非線性邊界)。

損失函數 模型如何學習到最優的權重 w 和偏置 b 呢?它需要一個**損失函數(Loss Function)**來衡量當前模型的預測與真實標簽之間的“差距”,然后通過優化算法(如梯度下降)來最小化這個損失。

對于邏輯回歸,我們不能使用線性回歸的均方誤差(MSE),因為它會導致一個非凸的損失函數,優化起來非常困難。我們使用的是對數損失(Log Loss),也稱為二元交叉熵損失(Binary Cross-Entropy Loss)。

對于單個樣本,其損失定義為:

- 如果真實標簽?

y = 1:Loss = -log(p),其中?p?是模型預測為1的概率。 - 如果真實標簽?

y = 0:Loss = -log(1-p)。

直觀理解:

- 當真實標簽是1時,我們希望預測概率?

p?越接近1越好。如果?p?趨近于1,-log(p)?就趨近于0,損失很小。如果模型錯誤地預測?p?趨近于0,-log(p)?會趨近于無窮大,給予巨大的懲罰。 - 當真實標簽是0時,情況正好相反。

這個分段函數可以優雅地寫成一個統一的式子: Loss = -[y * log(p) + (1 - y) * log(1 - p)] 整個訓練集的總損失就是所有樣本損失的平均值。模型訓練的目標,就是找到一組 w 和 b,使得這個總損失最小。

5.1.3 Scikit-learn實戰與正則化

代碼實現 在Scikit-learn中,使用邏輯回歸非常簡單。我們將以一個標準流程來展示其應用,這個流程也適用于后續將要學習的大多數模型。

# 導入必要的庫

from sklearn.model_selection import train_test_split, GridSearchCV

from sklearn.linear_model import LogisticRegression

from sklearn.metrics import classification_report, confusion_matrix

from sklearn.preprocessing import StandardScaler

import pandas as pd

import seaborn as sns

import numpy as np# --- 準備數據 (假設使用泰坦尼克數據集) ---

# 為了代碼能獨立運行,我們快速進行一次極簡的數據預處理

df = sns.load_dataset('titanic')

df.drop(['deck', 'embark_town', 'alive', 'who', 'adult_male', 'class'], axis=1, inplace=True)

df['age'].fillna(df['age'].median(), inplace=True)

df['embarked'].fillna(df['embarked'].mode()[0], inplace=True)

df = pd.get_dummies(df, columns=['sex', 'embarked'], drop_first=True)

df.drop('name', axis=1, inplace=True) # 名字暫時不用

df.drop('ticket', axis=1, inplace=True) # 票號暫時不用X = df.drop('survived', axis=1)

y = df['survived']# 1. 劃分數據

# stratify=y 確保訓練集和測試集中,目標變量y的類別比例與原始數據一致,這在分類問題中很重要

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.3, random_state=42, stratify=y)# 2. 特征縮放 (對于邏輯回歸,特別是帶正則化的,這是個好習慣)

scaler = StandardScaler()

X_train_scaled = scaler.fit_transform(X_train)

X_test_scaled = scaler.transform(X_test)# 3. 初始化并訓練模型

# penalty='l2'表示使用L2正則化,C是正則化強度的倒數

# solver='liblinear' 是一個適用于小數據集的優秀求解器

model = LogisticRegression(penalty='l2', C=1.0, solver='liblinear', random_state=42)

model.fit(X_train_scaled, y_train)# 4. 預測與評估

y_pred = model.predict(X_test_scaled)

print("--- 邏輯回歸基礎模型評估 ---")

print("混淆矩陣:\n", confusion_matrix(y_test, y_pred))

print("\n分類報告:\n", classification_report(y_test, y_pred))# 查看模型學習到的系數

# feature_names = X.columns

# coefs = pd.Series(model.coef_[0], index=feature_names).sort_values()

# print("\n模型系數:\n", coefs)

正則化參數(C) 邏輯回歸很容易過擬合,特別是當特征數量很多時。為了對抗過擬合,我們引入正則化。LogisticRegression類中最關鍵的超參數就是C和penalty。

penalty:指定使用哪種正則化,通常是'l1'或'l2'。- L2正則化(默認):懲罰那些值很大的權重,使得所有權重都趨向于變小,但不會變為0。它讓模型的決策邊界更平滑。

- L1正則化:同樣懲罰大權重,但它有一個特性,就是能將一些不重要的特征的權重直接懲罰為0,從而實現特征選擇。

C:正則化強度的倒數。它是一個正浮點數。- C值越小,代表正則化懲罰越強,模型會更簡單,有助于防止過擬合(增加偏差,降低方差)。

- C值越大,代表正則化懲罰越弱,模型會更努力地去擬合訓練數據,可能導致過擬合(降低偏差,增加方差)。

C是我們需要通過交叉驗證來調優的最重要的超參數。下面我們使用GridSearchCV來尋找最優的C值。

# --- 使用GridSearchCV進行超參數調優 ---

param_grid = {'C': [0.001, 0.01, 0.1, 1, 10, 100]}

grid_search = GridSearchCV(LogisticRegression(penalty='l2', solver='liblinear', random_state=42), param_grid, cv=5, scoring='accuracy')

grid_search.fit(X_train_scaled, y_train)print("\n--- 邏輯回歸超參數調優 ---")

print("最佳超參數:", grid_search.best_params_)

print("交叉驗證最佳得分:", grid_search.best_score_)# 使用最佳模型進行最終評估

best_model = grid_search.best_estimator_

y_pred_best = best_model.predict(X_test_scaled)

print("\n最佳模型在測試集上的分類報告:\n", classification_report(y_test, y_pred_best))

優缺點與適用場景

- 優點:

- 簡單快速:訓練速度快,計算成本低,易于實現。

- 可解釋性強:可以查看每個特征的權重

coef_,理解特征對結果的影響方向和大小,便于向業務方解釋。 - 輸出概率:結果為概率,而不僅僅是類別,這在很多場景下(如風險評估)非常有用。

- 應用廣泛:是許多工業界應用(如廣告點擊率預測、金融風控)的基石和首選基線模型。

- 缺點:

- 線性模型:模型假設是線性的,容易欠擬合,無法直接捕捉數據中的非線性關系。

- 對特征工程依賴高:需要手動創造特征(如多項式特征)來幫助模型學習非線性。

- 對多重共線性敏感:如果特征之間高度相關,模型權重的解釋性會下降。

適用場景:

- 作為任何分類問題的首選基線模型(Baseline Model)。在嘗試復雜模型前,先用邏輯回歸跑一個結果,可以幫你判斷問題的難度,并為后續優化提供一個比較的基準。

- 當需要一個可解釋的模型時。

- 當需要預測概率時。

- 對于大規模稀疏數據(如文本分類后的詞袋模型),邏輯回歸配合L1正則化常常表現出色。

5.2 K-近鄰(KNN):“物以類聚,人以群分”的樸素哲學

K-近鄰(K-Nearest Neighbors, KNN)算法是機器學習中最簡單、最直觀的算法之一。它的核心思想完美地詮釋了中國的一句古話:“物以類聚,人以群分”。要判斷一個未知樣本的類別,只需看看它在特征空間中的“鄰居”們都屬于哪個類別即可。

5.2.1 算法核心思想:近朱者赤,近墨者黑

“懶惰學習”的代表 KNN是一種**懶惰學習(Lazy Learning)或稱基于實例的學習(Instance-based Learning)**算法。它與其他我們即將學習的算法(如邏輯回歸、SVM)有一個根本區別:

- 它沒有傳統意義上的“訓練”過程。所謂的“訓練”,僅僅是把所有訓練數據加載到內存中而已。它不會從數據中學習一個判別函數或模型參數。

- 真正的計算發生在“預測”階段。當一個新樣本需要被預測時,KNN才會開始工作。

三個核心要素 KNN的預測過程由三個核心要素決定:

- K值的選擇:我們要看新樣本周圍的多少個“鄰居”。K是一個正整數。

- 距離度量:我們如何定義和計算樣本之間的“遠近”。

- 決策規則:根據K個鄰居的類別,如何做出最終的判決。最常見的是多數表決(Majority Voting)。

預測步驟:

- 計算未知樣本與訓練集中每一個樣本之間的距離。

- 找出距離最近的K個訓練樣本(即K個“鄰居”)。

- 統計這K個鄰居的類別。

- 將出現次數最多的那個類別,作為未知樣本的預測結果。

5.2.2 距離的度量與K值的選擇

常見的距離公式 距離度量是KNN的基石。最常用的距離是歐氏距離(Euclidean Distance),也就是我們初中就學過的兩點間直線距離公式。 對于兩個n維向量 x 和 y: d(x, y) = sqrt(Σ(x? - y?)2)

此外,還有其他距離度量方式,如:

- 曼哈頓距離(Manhattan Distance):

d(x, y) = Σ|x? - y?|,想象在城市街區中只能沿格線行走時的距離。 - 閔可夫斯基距離(Minkowski Distance):是歐氏距離和曼哈頓距離的推廣。

K值選擇的藝術 K值的選擇對KNN的性能至關重要,它直接影響著模型的偏差和方差。

- 較小的K值(如 K=1):

- 模型非常“敏感”,容易受到噪聲點的影響。

- 決策邊界會變得非常復雜、不規則。

- 這會導致低偏差,但高方差,容易過擬合。

- 較大的K值(如 K=N,N為訓練樣本總數):

- 模型非常“遲鈍”,無論新樣本在哪里,都會被預測為訓練集中數量最多的那個類別。

- 決策邊界會變得非常平滑。

- 這會導致高偏差,但低方差,容易欠擬合。

因此,選擇一個合適的K值是在偏差和方差之間做權衡。通常,我們會通過交叉驗證來尋找一個最優的K值。一個經驗法則是,K值通常選擇一個較小的奇數(以避免投票時出現平局)。

5.2.3 Scikit-learn實戰與數據標準化的重要性

代碼實現

from sklearn.neighbors import KNeighborsClassifier# 假設X_train_scaled, X_test_scaled, y_train, y_test已準備好# 初始化并訓練模型 (fit只是存儲數據)

knn = KNeighborsClassifier(n_neighbors=5) # 先選擇一個經驗值K=5

knn.fit(X_train_scaled, y_train)# 預測與評估

y_pred_knn = knn.predict(X_test_scaled)

print("--- KNN基礎模型評估 (K=5) ---")

print(classification_report(y_test, y_pred_knn))# 使用GridSearchCV尋找最優K值

param_grid_knn = {'n_neighbors': np.arange(1, 31, 2)} # 嘗試1到30之間的所有奇數

grid_search_knn = GridSearchCV(KNeighborsClassifier(), param_grid_knn, cv=5, scoring='accuracy')

grid_search_knn.fit(X_train_scaled, y_train)print("\n--- KNN超參數調優 ---")

print("最佳K值:", grid_search_knn.best_params_)

print("交叉驗證最佳得分:", grid_search_knn.best_score_)

數據標準化的必要性 對于KNN這類基于距離度量的模型,進行特征縮放(如標準化)是至關重要的,甚至是強制性的。

想象一個場景,我們有兩個特征:年齡(范圍20-80)和薪水(范圍5000-50000)。在計算歐氏距離時,薪水這個特征的數值差異會遠遠大于年齡的差異,從而在距離計算中占據絕對主導地位。這會使得年齡這個特征幾乎不起作用,這顯然是不合理的。

通過標準化(StandardScaler),我們將所有特征都轉換到同一個尺度下(均值為0,標準差為1),使得每個特征在距離計算中都有平等“話語權”。

優缺點與適用場景

- 優點:

- 思想簡單,易于理解和實現。

- 模型靈活:可以學習任意復雜的決策邊界。

- 無需訓練:對于需要快速上線、數據不斷更新的場景有優勢。

- 缺點:

- 計算成本高昂:預測一個新樣本需要與所有訓練樣本計算距離,當訓練集很大時,非常耗時。

- 對內存需求大:需要存儲整個訓練集。

- 對不平衡數據敏感:數量多的類別在投票中占優勢。

- 對維度詛咒敏感:在高維空間中,所有點之間的距離都趨向于變得遙遠且相近,“鄰居”的概念變得模糊。

適用場景:

- 小到中等規模的數據集。

- 當問題的決策邊界高度非線性時。

- 作為一種快速的基線模型。

5.3 支撐向量機(SVM):“一劃開天”的數學之美

支撐向量機(Support Vector Machine, SVM)是機器學習領域最強大、最優雅的算法之一。它誕生于上世紀90年代,在深度學習浪潮來臨之前,曾一度被認為是監督學習中效果最好的“大殺器”。SVM的核心思想是基于幾何間隔,尋找一個“最優”的決策邊界。

5.3.1 核心思想:尋找最大間隔的“最優”決策邊界

對于一個線性可分的二分類問題,能將兩類樣本分開的直線(或超平面)有無數條。邏輯回歸會找到其中一條,但SVM追求的是最好的那一條。

什么是“最好”? SVM認為,最好的決策邊界應該是那條離兩邊最近的樣本點最遠的邊界。這條邊界就像在兩軍對壘的戰場中央劃下的一道“停火線”,它使得雙方(不同類別的樣本)都離這條線有盡可能大的“緩沖地帶”。

間隔(Margin)與支持向量(Support Vectors)

- 決策邊界:就是中間那條實線的超平面?

w?x + b = 0。 - 間隔(Margin):是決策邊界與兩側距離它最近的樣本點之間的垂直距離。SVM的目標就是最大化這個間隔。

- 支持向量(Support Vectors):那些恰好落在間隔邊界上的樣本點。它們就像支撐起整個間隔的“樁子”。一個驚人的事實是:最終的決策邊界完全由這些支持向量決定,與其他樣本點無關。即使移動或刪除非支持向量的樣本點,決策邊界也不會改變。這使得SVM非常高效且魯棒。

從線性可分到線性不可分:軟間隔(Soft Margin) 現實世界的數據往往不是完美線性可分的,總會有一些噪聲點或“越界”的樣本。為了處理這種情況,SVM引入了**軟間隔(Soft Margin)**的概念。

軟間隔允許一些樣本點“犯規”,即可以處在間隔之內,甚至可以被錯誤分類。但這種“犯規”是要付出代價的。SVM引入了一個懲罰系數超參數 C:

C?控制了我們對“犯規”的容忍程度。- 較大的C值:代表對犯規的懲罰很重,SVM會努力將所有樣本都正確分類,這可能導致間隔變窄,模型變得復雜,容易過擬合。

- 較小的C值:代表對犯規比較寬容,允許一些錯誤分類,以換取一個更寬的間隔。這會使模型更簡單,泛化能力可能更強,但可能欠擬合。

C是在偏差和方差之間進行權衡的關鍵。

5.3.2 核技巧(Kernel Trick):低維到高維的“乾坤大挪移”

SVM最強大的武器是核技巧(Kernel Trick)。對于那些在原始特征空間中線性不可分的數據(例如,一個環形分布),SVM可以通過核技巧,巧妙地將其映射到一個更高維度的空間,使得數據在這個高維空間中變得線性可分。

核函數的魔力 想象一下,我們把二維平面上的一張紙(數據),通過某種方式向上“彎曲”,變成一個三維的碗狀。原本在紙上無法用一條直線分開的同心圓,在三維空間中就可以用一個水平面輕易地分開了。

核函數的神奇之處在于:它讓我們無需真正地去計算數據在高維空間中的坐標,就能得到數據點在高維空間中的內積結果。這極大地節省了計算量,使得在高維空間中尋找決策邊界成為可能。

常見的核函數

- 線性核(Linear Kernel):

kernel='linear'。實際上就是不做任何映射,在原始空間中尋找線性邊界。 - 多項式核(Polynomial Kernel):

kernel='poly'。可以將數據映射到多項式空間。 - 高斯徑向基核(Gaussian Radial Basis Function, RBF):

kernel='rbf'。這是最常用、最強大的核函數。它可以將數據映射到無限維空間,能夠學習任意復雜的非線性決策邊界。

5.3.3 Scikit-learn實戰與關鍵超參數

代碼實現

from sklearn.svm import SVC# 假設X_train_scaled, X_test_scaled, y_train, y_test已準備好# 初始化并訓練模型 (使用RBF核)

svm_model = SVC(kernel='rbf', C=1.0, gamma='scale', random_state=42)

svm_model.fit(X_train_scaled, y_train)# 預測與評估

y_pred_svm = svm_model.predict(X_test_scaled)

print("--- SVM基礎模型評估 ---")

print(classification_report(y_test, y_pred_svm))# 使用GridSearchCV進行超參數調優

param_grid_svm = {'C': [0.1, 1, 10],'gamma': ['scale', 0.1, 0.01],'kernel': ['rbf', 'linear']

}

grid_search_svm = GridSearchCV(SVC(random_state=42), param_grid_svm, cv=3, scoring='accuracy') # cv=3以加快速度

grid_search_svm.fit(X_train_scaled, y_train)print("\n--- SVM超參數調優 ---")

print("最佳超參數:", grid_search_svm.best_params_)

print("交叉驗證最佳得分:", grid_search_svm.best_score_)

關鍵超參數 對于使用RBF核的SVM,有兩個至關重要的超參數需要調優:

C?(懲罰系數):如前所述,控制著對錯誤分類的懲罰力度,權衡著間隔寬度和分類準確性。gamma?(核系數):它定義了單個訓練樣本的影響范圍。- 較小的

gamma值:意味著影響范圍大,決策邊界會非常平滑,模型趨向于欠擬合(高偏差)。 - 較大的

gamma值:意味著影響范圍小,只有靠近的樣本點才會對決策邊界產生影響,這會導致決策邊界非常曲折、復雜,模型趨向于過擬合(高方差)。

- 較小的

C和gamma通常需要一起進行網格搜索來尋找最優組合。

優缺點與適用場景

- 優點:

- 在高維空間中非常有效,甚至當維度數大于樣本數時。

- 內存效率高,因為它只使用一部分訓練點(支持向量)來做決策。

- 非常通用,通過選擇不同的核函數,可以適應各種數據和決策邊界。

- 缺點:

- 當樣本數量遠大于特征數量時,性能和速度通常不如一些集成模型(如隨機森林)。

- 對缺失數據敏感。

- 結果不易解釋,特別是使用非線性核時,它不像邏輯回歸或決策樹那樣直觀。

- 沒有直接的概率輸出(雖然可以通過一些方法間接計算)。

適用場景:

- 復雜但中小型的數據集。

- 高維數據,如圖像識別、文本分類。

- 當需要一個非線性分類器時,SVM(特別是RBF核)是一個強大的選擇。

5.4 決策樹與隨機森林:“集思廣益”的集成智慧

決策樹(Decision Tree)是一種非常符合人類直覺的分類模型。它通過學習一系列“if-then”規則,來構建一個樹形的決策結構。而隨機森林(Random Forest)則是通過“集體智慧”,將許多棵決策樹組合起來,形成一個更強大、更穩健的模型。

5.4.1 決策樹:像人一樣思考的樹形結構

構建過程 決策樹的構建是一個遞歸的過程,目標是生成一棵泛化能力強、不純度低的樹。

- 選擇根節點:從所有特征中,選擇一個“最好”的特征作為樹的根節點。

- 分裂:根據這個最優特征的取值,將數據集分裂成若干個子集。

- 遞歸:對每個子集,重復步驟1和2,即選擇該子集下的最優特征進行分裂,生成新的子節點。

- 停止:當滿足停止條件時(如節點下的所有樣本都屬于同一類別,或達到預設的樹深),該節點成為葉子節點,不再分裂。

如何選擇最優特征進行分裂 “最好”的特征,是指那個能讓分裂后的數據集**“不純度”下降最大**的特征。我們希望每次分裂后,各個子集內部的類別盡可能地“純粹”(即大部分樣本屬于同一個類別)。 衡量不純度的常用指標有:

- 基尼不純度(Gini Impurity):Scikit-learn中的默認選擇。它衡量的是從數據集中隨機抽取兩個樣本,其類別標簽不一致的概率。基尼不純度越小,數據集越純。

- 信息增益(Information Gain):基于信息熵(Entropy)的概念。信息熵衡量的是數據的不確定性。信息增益就是父節點的信息熵減去所有子節點信息熵的加權平均。信息增益越大,說明這次分裂帶來的“確定性”提升越大。

可視化與可解釋性 決策樹最大的優點之一就是高度的可解釋性。我們可以將訓練好的決策樹可視化出來,清晰地看到它的每一個決策規則。這使得它成為一個“白盒”模型,非常便于向非技術人員解釋。

剪枝(Pruning) 如果不加限制,決策樹會一直生長,直到每個葉子節點都只包含一個樣本,這會導致嚴重的過擬合。為了防止這種情況,我們需要對樹進行“剪枝”。

- 預剪枝(Pre-pruning):在樹的生長過程中,通過設定一些條件提前停止分裂。常用的超參數包括:

max_depth:樹的最大深度。min_samples_split:一個節點要分裂,至少需要包含的樣本數。min_samples_leaf:一個葉子節點至少需要包含的樣本數。

- 后剪枝(Post-pruning):先生成一棵完整的決策樹,然后自底向上地考察非葉子節點,如果將該節點替換為葉子節點能提升模型的泛化性能,則進行剪枝。

5.4.2 集成學習入門:從“一個好漢”到“三個臭皮匠”

集成學習(Ensemble Learning)是一種強大的機器學習范式,它不依賴于單個模型,而是將多個弱學習器(weak learners)組合起來,形成一個強大的強學習器。俗話說“三個臭皮匠,頂個諸葛亮”,這就是集成學習的核心思想。

Bagging思想 Bagging(Bootstrap Aggregating的縮寫)是集成學習中最基礎的思想之一。它的目標是降低模型的方差。

- 自助采樣(Bootstrap):從原始訓練集中,進行有放回地隨機抽樣,生成多個大小與原始數據集相同的自助樣本集。由于是有放回抽樣,每個自助樣本集中會包含一些重復樣本,也有些原始樣本未被抽到。

- 獨立訓練:在每個自助樣本集上,獨立地訓練一個基學習器(如一棵決策樹)。

- 聚合(Aggregating):對于分類任務,使用多數表決的方式,將所有基學習器的預測結果進行投票,得出最終的集成預測。對于回歸任務,則取所有基學習器預測結果的平均值。

5.4.3 隨機森林(Random Forest):決策樹的“集體智慧”

隨機森林就是以決策樹為基學習器的Bagging集成模型,并且在Bagging的基礎上,引入了進一步的“隨機性”。

“雙重隨機”的核心

- 樣本隨機(行抽樣):繼承自Bagging,每個基決策樹都在一個自助樣本集上訓練。

- 特征隨機(列抽樣):這是隨機森林的獨創。在每個節點進行分裂時,不是從所有特征中選擇最優特征,而是先從所有特征中隨機抽取一個子集(通常是sqrt(n_features)個),然后再從這個子集中選擇最優特征進行分裂。

為何隨機森林通常優于單棵決策樹

- 降低方差:Bagging的聚合過程本身就能有效降低方差。

- 增加模型多樣性:“特征隨機”這一步,使得森林中的每棵樹都長得“各不相同”,因為它們在每個節點上看到的“世界”(特征子集)都不同。這降低了樹與樹之間的相關性,使得投票結果更加穩健,進一步降低了整體模型的方差,有效防止了過擬合。

5.4.4 Scikit-learn實戰與特征重要性

代碼實現

from sklearn.tree import DecisionTreeClassifier

from sklearn.ensemble import RandomForestClassifier# --- 決策樹 ---

dt_model = DecisionTreeClassifier(max_depth=5, random_state=42)

dt_model.fit(X_train, y_train) # 決策樹對縮放不敏感,可以直接用原始數據

y_pred_dt = dt_model.predict(X_test)

print("--- 決策樹模型評估 ---")

print(classification_report(y_test, y_pred_dt))# --- 隨機森林 ---

rf_model = RandomForestClassifier(n_estimators=100, max_depth=5, random_state=42, n_jobs=-1)

rf_model.fit(X_train, y_train)

y_pred_rf = rf_model.predict(X_test)

print("\n--- 隨機森林模型評估 ---")

print(classification_report(y_test, y_pred_rf))

n_estimators是森林中樹的數量,n_jobs=-1表示使用所有CPU核心并行計算。

特征重要性(Feature Importance) 隨機森林還有一個非常有用的副產品——特征重要性。模型可以評估每個特征在所有樹的決策中所做的貢獻大小(通常是基于該特征帶來的不純度下降總量)。這為我們理解數據和篩選特征提供了極佳的洞察。

importances = rf_model.feature_importances_

feature_importances = pd.Series(importances, index=X.columns).sort_values(ascending=False)plt.figure(figsize=(10, 6))

sns.barplot(x=feature_importances, y=feature_importances.index)

plt.title('Feature Importances in Random Forest')

plt.show()

優缺點與適用場景

- 優點:

- 性能強大:通常能獲得非常高的準確率,是許多競賽和工業應用中的主力模型。

- 抗過擬合能力強:雙重隨機性使其非常穩健。

- 對缺失值和異常值不敏感。

- 無需特征縮放。

- 能處理高維數據,并能輸出特征重要性。

- 缺點:

- 可解釋性差:相比單棵決策樹,隨機森林是一個“黑盒”模型,難以解釋其內部決策邏輯。

- 計算和內存開銷大:需要訓練和存儲數百棵樹。

- 在某些噪聲很大的數據集上,可能會過擬合。

適用場景:

- 幾乎適用于任何分類(或回歸)問題,是工具箱中必備的“瑞士軍刀”。

- 當需要一個高性能、開箱即用的模型時。

- 用于特征選擇和數據探索。

5.5 樸素貝葉斯:“執果索因”的概率思維

樸素貝葉斯(Naive Bayes)是一類基于貝葉斯定理和特征條件獨立性假設的簡單概率分類器。盡管它的假設非常“樸素”,但在許多現實場景,尤其是文本分類中,其表現卻出人意料地好。

5.5.1 貝葉斯定理:概率論的基石

貝葉斯定理描述了兩個條件概率之間的關系。它的核心思想是根據“結果”來反推“原因”的概率。 P(A|B) = [P(B|A) * P(A)] / P(B)

在分類任務中,我們可以將其改寫為: P(類別 | 特征) = [P(特征 | 類別) * P(類別)] / P(特征)

P(類別 | 特征):后驗概率(Posterior)。這是我們想求的,即在看到這些特征后,樣本屬于某個類別的概率。P(特征 | 類別):似然(Likelihood)。在某個類別下,出現這些特征的概率。這是模型需要從訓練數據中學習的。P(類別):先驗概率(Prior)。在不看任何特征的情況下,某個類別本身出現的概率。可以從訓練數據中直接統計。P(特征):證據(Evidence)。這些特征出現的概率。在預測時,對于所有類別,它是一個常數,因此可以忽略。

所以,樸素貝葉斯的預測過程就是:對于一個新樣本,計算它屬于每個類別的后驗概率,然后選擇后驗概率最大的那個類別作為預測結果。

5.5.2 “樸素”在何處?特征條件獨立性假設

計算P(特征 | 類別),即P(特征?, 特征?, ... | 類別),是非常困難的。為了簡化計算,樸素貝葉斯做出了一個非常強的假設:

特征條件獨立性假設:它假設在給定類別的情況下,所有特征之間是相互獨立的。 P(特征?, 特征?, ... | 類別) = P(特征? | 類別) * P(特征? | 類別) * ...

這個假設就是“樸素”一詞的來源。在現實中,特征之間往往是有關聯的(例如,在文本中,“機器學習”和“算法”這兩個詞就經常一起出現)。但這個看似不合理的假設,卻極大地簡化了計算,并使得樸素貝葉斯在實踐中依然表現良好。

不同類型的樸素貝葉斯 根據特征數據的不同分布,樸素貝葉斯有幾種常見的變體:

- 高斯樸素貝葉斯(GaussianNB):假設連續型特征服從高斯分布(正態分布)。

- 多項式樸素貝葉斯(MultinomialNB):適用于離散型特征,特別是文本分類中的詞頻計數。

- 伯努利樸素貝葉斯(BernoulliNB):適用于二元特征(特征出現或不出現),也是文本分類的常用模型。

5.5.3 Scikit-learn實戰與文本分類應用

樸素貝葉斯最經典、最成功的應用領域莫過于文本分類。我們將以一個經典的垃圾郵件過濾為例,展示其工作流程。在文本處理中,我們通常使用MultinomialNB或BernoulliNB。

代碼實現 為了處理文本,我們首先需要將文字轉換成機器可以理解的數值形式。最常用的方法是詞袋模型(Bag-of-Words),它將每篇文檔表示為一個向量,向量的每個維度代表一個詞,值可以是該詞在文檔中出現的次數(詞頻)。Scikit-learn的CountVectorizer可以幫我們完成這個轉換。

make_pipeline是一個非常有用的工具,它可以將“特征提取”(如CountVectorizer)和“模型訓練”(如MultinomialNB)這兩個步驟串聯成一個無縫的處理流程。

from sklearn.feature_extraction.text import CountVectorizer

from sklearn.naive_bayes import MultinomialNB

from sklearn.pipeline import make_pipeline

from sklearn.model_selection import train_test_split

from sklearn.metrics import classification_report

import pandas as pd# 假設我們有一個包含郵件文本和標簽的數據集

# 為了演示,我們創建一個簡單的數據集