1. 批量歸一化

1.1 原理

當神經網絡比較深的時候會發現:數據在下面,損失函數在上面,這樣會出現什么問題?

- 正向傳遞的時候,數據是從下往上一步一步往上傳遞

- 反向傳遞的時候,數據是從上面往下傳遞,這時候就會出現問題:梯度在上面的時候比較大,越到下面就越容易變小(因為是n個很小的數進行相乘,越到后面結果就越小,也就是說越靠近數據的,層的梯度就越小)

- 上面的梯度比較大,那么每次更新的時候上面的層就會不斷地更新;但是下面層因為梯度比較小,所以對權重地更新就比較少,這樣的話就會導致上面的收斂比較快,而下面的收斂比較慢,這樣就會導致底層靠近數據的內容(網絡所嘗試抽取的網絡底層的特征:簡單的局部邊緣、紋理等信息)變化比較慢,上層靠近損失的內容(高層語義信息)收斂比較快,所以每一次底層發生變化,所有的層都得跟著變(底層的信息發生變化就導致上層的權重全部白學了),這樣就會導致模型的收斂比較慢

所以提出了假設:能不能在改變底部信息的時候,避免頂部不斷的重新訓練?(這也是批量歸一化所考慮的問題)

?是為了避免除以0

全連接層

通常,我們將批量規范化層置于全連接層中的仿射變換和激活函數之間。 設全連接層的輸入為x,權重參數和偏置參數分別為W和b,激活函數為?,批量規范化的運算符為BN。 那么,使用批量規范化的全連接層的輸出的計算詳情如下:

h=?(BN(Wx+b)).

回想一下,均值和方差是在應用變換的"相同"小批量上計算的。

卷積層

同樣,對于卷積層,我們可以在卷積層之后和非線性激活函數之前應用批量規范化。 當卷積有多個輸出通道時,我們需要對這些通道的“每個”輸出執行批量規范化,每個通道都有自己的拉伸(scale)和偏移(shift)參數,這兩個參數都是標量。 假設我們的小批量包含m個樣本,并且對于每個通道,卷積的輸出具有高度p和寬度q。 那么對于卷積層,我們在每個輸出通道的m?p?q個元素上同時執行每個批量規范化。 因此,在計算平均值和方差時,我們會收集所有空間位置的值,然后在給定通道內應用相同的均值和方差,以便在每個空間位置對值進行規范化。

批量歸一化需要在激活函數之前,因為BN是線性的嗎,而激活函數是非線性的

?使用BN,可以增大學習率,因此可以加速收斂速度

預測過程中的批量規范化

正如我們前面提到的,批量規范化在訓練模式和預測模式下的行為通常不同。 首先,將訓練好的模型用于預測時,我們不再需要樣本均值中的噪聲以及在微批次上估計每個小批次產生的樣本方差了。 其次,例如,我們可能需要使用我們的模型對逐個樣本進行預測。 一種常用的方法是通過移動平均估算整個訓練數據集的樣本均值和方差,并在預測時使用它們得到確定的輸出。 可見,和暫退法一樣,批量規范化層在訓練模式和預測模式下的計算結果也是不一樣的。

1.2 代碼

從零實現

import torch

from torch import nn

from d2l import torch as d2ldef batch_norm(X, gamma, beta, moving_mean, moving_var, eps, momentum):# 通過is_grad_enabled來判斷當前模式是訓練模式還是預測模式if not torch.is_grad_enabled():# 如果是在預測模式下,直接使用傳入的移動平均所得的均值和方差X_hat = (X - moving_mean) / torch.sqrt(moving_var + eps)else:assert len(X.shape) in (2, 4)if len(X.shape) == 2:# 使用全連接層的情況,計算特征維上的均值和方差mean = X.mean(dim=0)var = ((X - mean) ** 2).mean(dim=0)else:# 使用二維卷積層的情況,計算通道維上(axis=1)的均值和方差。# 這里我們需要保持X的形狀以便后面可以做廣播運算mean = X.mean(dim=(0, 2, 3), keepdim=True)var = ((X - mean) ** 2).mean(dim=(0, 2, 3), keepdim=True)# 訓練模式下,用當前的均值和方差做標準化X_hat = (X - mean) / torch.sqrt(var + eps)# 更新移動平均的均值和方差moving_mean = momentum * moving_mean + (1.0 - momentum) * meanmoving_var = momentum * moving_var + (1.0 - momentum) * varY = gamma * X_hat + beta # 縮放和移位return Y, moving_mean.data, moving_var.data創建一個正確的 BatchNorm 圖層

class BatchNorm(nn.Module):# num_features:完全連接層的輸出數量或卷積層的輸出通道數。# num_dims:2表示完全連接層,4表示卷積層def __init__(self, num_features, num_dims):super().__init__()if num_dims == 2:shape = (1, num_features)else:shape = (1, num_features, 1, 1)# 參與求梯度和迭代的拉伸和偏移參數,分別初始化成1和0self.gamma = nn.Parameter(torch.ones(shape))self.beta = nn.Parameter(torch.zeros(shape))# 非模型參數的變量初始化為0和1self.moving_mean = torch.zeros(shape)self.moving_var = torch.ones(shape)def forward(self, X):# 如果X不在內存上,將moving_mean和moving_var# 復制到X所在顯存上if self.moving_mean.device != X.device:self.moving_mean = self.moving_mean.to(X.device)self.moving_var = self.moving_var.to(X.device)# 保存更新過的moving_mean和moving_varY, self.moving_mean, self.moving_var = batch_norm(X, self.gamma, self.beta, self.moving_mean,self.moving_var, eps=1e-5, momentum=0.9)return Y應用BatchNorm 于LeNet模型

net = nn.Sequential(nn.Conv2d(1, 6, kernel_size=5), BatchNorm(6, num_dims=4),nn.Sigmoid(), nn.MaxPool2d(kernel_size=2, stride=2),nn.Conv2d(6, 16,kernel_size=5), BatchNorm(16, num_dims=4),nn.Sigmoid(), nn.MaxPool2d(kernel_size=2, stride=2),nn.Flatten(), nn.Linear(16 * 4 * 4, 120),BatchNorm(120, num_dims=2), nn.Sigmoid(),nn.Linear(120, 84), BatchNorm(84, num_dims=2),nn.Sigmoid(), nn.Linear(84, 10))在Fashion-MNIST數據集上訓練網絡

lr, num_epochs, batch_size = 1.0, 10, 256

train_iter, test_iter = d2l.load_data_fashion_mnist(batch_size)

d2l.train_ch6(net, train_iter, test_iter, num_epochs, lr, d2l.try_gpu())

?拉伸參數 gamma 和偏移參數 beta

net[1].gamma.reshape((-1, )), net[1].beta.reshape((-1, ))

?簡明實現

net = nn.Sequential(nn.Conv2d(1, 6, kernel_size=5), nn.BatchNorm2d(6),nn.Sigmoid(), nn.MaxPool2d(kernel_size=2, stride=2),nn.Conv2d(6, 16, kernel_size=5), nn.BatchNorm2d(16),nn.Sigmoid(), nn.MaxPool2d(kernel_size=2, stride=2),nn.Flatten(), nn.Linear(256, 120), nn.BatchNorm1d(120),nn.Sigmoid(), nn.Linear(120, 84), nn.BatchNorm1d(84),nn.Sigmoid(), nn.Linear(84, 10))d2l.train_ch6(net, train_iter, test_iter, num_epochs, lr, d2l.try_gpu())

小結

- 在模型訓練過程中,批量規范化利用小批量的均值和標準差,不斷調整神經網絡的中間輸出,使整個神經網絡各層的中間輸出值更加穩定。

- 批量規范化在全連接層和卷積層的使用略有不同。

- 批量規范化層和暫退層一樣,在訓練模式和預測模式下計算不同。

- 批量規范化有許多有益的副作用,主要是正則化。另一方面,”減少內部協變量偏移“的原始動機似乎不是一個有效的解釋。

2. ResNet

2.1 原理

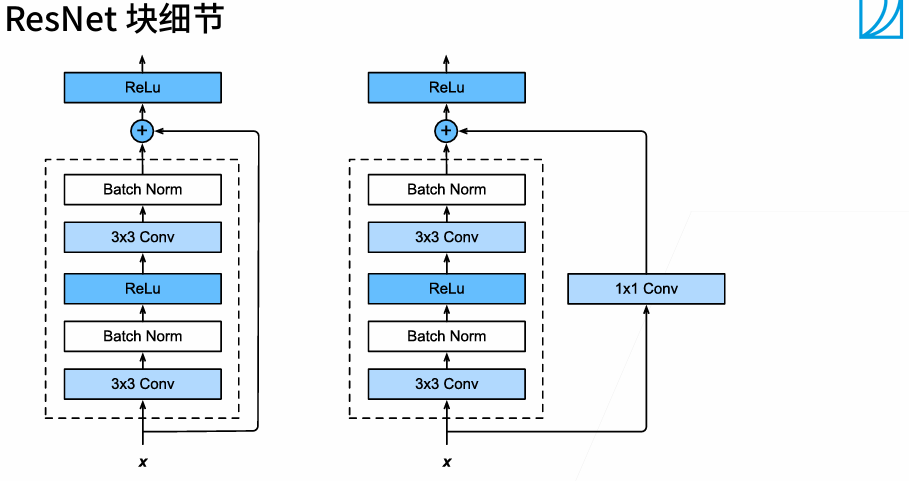

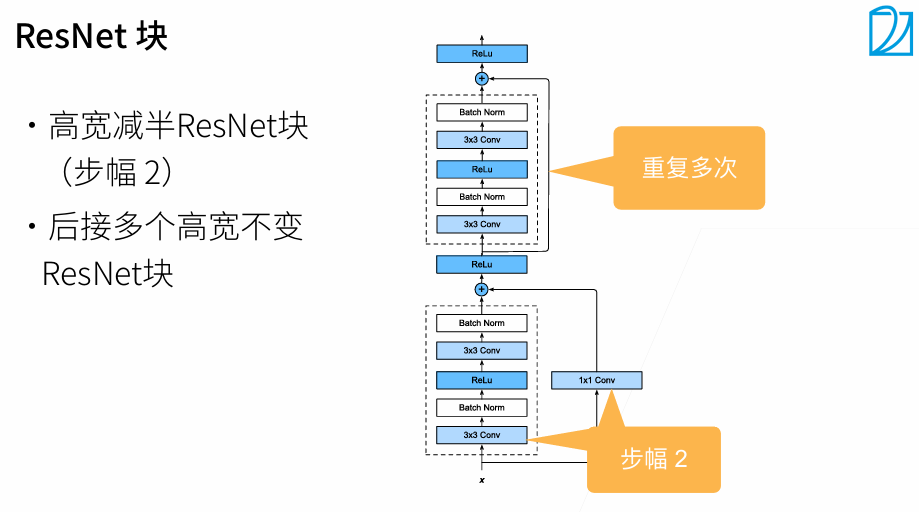

????????只有當較復雜的函數類包含較小的函數類時,我們才能確保提高它們的性能。 對于深度神經網絡,如果我們能將新添加的層訓練成恒等映射(identity function)f(x)=x,新模型和原模型將同樣有效。 同時,由于新模型可能得出更優的解來擬合訓練數據集,因此添加層似乎更容易降低訓練誤差。?

當經過很多層卷積之后,可能通道數會產生變化,所以要加上1×1的卷積轉換通道數。 (通常情況下是,當高寬減半時,通道數變為原來的一倍)

2.2 代碼

殘差塊

import torch

from torch import nn

from torch.nn import functional as F

from d2l import torch as d2lclass Residual(nn.Module):def __init__(self, input_channels, num_channels, use_1x1conv=False, strides=1):super().__init__()self.conv1 = nn.Conv2d(input_channels, num_channels, kernel_size=3,padding=1, stride=strides)self.conv2 = nn.Conv2d(num_channels, num_channels, kernel_size=3,padding=1)if use_1x1conv:self.conv3 = nn.Conv2d(input_channels, num_channels,kernel_size=1, stride=strides)else:self.conv3 = Noneself.bn1 = nn.BatchNorm2d(num_channels)self.bn2 = nn.BatchNorm2d(num_channels)# 當 inplace=True 時,ReLU 會直接在輸入張量上修改數據(覆蓋原值),不分配額外內存存儲輸出self.relu = nn.ReLU(inplace=True) def forward(self, X):Y = F.relu(self.bn1(self.conv1(X)))Y = self.bn2(self.conv2(Y))if self.conv3:X = self.conv3(X)Y = Y + Xreturn F.relu(Y)輸入和輸出形狀一致

blk = Residual(3, 3)

X = torch.rand(4, 3, 6, 6)

Y = blk(X)

Y.shape![]()

?增加輸出通道數的同時,減半輸出的高和寬

blk = Residual(3, 6, use_1x1conv=True, strides=2)

blk(X).shape![]()

?ResNet模型

b1 = nn.Sequential(nn.Conv2d(1, 64, kernel_size=7, stride=2, padding=3),nn.BatchNorm2d(64), nn.ReLU(),nn.MaxPool2d(kernel_size=3, stride=2, padding=1))def resnet_block(input_channels, num_channels, num_residuals,first_block=False):blk = []for i in range(num_residuals):if i == 0 and not first_block:blk.append(Residual(input_channels, num_channels, use_1x1conv=True,strides=2))else:blk.append(Residual(num_channels, num_channels))return blk# *的含義是將list展開,變成一個個的輸入

b2 = nn.Sequential(*resnet_block(64, 64, 2, first_block=True))

b3 = nn.Sequential(*resnet_block(64, 128, 2))

b4 = nn.Sequential(*resnet_block(128, 256, 2))

b5 = nn.Sequential(*resnet_block(256, 512, 2))net = nn.Sequential(b1, b2, b3, b4, b5, nn.AdaptiveAvgPool2d((1, 1)),nn.Flatten(), nn.Linear(512, 10))觀察一下ResNet中不同模塊的輸入形狀是如何變化的

X = torch.rand(size=(1, 1, 224, 224))

for layer in net:X = layer(X)print(layer.__class__.__name__, 'output shape:\t', X.shape)

訓練模型

lr, num_epochs, batch_size = 0.05, 10, 256

train_iter, test_iter = d2l.load_data_fashion_mnist(batch_size, resize=96)

d2l.train_ch6(net, train_iter, test_iter, num_epochs, lr, d2l.try_gpu())

小結

- 學習嵌套函數(nested function)是訓練神經網絡的理想情況。在深層神經網絡中,學習另一層作為恒等映射(identity function)較容易(盡管這是一個極端情況)。

- 殘差映射可以更容易地學習同一函數,例如將權重層中的參數近似為零。

- 利用殘差塊(residual blocks)可以訓練出一個有效的深層神經網絡:輸入可以通過層間的殘余連接更快地向前傳播。

- 殘差網絡(ResNet)對隨后的深層神經網絡設計產生了深遠影響。

ResNet的梯度計算

3. 第二次kaggle競賽

競賽地址:https://www.kaggle.com/c/classify-leaves

試用 32 -- AI做軟件程序測試 3)

![[MERN 項目實戰] MERN Multi-Vendor 電商平臺開發筆記(v2.0 從 bug 到結構優化的工程記錄)](http://pic.xiahunao.cn/[MERN 項目實戰] MERN Multi-Vendor 電商平臺開發筆記(v2.0 從 bug 到結構優化的工程記錄))

)

)

)