一、Dify的介紹

https://dify.ai/

Dify 是一款創新的智能生活助手應用,旨在為您提供便捷、高效的服務。通過人工智能技術, Dify 可以實現語音

助手、智能家居控制、日程管理等功能,助您輕松應對生活瑣事,享受智慧生活。簡約的界面設計,讓操作更加便

捷;豐富的應用場景,滿足您多樣化的需求。 Dify ,讓生活更簡單!

二、Dify的安裝方式

1. 在線體驗

速度比較慢。不推薦

2. 本地部署

2.1 Docker 安裝

安裝 Docker 環境

bash <(curl -sSl

https://cdn.jsdelivr.net/gh/SuperManito/LunuxMirrors@main/DockerInstallation.sh) 安裝 Docker Compose

curl -L "https://github.com/docker/compose/releases/latest/download/docker-compose-$(uname -

s)-$(uname -m)" -o /usr/local/bin/docker-compose && chmod +x /usr/local/bin/docker-compose 執行查看 Docker-compose 版本

docker-compose --version

說明安裝成功了

docker-compse 拉取鏡像很慢

sudo tee /etc/docker/daemon.json <<-'EOF'

{

"registry-mirrors": [

"https://do.nark.eu.org",

"https://dc.j8.work",

"https://docker.m.daocloud.io",

"https://dockerproxy.com",

"https://docker.mirrors.ustc.edu.cn",

"https://docker.nju.edu.cn"

]

}

EOF 執行上面的代碼

sudo systemctl daemon-reload # 重新加載 systemd 的配置文件

systemctl restart docker # 重啟docker 然后去 GitHub 上拉取 dify 的代碼。解壓后進入到 docker 目錄中

docker-compose up -d 執行即可

2.2 DockerDeskTop

在 Windows 環境下我們可以通過 DockerDesktop 來安裝。直接去官網下載對應的版本即可。同樣的我們需要拉

取 dify 的 GitHub 的代碼。然后進入到 Docker 目錄,同樣的執行這個代碼

docker-compose up 然后在地址欄中輸入 http://localhost/install 就可以訪問了

然后在地址欄中輸入 http://localhost/install 就可以訪問了 我們先設置管理員的相關信息。設置后再登錄

我們先設置管理員的相關信息。設置后再登錄

3. Ollama

https://ollama.com/

我們已經把 Dify 在本地部署了。然后我們可以通過 Ollama 在本地部署對應的大模型,比如 deepseek-r1:1.5b 這

種小模型

Ollama 是一個讓你能在本地運行大語言模型的工具,為用戶在本地環境使用和交互大語言模型提供了便利,具有以下

特點:

1 )多模型支持: Ollama 支持多種大語言模型,比如 Llama 2 、 Mistral 等。這意味著用戶可以根據自己的需求和場

景,選擇不同的模型來完成各種任務,如文本生成、問答系統、對話交互等。

2 )易于安裝和使用:它的安裝過程相對簡單,在 macOS 、 Linux 和 Windows 等主流操作系統上都能方便地部署。

用戶安裝完成后,通過簡潔的命令行界面就能與模型進行交互,降低了使用大語言模型的技術門檻。

3 )本地運行: Ollama 允許模型在本地設備上運行,無需依賴網絡連接來訪問云端服務。這不僅提高了數據的安全性

和隱私性,還能減少因網絡問題導致的延遲,實現更快速的響應。

搜索 Ollama 進入官網 https://ollama.com/download ,選擇安裝MAC版本的安裝包,點擊安裝即可

下載完成后直接雙擊安裝即可

命令:ollama,出現下面內容,說明安裝成

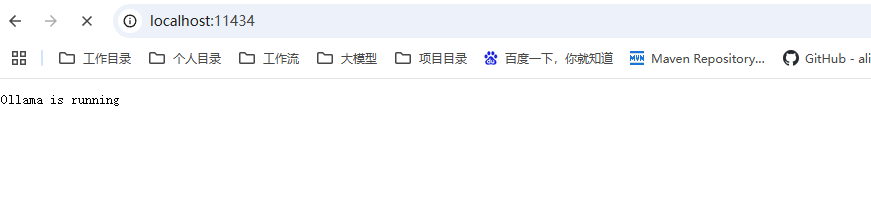

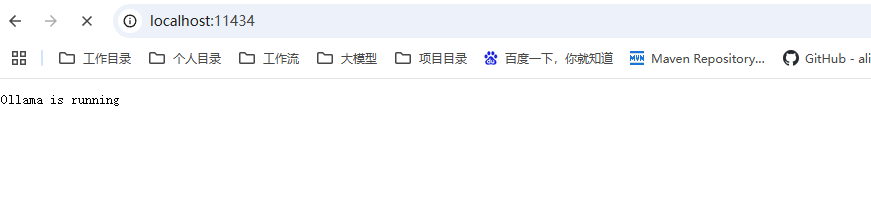

啟動 Ollama 服務

輸入命令【 ollama serve 】,瀏覽器打開,顯示running,說明啟動成功

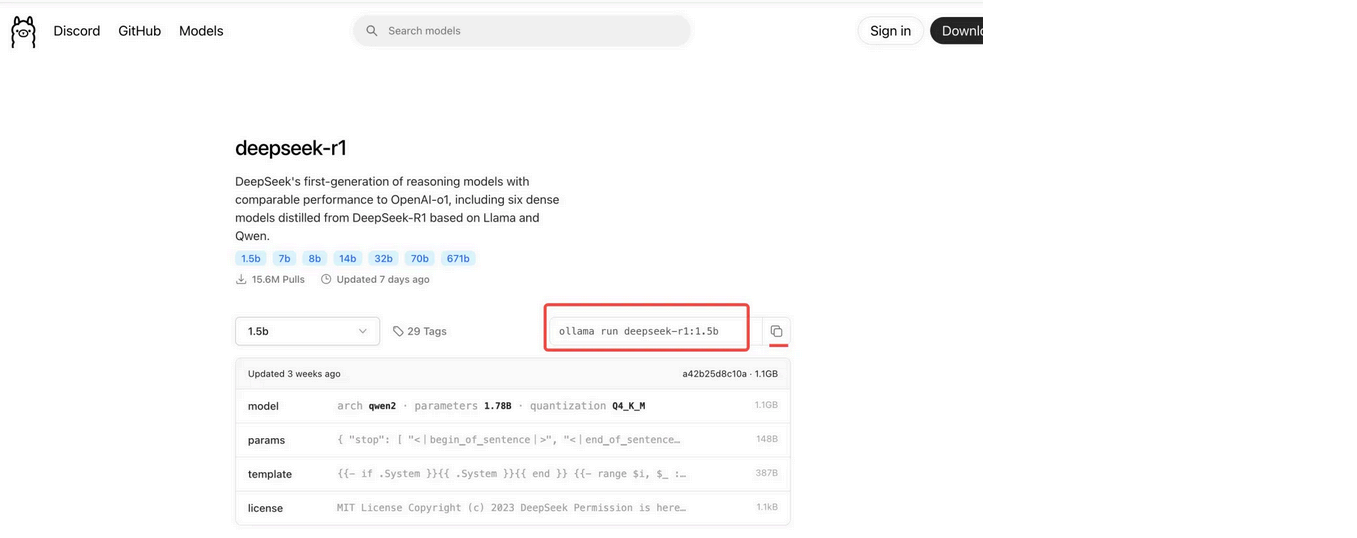

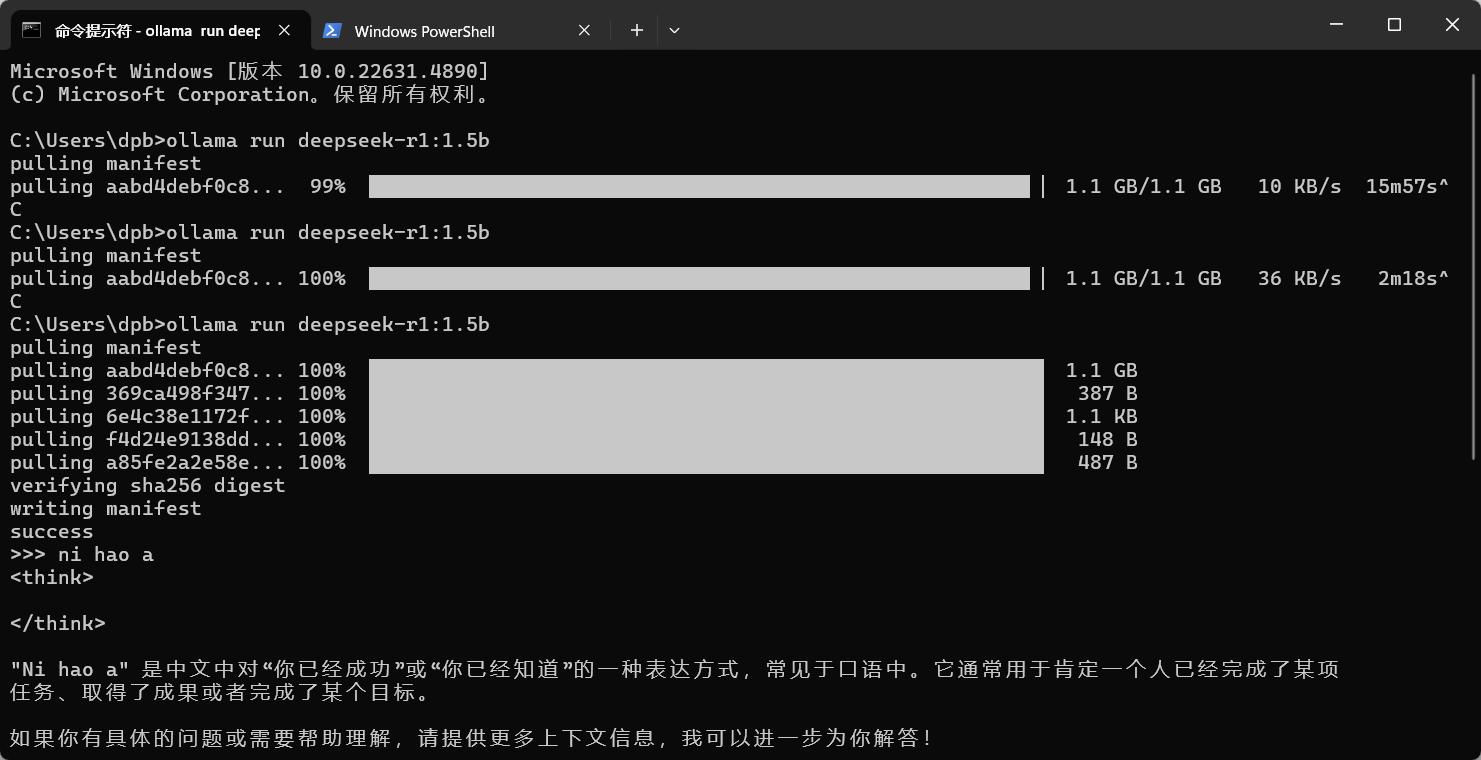

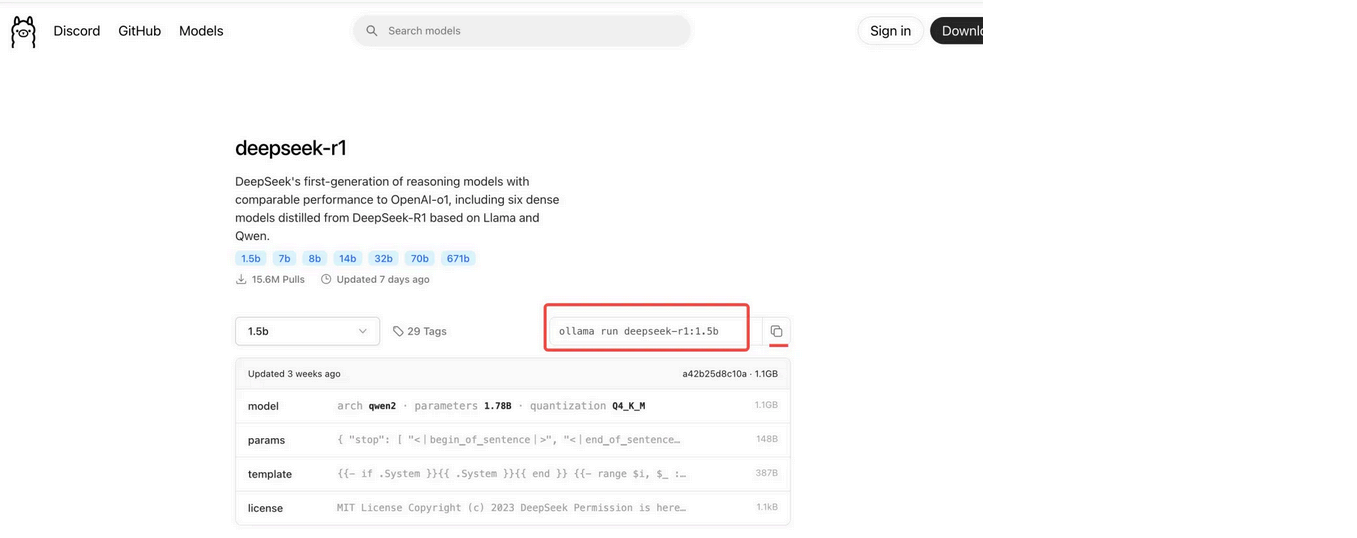

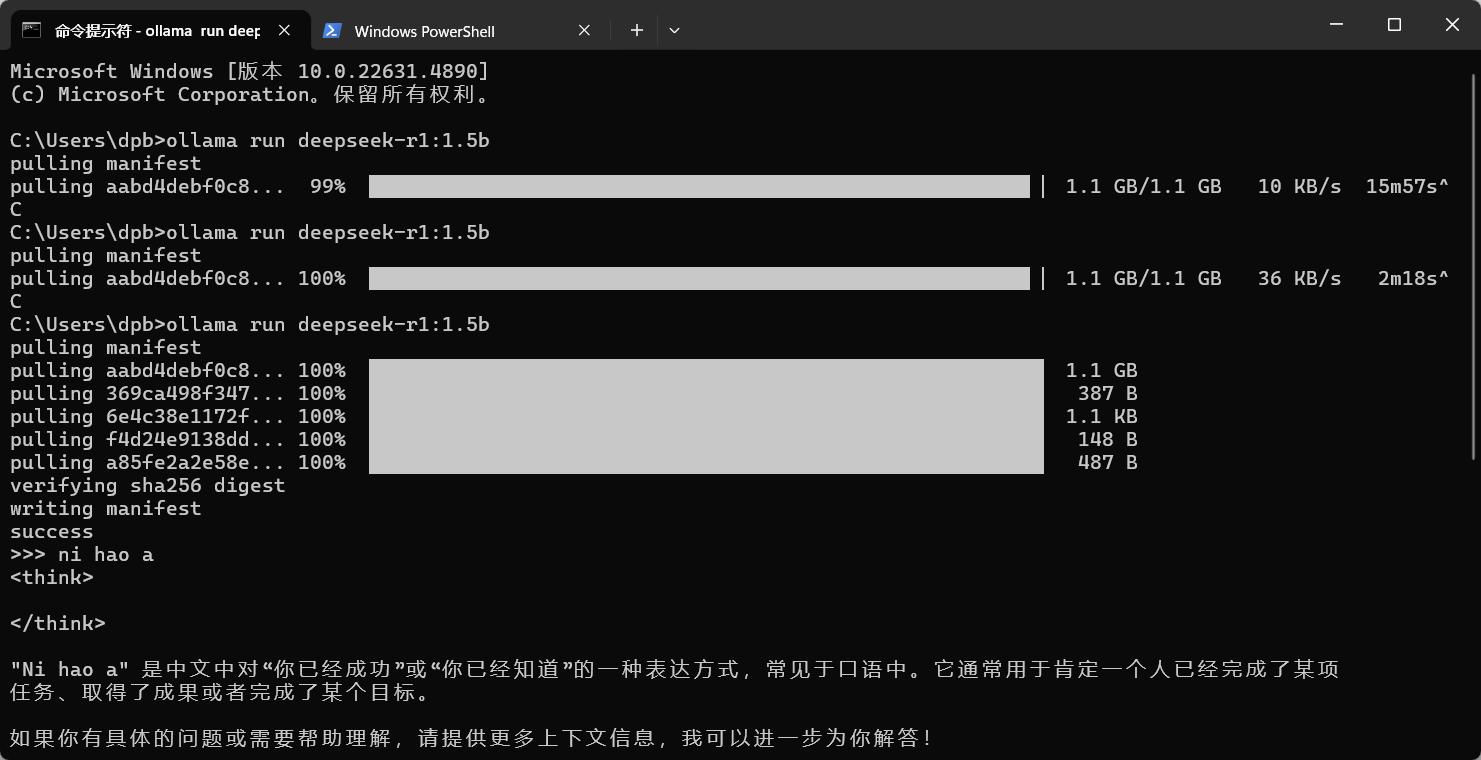

安裝 deepseek-r1:1.5b 模型

在 https://ollama.com/library/deepseek-r1:1.5b 搜索 deepseek-R1, 跳轉到下面的頁面,復制這個命令,在終端執

行,下載模型  cmd中執行這個命令

cmd中執行這個命令

cmd中執行這個命令

cmd中執行這個命令

4.Dify關聯Ollama

Dify 是通過 Docker 部署的,而 Ollama 是運行在本地電腦的,得讓 Dify 能訪問 Ollama 的服務。

在 Dify 項目 -docker- 找到 .env 文件,在末尾加上下面的配置:

# 啟用自定義模型

CUSTOM_MODEL_ENABLED=true

# 指定 Olama 的 API地址(根據部署環境調整IP)

OLLAMA_API_BASE_URL=host.docker.internal:11434 然后在模型中配置

在 Dify 的主界面 http://localhost/apps ,點擊右上角用戶名下的【設置】  在設置頁面--Ollama--添加模型,如下:

在設置頁面--Ollama--添加模型,如下:  添加成功后的

添加成功后的

在設置頁面--Ollama--添加模型,如下:

在設置頁面--Ollama--添加模型,如下:  添加成功后的

添加成功后的

模型添加完成以后,刷新頁面,進行系統模型設置。步驟:輸入 “ http://localhost/install ” 進入 Dify 主頁,用戶名 -- 設 置--模型供應商,點擊右側【系統模型設置】,如下:  這樣就關聯成功了!!!

這樣就關聯成功了!!!

這樣就關聯成功了!!!

這樣就關聯成功了!!! 下一集:DIFY搭建知識庫

Dify教程目錄

一、Dify的介紹

二、Dify的安裝方式

1. 本地部署

2. Docker安裝

3.Ollama

4.Dify關聯Ollama

三、Dify應用講解

1. 創建空白應用

2. 創建本地知識庫

3.知識庫應用

4. AI圖片生成工具

5. 旅游助手

6. SQL執行器

7. 科研論文翻譯

8. SEO翻譯

9. 標題覚文案生成

10.知識庫圖像檢索和展示

11.自然語言生成SQL

12. Echarts可視化助手

.........

持續更新中,如需DIFY全流程文檔可關注博主,查看私信獲取哦

)

安裝筆記)

:零信任架構下的認證授權技術與實戰)

)

)

)

上使用Qt編譯時遇到“type_traits文件未找到”的錯誤)