引言

過去十年,深度學習在圖像識別領域取得了驚人的突破。從2012年ImageNet大賽上的AlexNet,到后來的ResNet、EfficientNet,再到近年來Transformer架構的崛起,AI已經能在許多任務上超越人類,比如人臉識別、目標檢測、醫學影像分析等。然而,這些系統雖然能識別圖像中的物體,卻并不真正“理解”它們的含義。

想象這樣一個場景:一張圖片里有一只狗、一只貓和一個倒在地上的水杯。傳統的圖像識別模型能準確地告訴你這些物體分別是什么,但卻無法理解它們之間的關系——這只狗是不是剛剛撞到了桌子,導致水杯倒下?這只貓是不是在觀察水杯,還在猶豫要不要去舔灑出來的水?當前的深度學習模型仍然缺乏這樣的情境理解能力。

這正是AI發展的下一個關鍵挑戰——讓機器不僅能看到世界,還能理解世界。真正的智能不只是“識別物體”,更是“理解場景”,包括因果關系、行為意圖和時間演化等更深層次的信息。

本文將探討深度學習如何從圖像識別邁向情境理解,分析當前的技術瓶頸,并介紹正在推動這一領域進步的新方法和應用場景。

一、從圖像識別到情境理解的挑戰

盡管深度學習在圖像識別方面取得了顯著進步,但讓AI真正理解視覺場景仍然面臨諸多挑戰。這些挑戰不僅涉及技術層面的問題,也關乎AI如何認知世界的本質。

1、靜態識別 vs. 動態理解

目前的圖像識別技術主要關注單幀圖像中的物體分類和檢測,即“這是什么?”然而,在現實世界中,我們不僅要識別物體,還要理解它們之間的關系以及事件的動態發展。例如,在一張圖片中,AI或許能識別出一個人正在奔跑,但它難以判斷這個人是在追趕公交車,還是在逃離某個危險情境。情境理解要求AI能夠結合時間、空間和背景信息,分析物體的行為模式和潛在意圖。

2、多模態融合的必要性

人類在理解場景時,不僅依賴視覺信息,還會結合語言、聲音、常識知識等多種信息來源。例如,在一張餐桌上的圖片中,我們可以輕易推測出正在進行的是一場晚餐,而不僅僅是“桌子+盤子+食物”的簡單組合。然而,當前的計算機視覺系統往往只依賴于視覺數據,缺乏對語言描述、語音對話甚至觸覺信息的融合。這導致AI難以像人類一樣,通過多種感官信息來形成完整的認知。

3、因果推理 vs. 相關性學習

深度學習的本質是通過海量數據學習模式和相關性,但它并不具備因果推理能力。例如,如果AI在大量數據中發現“雨天時路上行人打傘的概率很高”,它可以基于模式學習來預測某天的場景中可能會出現打傘的人,但它無法理解“因為下雨,所以人們需要打傘”這一因果關系。這種缺乏因果推理的局限,使得AI在遇到復雜情境時容易產生錯誤推斷。例如,如果它看到一個人摔倒,它可能會簡單地把這歸結為“人類有摔倒的可能性”,而不是嘗試理解是由于地面濕滑、身體失去平衡或其他外部因素導致的。

4、對外部知識的依賴

人類理解世界的方式不僅僅是通過視覺感知,還依賴于豐富的世界知識和經驗。例如,一張圖片顯示一個人在廚房里切菜,人類可以推測出他可能正在準備一頓飯,因為我們擁有關于“做飯”的常識。然而,深度學習模型通常只學習有限的數據集,并不具備對世界的廣泛知識,因此難以推理出更高級的情境信息。

挑戰總結

要讓AI從圖像識別邁向真正的情境理解,需要突破以下幾個關鍵難點:

從靜態識別邁向動態分析,讓AI理解事件的時間發展過程。

整合多模態信息,讓視覺AI不僅依賴圖像,還能結合語言、聲音和知識庫。

引入因果推理能力,讓AI不只是發現模式,而是理解事件發生的邏輯關系。

讓AI具備世界知識,幫助其理解人類社會的規則、物理世界的規律以及人們的行為動機。

這些挑戰正推動計算機視覺和深度學習技術邁向新的方向,而在后續部分,我們將探討目前正在發展的核心技術,以及它們如何幫助AI更接近真正的“情境理解”。

二、技術突破:邁向情境理解的核心方向

要讓深度學習從簡單的圖像識別進化到真正的情境理解,需要突破多個關鍵技術瓶頸。目前,學術界和工業界正在從多個方向推進這些技術,包括視覺-語言模型、多模態融合、大規模世界知識整合、3D感知以及因果推理等。這些進展將幫助AI構建更接近人類的視覺認知能力。

1、視覺-語言模型(VLMs):用語言增強視覺理解

目前,像CLIP、BLIP、LLaVA(LLaMA + Vision)等視覺-語言模型,已經開始改變AI對圖像的認知方式。它們不僅能識別圖像中的物體,還能通過文本理解其含義。例如,CLIP 可以在沒有特定標注的情況下,根據文本描述來搜索或分類圖片,而LLaVA能像GPT一樣分析圖片并回答關于場景的復雜問題。

突破點:利用大規模文本數據幫助AI理解視覺概念,使AI不僅能看到物體,還能用語言表達其關系、作用和語境。

應用:智能搜索、視覺問答(VQA)、AI助手對圖片的深度理解(如描述藝術作品的風格與情感)。

2、大模型與世界知識的結合:讓AI具備“常識”

人類理解一張圖片時,會利用過去的經驗和世界知識。例如,看到一個人在廚房里切菜,我們能推測他在做飯,而不是隨意玩弄刀具。AI當前的一個重大挑戰是缺乏這樣的常識認知。

突破點:結合大規模知識圖譜(如ConceptNet、Wikidata)和大模型(如GPT-4、Gemini),讓AI能基于已有知識推理場景的真實含義。

應用:智能客服(基于圖片推測用戶意圖)、醫療診斷(結合病歷和影像判斷病因)。

3、3D感知與場景重建:從2D到真實世界的理解

傳統的圖像識別依賴2D圖像,但真實世界是三維的。為了更好地理解場景,AI需要具備3D感知能力。

突破點:NeRF(神經輻射場)、三維點云技術、深度學習驅動的3D場景重建,使AI能理解物體的空間關系、尺度以及環境。

應用:自動駕駛(理解道路結構、車輛動態)、機器人導航(精準避障和路徑規劃)、AR/VR(增強現實與交互體驗)。

4、視頻理解與事件推理:跨越時間維度的智能

大多數視覺AI仍然局限于單幀圖像的理解,而人類認知是基于時間的。視頻分析技術正在向深層次的事件推理發展,重點在于預測和理解行為。

突破點:基于Transformer的時序模型(如TimeSformer)、視頻大模型(如VideoGPT),能夠分析視頻中的行為模式,理解因果關系。

應用:安防監控(預測異常行為,如店鋪盜竊)、體育分析(理解球員戰術和運動軌跡)、影視智能剪輯(自動識別精彩片段)。

5、因果推理:讓AI理解“為什么”而非“是什么”

目前的深度學習系統主要依賴數據模式匹配,而不是因果推理。例如,AI可以識別出“雨天人們打傘”這一模式,但難以理解“因為下雨,人們才打傘”。

突破點:因果推理方法(如貝葉斯網絡、結構方程建模)正在與深度學習結合,使AI能夠建立因果關系,而不僅僅是統計相關性。

應用:醫學診斷(推測病因,而不僅是發現病癥)、經濟預測(分析政策變化對市場的真實影響)、工業故障檢測(判斷設備損壞的根本原因)。

總結

邁向情境理解,AI需要突破單純的視覺識別,向更高級的推理能力發展。視覺-語言融合、大模型知識整合、3D感知、時間維度理解以及因果推理,是當前推動深度學習進化的關鍵技術方向。隨著這些技術的不斷進步,AI將逐步從“看到”世界邁向“理解”世界,使其在自動駕駛、智能安防、機器人交互、醫療診斷等領域發揮更強大的作用。

三、應用場景:AI如何真正理解世界

當AI不僅能識別圖像中的物體,還能理解場景、推測意圖、預測事件時,它的應用價值將大幅提升。從自動駕駛到智能安防,從醫療診斷到機器人交互,情境理解技術將賦予AI更接近人類的感知能力,讓它真正“看懂”世界。

1、自動駕駛:不僅識別物體,還能理解道路場景

傳統的自動駕駛算法主要依賴目標檢測和路徑規劃,例如識別紅綠燈、行人、車輛等元素。然而,復雜的道路環境需要更深層的理解,例如:

預測行人的意圖:AI需要判斷一個行人是否只是站在路邊,還是即將橫穿馬路。

識別道路上的隱性風險:比如前方一輛車突然減速,可能是因為前方有障礙物,AI需要據此調整駕駛策略。

結合交通法規和常識:理解非正式交通規則,如某些地區的“禮讓行人”文化,或者觀察其他駕駛員的行為來預測潛在危險。

情境理解可以讓自動駕駛系統更安全、更智能,真正像人類駕駛員一樣做出合理決策。

2、智能安防:分析異常行為,而非簡單目標檢測

當前的安防系統主要依賴于攝像頭檢測異常物體,比如非法入侵、遺棄物品等。然而,許多危險行為在發生前并不會表現為明顯的“異常目標”,而是需要結合背景信息進行推理。例如:

在地鐵站,一名乘客徘徊不定,時而接近站臺邊緣,AI可以結合行人正常行為模式,判斷其是否有墜軌風險。

在商場,AI不僅檢測到顧客拿起商品,還能分析其購物行為是否符合正常模式,幫助商家識別潛在盜竊行為。

在智慧城市管理中,AI可以通過視頻分析,判斷人群密集區域是否存在踩踏風險,并提前預警。

情境理解讓安防系統從“被動監控”升級為“主動預測”,提升公共安全。

3、機器人交互:讓機器人理解環境,進行自主決策

家庭服務機器人、工業機器人乃至人形機器人,只有真正理解環境,才能提供更自然的交互體驗。例如:

家用機器人:當機器人看到主人在廚房忙碌,并聽到水沸騰的聲音,它能推測主人可能需要幫忙關火,而不僅僅是識別“鍋”和“水”。

工廠自動化:機器人在生產線上需要根據工人的動作和生產節奏進行調整,而不僅僅是機械地執行預設任務。

智能倉儲:AI機器人可以通過攝像頭分析貨物的擺放情況,理解哪些商品需要補貨,而不是僅僅依賴條形碼掃描。

有了情境理解,機器人將變得更加智能,真正具備“看懂”世界的能力。

4、醫療影像分析:結合患者病史,實現精準診斷

傳統的醫學影像AI主要依賴于圖像分類,比如判斷X光片或MRI掃描是否存在腫瘤。然而,醫生在做診斷時,不僅僅依賴單張影像,而是結合患者的病史、癥狀、實驗室檢測等多方面信息。因此,AI的情境理解能力對醫學診斷至關重要,例如:

在肺部CT掃描中,AI可以結合患者是否有長期吸煙史,調整診斷的置信度,避免誤判。

在腦部MRI中,AI可以結合患者的年齡、家族遺傳病史,分析是否有阿爾茨海默癥的早期跡象。

在急診中,AI可以實時分析多種傳感器數據,例如結合患者的心電圖、血壓和體溫,做出綜合判斷,而不僅僅依賴影像數據。

通過情境理解,AI可以提供更精準的醫學診斷,減少誤診率,提高醫療效率。

總結

AI的情境理解能力正在推動多個行業的智能化升級。從自動駕駛的智能決策,到智能安防的行為預測,從機器人交互的自然化,到醫療診斷的精準化,AI正在從“識別世界”走向“理解世界”。未來,隨著多模態學習、因果推理和大模型的發展,AI的情境理解能力將不斷提升,使其在更多場景中發揮更大價值。

四、未來展望與挑戰

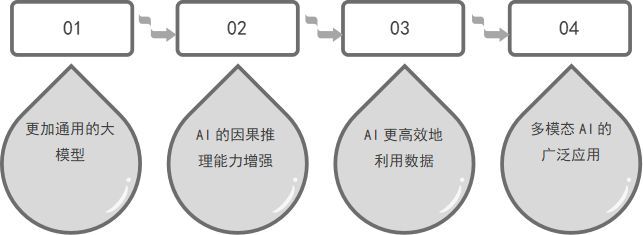

隨著深度學習從圖像識別邁向情境理解,AI正在逐步接近人類的視覺認知能力。然而,要讓AI真正理解世界,而不僅僅是“看見”,仍然面臨諸多挑戰。未來的發展將集中在更強大的模型、更高效的數據利用、因果推理能力的增強,以及倫理與安全問題的應對。

1、未來展望:AI如何邁向更高層次的理解?

更加通用的大模型

未來的AI不僅需要掌握視覺信息,還要結合語言、語音、文本、物理世界知識,形成“通用情境理解”能力。例如,下一代AI可以在看到一張手術室的照片時,不僅能識別器械和醫生,還能基于醫學知識推測手術的類型和風險。

具備通用情境理解能力的AI,將在醫療、自動駕駛、智能機器人等領域發揮更大作用。

AI的因果推理能力增強

未來的AI將超越基于相關性的模式學習,逐步具備因果推理能力。例如,在自動駕駛中,AI不僅能識別行人,還能推測行人的意圖,判斷其是否即將橫穿馬路。

結合貝葉斯網絡、結構因果模型等方法,使AI能夠基于情境推測事件的發展,而不僅僅是做靜態分類。

AI更高效地利用數據

目前的大模型依賴海量數據訓練,未來的AI需要具備“少樣本學習”(Few-shot Learning)和“零樣本學習”(Zero-shot Learning)能力。

通過強化學習、自監督學習等方法,使AI能在有限的數據情況下,依然具備出色的情境理解能力。

多模態AI的廣泛應用

AI將不再僅僅依賴視覺,而是結合語音、文本、物理感知,真正做到“感知+理解”。

例如,未來的智能家居系統,能通過攝像頭、語音傳感器、溫度傳感器等多種信息源,判斷用戶的意圖并做出最合理的響應。

2、仍然存在的挑戰:AI能否真正理解世界?

計算資源的巨大消耗

訓練具備情境理解能力的大模型,需要極高的計算資源。如何提高AI的計算效率,同時降低能耗,是未來技術突破的關鍵。

數據偏見與泛化能力

AI對情境的理解,往往依賴于訓練數據。但如果數據存在偏見,AI的理解能力也可能受到限制。例如,如果某個醫療AI主要基于西方國家的數據訓練,它可能無法很好地適用于亞洲患者。

如何讓AI具備更強的泛化能力,適應不同的環境,是一個重要挑戰。

因果推理的局限性

目前的因果推理方法,仍然無法完全復制人類的思維方式。例如,一個人看到倒地的水杯,會立刻推測它是被某個外力打翻的,而AI仍然難以在沒有明確數據支持的情況下做出類似推理。

未來需要結合更多的知識圖譜、邏輯推理方法,讓AI真正具備因果推理能力。

倫理與安全問題

具備情境理解能力的AI,如果被濫用,可能會帶來倫理問題。例如,過于精準的行為分析,可能會侵犯用戶隱私。

如何在提升AI智能的同時,確保其在合規、安全的范圍內使用,將成為未來發展的重要議題。

結語

從圖像識別到情境理解,AI正在從“看得見”走向“看得懂”。盡管面臨計算資源、因果推理、數據偏見等挑戰,但未來隨著大模型、因果推理、多模態融合技術的突破,AI有望在更多復雜場景中發揮作用,實現真正的智能化。

結論

從圖像識別到情境理解,深度學習正在邁向一個全新的階段。過去的AI能夠準確識別物體,但缺乏對場景、意圖和因果關系的理解。而如今,借助視覺-語言模型、多模態融合、因果推理和3D感知等技術,AI正逐步從“看得見”走向“看得懂”,在自動駕駛、智能安防、醫療診斷、機器人交互等領域展現出巨大的潛力。

然而,真正的情境理解仍然面臨諸多挑戰,例如計算資源消耗、數據偏見、因果推理的局限性以及倫理安全問題。未來的發展需要更強大的通用模型、更高效的數據利用方式,以及更完善的安全與合規機制,才能讓AI真正具備人類般的理解能力。

盡管道路充滿挑戰,但情境理解無疑是AI發展的下一個關鍵突破口。當AI不再只是被動地識別信息,而是能夠主動推理、預測和決策時,它將徹底改變我們與技術的交互方式,為社會帶來前所未有的智能化變革。

)

)

——修改emacs的一些默認行為)

)