搜索引擎的優勢

有了數據庫分頁查詢,為什么還需要搜索引擎?

- 搜索引擎

速度上很快 數據庫分頁查詢,隨著數據庫數據量增大,頁數靠后,會導致搜索速度變慢,但是搜索引擎不會- 搜索引擎支持

分詞查詢,地理坐標搜索等

搜索引擎排名

- 搜索引擎技術排名:

- Elasticsearch:搜索引擎

- Splunk:商目

- Solr:Apache

認識與安裝elasticSearch

前世

Lucene是一個Java語言的搜索引擎類庫,是Apache公司的頂級項目,由DougCutting于1999年研發

Lucene的優勢:

- 易擴展

- 高性能(基于倒排索引)

今生

2004年Shay Banon基于Lucene開發了Compass

2010年Shay Banon 重寫了Compass,取名為Elasticsearch。

官網地址:https:/www.elastic.co/cn/,目前最新的版本是:8.x.x

elasticsearch具備下列優勢:

- 支持

分布式,可水平擴展 - 提供

Restful接口,可被任何語言調用

結合

elasticsearch結合kibana、Logstash、Beats,是一整套技術棧,被叫做ELK。被廣泛應用在日志數據分析、實時監控等領域。

我們要安裝的內容包含2部分:

- elasticsearch:存儲、搜索和運算

- kibana:圖形化展示

首先Elasticsearch不用多說,是提供核心的數據存儲、搜索、分析功能的。

然后是Kibana,Elasticsearch對外提供的是Restful風格的API,任何操作都可以通過發送http請求來完成。不過http請求的方式、路徑、還有請求參數的格式都有嚴格的規范。這些規范我們肯定記不住,因此我們要借助于Kibana這個服務。

Kibana是elastic公司提供的用于操作Elasticsearch的可視化控制臺。它的功能非常強大,包括:

- 對Elasticsearch數據的搜索、展示

- 對Elasticsearch數據的統計、聚合,并形成圖形化報表、圖形

- 對Elasticsearch的集群狀態監控

- 它還提供了一個開發控制臺(DevTools),在其中對Elasticsearch的Restful的API接口提供了

語法提示

安裝elasticSearch

通過下面的Docker命令即可安裝單機版本的elasticsearch:

docker run -d \--name es \-e "ES_JAVA_OPTS=-Xms512m -Xmx512m" \-e "discovery.type=single-node" \-v es-data:/usr/share/elasticsearch/data \-v es-plugins:/usr/share/elasticsearch/plugins \--privileged \--network hm-net \-p 9200:9200 \-p 9300:9300 \elasticsearch:7.12.1

注意,這里我們采用的是elasticsearch的7.12.1版本,由于8以上版本的JavaAPI變化很大,在企業中應用并不廣泛,企業中應用較多的還是8以下的版本。

如果拉取鏡像困難,可以直接導入課前資料提供的鏡像tar包:

安裝完成后,訪問9200端口,即可看到響應的Elasticsearch服務的基本信息:

安裝Kibana

通過下面的Docker命令,即可部署Kibana:

docker run -d \

--name kibana \

-e ELASTICSEARCH_HOSTS=http://es:9200 \

--network=hm-net \

-p 5601:5601 \

kibana:7.12.1

如果拉取鏡像困難,可以直接導入課前資料提供的鏡像tar包:

安裝完成后,直接訪問5601端口,即可看到控制臺頁面:

選擇Explore on my own之后,進入主頁面:

然后選中Dev tools,進入開發工具頁面:

倒排索引

傳統數據庫

傳統數據庫(如MySQL)采用正向索引,例如給下表(tb_goods)中的id創建索引:

elasticSearch

elasticsearch采用倒排索引:

文檔(document):每條數據就是一個文檔詞條(term):文檔按照語義分成的詞語

lk分詞器

中文分詞往往需要根據語義分析,比較復雜,這就需要用到中文分詞器,例如IK分詞器。IK分詞器是林良益在2006年開源發布的,其采用的正向迭代最細粒度切分算法一直沿用至今。

1.安裝IK分詞器

方案一:在線安裝

運行一個命令即可:

docker exec -it es ./bin/elasticsearch-plugin install https://github.com/medcl/elasticsearch-analysis-ik/releases/download/v7.12.1/elasticsearch-analysis-ik-7.12.1.zip

重啟

docker restart es

方案二:離線安裝

如果網速較差,也可以選擇離線安裝。

首先,查看之前安裝的Elasticsearch容器的plugins數據卷目錄:

docker volume inspect es-plugins

結果如下:

[{"CreatedAt": "2024-11-06T10:06:34+08:00","Driver": "local","Labels": null,"Mountpoint": "/var/lib/docker/volumes/es-plugins/_data","Name": "es-plugins","Options": null,"Scope": "local"}

]

可以看到elasticsearch的插件掛載到了/var/lib/docker/volumes/es-plugins/_data這個目錄。我們需要把IK分詞器上傳至這個目錄。

找到課前資料提供的ik分詞器插件,課前資料提供了7.12.1版本的ik分詞器壓縮文件,你需要對其解壓:

然后上傳至虛擬機的/var/lib/docker/volumes/es-plugins/_data這個目錄:

最后,重啟es容器:

docker restart es

2.使用IK分詞器

IK分詞器包含兩種模式:

- ik_smart:智能語義切分

- ik_max_word:最細粒度切分

我們在Kibana的DevTools上來測試分詞器,首先測試Elasticsearch官方提供的標準分詞器:

POST /_analyze

{"analyzer": "standard","text": "黑馬程序員學習java太棒了"

}

結果如下:

{"tokens" : [{"token" : "黑","start_offset" : 0,"end_offset" : 1,"type" : "<IDEOGRAPHIC>","position" : 0},{"token" : "馬","start_offset" : 1,"end_offset" : 2,"type" : "<IDEOGRAPHIC>","position" : 1},{"token" : "程","start_offset" : 2,"end_offset" : 3,"type" : "<IDEOGRAPHIC>","position" : 2},{"token" : "序","start_offset" : 3,"end_offset" : 4,"type" : "<IDEOGRAPHIC>","position" : 3},{"token" : "員","start_offset" : 4,"end_offset" : 5,"type" : "<IDEOGRAPHIC>","position" : 4},{"token" : "學","start_offset" : 5,"end_offset" : 6,"type" : "<IDEOGRAPHIC>","position" : 5},{"token" : "習","start_offset" : 6,"end_offset" : 7,"type" : "<IDEOGRAPHIC>","position" : 6},{"token" : "java","start_offset" : 7,"end_offset" : 11,"type" : "<ALPHANUM>","position" : 7},{"token" : "太","start_offset" : 11,"end_offset" : 12,"type" : "<IDEOGRAPHIC>","position" : 8},{"token" : "棒","start_offset" : 12,"end_offset" : 13,"type" : "<IDEOGRAPHIC>","position" : 9},{"token" : "了","start_offset" : 13,"end_offset" : 14,"type" : "<IDEOGRAPHIC>","position" : 10}]

}可以看到,標準分詞器智能1字1詞條,無法正確對中文做分詞。

我們再測試IK分詞器:

POST /_analyze

{"analyzer": "ik_smart","text": "黑馬程序員學習java太棒了"

}

執行結果如下:

{"tokens" : [{"token" : "黑馬","start_offset" : 0,"end_offset" : 2,"type" : "CN_WORD","position" : 0},{"token" : "程序員","start_offset" : 2,"end_offset" : 5,"type" : "CN_WORD","position" : 1},{"token" : "學習","start_offset" : 5,"end_offset" : 7,"type" : "CN_WORD","position" : 2},{"token" : "java","start_offset" : 7,"end_offset" : 11,"type" : "ENGLISH","position" : 3},{"token" : "太棒了","start_offset" : 11,"end_offset" : 14,"type" : "CN_WORD","position" : 4}]

}隨著互聯網的發展,“造詞運動”也越發的頻繁。出現了很多新的詞語,在原有的詞匯列表中并不存在。比如:“泰褲辣”,“傳智播客” 等。

IK分詞器無法對這些詞匯分詞,測試一下:

POST /_analyze

{"analyzer": "ik_max_word","text": "傳智播客開設大學,真的泰褲辣!"

}

結果:

{"tokens" : [{"token" : "傳","start_offset" : 0,"end_offset" : 1,"type" : "CN_CHAR","position" : 0},{"token" : "智","start_offset" : 1,"end_offset" : 2,"type" : "CN_CHAR","position" : 1},{"token" : "播","start_offset" : 2,"end_offset" : 3,"type" : "CN_CHAR","position" : 2},{"token" : "客","start_offset" : 3,"end_offset" : 4,"type" : "CN_CHAR","position" : 3},{"token" : "開設","start_offset" : 4,"end_offset" : 6,"type" : "CN_WORD","position" : 4},{"token" : "大學","start_offset" : 6,"end_offset" : 8,"type" : "CN_WORD","position" : 5},{"token" : "真的","start_offset" : 9,"end_offset" : 11,"type" : "CN_WORD","position" : 6},{"token" : "泰","start_offset" : 11,"end_offset" : 12,"type" : "CN_CHAR","position" : 7},{"token" : "褲","start_offset" : 12,"end_offset" : 13,"type" : "CN_CHAR","position" : 8},{"token" : "辣","start_offset" : 13,"end_offset" : 14,"type" : "CN_CHAR","position" : 9}]

}可以看到,傳智播客和泰褲辣都無法正確分詞。

所以要想正確分詞,IK分詞器的詞庫也需要不斷的更新,IK分詞器提供了擴展詞匯的功能。

1)打開IK分詞器config目錄:

注意,如果采用在線安裝的通過,默認是沒有config目錄的,需要把課前資料提供的ik下的config上傳至對應目錄。

2)在IKAnalyzer.cfg.xml配置文件內容添加:

<?xml version="1.0" encoding="UTF-8"?>

<!DOCTYPE properties SYSTEM "http://java.sun.com/dtd/properties.dtd">

<properties><comment>IK Analyzer 擴展配置</comment><!--用戶可以在這里配置自己的擴展字典 *** 添加擴展詞典--><entry key="ext_dict">ext.dic</entry>

</properties>

3)在IK分詞器的config目錄新建一個 ext.dic,可以參考config目錄下復制一個配置文件進行修改

傳智播客

泰褲辣

4)重啟elasticsearch

docker restart es# 查看 日志

docker logs -f elasticsearch

再次測試,可以發現傳智播客和泰褲辣都正確分詞了:

{"tokens" : [{"token" : "傳智播客","start_offset" : 0,"end_offset" : 4,"type" : "CN_WORD","position" : 0},{"token" : "開設","start_offset" : 4,"end_offset" : 6,"type" : "CN_WORD","position" : 1},{"token" : "大學","start_offset" : 6,"end_offset" : 8,"type" : "CN_WORD","position" : 2},{"token" : "真的","start_offset" : 9,"end_offset" : 11,"type" : "CN_WORD","position" : 3},{"token" : "泰褲辣","start_offset" : 11,"end_offset" : 14,"type" : "CN_WORD","position" : 4}]

}

總結

分詞器的作用是什么?

- 創建

倒排索引時,對文檔分詞 - 用戶搜索時,對輸入的內容分詞

IK分詞器有幾種模式?

- ik_smart:

智能切分,粗粒度 - ik_max_word:最細切分,細粒度

IK分詞器如何拓展詞條?如何停用詞條?

- 利用

config目錄的IkAnalyzer.cfg.xml文件添加拓展詞典和停用詞典 - 在詞典中添加

拓展詞條或者停用詞條

基本概念

- 索引(index):相同類型的文檔的

集合 - 映射(mapping):索引中文檔的字段約束信息,類似

表的結構約束

數據庫和elasticSearch的對比

Mapping的映射屬性

mapping是對索引庫中文檔的約束,常見的mapping屬性包括:

- type:字段數據類型,常見的簡單類型有:

- 字符串:text(可分詞的文本)、keyword(精確值,例如:品牌、國家、ip地址)

- 數值:long、integer、short、byte、double、float、

- 布爾:boolean

- 日期:date

- 對象:object

- index:是否創建索引,默認為true

- analyzer:使用哪種分詞器

- properties:該字段的子字段

restful規范

Elasticsearch提供的所有API都是Restful的接口,遵循Restful的基本規范:

創建索引和mapping

基本語法:

- 請求方式:PUT

- 請求路徑:/索引庫名,可以自定義

- 請求參數:mapping映射

格式:

PUT /索引庫名稱

{"mappings": {"properties": {"字段名":{"type": "text","analyzer": "ik_smart"},"字段名2":{"type": "keyword","index": "false"},"字段名3":{"properties": {"子字段": {"type": "keyword"}}},// ...略}}

}

示例:

# PUT /heima

{"mappings": {"properties": {"info":{"type": "text","analyzer": "ik_smart"},"email":{"type": "keyword","index": "false"},"name":{"properties": {"firstName": {"type": "keyword"}}}}}

}

查詢索引庫

基本語法:

- 請求方式:GET

- 請求路徑:/索引庫名

- 請求參數:無

格式:

GET /索引庫名

示例:

GET /heima

修改索引庫

倒排索引結構雖然不復雜,但是一旦數據結構改變(比如改變了分詞器),就需要重新創建倒排索引,這簡直是災難。因此索引庫一旦創建,無法修改mapping。

雖然無法修改mapping中已有的字段,但是卻允許添加新的字段到mapping中,因為不會對倒排索引產生影響。因此修改索引庫能做的就是向索引庫中添加新字段,或者更新索引庫的基礎屬性。

語法說明:

PUT /索引庫名/_mapping

{"properties": {"新字段名":{"type": "integer"}}

}

示例:

PUT /heima/_mapping

{"properties": {"age":{"type": "integer"}}

}

刪除索引庫

語法:

- 請求方式:DELETE

- 請求路徑:/索引庫名

- 請求參數:無

格式:

DELETE /索引庫名

示例:

DELETE /heima

總結

索引庫操作有哪些?

- 創建索引庫:PUT /索引庫名

- 查詢索引庫:GET /索引庫名

- 刪除索引庫:DELETE /索引庫名

- 修改索引庫,添加字段:PUT /索引庫名/_mapping

可以看到,對索引庫的操作基本遵循的Restful的風格,因此API接口非常統一,方便記憶。

文檔操作

crud操作

有了索引庫,接下來就可以向索引庫中添加數據了。

Elasticsearch中的數據其實就是JSON風格的文檔。操作文檔自然保護增、刪、改、查等幾種常見操作,我們分別來學習。

1.新增文檔

語法:

POST /索引庫名/_doc/文檔id

{"字段1": "值1","字段2": "值2","字段3": {"子屬性1": "值3","子屬性2": "值4"},

}

示例:

POST /heima/_doc/1

{"info": "黑馬程序員Java講師","email": "zy@itcast.cn","name": {"firstName": "云","lastName": "趙"}

}

響應:

2.查詢文檔

根據rest風格,新增是post,查詢應該是get,不過查詢一般都需要條件,這里我們把文檔id帶上。

語法:

GET /{索引庫名稱}/_doc/{id}

示例:

GET /heima/_doc/1

查看結果:

3.刪除文檔

刪除使用DELETE請求,同樣,需要根據id進行刪除:

語法:

DELETE /{索引庫名}/_doc/id值

示例:

DELETE /heima/_doc/1

結果:

4.修改文檔

修改有兩種方式:

- 全量修改:直接覆蓋原來的文檔

- 局部修改:修改文檔中的部分字段

4.1.全量修改

全量修改是覆蓋原來的文檔,其本質是兩步操作:

- 根據指定的id刪除文檔

- 新增一個相同id的文檔

注意:如果根據id刪除時,id不存在,第二步的新增也會執行,也就從修改變成了新增操作了。

語法:

PUT /{索引庫名}/_doc/文檔id

{"字段1": "值1","字段2": "值2",// ... 略

}

示例:

PUT /heima/_doc/1

{"info": "黑馬程序員高級Java講師","email": "zy@itcast.cn","name": {"firstName": "云","lastName": "趙"}

}

由于id為1的文檔已經被刪除,所以第一次執行時,得到的反饋是created:

所以如果執行第2次時,得到的反饋則是updated:

4.2.局部修改

局部修改是只修改指定id匹配的文檔中的部分字段。

語法:

POST /{索引庫名}/_update/文檔id

{"doc": {"字段名": "新的值",}

}

示例:

POST /heima/_update/1

{"doc": {"email": "ZhaoYun@itcast.cn"}

}

執行結果:

批處理

批處理采用POST請求,基本語法如下:

POST _bulk

{ "index" : { "_index" : "test", "_id" : "1" } }

{ "field1" : "value1" }

{ "delete" : { "_index" : "test", "_id" : "2" } }

{ "create" : { "_index" : "test", "_id" : "3" } }

{ "field1" : "value3" }

{ "update" : {"_id" : "1", "_index" : "test"} }

{ "doc" : {"field2" : "value2"} }

其中:

- index代表新增操作

- _index:指定索引庫名

- _id指定要操作的文檔id

- { “field1” : “value1” }:則是要新增的文檔內容

- delete代表刪除操作

- _index:指定索引庫名

- _id指定要操作的文檔id

- update代表更新操作

- _index:指定索引庫名

- _id指定要操作的文檔id

- { “doc” : {“field2” : “value2”} }:要更新的文檔字段

示例,批量新增:

POST /_bulk

{"index": {"_index":"heima", "_id": "3"}}

{"info": "黑馬程序員C++講師", "email": "ww@itcast.cn", "name":{"firstName": "五", "lastName":"王"}}

{"index": {"_index":"heima", "_id": "4"}}

{"info": "黑馬程序員前端講師", "email": "zhangsan@itcast.cn", "name":{"firstName": "三", "lastName":"張"}}

批量刪除:

POST /_bulk

{"delete":{"_index":"heima", "_id": "3"}}

{"delete":{"_index":"heima", "_id": "4"}}

小結

文檔操作有哪些?

- 創建文檔:POST /{索引庫名}/_doc/文檔id { json文檔 }

- 查詢文檔:GET /{索引庫名}/_doc/文檔id

- 刪除文檔:DELETE /{索引庫名}/_doc/文檔id

- 修改文檔:

- 全量修改:PUT /{索引庫名}/_doc/文檔id { json文檔 }

- 局部修改:POST /{索引庫名}/_update/文檔id { “doc”: {字段}}

Java客戶端操作索引庫

Elasticsearch目前最新版本是8.0,其java客戶端有很大變化。不過大多數企業使用的還是8以下版本,所以我們選擇使用早期的JavaRestClient客戶端來學習。官方文檔地址:Elasticsearch Clients|Elastic

然后選擇7.12版本,HighLevelRestClient版本:

初始化client

在elasticsearch提供的API中,與elasticsearch一切交互都封裝在一個名為RestHighLevelClient的類中,必須先完成這個對象的初始化,建立與elasticsearch的連接。

分為三步:

1)在item-service模塊中引入es的RestHighLevelClient依賴:

<dependency><groupId>org.elasticsearch.client</groupId><artifactId>elasticsearch-rest-high-level-client</artifactId>

</dependency>

2)因為SpringBoot默認的ES版本是7.17.10,所以我們需要覆蓋默認的ES版本:

<properties><maven.compiler.source>11</maven.compiler.source><maven.compiler.target>11</maven.compiler.target><elasticsearch.version>7.12.1</elasticsearch.version></properties>

3)初始化RestHighLevelClient:

初始化的代碼如下:

RestHighLevelClient client = new RestHighLevelClient(RestClient.builder(HttpHost.create("http://192.168.150.101:9200")

));

這里為了單元測試方便,我們創建一個測試類IndexTest,然后將初始化的代碼編寫在@BeforeEach方法中:

package com.hmall.item.es;import org.apache.http.HttpHost;

import org.elasticsearch.client.RequestOptions;

import org.elasticsearch.client.RestClient;

import org.elasticsearch.client.RestHighLevelClient;

import org.elasticsearch.client.indices.CreateIndexRequest;

import org.elasticsearch.common.xcontent.XContentType;

import org.junit.jupiter.api.AfterEach;

import org.junit.jupiter.api.BeforeEach;

import org.junit.jupiter.api.Test;import java.io.IOException;public class ElasticSearchTest {private RestHighLevelClient client;@BeforeEachvoid setUp() {this.client = new RestHighLevelClient(RestClient.builder(HttpHost.create("http://192.168.88.130:9200")));}@Testvoid testConnect() {System.out.println(client);}@AfterEachvoid tearDown() throws IOException {this.client.close();}}1.創建索引庫

由于要實現對商品搜索,所以我們需要將商品添加到Elasticsearch中,不過需要根據搜索業務的需求來設定索引庫結構,而不是一股腦的把MySQL數據寫入Elasticsearch.

1.1.Mapping映射

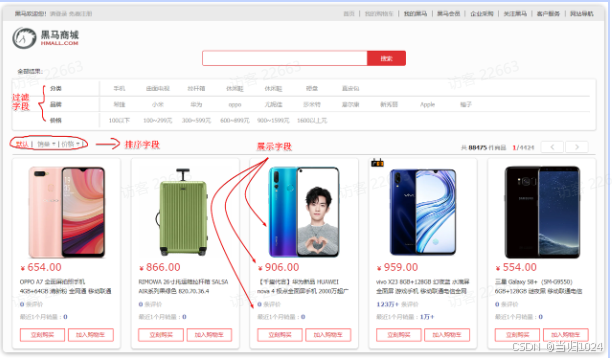

搜索頁面的效果如圖所示:

實現搜索功能需要的字段包括三大部分:

- 搜索過濾字段

- 分類

- 品牌

- 價格

- 排序字段

- 默認:按照更新時間降序排序

- 銷量

- 價格

- 展示字段

- 商品id:用于點擊后跳轉

- 圖片地址

- 是否是廣告推廣商品

- 名稱

- 價格

- 評價數量

- 銷量

對應的商品表結構如下,索引庫無關字段已經劃掉:

結合數據庫表結構,以上字段對應的mapping映射屬性如下:

因此,最終我們的索引庫文檔結構應該是這樣:

PUT /items

{"mappings": {"properties": {"id": {"type": "keyword"},"name":{"type": "text","analyzer": "ik_max_word"},"price":{"type": "integer"},"stock":{"type": "integer"},"image":{"type": "keyword","index": false},"category":{"type": "keyword"},"brand":{"type": "keyword"},"sold":{"type": "integer"},"commentCount":{"type": "integer","index": false},"isAD":{"type": "boolean"},"updateTime":{"type": "date"}}}

}

1.2.創建索引

創建索引庫的API如下:

代碼分為三步:

- 1)創建Request對象。

- 因為是創建索引庫的操作,因此Request是

CreateIndexRequest。

- 因為是創建索引庫的操作,因此Request是

- 2)添加請求參數

- 其實就是Json格式的Mapping映射參數。因為json字符串很長,這里是定義了靜態字符串常量

MAPPING_TEMPLATE,讓代碼看起來更加優雅。

- 其實就是Json格式的Mapping映射參數。因為json字符串很長,這里是定義了靜態字符串常量

- 3)發送請求

client.indices()方法的返回值是IndicesClient類型,封裝了所有與索引庫操作有關的方法。例如創建索引、刪除索引、判斷索引是否存在等

在item-service中的IndexTest測試類中,具體代碼如下:

@Test

void testCreateIndex() throws IOException {// 1.創建Request對象CreateIndexRequest request = new CreateIndexRequest("items");// 2.準備請求參數request.source(MAPPING_TEMPLATE, XContentType.JSON);// 3.發送請求client.indices().create(request, RequestOptions.DEFAULT);

}static final String MAPPING_TEMPLATE = "{\n" +" \"mappings\": {\n" +" \"properties\": {\n" +" \"id\": {\n" +" \"type\": \"keyword\"\n" +" },\n" +" \"name\":{\n" +" \"type\": \"text\",\n" +" \"analyzer\": \"ik_max_word\"\n" +" },\n" +" \"price\":{\n" +" \"type\": \"integer\"\n" +" },\n" +" \"stock\":{\n" +" \"type\": \"integer\"\n" +" },\n" +" \"image\":{\n" +" \"type\": \"keyword\",\n" +" \"index\": false\n" +" },\n" +" \"category\":{\n" +" \"type\": \"keyword\"\n" +" },\n" +" \"brand\":{\n" +" \"type\": \"keyword\"\n" +" },\n" +" \"sold\":{\n" +" \"type\": \"integer\"\n" +" },\n" +" \"commentCount\":{\n" +" \"type\": \"integer\"\n" +" },\n" +" \"isAD\":{\n" +" \"type\": \"boolean\"\n" +" },\n" +" \"updateTime\":{\n" +" \"type\": \"date\"\n" +" }\n" +" }\n" +" }\n" +"}";

2.刪除索引庫

刪除索引庫的請求非常簡單:

DELETE /hotel

與創建索引庫相比:

- 請求方式從PUT變為DELTE

- 請求路徑不變

- 無請求參數

所以代碼的差異,注意體現在Request對象上。流程如下:

- 1)創建Request對象。這次是DeleteIndexRequest對象

- 2)準備參數。這里是無參,因此省略

- 3)發送請求。改用delete方法

在item-service中的IndexTest測試類中,編寫單元測試,實現刪除索引:

@Test

void testDeleteIndex() throws IOException {// 1.創建Request對象DeleteIndexRequest request = new DeleteIndexRequest("items");// 2.發送請求client.indices().delete(request, RequestOptions.DEFAULT);

}

3.判斷索引庫是否存在

判斷索引庫是否存在,本質就是查詢,對應的請求語句是:

GET /hotel

因此與刪除的Java代碼流程是類似的,流程如下:

- 1)創建Request對象。這次是GetIndexRequest對象

- 2)準備參數。這里是無參,直接省略

- 3)發送請求。改用exists方法

@Test

void testExistsIndex() throws IOException {// 1.創建Request對象GetIndexRequest request = new GetIndexRequest("items");// 2.發送請求boolean exists = client.indices().exists(request, RequestOptions.DEFAULT);// 3.輸出System.err.println(exists ? "索引庫已經存在!" : "索引庫不存在!");

}

4.總結

JavaRestClient操作elasticsearch的流程基本類似。核心是client.indices()方法來獲取索引庫的操作對象。

索引庫操作的基本步驟:

- 初始化

RestHighLevelClient - 創建XxxIndexRequest。XXX是

Create、Get、Delete - 準備請求參數(

Create時需要,其它是無參,可以省略) - 發送請求。調用RestHighLevelClient#indices().xxx()方法,xxx是create、exists、delete

5.1.新增文檔

我們需要將數據庫中的商品信息導入elasticsearch中,而不是造假數據了。

5.1.1.實體類

索引庫結構與數據庫結構還存在一些差異,因此我們要定義一個索引庫結構對應的實體。

在hm-service模塊的com.hmall.item.domain.dto包中定義一個新的DTO:

package com.hmall.item.domain.po;import io.swagger.annotations.ApiModel;

import io.swagger.annotations.ApiModelProperty;

import lombok.Data;import java.time.LocalDateTime;@Data

@ApiModel(description = "索引庫實體")

public class ItemDoc{@ApiModelProperty("商品id")private String id;@ApiModelProperty("商品名稱")private String name;@ApiModelProperty("價格(分)")private Integer price;@ApiModelProperty("商品圖片")private String image;@ApiModelProperty("類目名稱")private String category;@ApiModelProperty("品牌名稱")private String brand;@ApiModelProperty("銷量")private Integer sold;@ApiModelProperty("評論數")private Integer commentCount;@ApiModelProperty("是否是推廣廣告,true/false")private Boolean isAD;@ApiModelProperty("更新時間")private LocalDateTime updateTime;

}

5.1.2.API語法

新增文檔的請求語法如下:

POST /{索引庫名}/_doc/1

{"name": "Jack","age": 21

}

對應的JavaAPI如下:

可以看到與索引庫操作的API非常類似,同樣是三步走:

- 1)創建Request對象,這里是IndexRequest,因為添加文檔就是創建倒排索引的過程

- 2)準備請求參數,本例中就是Json文檔

- 3)發送請求

變化的地方在于,這里直接使用client.xxx()的API,不再需要client.indices()了。

5.1.3.完整代碼

我們導入商品數據,除了參考API模板“三步走”以外,還需要做幾點準備工作:

- 商品數據來自于數據庫,我們需要先查詢出來,得到Item對象

- Item對象需要轉為ItemDoc對象

- ItemDTO需要序列化為json格式

因此,代碼整體步驟如下:

- 1)根據id查詢商品數據Item

- 2)將Item封裝為ItemDoc

- 3)將ItemDoc序列化為JSON

- 4)創建IndexRequest,指定索引庫名和id

- 5)準備請求參數,也就是JSON文檔

- 6)發送請求

在item-service的DocumentTest測試類中,編寫單元測試:

package com.heima.item.es;import cn.hutool.core.bean.BeanUtil;

import cn.hutool.json.JSONUtil;

import com.hmall.item.ItemApplication;

import com.hmall.item.domain.po.Item;

import com.hmall.item.domain.po.ItemDoc;

import com.hmall.item.service.IItemService;

import org.apache.http.HttpHost;

import org.elasticsearch.action.index.IndexRequest;

import org.elasticsearch.client.RequestOptions;

import org.elasticsearch.client.RestClient;

import org.elasticsearch.client.RestHighLevelClient;

import org.elasticsearch.common.xcontent.XContentType;

import org.junit.jupiter.api.AfterEach;

import org.junit.jupiter.api.BeforeEach;

import org.junit.jupiter.api.Test;

import org.springframework.beans.factory.annotation.Autowired;

import org.springframework.boot.test.context.SpringBootTest;import java.io.IOException;@SpringBootTest(classes = ItemApplication.class,properties = "spring.profiles.active=local")

public class DocumentTest {private RestHighLevelClient client;@Autowiredprivate IItemService itemService;@BeforeEachvoid setUp() {this.client = new RestHighLevelClient(RestClient.builder(HttpHost.create("http://192.168.88.130:9200")));}@Testvoid testConnect() {System.out.println(client);}@AfterEachvoid tearDown() throws IOException {this.client.close();}@Testvoid testAddDocument() throws IOException {// 1.根據id查詢商品數據Item item = itemService.getById(100002644680L);// 2.轉換為文檔類型ItemDoc itemDoc = BeanUtil.copyProperties(item, ItemDoc.class);// 3.將ItemDTO轉jsonString doc = JSONUtil.toJsonStr(itemDoc);// 1.準備Request對象IndexRequest request = new IndexRequest("items").id(itemDoc.getId());// 2.準備Json文檔request.source(doc, XContentType.JSON);// 3.發送請求client.index(request, RequestOptions.DEFAULT);}}

GET /items/_doc/100002644680

)

)

——修改emacs的一些默認行為)

)

——循環與條件任務)