1.為什么需要做位置編碼

????????位置編碼(Positional Encoding)在變換器(Transformer)模型中非常重要,因為變換器架構本身沒有內置的順序信息。變換器使用的是自注意力機制,它能夠捕捉輸入序列中所有詞之間的相關性,但它并不關心這些詞的順序。因此,我們需要一種方法來向模型提供詞的順序信息,這就是位置編碼的作用。

為什么需要位置編碼?

? ? ? ? transformer模型的輸入是一個序列的詞向量,這些詞向量是通過嵌入層(Embedding Layer)得到的。這些詞向量本質上是無序的,因為嵌入層只負責將詞轉換為向量表示,并不包含任何順序信息。

????????為了使模型理解序列中詞的順序,我們需要將位置信息引入到詞向量中。這有助于模型捕捉序列的結構和上下文關系,從而更好地理解和生成自然語言文本。

位置編碼的實現

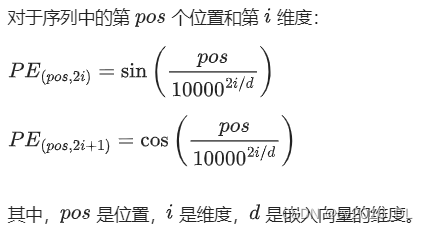

????????位置編碼有多種實現方法,其中最常見的是正弦和余弦位置編碼。這種方法的主要思想是使用不同頻率的正弦和余弦函數為每個位置生成唯一的編碼。具體公式如下:

位置編碼的特點

- 周期性:正弦和余弦函數的周期性使得位置編碼能夠捕捉到詞與詞之間的相對位置。

- 唯一性:不同位置的編碼是唯一的,確保每個位置的信息不會混淆。

- 易于計算:這種方法無需學習參數,只需計算正弦和余弦函數。

如何使用位置編碼

在變換器模型中,位置編碼通常與詞向量相加,形成包含順序信息的輸入向量。具體步驟如下:

- 計算位置編碼:根據前面的公式,為每個位置計算位置編碼。

- 加位置編碼到詞向量:將位置編碼與詞向量相加,形成新的輸入向量。

2.LLMs中,量化權重和量化激活的區別是什么?

????????在大型語言模型(LLMs)中,量化(Quantization)是一種將浮點數表示的權重和激活值轉換為較低位數的整數(例如,從32位浮點數轉換為8位整數)的技術。量化的目的是減少模型的計算和存儲需求,同時盡量保持模型性能。量化可以應用于模型的權重和激活值,它們之間有一些關鍵的區別。

量化權重(Weight Quantization)

量化權重是指將模型中的權重參數轉換為較低位數的表示。具體來說:

- 作用對象:模型的權重矩陣。

- 目的:減少模型的內存占用和計算復雜度。

- 方法:常見的方法包括對權重進行線性量化,將浮點數范圍映射到整數范圍。

- 影響:對推理過程中計算效率的提高非常顯著,因為權重在推理過程中是固定的。

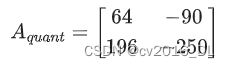

示例

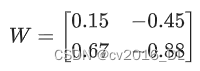

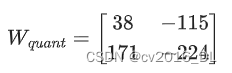

假設有一個浮點數權重矩陣:

經過量化后,可能變成一個8位整數矩陣:

量化激活(Activation Quantization)

量化激活是指將模型在推理過程中生成的激活值轉換為較低位數的表示。具體來說:

- 作用對象:模型在前向傳播過程中生成的中間激活值。

- 目的:進一步減少內存占用和加快計算速度,尤其是在推理階段。

- 方法:通常對激活值進行動態量化,因為激活值是隨輸入變化的。

- 影響:對模型性能的影響較大,因為激活值是動態變化的,需要更精確的量化方法來保持模型的準確性。

示例

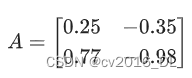

假設有一個浮點數激活矩陣:

經過量化后,可能變成一個8位整數矩陣:

主要區別

-

作用時間:

- 權重量化通常在模型訓練完成后進行,主要用于推理階段。

- 激活量化在推理過程中實時進行,因為激活值是動態變化的。

-

存儲需求:

- 權重量化主要減少模型文件的存儲需求。

- 激活量化主要減少推理過程中內存的使用量。

-

計算復雜度:

- 權重量化減少了每次前向傳播中的計算復雜度,因為權重是預先量化好的。

- 激活量化需要在每層激活值生成時進行量化,增加了一些計算開銷。

-

精度影響:

- 權重量化對模型精度的影響較小,因為可以在量化過程中進行精細調整。

- 激活量化對模型精度的影響較大,需要更加謹慎的量化策略。

總結

????????量化權重和量化激活都是為了提高模型的計算效率和減少內存占用,但它們在應用時有不同的側重點和技術難點。權重量化主要針對模型的固定參數,激活量化則針對模型的動態輸出。理解這兩者的區別和應用場景,有助于更好地優化大型語言模型的性能。

3.什么是檢索增強生成(RAG)?

????????檢索增強生成(Retrieval-Augmented Generation,簡稱RAG)是一種將檢索模型和生成模型結合起來的混合方法,用于提高文本生成任務的性能。這種方法利用信息檢索技術從大型數據庫中檢索相關文檔,然后利用生成模型基于這些檢索到的文檔生成高質量的文本。這種方法在處理需要豐富背景知識或長尾信息的問題時特別有效。

RAG 的基本流程

以下是 RAG 的基本工作流程:

- 檢索階段(Retrieval Stage):

- 給定一個輸入查詢(query),使用信息檢索模型從大型數據庫(如文檔庫、知識庫)中檢索出若干相關文檔。常用的檢索模型包括BM25、TF-IDF以及基于深度學習的雙編碼器(bi-encoder)模型。

- 生成階段(Generation Stage):

- 將檢索到的文檔作為上下文輸入到生成模型(如GPT-3、T5等),生成響應文本。生成模型基于輸入查詢和檢索到的相關文檔,生成更為準確和豐富的答案。

優勢

- 豐富的背景知識:通過檢索相關文檔,生成模型可以參考更廣泛的信息源,從而生成更為詳細和準確的回答。

- 處理長尾問題:對于一些長尾問題或罕見問題,RAG 可以通過檢索相關文檔提供必要的背景信息,從而生成高質量的回答。

- 靈活性:RAG 方法可以應用于多種任務,包括問答系統、對話生成、文本摘要等。

RAG 示例

以下是一個簡單的例子,展示了 RAG 的基本思路:

-

輸入查詢:

- 用戶輸入:

“什么是量子計算?”

- 用戶輸入:

-

檢索階段:

- 檢索模型從數據庫中檢索出相關的文檔,例如:

- 文檔1:

“量子計算是一種基于量子力學原理的新型計算方法...” - 文檔2:

“量子計算機利用量子比特(qubits)進行計算...”

- 文檔1:

- 檢索模型從數據庫中檢索出相關的文檔,例如:

-

生成階段:

- 生成模型基于輸入查詢和檢索到的文檔,生成一個綜合的回答:

- 回答:

“量子計算是一種利用量子比特進行計算的新型計算方法,它基于量子力學的原理,可以比傳統計算機更高效地解決某些復雜問題。”

- 回答:

- 生成模型基于輸入查詢和檢索到的文檔,生成一個綜合的回答:

RAG 的架構

RAG 的架構通常由以下幾個部分組成:

-

查詢編碼器(Query Encoder):

編碼輸入查詢,將其轉換為向量表示。 -

檢索器(Retriever):

利用查詢向量從大型文檔庫中檢索相關文檔。 -

文檔編碼器(Document Encoder):

對檢索到的文檔進行編碼,生成文檔向量表示。 -

生成器(Generator):

基于輸入查詢和檢索到的文檔向量,生成最終的回答。

實際應用

RAG 在許多實際應用中表現出色,包括:

- 開放域問答系統:回答用戶提出的各種問題。

- 對話系統:生成具有上下文意識的對話。

- 文本摘要:生成文檔的簡明摘要。

- 信息檢索:從大型數據庫中檢索相關信息并生成綜合報告。

總結

????????檢索增強生成(RAG)是一種強大的方法,通過結合信息檢索和文本生成技術,能夠生成高質量的文本回答。它在處理需要豐富背景知識和長尾信息的問題時特別有效。RAG 的應用廣泛,涵蓋了問答系統、對話生成、文本摘要等領域。

4.溫度系數和top-p、top-k參數有什么區別?

????????在自然語言生成模型(如GPT-3、T5等)的生成過程中,溫度系數(Temperature)、top-p和top-k參數都是用于控制生成文本的多樣性和質量的重要超參數。它們各自有不同的機制和效果,下面我們詳細介紹它們的區別和作用。

溫度系數(Temperature)

溫度系數是一個控制生成模型輸出概率分布“平滑度”的參數。

- 定義:溫度系數通常用符號T?表示。

- 范圍:通常為正數,常見范圍是?

。

。 - 影響:

- 當? T=1時,模型輸出的概率分布不變。

- 當 T<1 時,模型輸出的概率分布變得“尖銳”,高概率的詞更有可能被選擇,生成文本更加確定和保守。

- 當 T>1 時,模型輸出的概率分布變得更平滑,低概率的詞也有更大機會被選擇,生成文本更加多樣化和隨機。

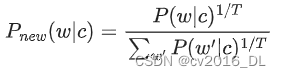

- 公式:通過調整生成時的概率分布?:

top-k 采樣

top-k 采樣是一種截斷采樣方法,通過只考慮概率最高的??個詞來生成下一個詞。

- 定義:top-k 采樣是指在生成下一個詞時,只從模型預測的概率最高的??個詞中進行選擇。

- 范圍:? k是一個正整數,通常??的取值范圍從幾到幾千不等。

- 影響:

- 當 k 較小時,生成的文本更加保守和確定,因為只考慮了少量高概率詞。

- 當?k較大時,生成的文本更加多樣化,因為考慮了更多的詞。

- 機制:從預測的概率分布中選擇前??個最高概率的詞,然后在這些詞中進行隨機采樣。

top-p 采樣(又稱核采樣,Nucleus Sampling)

????????top-p 采樣是一種動態截斷采樣方法,通過選擇累積概率超過閾值??的最小詞集合來生成下一個詞。

- 定義:top-p 采樣是指在生成下一個詞時,從模型預測的詞中選擇累積概率超過??的最小詞集合進行采樣。

- 范圍: p 是一個在 0 到? 0之間的實數。

- 影響:

- 當 p 較小時,生成的文本更加保守和確定,因為只考慮了少量的高概率詞。

- 當 p 較大時,生成的文本更加多樣化,因為考慮了更多的詞。

- 機制:從預測的概率分布中選擇使得累積概率超過? p的最小詞集合,然后在這些詞中進行隨機采樣。

????????這三種參數各有優劣,可以根據具體應用場景和需求進行選擇和調節。例如,在需要生成更加多樣化和創造性的文本時,可以適當增加溫度系數和top-p值;在需要生成更加確定和準確的文本時,可以減小溫度系數和top-p值,或者使用較小的top-k值。

5.為什么transformer塊使用LayerNorm而不是BatchNorm?

????????在Transformer架構中,Layer Normalization(LayerNorm)被廣泛使用,而不是Batch Normalization(BatchNorm)。主要原因有幾個方面,包括計算效率、適用性以及訓練過程中的穩定性。下面詳細介紹這些原因。

1. 適用性和計算效率

序列建模的特點

-

Batch Normalization:BatchNorm是針對一個批次(batch)內的數據進行歸一化。因此,它需要在整個batch上計算均值和方差。對于序列建模任務,批次內的序列長度和位置可能變化多端,導致計算復雜度增加。

-

Layer Normalization:LayerNorm是針對每一個樣本的特征維度進行歸一化。它不依賴于批次內其他樣本的分布。因此,LayerNorm在處理變長序列或在線推理時更加靈活和高效。

2. 訓練過程的穩定性

動態變化

-

Batch Normalization:在訓練過程中,BatchNorm對每個批次的數據進行歸一化,可能導致歸一化參數在不同批次之間發生劇烈變化。這在處理序列數據(如自然語言處理任務)時,尤其是在Transformer中,可能導致訓練過程不穩定。

-

Layer Normalization:LayerNorm對每個樣本的特征進行歸一化,不依賴于批次內的其他樣本。因此,LayerNorm的歸一化參數在訓練過程中更加穩定,適合處理動態變化的輸入數據。

3. 并行計算和依賴性

批次依賴性

-

Batch Normalization:由于BatchNorm依賴于整個批次的數據分布,它在計算時需要等待整個批次的數據可用。這在分布式計算或GPU加速時可能成為瓶頸,因為需要同步批次數據。

-

Layer Normalization:LayerNorm對每個樣本獨立進行歸一化,可以在樣本級別并行處理,減少了批次依賴性,提高了計算效率。

4. 序列依賴性和自注意力機制

自注意力機制

-

Batch Normalization:在自注意力機制中,每個位置的輸出依賴于整個序列的其他位置。BatchNorm在這種情況下可能會引入額外的復雜性,因為它需要在整個批次內的不同位置進行歸一化。

-

Layer Normalization:LayerNorm直接在每個位置的特征維度上進行歸一化,不受序列長度和批次分布的影響,更加適合自注意力機制。

6.介紹一下post layer norm和pre layer norm的區別?

????????在Transformer模型中,Layer Normalization(LayerNorm)可以應用在不同的位置,主要有兩種常見的方式:Post-LayerNorm 和 Pre-LayerNorm。它們在模型中的位置不同,對模型的訓練穩定性和性能有不同的影響。下面詳細介紹這兩種方法及其區別。

Post-LayerNorm

Post-LayerNorm是最早在原始Transformer論文中使用的方法。它將LayerNorm應用在殘差連接(Residual Connection)之后。

結構

- 殘差連接前的子層輸出(例如,自注意力層或前饋網絡層)

- 加上殘差連接(輸入直接加上子層輸出)

- 應用LayerNorm

公式表示:

![]()

優點

- 直觀性:殘差連接后的LayerNorm使得每一層的輸出更為平滑和歸一化,直觀上容易理解。

缺點

- 訓練不穩定:在深層Transformer中,由于LayerNorm放在殘差連接之后,可能會導致梯度消失或爆炸問題,影響訓練穩定性。

Pre-LayerNorm

????????Pre-LayerNorm是將LayerNorm應用在殘差連接之前的方法。近年來,這種方法被證明在許多情況下可以提高訓練穩定性和模型性能。

結構

- 應用LayerNorm(在殘差連接之前)

- 殘差連接前的子層輸出(例如,自注意力層或前饋網絡層)

- 加上殘差連接(輸入直接加上子層輸出)

公式表示:

![]()

優點

- 訓練穩定性更好:由于LayerNorm在殘差連接之前應用,可以在梯度傳播時保持更穩定的梯度,減少梯度消失或爆炸現象。

- 更深層次的模型:Pre-LayerNorm使得訓練更深層次的Transformer模型成為可能,進一步提高模型性能。

缺點

- 輸出分布變化:殘差連接后的輸出沒有經過歸一化,可能導致輸出分布變化較大。

7.RAG和微調的區別是什么?

????????檢索增強生成(Retrieval-Augmented Generation, RAG)和微調(Fine-Tuning)都是提高大型語言模型性能的有效方法,但它們有著不同的機制和應用場景。下面詳細介紹它們的區別。

RAG(Retrieval-Augmented Generation)

概念

RAG 是一種將檢索模型和生成模型結合起來的方法。它通過從外部知識庫或文檔庫中檢索相關信息,然后利用生成模型基于這些信息生成回答或文本。

工作流程

- 檢索階段:給定一個輸入查詢,使用檢索模型(如BM25、雙編碼器等)從大型文檔庫中檢索出相關文檔。

- 生成階段:將檢索到的文檔作為上下文輸入到生成模型(如GPT-3、T5等),生成最終的文本或回答。

優點

- 豐富的背景知識:通過檢索外部文檔,生成模型可以參考更多的信息源,從而生成更為詳實和準確的文本。

- 動態信息更新:可以實時檢索最新的信息,適應動態變化的知識需求。

- 處理長尾問題:對于罕見或長尾問題,RAG 可以通過檢索提供必要的背景信息,提高生成質量。

缺點

- 復雜性增加:需要維護一個高效的檢索系統,并處理檢索和生成的結合。

- 時延:檢索過程增加了生成時間,可能導致延遲。

微調(Fine-Tuning)

概念

微調是一種通過在特定任務或特定數據集上進一步訓練預訓練模型的方法。通過在目標任務的數據上進行額外訓練,模型可以更好地適應特定任務的需求。

工作流程

- 預訓練:首先,模型在大規模通用數據集上進行預訓練,以學習通用的語言表示。

- 微調:然后,在特定任務的數據集上進一步訓練模型,使其在該任務上表現更好。

優點

- 任務適應性強:通過微調,模型可以很好地適應特定任務,提高在該任務上的性能。

- 簡單直接:只需要在目標任務的數據集上進一步訓練模型,無需復雜的檢索系統。

缺點

- 數據依賴性強:微調需要大量與目標任務相關的數據,數據不足時效果有限。

- 更新不靈活:微調后的模型固定了知識,無法動態獲取最新信息。如果需要更新知識,可能需要重新微調模型。

對比與總結

| 特性 | RAG | 微調 |

|---|---|---|

| 機制 | 檢索相關文檔并基于文檔生成回答 | 在特定任務數據集上進一步訓練模型 |

| 優點 | 豐富背景知識,動態信息更新 | 任務適應性強,簡單直接 |

| 缺點 | 復雜性增加,時延 | 數據依賴性強,更新不靈活 |

| 適用場景 | 需要豐富背景知識和動態信息 | 任務明確且有足夠數據支持的場景 |

| 訓練需求 | 需要維護檢索系統和生成模型 | 需要大量相關數據進行訓練 |

選擇依據

- 需要動態信息更新:如果你的應用場景需要頻繁獲取最新信息或背景知識,RAG 是一個更好的選擇。

- 任務數據充足:如果你有大量與目標任務相關的數據,并且任務相對固定,微調模型能夠提供更高的性能。

- 復雜度和資源:RAG 需要更多的資源來維護檢索系統,而微調相對簡單,但需要更多特定數據。

8. 講一下GPT系列模型的是如何演進的?

????????GPT(Generative Pre-trained Transformer)系列模型是由OpenAI開發的一系列大規模自然語言處理模型。這些模型基于Transformer架構,通過在大規模文本數據集上進行無監督預訓練,然后在特定任務上進行微調,取得了顯著的效果。以下是GPT系列模型的演進過程及其主要特點。

GPT-1(2018年)

- 發布:2018年6月

- 論文:Improving Language Understanding by Generative Pre-Training

- 架構:基于Transformer的解碼器部分,包含12層Transformer塊。

- 參數:1.1億個參數。

- 訓練數據:BooksCorpus數據集,包含約7,000本書。

- 特點:

- 預訓練:在大規模文本數據上進行無監督預訓練,學習語言模型。

- 微調:在特定任務的數據集上進行監督微調,適應具體任務需求。

- 創新點:展示了通過預訓練生成模型,然后進行微調,可以在多種自然語言處理任務上取得良好效果。

GPT-2(2019年)

- 發布:2019年2月

- 論文:Language Models are Unsupervised Multitask Learners

- 架構:延續GPT-1的架構,擴大了模型規模,包括48層Transformer塊(最大版本)。

- 參數:有四個版本,分別為117M、345M、762M和1.5B(15億)參數。

- 訓練數據:WebText數據集,包含約800萬個網頁。

- 特點:

- 更大模型:顯著增加了模型參數量,提高了生成文本的能力。

- 開放域生成:展示了在開放域文本生成任務中的強大能力,能夠生成連貫且有意義的長文本。

- 多任務學習:模型在預訓練過程中學習了多任務能力,無需微調即可在多種任務上表現出色。

- 倫理考量:由于模型生成高質量文本的能力,OpenAI最初選擇逐步發布模型,以評估其潛在風險。

GPT-3(2020年)

- 發布:2020年6月

- 論文:Language Models are Few-Shot Learners

- 架構:進一步擴大了模型規模,包括96層Transformer塊(最大版本)。

- 參數:有多個版本,最大版本包含1750億參數。

- 訓練數據:多種數據集,包括Common Crawl、WebText、BooksCorpus和Wikipedia等。

- 特點:

- 超大規模:1750億參數使得GPT-3成為當時最大的語言模型,極大地提升了生成能力和理解能力。

- 少樣本學習:展示了強大的Few-Shot、One-Shot和Zero-Shot學習能力,在無需大規模微調的情況下,能夠通過提供少量示例進行任務。

- 廣泛應用:在文本生成、翻譯、問答、總結等任務上表現優異,被廣泛應用于各種自然語言處理任務。

GPT-4(預期中的演進)

雖然截至目前(2024年),GPT-4尚未正式發布,但可以預期其在以下方面可能的改進:

- 更大規模:進一步增加模型參數量,可能達到數千億甚至上萬億參數。

- 多模態:結合文本、圖像等多種模態數據,增強模型的多模態理解和生成能力。

- 更強的推理能力:在邏輯推理、常識理解等方面進一步提升。

- 更好的控制和安全性:增強模型的可控性,減少偏見和有害內容生成,提升使用安全性。

主要進展和影響

- 規模提升:隨著每一代模型的推出,參數量顯著增加,模型能力不斷提升。

- 應用廣泛:GPT系列模型被應用于各種自然語言處理任務,包括文本生成、翻譯、問答、對話系統等。

- 技術創新:展示了預訓練-微調范式的巨大潛力,推動了自然語言處理領域的發展。

- 倫理和安全:由于模型生成高質量文本的能力,引發了對其潛在濫用和倫理問題的關注,推動了對AI倫理和安全的研究。

?

)

ubuntu18.04上安裝opencv環境)

方法)