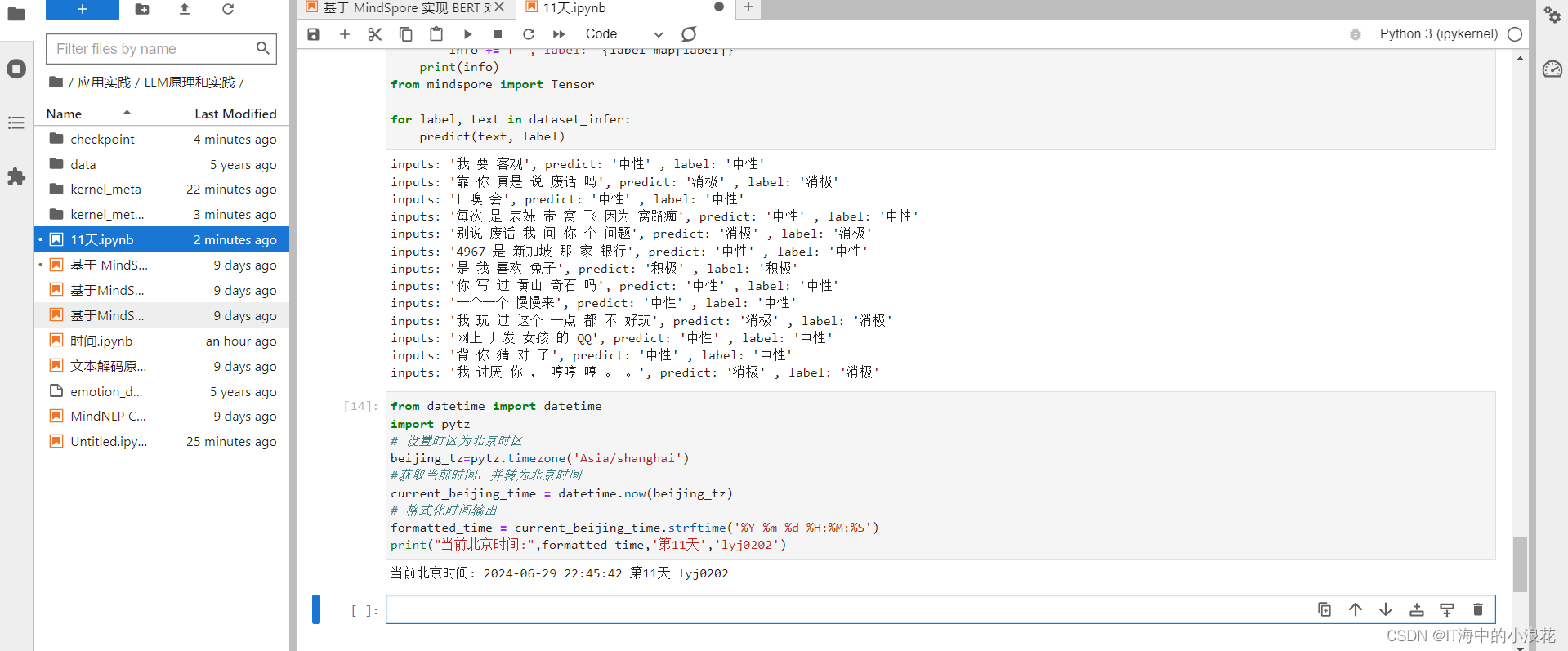

11天 本節學習到BERT全稱是來自變換器的雙向編碼器表征量,它是Google于2018年末開發并發布的一種新型語言模型。BERT模型的主要創新點都在pre-train方法上,即用了Masked Language Model和Next Sentence Prediction兩種方法分別捕捉詞語和句子級別的representation。通過一個文本情感分類任務為例子來學習了BERT模型的整個應用過程。

本節學習到BERT全稱是來自變換器的雙向編碼器表征量,它是Google于2018年末開發并發布的一種新型語言模型。BERT模型的主要創新點都在pre-train方法上,即用了Masked Language Model和Next Sentence Prediction兩種方法分別捕捉詞語和句子級別的representation。通過一個文本情感分類任務為例子來學習了BERT模型的整個應用過程。

《昇思25天學習打卡營第11天 | 昇思MindSpore基于 MindSpore 實現 BERT 對話情緒識別》

本文來自互聯網用戶投稿,該文觀點僅代表作者本人,不代表本站立場。本站僅提供信息存儲空間服務,不擁有所有權,不承擔相關法律責任。 如若轉載,請注明出處:http://www.pswp.cn/diannao/37804.shtml 繁體地址,請注明出處:http://hk.pswp.cn/diannao/37804.shtml 英文地址,請注明出處:http://en.pswp.cn/diannao/37804.shtml

如若內容造成侵權/違法違規/事實不符,請聯系多彩編程網進行投訴反饋email:809451989@qq.com,一經查實,立即刪除!相關文章

【SGX系列教程】(五)Intel-SGX 官方示例分析(SampleCode)——RemoteAttestation

文章目錄 一.RemoteAttestation原理介紹1.1 遠程認證原理1.2 遠程認證步驟1.3 遠程認證基本流程1.4 IAS通過以下步驟驗證報告的簽名1.5 關鍵術語1.6 總結二.源碼分析2.1 README2.1.1 README給出的編譯流程2.2 重點代碼分析2.2.0 主要代碼模塊交互流程分析2.2.1 isv_app文件夾2.…

python-18-零基礎自學python-用類創建冰淇凌小店的口味

學習內容:《python編程:從入門到實踐》第二版

知識點:

類、子類、繼承、調用函數 練習內容:

練習9-6:冰激凌小店

冰激凌小店是一種特殊的餐館。編寫一個名為IceCreamStand的類,讓它繼承為完成練習9-1或…

YonBIP 獲取項目代碼配置(圖文)

項目開發文件在本地環境重新部署后,開發端機器需要重新部署,在此記錄一下操作過程。

1. 新建項目目錄,在目錄下點鼠標右鍵,選 Git Bash Here 2. 開始下載代碼,根據代碼量多少,幾分鐘就能下載完成。 3. 下載…

【單元測試】Controller、Service、Repository 層的單元測試

Controller、Service、Repository 層的單元測試 1.Controller 層的單元測試1.1 創建一個用于測試的控制器1.2 編寫測試 2.Service 層的單元測試2.1 創建一個實體類2.2 創建服務類2.3 編寫測試 3.Repository 1.Controller 層的單元測試

下面通過實例演示如何在控制器中使用 Moc…

什么是死鎖以及如何避免

什么是死鎖?

死鎖是指兩個或兩個以上的進程在執行過程中,由于競爭資源或者由于彼此通信而造成的一種阻塞的現象,若無外力作用,它們都將無法推進下去。此時稱系統處于死鎖狀態或系統產生了死鎖,這些永遠在互相等待的進…

關于配置webpack eslint插件版本問題說明

webpack相關版本說明

按照當前情況下,以及eslint-webpack-plugin的官方版本使用的是8.x版本的eslint,我們進行如下依賴安裝

npm i -D eslint8 eslint-webpack-plugin "devDependencies": {"eslint": "^8.57.0","eslint-webpac…

簡單了解下Java中鎖的概念和原理

你好,這里是codetrend專欄“高并發編程基礎”。

Java提供了很多種鎖的接口和實現,通過對各種鎖的使用發現理解鎖的概念是很重要的。

Java的鎖通過java代碼實現,go語言的鎖通過go實現,python語言的鎖通過python實現。它們都實現的…

Apache Calcite Linq4j學習

Lin4j簡介

Linq4j是Apache Calcite項目中的一個模塊,它提供了類似于LINQ(Language-Integrated Query)的功能,用于在Java中進行數據查詢和操作。Linq4j可以將邏輯查詢轉換為物理查詢,支持對集合進行篩選、映射、分組等…

python自動例化verilog

python自動例化verilog 使用方法:在gvim頁面,使用命令自動例化 :r !AUTO_inst xxx.v

#python

import re

import sysmdl_re r"\s*module\s*(?P<mname>\w) *"

port_re r"\s*(?P<dir>input|output)\s(?P<typ>wire|re…

FastAPI-Cookie

fastapi-learning-notes/codes/ch01/main.py at master Relph1119/fastapi-learning-notes GitHub

1、Cookie的作用

Cookie可以充當用戶認證的令牌,使得用戶在首次登錄后無需每次手動輸入用戶名和密碼,即可訪問受限資源,直到Cookie過期或…

《PyTorch計算機視覺實戰》:一、二章

目錄 第一章:人工神經網絡基礎

比較人工智能和傳統機器學習

人工神經網絡(Artificial Neural Network,ANN) 是一種受人類大腦運作方式啟發而構建的監督學習算法。神經網絡與人類大腦中神經元連接和激活的方式比較類似࿰…

mysql查看用戶的過期時間

1. mysql查看用戶的過期時間的方法

在MySQL中,用戶的過期時間(也稱為賬戶過期日期)是一個可選項,用于確定某個MySQL用戶賬戶何時到期。但是,值得注意的是,并非所有的MySQL安裝或版本都支持直接設置用戶賬戶…

CSS元素之間的空白問題:原因與解決方案

在網頁設計中,CSS元素之間的空白是一個常見但往往不易察覺的問題。空白不僅影響布局的準確性,還可能破壞設計的整體美感。本文將探討元素之間空白的產生原因,并提供有效的解決方案。

空白產生的根源

空白問題主要發生在行內元素和行內塊元素…

4.x86游戲實戰-人物狀態標志位

免責聲明:內容僅供學習參考,請合法利用知識,禁止進行違法犯罪活動!

本次游戲沒法給

內容參考于:微塵網絡安全

上一個內容:3.x86游戲實戰-寄存器

人物狀態標志位: 什么叫人物狀態標志位&…

力扣刷題--3168. 候診室中的最少椅子數【簡單】

題目描述

給你一個字符串 s,模擬每秒鐘的事件 i:

如果 s[i] ‘E’,表示有一位顧客進入候診室并占用一把椅子。 如果 s[i] ‘L’,表示有一位顧客離開候診室,從而釋放一把椅子。 返回保證每位進入候診室的顧客都能有…

Leetcode[反轉鏈表]

LCR 024. 反轉鏈表

給定單鏈表的頭節點 head ,請反轉鏈表,并返回反轉后的鏈表的頭節點。 示例 1: 輸入:head [1,2,3,4,5]

輸出:[5,4,3,2,1]示例 2: 輸入:head [1,2]

輸出:[2,1]示…

Go使用Gin框架開發的Web程序部署在Linux時,無法綁定監聽Ipv4端口

最近有寫一部分go語言開發的程序,在部署程序時發現,程序在啟動后并沒有綁定ipv4的端口,而是直接監聽綁定ipv6的端口。

當我用netstat -antup | grep 3601查找我的gin服務啟動的端口占用情況的時候發現,我的服務直接綁定了tcp6 &a…

Intel-SGX 官方示例分析(SampleCode)——RemoteAttestation)

)

![Leetcode[反轉鏈表]](http://pic.xiahunao.cn/Leetcode[反轉鏈表])