?

目錄

一、深度學習基礎

1.1 神經網絡簡介

1.2 激活函數

1.3 損失函數

1.4 優化算法

二、PyTorch基礎

2.1 PyTorch簡介

2.2 張量操作

2.3 構建神經網絡

?2.4訓練模型

2.5?模型評估

三、PyTorch實戰

3.1 數據加載與預處理

3.2 模型定義與訓練

3.3 模型評估與調優

3.4 模型保存與加載

四、深度學習的實際應用

4.1 圖像分類

4.1.1 數據集

4.1?.2構建模型

4.1.3 訓練模型?

?4.1.4 模型評估

?4.1.5 可視化

4.1.6 模型保存與加載

4.2 自然語言處理(NLP)

4.3 生成對抗網絡(GAN)

五、總結

?

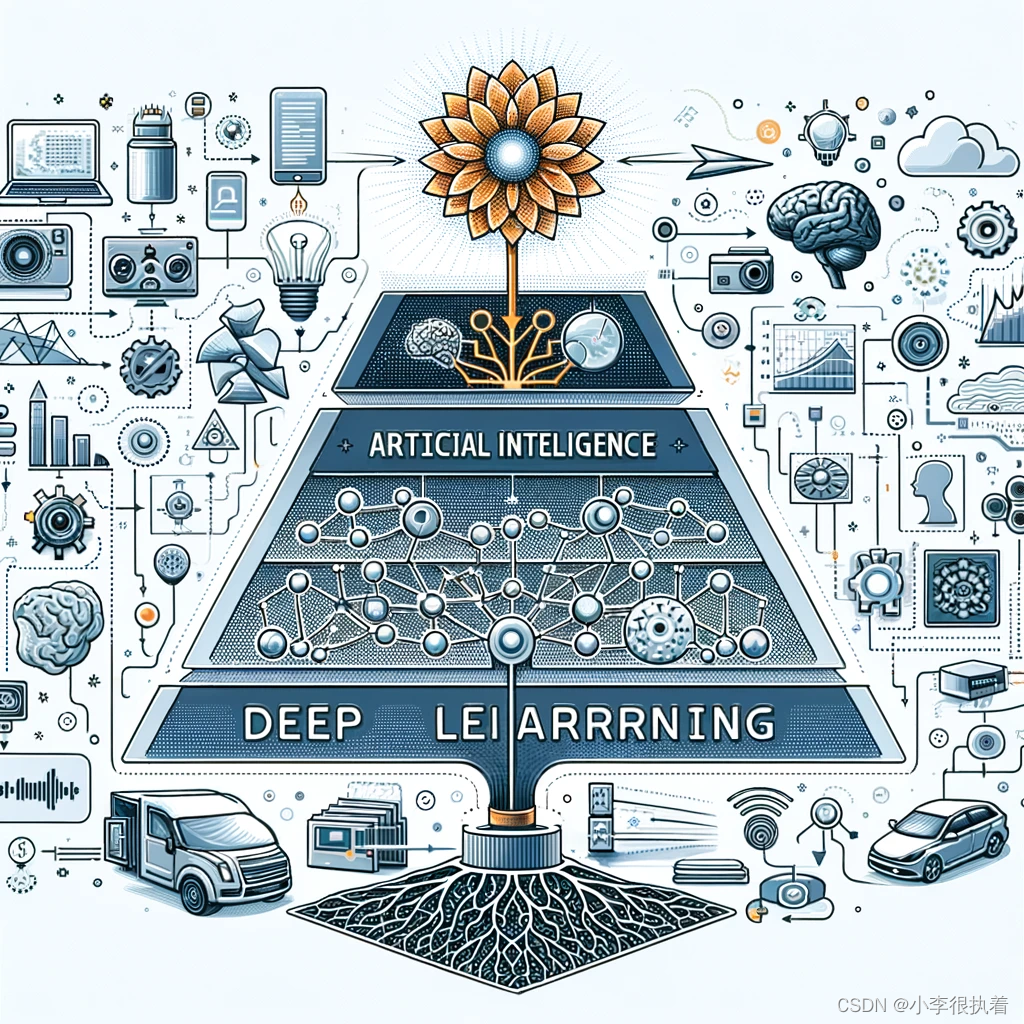

深度學習是機器學習的一個分支,主要通過多層神經網絡進行數據特征的自動提取和建模。本文將通過PyTorch這個深度學習框架,從理論到實戰,詳細介紹深度學習的基本概念、模型構建、訓練和評估的過程。我會包含實例和代碼,以幫助理解。

一、深度學習基礎

1.1 神經網絡簡介

神經網絡模仿生物神經系統,由許多互聯的神經元(人工神經元)組成。主要分為以下幾部分:

- 輸入層:接收外部輸入數據,每個神經元代表一個輸入特征。

- 隱藏層:位于輸入層和輸出層之間,負責提取和處理輸入特征,數量和結構可以多樣化。

- 輸出層:產生最終的輸出,每個神經元代表一個輸出結果。

神經網絡通過調整各層之間的連接權重,學習數據中的模式和特征。

1.2 激活函數

激活函數引入非線性,使神經網絡能夠擬合復雜的函數。常用的激活函數包括:

- Sigmoid:輸出范圍為(0, 1),適合用于輸出層進行二分類。

- Tanh:輸出范圍為(-1, 1),相比Sigmoid中心對稱且梯度較大。

- ReLU(Rectified Linear Unit):如果輸入大于0則輸出為輸入,否則輸出為0,計算簡單且有效,廣泛應用于隱藏層。

import torch.nn.functional as F# ReLU激活函數

x = torch.tensor([-1.0, 0.0, 1.0])

relu = F.relu(x)

print(relu) # tensor([0., 0., 1.])1.3 損失函數

損失函數用于衡量模型預測值與真實值的差距,是模型優化的目標。常見的損失函數包括:

- 均方誤差損失(MSE):用于回歸問題,衡量預測值與真實值之間的平方差的平均值。

- 交叉熵損失(Cross Entropy Loss):用于分類問題,衡量預測概率分布與真實分布之間的差距。

# MSE Loss

mse_loss = nn.MSELoss()

output = torch.tensor([1.0, 2.0, 3.0])

target = torch.tensor([1.5, 2.5, 3.5])

loss = mse_loss(output, target)

print(loss) # tensor(0.2500)1.4 優化算法

# Adam優化器

optimizer = optim.Adam(model.parameters(), lr=0.001)

優化算法用于調整模型參數,以最小化損失函數。常見的優化算法包括:

- 隨機梯度下降(SGD):通過對每個訓練樣本計算梯度并更新參數,計算簡單,但可能會陷入局部最小值。

- Adam:結合了動量和自適應學習率調整的方法,能夠快速收斂且穩定性高,廣泛應用于各種深度學習任務。

二、PyTorch基礎

2.1 PyTorch簡介

PyTorch是一個開源的深度學習框架,具有以下特點:

- 動態計算圖:支持即時計算,便于調試和修改模型結構。

- 強大的自動微分:通過

autograd模塊實現自動求導,簡化了梯度計算過程。- 模塊化設計:提供豐富的預定義模塊和函數,方便構建和訓練復雜的神經網絡。

-

import torch# 創建張量 x = torch.tensor([[1, 2], [3, 4]]) y = torch.tensor([[5, 6], [7, 8]])# 張量運算 z = x + y print(z) # tensor([[ 6, 8], [10, 12]])# 自動求導 x = torch.tensor(2.0, requires_grad=True) y = x**2 y.backward() print(x.grad) # tensor(4.)?

2.2 張量操作

張量是PyTorch的基本數據結構,類似于Numpy的多維數組,但支持GPU加速。常見的張量操作包括創建、索引、運算和自動求導。

2.3 構建神經網絡

在PyTorch中,神經網絡可以通過繼承nn.Module類來定義。模型的各層通過nn模塊提供的預定義層(如nn.Linear、nn.Conv2d等)構建,forward方法定義了前向傳播過程。

PyTorch中的神經網絡可以通過繼承nn.Module類來定義

class Net(nn.Module):def __init__(self):super(Net, self).__init__()self.fc1 = nn.Linear(1, 10)self.fc2 = nn.Linear(10, 1)def forward(self, x):x = F.relu(self.fc1(x))x = self.fc2(x)return xnet = Net()

print(net)?2.4訓練模型

以一個簡單的回歸任務為例,介紹模型的訓練過程

# 生成數據

x = torch.linspace(0, 10, 100).view(-1, 1)

y = 2 * x + 1 + torch.randn(x.size()) * 0.5# 定義模型、損失函數和優化器

model = Net()

criterion = nn.MSELoss()

optimizer = optim.Adam(model.parameters(), lr=0.01)# 訓練模型

num_epochs = 1000

for epoch in range(num_epochs):model.train()optimizer.zero_grad()outputs = model(x)loss = criterion(outputs, y)loss.backward()optimizer.step()# 打印模型參數

for param in model.parameters():print(param.data)2.5?模型評估

模型訓練完成后,需要對模型進行評估。常用的評估指標包括準確率、精確率、召回率等

# 生成測試數據

x_test = torch.linspace(0, 10, 100).view(-1, 1)

y_test = 2 * x_test + 1 + torch.randn(x_test.size()) * 0.5# 預測

model.eval()

with torch.no_grad():predictions = model(x_test)# 可視化

import matplotlib.pyplot as pltplt.scatter(x_test.numpy(), y_test.numpy(), label='True Data')

plt.plot(x_test.numpy(), predictions.numpy(), label='Predictions', color='red')

plt.legend()

plt.show()三、PyTorch實戰

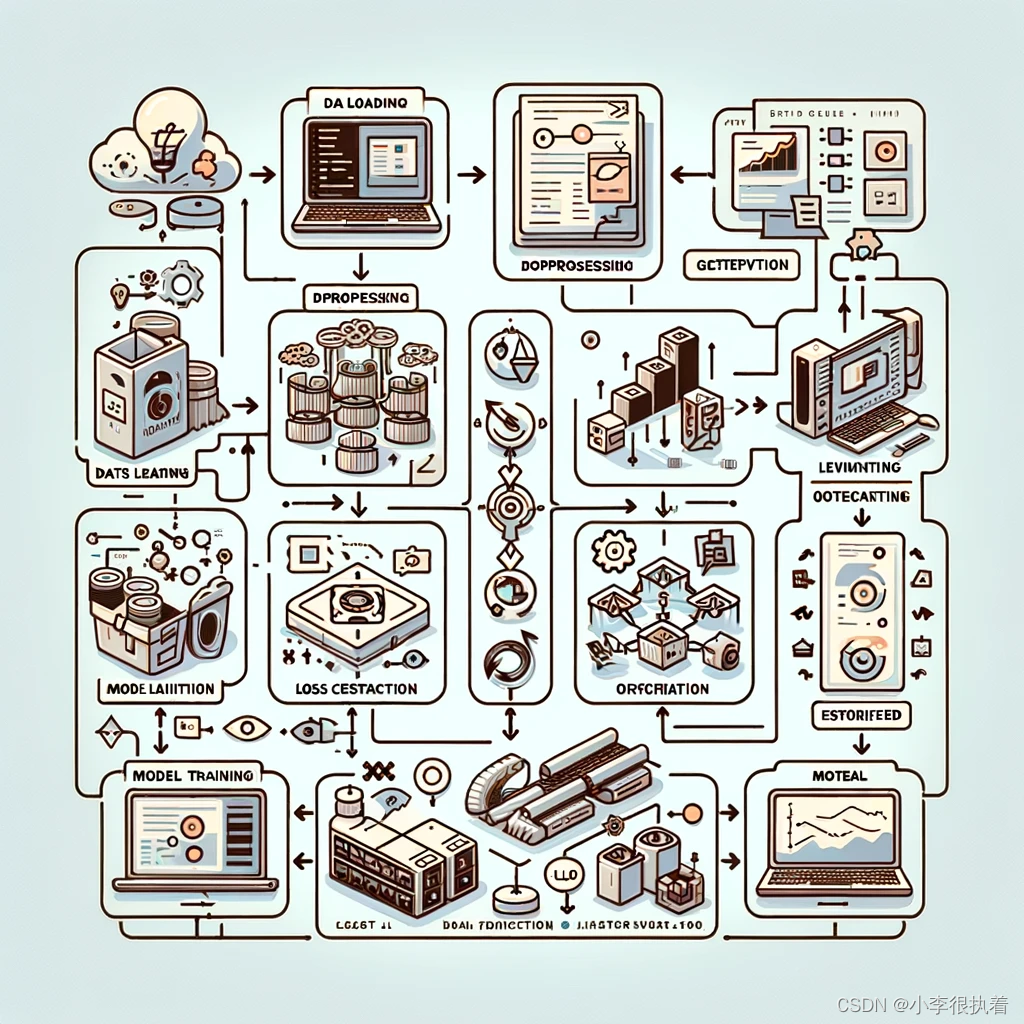

3.1 數據加載與預處理

PyTorch提供了torchvision和torchtext等庫,用于處理常見的數據集。數據加載器(DataLoader)可以幫助我們高效地批量加載和預處理數據。

3.2 模型定義與訓練

模型定義包括選擇合適的層結構和激活函數。訓練過程包括以下步驟:

- 初始化模型:定義模型結構并初始化參數。

- 定義損失函數和優化器:選擇合適的損失函數和優化算法。

- 訓練循環:

- 前向傳播:將輸入數據傳入模型,計算輸出。

- 計算損失:使用損失函數計算預測值與真實值之間的差距。

- 反向傳播:計算梯度,并通過優化器更新模型參數。

3.3 模型評估與調優

訓練完成后,需要對模型進行評估。常用的評估指標包括準確率、精確率、召回率和F1分數等。根據評估結果,可以調整模型結構、參數和訓練策略,以提高模型性能。

3.4 模型保存與加載

訓練好的模型可以保存下來,以便后續使用或部署。PyTorch提供了簡單的接口來保存和加載模型,包括保存模型參數和完整模型結構。

四、深度學習的實際應用

4.1 圖像分類

圖像分類是計算機視覺中的一個基本任務。通過卷積神經網絡(CNN)可以高效地提取圖像特征并進行分類。經典的數據集包括MNIST、CIFAR-10和ImageNet等。

4.1.1 數據集

我們將使用MNIST數據集,這是一個手寫數字的圖像數據集。

from torchvision import datasets, transformstransform = transforms.Compose([transforms.ToTensor(), transforms.Normalize((0.5,), (0.5,))])train_dataset = datasets.MNIST(root='./data', train=True, download=True, transform=transform)

test_dataset = datasets.MNIST(root='./data', train=False, download=True, transform=transform)train_loader = torch.utils.data.DataLoader(dataset=train_dataset, batch_size=64, shuffle=True)

test_loader = torch.utils.data.DataLoader(dataset=test_dataset, batch_size=64, shuffle=False)4.1?.2構建模型

我們將構建一個簡單的卷積神經網絡(CNN)來進行圖像分類。

class CNN(nn.Module):def __init__(self):super(CNN, self).__init__()self.conv1 = nn.Conv2d(1, 32, kernel_size=3, stride=1, padding=1)self.conv2 = nn.Conv2d(32, 64, kernel_size=3, stride=1, padding=1)self.fc1 = nn.Linear(64*7*7, 128)self.fc2 = nn.Linear(128, 10)def forward(self, x):x = F.relu(self.conv1(x))x = F.max_pool2d(x, 2)x = F.relu(self.conv2(x))x = F.max_pool2d(x, 2)x = x.view(-1, 64*7*7)x = F.relu(self.fc1(x))x = self.fc2(x)return xmodel = CNN()4.1.3 訓練模型?

criterion = nn.CrossEntropyLoss()

optimizer = optim.Adam(model.parameters(), lr=0.001)num_epochs = 10

for epoch in range(num_epochs):model.train()for images, labels in train_loader:optimizer.zero_grad()outputs = model(images)loss = criterion(outputs, labels)loss.backward()optimizer.step()print(f'Epoch [{epoch+1}/{num_epochs}], Loss: {loss.item():.4f}')?4.1.4 模型評估

model.eval()

correct = 0

total = 0

with torch.no_grad():for images, labels in test_loader:outputs = model(images)_, predicted = torch.max(outputs.data, 1)total += labels.size(0)correct += (predicted == labels).sum().item()print(f'Accuracy: {100 * correct / total:.2f}%')?4.1.5 可視化

# 取一些測試數據

images, labels = iter(test_loader).next()

outputs = model(images)

_, predicted = torch.max(outputs, 1)# 顯示圖片和預測結果

fig = plt.figure(figsize=(10, 4))

for idx in np.arange(20):ax = fig.add_subplot(2, 10, idx+1, xticks=[], yticks=[])img = images[idx].numpy().squeeze()ax.imshow(img, cmap='gray')ax.set_title(f'{predicted[idx].item()}', color='green' if predicted[idx] == labels[idx] else 'red')

plt.show()4.1.6 模型保存與加載

在訓練完模型后,我們可以將其保存下來以便后續使用。PyTorch提供了簡單的接口來保存和加載模型。

?

# 保存模型

torch.save(model.state_dict(), 'cnn_model.pth')# 加載模型

model = CNN()

model.load_state_dict(torch.load('cnn_model.pth'))4.2 自然語言處理(NLP)

在自然語言處理領域,深度學習用于文本分類、情感分析、機器翻譯等任務。常用的模型包括循環神經網絡(RNN)、長短期記憶網絡(LSTM)和Transformer等。

import torchtext

from torchtext.data import Field, LabelField, TabularDataset, BucketIterator# 數據預處理

TEXT = Field(tokenize='spacy', tokenizer_language='en_core_web_sm', lower=True)

LABEL = LabelField(dtype=torch.float)

datafields = [("text", TEXT), ("label", LABEL)]train_data, test_data = TabularDataset.splits(path="./data", train='train.csv', test='test.csv', format='csv', skip_header=True, fields=datafields)TEXT.build_vocab(train_data, max_size=10000, vectors="glove.6B.100d")

LABEL.build_vocab(train_data)train_iterator, test_iterator = BucketIterator.splits((train_data, test_data), batch_size=64, sort_within_batch=True, sort_key=lambda x: len(x.text), device='cuda')# 構建模型

class RNN(nn.Module):def __init__(self, vocab_size, embedding_dim, hidden_dim, output_dim):super(RNN, self).__init__()self.embedding = nn.Embedding(vocab_size, embedding_dim)self.rnn = nn.LSTM(embedding_dim, hidden_dim)self.fc = nn.Linear(hidden_dim, output_dim)def forward(self, x):embedded = self.embedding(x)output, (hidden, cell) = self.rnn(embedded)hidden = torch.squeeze(hidden[-1, :, :])return self.fc(hidden)# 初始化模型

vocab_size = len(TEXT.vocab)

embedding_dim = 100

hidden_dim = 256

output_dim = 1

model = RNN(vocab_size, embedding_dim, hidden_dim, output_dim)# 使用預訓練的詞向量

pretrained_embeddings = TEXT.vocab.vectors

model.embedding.weight.data.copy_(pretrained_embeddings)# 定義損失函數和優化器

optimizer = optim.Adam(model.parameters())

criterion = nn.BCEWithLogitsLoss()# 訓練模型

model = model.to('cuda')

criterion = criterion.to('cuda')num_epochs = 5

for epoch in range(num_epochs):model.train()for batch in train_iterator:optimizer.zero_grad()predictions = model(batch.text).squeeze(1)loss = criterion(predictions, batch.label)loss.backward()optimizer.step()# 評估模型

model.eval()

with torch.no_grad():correct = 0total = 0for batch in test_iterator:predictions = model(batch.text).squeeze(1)rounded_preds = torch.round(torch.sigmoid(predictions))correct += (rounded_preds == batch.label).float().sum()total += batch.label.size(0)accuracy = correct / totalprint(f'Accuracy: {accuracy.item():.4f}')4.3 生成對抗網絡(GAN)

生成對抗網絡(GAN)通過生成器和判別器的對抗性訓練,可以生成逼真的圖像、文本和其他數據。GAN在圖像生成、圖像修復、數據增強等方面有廣泛應用。

import torch

import torch.nn as nn

import torch.optim as optim# 定義生成器

class Generator(nn.Module):def __init__(self, input_dim, output_dim):super(Generator, self).__init__()self.model = nn.Sequential(nn.Linear(input_dim, 128),nn.ReLU(),nn.Linear(128, output_dim),nn.Tanh())def forward(self, x):return self.model(x)# 定義判別器

class Discriminator(nn.Module):def __init__(self, input_dim):super(Discriminator, self).__init__()self.model = nn.Sequential(nn.Linear(input_dim, 128),nn.LeakyReLU(0.2),nn.Linear(128, 1),nn.Sigmoid())def forward(self, x):return self.model(x)# 初始化模型

latent_dim = 100

img_dim = 28 * 28

generator = Generator(latent_dim, img_dim)

discriminator = Discriminator(img_dim)# 定義損失函數和優化器

adversarial_loss = nn.BCELoss()

optimizer_G = optim.Adam(generator.parameters(), lr=0.0002)

optimizer_D = optim.Adam(discriminator.parameters(), lr=0.0002)# 訓練GAN

num_epochs = 20000

for epoch in range(num_epochs):# 訓練判別器real_imgs = torch.randn(64, img_dim) # 使用隨機數據代替真實圖像valid = torch.ones(64, 1)fake = torch.zeros(64, 1)optimizer_D.zero_grad()real_loss = adversarial_loss(discriminator(real_imgs), valid)z = torch.randn(64, latent_dim)gen_imgs = generator(z)fake_loss = adversarial_loss(discriminator(gen_imgs.detach()), fake)d_loss = (real_loss + fake_loss) / 2d_loss.backward()optimizer_D.step()# 訓練生成器optimizer_G.zero_grad()g_loss = adversarial_loss(discriminator(gen_imgs), valid)g_loss.backward()optimizer_G.step()if epoch % 1000 == 0:print(f'Epoch {epoch}, D loss: {d_loss.item()}, G loss: {g_loss.item()}')五、總結

深度學習是一種基于人工神經網絡的機器學習方法,模擬人腦神經元的工作機制,通過多層神經元的組合進行數據特征的提取和模式識別。神經網絡由輸入層、隱藏層和輸出層組成。輸入層接收外部數據,隱藏層對數據進行特征提取和非線性變換,輸出層生成預測結果。神經網絡通過調整神經元之間的連接權重來學習數據中的模式和規律。

PyTorch是一個開源的深度學習框架,以其動態計算圖和易用性而廣受歡迎。PyTorch的基本數據結構是張量,類似于Numpy的多維數組,但支持GPU加速。PyTorch的核心模塊包括

torch用于張量操作,torch.nn用于構建神經網絡,torch.optim用于定義優化算法,以及torch.autograd用于自動求導。?

?

?

-----7-3 sdut-C語言實驗-鏈表的結點插入)