Neural Architecture Search(NAS)

- 一個神經網絡有不同類型的超參數

拓撲結構:resnet,mobilenet

單獨層:核大小,卷積層的通道,輸出隱藏單元的個數 - NAS自動設計神經網絡

如何設計搜索空間

如何探索搜索空間

性能評估

one-shot 方法

- 將學習架構核模型參數聯系在一起學習

- 構建訓練一個單獨的模型來表現一系列廣泛的模型

- 評價候選結構

只關心候選排名

用一個近似的指標:幾個輪次之后的準確度 - 重新訓練最好的候選模型

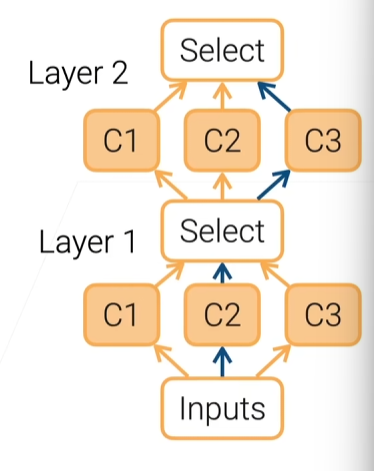

可微的架構搜索(Differentiable Architecture Search)

- 將子路類別選擇給softmax執行

1、每一層有多個候選

2、在l層第i個候選的輸出是oilo^l_ioil?

3、學習一個混合權重ala^lal,第i+1層的輸入是∑iαiloil\displaystyle\sum_{\substack i}\alpha^l_io^l_ii?∑?αil?oil?,其中αl=softmax(al)\alpha^l=softmax(a^l)αl=softmax(al)

4、選擇候選argmaxiαiargmax_i\alpha_iargmaxi?αi?

5、將學習的ala^lal加入網絡參數

Scaling CNNs

- 一個CNN能有3種方法調節

1、更深:更多層

2、更寬:更多輸出通道

3、更大的輸出:增加輸入圖像的分辨率 - EfficientNet建議一個混合的scaling

1、深度規模每次變換α?\alpha^\phiα?,寬度變換β?\beta^\phiβ?,分辨率變換γ?\gamma^\phiγ?

2、αβ2γ2≈2\alpha\beta^2\gamma^2\approx2αβ2γ2≈2,若?=1\phi=1?=1,則把計算復雜度(FLOP)翻了一倍

3、可調參數α,β,γ,?\alpha,\beta,\gamma,\phiα,β,γ,?

研究方向

- NAS結果的可解釋性

- 適合邊緣設備(如手機)的搜索結構

- 到哪種程度我們能實現整個機器學習的自動化

------休眠函數sleep_for和sleep_until)

:計數排序)

;初識類的默認成員函數)

)

![【AI開發】【前后端全棧】[特殊字符] AI 時代的快速開發思維](http://pic.xiahunao.cn/【AI開發】【前后端全棧】[特殊字符] AI 時代的快速開發思維)

—PyTorch使用—張量的創建和類型轉換】)