目錄

前言

一、Embedding 模型基礎:文本到向量的“魔術師”

1.1 什么是 Embedding?

1.2 為什么需要 Embedding?

二、核心作用與優勢:語義分析的“利刃”

三、工作原理拆解:從訓練到應用的完整鏈條

3.1 訓練階段:學習語義關系

3.2 推理階段:生成向量

3.3?應用階段:相似度計算與決策

四、實際應用場景:以智能客服為例,Embedding 如何“把關”

五、衡量相似度的方法

六、Embedding 在不同場景的應用模式

6.1?語義搜索

6.2 語義分類 / 意圖識別

6.3 語義匹配

6.4 推薦系統

6.5 聚類與主題發現

七、如何評估 Embedding 的效果

八、調優與實踐建議

未來展望:Embedding 的無限可能

前言

在人工智能領域,Embedding 模型已成為連接人類語言與機器理解的橋梁。它不僅僅是“詞向量分析”的工具,更是現代 AI 系統(如搜索引擎、推薦系統和聊天機器人)背后的核心引擎。今天,我們來全面剖析 Embedding 模型的作用、原理和工作機制。作為一名 AI 從業者,我將用通俗易懂的語言,結合實際場景,幫助你徹底搞懂這個概念。

文章結構如下,便于你逐層深入:

- Embedding 模型基礎:什么是 Embedding?它如何將文本轉化為向量?

- 核心作用與優勢:Embedding 在語義分析中的關鍵功能。

- 工作原理拆解:從訓練到應用的全流程。

- 實際應用場景:以智能客服為例,展示 Embedding 如何優化系統。

- 衡量相似度方法:常用余弦相似度、點積、歐氏距離等方式量化向量間的語義接近度。

- Embedding在不同場景的應用模式:語義搜索、分類、匹配、推薦、聚類等多領域落地。

- 如何評估Embedding的效果:通過相似度任務、分類準確率、檢索指標和可視化分析驗證質量。

- 調優和實踐建議:合理選型、歸一化、批量計算、緩存與索引優化提升性能與效果。

- 未來展望:Embedding 的發展趨勢。

通過這篇文章,你將明白 Embedding 為什么是 AI 的“語義翻譯家”,并學會如何在項目中應用它。

一、Embedding 模型基礎:文本到向量的“魔術師”

1.1 什么是 Embedding?

Embedding 是將文本等信息轉化為向量并通過相似度計算實現語義理解與應用的核心技術。

Embedding 模型是一種將離散數據(如單詞、句子或圖像)映射到連續向量空間的 AI 技術。在自然語言處理(NLP)中,它最常見的形式是 文本 Embedding,即將文字轉化為高維向量(例如,一個 768 維的數字數組)。這些向量捕捉了文本的語義、語法和上下文信息。

簡單比喻:想象語言是一張地圖,單詞是城市。Embedding 就像 GPS 坐標系統——相似的“城市”(如 “貓” 和 “狗”)坐標接近,不相關的(如 “貓” 和 “汽車”)則相距甚遠。

1.2 為什么需要 Embedding?

因為計算機不能直接理解語言、圖片的含義,但向量可以:

方便用距離/相似度來衡量內容是否相近

支持模糊匹配(不同表達、同一意思)

高效檢索(向量數據庫支持毫秒級相似度查詢)

是很多 AI 應用的基礎特征表示

傳統計算機處理文本時,只能看到字符串(如 “apple”),無法理解含義。Embedding 解決了這個問題:

- 語義捕捉:它讓機器“懂” 同義詞(“happy” 和 “joyful” 向量相似)和多義詞(“bank” 在不同上下文中向量不同)。

- 維度降維:從海量詞匯庫中提取本質特征,便于計算。

常見模型包括:

- Word2Vec:早期詞向量模型,基于上下文預測。

- BERT / Sentence-BERT:句子級 Embedding,考慮全局上下文。

- OpenAI 的 text-embedding-ada-002:高效、通用,支持多語言。

二、核心作用與優勢:語義分析的“利刃”

Embedding 的核心作用在于 向量表示與相似度計算,它在 AI 系統中的優勢體現在多個層面:

1.語義相似度度量:

通過計算向量間的距離(如余弦相似度:cos(θ) = (A · B) / (|A| |B|)),Embedding 可以判斷兩個文本的相似程度。

優勢:超越關鍵詞匹配,能處理變體表達(如 “天氣熱” 和 “今天好曬” 相似度高)。????????

2.高效過濾與分類:

在大數據場景中,Embedding 作為“前置篩子”,快速排除無關內容,節省計算資源。

優勢:生成向量只需毫秒,遠低于完整模型推理。

3.多模態擴展:

現代 Embedding 支持文本、圖像甚至音頻的統一向量空間(如 CLIP 模型),便于跨模態搜索。

優勢:實現“圖文匹配”或“語音轉義義”。

4.下游任務支持:

Embedding 是許多 AI 應用的“輸入層”,如聚類、推薦和檢索增強生成(RAG)。

優勢:可微分,便于與神經網絡集成。

用數據說話:根據 Hugging Face 的基準測試,Embedding 模型在語義相似度任務上的準確率可達 90% 以上,遠超傳統方法。

三、工作原理拆解:從訓練到應用的完整鏈條

以文本 embedding 為例,大致過程是:

分詞/編碼:將句子切分成 token(字、詞、子詞)

向量化表示:用詞向量(word embeddings)或上下文向量(contextual embeddings)

模型處理:通常是 Transformer(如 BERT、RoBERTa、SimCSE)

池化(Pooling):把每個 token 的向量合并成一個固定長度的句向量(CLS token、平均池化等)

歸一化:可選,將向量模長歸一化,便于余弦相似度計算

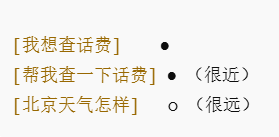

可視化示意(二維化后):

要講透 Embedding,我們從頭拆解其原理。過程分為三個階段:

3.1 訓練階段:學習語義關系

- 數據輸入:海量文本語料(如維基百科、書籍)。

- 模型架構:使用 Transformer(如 BERT)或 Skip-Gram(Word2Vec)。模型通過自監督學習預測缺失詞或上下文。

- 輸出:一個嵌入矩陣,每個詞/句子對應一個固定維度向量。

示例:訓練中,“The cat sits on the mat” → 模型學習 “cat” 和 “mat” 的關聯,向量中編碼位置、語法等。- 關鍵技術:負采樣(加速訓練)和注意力機制(捕捉長距依賴)。

3.2 推理階段:生成向量

- 輸入文本 → Tokenization(分詞) → 通過模型前向傳播 → 輸出向量。

- 示例代碼(Python + Hugging Face):

from sentence_transformers import SentenceTransformer model = SentenceTransformer('all-MiniLM-L6-v2') sentence = "Embedding models are powerful." embedding = model.encode(sentence)????????輸出: [0.12, -0.34, ..., 0.56] (384 維)

- 耗時:單句通常 < 10ms。

3.3?應用階段:相似度計算與決策

- 比較兩個向量:使用歐氏距離或余弦相似度。

- 閾值判斷:相似度 > 0.7 視為相關。

- 擴展:KNN 搜索(最近鄰)用于大規模檢索。

這個鏈條確保 Embedding 不僅準確,還高效、可擴展。

四、實際應用場景:以智能客服為例,Embedding 如何“把關”

雖然智能客服只是一個場景,但它完美展示了 Embedding 的實戰價值。假設客戶撥打熱線(如 10086),常聊無關話題(如天氣),導致系統占線。傳統客服“有問必答”,但 Embedding 可在調用主模型(如 LLM)前進行語義識別,過濾無關查詢。

Embedding 在此的作用:

- 語義識別前置:將客戶查詢轉為向量,與預定義業務主題向量(e.g., “套餐咨詢”的向量)比較。

- 無關(如 “聊聊人生”):相似度低 → 直接回復“不在服務范圍”,不調用模型。

- 相關(如 “信號差”):相似度高 → 轉入深度處理。

- 具體優勢:

- 資源優化:減少 30%-50% 無謂調用,降低成本。

- 實時性:向量計算快,響應延遲最小化。

- 準確提升:處理模糊表達,避免誤答。

流程:

- 語音轉文本 → 查詢向量生成。

- 計算與業務向量的相似度。

- 決策:相關 → 調用 LLM;無關 → 標準拒絕。

這個場景突顯 Embedding 的“過濾器”作用,但它在搜索(如 Google 的語義搜索)、推薦(如 Netflix 的內容匹配)中同樣閃耀。

五、衡量相似度的方法

-

余弦相似度(cosine similarity):衡量方向一致性(常配歸一化)

-

點積(dot product):衡量向量投影大小

-

歐氏距離(L2):幾何距離

公式示例:

cos_sim(u,v) = (u · v) / (||u|| * ||v||)

六、Embedding 在不同場景的應用模式

這里給出幾個典型模式(智能客服只是其中之一):

6.1?語義搜索

用戶輸入問題 → embedding

文檔向量庫檢索相似度最高的內容

應用:知識庫搜索、法律文書檢索、代碼搜索

6.2 語義分類 / 意圖識別

將輸入 embedding 后,與各類別中心向量對比

應用:客服意圖分類、工單路由、垃圾郵件識別

6.3 語義匹配

比較兩段文本 embedding,判斷是否語義相似

應用:FAQ 匹配、重復問題檢測、相似商品推薦

6.4 推薦系統

用戶行為 embedding + 物品內容 embedding

計算相似度推薦最相關的物品

6.5 聚類與主題發現

embedding 后做 K-means / HDBSCAN

應用:自動話題聚類、熱點分析

七、如何評估 Embedding 的效果

-

語義相似度任務:STS(Semantic Textual Similarity)數據集,計算 Spearman / Pearson 相關系數

-

分類準確率:在分類任務上用 embedding 作為特征

-

檢索指標:Recall@K、nDCG、MRR

-

可視化:用 t-SNE/U-MAP 將高維向量降維,看聚類效果

八、調優與實踐建議

-

模型選擇

小模型:快(適合在線實時)

大模型:準(適合離線檢索、分析)

-

歸一化:方便余弦相似度計算

-

批量計算:提高吞吐量

-

緩存:熱門查詢 embedding 緩存

-

向量庫優化:HNSW 索引參數調優

-

閾值調節:結合 ROC 曲線選擇合適閾值

未來展望:Embedding 的無限可能

隨著 AI 進步,Embedding 將更智能:多模態統一(文本+圖像+視頻)、實時學習(在線更新)和量子加速(更快計算)。想象未來,Embedding 可驅動元宇宙的語義交互,或醫療的精準診斷。

地圖控件和矢量圖形繪制)

原理詳解與實例)

)