ETL(Extract, Transform, Load)工具是用于數據抽取、轉換和加載的軟件工具,用于支持數據倉庫和數據集成過程。Kettle作為傳統的ETL工具是純 java 開發的開源的?ETL工具,用于數據庫間的數據遷移?。可以在 Linux、windows、unix 中運行。有圖形界面,也有命令腳本還可以二次開發。

kettle?的官網為:

?https://community.hitachivantara.com/docs/DOC-1009855

github 地址為:

?https://github.com/pentaho/pentaho-kettle。

一、Kettle是什么?

Kettle 是一款開源的 ETL(Extract - Transform - Load)工具,用于數據抽取、轉換和加載。它提供了一個可視化的設計環境,允許用戶通過簡單的拖拽和配置操作來構建復雜的數據處理工作流,能夠處理各種數據源和目標之間的數據集成任務,幫助企業將來自不同數據源的數據進行整合,然后加載到數據倉庫或其他目標系統中。

二、Kettle的組成部分

Kettle主要由以下幾個關鍵部分組成:

1、轉換(Transformation)

轉換是Kettle的核心組件之一,主要用于對數據進行各種操作和轉換。它的目的是將輸入數據按照預先定義的規則進行處理,生成符合要求的輸出數據。轉換可以被看作是一個數據加工的流水線,數據在這個流水線上依次經過各種處理步驟。

2、作業(Job)

作業用于對一系列任務進行組織和調度。它可以包含多個轉換、其他作業或者其他操作步驟,并且可以定義這些任務的執行順序和條件。作業更側重于數據處理流程的整體控制和自動化,比如按照時間順序或者特定的事件觸發數據處理任務。

3、存儲庫(Repository)

存儲庫是Kettle用于存儲和管理對象(如轉換、作業、數據庫連接等)的地方。它提供了一種集中式的管理方式,方便用戶在團隊環境中共享和復用數據處理資源。

4、調度器(Scheduler)

調度器用于安排作業的執行時間和頻率。它可以根據用戶設定的時間表(如每天幾點執行、每周幾執行、每月幾號執行等)或者特定的事件觸發(如文件到達指定目錄、數據庫表中的數據更新等)來自動啟動作業。

組成部分的具體解釋可以通過官網進一步了解和學習,在這里不再贅述。

三、Kettle的優缺點

優點:

1)可視化操作界面:Kettle 提供了直觀的圖形化界面,用戶無需編寫大量的代碼即可構建復雜的數據處理流程。通過簡單的拖拽和配置步驟的屬性,就能完成從數據抽取到加載的整個過程,大大降低了數據集成的難度,使得非技術人員也能夠相對容易地進行操作。

2)豐富的組件庫:它擁有眾多的數據處理步驟和插件,涵蓋了幾乎所有常見的數據操作。例如,有用于數據過濾的步驟、數據排序步驟、數據分組步驟、各種數據格式轉換步驟(如日期格式轉換、字符串編碼轉換等),以及用于連接不同類型數據源和目標的步驟,能夠滿足多樣化的數據集成需求。

3)可擴展性和靈活性:可以通過編寫自定義插件來擴展Kettle的功能。對于一些特殊的業務需求或者特定的數據處理操作,如果現有的步驟和組件無法滿足,可以開發自定義的插件并集成到 Kettle 中。同時,它可以靈活地處理不同規模的數據集成任務,從小型的部門級數據整合到大型企業級的數據倉庫加載都能勝任。

4)支持多種數據源和目標:能夠處理多種數據源類型。除了常見的關系型數據庫,還可以處理文件類型(如文本文件、XML 文件、JSON 文件)、大數據源(如 Hadoop 分布式文件系統 HDFS)以及通過網絡接口(如 RESTful API)獲取的數據。在目標方面,同樣可以將數據輸出到多種類型的存儲介質中。

缺點:

1、性能方面的局限

1)大規模數據處理效率較低 :

當處理海量數據時,Kettle 的性能可能會顯著下降。由于它是基于 Java 開發的,數據處理過程中涉及大量的內存操作和中間緩存。例如,在對包含數億條記錄的大型數據庫表進行復雜的轉換(如多表連接、嵌套子查詢轉換等)和抽取操作時,可能會出現內存溢出或者處理速度極慢的情況。這是因為 Kettle 在處理數據時,需要將數據加載到內存中的某些數據結構中進行處理,隨著數據量的增大,內存消耗會急劇增加。

2)資源消耗問題:

它對系統資源(如 CPU 和內存)的消耗比較大。在運行復雜的工作流時,尤其是包含多個數據密集型的轉換步驟和作業任務時,可能會占用大量的 CPU 時間和內存空間。這可能導致在同一臺服務器上運行的其他應用程序受到影響,甚至在資源有限的環境中,可能無法順利完成數據處理任務。

2、功能和靈活性方面的不足

1)高級功能實現復雜:

盡管 Kettle 提供了豐富的基本數據處理步驟,但對于一些非常高級的數據分析和處理功能,實現起來比較復雜。例如,對于復雜的機器學習算法應用或者深度數據挖掘任務,雖然可以通過自定義插件等方式來實現,但這需要開發者具備較高的技術水平,包括熟練掌握 Java 編程和 Kettle的插件開發機制。

2)對實時數據處理支持有限:

在面對實時數據處理場景時,Kettle 的能力相對較弱。它主要側重于批處理模式的數據抽取、轉換和加載,對于像實時流數據的處理(如物聯網設備產生的連續數據流、金融交易實時數據等),需要進行大量的定制化開發和額外的配置才能勉強滿足需求,而且性能和穩定性也難以保證。

3、維護和管理的困難

1)工作流的復雜性管理:

隨著數據處理任務的增加和業務邏輯的復雜化,Kettle 中構建的工作流(包括轉換和作業)會變得非常復雜。當需要對這些工作流進行修改或者維護時,例如,當數據源的結構發生變化或者業務規則調整時,要準確地找到需要修改的步驟和作業,并確保修改后的工作流能夠正確運行,是一項具有挑戰性的任務。因為一個復雜的工作流可能包含眾多相互關聯的步驟和依賴關系,一處修改可能會影響到整個工作流的其他部分。

4、學習和使用成本較高

1)陡峭的學習曲線:

盡管 Kettle 有可視化的操作界面,但要熟練掌握它并能高效地構建復雜的數據處理工作流,仍然需要花費大量的時間學習。用戶需要了解各種數據處理步驟的功能、參數設置,以及如何合理地組合這些步驟來實現特定的業務邏輯。對于沒有ETL工具使用經驗或者編程基礎較弱的用戶來說,學習成本會更高。

2)文檔和技術支持的局限性:

開源工具的文檔通常不如商業軟件完善。Kettle 的文檔雖然能夠提供基本的功能介紹和操作指南,但對于一些復雜的場景和高級功能的解釋可能不夠詳細。而且,在遇到問題時,由于沒有像商業軟件那樣完善的技術支持團隊,用戶可能需要花費更多的時間在網上搜索解決方案或者在社區中尋求幫助,這可能會導致問題解決的效率較低。

四、Kellte安裝

以 windows 下的配置為例,linux 下配置類似。

jdk 安裝及配置環境變量

由于 kettle 是基于 java 的,因此需要安裝 java 環境,并配置 JAVA_HOME 環境變量。

建議安裝 JDK1.8 及以上,7.0以后版本的 kettle 不支持低版本 JDK。

下載 kettle

從 官網 下載 kettle ,解壓到本地即可。

下載相應的數據庫驅動:由于 kettle 需要連接數據庫,因此需要下載對應的數據庫驅動。

例如 MySQL 數據庫需要下載 mysql-connector-java.jar,oracle 數據庫需要下載 ojdbc.jar。下載完成后,將 jar 放入 kettle 解壓后路徑的 lib 文件夾中即可。

本人網盤也可下載(包括Kettle和oracle、mysql數據庫驅動):通過網盤分享的文件:Kettle數據遷移工具.zip

關注公眾號(悟心生之道):回復:數據遷移,即可網盤下載

五、實戰演示

1、啟動

添加完驅動后,雙擊程序 Spoon.bat 就能啟動 kettle 。

2、轉換

轉換包括一個或多個步驟,步驟之間通過跳(hop)來連接。跳定義了一個單向通道,允許數據從一個步驟流向另一個步驟。在Kettle中,數據的單位是行,數據流就是數據行從一個步驟到另一個步驟的移動。

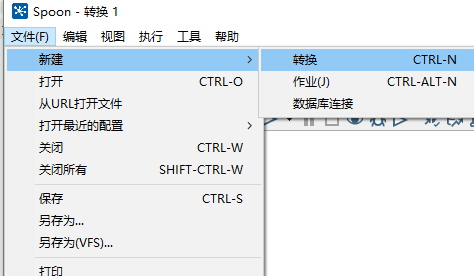

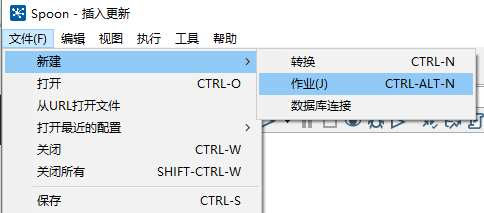

?(1)打開 kettle,點擊 文件->新建->轉換。

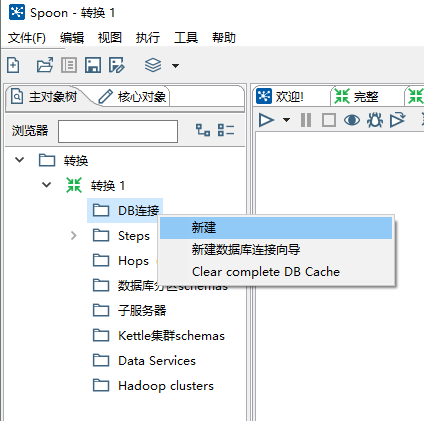

(2)在左邊 DB 連接處點擊新建。

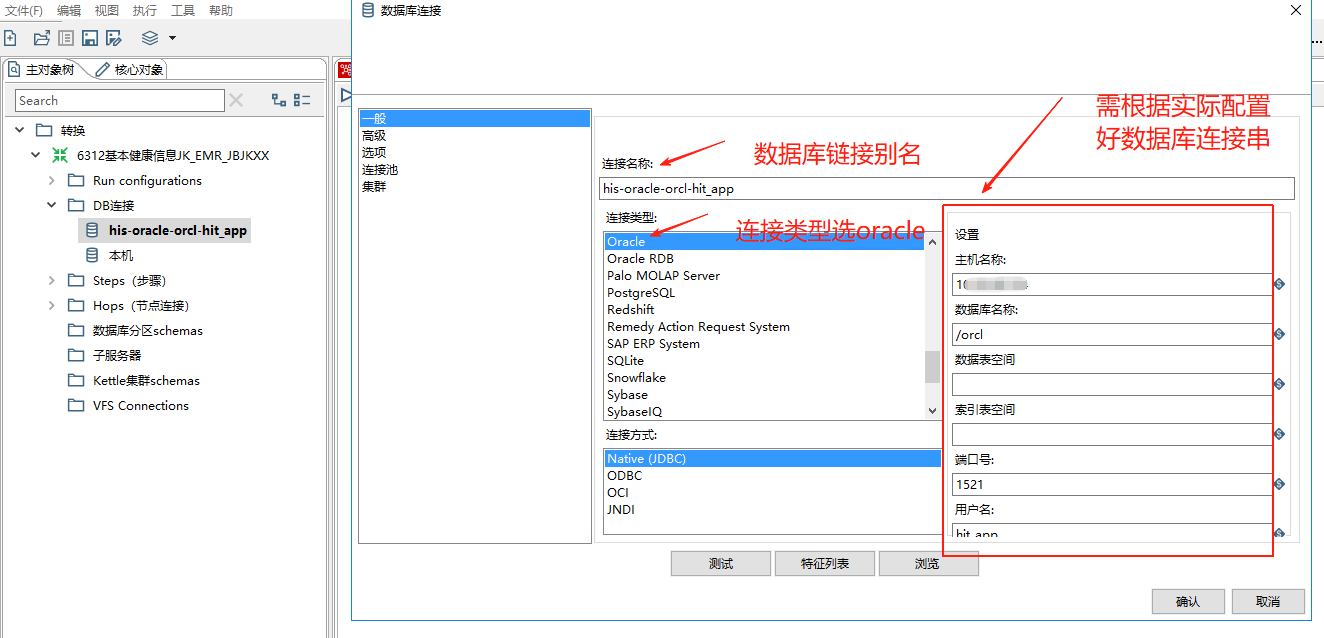

根據提示配置數據庫,配置完成后可以點擊測試進行驗證,這邊以 oracle?為例。

(3)在左側找到表輸入(核心對象->輸入->表輸入),拖到右方。

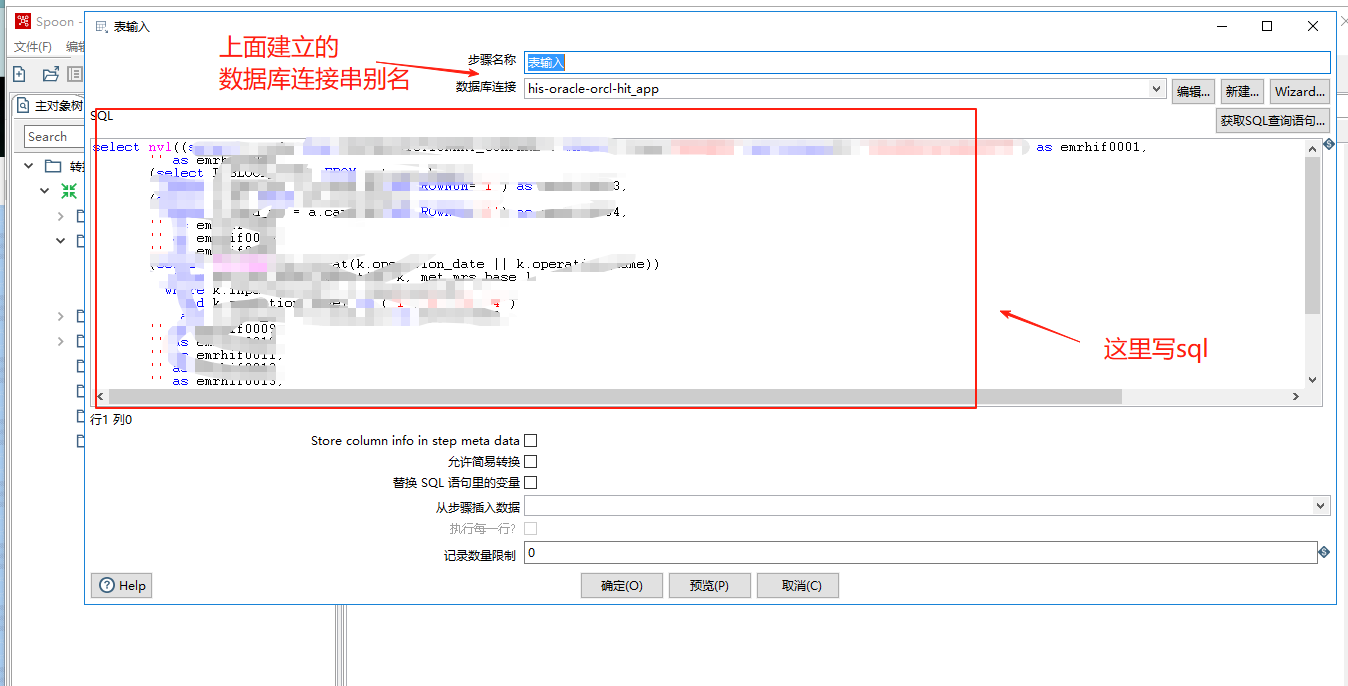

雙擊右側表輸入,進行配置,選擇數據源,并輸入 SQL。可以點擊預覽進行預覽數據。

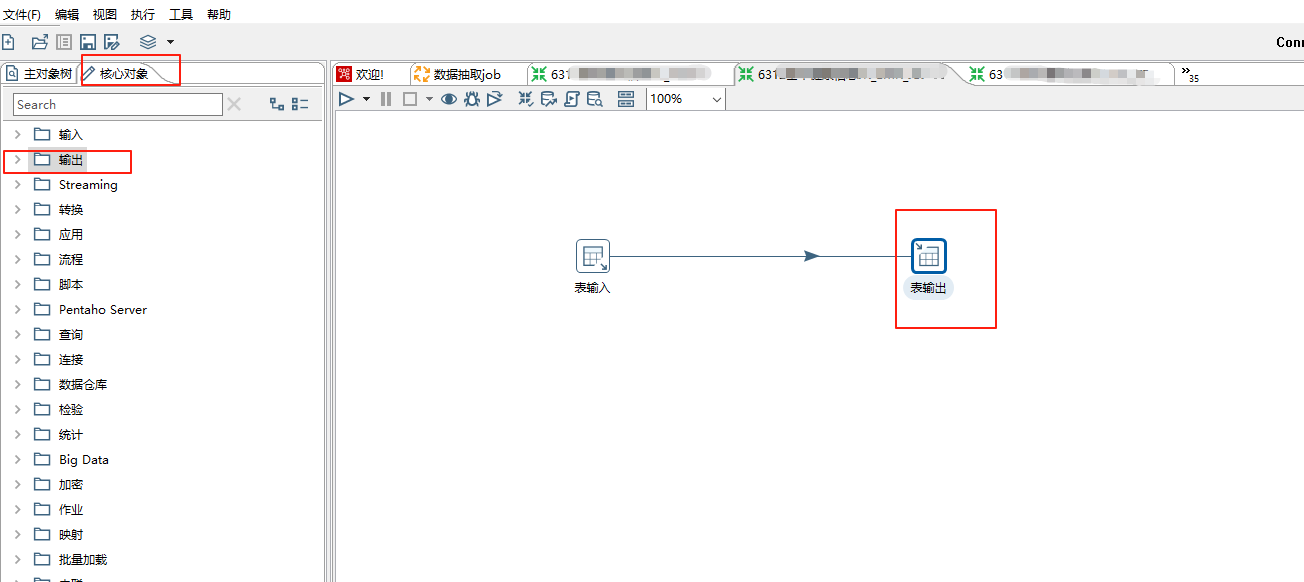

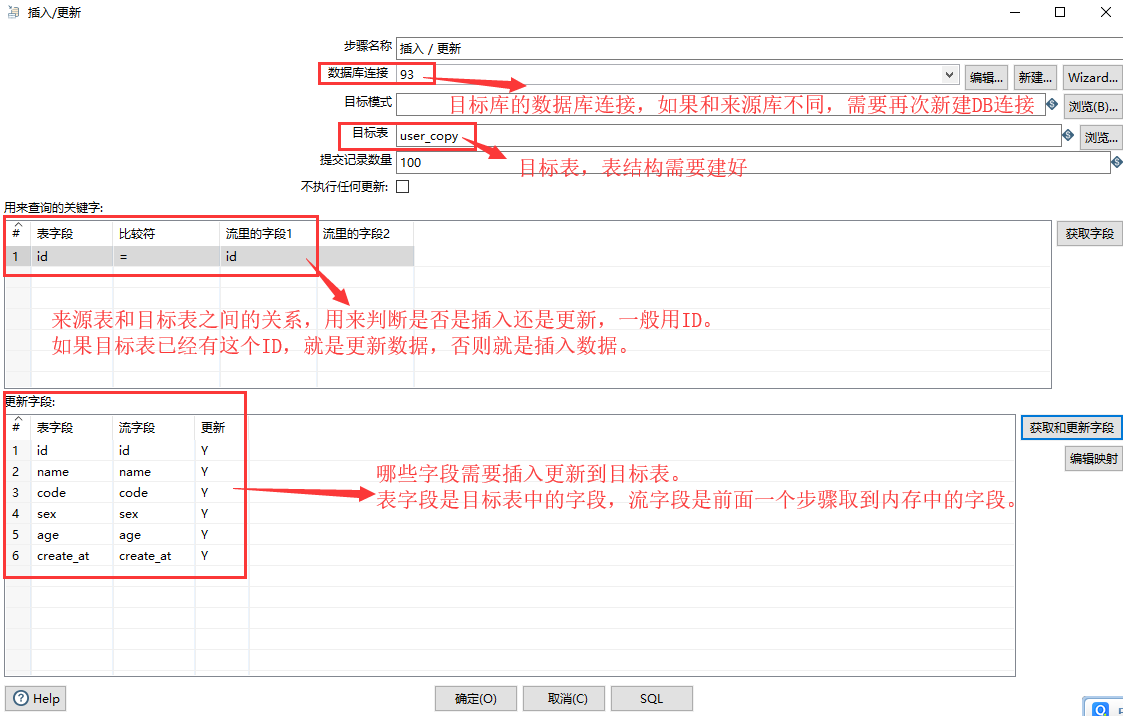

(4)在左側找到插入/更新(核心對象->輸出->插入/更新),拖到右方。也可以拖表輸出到右方進行新增,這里已新增為例:

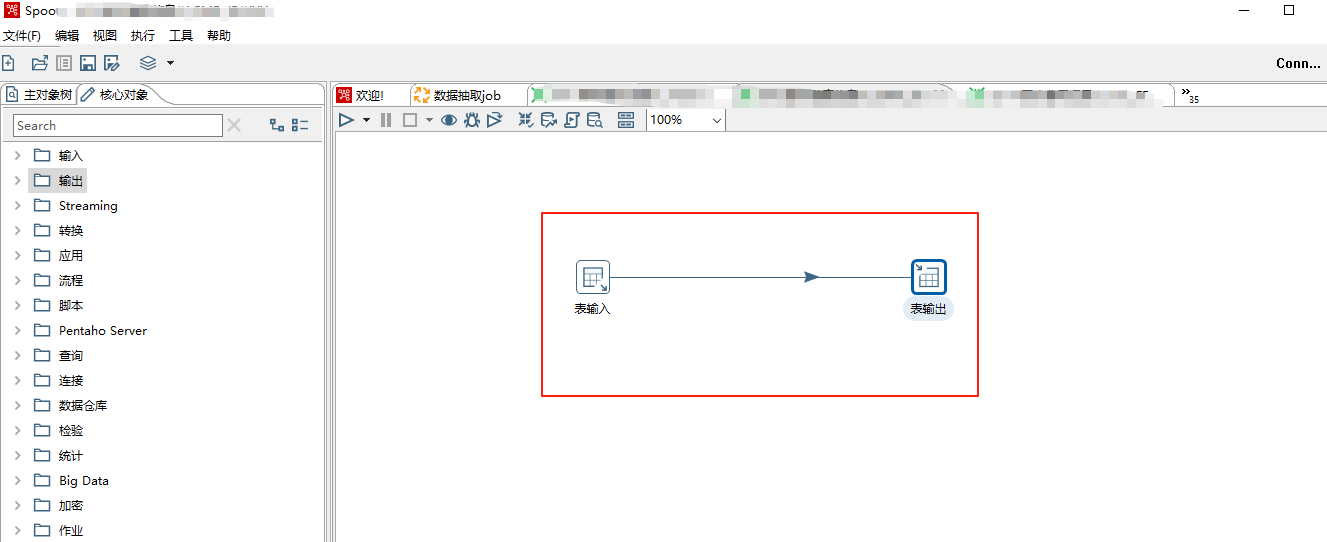

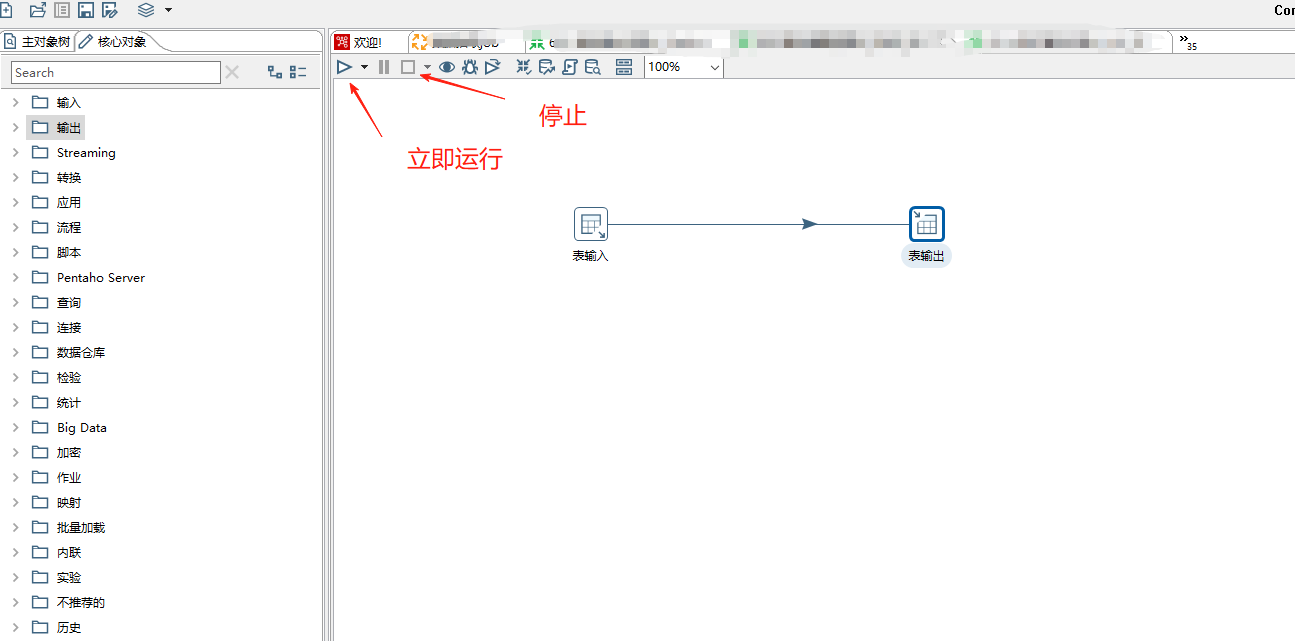

按住 Shift 鍵,把表輸入和插入/更新用線連接起來,注意中間的線點擊灰色表示禁用,藍色表示啟用。

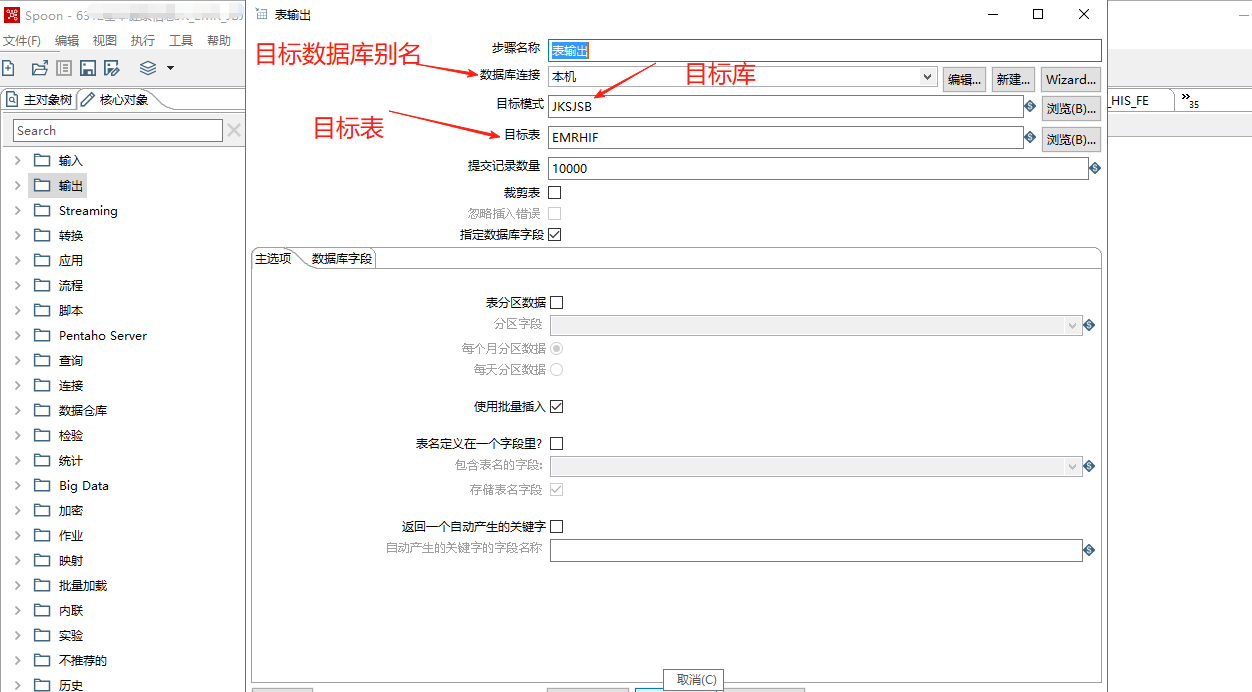

對輸出表雙擊進行配置:

附上插入/更新的配置說明:

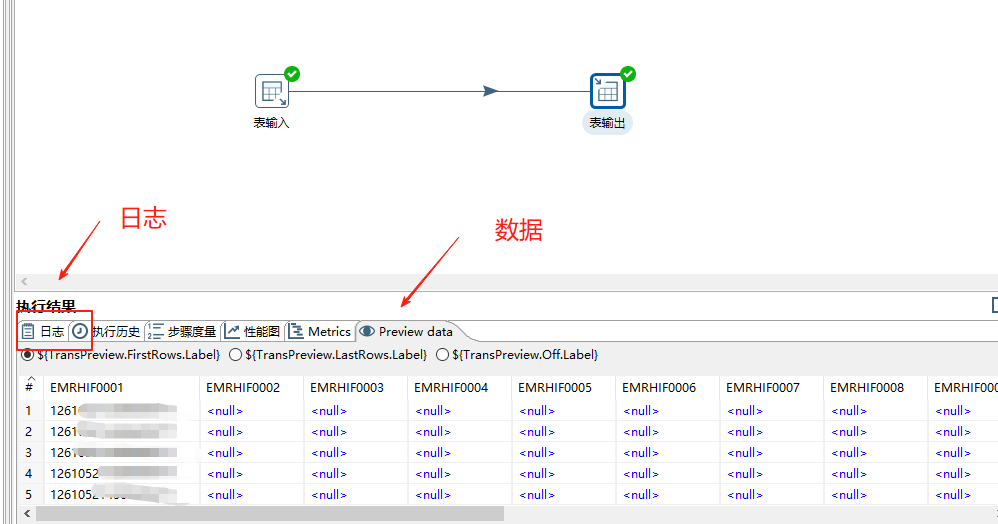

(5)點擊運行,就可以運行這一個轉換。

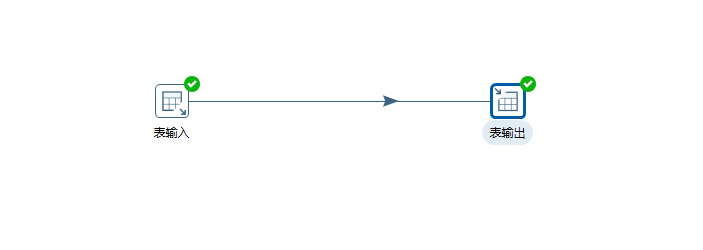

運行結束后會看到綠色對號,表示成功:

3、作業

如果想要定時運行這個轉換,那么就要用到作業。

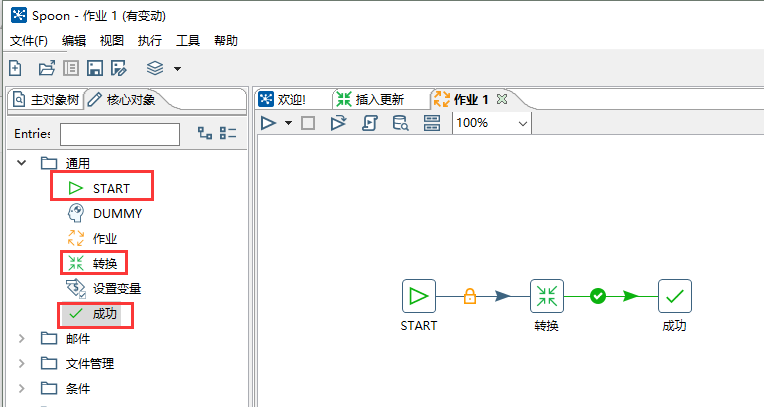

新建一個作業。

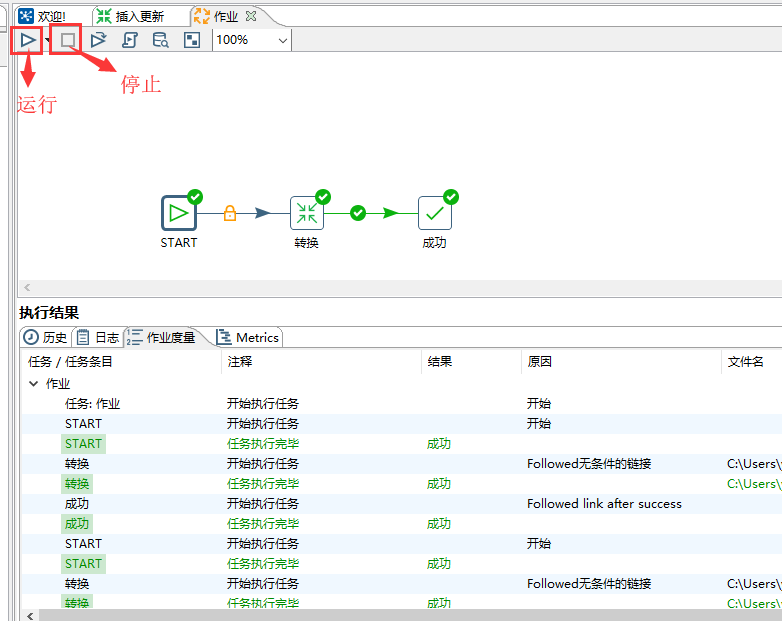

從左側依次拖動 START 、轉換、成功到右側,并用線連接起來。

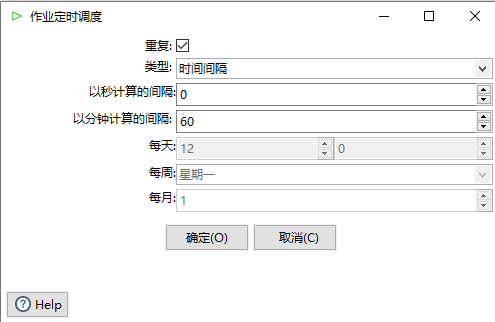

雙擊 START,可以配置作業的運行間隔,這邊配置了每小時運行一次。

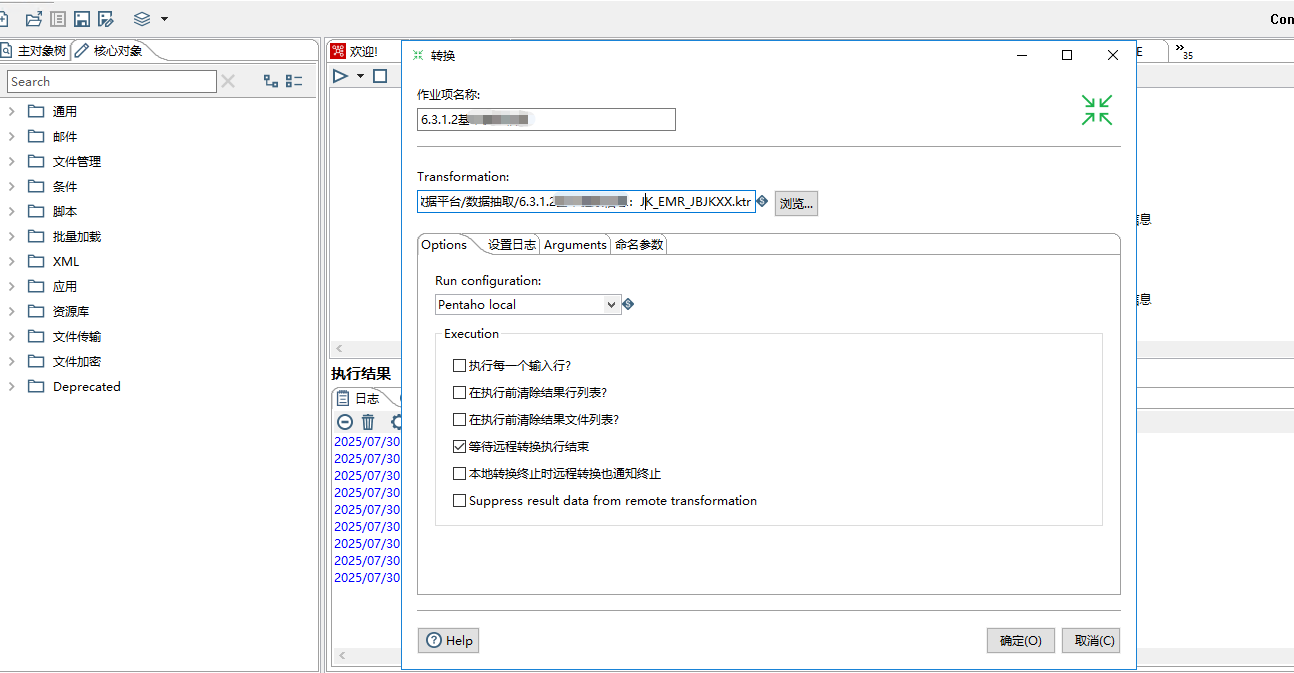

雙擊轉換,選擇之前新建的那個轉換。

點擊運行,就能運行這次作業,點擊停止就能停止。在下方執行結果,可以看到運行的日志。

這樣就完成了一個最簡單的作業,每隔1小時,將源表的數據遷移到目標表。

六、實戰總結

以上是本人對Kettle工具的一些基本認識和用法,Kettle工具本身也是一個非常強大的ETL工具,可以輕松通過Kettle的圖形化界面完成數據的遷移,不用額外開發代碼,并實現定時任務執行數據遷移,關于該工具的詳細使用今天就分享到這里,希望大家能夠學習和成長,也希望大家能夠摸索出更好的工具分享出來。

技術架構與工程實踐:從原理到部署)

)

數據庫安裝教程)

)

![[LINUX操作系統]shell腳本之循環](http://pic.xiahunao.cn/[LINUX操作系統]shell腳本之循環)