探索Lora:微調大型語言模型和擴散模型的低秩適配方法

隨著深度學習技術的快速發展,大型語言模型(LLMs)和擴散模型(Diffusion Models)在自然語言處理和計算機視覺領域取得了顯著的成果。然而,這些模型的規模和復雜性使得它們的微調過程既耗時又費力。Lora(Low-Rank Adaptation)作為一種創新的方法,能夠高效地對這些大模型進行微調。本文將詳細介紹Lora的背景、原理、公式、代碼實現及其效果。

背景

在深度學習中,大型模型通常需要大量的數據和計算資源進行訓練。然而,在實際應用中,我們常常需要針對特定任務對預訓練的大模型進行微調。傳統的微調方法需要更新所有模型參數,耗費大量的計算資源和存儲空間。

Lora方法通過低秩適配(Low-Rank Adaptation)實現高效微調,僅需更新少量參數,從而大大降低了計算資源和存儲需求。這使得Lora成為對大型模型進行微調的一種極具吸引力的方法。

原理

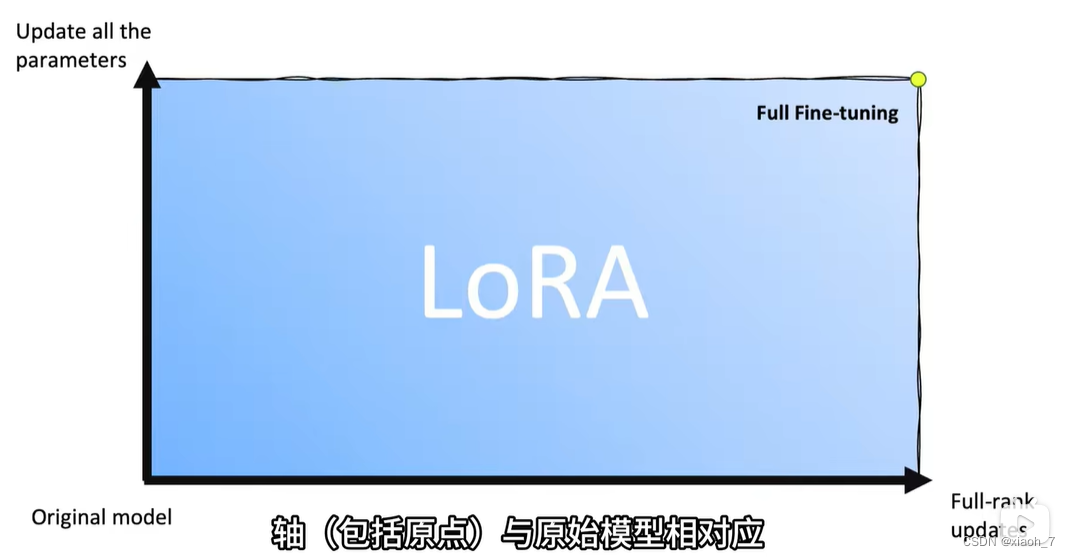

Lora可以說是解決這樣兩個問題:模型需要全部參數微調嗎?模型微調程度的衡量標準是什么?在圖中,左小角就是原始模型,右上角就是模型全參數微調,而矩形面積中的點就是各種Lora。

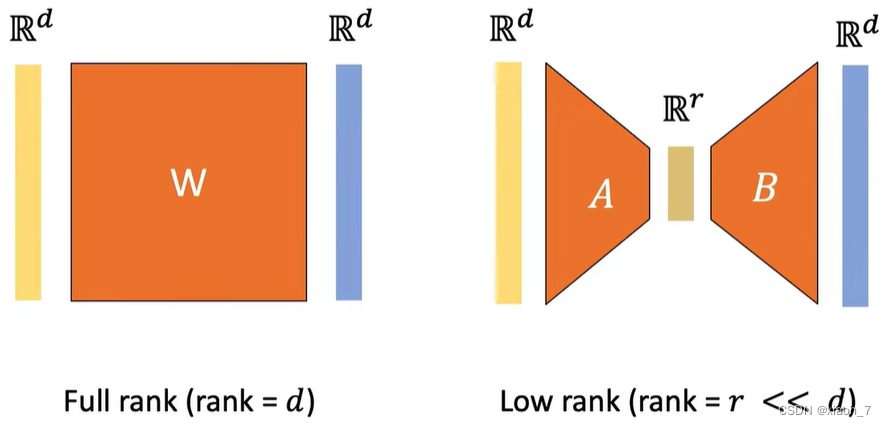

Lora的核心思想是利用低秩矩陣分解來近似模型參數的變化。在微調過程中,Lora不直接更新模型的原始權重矩陣,而是通過添加一個低秩矩陣來調整模型。

具體來說,假設我們有一個預訓練的權重矩陣 ( W ),在微調過程中,我們引入兩個低秩矩陣 ( A ) 和 ( B ),使得新的權重矩陣 ( W’ ) 表示為:

[ W’ = W + \Delta W ]

其中, ( \Delta W = A B^T ) 。這里, ( A ) 和 ( B ) 是低秩矩陣,其秩遠小于 ( W ) 的秩。這意味著我們只需要更新 ( A ) 和 ( B ) ,而不是整個 ( W ) 矩陣,從而大大減少了需要更新的參數數量。

如圖,如果完全微調整個模型的話,參數量就是d^2,而改用Lora,參數量就是2rd,而r是遠遠小于d的。

公式

假設原始權重矩陣 ( W ) 的尺寸為 ( d \times k ),我們引入兩個低秩矩陣 ( A ) 和 ( B ) ,其中 ( A ) 的尺寸為 ( d \times r ) ,( B ) 的尺寸為 ( k \times r ) ,且 ( r \ll \min(d, k) )。則新的權重矩陣 ( W’ ) 表示為:

[ W’ = W + A B^T ]

在訓練過程中,我們只需要優化 ( A ) 和 ( B ) ,而保持 ( W ) 不變。這樣,通過調整較少的參數,便可以實現對大模型的有效微調。

代碼實現

下面是一個簡單的示例代碼,演示如何在PyTorch中實現Lora方法對一個預訓練模型進行微調:

import torch

import torch.nn as nn

import torch.optim as optimclass LoraLayer(nn.Module):def __init__(self, original_layer, rank):super(LoraLayer, self).__init__()self.original_layer = original_layerself.rank = rankself.A = nn.Parameter(torch.randn(original_layer.weight.size(0), rank))self.B = nn.Parameter(torch.randn(original_layer.weight.size(1), rank))def forward(self, x):delta_W = torch.mm(self.A, self.B.t())return self.original_layer(x) + torch.mm(x, delta_W.t())# 假設我們有一個預訓練的線性層

original_layer = nn.Linear(768, 768)

lora_layer = LoraLayer(original_layer, rank=4)# 優化器只更新A和B矩陣

optimizer = optim.Adam([lora_layer.A, lora_layer.B], lr=1e-3)# 示例訓練過程

def train_step(input, target):optimizer.zero_grad()output = lora_layer(input)loss = nn.MSELoss()(output, target)loss.backward()optimizer.step()return loss.item()# 示例輸入和目標

input = torch.randn(32, 768)

target = torch.randn(32, 768)# 訓練一個步驟

loss = train_step(input, target)

print(f'Training loss: {loss}')

效果

Lora方法通過引入低秩矩陣分解,有效地減少了模型微調過程中需要更新的參數數量。研究表明,在許多任務中,Lora能夠在保持模型性能的同時,顯著減少計算和存儲開銷。

具體效果上,在自然語言處理任務(如機器翻譯、文本生成)和計算機視覺任務(如圖像分類、目標檢測)中,Lora均表現出優異的性能。與傳統微調方法相比,Lora的參數更新量減少了數個數量級,但依然能夠達到甚至超過原始模型的性能。

總結

Lora是一種創新且高效的微調大型模型的方法。通過低秩矩陣分解,Lora能夠在保持模型性能的同時,顯著減少計算資源和存儲需求。本文介紹了Lora的背景、原理、公式、代碼實現及其效果,希望能幫助你更好地理解和掌握這一方法。隨著大型模型在各個領域的廣泛應用,Lora的出現為我們提供了一種高效、實用的微調解決方案。

版權聲明

本博客內容僅供學習交流,轉載請注明出處。

)

)