引言

多模態大模型是當今人工智能領域的熱門方向之一。它不僅能處理文本,還能理解和生成圖像、視頻、語音等多種模態的數據。這種能力使得多模態大模型在自然語言處理、計算機視覺等多個領域展示出巨大的潛力和應用價值。那么,多模態大模型是如何訓練出來的?其發展趨勢如何?又面臨哪些問題?本文將對這些問題進行深入探討。

多模態大模型的訓練與架構

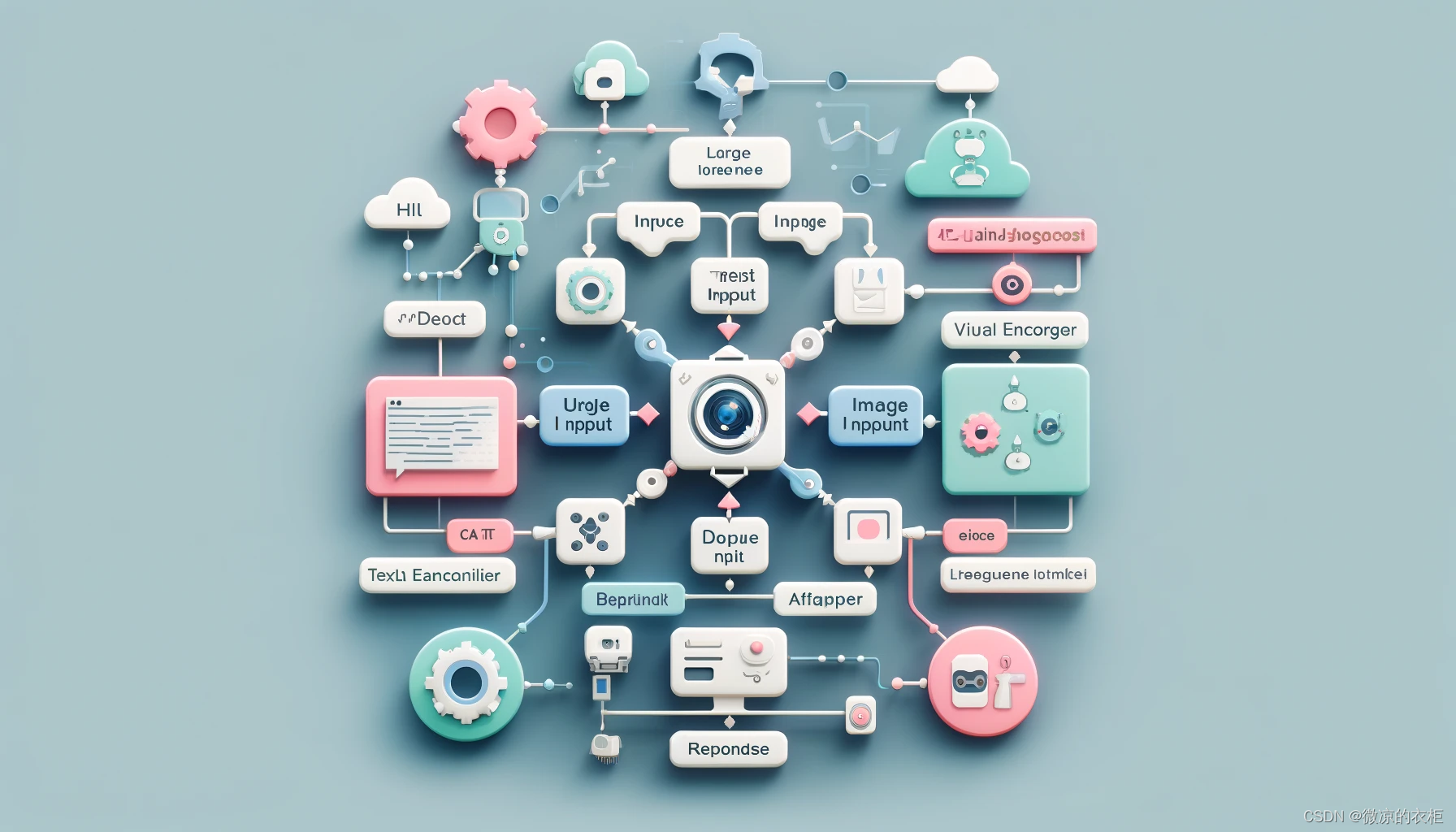

多模態大模型的核心是如何將不同模態的數據進行有效的整合和理解。下面是多模態大模型的基本架構和訓練方法:

基本架構

- 視覺編碼器(Visual Encoder):用于提取圖片或視頻的特征,一般采用現成的視覺模型,如CLIP。

- 適配器(Adapter):將視覺特征映射到文本特征空間,使得圖像信息可以與文本信息對齊。

- 大語言模型(Large Language Model, LLM):作為核心處理模塊,利用其強大的語言理解和生成能力,整合多模態信息并生成最終輸出。

- 多模態數據:用于訓練模型的配對數據,如圖片和其對應的描述文本。

- 指令調優(Instruct Tuning):通過預先設定的任務,讓模型能夠更好地理解和執行人類的指令。

典型系統

- BLIP:采用簡單的線性映射方法,將圖片特征直接嵌入文本空間,結構簡單但效果顯著。

- LLaVA:采用典型的多模態架構,包括視覺編碼器和適配器,提供了良好的文本和圖像理解能力。

- 千問QL:通過多階段訓練,特別是在第二階段進行多任務學習,顯著提升了模型的性能。

- SPINX:支持高清圖像處理,并集成了多個視覺編碼器,提高了視覺特征的提取和理解能力。

發展趨勢

在多模態大模型的發展過程中,以下幾個技術趨勢尤為重要:

高清圖像處理

高清圖像處理技術可以顯著提升多模態模型的性能。通過將高清圖像切割成小塊并保持其高分辨率輸入,模型能夠獲得更豐富和精細的圖像特征,從而提高整體的識別和生成能力。

多視覺編碼器集成

集成多個視覺編碼器可以有效補充單一編碼器的不足,從而提供更全面的圖像特征提取。不同編碼器可以從不同角度理解圖像信息,使得模型的視覺感知能力更強。

細粒度的文圖對齊

細粒度的文圖對齊技術通過精確標注圖像中各個部分與文本描述的對應關系,進一步提高了模型的理解能力。這種標注需要在圖像中明確指出每個對象的位置和其對應的文本描述,確保模型能夠準確理解圖像的深層含義。

文圖交織數據

在訓練多模態大模型時,除了嚴格對齊的文圖數據,還需要大量不嚴格對齊的數據。這可以有效緩解模型的災難性遺忘問題,保持大語言模型原有的語言和推理能力。

面臨的問題

盡管多模態大模型展示了巨大的潛力,但在實際應用中仍面臨不少挑戰:

視覺感知能力弱

目前的多模態大模型在視覺感知方面的表現尚不理想,約35%的錯誤來源于視覺編碼器。這表明模型在處理圖像特征時仍存在很大的改進空間。

空間關系建模差

多模態大模型對圖像中物體的空間關系理解較差。在測試中,模型在判斷物體位置關系(如左側和右側)時經常出錯。這主要是由于模型缺乏足夠的空間關系數據進行訓練。

深層語義理解難

多模態大模型在理解圖像的深層語義時表現不佳。盡管在表層語義理解上有一定的成績,但在涉及深層次含義(如漫畫表達的寓意)時,模型的表現依然遠低于人類水平。

視覺數理推理能力不足

多模態大模型在進行視覺數理推理時表現較差。例如,在處理函數圖像并求解最大局部值的問題時,模型往往無法正確回答。這反映出模型在視覺推理和邏輯推理方面的能力仍需提升。

結論與展望

多模態大模型作為人工智能領域的重要方向,展現出了廣泛的應用前景和發展潛力。盡管目前在視覺感知、空間關系建模、深層語義理解和數理推理等方面還存在諸多挑戰,但通過不斷的技術創新和優化,相信這些問題終將得到解決。未來,多模態大模型有望在更多實際場景中發揮重要作用,推動人工智能技術的發展和應用。

進一步學習資源

- OpenAI GPT-4

- CLIP: Connecting Text and Images

- LLaVA: Large Language and Vision Assistant

- SPINX: Advanced Vision Encoder Integration

一個Agent的“旅行”)

![【Qt秘籍】[003]-Qt環境變量配置-磨刀不誤砍柴工](http://pic.xiahunao.cn/【Qt秘籍】[003]-Qt環境變量配置-磨刀不誤砍柴工)

)

)