【GPT入門】第65課 vllm指定其他卡運行的方法,解決單卡CUDA不足的問題

- 1.原理

- 說明:

- 2.實踐

1.原理

要將 vllm 部署在第二張 GPU 卡上(設備編號為 1),只需在命令前添加 CUDA_VISIBLE_DEVICES=1 環境變量指定 GPU 設備:

CUDA_VISIBLE_DEVICES=1 vllm serve /root/autodl-tmp/models_xxzh/Qwen/Qwen1.5-1.8B-Chat

說明:

CUDA_VISIBLE_DEVICES=1是核心配置,強制程序僅使用編號為 1 的 GPU(第二張卡,GPU 編號從 0 開始計數)- 若需驗證 GPU 編號,可先運行

nvidia-smi查看所有 GPU 設備的序號和狀態 - 如需額外參數(如指定端口、并發數等),可直接追加在命令后,例如:

CUDA_VISIBLE_DEVICES=1 vllm serve /root/autodl-tmp/models_xxzh/Qwen/Qwen1.5-1.8B-Chat --port 8000 --max-num-seqs 32

2.實踐

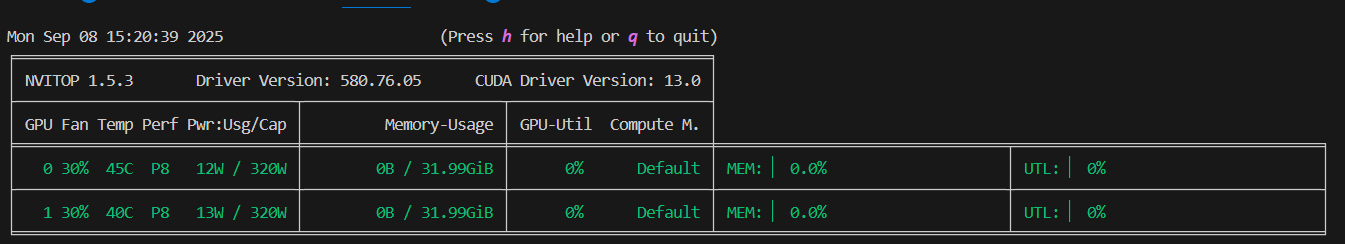

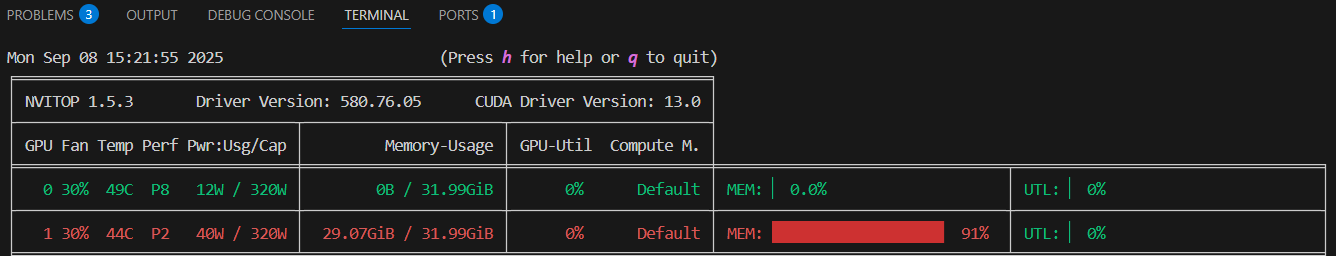

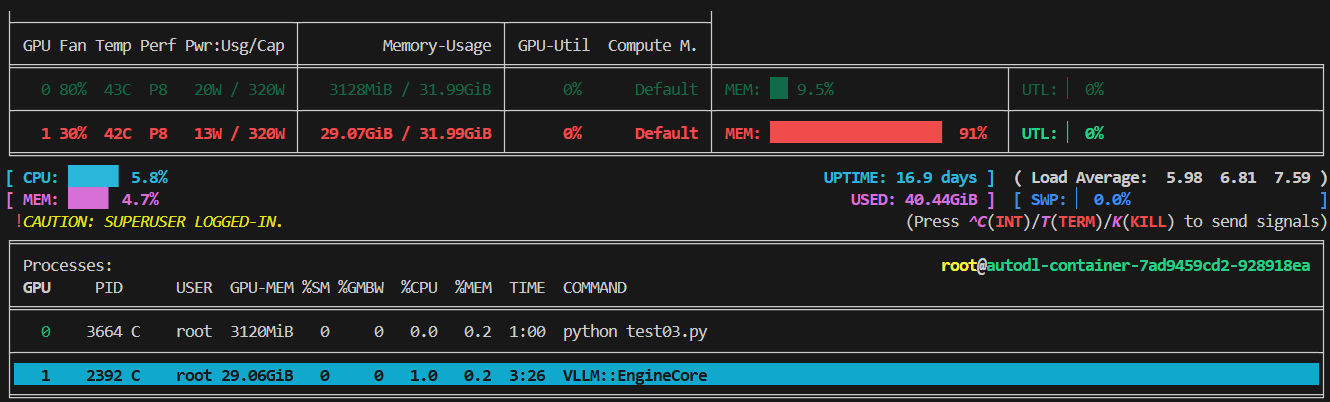

下面的圖是nvitop, (通過pip install nvitop 安裝) 的截圖

- 運行前

- 指定第一個卡運行

命令:

CUDA_VISIBLE_DEVICES=1 vllm serve /root/autodl-tmp/models_xxzh/Qwen/Qwen1.5-1.8B-Chat

- 其他llm程序默認在第0個卡運行

)

)

)