引言:從“能算會說”到“會看能做”

具身智能真正的門檻,不在于把模型做得更大,而在于把感知—決策—執行焊成一條低時延、穩態可控的閉環工程鏈路:從相機/麥克風采集,到編解碼與傳輸,再到邊/端推理、指令下發與動作執行,最后回到新一輪的感知反饋。

這個閉環要想在真實世界長期穩定運行,離不開一條跨平臺、可運維、可度量的音視頻“神經通道”。大牛直播SDK(SmartMediaKit)提供的推流、播放、輕量級 RTSP 服務、GB28181 接入、多路轉發與錄像等模塊,正是這條通道的標準化積木。

本文聚焦工程落地與復用,回答一個核心問題——如何用這些模塊搭建具身智能的通用底座,使系統真正做到看得清、傳得穩、算得快、控得準。

技術落地的關鍵:先固鏈路,再談智能

如果把具身智能類比為“人”,那么模型是大腦,而視頻鏈路就是眼耳鼻喉與神經通道。沒有穩定的鏈路,感知再精準、算法再強大,也無法在真實場景中閉環。

在這一點上,大牛直播SDK的價值不只是“能推流能播放”,而是將 RTSP/RTMP 播放器、推流模塊、輕量級 RTSP 服務、GB28181 對接、多路轉發、錄像 等能力打磨成可組合的基礎部件。它讓開發者無需從零構建底層傳輸棧,就能快速拼出可復用、可擴展的“視頻-控制”底座。

換句話說,大牛直播SDK并不是簡單的工具箱,而是具身智能場景里實現“看得清、傳得穩、控得準”的工程基座。

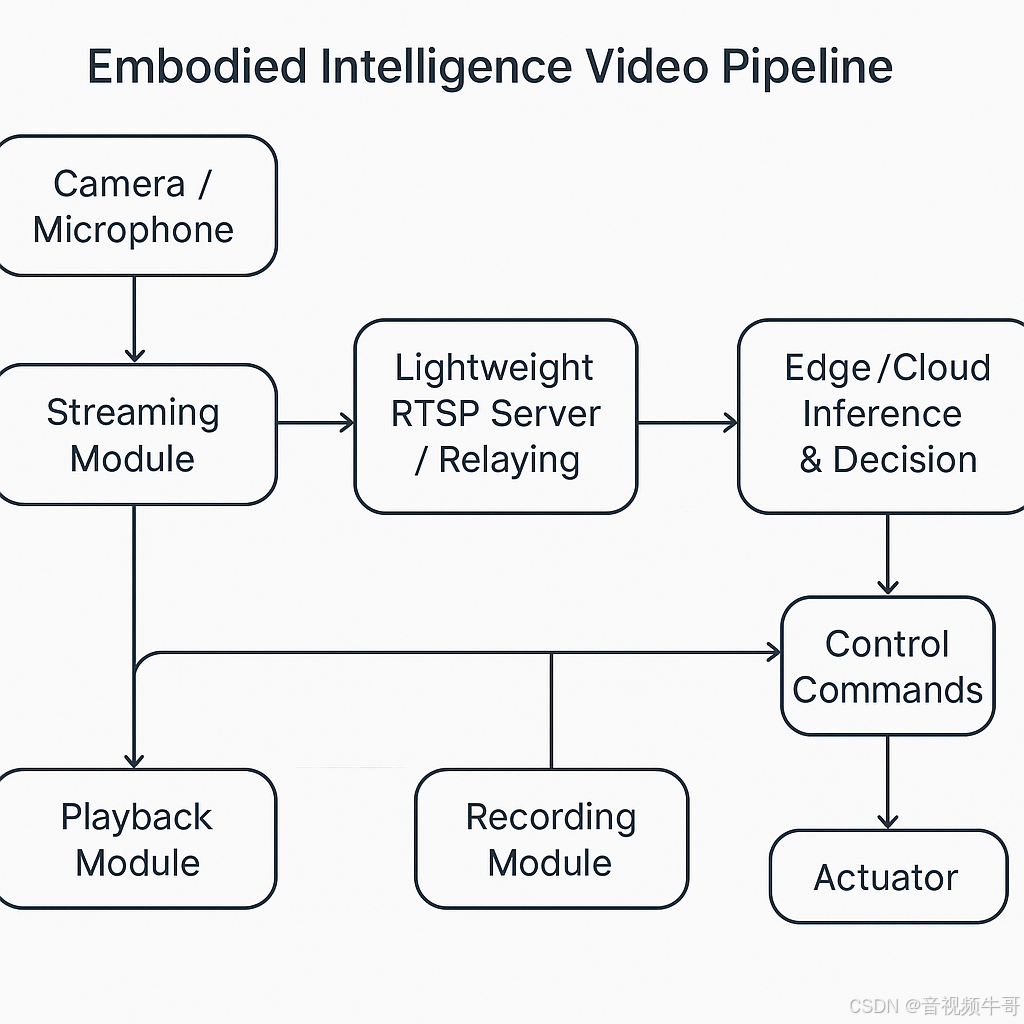

典型架構示例:視頻鏈路作為具身智能的“神經系統”

在機器人、無人機或工業場景中,典型的具身智能架構可以抽象為以下鏈路:

[傳感器/攝像頭/麥克風] → [大牛直播SDK 推流模塊] → [5G/專網/局域網] → [輕量級 RTSP 服務/多路轉發] → [邊緣/云端推理與決策] → [控制指令下發 → 執行器] → [錄像存證/回放訓練]

其中:

-

推流模塊:保證視頻/音頻數據以低延遲、高穩定性方式傳出;

-

輕量級 RTSP 服務:支持局域內轉發、多協議適配(RTSP?RTMP、RTSP|RTMP→GB28181);

-

播放模塊:既服務人機交互終端,也為算法節點提供實時畫面;

-

錄像模塊:實現預錄、事件打點、離線回灌,既滿足合規留痕,又為模型訓練提供數據。

通過這種模塊化拼裝,開發者能快速構建一個“即插即用”的視頻通感通道,把智能算法穩穩地綁在真實物理環境中。

安卓RTSP播放器多實例播放時延測試

分場景解析:不同具身智能應用的鏈路重點

1. 無人機巡檢

-

挑戰:帶寬波動大、環境復雜;

-

重點:推流穩定性與斷點續連;

-

方案:H.265/Enhanced RTMP HEVC 節省帶寬,RTSP 服務支持邊緣匯聚,錄像模塊提供飛行全程留痕。

2. 工業機器人

-

挑戰:強調控制精度與延遲下限;

-

重點:鏈路必須“短而穩”;

-

方案:局域網 RTSP 推流保證 <100ms 時延,播放模塊與算法節點結合,預錄+事件錄像用于異常復盤。

3. 人形/服務機器人

-

挑戰:多模態數據、多終端交互;

-

重點:多實例同步與跨平臺適配;

-

方案:SDK 支持多實例推流/播放,Unity3D 集成 OES 渲染,錄像事件打點與語義時間線結合,方便訓練與交互。

工程落地要點:從“能跑通”到“可運維”

-

監控與告警:提供碼率、幀率、丟包率、RTT 等指標,構建可觀測鏈路;

-

容錯與重連:內置斷線重連與清緩存機制,避免延遲被歷史數據拖長;

-

數據回灌與迭代:事件打點與預錄支持“錄像回灌→算法優化→部署驗證”的閉環;

-

跨平臺統一性:Windows/Linux/Android/iOS/Unity3D 一致接口,降低集成與運維成本。

真正的規模化應用,不是先有算法,而是先要一條能觀測、能修復、能持續演進的鏈路。

安卓RTMP播放器同時播放4路RTMP流延遲測試

結語與展望:讓智能真正“落地生根”

具身智能的發展正在從實驗室走向工廠車間、城市街區與低空空域。核心挑戰不是“有沒有大模型”,而是能否通過穩定的鏈路把算法綁在真實世界。

大牛直播SDK通過模塊化的推流、播放、輕量級 RTSP 服務、GB28181 接入、多路轉發與錄像功能,已經成為具身智能落地的“神經系統工程件”。

未來,它將在三個方向持續演進:

-

更低延遲與更強魯棒性:適配新一代編解碼與傳輸協議;

-

更緊密的 AI 融合:錄像與回灌功能服務于模型訓練與在線優化;

-

更開放的生態接口:深度對接 ROS、Unity、工業總線,成為跨行業的視頻樞紐。

當系統能夠做到看得清、傳得穩、控得準,具身智能才真正具備走向規模化產業的可能,也才能推動人機協作和生產力范式的全面升級。

📎 CSDN官方博客:音視頻牛哥-CSDN博客

)

超詳細_Leetcode_20. 有效的括號)

實現CIFAR-10圖像分類)