題目

在深度學習中,為什么batch_size設置為1不好?為什么batch_size設為整個數據集的大小也不好?(假設服務器顯存足夠)

解答

這是一個非常核心的深度學習超參數問題。即使顯存足夠,選擇極端的?batch_size?也通常會帶來顯著的性能下降。這背后是優化動力學(Optimization Dynamics)和泛化能力(Generalization)?的深層權衡。

下面我們分別詳細探討。

一、為什么?batch_size = 1(在線學習)不好?

將?batch_size?設置為 1 意味著每看到一個樣本就更新一次權重,這被稱為隨機梯度下降(SGD)?或在線學習。其問題主要在于:

1.?訓練過程極度不穩定,收斂困難

高方差梯度:單個樣本的梯度是整個訓練集梯度的一個噪聲非常大的估計。這次更新可能指向一個正確的方向,下一次更新可能指向一個完全相反的方向。

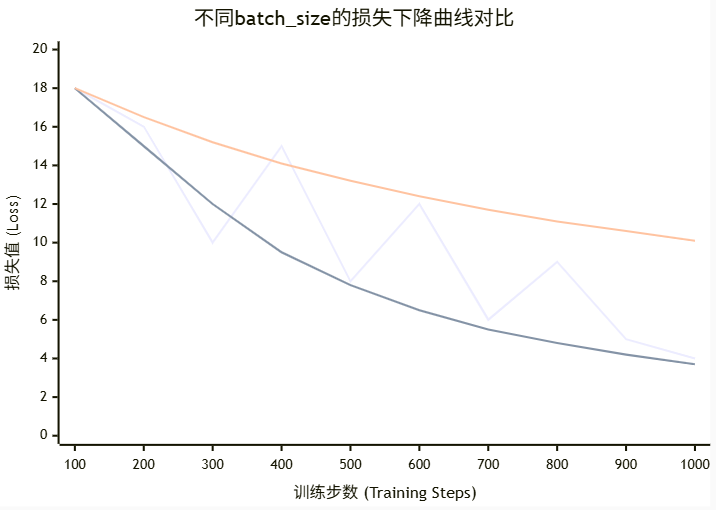

損失劇烈震蕩:模型的損失函數會劇烈跳動,難以平滑地下降到一個好的局部最優點(或平坦的最小值區域)。如下圖所示,

bs=1?的路徑非常曲折嘈雜。難以設置學習率:學習率設置得非常小,收斂會慢得無法忍受;學習率設置得稍大,一次“壞”的更新就可能讓模型參數跳出當前正在優化的良好區域,甚至導致梯度爆炸,訓練完全失敗。

2.?無法利用硬件并行計算,訓練效率極低

現代深度學習嚴重依賴?GPU/TPU 的并行計算能力。這些硬件在設計上對大規模矩陣運算(如大的矩陣乘法)進行了極致優化。

batch_size = 1?意味著每次只計算一個樣本的梯度,GPU 的絕大多數計算單元都處于空閑狀態。這完全浪費了硬件的強大算力,導致訓練時間變得異常漫長。

3.?失去梯度下降的“平均”效應

Batch 梯度下降的核心思想是通過一批樣本的梯度求平均來獲得一個對數據分布更真實、更穩定的估計。

bs=1?失去了這種平均效應,模型更容易記住噪聲和異常值,而不是學習數據中通用的模式。

簡單比喻:這就像在暴風雨中劃船,你每劃一槳(一次更新)就根據剛剛遇到的一個浪頭來決定下一槳的方向,而不是觀察過去幾秒鐘的整體水流情況。結果就是你一直在劇烈地左右搖擺,很難高效地前進。

二、為什么?batch_size = 整個訓練集(批梯度下降)也不好?

將?batch_size?設置為整個數據集的大小,意味著每個 epoch 只進行一次更新。雖然梯度方向是最準確的,但問題同樣突出:

1.?泛化能力差:容易陷入尖銳最小值(Sharp Minimum)

這是最核心的問題。理論研究和大規模實驗表明,小的 batch size 傾向于找到?平坦的最小值(Flat Minimum),而大的 batch size 傾向于找到?尖銳的最小值(Sharp Minimum)。

平坦最小值:損失函數在某個區域都比較低,像一個寬闊的山谷。模型參數在這個區域發生微小變化時,損失值變化不大,因此模型對沒見過的測試數據(分布略有不同)魯棒性強,泛化能力好。

尖銳最小值:損失函數在一個點很低,但周圍陡然升高,像一個狹窄的深井。雖然訓練損失可以很低,但模型參數稍一變動,性能就急劇下降,因此泛化能力通常很差,容易過擬合。

2.?計算成本和內存問題

雖然假設顯存足夠,但計算依然昂貴:即使顯存能放下整個數據集,計算整個數據集的梯度也是一次巨大的計算開銷。尤其是對于大規模數據集(如 ImageNet),一次前向和反向傳播的計算成本非常高。

內存瓶頸:對于非常大的模型和數據集,即使顯存足夠,一次加載所有數據也會觸及硬件的內存帶寬上限,可能并不會比中等 batch size 快多少。

3.?優化過程容易陷入局部最優點和鞍點

小 batch size 帶來的梯度噪聲在某種程度上是一種正則化,它可以幫助模型參數“跳出”不好的局部最優點或鞍點。

當使用全批梯度下降時,梯度估計非常精確,缺乏這種“擾動”能力。一旦梯度接近于零(如在鞍點或平坦區域),優化過程就會完全停止,因為沒有噪聲把它推出去尋找更好的區域。

4.?收斂所需的迭代次數更少,但總計算量更大

由于每次更新方向都是最優的,理論上達到相同精度所需的?epoch 數量更少。

但是,每個 epoch 的計算成本遠遠高于小 batch size 的方案。綜合考慮總計算時間和最終泛化性能,全批梯度下降幾乎總是最差的選擇。

簡單比喻:這就像你要從北京去上海,全批梯度下降是讓你先精確測量出整個地球的曲率和路況,規劃出一條理論上絕對最短的直線路徑(可能要打隧道、架跨海大橋),然后一步到位。這個過程規劃成本極高,且路徑脆弱(橋斷了就完了)。而小批量梯度下降則是每走一段就看一眼地圖調整一下,雖然路徑不是絕對最短,但更靈活、更魯棒,總用時可能更少。

總結與最佳實踐

| 特性 | batch_size = 1 | batch_size = 全數據集 | 中等 batch_size (e.g., 32, 64, 256) |

|---|---|---|---|

| 梯度質量 | 噪聲大,方差高 | 非常精確,方差低 | 噪聲適中,是真實梯度的良好估計 |

| 訓練穩定性 | 非常不穩定 | 非常穩定 | 相對穩定 |

| 收斂速度 | 慢(步數多) | 快(步數少)但每步慢 | 總計算時間最優 |

| 泛化能力 | 通常較好(噪聲正則化) | 通常較差(陷尖銳最小點) | 最好(噪聲與穩定性的平衡) |

| 硬件利用率 | 極低(無法并行) | 高(但可能內存受限) | 極高(完美并行) |

| 內存需求 | 很低 | 極高 | 可調節 |

最佳實踐:

從一個適中的值開始(例如 32),這是一個在大多數任務上都表現良好的默認值。

考慮?GPU 內存:在保證不爆顯存的前提下,盡可能使用更大的 batch size 以充分利用并行計算。通常使用?

2^N?的大小(如 32, 64, 128),因為某些硬件和庫對此有優化。調整學習率:當增加 batch size 時,通常需要同步增大學習率(如線性縮放規則:

new_lr = old_lr * (new_bs / old_bs)),因為更大的 batch 意味著更可靠的梯度,我們可以更大膽地前進。對于非常大的 batch size,還需要配合學習率熱身(Learning Rate Warmup)?等技巧來保持訓練的穩定性。

因此,深度學習中 batch size 的選擇是一個典型的權衡藝術,需要在優化效率和泛化性能之間找到最佳平衡點,而兩個極端通常都不是好的選擇。

)

)

與同義詞治理)