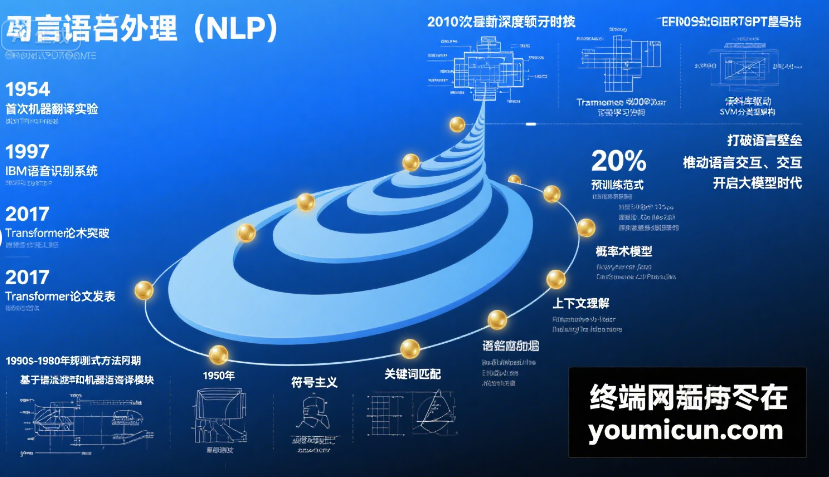

自然語言處理(NLP)作為人工智能的重要分支,其發展歷程跨越了大半個世紀,從早期的規則式嘗試到如今的大模型時代,技術路徑不斷迭代,核心目標始終是實現人機間的自然語言交互。以下從關鍵階段、技術突破和標志性成果三個維度,展開介紹 NLP 的發展歷史:

一、萌芽期(20 世紀 50-70 年代):規則驅動的初步探索

這一階段的核心思路是通過人工定義語言規則來實現簡單的語言處理,依賴語言學專家的知識編碼。

- 標志性成果:

- 1954 年,IBM 與喬治城大學合作實現了首個機器翻譯系統,將 60 句俄語自動翻譯成英語,開創了 NLP 研究的先河。但受限于規則復雜度,翻譯質量極低,且僅能處理特定領域短句。

- 1966 年,美國語言學家韋曾鮑姆(Joseph Weizenbaum)開發ELIZA,這是首個聊天機器人。它通過模式匹配(如識別 “我感到難過” 時回復 “你為什么感到難過?”)模擬對話,雖無真正理解能力,卻讓人們首次感受到人機對話的可能。

- 局限性:規則需人工編寫,難以覆蓋復雜語法、歧義語境和多樣化表達,導致系統擴展性極差,很快陷入瓶頸。

二、統計學習期(20 世紀 80-90 年代):數據驅動的范式轉變

隨著計算機算力提升和語料庫建設,NLP 從 “規則驅動” 轉向 “統計驅動”,通過數學模型從數據中學習語言規律。

- 核心技術:

- 隱馬爾可夫模型(HMM):廣泛應用于語音識別和詞性標注,通過概率計算處理語言序列的不確定性(如識別 “蘋果” 是水果還是公司時,結合上下文概率判斷)。

- 最大熵模型、條件隨機場(CRF):提升命名實體識別(如識別 “北京” 是城市名)、句法分析等任務的準確率。

- 里程碑事件:

- 1994 年,Penn Treebank 語料庫發布,包含大量標注了詞性、句法結構的英語文本,為統計模型提供了標準化訓練數據,推動了 NLP 的工程化落地。

- 2000 年左右,統計機器翻譯(SMT)取代規則翻譯成為主流,通過雙語平行語料庫(如漢英對照文本)學習翻譯概率,翻譯準確率較早期系統提升 30% 以上。

- 局限:依賴人工特征工程(如手動設計 “詞性 + 上下文窗口” 特征),對長文本依賴和語義理解能力依然薄弱。

三、深度學習期(2010 年代):神經網絡的顛覆性突破

2010 年后,深度學習技術(尤其是神經網絡)主導 NLP 發展,通過多層非線性網絡自動學習語言特征,擺脫了對人工特征的依賴。

- 關鍵突破:

- 詞向量(Word Embedding):2013 年,Mikolov 等人提出 Word2Vec,將詞語轉化為低維稠密向量(如 “國王 - 男人 + 女人≈女王”),首次實現了詞語語義的數值化表示,解決了傳統 “獨熱編碼” 無法捕捉語義關聯的問題。

- 循環神經網絡(RNN/LSTM/GRU):通過時序結構處理文本序列,在機器翻譯、情感分析等任務中表現優于統計模型。2014 年,基于 LSTM 的神經機器翻譯(NMT)系統問世,翻譯質量遠超統計方法。

- Transformer 架構:2017 年,Google 團隊在《Attention Is All You Need》中提出 Transformer,以 “自注意力機制” 替代 RNN 的時序依賴,可并行處理文本,同時捕捉長距離語義關聯(如一句話中 “他” 與前文 “小明” 的指代關系)。這一架構成為后續所有大模型的基礎,標志著 NLP 進入 “預訓練時代”。

- 代表性模型:

- 2018 年,Google 發布BERT(雙向預訓練模型),通過 “掩碼語言模型(MLM)” 學習上下文語義,在問答、情感分析等 11 項任務中刷新紀錄,推動 NLP 從 “單任務訓練” 轉向 “預訓練 + 微調” 模式。

- 同期,OpenAI 的GPT 系列(生成式預訓練模型)采用自回歸方式生成文本,GPT-1(2018)、GPT-2(2019)逐步提升模型參數規模(GPT-2 達 15 億參數),展現出強大的文本生成能力(如續寫故事、撰寫新聞)。

四、大模型時代(2020 年至今):通用智能的跨越

隨著算力(如 GPU 集群)和數據量(萬億級文本語料)的爆發,NLP 進入 “大模型時代”,模型參數從百億級躍升至萬億級,能力從 “專項任務” 向 “通用智能” 突破。

- 里程碑模型:

- GPT-3(2020):OpenAI 推出 1750 億參數的 GPT-3,無需微調即可通過 “提示詞(Prompt)” 完成翻譯、編程、創作等多任務,展現出 “少樣本學習” 能力,讓人們看到通用人工智能(AGI)的曙光。

- GPT-4(2023):支持文本、圖像等多模態輸入,邏輯推理、復雜任務處理能力大幅提升(如解析圖表、生成法律文書),成為商業化落地的標桿。

- 其他代表性模型:Google 的 PaLM(5400 億參數)、 Anthropic 的 Claude(側重安全性)、國內的百度文心一言、阿里通義千問等,推動大模型向行業場景滲透。

- 技術趨勢:

- 多模態融合:NLP 與計算機視覺、語音識別結合(如 “文本 + 圖像” 生成視頻、“語音 + 手勢” 交互),突破單一模態限制。

- 高效訓練與壓縮:通過模型量化、知識蒸餾等技術,降低大模型部署成本(如 GPT-3 的輕量版可在手機端運行)。

- 安全與對齊:通過 “人類反饋強化學習(RLHF)” 減少模型偏見,確保生成內容符合倫理規范(如避免虛假信息、歧視性言論)。

總結:NLP 發展的核心邏輯

從 “人工規則” 到 “統計學習”,再到 “深度學習” 和 “大模型”,NLP 的發展史本質是 **“數據 + 算力 + 算法” 協同進化 ** 的過程:數據規模從百萬級到萬億級,算力從單機到分布式集群,算法從線性模型到復雜神經網絡。未來,隨著技術進一步突破,NLP 將更深度地融入日常生活,成為連接人類與智能系統的 “自然語言橋梁”。

)

)

)