在人工智能奔騰的2025年,WAIC(世界人工智能大會)釋放出一個明確信號:視頻能力已經成為通往“遠程智能”的神經中樞。在無人機、四足機器人、遠程施工、巡檢等新興場景中,一套可靠、低延遲、可嵌入頭顯設備的視頻傳輸系統,正成為 AI 系統眼中的“關鍵器官”。

今天,我們以 大牛直播SDK × 頭顯設備(Pico/Quest)× 遠程智能操控場景 為核心,深入剖析一條從實時感知到遠程決策的閉環路徑,探討視頻傳輸能力如何成為 AI 控制鏈條中的基礎設施。

一、🌍 時代背景:智能體 + 遠程感知,進入頭顯協作新時代

在本屆 WAIC 2025 上,最吸引人關注的關鍵詞不是“AGI”,而是:

“多模態感知 + 實時協作 + 虛實融合控制”

智能體不再是孤立運行的節點,而是逐步演化為具身智能系統中的一部分,依托于網絡通信、視頻感知、觸覺反饋、動作控制等多模態通道,實現與遠程操作者的實時聯動與深度協作。

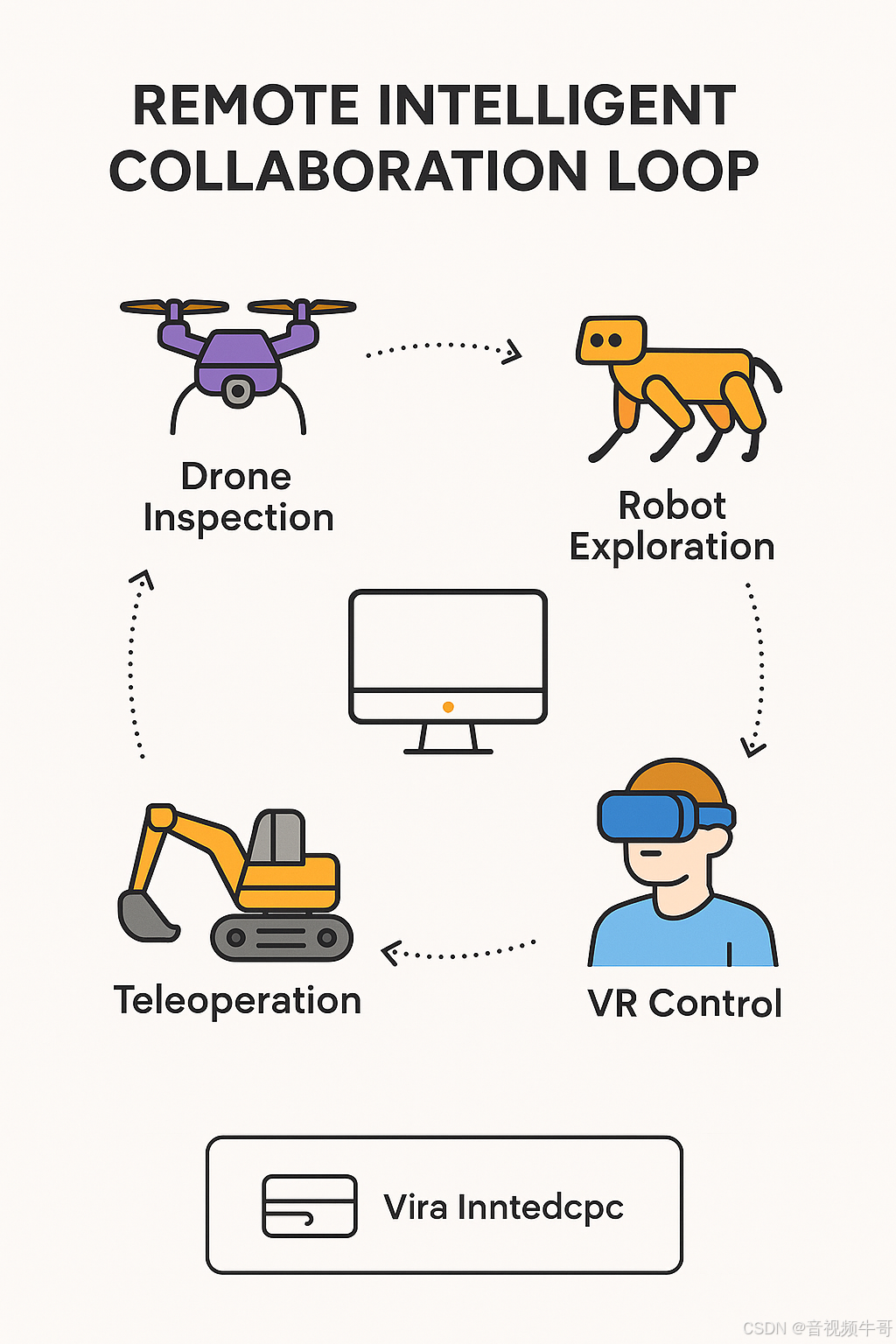

🚁 無人機遠程巡檢

無人機不只是飛行平臺,更是高空智能“觀察者”。在山火探測、災后勘察、橋梁檢查等場景中,通過 RTSP/RTMP 實時推送高清畫面至地面指揮中心,遠程操控者借助頭顯設備以“第一視角”進行畫面巡查與路徑調整,必要時可快速切換飛控權限進行干預。低延遲視頻鏈路是及時響應、精準決策的前提。

🐾 四足機器人進入復雜環境

在電力管廊、地下管網、震后廢墟等高危空間,四足機器人成為最理想的探測/作業單元。遠程操作者通過 VR 頭顯查看實時畫面,并結合 AI 分析結果下達操作指令,如拾取物體、規避障礙、調整姿態等。此過程中,視頻數據不僅服務人眼,還作為 AI 行為感知模型的原始輸入,穩定 + 可控 + 低延遲的視頻成為閉環關鍵。

🏗 遠程精細操控作業

電鏟、挖掘機、機械臂等工程裝備,在某些危險或遠程區域需由經驗豐富的操作者進行遠距控制。操作者佩戴 Pico 或 Quest 頭顯,通過低延遲 RTMP 視頻流“身臨其境”地觀察作業環境,并結合動作捕捉與觸控反饋完成高精度操作。視頻延遲直接影響作業精度與安全性,不能超過人眼可容忍的感知閾值(一般在 200ms 以下)。

🚧 危險場景下的人類視覺代理

在核電站巡檢、易燃爆倉庫、深井等高危區域,操作人員無法親臨現場,但任務又必須“人工判斷”。此時,機器人通過高清攝像頭與傳感器采集一線信息,大牛直播SDK將視頻實時推送到頭顯設備中,讓遠程人員“身臨其境”,進行判斷、下達指令或接管控制,實現遠程“虛擬親臨”。

這一切應用背后,共同指向一個不可動搖的技術基石:

高幀率 + 低延遲 + 異構網絡適配 + 多協議兼容的視頻實時傳輸能力,是遠程智能協作的“視覺神經”。**

而這正是大牛直播SDK在各大遠程智能系統中持續發力的方向 —— 從終端設備采集、協議轉換,到跨平臺播放與 Unity 嵌入,構建真正可落地、可部署的遠程視覺閉環。

二、🔧 技術挑戰:為什么“視頻上頭顯”很難?

盡管“在頭顯設備中觀看實時視頻流”聽起來是一個直觀的應用,但要實現真正流暢、低延遲、無眩暈的體驗,在實際工程中卻面臨諸多挑戰,特別是在無人機遠程控制、四足機器人操控、重型機械遠程施工等對響應時間極其敏感的場景中,視頻系統往往成為性能瓶頸和系統瓶頸的交匯點。

📊 常見技術挑戰與底層難點

| 技術挑戰 | 底層難點分析 |

|---|---|

| ? 端到端延遲過高 | 視頻采集 → 編碼 → 推流 → 解碼 → 渲染 → 顯示鏈路復雜,任一環節延時堆積都可能引發“操控滯后”或“頭暈眩暈”問題。頭顯設備對延遲非常敏感,一般要求控制在 200ms以內,但傳統播放器方案(如FFmpeg+Unity插件)容易超過此閾值。 |

| 🖥 Unity渲染瓶頸 | Unity 本身對外部紋理支持有限,若未使用 OES/SurfaceTexture 等原生機制,容易引發 CPU→GPU 紋理傳輸瓶頸,導致渲染掉幀、畫面撕裂等問題,直接影響沉浸體驗。 |

| 📶 弱網環境下穩定性差 | 戶外飛行、工地、山區等實際場景中網絡抖動、丟包頻繁,常規播放器容易出現花屏、斷流、音畫不同步等異常,缺乏魯棒性的協議適配與自適應策略。 |

| 🧩 多協議/多格式兼容難 | 視頻源可能來自無人機(RTSP)、邊緣服務器(RTMP),若播放器不具備靈活協議支持與快速切換能力,將限制系統擴展性和部署靈活性。 |

| 🎛 缺乏精準控制接口 | 遠程操控類應用要求播放器支持精細接口,如:播放精確控制、YUV/RGB 數據回調、延遲統計、異常捕獲等,傳統播放器或開源方案支持有限。 |

| 🧠 頭顯設備異構適配復雜 | 市面上頭顯設備硬件平臺差異極大,要實現跨平臺穩定運行,播放器需封裝良好、接口清晰、兼容性強。 |

📌 舉例說明:傳統方案在頭顯播放中常見問題

-

FFmpeg 播放器 → 紋理上傳方式不兼容 Unity,需逐幀拷貝 → 幀率下降嚴重

-

VLC 嵌入方案 → 無法控制播放延遲 → 操控動作和畫面不同步

? 小結:頭顯 ≠ 屏幕,視頻播放能力必須“原生化 + 可控化 + 高性能化”

要在頭顯設備中實現工業級視頻播放體驗,絕不能只是“能播出來”,而是要做到:

-

極低的端到端延遲(<200ms)

-

無額外 CPU-GPU 拷貝的高效紋理通路

-

自動適應網絡波動的穩定播放

-

與操控鏈路高度同步的播放節奏

-

Unity / 原生系統下的多平臺適配與封裝

三、🚀 解決方案:大牛直播SDK × Unity × Pico/Quest 的超低延遲播放架構

面對“視頻上頭顯”在延遲控制、渲染效率、平臺適配等方面的多重挑戰,大牛直播SDK 提供了一套經大量實戰驗證的完整解決方案 —— 從協議接入到 Unity 渲染,從原生紋理共享到跨平臺適配,構建起一個可插拔、低延遲、高并發、可控可調的視頻播放能力閉環,特別適用于 Pico、Quest 等主流 VR 設備。

🧠 架構總覽:從碼流到畫面,一站式鏈路優化

[遠端設備輸出] → RTSP/RTMP/SRT → [大牛直播SDK] → [原生解碼 + OES紋理] → [Unity中 Texture 顯示] → Pico/Quest頭顯| 階段 | 關鍵技術手段 | 延遲優化方式 |

|---|---|---|

| 視頻接入 | 多協議支持(RTSP、RTMP、SRT、HLS 等) | 最短路徑接入,裸流直解 |

| 解碼處理 | 內置 Android MediaCodec / 硬解 FFmpeg | 避免中間緩存堆積,幀間調度精細 |

| 紋理上傳 | OES + SurfaceTexture 紋理共享 | 避免 CPU → GPU 拷貝 |

| Unity 顯示 | Unity 插件綁定 ExternalTexture | 原生幀對幀同步,延遲最小化 |

| 控制交互 | 播放控制接口 / 延遲回調 / 狀態同步 | 實時反饋播放狀態,便于操控協調 |

? 核心能力一:多協議直通,兼容工業設備

-

🛠 支持多種輸入協議:RTSP(主流攝像頭/無人機)、RTMP(邊緣推流等;

-

🔌 協議棧內建且高度可控,無需依賴外部播放器,開箱即用;

-

🔄 可動態切換源,適配巡檢/多路視角切換場景。

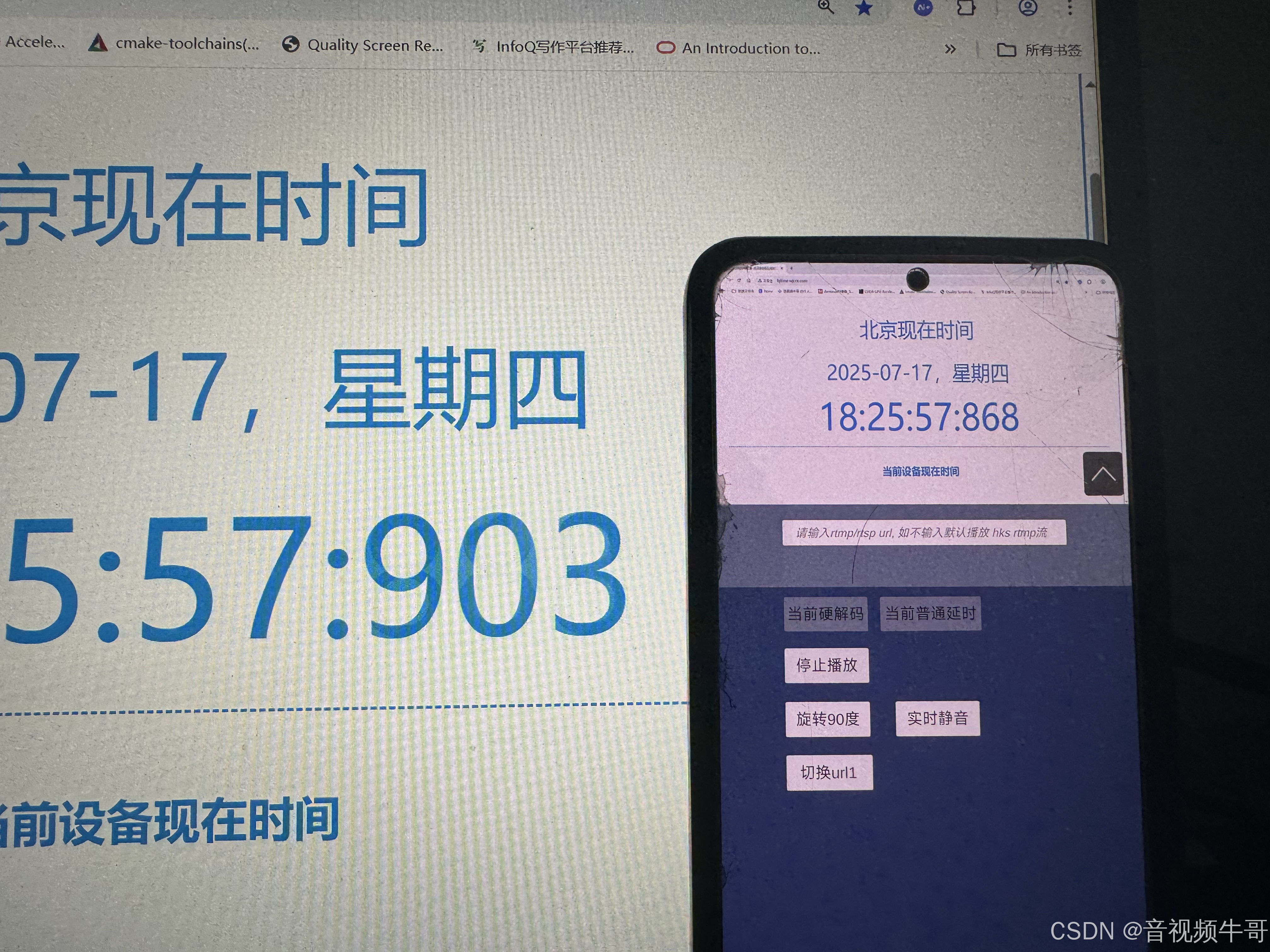

? 核心能力二:低延遲鏈路級優化

Android平臺Unity共享紋理模式RTMP播放延遲測試

-

? 端到端延遲可壓縮至 100ms~250ms,有效解決“視覺滯后”問題;

-

📦 內置自適應解碼緩沖機制,應對弱網丟幀、碼率不穩定情況;

-

🧊 無緩存模式(Zero Buffer Mode)支持,極端場景下實時渲染。

? 核心能力三:Unity 插件 + 原生紋理協作

-

🔧 提供完整 Unity 插件庫和demo示例代碼;

-

🔁 使用 Android SurfaceTexture + ExternalTextureID 實現原生視頻幀 → Unity 顯示紋理的零拷貝渲染;

-

🎮 上層APP可以做邏輯開發,適配各類頭顯交互需求。

四、🎮 典型場景落地:頭顯 × 視頻 × 控制的“遠程閉環”

| 場景類型 | 視頻方案價值 |

|---|---|

| 🚁 無人機圖傳 | 通過 RTSP 推流,實時在 Pico 頭顯中低延遲預覽,搭配陀螺儀控制視角,提升操作沉浸感 |

| 🐾 四足機器人巡檢 | 實時畫面上屏,AI 檢測異常后遠程操控人員接管,可實現遠程步態導航與任務控制 |

| 🏗 遠程機械控制 | 利用 RTMP 推流至局域網控制中心,頭顯人員通過手柄與姿態感應控制大型機械臂操作 |

| 🧠 AI+VR 協作決策 | 多頭顯協同查看實時現場畫面,輔助調度/部署決策,結合語音/文字交互實現聯合響應 |

五、📦 模塊結構:大牛直播SDK 視頻能力如何嵌入遠程智能系統?

在遠程智能控制、機器人協作、虛實融合系統等新一代 AI 場景中,視頻模塊不再是“可有可無的展示端”,而是承擔環境感知、任務判斷、反饋確認等核心職責的“視覺入口”。

大牛直播SDK 提供了一套 高度模塊化、低耦合、跨平臺的嵌入式視頻能力體系,可靈活接入多種智能系統架構,完成從設備端 → 渲染端 → 控制端的全流程打通。

🔧 核心模塊組成與功能分布

| 模塊名稱 | 功能描述 |

|---|---|

| 🎯 協議接入模塊 | 支持 RTSP / RTMP 多協議接入,兼容工業設備、無人機、平臺推流等各類來源 |

| 🧠 解碼渲染模塊 | 基于 Android MediaCodec / FFmpeg 提供軟硬解混合解碼能力,支持 H.264/H.265 等常見編碼格式 |

| 🎮 OpenGL/OES 輸出模塊 | 將解碼后的視頻幀通過 OES 紋理輸出,避免 CPU→GPU 資源拷貝,提高渲染效率,適配 Unity/Native |

| 🧩 Unity 插件封裝模塊 | 支持 Unity 外部紋理綁定,輕松集成到 Pico / Quest 等頭顯設備中 |

| 📷 畫面控制與數據接口模塊 | 支持快照、錄像、YUV/RGB 數據回調、實時碼率統計、幀率監控、參數調節等功能 |

| 📡 異常處理與網絡適配模塊 | 自帶斷流重連機制、緩沖策略調優、網絡狀態感知與弱網容錯邏輯,保障播放穩定性 |

📊 架構示意:大牛直播SDK 視頻能力嵌入路徑(Pico/Quest 頭顯場景)

[視頻源] --> [協議接入模塊] --> [解碼模塊] --> [OES紋理輸出] --> [Unity綁定模塊] --> [頭顯顯示] ↑ [畫面控制 / 數據回調 / 狀態監控模塊]此架構具備以下優勢:

-

🔄 模塊解耦,按需集成:無需全部依賴,可根據項目只集成解碼+回調、或解碼+播放等子模塊;

-

?? 跨平臺統一封裝:支持 Android / iOS / Windows / Linux 等主流平臺;

-

💡 支持私有化定制與接口擴展:便于嵌入復雜業務系統或智能體框架中使用;

-

🧩 完美嵌入工業級智能系統:如機器人控制系統、工業可視化平臺、AI分析平臺等。

🔗 與智能系統的聯動能力

| 系統組件 | 大牛直播SDK 提供的連接接口與價值 |

|---|---|

| 🤖 智能機器人系統 | 視頻回調可接入 AI 行為模型;播放狀態可驅動動作執行同步 |

| 📡 無人機調度平臺 | 支持多路視頻流并發解碼與畫面切換;提供原始幀流用于二次分析 |

| 🧠 AI 邊緣分析框架 | 提供 YUV/RGB 原始幀數據;可用于目標檢測/姿態估計等算法接入 |

| 🕶 XR/頭顯應用系統 | 與 Unity 渲染無縫結合;支持上層繼續開發沉浸式交互與多視角同步切換 |

| 🧰 工業控制/遠程維護 | 快速嵌入控制終端或可視化面板,保障低延遲操作響應與狀態反饋 |

? 為什么值得嵌入大牛直播SDK?

-

? 穩定性強:穩定運營經驗,工業場景長期驗證;

-

? 極低延遲:播放鏈路全棧可控,支持端到端延遲控制在100-250ms;

-

? 高度集成:提供完整播放、控制、畫面處理與調試接口;

-

? 易擴展、可裁剪:支持業務定制,輕松嵌入復雜系統架構;

-

? AI 就緒:視頻數據可直接流向 AI 模型,無需二次封裝;

-

? 跨平臺適配:從 Android 到 Pico / Quest / Unity3D 一站打通。

一句話總結:大牛直播SDK的視頻能力,不僅是播放端,更是遠程智能系統中的“視覺通感中樞”,具備從數據采集 → 解碼渲染 → 控制反饋全鏈路打通的能力,真正讓視頻為智能體賦能。

六、🔚 總結:視頻能力,是遠程智能系統的“基礎感官”

在 2025 世界人工智能大會上,我們看到一個明確的趨勢正在發生:

智能系統不再只依賴算法內核,而是加速向具身智能、遠程協同、實時反饋的方向演進。感知能力成為支撐這一轉變的底座,而“視頻”無疑是最直接、最信息密集的感知通道。

就像神經系統中的“視神經”,視頻能力在遠程智能場景中承載著至關重要的角色:

-

它是環境理解的前提:無人機不可能識別山火、四足機器人無法判斷通道障礙、遠程機械手無法完成精細操作,如果沒有高質量的圖像輸入;

-

它是人機協作的橋梁:通過頭顯設備,操控者可以與 AI 系統共享第一視角、協同感知、動態決策;

-

它是智能反饋的起點:AI 模型對事件的判斷,往往基于穩定、低延遲的視頻流進行實時推理和響應;

-

它是安全控制的保障:在高風險環境中,視頻流能讓遠程操作者擁有“沉浸式”判斷力,從而更安全地控制任務。

因此,視頻不只是展示,更是連接“感知—決策—控制”閉環的核心基石。

📌 大牛直播SDK:為遠程智能打造的“視頻通感模塊”

大牛直播SDK 提供的不僅是一套播放器,而是一個適配未來遠程智能系統的通用感知接口,具備以下關鍵優勢:

-

💡 適配性強:兼容無人機、機器人、工業設備、XR終端等多種前端與平臺;

-

? 低延遲穩定:從碼流到畫面端到端可控,保障遠程響應效率;

-

🧠 AI 友好:支持原始數據回調,便于對接檢測、跟蹤、識別模型;

-

🔁 高并發可擴展:滿足多終端、多通道、多任務并行協作;

-

🔗 可嵌入系統級框架:與 Unity、原生 App可無縫融合;

-

🧩 模塊化部署:輕量封裝,靈活集成,無需綁定平臺或復雜依賴。

當“遠程智能”成為時代的新常態,視頻能力的質量、效率與開放性,將決定系統的真實響應力與協作邊界。

而大牛直播SDK,正是在這條視頻感知鏈路上,構建了一塊值得信賴的基座,讓每一個 AI 系統,都能“看得見、看得快、看得穩”。

:使用 Milvus 實現高效圖片查重功能)

的自述)