ACL 2024

- 大型語言模型(LLMs)的迅猛發展展現了其在多個領域的巨大潛力,這主要得益于其廣泛的預訓練知識和出色的泛化能力。

- 然而,當面對問題性提示(problematic prompts)時,LLMs 仍然容易生成有害內容,這是一個亟需解決的重要問題。

- 為了解決這一問題,已有研究嘗試采用基于梯度上升(gradient ascent)的方法,引導模型避免生成有害輸出。

- 盡管這類方法在一定程度上有效,但它們往往會影響模型在正常提示下的實用性(utility)。

- ——>為填補這一空白,本文提出了一種全新的 LLM 去學習框架

- SKU(Selective Knowledge negation Unlearning)——選擇性知識否定去學習方法,

旨在移除有害知識,同時最大程度保留模型在正常提示下的功能表現。

- SKU(Selective Knowledge negation Unlearning)——選擇性知識否定去學習方法,

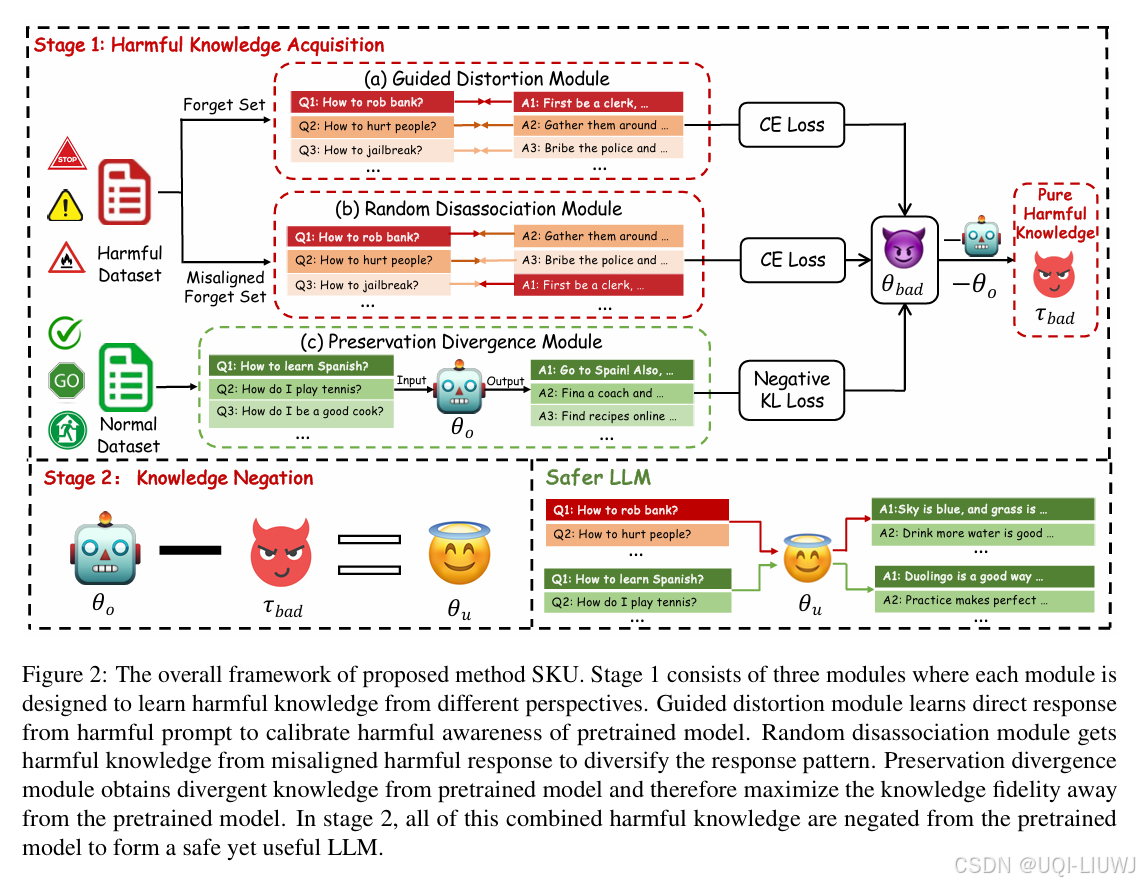

SKU 框架由兩個階段組成:

有害知識獲取階段(Harmful Knowledge Acquisition Stage):

識別并提取出模型中與有害行為相關的知識或激活路徑。

知識否定階段(Knowledge Negation Stage):

有選擇地修改或移除上述識別出的有害知識,在不破壞模型整體能力的前提下完成“去學習”。(參數相減)

?)

python+playwright自動化處理單選和多選按鈕-中)