(一)安裝Spark

? 安裝Spark的過程就是下載和解壓的過程。接下來的操作,我們把它上傳到集群中的節點,并解壓運行。

1.啟動虛擬機

2.通過finalshell連接虛擬機,并上傳安裝文件到 /opt/software下

3.解壓spark安裝文件到/opt/module

tar -zxvf spark-3.3.1-bin-hadoop3.tgz -C /opt/module/

4.重命名,把解壓后的文件夾改成spark-local。因為后續我們還會使用其他的配置方式,所以這里先重命名一次。mv是linux的命令

mv spark-3.3.1-bin-hadoop3 spark-local

(二)配置環境變量

1.打開etc/profile.d/my_env.sh文件中,補充設置spark的環境變量。

# 省略其他...

# 添加spark 環境變量

export SPARK_HOME=/opt/module/spark-local

export PATH=$PATH:$SPARK_HOME/bin:$SPARK_HOME/sbin

2.使用 source /etc/profile 命令讓環境變量生效

(三)單機模式運行第一個Spark程序

這里使用單機模式快運行第一個Spark程序,讓大家有個基本的印象。在安裝Spark時,它就提供了一些示例程序,我們可以直接來調用。進入到spark-local,運行命令spark-submit命令。

spark-submit --class org.apache.spark.examples.SparkPi --master local[2]

/opt/module/spark-local/examples/jars/spark-examples_2.12-3.1.1.jar 10

或者寫成

$ cd /opt/module/spark-local

$ bin/spark-submit \--class org.apache.spark.examples.SparkPi \

--master local[2] \

./examples/jars/spark-examples_2.12-3.3.1.jar \

10

? 這里的 \ 是換行輸入的意思,整體的代碼就只有一句,只不過太長了,我們把它拆開成幾個部分來輸入,其中\ 的意思就是這里寫不下,寫在下一行。

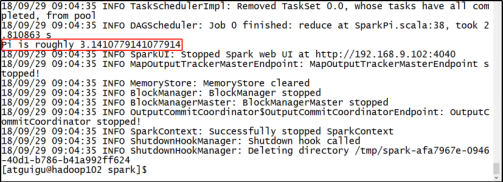

結果展示

該算法是利用蒙特·卡羅算法求PI的值,具體運行效果如下。請注意,它并不會產生新的文件,而是直接在控制臺輸出結果。

(四)查看運行任務詳情

? 在任務還處于運行狀態時,可以通過hadoop100:4040來查看。請注意,一旦任務結束,則這個界面就不可訪問了。

:數據庫)

)

)