文章目錄

- 一、DeepSeek相關網站

- 二、DeepSeek-R1硬件要求

- 三、本地部署DeepSeek-R1

- 1. 安裝Ollama

- 1.1 Windows

- 1.2 Linux

- 1.3 macOS

- 2. 下載和運行DeepSeek模型

- 3. 列出本地已下載的模型

- 四、Ollama命令大全

- 五、常見問題解決

- 附:DeepSeek模型資源

一、DeepSeek相關網站

官方網站:DeepSeek

開源模型:https://huggingface.co/deepseek-ai

GitHub地址:https://github.com/deepseek-ai

接口文檔:首次調用 API | DeepSeek API 文檔

二、DeepSeek-R1硬件要求

以下是 DeepSeek-R1 系列模型在不同規模下的硬件需求(以 Q4_K_M 量化 為例)。這些需求是估算值,實際需求可能因實現方式和上下文長度而有所不同:

| 模型規模 | 顯存需求 (Q4_K_M) | 硬件需求說明 |

|---|---|---|

| 1.5B | ~1.5 GB | 輕量級,適合大多數消費級 GPU(如 GTX 1060 以上) |

| 7B | 4.7 GB | 示例數據(Q4_K_M 量化),需要中端 GPU(如 RTX 3060) |

| 8B | ~5.4 GB | 略高于 7B,適合 RTX 3060/3070 |

| 14B | ~9.4 GB | 需要高端消費級 GPU(如 RTX 3080/3090) |

| 32B | ~21.5 GB | 需要專業級 GPU(如 A100 或 3090 24GB) |

| 70B | ~47 GB | 通常需要多 GPU 或 云服務器(如 A100 40GB) |

| 671B | ~450 GB | 僅適合分布式系統或超大規模集群 |

說明:

-

量化方式:假設使用 4-bit 量化(Q4_K_M),顯存需求較低。如果使用 FP16/32,顯存需求會大幅增加(如 7B FP16 需要約 14 GB)。

-

硬件建議:

1.5B-14B:適合消費級 GPU,如 RTX 3060/3080。

32B-70B:需要專業級 GPU 或多 GPU 并行。

671B:僅適合超大規模集群或分布式系統。 -

上下文長度:長上下文會進一步增加顯存需求,建議根據實際場景調整硬件配置。

如果需要更高精度(如 FP16/32)的顯存需求,可以按比例估算(FP16 約為 Q4_K_M 的 4 倍)

三、本地部署DeepSeek-R1

1. 安裝Ollama

https://ollama.com/download

根據你的操作系統選擇安裝方式:

1.1 Windows

- 訪問 https://ollama.com/download/windows 下載Windows安裝程序。

- 雙擊安裝,完成后在命令行輸入

ollama驗證。

1.2 Linux

curl -fsSL https://ollama.ai/install.sh | sh

1.3 macOS

方式1:直接下載安裝,訪問 https://ollama.com/download/mac 下載macOS安裝包,雙擊安裝。

方式2:Homebrew 安裝

brew install ollama

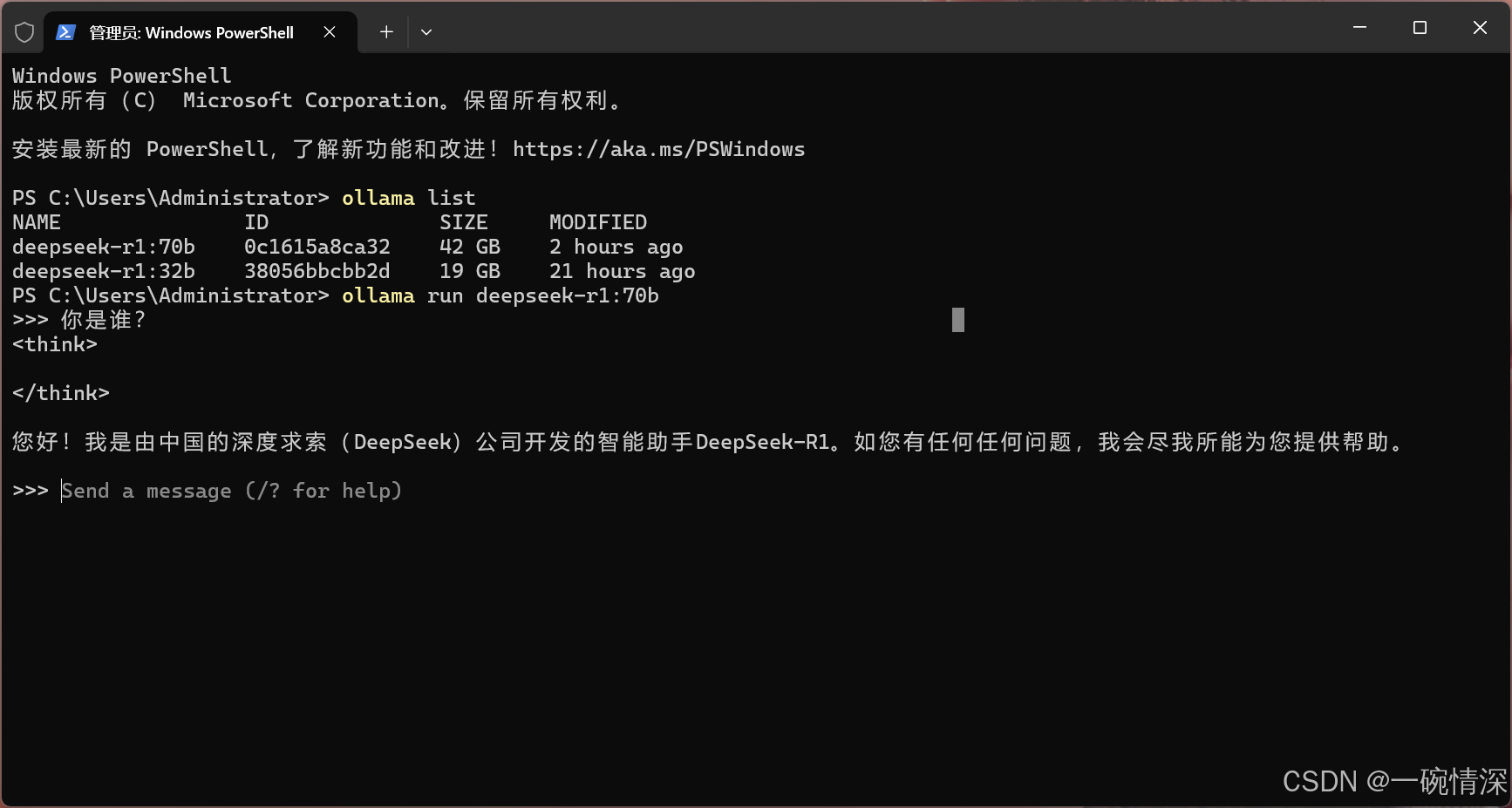

2. 下載和運行DeepSeek模型

訪問 ollama 網站 deepseek-r1 各個版本:https://ollama.com/library/deepseek-r1

選擇電腦符合條件的模型規模,復制命令。

- 方式一:直接運行

以使用70b為例,打開命令行粘貼或輸入:

ollama run deepseek-r1:70b

當我們沒有該模型時會自動下載并運行,如果已經下載完成,運行該命令則直接啟動。

運行后出現以下提示表示成功:

>>> Send a message (/? for help)

- 方式二:下載并部署

拉取的過程后面可能會很慢,對于 linux 和 mac 使用掛在后臺拉取:

nohup ollama pull deepseek-r1:70b &

3. 列出本地已下載的模型

ollama list

四、Ollama命令大全

| 命令 | 描述 | 示例 |

|---|---|---|

| ollama run [model-name] | 啟動模型并與之交互 | ollama run deepseek-r1:7b |

| ollama list | 列出本地已下載的模型 | ollama list |

| ollama pull [model-name] | 從模型庫中下載一個模型 | ollama pull deepseek-r1:7b |

| ollama rm [model-name] | 刪除本地的一個模型 | ollama rm deepseek-r1:7b |

| ollama show [model-name] | 查看某個模型的詳細信息 | ollama show deepseek-r1:7b |

| ollama serve | 啟動 Ollama 服務 | ollama serve |

| ollama stop | 停止 Ollama 服務 | ollama stop |

| ollama logs | 查看 Ollama 的日志信息 | ollama logs |

| ollama create [model-name] -f [config-file] | 使用自定義的模型配置文件創建模型 | ollama create deepseek-r1:7b -f ./my-model-config.yaml |

| ollama export [model-name] [output-file] | 導出模型為文件 | ollama export deepseek-r1:7b ./llama2-model.tar |

| ollama import [input-file] | 從文件導入模型 | ollama import ./llama2-model.tar |

| ollama version | 查看 Ollama 的版本信息 | ollama version |

| ollama --help | 查看所有可用的命令及其說明 | ollama --help |

五、常見問題解決

- 模型不存在?

確認模型名稱正確,或訪問DeepSeek官網獲取最新模型名稱。 - 網絡問題

配置代理(Linux/macOS):

export HTTP_PROXY=http://127.0.0.1:7890

export HTTPS_PROXY=http://127.0.0.1:7890

附:DeepSeek模型資源

- DeepSeek-R1:https://github.com/deepseek-ai/DeepSeek-R1

- 官方模型庫:https://huggingface.co/deepseek-ai

- Ollama文檔:https://github.com/ollama/ollama

在 Postman 中的創建與用法(含完整實測效果圖))

)