大家好,我是靈魂畫師向陽

今天給大家分享一個基于Stable Diffusion WebUI 構建的AI繪圖工具—sd-webui-forge,該工具的目標在于簡化插件開發,優化資源管理,加速推理。

Forge承諾永遠不會對Stable Diffusion WebUI用戶界面添加不必要的改變,對于熟悉Stable Diffusion WebUI的同學,能夠借助 WebUI經驗,快速上手Forge的操作使用。

題外話:Forge作者一直活躍在AIGC繪圖社區。先后開源了ControlNet、Foooucs社區優秀的開源軟件,最近他又投入到Forge的開發,目標簡化AIGC新手入門繪圖門檻。

在分辨率為1024px圖像質量下,Forge與原始WebUI在SDXL模型推理速率相比,可獲得極大的性能加速提升:

-

如果你使用常見的GPU,如8GB顯存,推理速度(it/s)可以提高約30~45%,GPU內存峰值(在任務管理器中)降低約700MB到1.3GB,最大擴散分辨率(不會OOM)提高約2倍到3倍,最大擴散批量大小(不會OOM)提高約4倍到6倍。

-

如果你使用性能較低的GPU,如6GB顯存,推理速度(it/s)可以提高約60~75%,GPU內存峰值(在任務管理器中)降低約800MB到1.5GB,最大擴散分辨率(不會OOM)提高約3倍,最大擴散批量大小(不會OOM)提高約4倍。

-

如果你使用性能強大的GPU,如4090,帶有24GB顯存,推理速度(it/s)可以 提高約3~6%,GPU內存峰值(在任務管理器中)降低約1GB到1.4GB,最大擴散分辨率(不會OOM)提高約1.6倍,最大擴散批量大小(不會OOM)提高約2倍。

-

如果你使用ControlNet來進行SDXL推理,最大ControlNet數量(不會OOM)提高約2倍,SDXL+ControlNet的速度提高約30~45%。

除此之外,Forge還增加了一些高效的采樣器,例如:DDPM、DDPM Karras、DPM++ 2M Turbo、DPM++ 2M SDE Turbo、LCM Karras、Euler A Turbo等。

sd-webui-forge安裝

安裝包安裝

對于不熟悉git操作同學,則可以掃描免費獲取一鍵安裝包。下載完成安裝包后,本地解壓縮文件,然后使用update.bat更新,再使用./webui.bat運行,便可啟動forge軟件。

注意:一定要運行update.bat命令,這個很重要的,因為forge代碼還在快速迭代開發中,確保及時更新最新代碼和環境,否則可能會遇見一些未知的潛在bug版本。與sd-web-ui共享繪圖模型的方式與git方案完全一致。

Git安裝

如果是熟悉Git有一定開發經驗的用戶,可以使用git clone下載最新版forge源碼本地安裝.

環境安裝:

git clone https://github.com/lllyasviel/stable-diffusion-webui-forge.git

cd ./stable-diffusion-webui-forge

# Linux

pip3 install torch torchvision torchaudio

# window

# pip3 install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu121

pip install -r requirements.txt -U

與sd-web-ui共享模型,節約磁盤浪費。如果是window用戶則修改webui-user.bat如下:

@echo offset PYTHON=

set GIT=

set VENV_DIR=

set COMMANDLINE_ARGS=@REM Uncomment following code to reference an existing A1111 checkout.

set A1111_HOME=[stable-diffusion-webui目錄]set VENV_DIR=%A1111_HOME%/venv

set COMMANDLINE_ARGS=%COMMANDLINE_ARGS% ^--ckpt-dir %A1111_HOME%/models/Stable-diffusion ^--hypernetwork-dir %A1111_HOME%/models/hypernetworks ^--embeddings-dir %A1111_HOME%/embeddings ^--lora-dir %A1111_HOME%/models/Loracall webui.bat

當看見啟動命令如下則設置共享成功:

Launching Web UI with arguments: --xformers --forge-ref-a1111-home=sd目錄/ --ckpt-dir sd目錄/models/Stable-diffusion --vae-dir sd目錄/models/VAE --hypernetwork-dir sd目錄/models/hypernetworks --embeddings-dir sd目錄/embeddings --lora-dir /models/lora --controlnet-dir sd目錄/models/ControlNet --controlnet-preprocessor-models-dir sd目錄/extensions/sd-webui-controlnet/annotator/downloads

Forge啟動

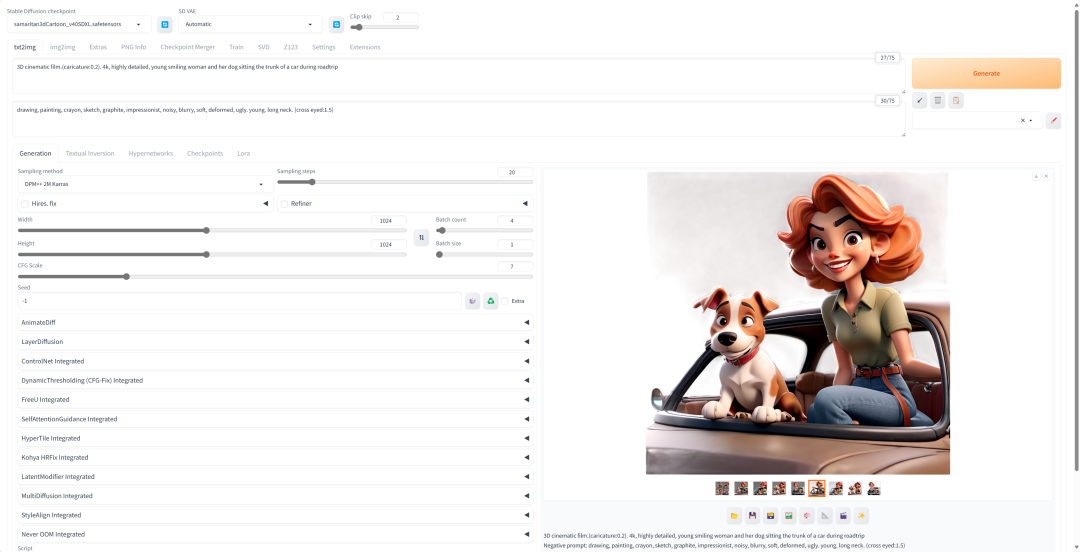

從啟動界面可以看到,Forge的用戶使用界面與sd-web-ui完美的保持WebUI不變。這對新手用戶上手門檻降低了極大的門檻。在啟動界面中,能夠看見新增的SVD、Z123兩個tab,這是前文說的Unet Patcher帶來的新特性。

另外作者提到,Forge在保持了前端界面一致性,并承諾永遠不增加任何不必要的改變。后端則移除了所有與資源管理相關的WebUI代碼,并重新構建了后端的全部基礎設施,是一個重大的重構過程。

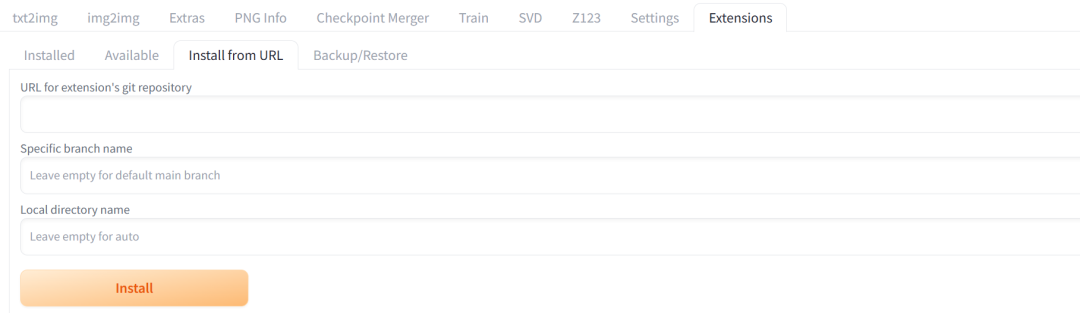

Forge插件不會共享,和webui一樣,使用extension安裝或者手工從webui復制。

sd-webui-forge體驗

在本地rtx4090 24G顯存的Linux環境中,使用sd_xl_base_1.0模型繪圖,能夠看見對應性能提升。耗時3.2秒,平均7.18GB顯存使用,最高峰8.46GB,系統使用率42.1%。相信對于其他低顯存機器,有更顯著的推理提升。

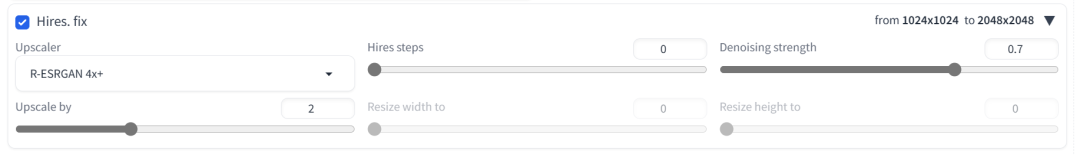

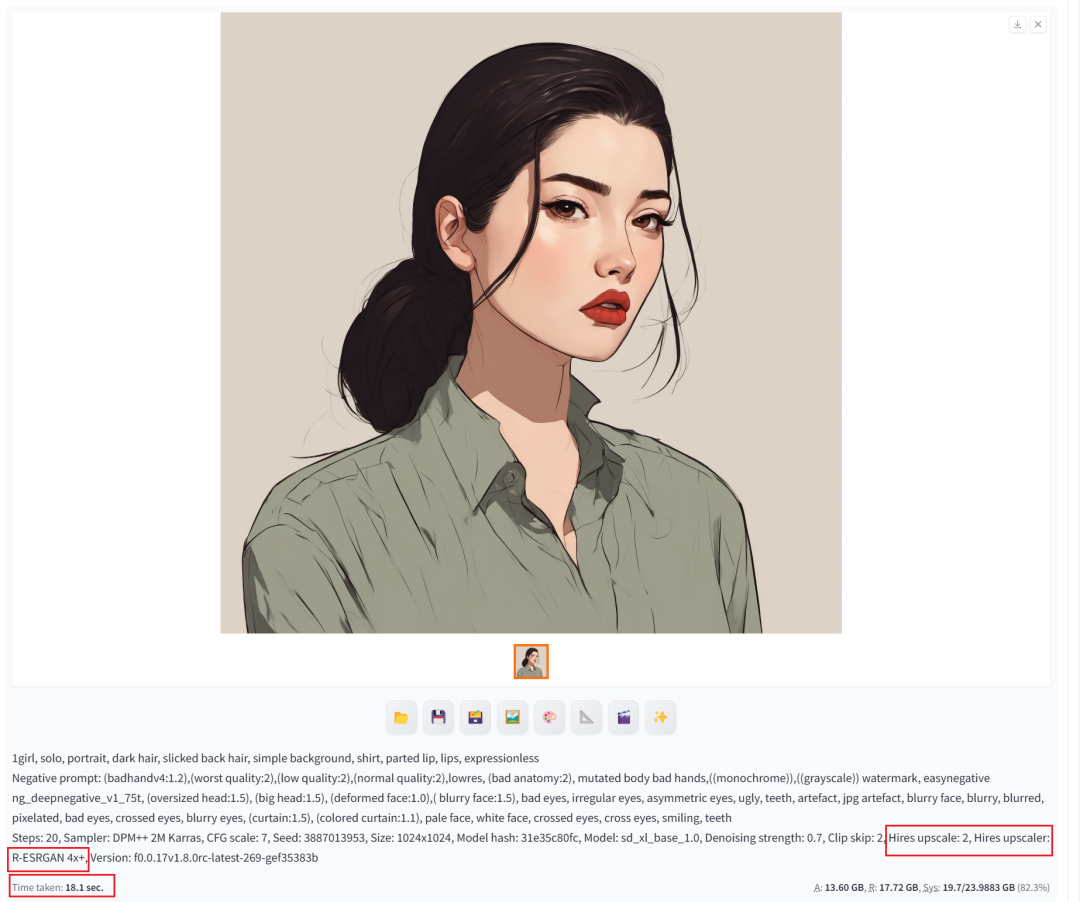

使用圖像擴大算法R-ESRGAN 4x+,擴大2X體驗。工具設置參數如下:

耗時18.1秒,平均13.6GB顯存使用,最高峰17.72GB,系統使用率82.3%。

forge主要是對顯存使用做了有效優化,對30系顯卡提升比較明顯,40系顯卡提升空間不大。但是有一些新增插件支持會很好,比如:sd-forge-layerdiffusio,以及官方feature列表中的Playground v2.5支持也是期待的功能。

繪圖體驗

1girl, solo, portrait, dark hair, slicked back hair, simple background, shirt, parted lip, lips, expressionless

感興趣的小伙伴,贈送全套AIGC學習資料,包含AI繪畫、AI人工智能等前沿科技教程和軟件工具,具體看這里。

AIGC技術的未來發展前景廣闊,隨著人工智能技術的不斷發展,AIGC技術也將不斷提高。未來,AIGC技術將在游戲和計算領域得到更廣泛的應用,使游戲和計算系統具有更高效、更智能、更靈活的特性。同時,AIGC技術也將與人工智能技術緊密結合,在更多的領域得到廣泛應用,對程序員來說影響至關重要。未來,AIGC技術將繼續得到提高,同時也將與人工智能技術緊密結合,在更多的領域得到廣泛應用。

?

一、AIGC所有方向的學習路線

AIGC所有方向的技術點做的整理,形成各個領域的知識點匯總,它的用處就在于,你可以按照下面的知識點去找對應的學習資源,保證自己學得較為全面。

二、AIGC必備工具

工具都幫大家整理好了,安裝就可直接上手!

三、最新AIGC學習筆記

當我學到一定基礎,有自己的理解能力的時候,會去閱讀一些前輩整理的書籍或者手寫的筆記資料,這些筆記詳細記載了他們對一些技術點的理解,這些理解是比較獨到,可以學到不一樣的思路。

四、AIGC視頻教程合集

觀看全面零基礎學習視頻,看視頻學習是最快捷也是最有效果的方式,跟著視頻中老師的思路,從基礎到深入,還是很容易入門的。

五、實戰案例

紙上得來終覺淺,要學會跟著視頻一起敲,要動手實操,才能將自己的所學運用到實際當中去,這時候可以搞點實戰案例來學習。

若有侵權,請聯系刪除

若有侵權,請聯系刪除

四十八 PCA主成分分析降維與圖像重建)

)

——while語句【互三互三】)

——匿名管道)

)

![[筆記.AI]AI Agent理解(LLM AI Agent)](http://pic.xiahunao.cn/[筆記.AI]AI Agent理解(LLM AI Agent))