LlaMA 3 系列博客

基于 LlaMA 3 + LangGraph 在windows本地部署大模型 (一)

基于 LlaMA 3 + LangGraph 在windows本地部署大模型 (二)

基于 LlaMA 3 + LangGraph 在windows本地部署大模型 (三)

基于 LlaMA 3 + LangGraph 在windows本地部署大模型 (四)

基于 LlaMA 3 + LangGraph 在windows本地部署大模型 (五)

基于 LlaMA 3 + LangGraph 在windows本地部署大模型 (六)

基于 LlaMA 3 + LangGraph 在windows本地部署大模型 (七)

基于 LlaMA 3 + LangGraph 在windows本地部署大模型 (八)

基于 LlaMA 3 + LangGraph 在windows本地部署大模型 (九)

基于 LlaMA 3 + LangGraph 在windows本地部署大模型 (十)

構建安全的GenAI/LLMs核心技術解密之大模型對抗攻擊(一)

構建安全的GenAI/LLMs核心技術解密之大模型對抗攻擊(二)

構建安全的GenAI/LLMs核心技術解密之大模型對抗攻擊(三)

構建安全的GenAI/LLMs核心技術解密之大模型對抗攻擊(四)

構建安全的GenAI/LLMs核心技術解密之大模型對抗攻擊(五)

你好 GPT-4o!

大模型標記器之Tokenizer可視化(GPT-4o)

大模型標記器 Tokenizer之Byte Pair Encoding (BPE) 算法詳解與示例

大模型標記器 Tokenizer之Byte Pair Encoding (BPE)源碼分析

大模型之自注意力機制Self-Attention(一)

大模型之自注意力機制Self-Attention(二)

大模型之自注意力機制Self-Attention(三)

基于 LlaMA 3 + LangGraph 在windows本地部署大模型 (十一)

Llama 3 模型家族構建安全可信賴企業級AI應用之 Code Llama (一)

Llama 3 模型家族構建安全可信賴企業級AI應用之 Code Llama (二)

Llama 3 模型家族構建安全可信賴企業級AI應用之 Code Llama (三)

Llama 3 模型家族構建安全可信賴企業級AI應用之 Code Llama (四)

Llama 3 模型家族構建安全可信賴企業級AI應用之 Code Llama (五)

Llama 3 模型家族構建安全可信賴企業級AI應用之使用 Llama Guard 保護大模型對話(一)

Llama 3 模型家族構建安全可信賴企業級AI應用之使用 Llama Guard 保護大模型對話(二)

Llama 3 模型家族構建安全可信賴企業級AI應用之使用 Llama Guard 保護大模型對話(三)

大模型之深入理解Transformer位置編碼(Positional Embedding)

大模型之深入理解Transformer Layer Normalization(一)

大模型之深入理解Transformer Layer Normalization(二)

大模型之深入理解Transformer Layer Normalization(三)

大模型之一步一步使用PyTorch編寫Meta的Llama 3代碼(一)初學者的起點

大模型之一步一步使用PyTorch編寫Meta的Llama 3代碼(二)矩陣操作的演練

大模型之一步一步使用PyTorch編寫Meta的Llama 3代碼(三)初始化一個嵌入層

大模型之一步一步使用PyTorch編寫Meta的Llama 3代碼(四)預先計算 RoPE 頻率

大模型之一步一步使用PyTorch編寫Meta的Llama 3代碼(五)預先計算因果掩碼

大模型之一步一步使用PyTorch編寫Meta的Llama 3代碼(六)首次歸一化:均方根歸一化(RMSNorm)

大模型之一步一步使用PyTorch編寫Meta的Llama 3代碼(七) 初始化多查詢注意力

大模型之一步一步使用PyTorch編寫Meta的Llama 3代碼(八)旋轉位置嵌入

大模型之一步一步使用PyTorch編寫Meta的Llama 3代碼(九) 計算自注意力

大模型之一步一步使用PyTorch編寫Meta的Llama 3代碼(十) 殘差連接及SwiGLU FFN

大模型之一步一步使用PyTorch編寫Meta的Llama 3代碼(十一)輸出概率分布 及損失函數計算

大模型之使用PyTorch編寫Meta的Llama 3實際功能代碼(一)加載簡化分詞器及設置參數

大模型之使用PyTorch編寫Meta的Llama 3實際功能代碼(二)RoPE 及注意力機制

大模型之使用PyTorch編寫Meta的Llama 3實際功能代碼(三) FeedForward 及 Residual Layers

大模型之使用PyTorch編寫Meta的Llama 3實際功能代碼(四) 構建 Llama3 類模型本身

大模型之使用PyTorch編寫Meta的Llama 3實際功能代碼(五)訓練并測試你自己的 minLlama3

大模型之使用PyTorch編寫Meta的Llama 3實際功能代碼(六)加載已經訓練好的miniLlama3模型

Llama 3 模型家族構建安全可信賴企業級AI應用之使用 Llama Guard 保護大模型對話 (四)

Llama 3 模型家族構建安全可信賴企業級AI應用之使用 Llama Guard 保護大模型對話 (五)

Llama 3 模型家族構建安全可信賴企業級AI應用之使用 Llama Guard 保護大模型對話 (六)

Llama 3 模型家族構建安全可信賴企業級AI應用之使用 Llama Guard 保護大模型對話 (七)

Llama 3 模型家族構建安全可信賴企業級AI應用之使用 Llama Guard 保護大模型對話 (八)

Llama 3 模型家族構建安全可信賴企業級AI應用之 CyberSecEval 2:量化 LLM 安全和能力的基準(一)

Llama 3 模型家族構建安全可信賴企業級AI應用之 CyberSecEval 2:量化 LLM 安全和能力的基準(二)

Llama 3 模型家族構建安全可信賴企業級AI應用之 CyberSecEval 2:量化 LLM 安全和能力的基準(三)

Llama 3 模型家族構建安全可信賴企業級AI應用之 CyberSecEval 2:量化 LLM 安全和能力的基準(四)

Llama 3 模型家族構建安全可信賴企業級AI應用之code shield(一)Code Shield簡介

Llama 3 模型家族構建安全可信賴企業級AI應用之code shield(二)防止 LLM 生成不安全代碼

Llama 3 模型家族構建安全可信賴企業級AI應用之code shield(三)Code Shield代碼示例

Llama模型家族之使用 Supervised Fine-Tuning(SFT)微調預訓練Llama 3 語言模型(一) LLaMA-Factory簡介

Llama模型家族之使用 Supervised Fine-Tuning(SFT)微調預訓練Llama 3 語言模型(二) LLaMA-Factory訓練方法及數據集

大模型之Ollama:在本地機器上釋放大型語言模型的強大功能

Llama模型家族之使用 Supervised Fine-Tuning(SFT)微調預訓練Llama 3 語言模型(三)通過Web UI微調

Llama模型家族之使用 Supervised Fine-Tuning(SFT)微調預訓練Llama 3 語言模型(四)通過命令方式微調

Llama模型家族之使用 Supervised Fine-Tuning(SFT)微調預訓練Llama 3 語言模型(五) 基于已訓練好的模型進行推理

Llama模型家族之使用 Supervised Fine-Tuning(SFT)微調預訓練Llama 3 語言模型(六)Llama 3 已訓練的大模型合并LoRA權重參數

Llama模型家族之使用 Supervised Fine-Tuning(SFT)微調預訓練Llama 3 語言模型(七) 使用 LoRA 微調 LLM 的實用技巧

Llama模型家族之使用 Supervised Fine-Tuning(SFT)微調預訓練Llama 3 語言模型(八) 使用 LoRA 微調 LLM 的實用技巧

Llama模型家族之使用 Supervised Fine-Tuning(SFT)微調預訓練Llama 3 語言模型(九) 使用 LoRA 微調常見問題答疑

Llama模型家族之使用 Supervised Fine-Tuning(SFT)微調預訓練Llama 3 語言模型(十) 使用 LoRA 微調常見問題答疑

Llama模型家族訓練獎勵模型Reward Model技術及代碼實戰(一)簡介

Llama模型家族訓練獎勵模型Reward Model技術及代碼實戰(二)從用戶反饋構建比較數據集

Llama模型家族訓練獎勵模型Reward Model技術及代碼實戰(三) 使用 TRL 訓練獎勵模型

Llama模型家族之RLAIF 基于 AI 反饋的強化學習(一)RLHF簡介

Llama模型家族之RLAIF 基于 AI 反饋的強化學習(二)RLHF 與RAIF比較

Llama模型家族之RLAIF 基于 AI 反饋的強化學習(三) RLAIF 的工作原理

Llama模型家族之RLAIF 基于 AI 反饋的強化學習(四)RLAIF 優勢

Llama模型家族之RLAIF 基于 AI 反饋的強化學習(五)RLAIF 挑戰

Llama模型家族之RLAIF 基于 AI 反饋的強化學習(六) RLAIF 代碼實戰

Llama模型家族之RLAIF 基于 AI 反饋的強化學習(七) RLAIF 代碼實戰

Llama模型家族之RLAIF 基于 AI 反饋的強化學習(八) RLAIF 代碼實戰

Llama模型家族之RLAIF 基于 AI 反饋的強化學習(九) RLAIF 代碼實戰

Llama模型家族之RLAIF 基于 AI 反饋的強化學習(十) RLAIF 代碼實戰

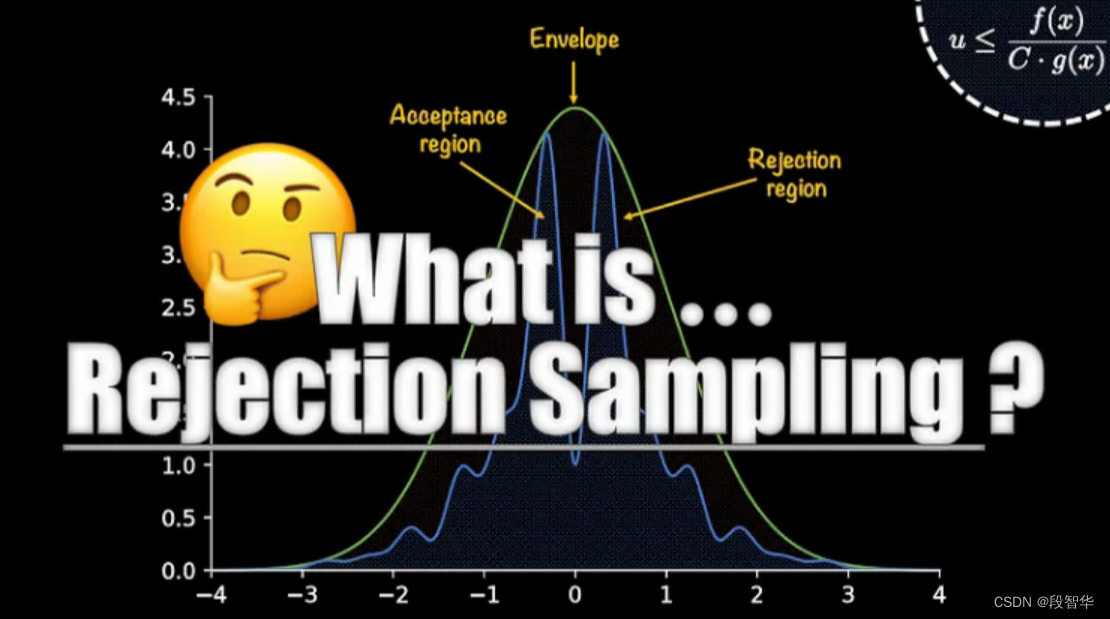

Llama模型家族之拒絕抽樣(Rejection Sampling)(一)

Llama模型家族之拒絕抽樣(Rejection Sampling)(二)

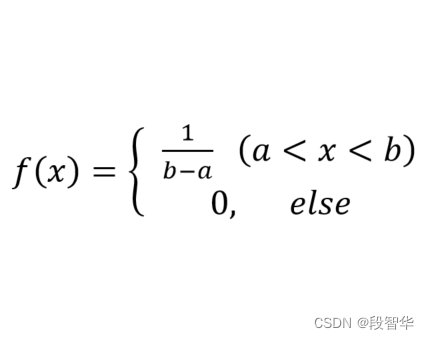

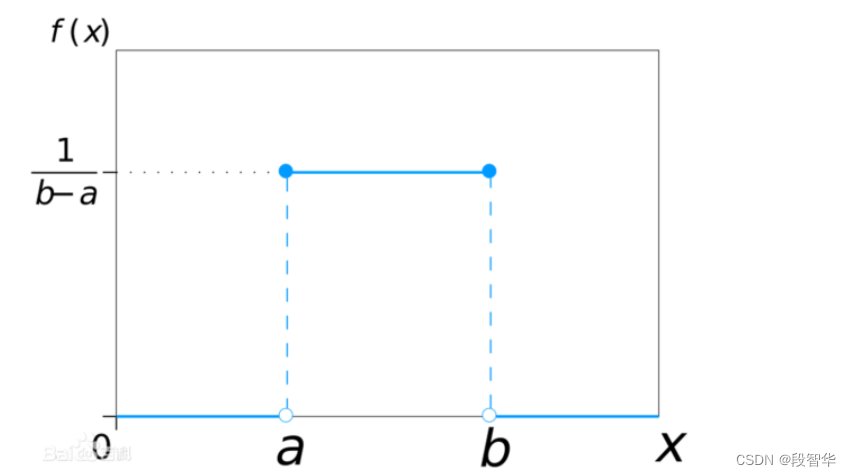

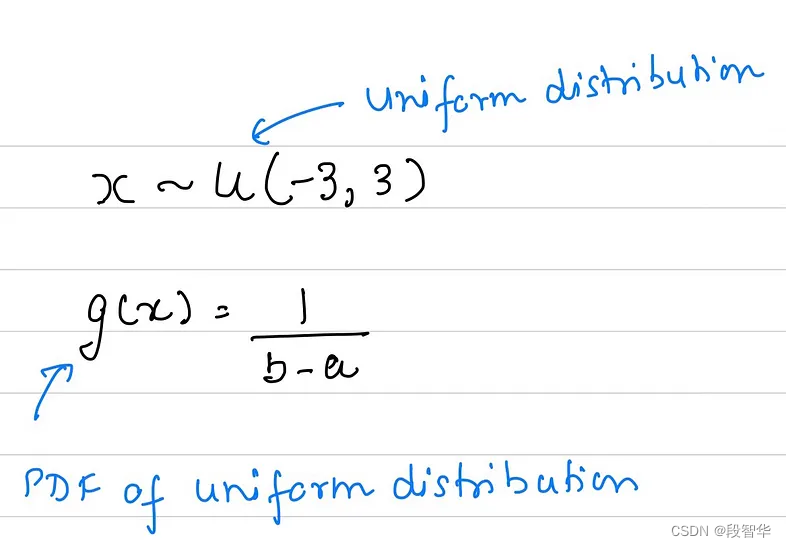

均勻分布(Uniform Distribution)

均勻分布在等長區間上的取值概率是相同的。

概率密度函數及概率分布圖如下所示:

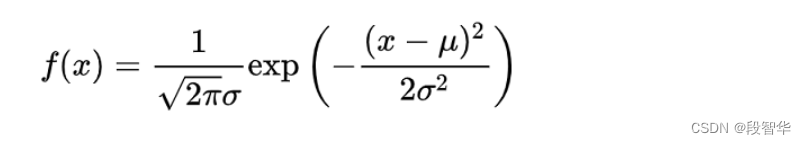

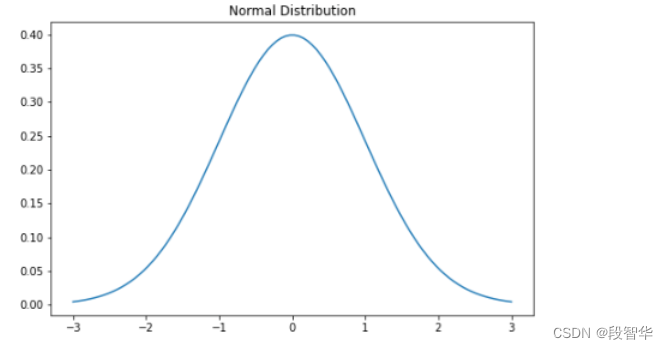

正態分布(Normal Distribution)

正態分布數學期望為 μ,標準差為 σ,記做 N (μ, σ2)。

數學期望為 0、標準差為 1 的正態分布稱為標準正態分布。

正態分布曲線呈鐘型,兩邊低,中間高,左右對稱。

正態分布概率密度函數及分布圖如下所示:

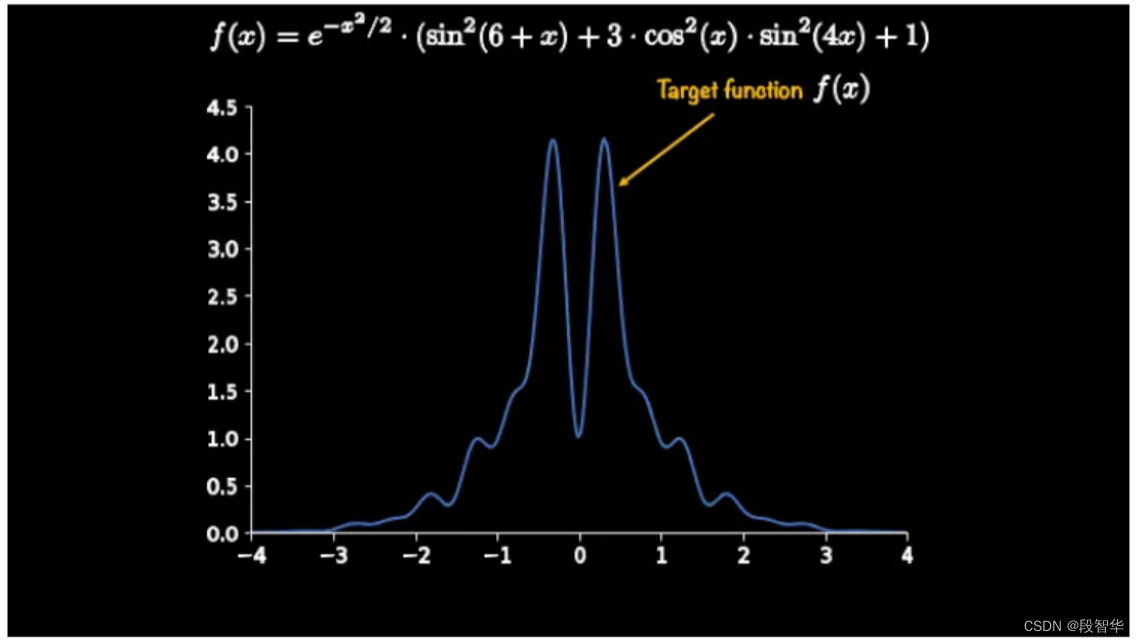

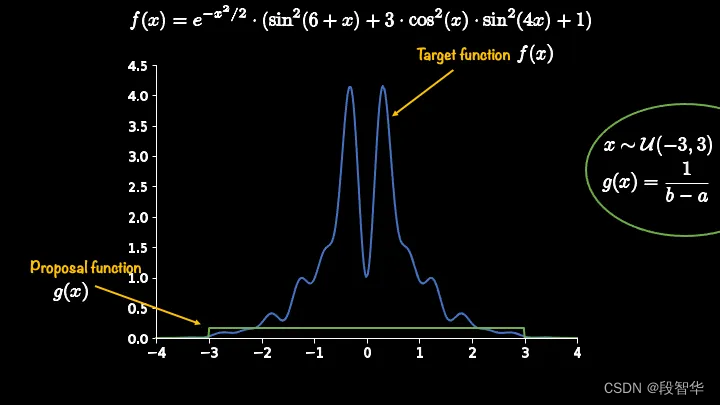

考慮一個 無法采樣的目標分布函數。

這是一個一維目標函數,我們的任務是獲取介于 -3 和 3 之間的樣本。提議函數的一個選擇是均勻分布函數。下面顯示了它的函數形式,即 g(x)。

如果采用這個提議函數并將其與 目標函數一起繪制,那么它將看起來像這樣:

如你所見,目前 建議函數并沒有完全封裝 目標函數。一旦 制定了糾正措施(或驗收標準),這種封裝的意義就會變得清晰起來。

大模型技術分享

《企業級生成式人工智能LLM大模型技術、算法及案例實戰》線上高級研修講座

模塊一:Generative AI 原理本質、技術內核及工程實踐周期詳解

模塊二:工業級 Prompting 技術內幕及端到端的基于LLM 的會議助理實戰

模塊三:三大 Llama 2 模型詳解及實戰構建安全可靠的智能對話系統

模塊四:生產環境下 GenAI/LLMs 的五大核心問題及構建健壯的應用實戰

模塊五:大模型應用開發技術:Agentic-based 應用技術及案例實戰

模塊六:LLM 大模型微調及模型 Quantization 技術及案例實戰

模塊七:大模型高效微調 PEFT 算法、技術、流程及代碼實戰進階

模塊八:LLM 模型對齊技術、流程及進行文本Toxicity 分析實戰

模塊九:構建安全的 GenAI/LLMs 核心技術Red Teaming 解密實戰

模塊十:構建可信賴的企業私有安全大模型Responsible AI 實戰

Llama3關鍵技術深度解析與構建Responsible AI、算法及開發落地實戰

1、Llama開源模型家族大模型技術、工具和多模態詳解:學員將深入了解Meta Llama 3的創新之處,比如其在語言模型技術上的突破,并學習到如何在Llama 3中構建trust and safety AI。他們將詳細了解Llama 3的五大技術分支及工具,以及如何在AWS上實戰Llama指令微調的案例。

2、解密Llama 3 Foundation Model模型結構特色技術及代碼實現:深入了解Llama 3中的各種技術,比如Tiktokenizer、KV Cache、Grouped Multi-Query Attention等。通過項目二逐行剖析Llama 3的源碼,加深對技術的理解。

3、解密Llama 3 Foundation Model模型結構核心技術及代碼實現:SwiGLU Activation Function、FeedForward Block、Encoder Block等。通過項目三學習Llama 3的推理及Inferencing代碼,加強對技術的實踐理解。

4、基于LangGraph on Llama 3構建Responsible AI實戰體驗:通過項目四在Llama 3上實戰基于LangGraph的Responsible AI項目。他們將了解到LangGraph的三大核心組件、運行機制和流程步驟,從而加強對Responsible AI的實踐能力。

5、Llama模型家族構建技術構建安全可信賴企業級AI應用內幕詳解:深入了解構建安全可靠的企業級AI應用所需的關鍵技術,比如Code Llama、Llama Guard等。項目五實戰構建安全可靠的對話智能項目升級版,加強對安全性的實踐理解。

6、Llama模型家族Fine-tuning技術與算法實戰:學員將學習Fine-tuning技術與算法,比如Supervised Fine-Tuning(SFT)、Reward Model技術、PPO算法、DPO算法等。項目六動手實現PPO及DPO算法,加強對算法的理解和應用能力。

7、Llama模型家族基于AI反饋的強化學習技術解密:深入學習Llama模型家族基于AI反饋的強化學習技術,比如RLAIF和RLHF。項目七實戰基于RLAIF的Constitutional AI。

8、Llama 3中的DPO原理、算法、組件及具體實現及算法進階:學習Llama 3中結合使用PPO和DPO算法,剖析DPO的原理和工作機制,詳細解析DPO中的關鍵算法組件,并通過綜合項目八從零開始動手實現和測試DPO算法,同時課程將解密DPO進階技術Iterative DPO及IPO算法。

9、Llama模型家族Safety設計與實現:在這個模塊中,學員將學習Llama模型家族的Safety設計與實現,比如Safety in Pretraining、Safety Fine-Tuning等。構建安全可靠的GenAI/LLMs項目開發。

10、Llama 3構建可信賴的企業私有安全大模型Responsible AI系統:構建可信賴的企業私有安全大模型Responsible AI系統,掌握Llama 3的Constitutional AI、Red Teaming。

解碼Sora架構、技術及應用

一、為何Sora通往AGI道路的里程碑?

1,探索從大規模語言模型(LLM)到大規模視覺模型(LVM)的關鍵轉變,揭示其在實現通用人工智能(AGI)中的作用。

2,展示Visual Data和Text Data結合的成功案例,解析Sora在此過程中扮演的關鍵角色。

3,詳細介紹Sora如何依據文本指令生成具有三維一致性(3D consistency)的視頻內容。 4,解析Sora如何根據圖像或視頻生成高保真內容的技術路徑。

5,探討Sora在不同應用場景中的實踐價值及其面臨的挑戰和局限性。

二、解碼Sora架構原理

1,DiT (Diffusion Transformer)架構詳解

2,DiT是如何幫助Sora實現Consistent、Realistic、Imaginative視頻內容的?

3,探討為何選用Transformer作為Diffusion的核心網絡,而非技術如U-Net。

4,DiT的Patchification原理及流程,揭示其在處理視頻和圖像數據中的重要性。

5,Conditional Diffusion過程詳解,及其在內容生成過程中的作用。

三、解碼Sora關鍵技術解密

1,Sora如何利用Transformer和Diffusion技術理解物體間的互動,及其對模擬復雜互動場景的重要性。

2,為何說Space-time patches是Sora技術的核心,及其對視頻生成能力的提升作用。

3,Spacetime latent patches詳解,探討其在視頻壓縮和生成中的關鍵角色。

4,Sora Simulator如何利用Space-time patches構建digital和physical世界,及其對模擬真實世界變化的能力。

5,Sora如何實現faithfully按照用戶輸入文本而生成內容,探討背后的技術與創新。

6,Sora為何依據abstract concept而不是依據具體的pixels進行內容生成,及其對模型生成質量與多樣性的影響。

)

【應用啟動框架AppStartup】)