近年來,生成性AI技術在眾多領域取得了前所未有的進步。大規模預訓練模型的出現激發了各種下游任務中的新應用。這在文本到圖像生成領域尤為明顯,例如Stable Diffusion、DALL-E 2和Imagen等模型已經顯著展示了它們的能力。盡管如此,復雜提示中包含多個實體和復雜屬性時會出現挑戰。生成的圖像質量下降,導致實體泄露和屬性不對齊等問題。目前,大多數最先進模型使用預訓練的語言模型對提示進行編碼,然后將文本嵌入集成到注意力模塊中,其中高斯噪聲擴散到最終生成的圖像中。然而,最近的研究已經確定,與次優生成圖像相關的許多問題與注意力機制的缺陷密切相關。

擴散模型在各種內容生成領域取得了顯著的成功,其核心概念是通過輸入提示引導的擴散過程,在潛在空間中從噪聲迭代重建圖像。現有的基于擴散的圖像生成模型在大規模數據集上訓練,并且與以前的方法相比,性能有了顯著提高。然而,在處理復雜輸入提示時,這些生成模型的保真度往往無法得到保證。最近,基于擴散的文本到視頻模型Sora被公布,展示了在生成高保真度、長時間、高分辨率視頻方面的強能力。實驗結果在各種對齊場景中表明此模型以最小的額外計算成本實現了更好的圖像-文本對齊。

方法

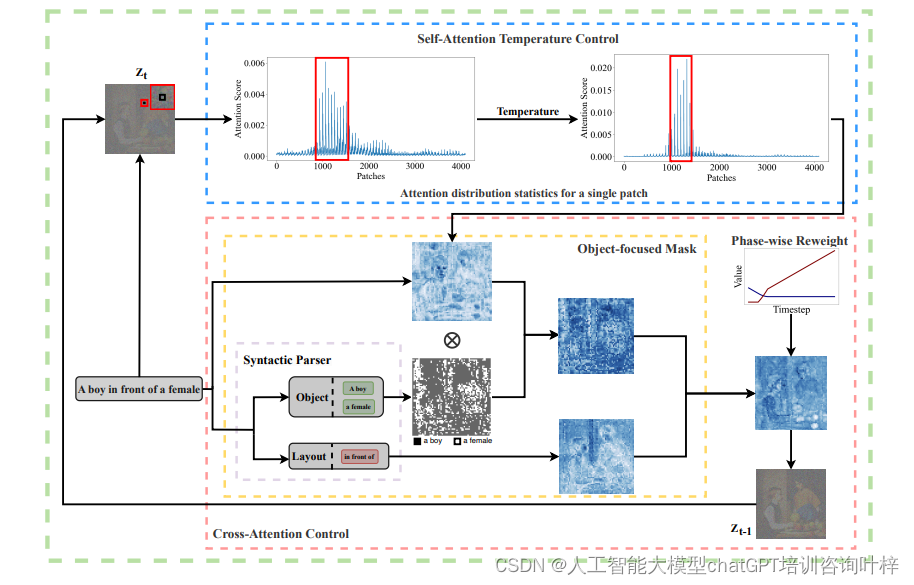

研究團隊提出了一種創新的注意力控制機制,旨在改善文本到圖像生成任務中的實體對齊和屬性分配問題。這種方法不需要額外的訓練過程,通過調整自注意力和交叉注意力模塊來實現對生成模型的精細控制。

自注意力溫度控制

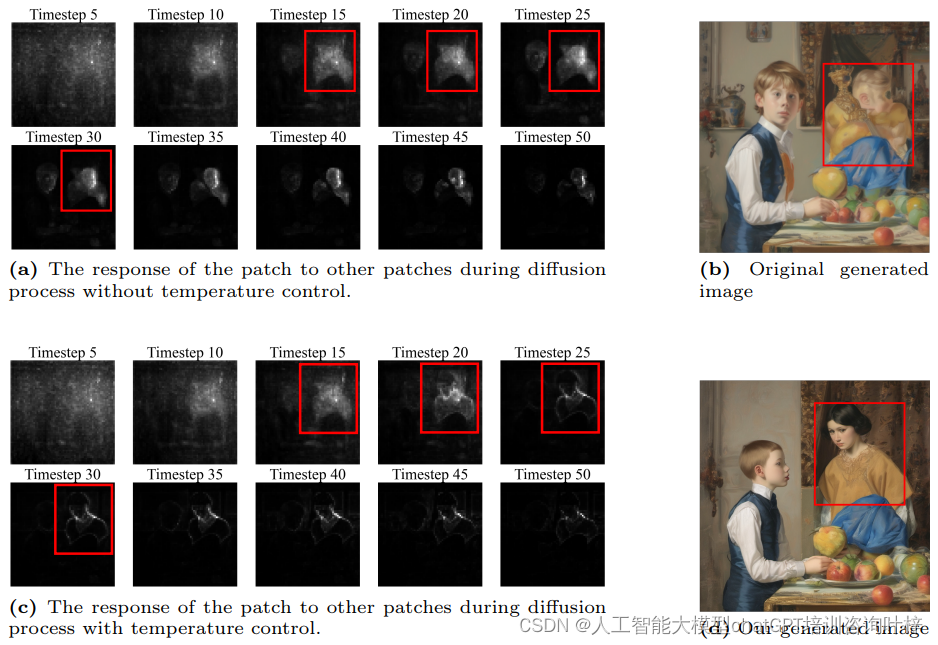

自注意力溫度控制是一種調整模型在生成圖像時如何分配注意力的機制。在文本到圖像的生成任務中,自注意力層允許模型的每個部分(或稱為補丁)評估與其他部分的關系,從而確定在生成圖像時如何相互影響。然而,如果沒有適當的控制,補丁可能會對周圍較大區域內的其他補丁產生高響應值,這可能導致生成的圖像中對象的邊界不清晰或對象特征混淆。

在圖2中,自注意力溫度控制的效果通過對比展示了。在沒有溫度控制的情況下(圖2a),一個特定的補丁可能對多個其他補丁有較高的注意力值,這在自注意力圖中表現為一個較廣泛的高響應區域。這種廣泛的注意力分布可能導致模型在生成圖像時無法精確區分各個實體,比如無法明確區分“一個男孩”和“一個女孩”的邊界,導致圖像中出現實體融合或特征錯誤。

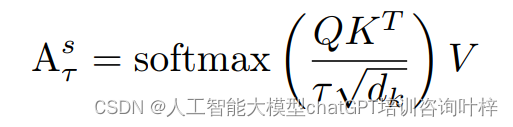

為了解決這個問題,研究者引入了溫度控制機制(如圖2c所示)。通過調整一個超參數τ,即溫度,改變了自注意力層中softmax函數的尺度。溫度控制的數學表達式如下:

通過這種溫度操作,增強了相關性較強的補丁之間的高注意力值,同時抑制了不相關補丁之間的低注意力值。這使得每個補丁能夠與高度相關的補丁組合在一起,從而產生更加真實的輪廓。在圖2c中,應用溫度控制后,補丁只與周圍較小區域內的補丁相對應,這有助于在最終生成的圖像中構建正確的輪廓。需要注意的是,由于自注意力控制直接改變了補丁之間的關系,這種控制必須是精確和適度的;否則,它可能會影響到最終圖像的整體內容。溫度操作應用于擴散模型自注意力層的早期生成階段。

對象聚焦的掩蔽機制

接下來,引入了一種對象聚焦的掩蔽機制來解決屬性不對齊的問題。對象聚焦的掩蔽機制是為了提高文本到圖像生成任務的準確性而設計的一種創新方法。這種方法特別針對于解決當文本提示中包含多個不同對象時,模型在生成圖像的過程中可能出現的對象邊界不清晰或對象特征混淆的問題。

在傳統的生成模型中,由于補丁之間的注意力分布可能過于分散,導致生成的圖像無法準確反映文本提示中的各個獨立對象及其屬性。為了克服這一難題,研究團隊采用了句法解析技術來分析文本提示,識別出其中的所有實體和屬性。這一步驟是基礎,因為它幫助理解了文本提示的結構和語義內容。

基于句法解析的結果,研究團隊為圖像中的每個補丁指定了最有可能對應的實體組。在生成過程中,研究團隊為每個補丁創建了一個掩蔽,這個掩蔽確保補丁只關注與它指定的實體組相關的信息。這意味著,如果一個補丁通過句法分析被確定與“一個男孩”這一實體相關,那么在生成過程中,這個補丁的注意力將主要集中于與“一個男孩”相關的特征,而不是其他不相關的對象或屬性。

通過這種方式,研究團隊有效地過濾了補丁需要處理的信息,減少了無關信息的干擾。這不僅提高了對象的邊界清晰度,還減少了屬性錯誤分配的風險。例如,如果文本提示中提到“一個戴帽子的年輕男孩”,我們的掩蔽機制將確保與“年輕男孩”相關的補丁不會錯誤地生成與“帽子”無關的特征,比如將帽子錯誤地分配給圖像中的其他對象。

掩蔽機制還考慮了全局信息,如圖像的布局和動作等。這意味著即使在關注特定實體的同時,模型也能夠保持對整體場景的一致性和連貫性,從而生成結構合理、符合文本描述的圖像。

對象聚焦的掩蔽機制通過精確控制補丁的注意力焦點,顯著提升了模型對文本提示中多個對象和屬性的處理能力,從而在生成圖像時實現了更高的準確性和真實性。這種方法在處理復雜提示時尤其有效,能夠生成更加細致和符合預期的圖像結果。

階段性動態重新加權機制

階段性動態重新加權機制是為了進一步提升文本到圖像生成任務中屬性對齊的準確性而設計的一種策略。這種機制的核心思想是,在圖像生成過程的不同階段,模型應該關注不同類型的信息:在早期階段關注全局信息,如整體布局;而在中后期則逐漸轉移到對象的具體細節。

在擴散模型的早期階段,圖像的大體結構和布局是首先需要確定的。隨著生成過程的進行,模型需要逐漸細化這些結構,填充具體的對象特征。為了適應這種階段性的信息關注需求,研究團隊設計了兩種權重控制曲線:一種針對全局信息,另一種針對實例細節。

全局信息的權重控制曲線會隨著時間步的增加而逐漸減小。這意味著在生成過程的早期,模型會更加關注文本提示中的全局信息,如場景的布局和整體結構。隨著時間的推進,這種關注會逐漸減弱,為對象細節的生成讓出空間。

相對地,實例細節的權重控制曲線則隨著時間步的增加而逐漸增大。這確保了在生成過程的中后期,模型會更多地關注文本提示中的具體對象和它們的屬性,如顏色、形狀和大小等。這種權重的增加幫助模型在圖像的細節層面上實現更高的準確性和豐富性。

通過這種動態的權重調整,模型能夠在正確的時間關注正確的信息,從而在生成的圖像中實現更好的實體和背景區分。這種機制使得生成的圖像不僅在宏觀上結構合理,也在微觀上細節豐富,更貼近文本提示的描述。

在實際應用中,這種階段性動態重新加權機制可以通過調整自注意力和交叉注意力層中的權重來實現。通過精心設計的權重控制曲線,模型在生成過程中的每一步都能夠適應性地調整其關注焦點,確保生成的圖像在不同階段都能夠與文本提示保持高度一致。

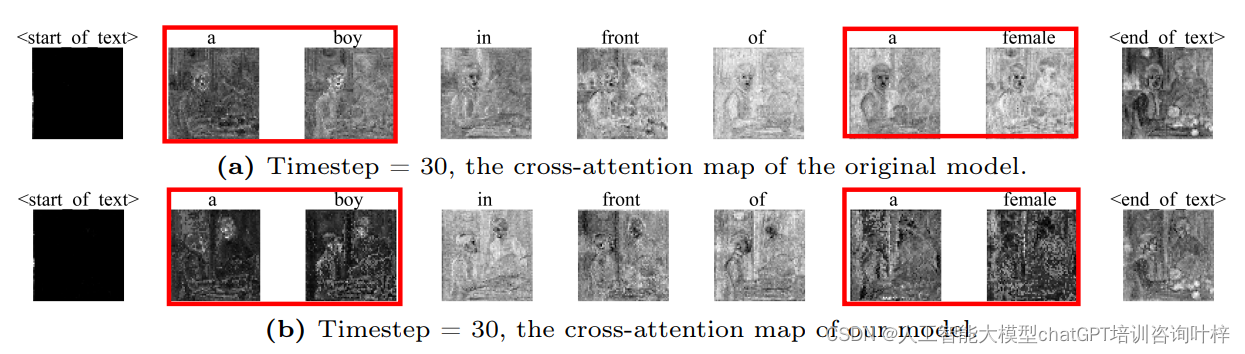

Fig. 3比較了原始模型與創新方法在時間步30時的交叉注意力圖。給定的文本提示是“一個男孩在一個女孩前面”,通過這個例子,我們可以直觀地看到兩種方法在處理對象對齊方面的差異。

在原始模型中,擴散過程中的交叉注意力圖,其中某些token(例如“男孩”和“女孩”)的語義信息在整個圖像中擴散。這種擴散可能導致生成的圖像中對象的界限模糊,對象特征混淆,最終導致對齊效果差。例如,如果“女孩”的語義信息擴散到了整個圖像,模型可能無法確定女孩的具體位置,導致生成的圖像中女孩的形象不清晰或者與背景或其他對象混合。

相比之下,對象聚焦掩蔽機制和階段性動態重新加權機制后的交叉注意力圖與實體相對應的token信息變得更加集中。這意味著每個對象的語義信息被更精確地定位在圖像中的相應區域,從而改善了對象的對齊和整體圖像的生成質量。

通過對象聚焦掩蔽機制,確保了每個補丁主要關注與它最相關的實體組,減少了與其他對象的無關信息的干擾。階段性動態重新加權機制進一步確保了在生成過程的不同階段,模型能夠適當地關注全局信息和細節信息。在早期階段,模型可能更關注于整體布局,而在后期階段,則更多地關注于對象的具體特征。

實驗

本研究中采用了無需訓練的注意力控制機制,旨在改善文本到圖像生成任務中的實體泄露和屬性不對齊問題。使用了COCO2014驗證集作為評估數據,并選取了最新的Stable Diffusion XL 1.0作為基線模型,與本模型進行比較。

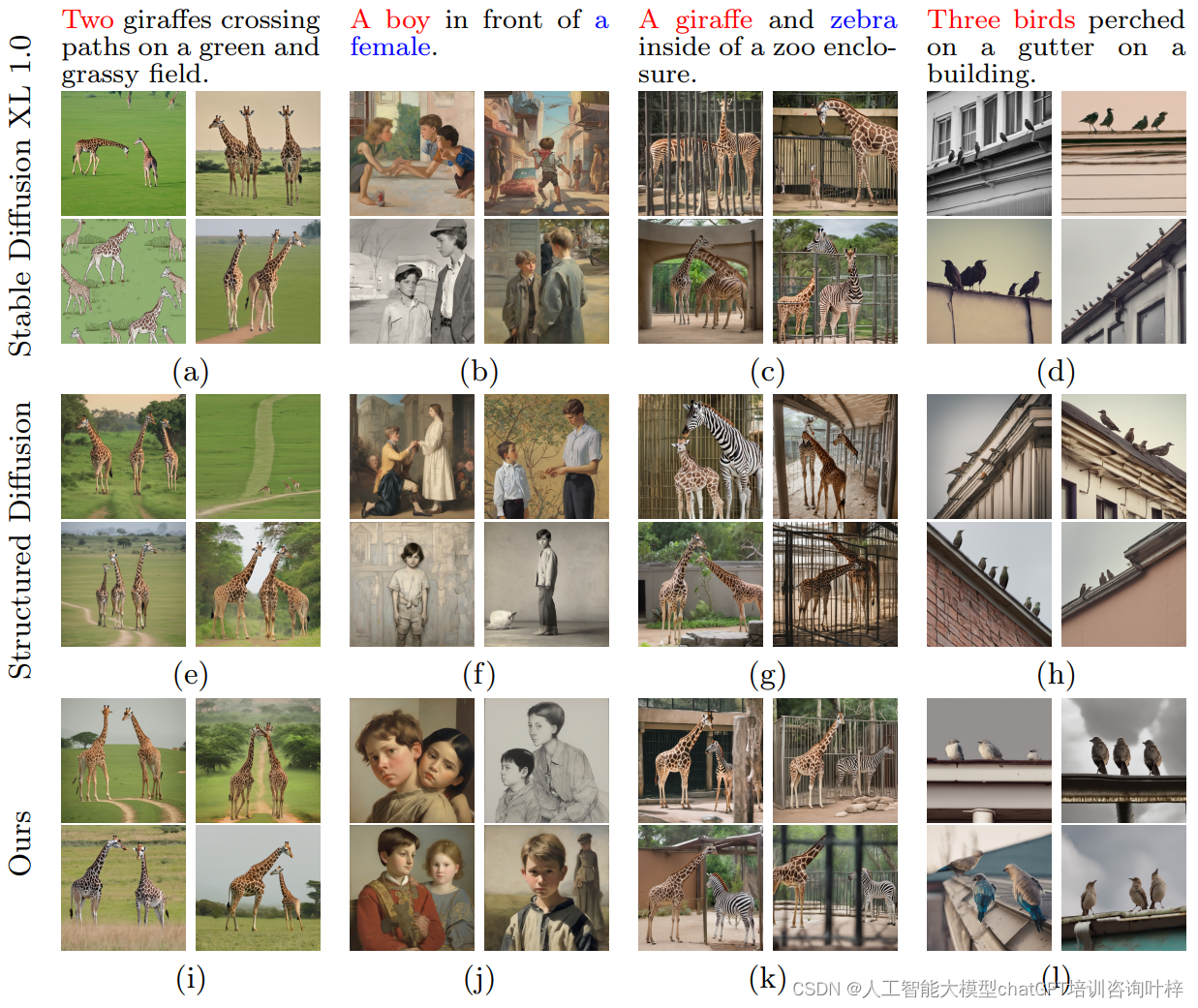

定性分析?通過視覺檢查生成圖像與文本提示的對齊程度。如圖5所示,展示了Stable Diffusion、Structured Diffusion以及創新方法的生成結果。可以觀察到,現有模型在處理涉及多個對象和屬性的復雜提示時仍然存在挑戰。例如,在數字對齊方面,現有模型常常無法準確復現提示中指定的數量,如在圖5的第一和第四列中,與提示相比,生成的長頸鹿和鳥的數量明顯過多。而本方法能夠減少這類數值錯誤的發生,如圖5的(i)(l)所示。

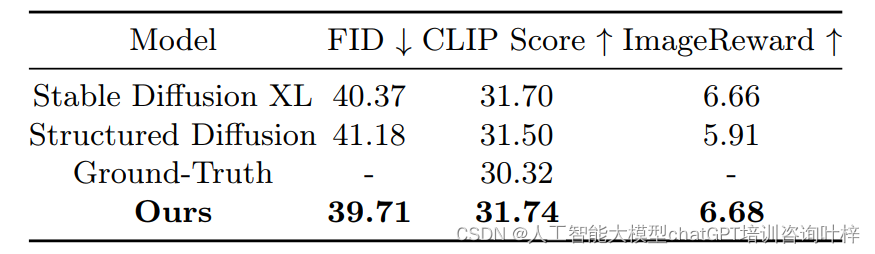

定量分析?使用FID(Fréchet Inception Distance)、CLIP Score和ImageReward等指標來評估生成圖像的質量。FID用于衡量生成圖像與真實圖像之間的分布差異,CLIP Score基于CLIP模型評估圖像與文本的一致性,而ImageReward則是學習并評估人類對生成圖像的偏好。實驗結果表明,本模型在這些指標上都取得了更好的成績,表明生成的圖像與輸入提示的對齊度更高,圖像質量也更優。

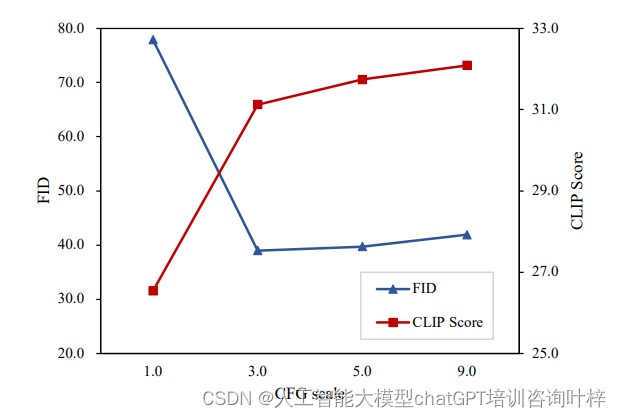

在Fig. 6中,我們可以看到隨著CFG規模的增加,FID和CLIP分數如何變化。FID分數衡量的是生成圖像與真實圖像分布之間的差異,而CLIP分數則衡量生成圖像與輸入文本提示的一致性。理想情況下,我們希望FID分數越低越好,CLIP分數越高越好,這表示生成圖像不僅與真實圖像相似,而且與輸入的文本提示也高度一致。

Table 1提供了創新方法與現有方法在定量評估上的比較結果,包括FID、CLIP Score和ImageReward三個指標。本方法在這些指標上與Stable Diffusion XL和Structured Diffusion進行了對比,這些指標共同衡量了生成圖像的質量與輸入文本提示的對齊程度。

具體來說,FID分數衡量生成圖像與真實圖像集合之間的分布差異,分數越低表示生成圖像與真實圖像越相似。CLIP Score評估生成圖像與文本描述的匹配度,分數越高表示匹配度越好。ImageReward則是基于人類偏好的學習評估指標。

在Table 1中,我們可以看到,與Stable Diffusion XL和Structured Diffusion相比,本方法在FID分數上略高,但與真實圖像(Ground-Truth)相比仍具有競爭力,這表明本模型在圖像質量上有所提升。在CLIP Score上,本方法與Stable Diffusion XL得分相近,均高于Structured Diffusion,顯示出在圖像與文本對齊方面的優勢。這些結果證明了本方法在改善文本到圖像生成任務中的有效性,尤其是在提升圖像質量和文本對齊方面。

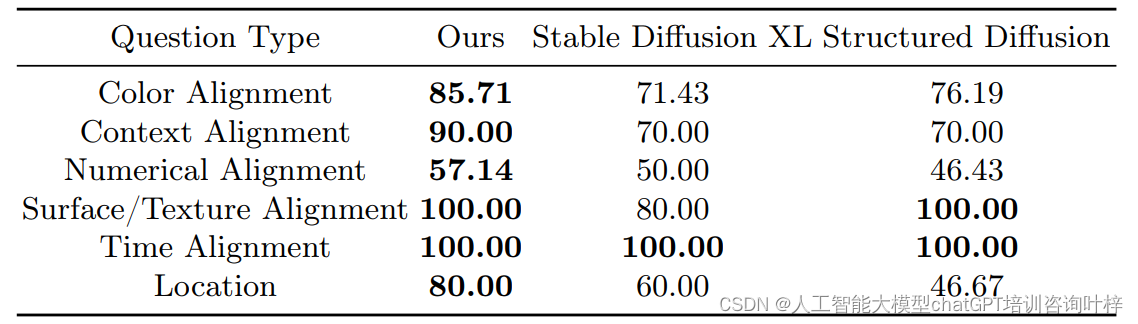

半人工評估 除了定量指標,還設計了半人工評估來更細致地考察模型在特定對齊任務上的表現。隨機選取了50個提示,并使用基線模型和我們的模型生成圖像。然后,利用GPT-4生成與這些圖像相關的一系列問題,從不同角度評估圖像的對齊性能,包括顏色、內容、數量、表面/紋理、時間和位置對齊。通過人工檢查這些問題,發現本模型在所有對齊任務上都取得了優于基線模型的結果。

Table 2在論文中展示了半人工評估的結果,這些結果是基于GPT-4生成的問題對不同模型生成的圖像進行評估的準確性。在這個表中,研究人員手動檢查并修訂了基于GPT-4答案的比較結果,以確定每種模型在各種對齊任務上的表現。

具體來說,Table 2列出了以下幾種類型的對齊任務,并為每種任務提供了不同模型的性能百分比(準確率):

- 顏色對齊(Color Alignment):評估圖像中指定對象的顏色是否與文本提示中的顏色準確生成。

- 內容對齊(Context Alignment):檢查圖像中的場景、對象和角色動作是否與文本提示一致。

- 數量對齊(Numerical Alignment):驗證圖像是否準確地表示了文本提示中指定的不同對象的數量。

- 表面/紋理對齊(Surface/Texture Alignment):判斷生成的對象是否具有與文本提示描述一致的紋理。

- 時間對齊(Time Alignment):確認圖像中呈現的環境時間是否與文本提示中描述的時間相匹配。

- 位置對齊(Location):評估圖像中生成的環境設置和空間關系是否與文本提示一致。

表中列出了幾種模型的名稱,包括基線模型(如Stable Diffusion XL和Structured Diffusion)和本模型(即采用新提出的注意力控制機制的模型)。每種模型在上述任務上的表現會以百分比形式展示,百分比越高,表示模型在該對齊任務上的準確率越高,生成的圖像與文本提示的一致性越好。

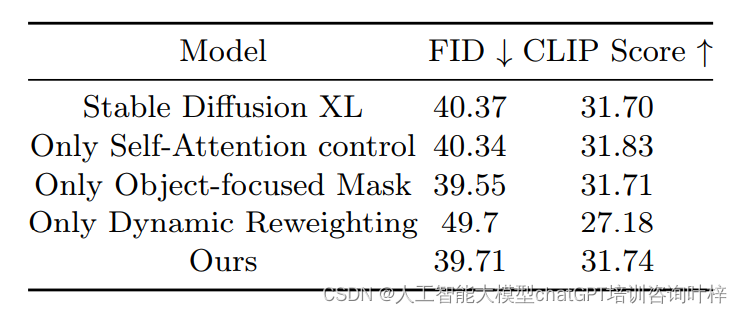

消融研究 ?通過消融研究深入探討了自注意力控制策略、對象聚焦掩蔽機制和動態重新加權策略這三種組件對模型性能的影響。

研究團隊首先單獨測試了自注意力控制策略。這一策略通過調整自注意力層中的溫度參數,優化了補丁間的注意力分布。結果顯示,即使只使用這一策略,模型的FID和CLIP Score也比基線模型有所改善,這表明自注意力控制在提升圖像質量和文本對齊方面起到了積極作用。

接著,單獨評估了對象聚焦掩蔽機制。這一機制通過句法解析確定文本提示中的實體,并為每個補丁創建掩蔽,以集中注意力于相關實體。消融研究的結果顯示,對象聚焦掩蔽機制同樣在單獨使用時提升了模型性能,減少了屬性不對齊和實體泄露的問題。

當單獨應用動態重新加權策略時,效果并不理想。動態重新加權策略根據生成過程的不同階段調整不同語義組成部分的權重。在沒有掩蔽機制配合的情況下,這一策略可能會無意中增強了不必要的注意力分布,導致生成效果不佳。

當將這三個組件結合起來使用時,模型的性能得到了顯著提升。這表明這些組件之間存在互補關系,通過協同作用,能夠有效地提升模型的整體性能。結合使用時,自注意力控制和對象聚焦掩蔽機制能夠確保注意力的準確分配,而動態重新加權策略則在這一基礎上進一步優化了不同階段的注意力重點。

以上表格展示了不同配置下的FID和CLIP Score,清晰地呈現了每種組件以及它們組合使用時對模型性能的具體影響。

結論

在本文中,我們提出了一種無需訓練的階段性注意力控制機制。我們在自注意力模塊中集成了新穎的溫度控制,并在交叉注意力模塊中進行了階段特定的掩蔽控制。這些注意力控制使模型能夠更有效地將圖像補丁塑造成連貫的對象,并顯著緩解實體融合和不對齊的問題。在我們的實驗中,我們使用現有的基準指標和針對不同對齊場景量身定制的半人工評估來評估我們的模型。實驗結果證明了我們的模型在對齊聚焦的圖像生成任務中的魯棒性和有效性。

![appium篇-windows桌面自動化(一)[環境配置]](http://pic.xiahunao.cn/appium篇-windows桌面自動化(一)[環境配置])

)

函數)

安裝 Docker)

)