LlaMA 3 系列博客

基于 LlaMA 3 + LangGraph 在windows本地部署大模型 (一)

基于 LlaMA 3 + LangGraph 在windows本地部署大模型 (二)

基于 LlaMA 3 + LangGraph 在windows本地部署大模型 (三)

基于 LlaMA 3 + LangGraph 在windows本地部署大模型 (四)

基于 LlaMA 3 + LangGraph 在windows本地部署大模型 (五)

基于 LlaMA 3 + LangGraph 在windows本地部署大模型 (六)

基于 LlaMA 3 + LangGraph 在windows本地部署大模型 (七)

基于 LlaMA 3 + LangGraph 在windows本地部署大模型 (八)

基于 LlaMA 3 + LangGraph 在windows本地部署大模型 (九)

基于 LlaMA 3 + LangGraph 在windows本地部署大模型 (十)

構建安全的GenAI/LLMs核心技術解密之大模型對抗攻擊(一)

構建安全的GenAI/LLMs核心技術解密之大模型對抗攻擊(二)

構建安全的GenAI/LLMs核心技術解密之大模型對抗攻擊(三)

構建安全的GenAI/LLMs核心技術解密之大模型對抗攻擊(四)

構建安全的GenAI/LLMs核心技術解密之大模型對抗攻擊(五)

你好 GPT-4o!

大模型標記器之Tokenizer可視化(GPT-4o)

大模型標記器 Tokenizer之Byte Pair Encoding (BPE) 算法詳解與示例

大模型標記器 Tokenizer之Byte Pair Encoding (BPE)源碼分析

大模型之自注意力機制Self-Attention(一)

大模型之自注意力機制Self-Attention(二)

大模型之自注意力機制Self-Attention(三)

基于 LlaMA 3 + LangGraph 在windows本地部署大模型 (十一)

Llama 3 模型家族構建安全可信賴企業級AI應用之 Code Llama (一)

Llama 3 模型家族構建安全可信賴企業級AI應用之 Code Llama (二)

Llama 3 模型家族構建安全可信賴企業級AI應用之 Code Llama (三)

Llama 3 模型家族構建安全可信賴企業級AI應用之 Code Llama (四)

Llama 3 模型家族構建安全可信賴企業級AI應用之 Code Llama (五)

Llama 3 模型家族構建安全可信賴企業級AI應用之使用 Llama Guard 保護大模型對話(一)

Llama 3 模型家族構建安全可信賴企業級AI應用之使用 Llama Guard 保護大模型對話(二)

Llama 3 模型家族構建安全可信賴企業級AI應用之使用 Llama Guard 保護大模型對話(三)

大模型之深入理解Transformer位置編碼(Positional Embedding)

大模型之深入理解Transformer Layer Normalization(一)

大模型之深入理解Transformer Layer Normalization(二)

大模型之深入理解Transformer Layer Normalization(三)

大模型之一步一步使用PyTorch編寫Meta的Llama 3代碼(一)初學者的起點

大模型之一步一步使用PyTorch編寫Meta的Llama 3代碼(二)矩陣操作的演練

大模型之一步一步使用PyTorch編寫Meta的Llama 3代碼(三)初始化一個嵌入層

大模型之一步一步使用PyTorch編寫Meta的Llama 3代碼(四)預先計算 RoPE 頻率

大模型之一步一步使用PyTorch編寫Meta的Llama 3代碼(五)預先計算因果掩碼

大模型之一步一步使用PyTorch編寫Meta的Llama 3代碼(六)首次歸一化:均方根歸一化(RMSNorm)

大模型之一步一步使用PyTorch編寫Meta的Llama 3代碼(七) 初始化多查詢注意力

大模型之一步一步使用PyTorch編寫Meta的Llama 3代碼(八)旋轉位置嵌入

大模型之一步一步使用PyTorch編寫Meta的Llama 3代碼(九) 計算自注意力

大模型之一步一步使用PyTorch編寫Meta的Llama 3代碼(十) 殘差連接及SwiGLU FFN

大模型之一步一步使用PyTorch編寫Meta的Llama 3代碼(十一)輸出概率分布 及損失函數計算

大模型之使用PyTorch編寫Meta的Llama 3實際功能代碼(一)加載簡化分詞器及設置參數

大模型之使用PyTorch編寫Meta的Llama 3實際功能代碼(二)RoPE 及注意力機制

大模型之使用PyTorch編寫Meta的Llama 3實際功能代碼(三) FeedForward 及 Residual Layers

大模型之使用PyTorch編寫Meta的Llama 3實際功能代碼(四) 構建 Llama3 類模型本身

大模型之使用PyTorch編寫Meta的Llama 3實際功能代碼(五)訓練并測試你自己的 minLlama3

大模型之使用PyTorch編寫Meta的Llama 3實際功能代碼(六)加載已經訓練好的miniLlama3模型

Llama 3 模型家族構建安全可信賴企業級AI應用之使用 Llama Guard 保護大模型對話 (四)

Llama 3 模型家族構建安全可信賴企業級AI應用之使用 Llama Guard 保護大模型對話 (五)

Llama 3 模型家族構建安全可信賴企業級AI應用之使用 Llama Guard 保護大模型對話 (六)

Llama 3 模型家族構建安全可信賴企業級AI應用之使用 Llama Guard 保護大模型對話 (七)

Llama 3 模型家族構建安全可信賴企業級AI應用之使用 Llama Guard 保護大模型對話 (八)

Llama 3 模型家族構建安全可信賴企業級AI應用之 CyberSecEval 2:量化 LLM 安全和能力的基準(一)

Llama 3 模型家族構建安全可信賴企業級AI應用之 CyberSecEval 2:量化 LLM 安全和能力的基準(二)

Llama 3 模型家族構建安全可信賴企業級AI應用之 CyberSecEval 2:量化 LLM 安全和能力的基準(三)

Llama 3 模型家族構建安全可信賴企業級AI應用之 CyberSecEval 2:量化 LLM 安全和能力的基準(四)

Llama 3 模型家族構建安全可信賴企業級AI應用之code shield(一)Code Shield簡介

Llama 3 模型家族構建安全可信賴企業級AI應用之code shield(二)防止 LLM 生成不安全代碼

Llama 3 模型家族構建安全可信賴企業級AI應用之code shield(三)Code Shield代碼示例

Llama模型家族之使用 Supervised Fine-Tuning(SFT)微調預訓練Llama 3 語言模型(一) LLaMA-Factory簡介

Llama模型家族之使用 Supervised Fine-Tuning(SFT)微調預訓練Llama 3 語言模型(二) LLaMA-Factory訓練方法及數據集

大模型之Ollama:在本地機器上釋放大型語言模型的強大功能

大型語言模型 (LLM) 已成為行業變革者,能夠生成人類質量的文本、翻譯語言以及編寫不同類型的創意內容。然而,它們的傳統用途需要訪問強大的云資源,因此許多個人無法獲得它們。

開源框架 Ollama 打破了這一障礙,它允許你直接在本地機器上運行這些強大的模型。這開辟了一個充滿可能性的世界,使你能夠:

- 激發創造力:產生想法、集思廣益、撰寫詩歌或劇本等不同創意格式,甚至翻譯現有內容。苦于想不出吸引人的標題或引人入勝的開場白?Ollama 可以幫助你克服寫作障礙并激發新的靈感。

- 提高寫作質量:核實信息,確保事實準確性,改寫句子以提高清晰度,并生成替代措辭以使你的寫作更流暢。Ollama 可以成為你的個人編輯,幫助你完善作品的寫作風格。

- 自動執行任務:厭倦了總結長篇文章或創建大綱?Ollama 可以為你處理這些重復性任務,讓你有時間專注于工作中更具創造性的方面。此外,你還可以為特定受眾生成不同版本的內容,從而簡化內容創建流程。

開始使用 Ollama

下載安裝 Ollama

登錄https://ollama.com/ 網站下載。

下載以后,點擊OllamaSetup.exe 應用程序直接安裝。

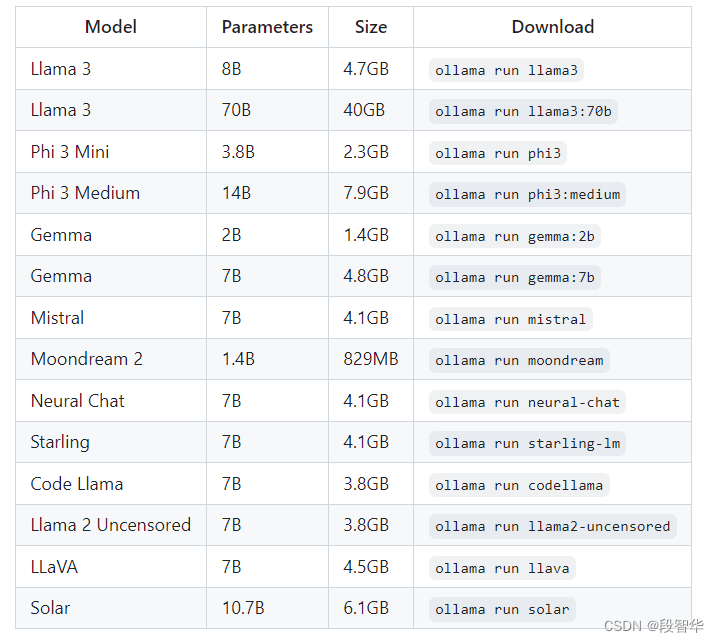

選擇大模型

https://ollama.com/library

Ollama 提供了一個預先訓練好的模型庫,每個模型都有不同的功能和優勢。 Llama-3 模型是一個很好的起點,但探索 Ollama 網站https://github.com/ollama/ollama上的可用選項可以讓您找到最適合您特定需求的模型。

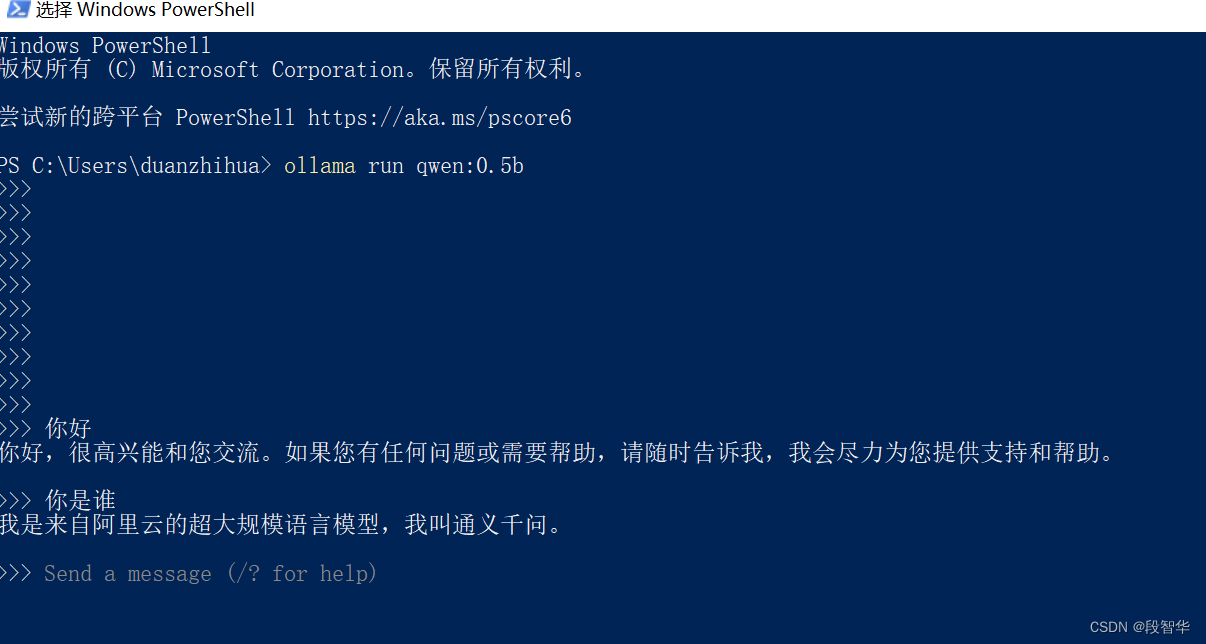

以交互模式使用 Ollama:

下載模型:打開終端并輸入以下命令,替換<model_name>為你要下載的模型的名稱(例如llama2):

ollama pull <model_name>

運行模型:下載后,使用此命令開始與 LLM 對話:

ollama run <model_name>

Ollama 除了其交互模式之外,還通過代碼集成提供編程交互,允許直接向 LLM 發送提示并在代碼中接收響應。以下是與 Ollama 的代碼集成概述:

要求:

- Python: Ollama 的代碼集成依賴于 Python。請確保您的系統上安裝了 Python 3.7 或更高版本。

- Ollama 庫:您需要安裝 Ollama 庫。可以使用 完成pip install ollama。

python基本集成:

from langchain.prompts import PromptTemplate

from langchain.chains import LLMChain

from langchain_community.llms import Ollamaprompt_template = "請寫一首關于{product}的詩,我希望是七言律詩"

# ollama run qwen:0.5b

ollama_llm = Ollama(model="qwen:0.5b")

llm_chain = LLMChain(llm = ollama_llm,prompt = PromptTemplate.from_template(prompt_template)

)

result=llm_chain.invoke("春天")

print(result)運行結果為

python.exe d:/2024_PEFT_LoRA_Train/2024-PurpleLlama-main/CodeShield/sam_test/ollama_test.py

E:\Users\duanzhihua\Anaconda3\envs\chatgpt_book_2023\Lib\site-packages\langchain_core\_api\deprecation.py:119: LangChainDeprecationWarning: The class `LLMChain` was deprecated in LangChain 0.1.17 and will be removed in 0.3.0. Use RunnableSequence, e.g., `prompt | llm` instead.warn_deprecated(

{'product': '春天', 'text': '春風拂面柔,萬物復蘇春常駐。\n桃李芬芳滿枝開,魚躍龍門展雄姿。\n人間四月芳菲盡,百鳥齊鳴春意濃

。'}

優點:

- 可訪問性: Ollama 消除了無法使用昂貴云資源或缺乏使用基于云的 LLM 所需技術專業知識的個人的準入門檻。這為更廣泛的受眾探索和試驗 LLM 敞開了大門。

- 定制: Ollama 允許您從各種預先訓練的模型中進行選擇,甚至可以針對特定任務對其進行微調。這種級別的定制使用戶能夠根據自己的獨特需求和偏好定制 LLM 的功能。

- 控制:通過本地執行,您可以完全控制 LLM 的操作。這意味著您可以調整設置、嘗試不同的配置,并根據自己的喜好微調模型的行為。

缺點:

- 計算要求:雖然 Ollama 允許使用本地 LLM,但這些模型仍然需要大量計算資源,尤其是對于更大、更復雜的模型。對于硬件能力有限的用戶來說,這可能是一個限制因素,可能會導致性能問題,例如響應時間慢甚至模型崩潰。

- 功能有限:與基于云的 LLM 解決方案相比,Ollama 可能提供更有限的功能。這是因為與強大的云服務器相比,本地機器通常具有較少的可用資源。

社區集成

Open WebUI

Enchanted (macOS native)

Hollama

Lollms-Webui

LibreChat

Bionic GPT

HTML UI

Saddle

Chatbot UI

Chatbot UI v2

Typescript UI

Minimalistic React UI for Ollama Models

Ollamac

big-AGI

Cheshire Cat assistant framework

Amica

chatd

Ollama-SwiftUI

Dify.AI

MindMac

NextJS Web Interface for Ollama

Msty

Chatbox

WinForm Ollama Copilot

NextChat with Get Started Doc

Alpaca WebUI

OllamaGUI

OpenAOE

Odin Runes

LLM-X (Progressive Web App)

AnythingLLM (Docker + MacOs/Windows/Linux native app)

Ollama Basic Chat: Uses HyperDiv Reactive UI

Ollama-chats RPG

QA-Pilot (Chat with Code Repository)

ChatOllama (Open Source Chatbot based on Ollama with Knowledge Bases)

CRAG Ollama Chat (Simple Web Search with Corrective RAG)

RAGFlow (Open-source Retrieval-Augmented Generation engine based on deep document understanding)

StreamDeploy (LLM Application Scaffold)

chat (chat web app for teams)

Lobe Chat with Integrating Doc

Ollama RAG Chatbot (Local Chat with multiple PDFs using Ollama and RAG)

BrainSoup (Flexible native client with RAG & multi-agent automation)

macai (macOS client for Ollama, ChatGPT, and other compatible API back-ends)

相關庫

LangChain and LangChain.js with example

LangChainGo with example

LangChain4j with example

LlamaIndex

LiteLLM

OllamaSharp for .NET

Ollama for Ruby

Ollama-rs for Rust

Ollama4j for Java

ModelFusion Typescript Library

OllamaKit for Swift

Ollama for Dart

Ollama for Laravel

LangChainDart

Semantic Kernel - Python

Haystack

Elixir LangChain

Ollama for R - rollama

Ollama for R - ollama-r

Ollama-ex for Elixir

Ollama Connector for SAP ABAP

Testcontainers

Portkey

PromptingTools.jl with an example

LlamaScript

擴展插件

Raycast extension

Discollama (Discord bot inside the Ollama discord channel)

Continue

Obsidian Ollama plugin

Logseq Ollama plugin

NotesOllama (Apple Notes Ollama plugin)

Dagger Chatbot

Discord AI Bot

Ollama Telegram Bot

Hass Ollama Conversation

Rivet plugin

Obsidian BMO Chatbot plugin

Cliobot (Telegram bot with Ollama support)

Copilot for Obsidian plugin

Obsidian Local GPT plugin

Open Interpreter

Llama Coder (Copilot alternative using Ollama)

Ollama Copilot (Proxy that allows you to use ollama as a copilot like Github copilot)

twinny (Copilot and Copilot chat alternative using Ollama)

Wingman-AI (Copilot code and chat alternative using Ollama and HuggingFace)

Page Assist (Chrome Extension)

AI Telegram Bot (Telegram bot using Ollama in backend)

AI ST Completion (Sublime Text 4 AI assistant plugin with Ollama support)

Discord-Ollama Chat Bot (Generalized TypeScript Discord Bot w/ Tuning Documentation)

Discord AI chat/moderation bot Chat/moderation bot written in python. Uses Ollama to create personalities.

大模型技術分享

《企業級生成式人工智能LLM大模型技術、算法及案例實戰》線上高級研修講座

模塊一:Generative AI 原理本質、技術內核及工程實踐周期詳解

模塊二:工業級 Prompting 技術內幕及端到端的基于LLM 的會議助理實戰

模塊三:三大 Llama 2 模型詳解及實戰構建安全可靠的智能對話系統

模塊四:生產環境下 GenAI/LLMs 的五大核心問題及構建健壯的應用實戰

模塊五:大模型應用開發技術:Agentic-based 應用技術及案例實戰

模塊六:LLM 大模型微調及模型 Quantization 技術及案例實戰

模塊七:大模型高效微調 PEFT 算法、技術、流程及代碼實戰進階

模塊八:LLM 模型對齊技術、流程及進行文本Toxicity 分析實戰

模塊九:構建安全的 GenAI/LLMs 核心技術Red Teaming 解密實戰

模塊十:構建可信賴的企業私有安全大模型Responsible AI 實戰

Llama3關鍵技術深度解析與構建Responsible AI、算法及開發落地實戰

1、Llama開源模型家族大模型技術、工具和多模態詳解:學員將深入了解Meta Llama 3的創新之處,比如其在語言模型技術上的突破,并學習到如何在Llama 3中構建trust and safety AI。他們將詳細了解Llama 3的五大技術分支及工具,以及如何在AWS上實戰Llama指令微調的案例。

2、解密Llama 3 Foundation Model模型結構特色技術及代碼實現:深入了解Llama 3中的各種技術,比如Tiktokenizer、KV Cache、Grouped Multi-Query Attention等。通過項目二逐行剖析Llama 3的源碼,加深對技術的理解。

3、解密Llama 3 Foundation Model模型結構核心技術及代碼實現:SwiGLU Activation Function、FeedForward Block、Encoder Block等。通過項目三學習Llama 3的推理及Inferencing代碼,加強對技術的實踐理解。

4、基于LangGraph on Llama 3構建Responsible AI實戰體驗:通過項目四在Llama 3上實戰基于LangGraph的Responsible AI項目。他們將了解到LangGraph的三大核心組件、運行機制和流程步驟,從而加強對Responsible AI的實踐能力。

5、Llama模型家族構建技術構建安全可信賴企業級AI應用內幕詳解:深入了解構建安全可靠的企業級AI應用所需的關鍵技術,比如Code Llama、Llama Guard等。項目五實戰構建安全可靠的對話智能項目升級版,加強對安全性的實踐理解。

6、Llama模型家族Fine-tuning技術與算法實戰:學員將學習Fine-tuning技術與算法,比如Supervised Fine-Tuning(SFT)、Reward Model技術、PPO算法、DPO算法等。項目六動手實現PPO及DPO算法,加強對算法的理解和應用能力。

7、Llama模型家族基于AI反饋的強化學習技術解密:深入學習Llama模型家族基于AI反饋的強化學習技術,比如RLAIF和RLHF。項目七實戰基于RLAIF的Constitutional AI。

8、Llama 3中的DPO原理、算法、組件及具體實現及算法進階:學習Llama 3中結合使用PPO和DPO算法,剖析DPO的原理和工作機制,詳細解析DPO中的關鍵算法組件,并通過綜合項目八從零開始動手實現和測試DPO算法,同時課程將解密DPO進階技術Iterative DPO及IPO算法。

9、Llama模型家族Safety設計與實現:在這個模塊中,學員將學習Llama模型家族的Safety設計與實現,比如Safety in Pretraining、Safety Fine-Tuning等。構建安全可靠的GenAI/LLMs項目開發。

10、Llama 3構建可信賴的企業私有安全大模型Responsible AI系統:構建可信賴的企業私有安全大模型Responsible AI系統,掌握Llama 3的Constitutional AI、Red Teaming。

解碼Sora架構、技術及應用

一、為何Sora通往AGI道路的里程碑?

1,探索從大規模語言模型(LLM)到大規模視覺模型(LVM)的關鍵轉變,揭示其在實現通用人工智能(AGI)中的作用。

2,展示Visual Data和Text Data結合的成功案例,解析Sora在此過程中扮演的關鍵角色。

3,詳細介紹Sora如何依據文本指令生成具有三維一致性(3D consistency)的視頻內容。 4,解析Sora如何根據圖像或視頻生成高保真內容的技術路徑。

5,探討Sora在不同應用場景中的實踐價值及其面臨的挑戰和局限性。

二、解碼Sora架構原理

1,DiT (Diffusion Transformer)架構詳解

2,DiT是如何幫助Sora實現Consistent、Realistic、Imaginative視頻內容的?

3,探討為何選用Transformer作為Diffusion的核心網絡,而非技術如U-Net。

4,DiT的Patchification原理及流程,揭示其在處理視頻和圖像數據中的重要性。

5,Conditional Diffusion過程詳解,及其在內容生成過程中的作用。

三、解碼Sora關鍵技術解密

1,Sora如何利用Transformer和Diffusion技術理解物體間的互動,及其對模擬復雜互動場景的重要性。

2,為何說Space-time patches是Sora技術的核心,及其對視頻生成能力的提升作用。

3,Spacetime latent patches詳解,探討其在視頻壓縮和生成中的關鍵角色。

4,Sora Simulator如何利用Space-time patches構建digital和physical世界,及其對模擬真實世界變化的能力。

5,Sora如何實現faithfully按照用戶輸入文本而生成內容,探討背后的技術與創新。

6,Sora為何依據abstract concept而不是依據具體的pixels進行內容生成,及其對模型生成質量與多樣性的影響。

![[Algorithm][回溯][記憶化搜索][最長遞增子序列][猜數字大小Ⅱ][矩陣中的最長遞增路徑]詳細講解](http://pic.xiahunao.cn/[Algorithm][回溯][記憶化搜索][最長遞增子序列][猜數字大小Ⅱ][矩陣中的最長遞增路徑]詳細講解)

)

)

)