?1 概率論知識

1.1 先驗概率

先驗概率是基于背景常識或者歷史數據的統計得出的預判概率,一般只包含一個變量,例如P(A),P(B)。

1.2 聯合概率

聯合概率指的是事件同時發生的概率,例如現在A,B兩個事件同時發生的概率,記為P(A,B)、P(A∩B)、P(AB)。

若事件A和事件B相互獨立,則有:

例子:假設事件A為明天上班,事件B為明天中彩票,其中P(A)=0.5,P(B)=0.5,則明天既上班又中彩票的概率為P(A)P(B)=0.25

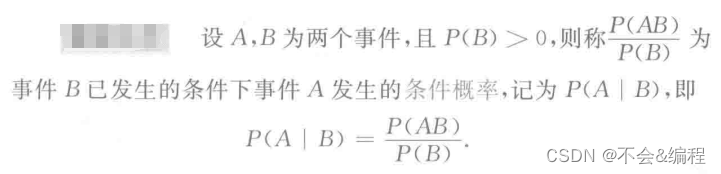

1.3 條件概率

其中一般條件概率中的A事件表示結果,B事件表示原因,即由因求果

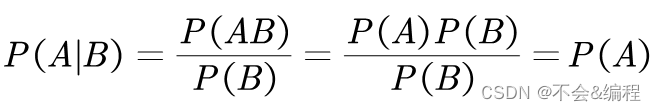

其中,P (AB) 就是聯合概率。在A與B相互獨立的情況下,易得:

即B事件對A事件沒有影響

1.4 后驗概率

后驗概率和條件概率的區別是:后驗概率是由果求因:,例如,事件A是由事件B引起的,則P(A|B)是條件概率,P(B|A)是后驗概率

舉個通俗易懂的例子:

- 條件概率:新聞說今天路上出現了交通事故,若想推算一下因此而堵車的概率,也就是 P(堵車|交通事故),這是由因推果。

- 后驗概率:出門后路上遇到了堵車,若想推算一下這次堵車是由發生了交通事故而引起的概率,也就是后驗概率 P(交通事故|堵車),這是由果求因。

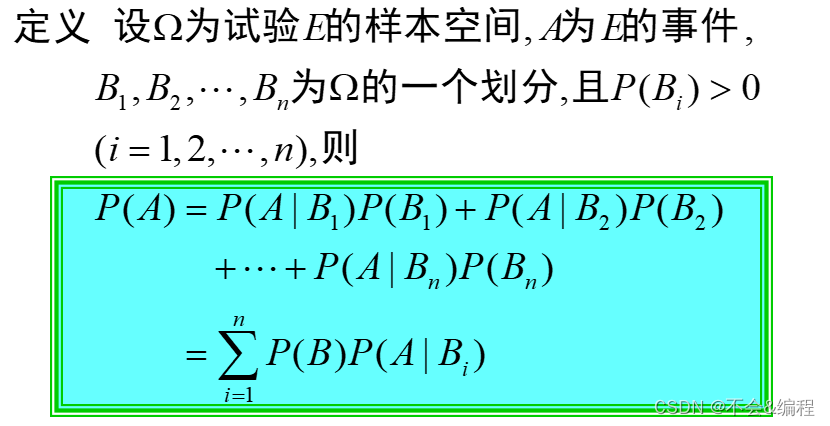

1.5 全概率公式

(1)樣本空間

(2)全概率公式

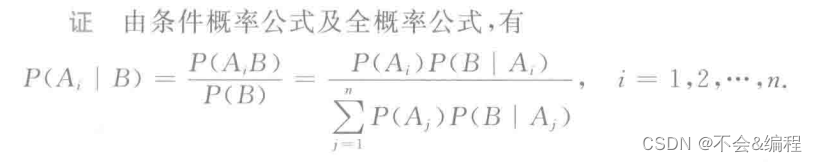

1.6 貝葉斯公式

設樣本空間為Ω,B為Ω中的事件,為Ω的一個劃分,且

,則有:

稱上式為貝葉斯公式,也稱為逆概率公式

2 貝葉斯分類器理論知識

2.1 樸素貝葉斯發的學習與分類

2.1.1?基本方法

設

- 輸入空間:

?

?

為n維集合的向量

- 輸出空間:類標記集合

?

- 輸入為特征向量:

?

- 輸出為類標記(class label):

?

X是定義在輸入空間上的隨機向量,Y是定義在輸出空間

上的隨機變量。

是X和Y的聯合概率分布。訓練數據集

?

是獨立同分布產生

樸素貝葉斯法通過訓練數據集學習聯合概率分布,學習過程如下:

(1)學習先驗概率分布及條件概率分布

- 先驗概率分布:

- 條件概率分布:

假設可取值有

個,

,Y的可能取值有K個,那么參數的個數有

,因此條件概率分布

有指數級別數量的參數,其估計實際是不可行的

樸素貝葉斯法對條件概率分布作了條件獨立性的假設。由于這是一個較強的假設,樸素貝葉斯法也由此得名。樸素貝葉斯法的條件獨立性假設為:

樸素貝葉斯法實際上學習到生成數據的機制,所以屬于生成模型。條件獨立假設等于是說用于分類的特征在類確定的條件下都是條件獨立的。這一假設使樸素貝葉斯法變得簡單,但有時會犧牲一定的分類準確率。

樸素貝葉斯分類時,對給定的輸入x,通過學習到的模型計算后驗概率分布,將后驗概率最大的類作為x的類輸出,后驗概率計算根據貝葉斯定理進行:

將公式(1)代入到公式(2)可得:

于是, 樸素貝葉斯分類器可表示為:

由于分母是一樣的,所以可以簡化為:

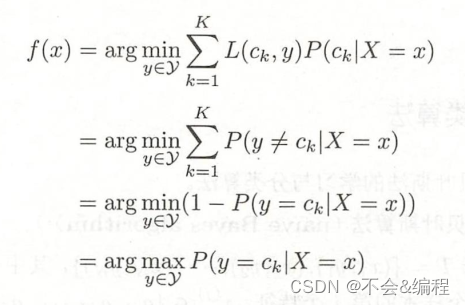

2.1.2 后驗概率最大化含義

樸素貝葉斯會將實例分到后驗概率最大的類中,即等價于期望風險最小化,假設選擇0-1損失函數:

其中是分類決策函數。這時,期望風險函數為

期望是對聯合分布取的。所以取條件期望

為了使期望風險最小化,只需對逐個最小化,因此有

最終可知后驗概率最大的類=期望風險最小的類,即樸素貝葉斯采用的原理:

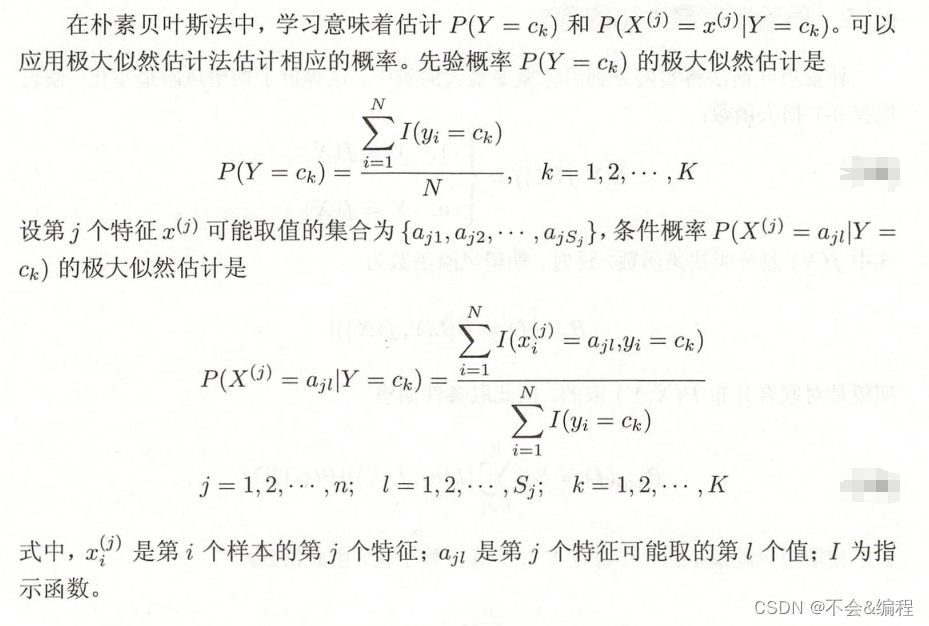

2.2?樸素貝葉斯法的參數估計

2.2.1 極大似然估計

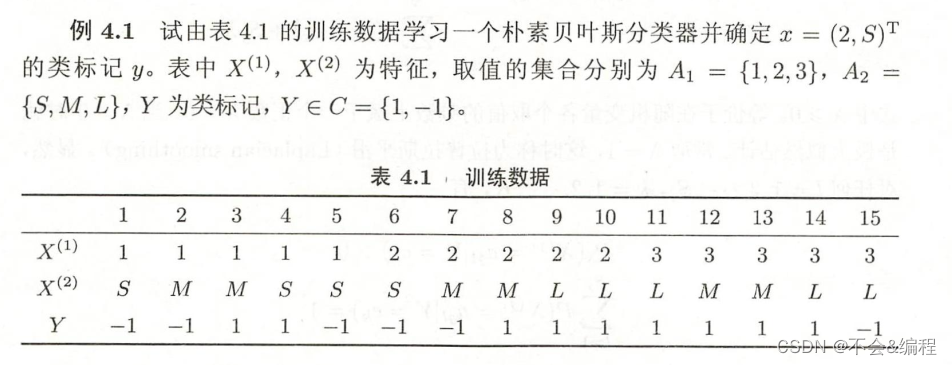

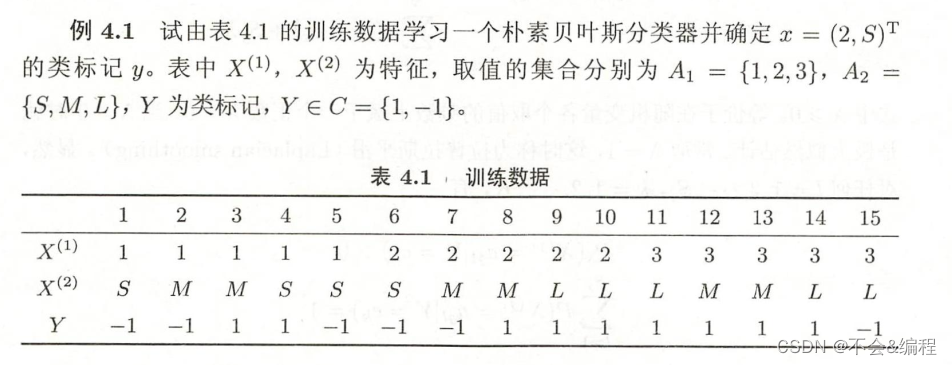

2.2.2 學習與分類算法

1 算法流程

2 例子

2.2.3 貝葉斯估計

1 理論

2 例子

取λ=1,之后如下所示:

)

![[muduo網絡庫]——muduo庫Acceptor類(剖析muduo網絡庫核心部分、設計思想)](http://pic.xiahunao.cn/[muduo網絡庫]——muduo庫Acceptor類(剖析muduo網絡庫核心部分、設計思想))