? ? ? ?在數字化的時代浪潮中,人工智能技術正以前所未有的速度蓬勃發展,而大模型作為其中的翹楚,以生成式對話技術逐漸成為推動行業乃至整個社會進步的核心力量。再往近一點來說,在公司,不少產品都戴上了人工智能的帽子,各種高大上人工對話界面,作為一個已經工作8年的老程序員來說,一種壓力感撲面而來,這使得我不得不去接受新的東西,在學習和使用Prompt、function-call和Rag后發現了一個對AI初學者極其友好的框架——Langchain,幫助我更好更快的使用大模型。

????????在接下來的文章里,我將帶著大家來分析和感受LangChain的發展和應用。通過深入了解,我們可以更好地利用LangChain的優勢和避免它的不足之處。

LangChain總結

面向大模型的開發框架(SDK)

????????LangChain是一套被設計成易于使用的軟件工具集,專門為程序員提供了使用大型模型的能力。它的主要目的是幫助程序員減少開發工作量,并且將底層的復雜和重復性工作封裝起來。使用LangChain,你可以簡單方便地利用這些封裝好的功能來開發軟件。這個框架的初衷就是讓你能夠更加高效地開發,并且更加輕松地使用大型模型的能力。

基于軟件工程思維,要更關注接口變更

????????使用這套框架確實需要一定的代碼能力,因為這個框架的設計本質是基于軟件工程思路的,對編程基礎有一定要求。另外,大模型技術和輔助工具正處于一個初級階段,發展時間并不長,大模型誕生也就好一年多的時間。因此,在學習這些工具時,我們最好不要過于專注于每個接口的具體用法,例如像前端框架vue對于這個功能怎么實現,這類工具不能這么學,因為大模型技術目前還處于初級階段,未來仍會有很多變化。我們更應該關注這些框架的設計思路和模塊結構,因為它們的模塊大部分可能不會改變,只是接口可能會有一些細微的調整。更應該關注它的設計思路在你的實際工作中能否得到參考,通過這些思考我到底是直接拿它來用,還是參考它來設計,還是完全做一個更新的設計,這些都會在實際開發中大有裨益。

?AGI 時代軟件工程的一個探索和原型,迭代速度快

????????LangChain的迭代速度明顯快于Semantic Kernel,幾乎每天都有一個新版本發布。LangChain的發展是一個學習和探索的過程,在早期存在許多不成熟的接口,以及一些設計過于復雜的函數或流程。但是通過這么多次的迭代,幾乎所有的問題都得到了修復,可以說它的成熟度是與日俱增的,目前來看,LangChain已經具備了一定的可用性的。一些模塊在設計上非常成熟,具備拿來就用的,甚至在生產機使用時沒問題的,而有些模塊設計的還是很粗糙,例如第三方功能實現的一些模塊,不建議使用的。還有一些模塊在設計上沒有問題,但在實際工作中可能并不是必需的,完全取決于你的需求。接下來我將帶著大家來分析和感受。

與其他開發框架的對比

數據來源:GitHub Star History

????????Github的平行樹的對比,LangChain的歡迎程度明顯還是遙遙領先的,之所以會形成這個情況,是因為LangChain最早期設計是比較簡單易懂,不像Semantic-kernel是有一套宏大的理念導致整個抽象程度太高,導致它的可讀性或感受上很晦澀。所以Langchain比較方便大家知道怎么用,拿來就知道好不好用,都能很直接的評估出來。

LangChain 的核心組件

模型 I/O 封裝

- LLMs:大語言模型,因為它對模型、檢索都做了統一的封裝,調用llama或其他大模型實現本地的Rag會更加簡單。

- Chat Models:一般基于 LLMs,但按對話結構重新封裝,

- PromptTemple:提示詞模板,對提示詞模板的操作給以了封裝。

- OutputParser:解析輸出,模型的輸出結果,給了不同的解析工具,這個是Semantic-kernel所沒有的,也是它方便使用的功能之一。

數據連接封裝

- Document Loaders:如何加載各種格式文檔,集結了各種格式文件的加載器。

- Document Transformers:封裝了對文檔的常用操作工具,如:split, filter, translate, extract metadata, etc

- Text Embedding Models:對不同的embedding模型做了統一的封裝,不管你底層是什么,基本都是統一的接口都可以去使用。然后對各種各樣的三方的向量數據庫做了封裝,也就是說你不用太關心,背后向量數據庫到底是啥,通過Langchain的統一的接口去調用。文本向量化表示,用于檢索等操作。

- Verctorstores: (面向檢索的)向量的存儲,就是將向量數據庫的封裝后轉成一個檢索器

- Retrievers: 向量的檢索,一個用于檢索的工具。

記憶封裝

- Memory:這里不是物理內存,從文本的角度,可以理解為“上文”、“歷史記錄”或者說“記憶力”的管理。對上下文的管理做了一層封裝或賦予了一組工具。

架構封裝

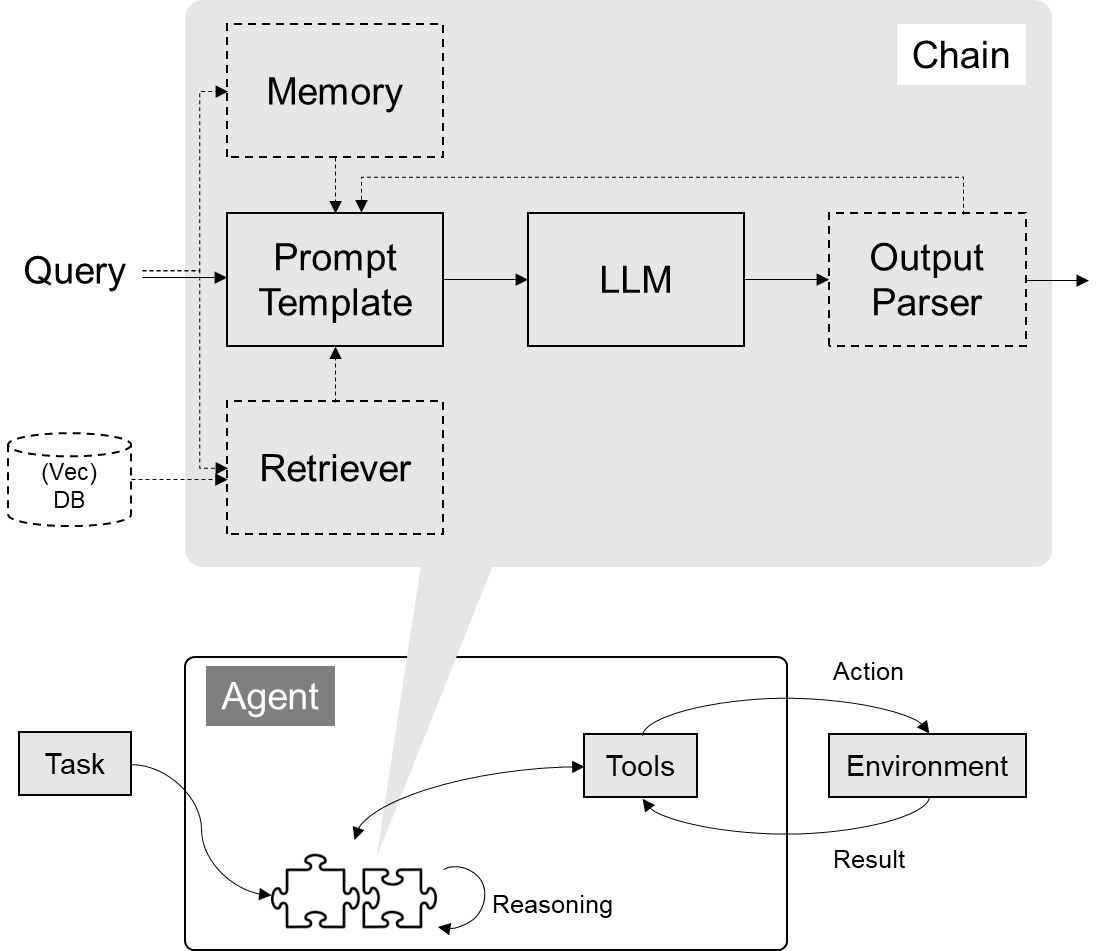

????????最核心的是在架構上做了一層封裝,包括了調用一系列組合的pipeline。

- Chain:實現一個功能或者一系列順序功能組合,pipeline順序調用。

- Agent:智能體架構的封裝,根據用戶輸入,自動規劃執行步驟,自動選擇每步需要的工具,最終完成用戶指定的功能

- Tools:調用外部功能的函數,例如:調 google 搜索、文件 I/O、Linux Shell 等等

- Toolkits:操作某軟件的一組工具集,例如:操作 DB、操作 Gmail 等等

Callbacks

??????他每個模塊內部到底發生了什么,它都給了你一些Callback事件。具體可參考官網,里面有更為詳細的講解。

? ? ? ? 可參考官網:Callbacks | 🦜?🔗 LangChain

主要用途

解決Chain的問題

? ? ? ? 以一個Pipline (一種既定流程去調用不同組件) 的維度去看。核心解決的是一個查詢(Query)進來后,可以將問題填充到提示詞(Prompt)模板中去,然后通過Prompt去調用大語言模型(LLM)輸出的模型結果,其結果(Json / List / Text / Code ...)可以通過Output Parser進行解析提取核心數據放到下個輸入環節中,以填充新的Prompt模板,如此反復,不斷提煉輸出內容。

? ? ? ? 在前面套流程之上還賦予了上下文管理(Memory)能力和連接外部數據(Retriever)能力及工具。連接外部數據最典型的方式就是以向量數據進行向量檢索。核心利用了這幾大模塊,解決了和大模型打交道常見的功能,然后將這些功能做了統一的封裝。做了統一封裝的好處就是語言模型我可以換不同的模型的同時還不用該接口,整個代碼不用變我就把這個大預言模型就給換了。

構成智能體(Agent)

????????智能體就是經過自己反復思考,選擇不同的工具,通過多步(調用工具 -> 拿到工具結果 ->分析結果 -> 選擇工具)處理一個復雜任務,這樣一個流程作為大模型誕生后的一個新的模式。而里面一個反復思考都是在調用大模型(LLM),這個調用流程其實就是用上面的Chain來進行封裝組成的,而LangChain也對智能體架構也做了一個標準化的封裝。

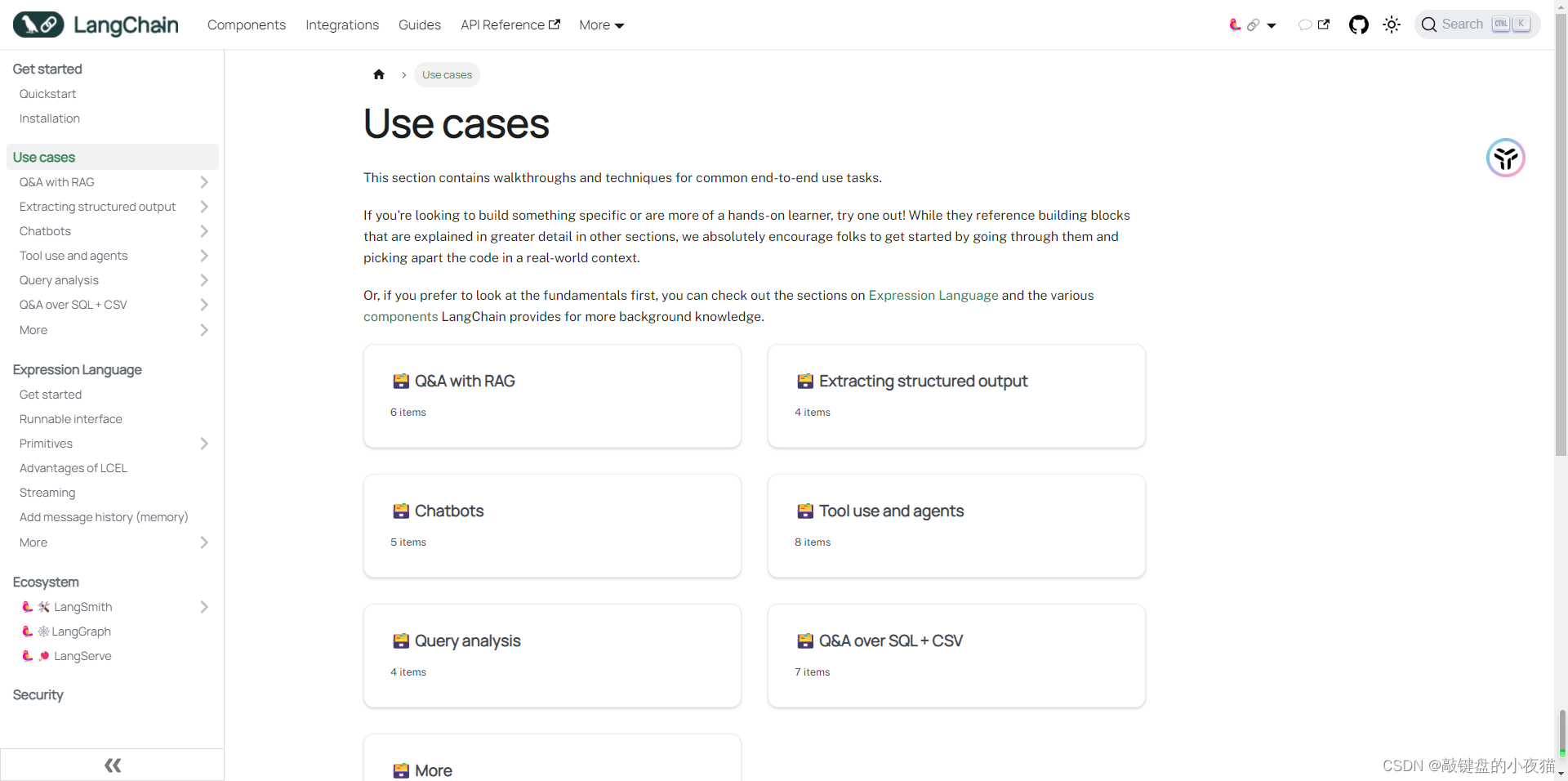

相關文檔(以 Python 版為例)

? ? ? ? 官方文檔還是比較清晰的,Docs是LangChain自己提供的核心組件所有得文檔和例子;Integrations是所有跟三方的服務和組件的連接,比如你要連接各種各種的語言模型Llama,或不同的向量數據等都在這里面可以找到;Use cases則是Langchain封裝好的流程和功能,例如怎么實現Rag、怎么實現Sql查數據庫、怎么實現checkout和怎么實現摘要這類的例子;更深一點比如說怎么做debugging、調試部署、評估這類相關的文檔里沒有的技巧和方法都在Guides里邊。

主要幾大核心文檔

- 功能模塊:主要模塊有Model I/O、Retrieval、Agents、Chains、Memory、Callbacks這類

?直通車:https://python.langchain.com/docs/get_started/introduction

- API 文檔:針對以上更細的內容,如每個函數、每個類,參數、響應的接口文檔描述。

直通車:https://api.python.langchain.com/en/latest/langchain_api_reference.html

- 三方組件集成:提供程序具有獨立的langchain-{provider}包,用于改進版本控制、依賴關系管理和測試。

直通車:https://python.langchain.com/docs/integrations/platforms/

- 官方應用案例:包含常見對接技術和例子

直通車:https://python.langchain.com/docs/use_cases

- 調試部署等指導:https://python.langchain.com/docs/guides/debugging

小試牛刀

安裝最新LangChain依賴

pip install --upgrade langchain

pip install --upgrade langchain-openai # v0.1.0新增的底包

pip install qianfan #安裝文言千帆模型ApiOpenAI?vs Langchain

????????接下來會用以下這兩個例子對比Langchain的優勢。

多輪對話實現

OpenAI

? ? ? ? 原生的Openai通過一個json數組,每一輪都一個任務一個content來去表示一個對話上下文。

# 加載 .env 文件到環境變量

from dotenv import load_dotenv, find_dotenv

from openai import OpenAI_ = load_dotenv(find_dotenv())# 初始化 OpenAI 服務。會自動從環境變量加載 OPENAI_API_KEY 和 OPENAI_BASE_URL

client = OpenAI()# 消息格式

messages = [{"role": "system","content": "你是AI助手小京。"},{"role": "human","content": "我是Csdn的一名博主,我叫Muller"},{"role": "assistant","content": "歡迎!"},{"role": "user","content": "我是誰?"},]# 調用 GPT-3.5

chat_completion = client.chat.completions.create(model="gpt-3.5-turbo",messages=messages

)# 輸出回復

print(chat_completion.choices[0].message.content)

# 您自己告訴我您是CSDN的博主Muller。Langchian

? ? ? ? 那么在langchain的框架下,可以通過它定義的結構來去表示一個對話。然后呢我們還是把這個對話通過invoke接口來傳給大模型。

# 加載 .env 到環境變量

from dotenv import load_dotenv, find_dotenv

_ = load_dotenv(find_dotenv())from langchain_openai import ChatOpenAIllm = ChatOpenAI() # 默認是gpt-3.5-turbofrom langchain.schema import (AIMessage, #等價于OpenAI接口中的assistant roleHumanMessage, #等價于OpenAI接口中的user roleSystemMessage #等價于OpenAI接口中的system role

)

messages = [SystemMessage(content="從現在開始你叫AI助手-小京。"),HumanMessage(content="我是Csdn的一名博主,我叫Muller"),AIMessage(content="歡迎!"),HumanMessage(content="我是誰")

]

response = llm.invoke(messages)

print(response.content)#你是Muller,一名CSDN的博主。Langchains實現會更加的簡潔,且可以輕松實現一個Pipline。

國產模型調用

OpenAi

import json

import requests

import os# 通過鑒權接口獲取 access token

def get_access_token():"""使用 AK,SK 生成鑒權簽名(Access Token):return: access_token,或是None(如果錯誤)"""url = "https://aip.baidubce.com/oauth/2.0/token"params = {"grant_type": "client_credentials","client_id": "ERNIE_CLIENT_ID","client_secret": "ERNIE_CLIENT_SECRET"}return str(requests.post(url, params=params).json().get("access_token"))# 調用文心4.0對話接口

def get_completion_ernie(prompt):url = "https://aip.baidubce.com/rpc/2.0/ai_custom/v1/wenxinworkshop/chat/completions_pro?access_token=" + get_access_token()payload = json.dumps({"messages": [{"role": "user","content": prompt}]})headers = {'Content-Type': 'application/json'}response = requests.request("POST", url, headers=headers, data=payload).json()return response["result"]class RAG_Bot:def __init__(self, llm_api, n_results=2):self.llm_api = llm_apiself.n_results = n_resultsdef chat(self, user_query):# 3. 調用 LLMresponse = self.llm_api(user_query)return response# 創建一個RAG機器人

new_bot = RAG_Bot(llm_api=get_completion_ernie

)user_query = "你是誰?"response = new_bot.chat(user_query)print(response)Langchain

# 其它模型分裝在 langchain_community 底包中

from langchain_community.chat_models import QianfanChatEndpoint

from langchain_core.messages import HumanMessage

import osllm = QianfanChatEndpoint(qianfan_ak=os.getenv('ERNIE_CLIENT_ID'),qianfan_sk=os.getenv('ERNIE_CLIENT_SECRET')

)messages = [HumanMessage(content="你是誰")

]ret = llm.invoke(messages)print(ret.content)通過模型封裝,實現不同模型的統一接口調用

![[AI OpenAI-doc] 安全最佳實踐](http://pic.xiahunao.cn/[AI OpenAI-doc] 安全最佳實踐)

失敗)

等級考試試卷(二級)2024年3月)

)

list類(STL))

)

)