在Mac上搭建本地AI工作流:Dify與DeepSeek的完美結合

一、Dify平臺簡介

Dify是一個開源的大語言模型(LLM)應用開發平臺,旨在簡化和加速生成式AI應用的創建和部署。其名字蘊含著"Define(定義)+ Modify(修改)"的理念,體現了平臺的靈活性和易用性。

作為一個綜合性開發平臺,Dify結合了后端即服務(BaaS)和LLMOps的概念,使開發人員能夠更高效地構建AI原生應用。無論您是開發者還是非技術人員,都可以利用Dify構建、部署和運營AI應用。

Dify的主要特點包括可視化的AI應用開發模式,支持聊天機器人、AI工作流、RAG管道、Agent、模型管理以及可觀測性功能。其應用場景十分廣泛,包括智能客服、企業知識庫、特定領域的聊天機器人和AI助理、自動化報告生成以及多模態內容創作。

二、在Mac上本地部署Dify

(一)準備工作

- 確保Mac環境滿足要求:你的Mac需要安裝有Homebrew,它是Mac上優秀的包管理工具。如果沒有安裝,可以在終端中運行以下命令進行安裝:

/bin/bash -c "$(curl -fsSL https://raw.githubusercontent.com/Homebrew/install/HEAD/install.sh)"

- 安裝Docker:Dify通過Docker進行部署,所以需要安裝orbstack。你可以前往orbstack官網下載并按照提示完成安裝。安裝完成后,啟動Docker,確保其在后臺運行。

- 鏡像加速:加速的目的是為了下載dify時不出現因為超時而報錯,操作步驟:使用 vim 命令行打開docker.json文件,輸入下面鏡像的地址。

vi ~/.orbstack/config/docker.json

{

"registry-mirrors":[

"https://dockerproxy.com",

"https://docker.mirrors.ustc.edu.cn",

"https://docker.nju.edu.cn"]

}

(二)獲取Dify代碼

在終端中執行以下命令,克隆Dify的代碼倉庫:

git clone https://github.com/dify-ai/dify.git

克隆完成后,進入dify目錄并設置.env文件:

cd dify/docker

cp .env.example .env

(三)配置與啟動

- 環境變量配置(可選):如果有特殊的配置需求,比如修改服務端口、配置代理等,可以通過編輯

.env文件來設置環境變量。在dify目錄下找到.env.example文件,將其復制一份并命名為.env,然后根據實際需求修改其中的配置項。例如,如果想修改Dify服務的端口為8080,可以找到并修改APP_PORT=8080這一行(原端口可能是其他值)。 - 啟動Dify:在終端中,確保當前目錄為dify目錄,然后執行以下命令啟動Dify:

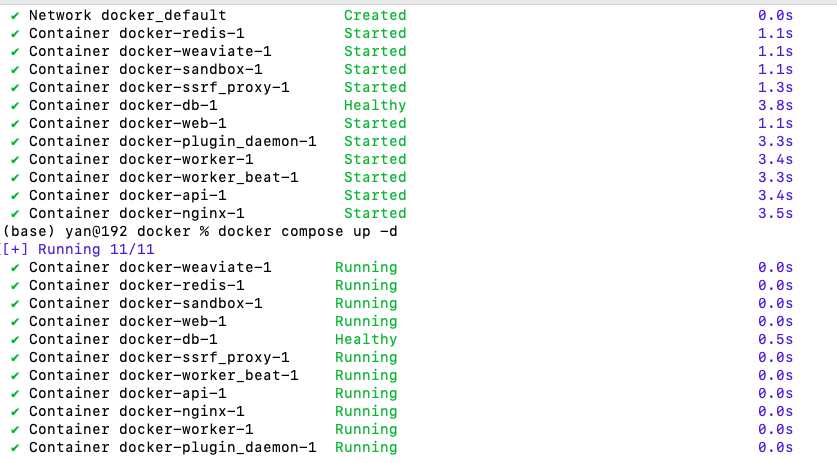

docker compose up -d

該命令會在后臺啟動Dify相關的容器,包括數據庫、應用服務等。啟動過程可能需要一些時間,取決于你的網絡速度和機器性能。啟動完成后,可以通過訪問http://localhost(如果修改了端口,需要使用修改后的端口,如http://localhost:8080)來打開Dify的Web界面。啟動后界面如下:

四、使用Ollama本地部署DeepSeek模型

Ollama是一個跨平臺的輕量級工具,旨在本地運行大型語言模型,如DeepSeek、Llama和Mistral。它提供了一鍵式模型部署,適合需要數據隱私和本地控制的用戶。

- 在Mac上使用Ollama部署DeepSeek的步驟如下:

1.訪問Ollama官網(https://ollama.ai/ )下載適合Mac的安裝包。

2.安裝Ollama。安裝過程非常簡單,按照提示完成即可。

3.安裝完成后,打開終端,驗證Ollama是否正確安裝:

ollama --version

拉取DeepSeek模型。Ollama支持多種規模的DeepSeek模型,您可以根據自己的硬件條件選擇合適的版本:

ollama pull deepseek-r1:1.5b

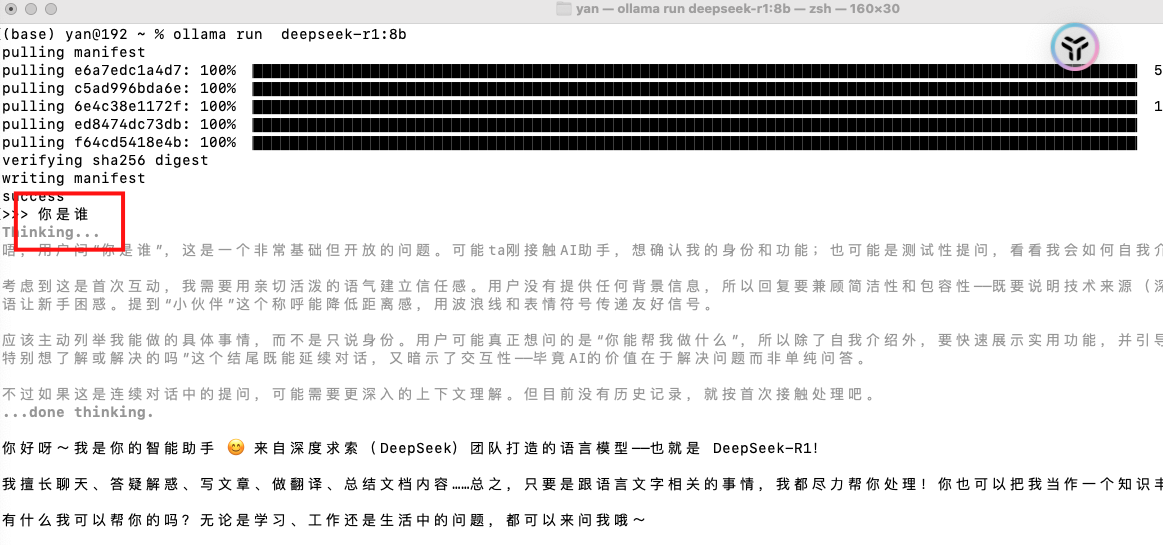

驗證模型是否正常運行:

ollama run deepseek-r1:1.5b

這將啟動一個交互式會話,您可以直接與DeepSeek模型對話。

五、在 Dify 中配置 DeepSeek 并創建聊天助手?

(一)配置模型接口?

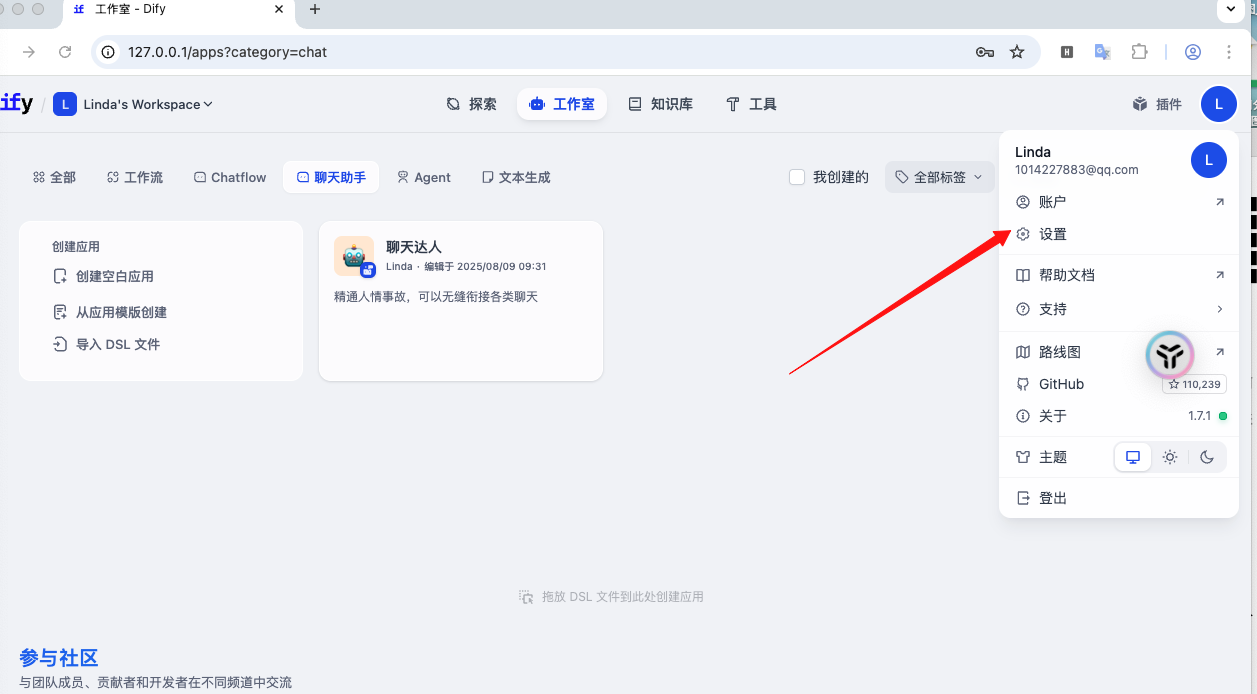

1.登錄 Dify:在瀏覽器中訪問http://localhost完成注冊并登錄賬號。?

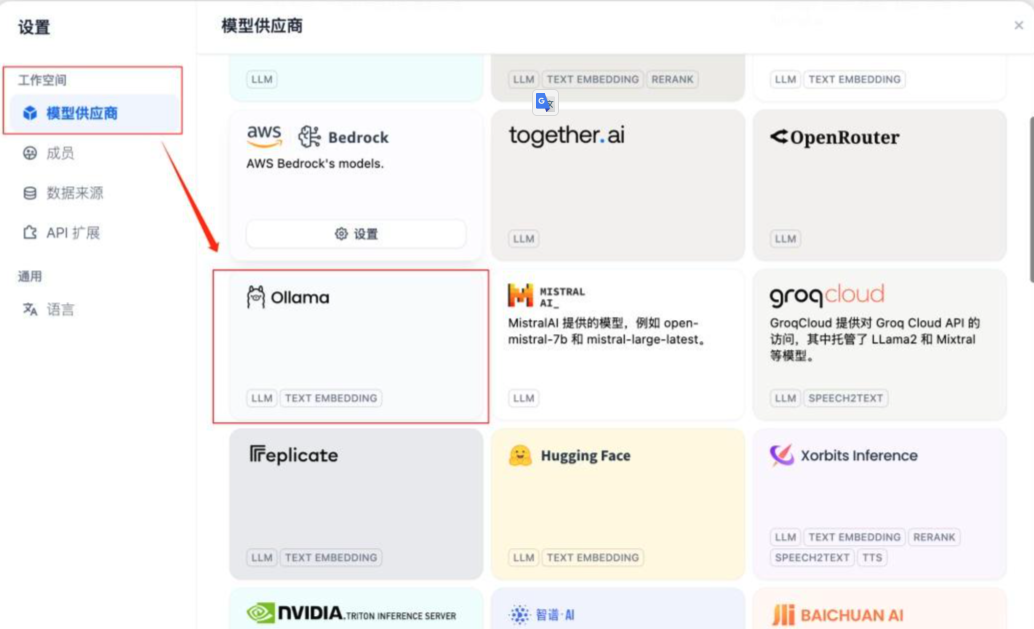

2.進入模型配置頁:點擊左側導航欄的 “設置”→“模型”→“添加模型”,選擇 “模型供應商”。?

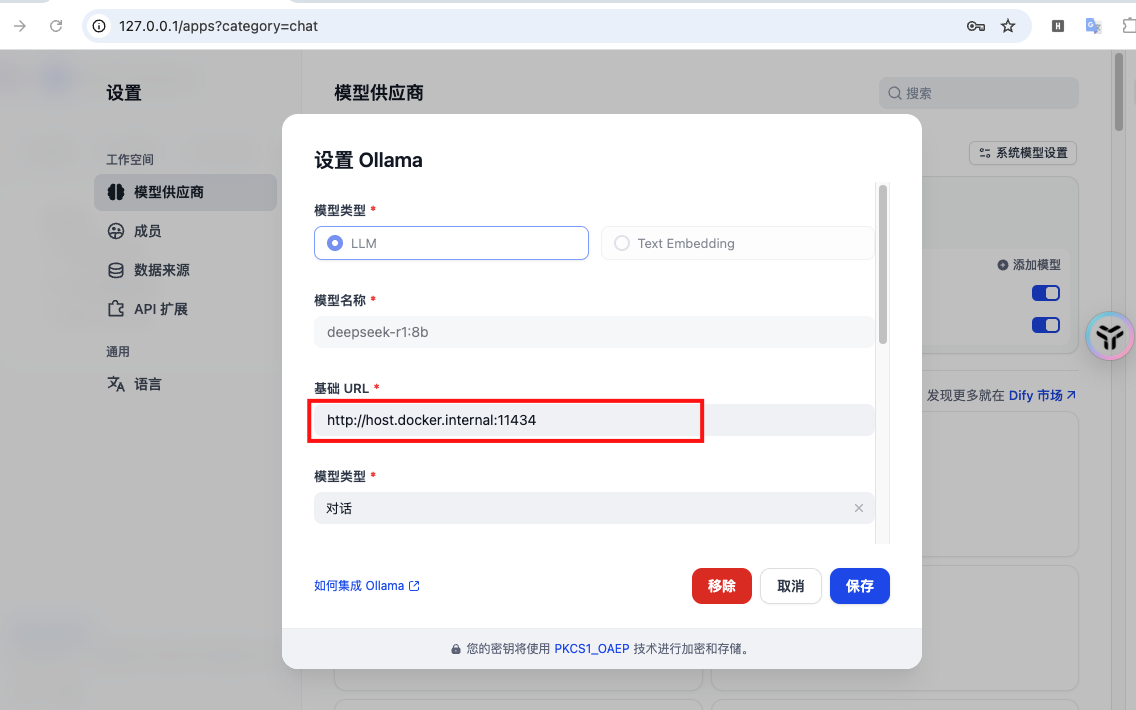

3.填寫信息:?

- 選擇供應商模型 ollama

- 模型基礎URL:http://host.docker.internal:11434/api/chat(Ollama 默認接口地址,Docker 內部需用host.docker.internal訪問本地服務)?,模型名稱為本地ollama部署的模型名稱(如:deepseek-r1:8b)。

- 點擊 “保存”,即配置完成。

(二)創建聊天助手?

新建應用:點擊左側導航欄的 “應用”→“創建應用”,選擇 “聊天助手” 類型。?

配置助手:?

應用名稱:自定義(如 “本地 DeepSeek 助手”)?

選擇模型:在下拉框中選擇剛配置的 “DeepSeek-Local”?

其他設置(如開場白、回復風格)保持默認即可。?

測試助手:點擊 “預覽” 按鈕,在聊天窗口中輸入問題(如 “介紹一下人工智能”),若能收到來自 DeepSeek 模型的回應,說明聊天助手創建成功。

)