目錄

一、語言中的詞匯

1、詞的形態學

2、詞的詞性

二、詞語規范化

1、詞語切分

2、詞形還原

3、詞干提取

三、中文分詞

1、概述

2、基于最大匹配的中文分詞

3、基于線性鏈條件隨機場的中文分詞

4、基于感知器的中文分詞

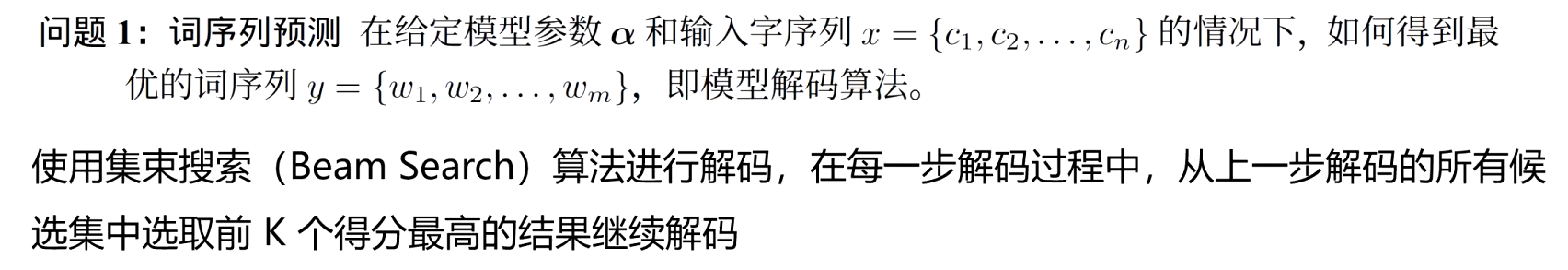

詞序列預測

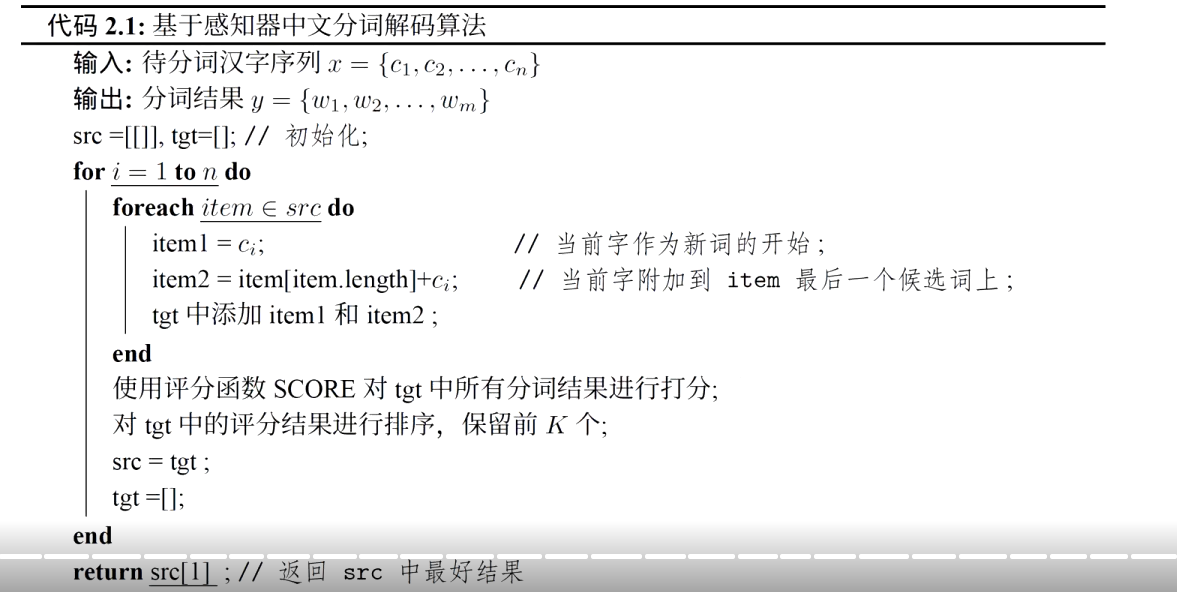

模型參數學習

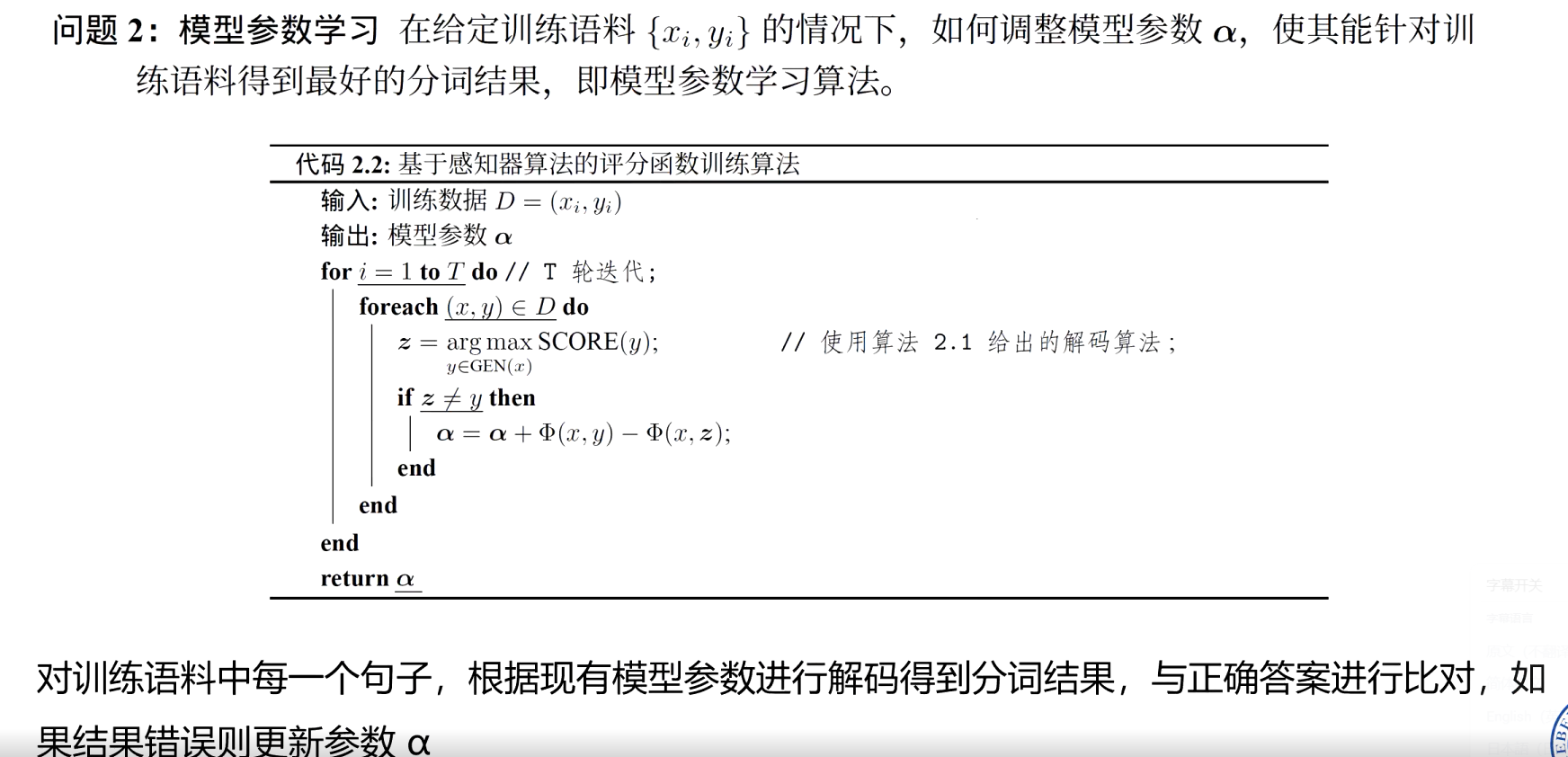

特征定義

5、基于雙向長短期記憶網絡的中文分詞

6、中文分詞評價方法

7、中文分詞語料庫

四、詞性標注

1、基于規則的詞性標注

2、基于隱馬爾可夫模型的詞性標注

3、基于卷積神經網絡的詞性標注

4、詞性標注評價方法

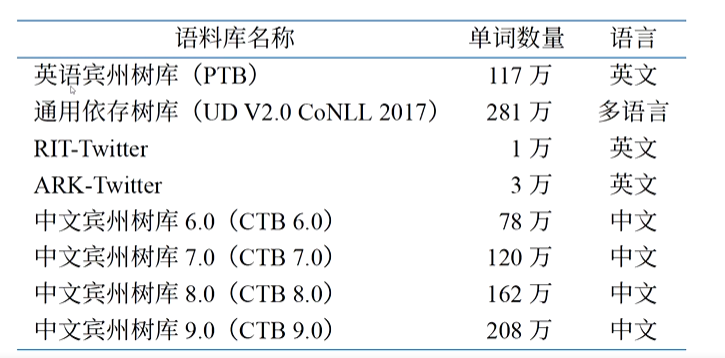

5、詞性標注語料庫?

????????自然語言處理算法中詞通常也是基本單元,詞的處理也是自然語言處理中重要的底層任務,是句法分析、文本分類、語言型等任務的基礎。

一、語言中的詞匯

?????????詞(word)是形式和意義相結合的單位,也是語言中能夠獨立運用的最小單位掌握一個詞匯意味著知道其讀音和語義。

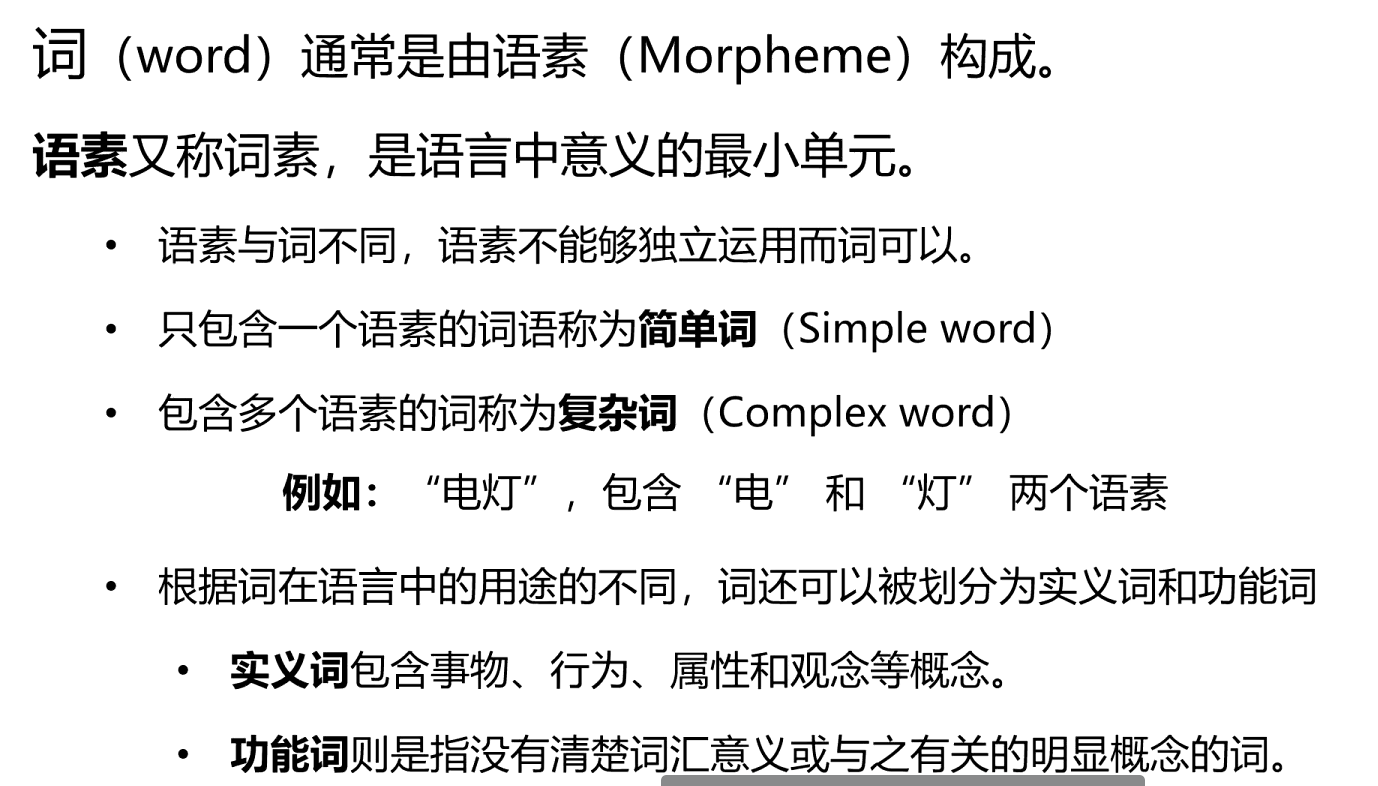

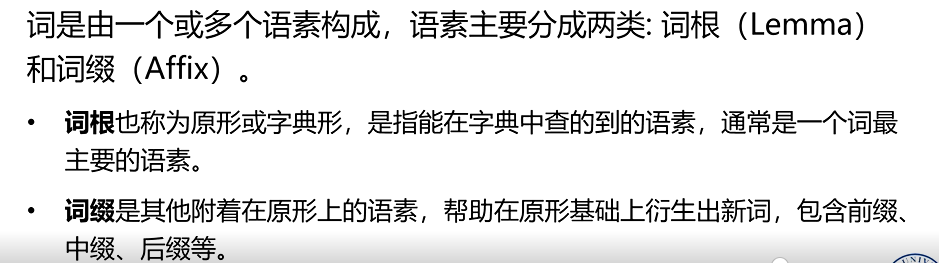

1、詞的形態學

·? ? ? ?詞的形式具有服從于某種規則的內在結構。研究單詞的內部結構和其構成方式的學科稱為形態學(Morphology),又稱構詞學。

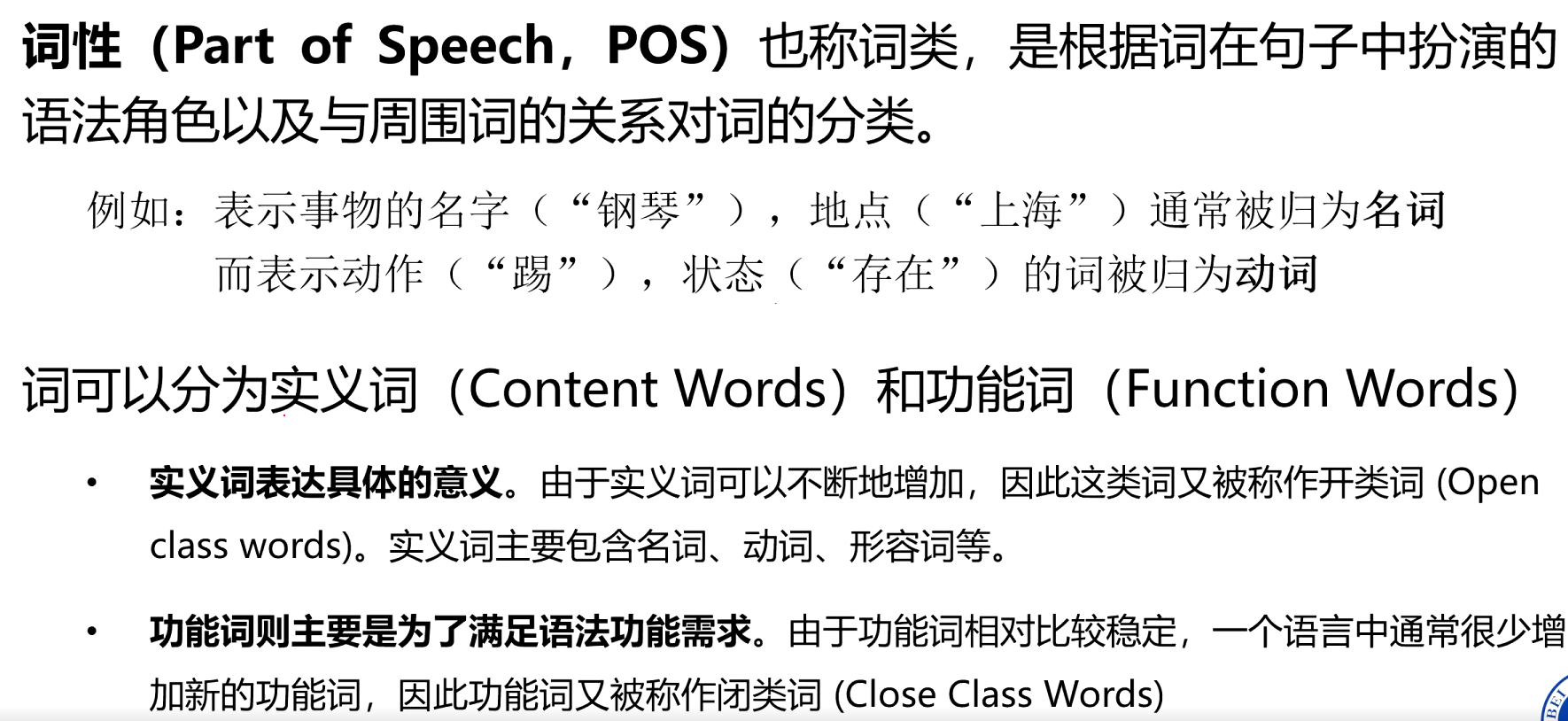

2、詞的詞性

二、詞語規范化

????????詞語規范化(Word Normalization)任務是將單詞或詞形轉化為標準形式,針對有多種形式的單詞使用一種單一的形式進行表示。

????????詞語切分是前提,為詞形還原和詞干提取提供處理對象;詞形還原和詞干提取則是詞語規范化的核心手段,目的都是將同一單詞的不同形式統一為更簡潔的表示

1、詞語切分

????????將連續的文本序列按照一定規則分割成有意義的詞語單元。例如:中文句子 “我愛自然語言處理” 經切分后為 “我 / 愛 / 自然 / 語言 / 處理”

????????word 是語言自然存在的表意單位,而 token 是為了計算需求對文本進行切分后的最小單元。token 可以是一個完整的 word,也可以是 word 的一部分(如子詞、字符序列)

2、詞形還原

????????將單詞的各種變形形式(如時態、語態、單復數、詞性變化等)還原為其基本形式(即 “詞根” 或 “原型”),且還原后的形式需是語言中實際存在的合法單詞。

- 動詞 “running”“ran” 還原為原型 “run”;

- 名詞 “mice” 還原為原型 “mouse”;

- 形容詞 “better” 還原為原型 “good”。

3、詞干提取

????????指通過去除單詞的詞綴(如前綴、后綴)等方式,提取出單詞的核心部分(即 “詞干”),但詞干可能并非語言中實際存在的完整單詞。最簡單的詞干提取算法可以通過查詢詞表的方法獲得

另外一種方法是后綴剝離(Suffix-stripping),通過定義一組規則,將特定的后綴從詞形中刪除

- “running”“runner” 去除后綴 “-ing”“-er” 后,詞干為 “run”;

- “happiness” 去除后綴 “-ness” 后,詞干為 “happi”(非完整單詞

三、中文分詞

1、概述

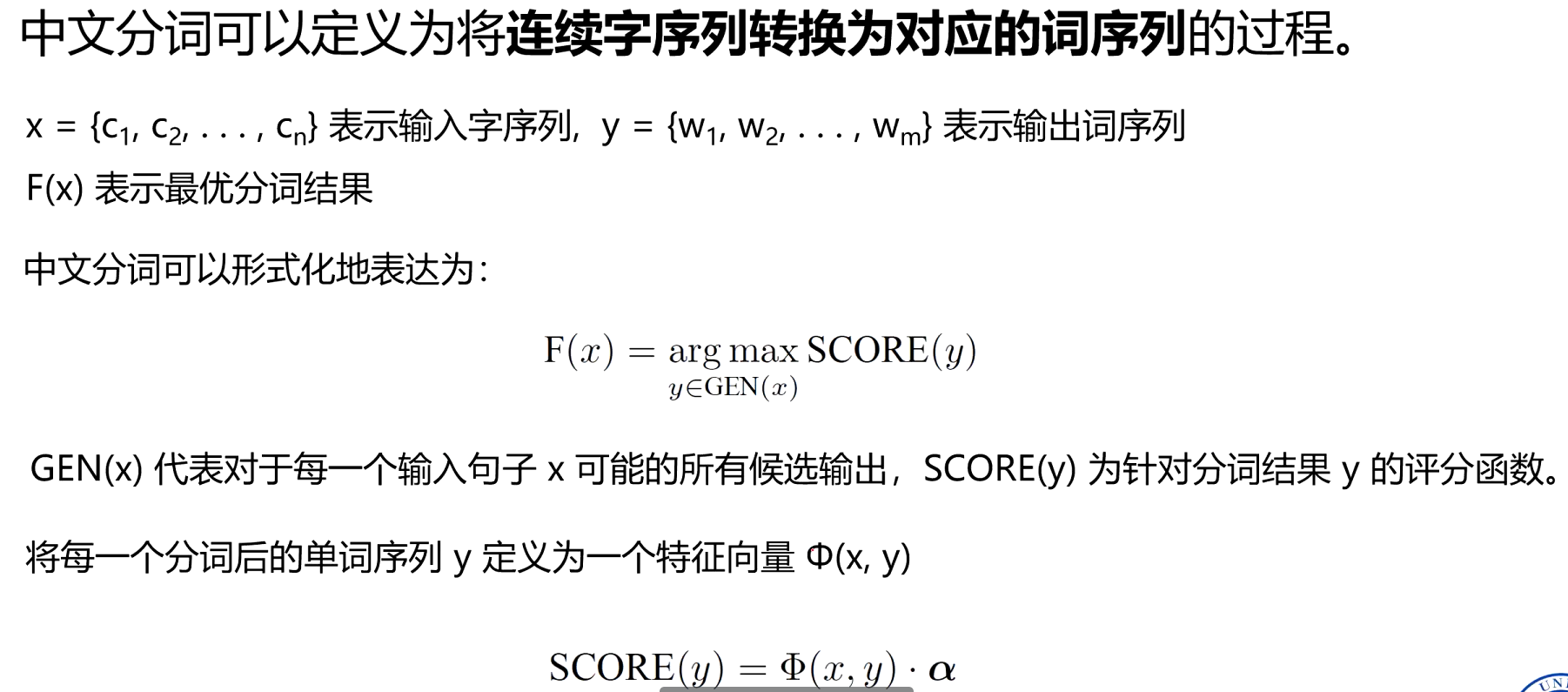

????????中文分詞(Chinese Word Segmentation,CWS)是指將連續字序列轉換為對應的詞序列的過程,也可以看做在輸入的序列中添加空格或其他邊界標記的過程。

? ?主要困難來自以下三個方面:分詞規范、歧義切分和未登錄詞【生詞】識別。

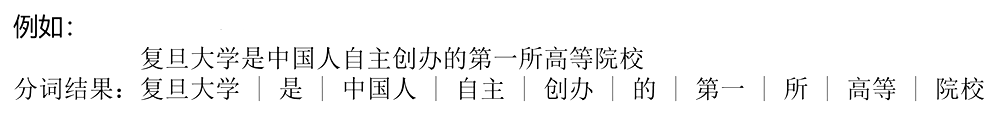

2、基于最大匹配的中文分詞

????????最大匹配(Maximum Matching)分詞算法,核心思想是 “從詞典中找出最長的詞來匹配當前文本片段”,通過貪心策略確定詞邊界。主要包含前向最大匹配、后向最大匹配以及雙向最大匹配等三類。

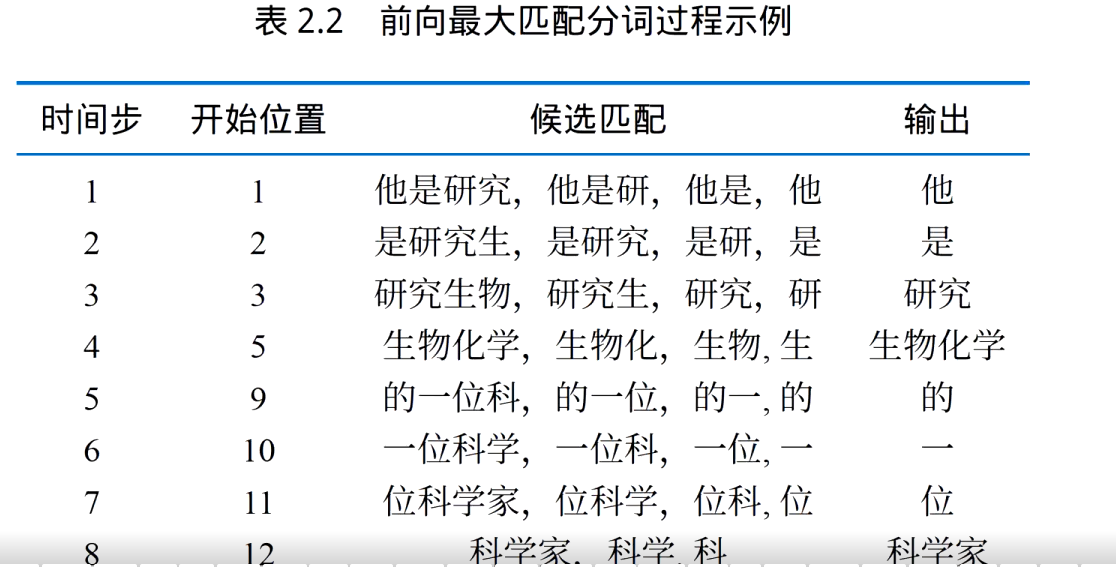

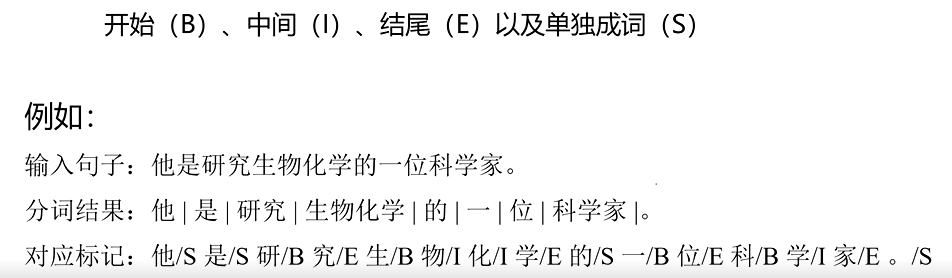

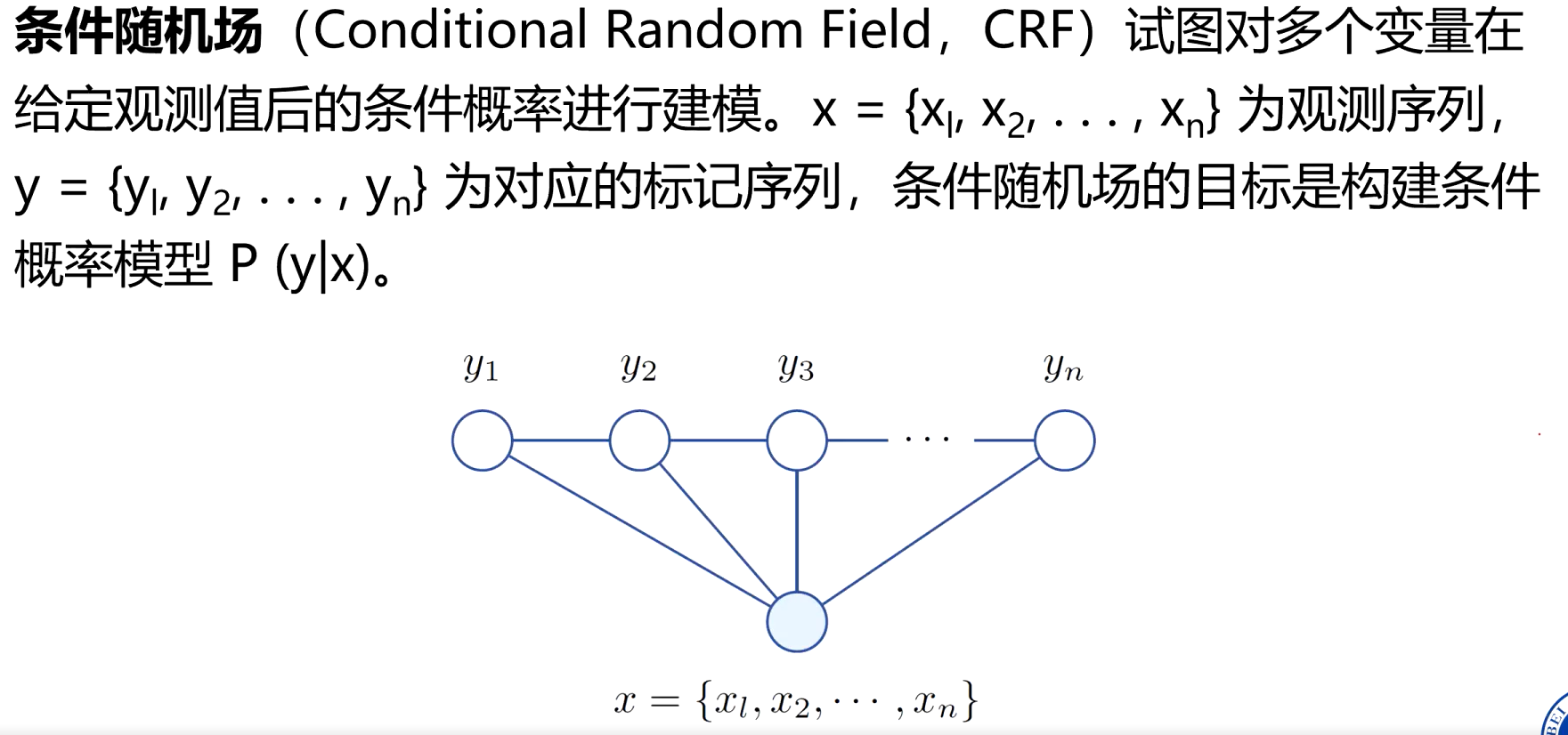

3、基于線性鏈條件隨機場的中文分詞

- 先給每個字貼標簽,再按標簽切分

????????將分詞過程轉換為對字的分類問題,對于輸入句子中的每一個字c;,根據它在分詞結果中的位置賦予不同的標簽。

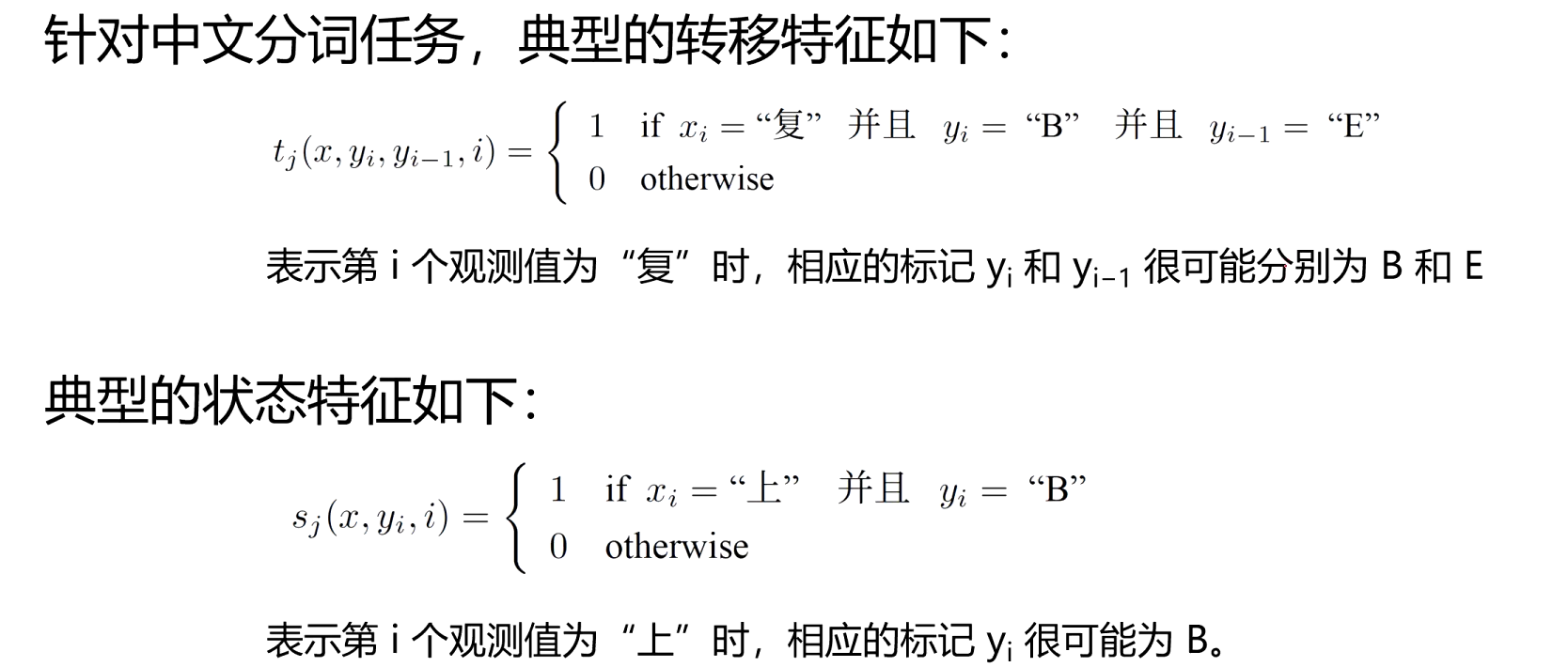

怎么讓機器準確地給每個字貼 B/I/E/S 標簽?線性鏈條件隨機場(CRF)就是干這個的 “聰明工具”。給每個字貼標簽時,不會只看單個字,而是會看這個字本身的特點、看上下文的關系、遵守標簽之間的 “規矩”

- 如何學習的呢?

- 用 BIES 標簽將分詞轉化為序列標注;

- 設計轉移特征(約束標簽合法性)和狀態特征(捕捉漢字與標簽的關聯);

- 通過訓練學習特征權重,使模型符合語言規律;

- 用 Viterbi 算法快速找到最優標簽序列,實現分詞。

4、基于感知器的中文分詞

-

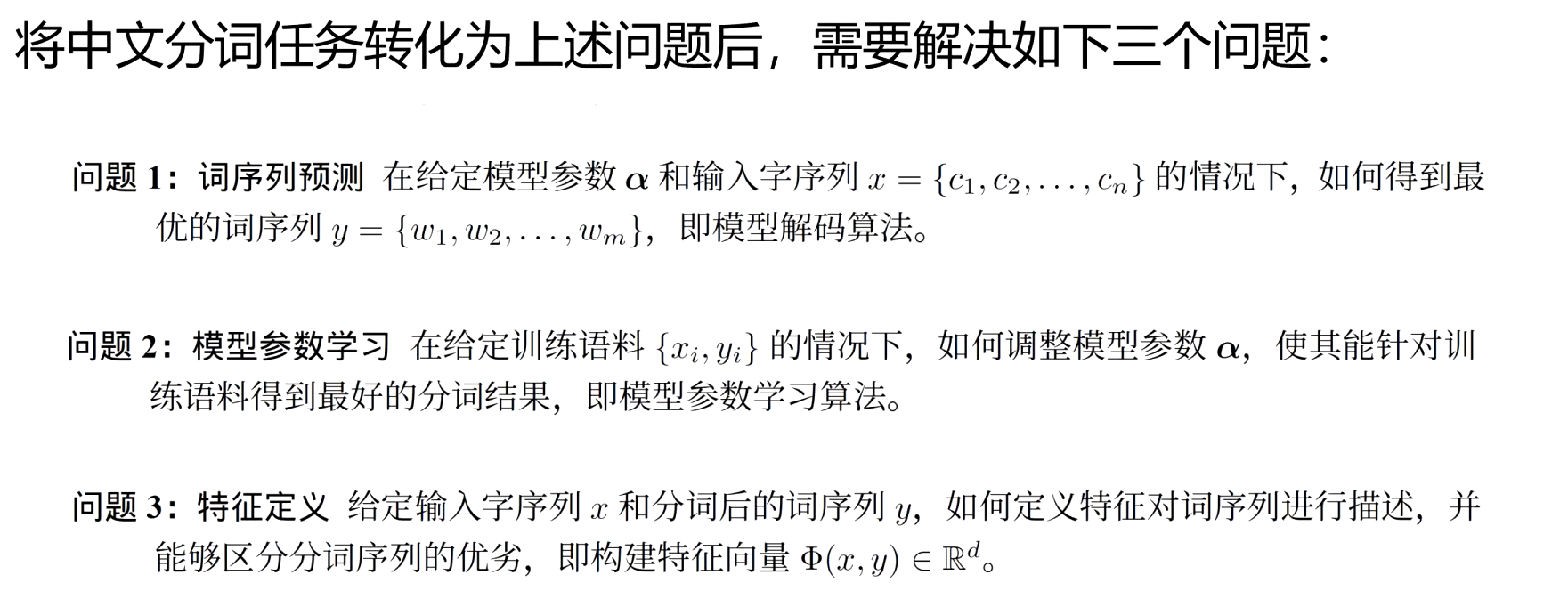

詞序列預測

-

模型參數學習

-

特征定義

5、基于雙向長短期記憶網絡的中文分詞

????????核心是利用神經網絡自動學習漢字的上下文特征,將分詞轉化為序列標注任務

????????BiLSTM 是 LSTM(長短期記憶網絡)的雙向擴展,能同時捕捉文本的 “左→右” 和 “右→左” 上下文信息

6、中文分詞評價方法

????????中文分詞的評價核心是衡量 “系統切分結果” 與 “人工標注的標準答案(gold standard)” 的一致性,常用指標包括準確率、召回率、F1 值,輔以其他輔助指標。

7、中文分詞語料庫

分詞語料庫是人工標注了正確詞邊界的中文文本集合,是訓練和評價分詞模型的基礎.

公開語料庫:PKU、MSR 等可通過學術平臺(如 LDC、SIGHAN 官網)免費獲取

四、詞性標注

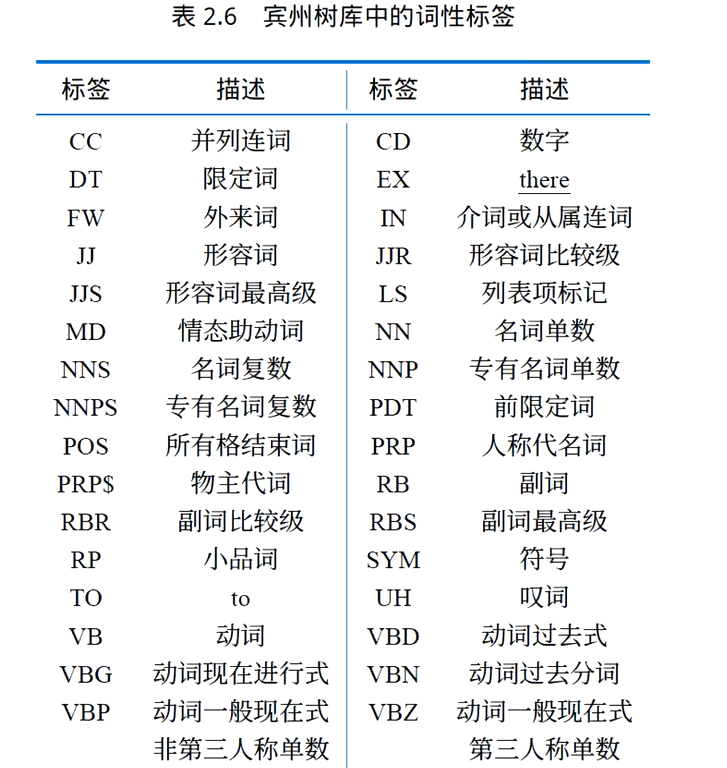

????????詞性是詞語的基本屬性,根據其在句子中所扮演的語法角色以及與周圍詞的關系進

行分類。詞性標注(Part-of-speech Tagging,POs Tagging)是指在給定的語境中確定句子中各詞的詞性。????????詞性標注的主要難點在于歧義性,即一個詞可能在不同的上下文中具有不同的詞性。也沒有一個被廣泛認可的統一詞性劃分標準。

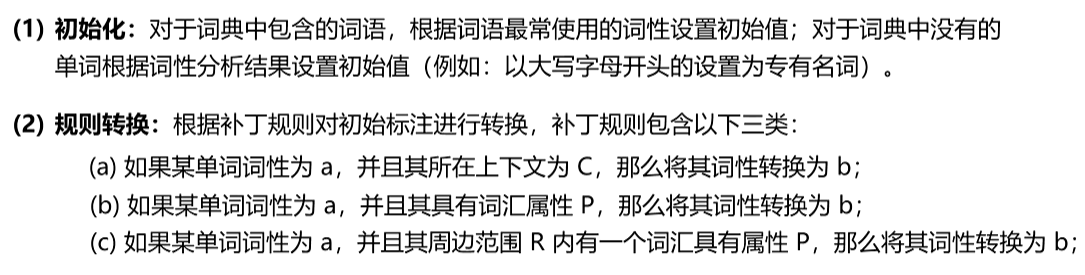

1、基于規則的詞性標注

利用詞典和搭配規則針對詞語和上下文進行分析,從而得到句子中每個詞語詞性。

例如:補丁規則“NN VB? ?PREV-TAG TO”表示,如果一個單詞被標注為了NN(名詞并且它前面的單詞標注為了TO(不定式“to”),那么將這個單詞的詞性轉換為VB(動詞)

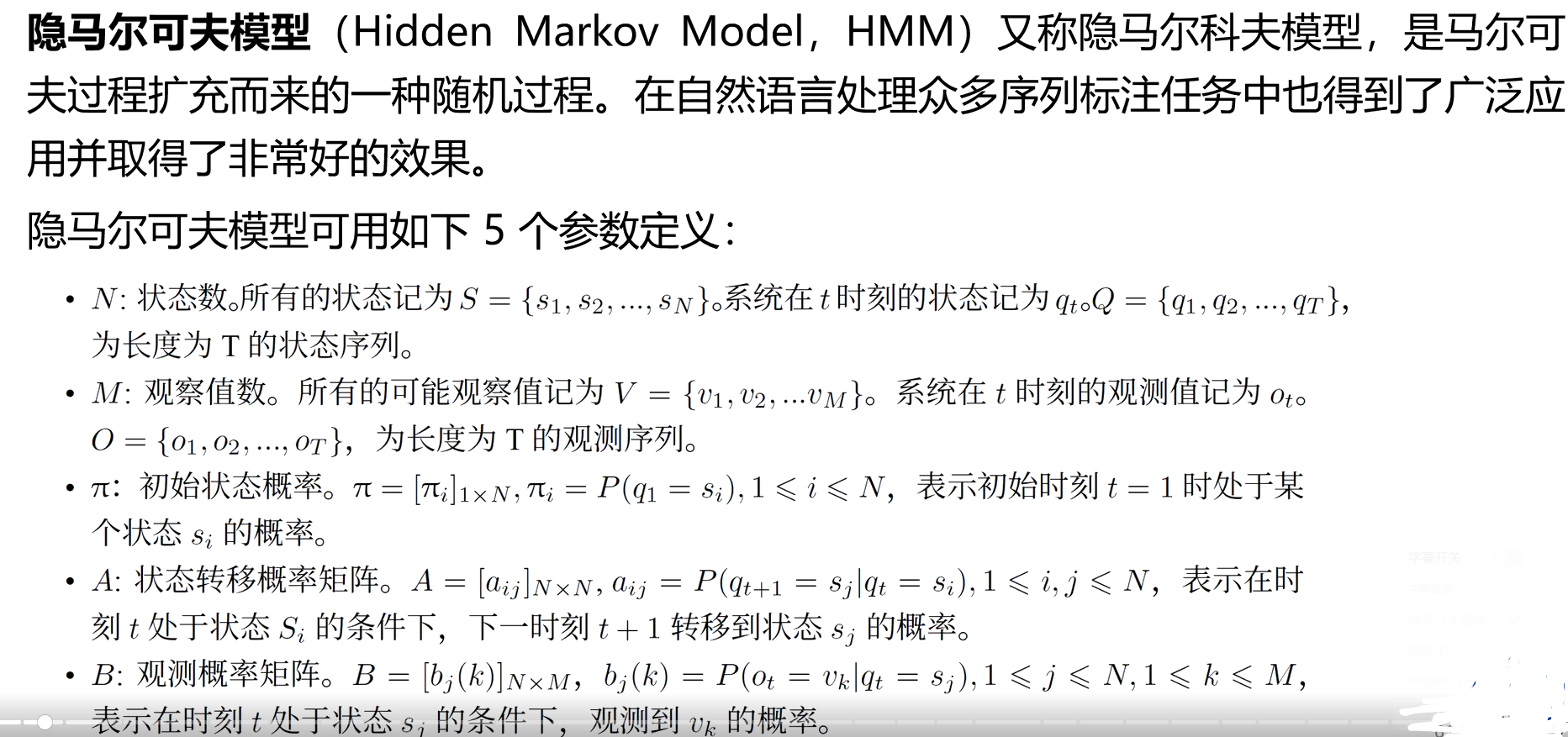

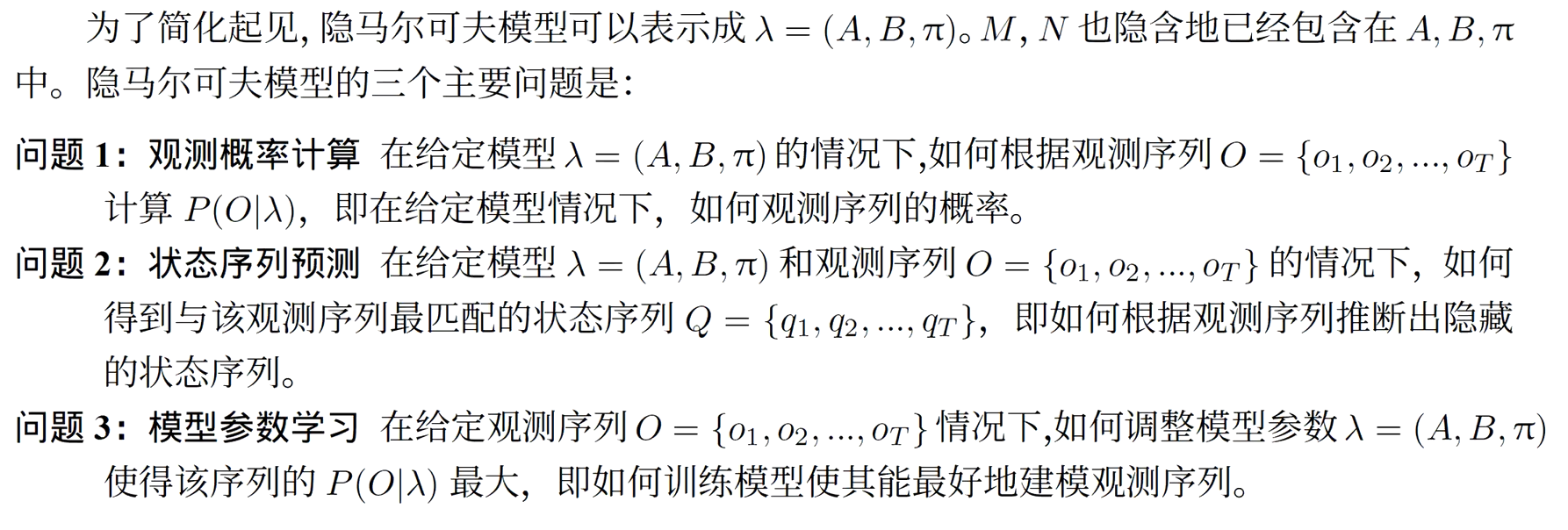

2、基于隱馬爾可夫模型的詞性標注

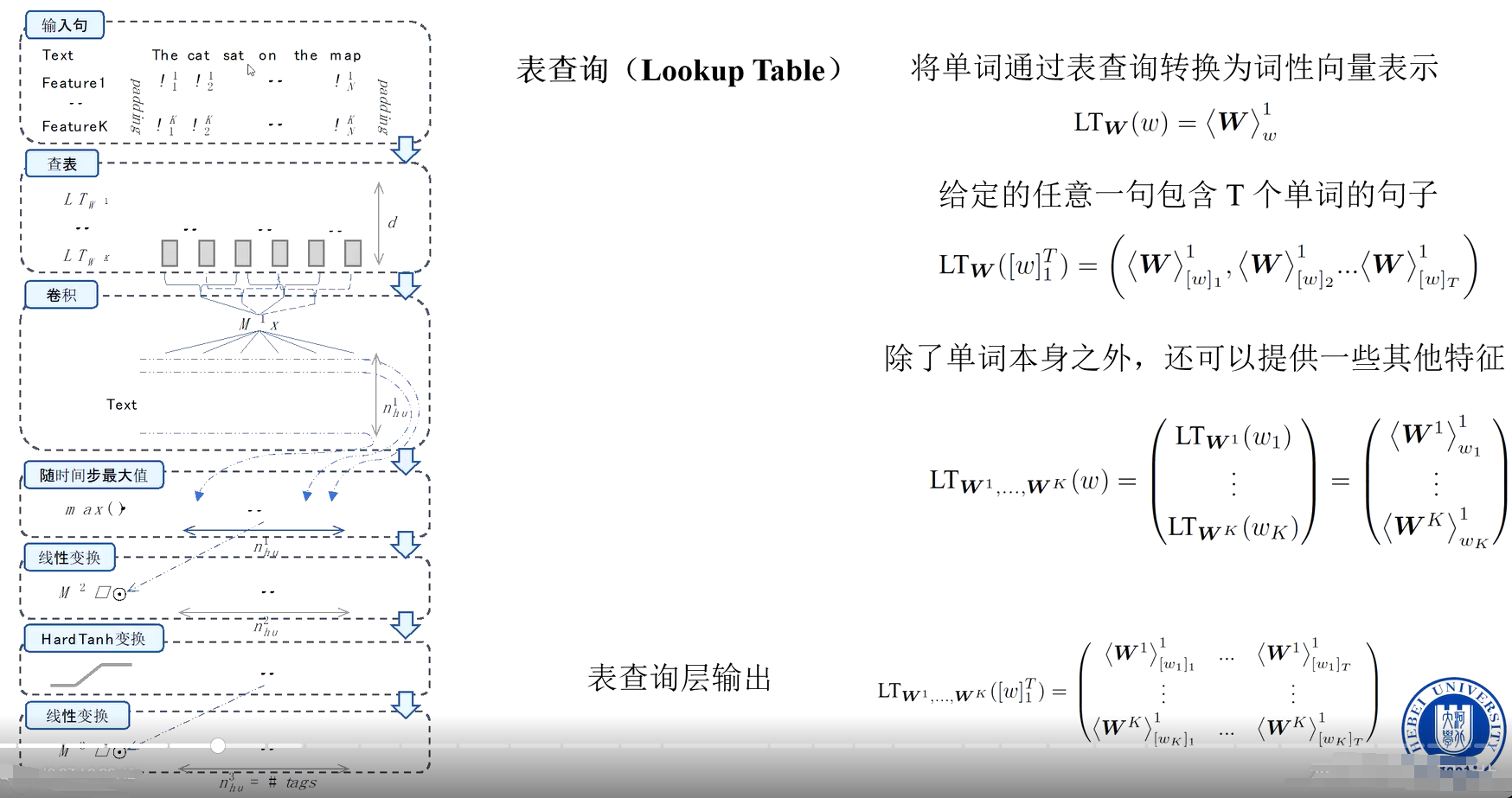

3、基于卷積神經網絡的詞性標注

?輸入層:詞嵌入(Word Embedding)

卷積層:提取局部上下文特征?

池化層:聚合局部特征?

全連接層與輸出層:預測詞性標簽

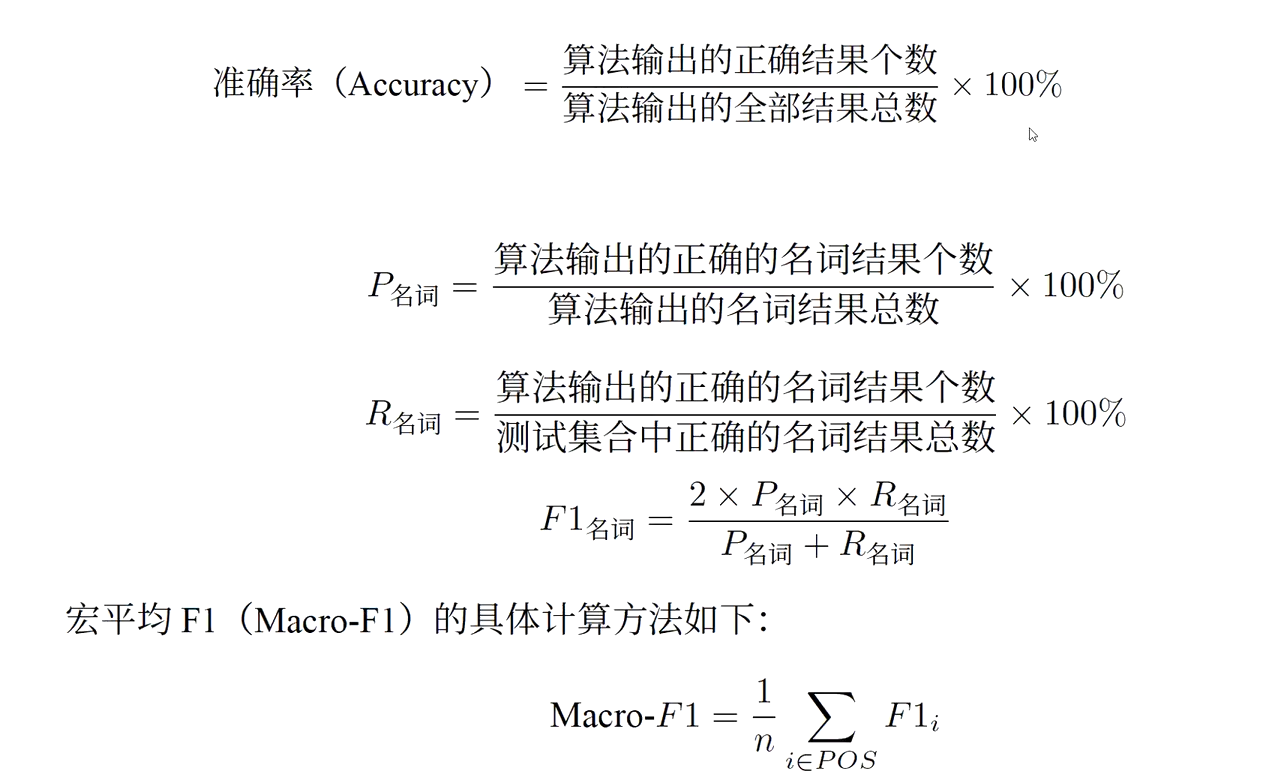

4、詞性標注評價方法

)

)