Spring AI聊天模型API:輕松構建智能聊天交互

前言

在當今數字化時代,智能聊天功能已成為眾多應用程序提升用戶體驗、增強交互性的關鍵要素。Spring AI的聊天模型API為開發者提供了一條便捷通道,能夠將強大的AI驅動的聊天完成功能無縫集成到各類應用中。借助預先訓練的語言模型,如廣為人知的GPT,它能夠依據用戶輸入生成自然流暢、類人化的回復。這一API不僅工作機制高效,而且設計理念極為先進,旨在實現簡單易用與高度可移植性,讓開發者能以極少的代碼改動在不同AI模型間自由切換,充分契合Spring框架一貫秉持的模塊化與可互換性原則。接下來,讓我們深入探索Spring AI聊天模型API的精妙之處。

一、核心接口與類解析

(一)ChatModel接口

ChatModel接口作為核心,定義了與AI模型交互的基本方法。它繼承自Model<Prompt, ChatResponse>,提供了兩個重載的call方法:

public interface ChatModel extends Model<Prompt, ChatResponse> {default String call(String message) {...}@OverrideChatResponse call(Prompt prompt);

}

call(String message)方法簡化了初始使用流程,開發者無需深入了解復雜的Prompt和ChatResponse類即可快速上手,直接傳入簡單字符串消息就能獲得初步響應。然而,在實際開發中,call(Prompt prompt)方法更為常用,它接收封裝好的Prompt實例,返回包含豐富信息的ChatResponse,為復雜業務場景提供了更強大的支持。

(二)StreamingChatModel接口

針對需要實時響應、提升交互即時性的場景,StreamingChatModel接口應運而生。它繼承自StreamingModel<Prompt, ChatResponse>,同樣有兩個stream方法重載:

public interface StreamingChatModel extends StreamingModel<Prompt, ChatResponse> {default Flux<String> stream(String message) {...}@OverrideFlux<ChatResponse> stream(Prompt prompt);

}

與ChatModel類似,stream(String message)簡化了使用,而stream(Prompt prompt)更適用于實際業務。該接口利用響應式編程的Flux API,將AI模型的響應以流的形式逐步返回,讓用戶在輸入后能快速看到部分結果,極大提升了交互體驗,尤其適用于長文本生成或實時聊天場景。

(三)Prompt類

Prompt類承擔著封裝輸入信息的重任,它實現了ModelRequest<List<Message>>接口。其內部包含一個messages列表,用于存儲多條消息,還可以有ChatOptions類型的模型請求選項。主要方法包括獲取選項的getOptions和獲取指令列表的getInstructions。

public class Prompt implements ModelRequest<List<Message>> {private final List<Message> messages;private ChatOptions modelOptions;@Overridepublic ChatOptions getOptions() {...}@Overridepublic List<Message> getInstructions() {...}// constructors and utility methods omitted

}

通過Prompt類,開發者可以靈活組織輸入內容,將不同類型的消息以及對應的模型選項整合在一起,為AI模型提供精準的輸入指令。

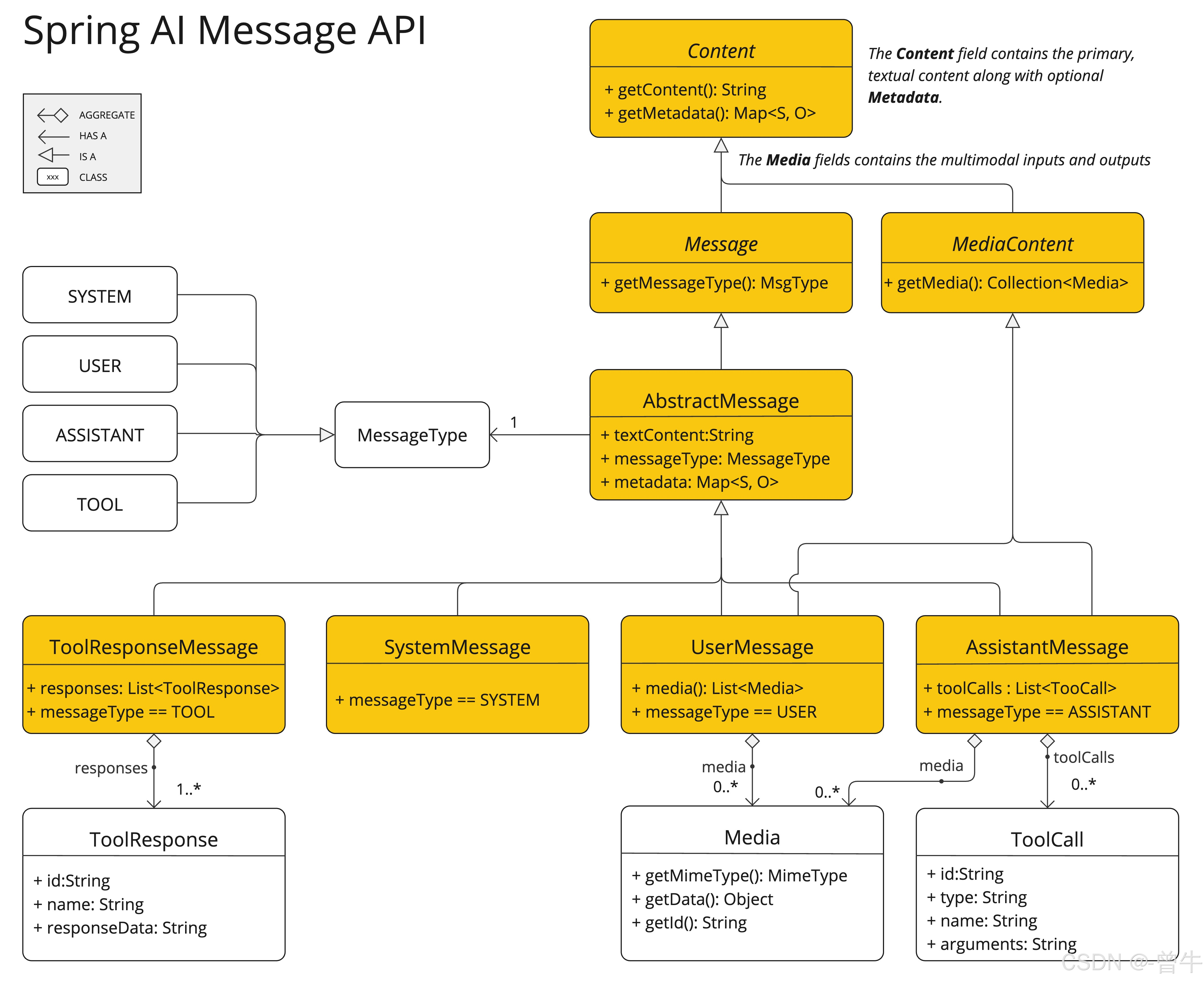

(四)Message接口及相關實現

Message接口用于封裝消息內容、元數據以及消息類型MessageType。它繼承自Content接口,Content接口又定義了獲取文本內容的getText方法和獲取元數據的getMetadata方法。

public interface Content {String getText();Map<String, Object> getMetadata();

}

public interface Message extends Content {MessageType getMessageType();

}

此外,多模態消息類型還實現了MediaContent接口,用于提供媒體內容對象。在實際應用中,不同的AI模型對消息類別有不同的識別方式,例如OpenAI能識別system、user、function、assistant等不同對話角色的消息類別。而對于一些不區分特定角色的AI模型,UserMessage實現類常作為標準類別,代表用戶生成的查詢或指令。這種設計使得Spring AI能夠適配多種類型的AI模型,滿足不同場景下的消息處理需求。

(五)ChatOptions接口

ChatOptions接口繼承自ModelOptions,用于定義可傳遞給AI模型的可移植選項。它包含了諸如獲取模型名稱的getModel、頻率懲罰系數的getFrequencyPenalty、最大生成令牌數的getMaxTokens等一系列方法,還提供了復制選項的copy方法。

public interface ChatOptions extends ModelOptions {String getModel();Float getFrequencyPenalty();Integer getMaxTokens();Float getPresencePenalty();List<String> getStopSequences();Float getTemperature();Integer getTopK();Float getTopP();ChatOptions copy();

}

每個特定的ChatModel或StreamingChatModel實現都可以有自身特有的選項,例如OpenAI聊天完成模型的logitBias、seed和user等選項。Spring AI通過這種設計,允許開發者在啟動應用時設置默認配置,又能在運行時根據每個Prompt請求靈活覆蓋這些設置,極大地提高了配置的靈活性。

(六)ChatResponse類與Generation類

ChatResponse類用于保存AI模型的輸出結果。它包含一個ChatResponseMetadata對象用于存儲模型響應的元數據,以及一個generations列表,每個Generation實例代表單個提示可能產生的多個輸出之一。

public class ChatResponse implements ModelResponse<Generation> {private final ChatResponseMetadata chatResponseMetadata;private final List<Generation> generations;@Overridepublic ChatResponseMetadata getMetadata() {...}@Overridepublic List<Generation> getResults() {...}// other methods omitted

}

Generation類則繼承自ModelResult<AssistantMessage>,它包含一個assistantMessage用于表示模型輸出的內容,以及ChatGenerationMetadata類型的元數據。

public class Generation implements ModelResult<AssistantMessage> {private final AssistantMessage assistantMessage;private ChatGenerationMetadata chatGenerationMetadata;@Overridepublic AssistantMessage getOutput() {...}@Overridepublic ChatGenerationMetadata getMetadata() {...}// other methods omitted

}

這兩個類相互配合,完整地將AI模型的輸出結果結構化,方便開發者獲取和處理模型生成的內容及相關信息。

這Messageinterface 具有各種實現,這些實現對應于 AI 模型可以處理的消息類別:

二、可用實現與框架優勢

Spring AI聊天模型API支持多種來自不同提供商的AI聊天模型,如OpenAI聊天完成(具備流媒體、多模式和函數調用支持)、Microsoft Azure Open AI Chat Completion(支持直播和函數調用)、Ollama聊天完成(支持流媒體、多模態和函數調用)、Hugging Face Chat完成(不支持流式傳輸)、Google Vertex AI Gemini聊天完成功能(支持流式、多模態和函數調用)、Amazon Bedrock、Mistral AI聊天完成(支持流媒體和函數調用)、Anthropic Chat Completion(支持流媒體和函數調用)等。這種廣泛的支持使得開發者能夠根據項目需求、預算以及對功能特性的要求,靈活選擇最適合的AI模型。同時,Spring AI提供了一套復雜而靈活的系統來配置和使用聊天模型。在啟動時,開發者可以設置默認配置,而在運行時,又能依據每個請求動態覆蓋這些設置,所有操作都在Spring AI框架提供的統一接口中完成,極大地提高了開發效率和系統的可維護性。

三、配置與執行流程

Spring AI處理聊天模型的配置和執行流程設計精妙。在啟動階段,ChatModel或StreamingChatModel會使用“啟動”聊天選項進行初始化,這些選項為模型提供了默認配置。在運行時,每個請求的Prompt可以包含運行時聊天選項,這些選項能夠覆蓋啟動時設置的默認選項。在實際執行過程中,會先進行“合并選項”操作,將啟動選項和運行時選項結合起來,若有運行時選項,則其優先級高于啟動選項。接著,“轉換輸入”步驟會將輸入指令轉換為特定模型的原生格式,以便模型能夠理解和處理。模型處理完成后,“Convert Output”步驟會將模型的響應轉換為標準化的ChatResponse格式,方便應用程序后續使用。這種啟動和運行時選項分離的設計,既保證了全局配置的穩定性,又提供了針對特定請求的靈活調整能力。

以程圖說明了 Spring AI 如何處理聊天模型的配置和執行,并結合了啟動和運行時選項:

四、基于Spring AI通用模型API構建

Spring AI聊天模型API構建在Spring AI的通用模型API之上,它充分利用了通用模型API的基礎能力,在此之上提供了特定于聊天場景的抽象和實現。這種設計使得不同AI服務之間的集成和切換變得輕松自如,同時為客戶端應用程序始終保持一致的API,極大地降低了開發者在不同AI模型間切換的成本,提高了代碼的可復用性和可維護性。

此圖說明了統一接口ChatModel和StreamingChatModel用于與來自不同提供商的各種 AI 聊天模型進行交互,從而允許在不同的 AI 服務之間輕松集成和切換,同時為客戶端應用程序保持一致的 API。

總結

Spring AI的聊天模型API無疑是開發者在構建智能聊天應用時的得力助手。它憑借豐富且靈活的接口設計,支持多種主流AI模型,為開發者提供了廣闊的選擇空間;獨特的配置與執行流程,兼顧了全局配置的穩定性與請求級別的靈活性;構建于通用模型API之上的架構,又確保了不同AI服務集成與切換的便捷性。通過使用Spring AI聊天模型API,開發者能夠高效地將智能聊天功能融入應用程序,為用戶帶來更加自然、流暢的交互體驗。無論是開發智能客服系統、在線教育輔導工具,還是社交聊天應用,Spring AI聊天模型API都能助力開發者快速實現創新想法,在智能交互領域邁出堅實步伐。期待開發者們在這一強大API的支持下,創造出更多令人驚艷的智能聊天應用。

)

![每日c/c++題 備戰藍橋杯(洛谷P1015 [NOIP 1999 普及組] 回文數)](http://pic.xiahunao.cn/每日c/c++題 備戰藍橋杯(洛谷P1015 [NOIP 1999 普及組] 回文數))