本文選自gongzhonghao【圖靈學術SCI論文輔導】

關注我們,掌握更多頂會頂刊發文資訊

今天,為大家推薦一個極具前沿價值與實用潛力的研究方向:圖神經網絡(GNN)。作為深度學習領域的新興力量,圖神經網絡在近年頂會論文中的占比持續攀升,尤其在圖結構數據建模、跨模態關系推理和復雜系統優化等核心領域表現亮眼。這些研究通過挖掘節點間的拓撲關聯與動態交互,顯著提升了模型對非歐幾里得數據的表征能力與泛化性能。

圖神經網絡不僅能高效處理社交網絡、分子結構和知識圖譜等復雜關系數據,更因其強大的結構適應性,在藥物研發、金融風控、智慧交通和工業設計等多元化場景中實現技術突破。這一方向兼具理論深度與應用廣度,是推動下一代人工智能的關鍵引擎。

下面小圖給大家精選3篇CVPR圖神經網絡方向的論文,請注意查收!

Image Processing GNN: Breaking Rigidity in Super-Resolution

方法:

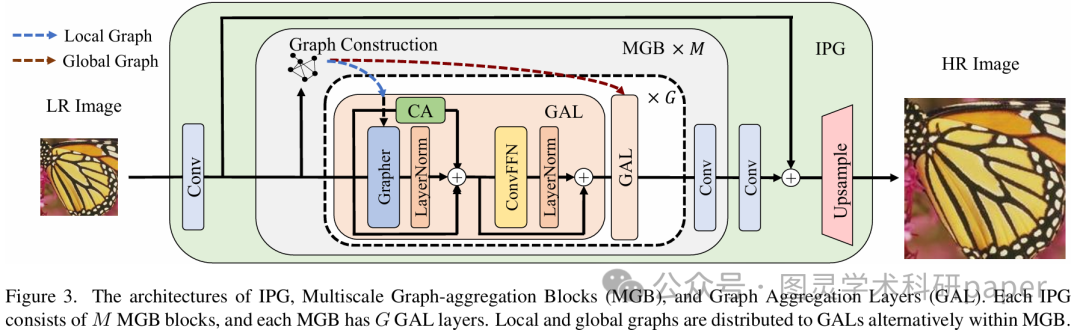

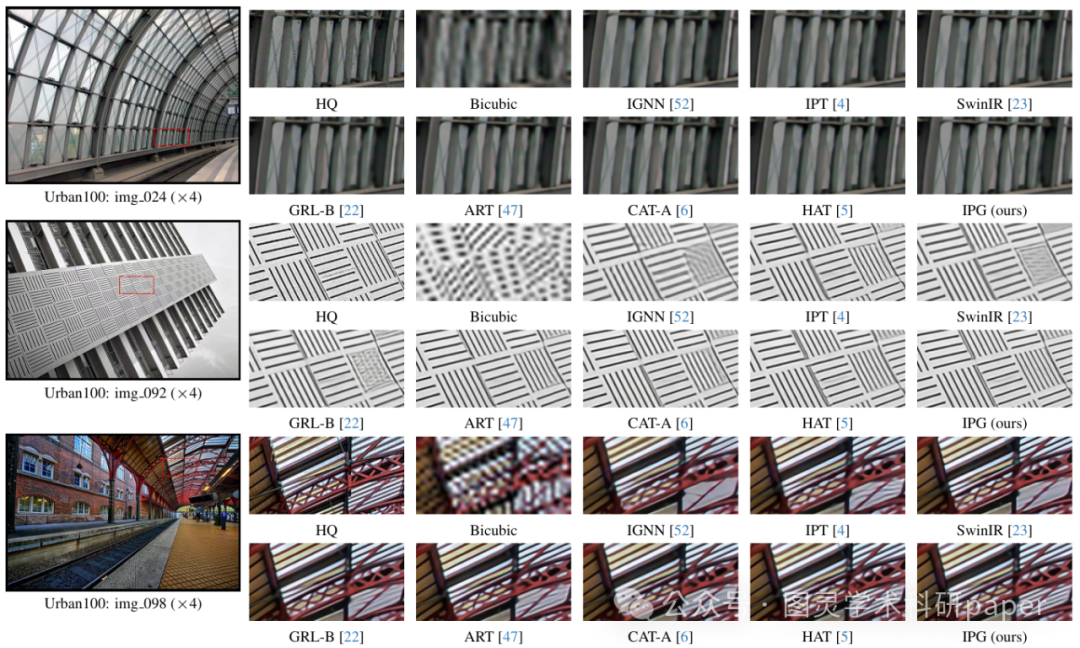

文章首先通過設計細節豐富度指標來衡量圖像節點的重要性,并據此為高頻率節點分配更高的度數,從而構建出度數靈活的圖。接著,將圖像視為像素節點集合而非圖像塊節點集合,避免了圖像塊剛性帶來的錯位問題。最后,通過在局部鄰域內搜索節點連接構建局部圖,以及在全圖的稀疏采樣空間內搜索節點連接構建全局圖,實現了局部和全局信息的高效聚合,從而提升了超分辨率性能。

創新點:

提出了基于細節豐富度的度數可變圖構建方案,打破了傳統方法中所有像素聚合鄰域數量固定的剛性限制,使細節豐富的像素能夠聚合更多相關信息,從而更好地重建圖像細節。

首次在超分辨率任務中采用像素節點代替圖像塊節點構建圖,避免了圖像塊剛性帶來的錯位問題,提升了圖聚合的靈活性和準確性。

設計了局部和全局圖采樣策略,同時利用局部和全局信息進行超分辨率重建,兼顧了細節重建的局部需求和全局特征的利用,在保持效率的同時提升了超分辨率性能。

論文鏈接:

https://ieeexplore.ieee.org/document/10658586

GreedyViG: Dynamic Axial Graph Construction for Efficient Vision GNNs

方法:

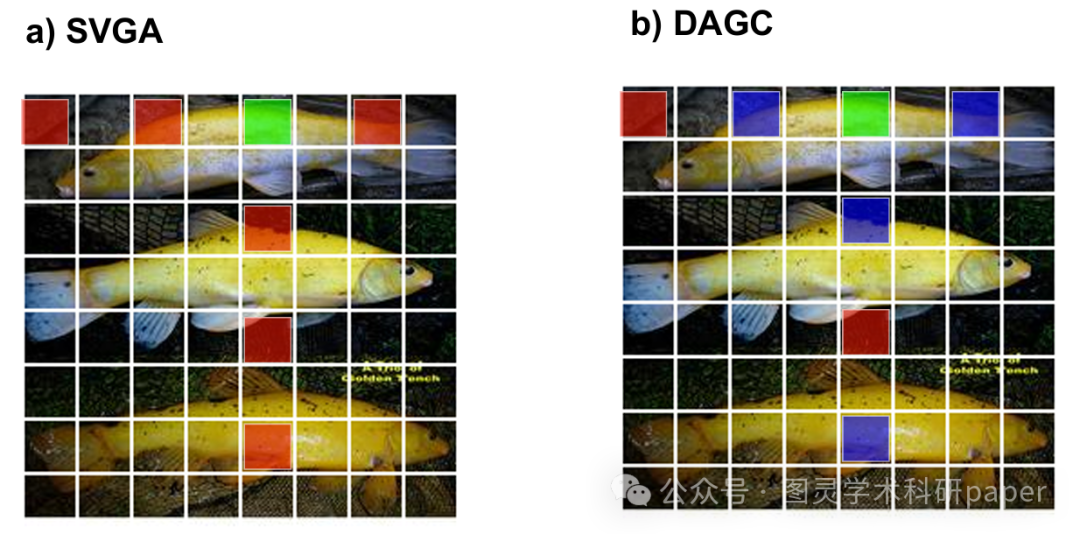

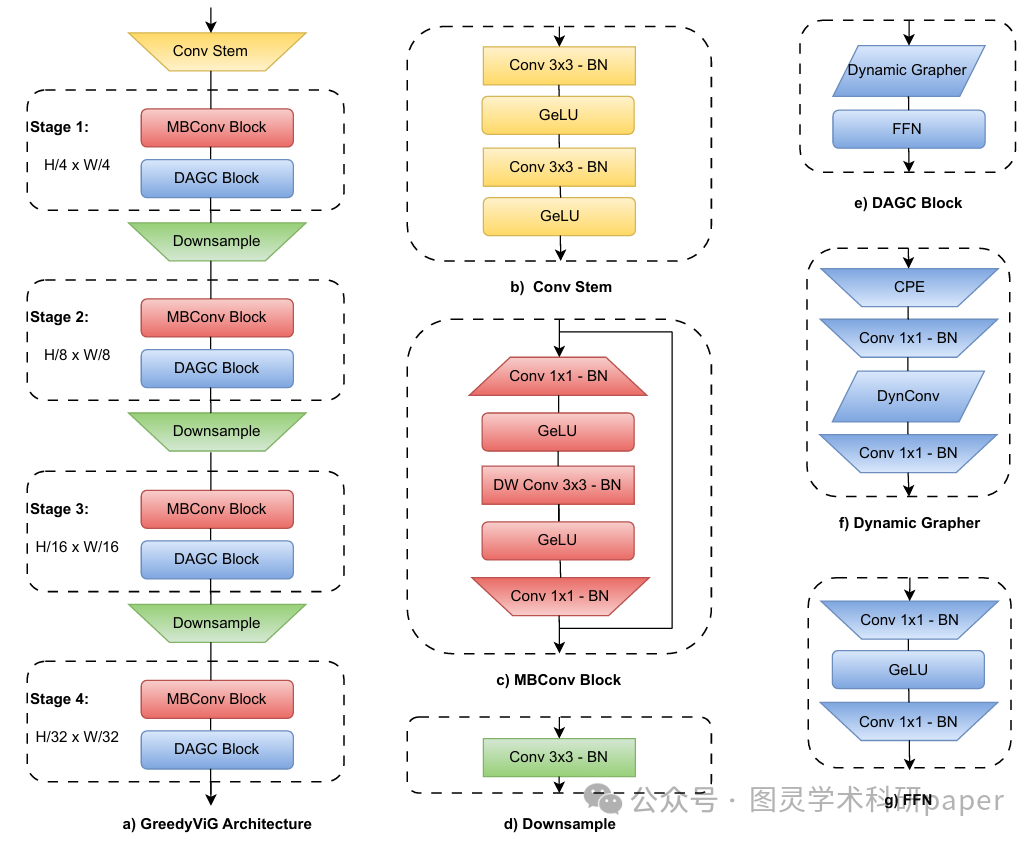

文章首先介紹了動態軸向圖構建(DAGC)算法,該算法基于圖像塊之間的歐幾里得距離的均值和標準差動態構建圖,避免了KNN算法中對每個節點都進行最近鄰搜索的高計算成本。接著,文章詳細描述了如何將DAGC算法整合到GreedyViG架構中,通過在每個階段結合卷積層和圖卷積層,實現了對圖像的局部和全局特征的高效處理。最后,通過在ImageNet-1K、COCO和ADE20K等數據集上的實驗驗證了GreedyViG的性能,證明了其在多個任務上的優越性。

創新點:

提出了動態軸向圖構建(DAGC)方法,相比傳統的KNN圖構建方式,DAGC通過限制圖像內圖連接的數量,僅保留最重要的連接,顯著提高了計算效率。

設計了GreedyViG架構,這是一種新穎的CNN-GNN混合架構,結合了條件位置編碼(CPE)和最大相對圖卷積,能夠在不同分辨率下同時進行局部和全局信息處理。

在多個視覺任務(如圖像分類、目標檢測、實例分割和語義分割)上進行了廣泛的實驗,GreedyViG在準確率、參數數量和計算量(GMACs)方面均優于現有的ViG、CNN和ViT架構。

論文鏈接:

https://ieeexplore.ieee.org/document/10656295

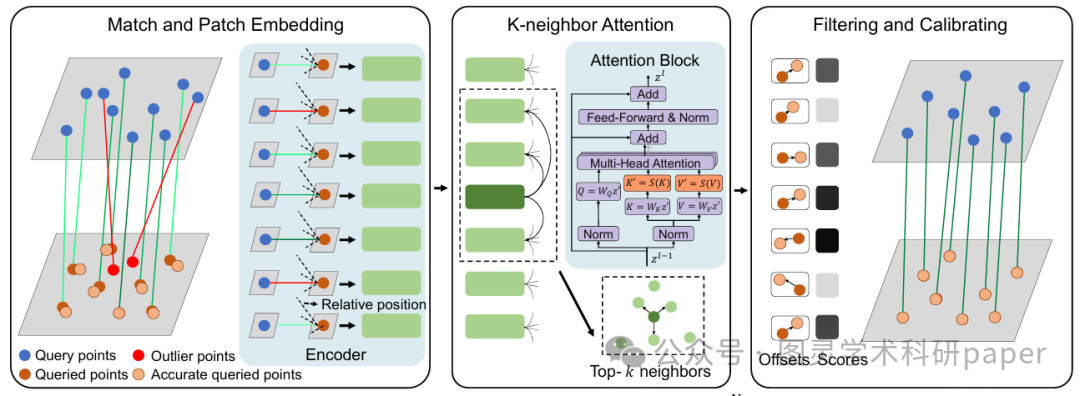

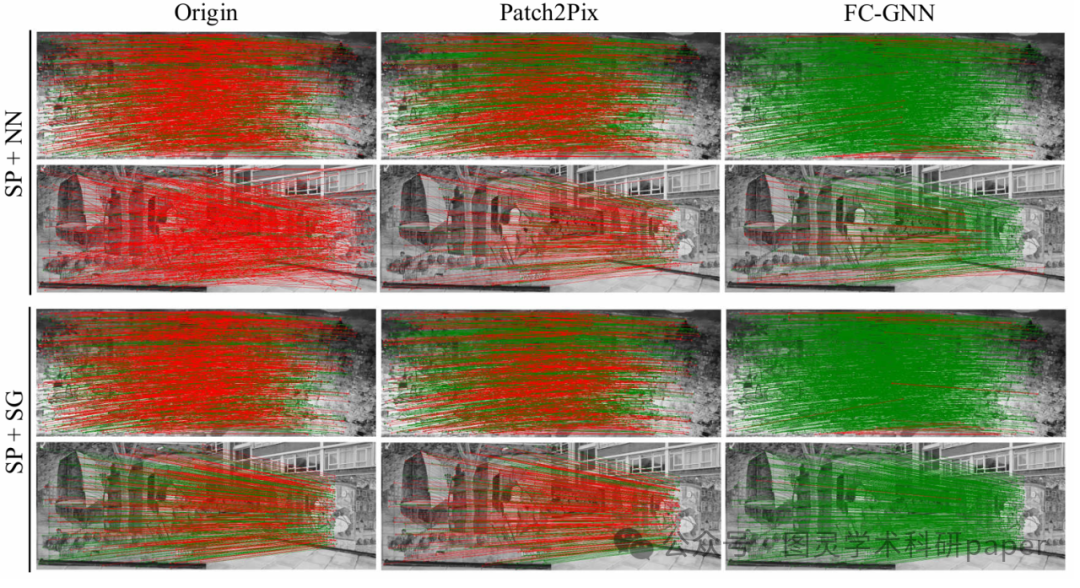

FC-GNN: Recovering Reliable and Accurate Correspondences from Interferences

方法:

文章首先定義了匹配優化問題,將其分解為異常值剔除和不準確匹配校準兩個子問題,然后設計了FC-GNN網絡架構,利用相對位置編碼和局部圖像塊嵌入來提取匹配和局部紋理信息,并通過k-鄰域自注意力機制逐步擴展感受野,最后通過兩個解碼器分別輸出匹配的置信度分數和校準偏移量,以實現聯合過濾和校準。

創新點:

提出了一種新穎的聯合過濾和校準(Filtering and Calibrating, FC)方法,能夠同時剔除具有較大誤差的異常值,并優化具有較小誤差的不準確匹配,從而提高匹配的可靠性和準確性。

構建了基于注意力機制的圖神經網絡(FC-GNN),通過結合上下文信息和局部圖像紋理,有效整合局部和全局信息,以減少匹配不確定性,并降低計算復雜度。

通過實驗驗證了該方法在多種匹配流程和不同任務中的顯著性能提升,證明了其作為圖像匹配標準優化組件的巨大潛力。

論文鏈接:

https://ieeexplore.ieee.org/document/10656277

本文選自gongzhonghao【圖靈學術SCI論文輔導】

關注我們,掌握更多頂會頂刊發文資訊

(有視頻演示))

)

詳解)

5G、太空和統一網絡)

的題目類型、知識點及難度總結)