目錄

一、InternVL1.5

1、改進

二、InternVL2

1、漸進式擴展

2、多模態擴展

三、InternVL2.5

1、方法

2、數據優化

四、InternVL3

2、方法

3、訓練后處理

4、測試時擴展

五、BLIP-3o

一、InternVL1.5

1、改進

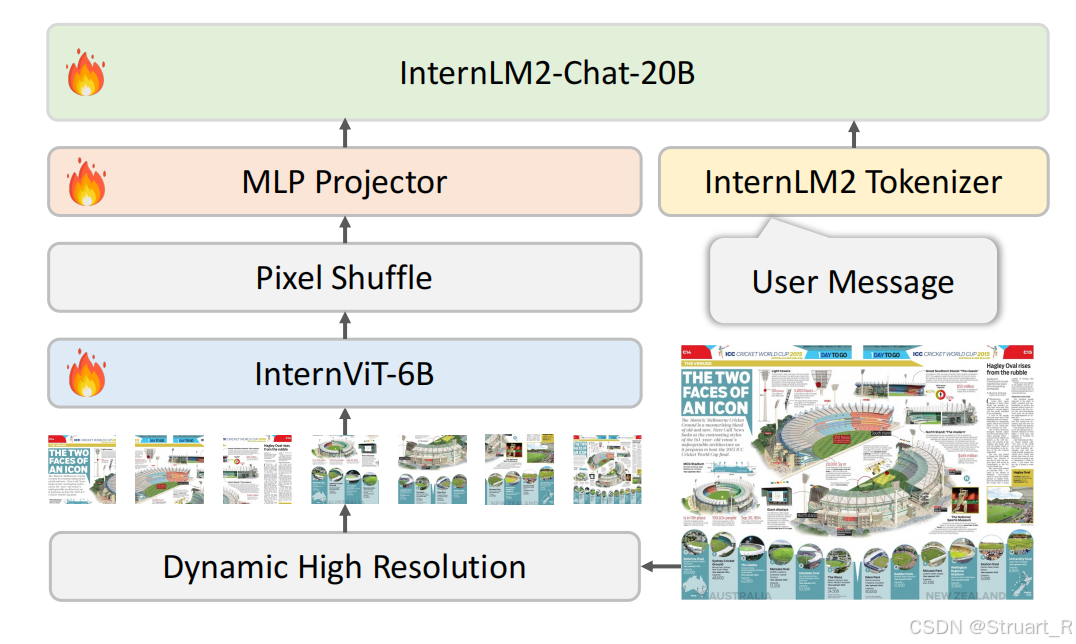

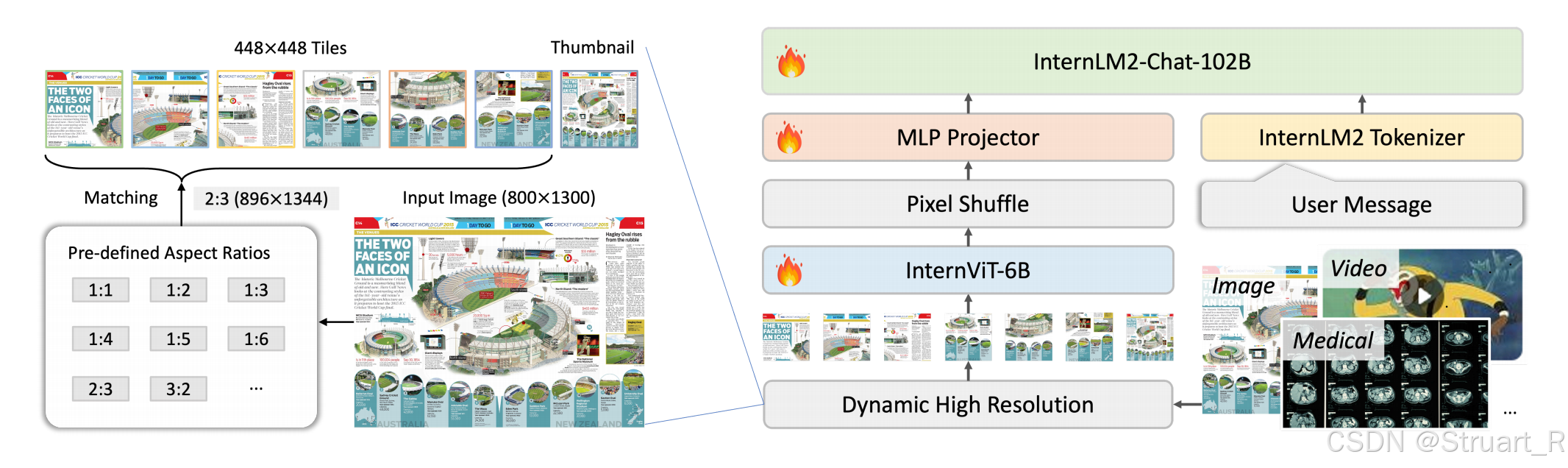

? ? ? ? InternVL1.5在InternVL基礎上,優化了QLLaMA中間件,轉而采用簡單的MLP作為圖文對齊的橋梁。

? ? ? ? 視覺編碼器:將InternViT-6B的層數從48層優化到45層,并且通過連續學習策略提升視覺理解能力,在高質量圖文數據上微調,處理高分辨率圖像(448x448)

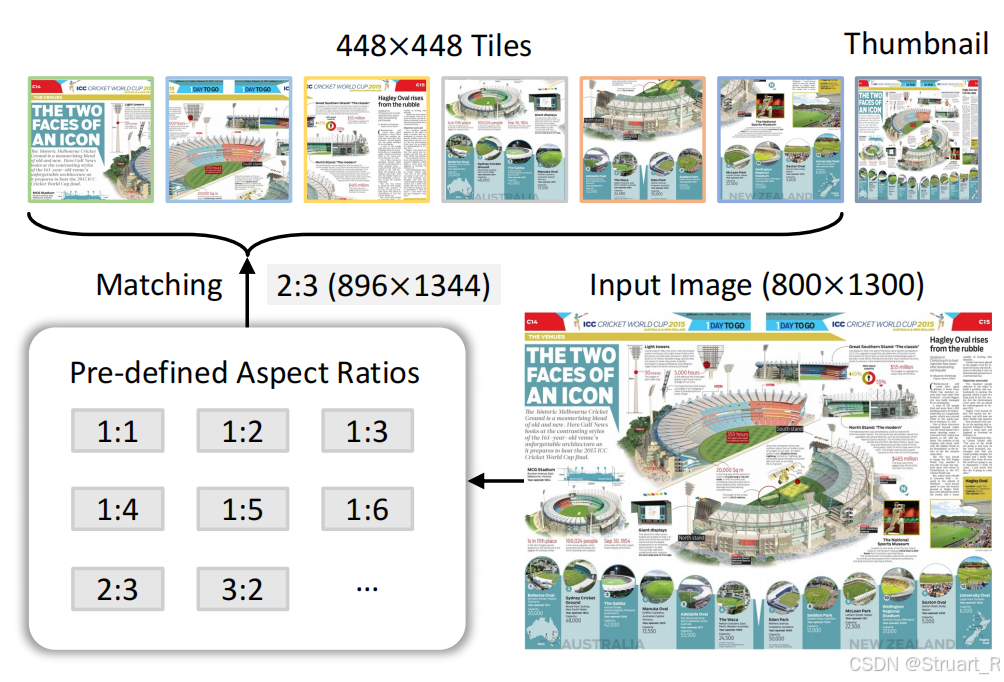

? ? ? ? 動態高分辨率:根據輸入圖像寬高比和分辨率,將圖像分割為1到40個448x448的圖塊,最高支持4K分辨率輸入。(低分辨率用于場景描述,高分辨率用于文檔理解)。訓練過程中先使用224x224的分辨率進行訓練,再使用448x448分辨率訓練。

? ? ? ? Pixel Shuffle:為提升高分辨率的擴展性,將像素隨機排列為visual tokens數量降低到原來的四分之一。

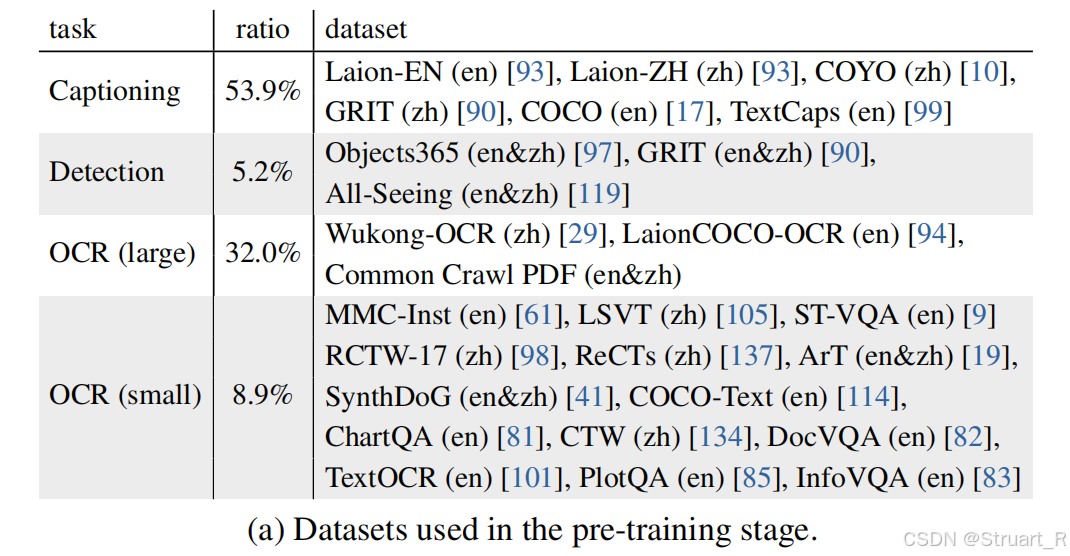

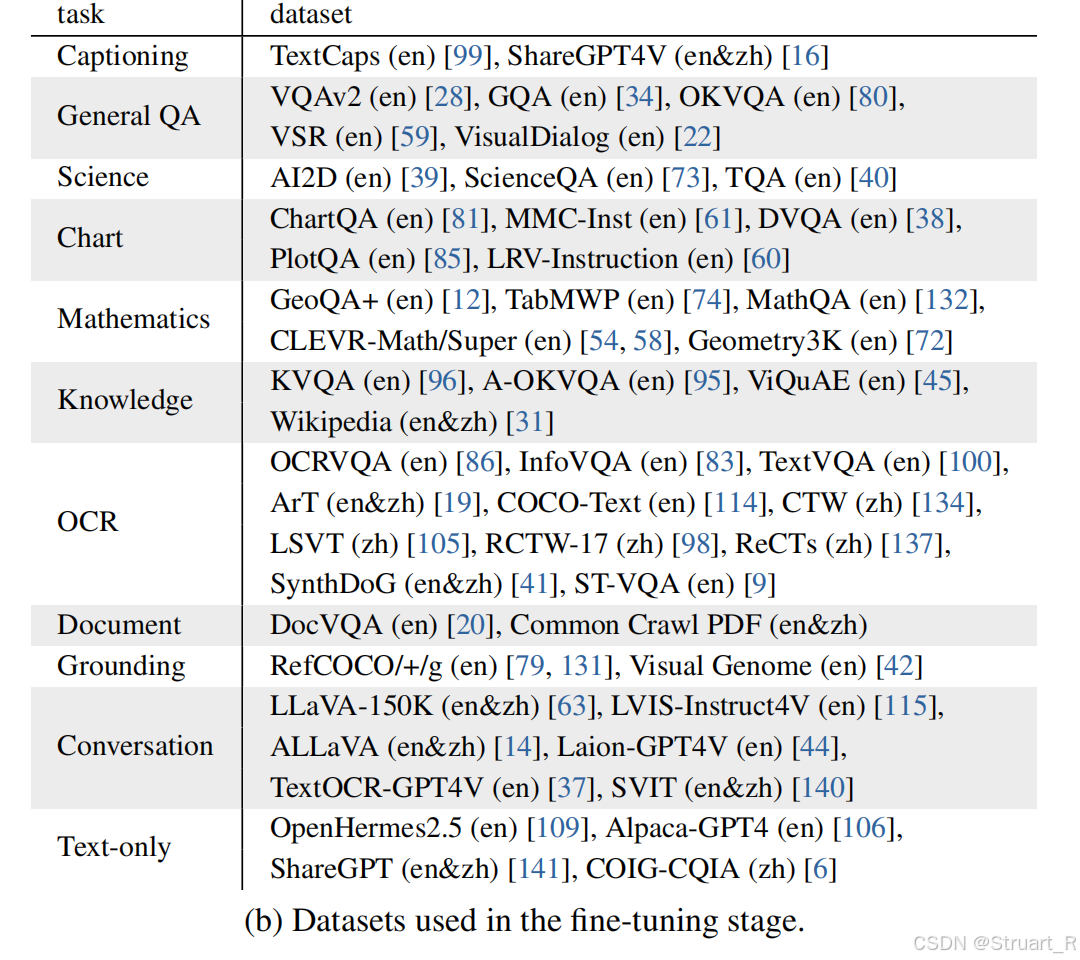

? ? ? ? 訓練過程包含預訓練+微調兩步,預訓練數據采用海量互聯網公開數據集弱標注圖文對,采用雙語數據,數億級別,只訓練InternViT-6B和MLP。微調部分數據包含文檔解析、數學推理、多輪對話多任務,百萬級別數據量,對所有260億參數進行全參數調整,確保模態對齊。上下文均為4096tokens。

?????????在InternVL1.2與LLaVA-NeXT對比中提到,二者的LLM部分參數量一致均為34B,vision encoder部分InternVL1.2采用InternViT-6B的6B參數量,LLAVA-NeXT采用CLIP-ViT約300M。由于LLAVA-NeXT訓練數據集未公開,所以自己做了一個相似數據集,但由于框架本身問題,LLaVA-NeXT采用了672x672的分辨率,InternVL采用448x448的分辨率。經過作者的訓練過后,InternVL1.2在更多的Benchmark下更優,證明了大的vision encoder 參數量可以支撐更復雜的推理的特征信息。

? ? ? ? InterVL1.5在OCR任務中效果可以與GPT-4V,Qwen-VL-Max,Gemini ultra1.0這些方法競爭,在多模態評估問題上,還是站不太住。

二、InternVL2

? ? ? ? InternVL2在InternVL1.5架構基礎上,針對更多模態,更多任務,更大參數量進行了擴展。InternVL2系列也是從2B參數量到108B參數量適應不同的場景應用。

1、漸進式擴展

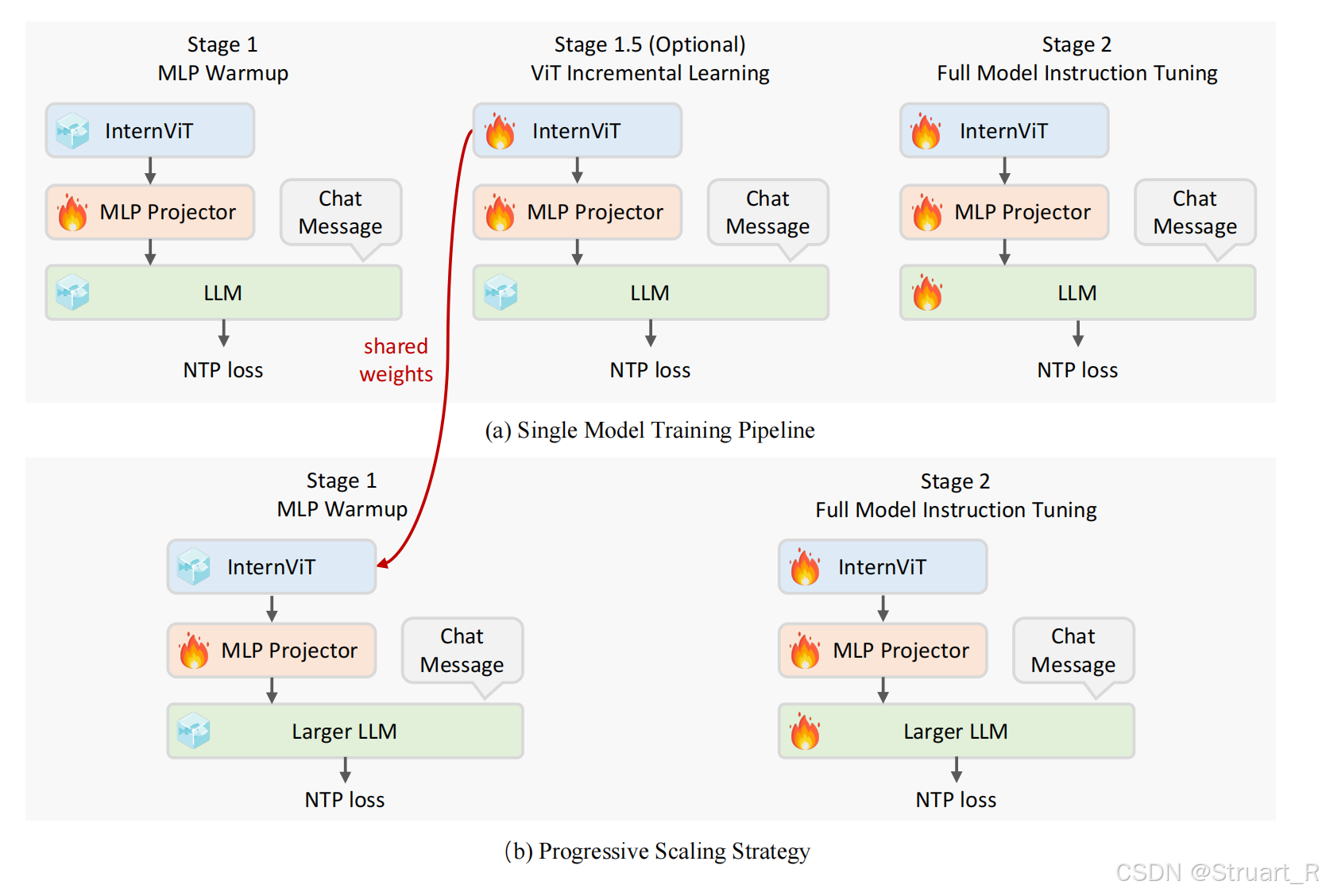

? ? ? ? 采用從小模型到大模型漸進訓練,數據從粗到精迭代的策略。通過這種方式顯著降低了大模型訓練成本,并且在有限資源下實現高性能。具體來說,先用小規模語言模型(20B參數)訓練視覺編碼器InternViT,之后將視覺編碼器遷移到大規模LLM上,通過這種機制訓練效率提升十倍,參數量更大。(這一部分在InternVL2.5論文才提到)

? ? ? ? 另外提到InternVL2首次實現視覺基礎模型與大語言模型的原生對齊。(由于沒有論文只有一個technical log不太懂)

2、多模態擴展

? ? ? ? 支持文本、圖像、視頻、醫療數據統一輸入,并且在以往1.5版本聚焦圖文雙模態的基礎上,增加了視頻理解和醫療數據解析。

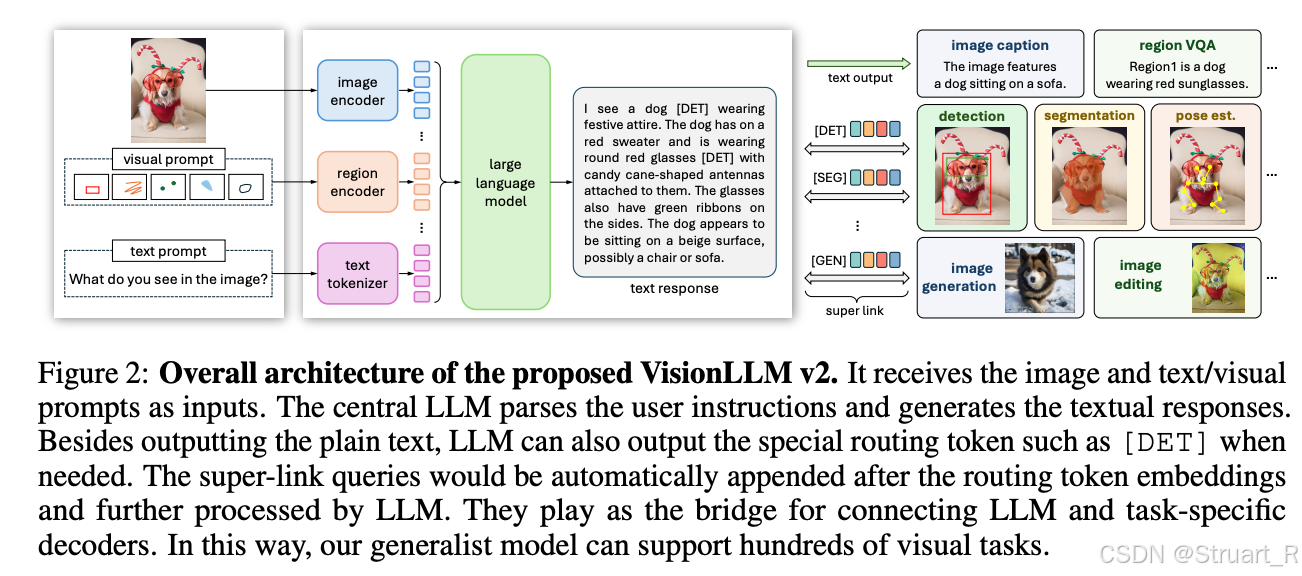

? ? ? ? 支持下游任務泛化,通過VisionLLMv2框架鏈接下游任務解碼器支持圖像生成、檢測框、分割掩碼等多樣化輸出。VisionLLMv2框架圖如下。

? ? ? ? InternVL2的訓練第一階段應該是凍結了InternViT,只訓練MLP,第二階段依然是全參數微調。?

三、InternVL2.5

? ? ? ? InternVL2.5的架構如出一轍,他的改進在于訓練過程和數據。

1、方法

? ? ? ? 訓練過程:由于InternVL2采用的漸進式訓練,所以已經預訓練了InternViT。第一部分訓練MLP,第二部分訓練InternViT+MLP,第三部分訓練所有參數。

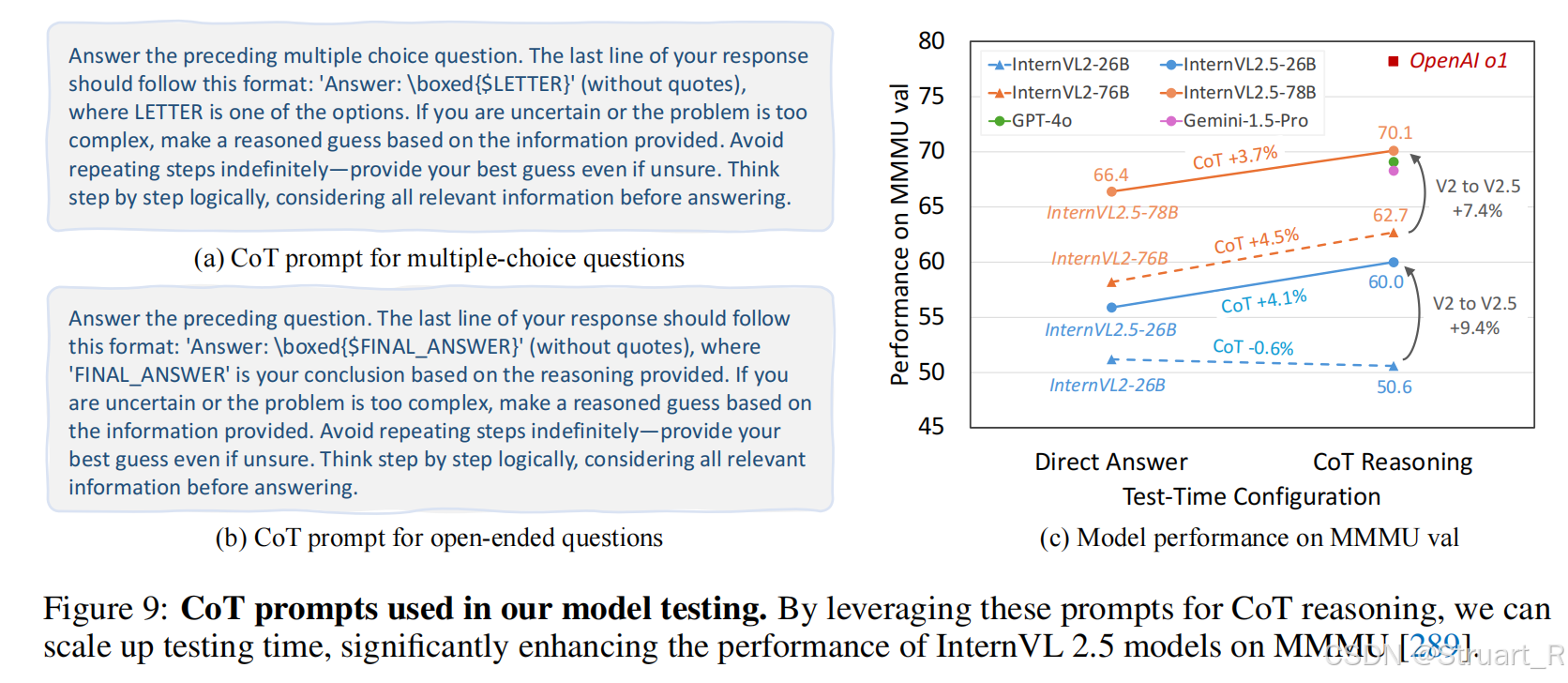

?????????測試時擴展:test-time scaling,在推理階段動態調整模型行為,通過多次生成結果優化最終輸出。通過CoT+Majority Voting實現。通過這種方式,多步驗證降低大模型illusion,尤其是在復雜數學問題,長文檔分析上。

? ? ? ? ?思維鏈推理:CoT,Chain-of-Thought,通過多步邏輯推理生成答案,并模擬人類逐步分析問題的過程。在提示詞中要求模型先解釋推理步驟,再給出最終答案。

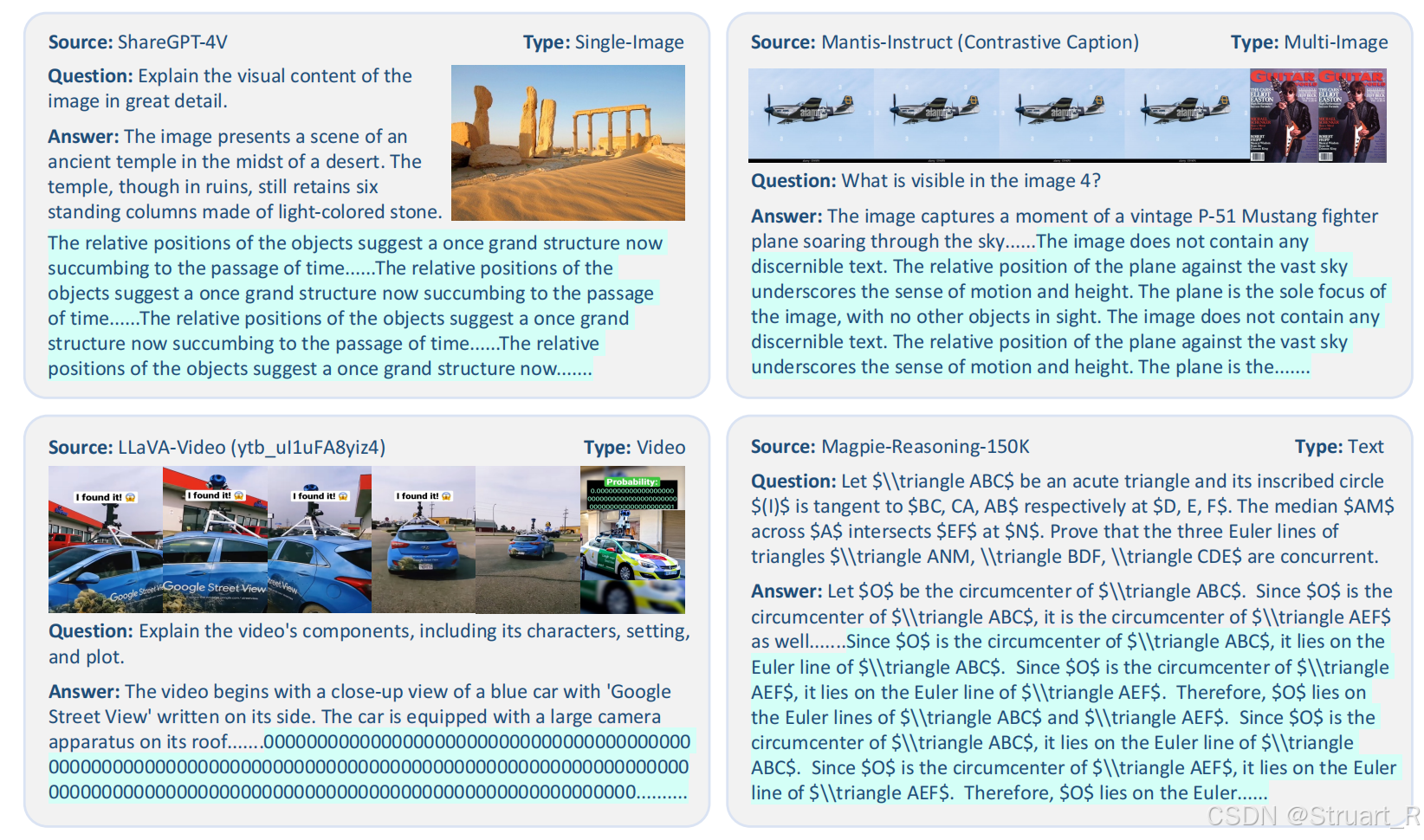

2、數據優化

? ? ? ? 盡管CoT在推理階段執行,但是其效果高度依賴訓練數據的質量,低質量的數據會導致模型在CoT推理過程中陷入循環錯誤。?以往推理循環的表現如下。

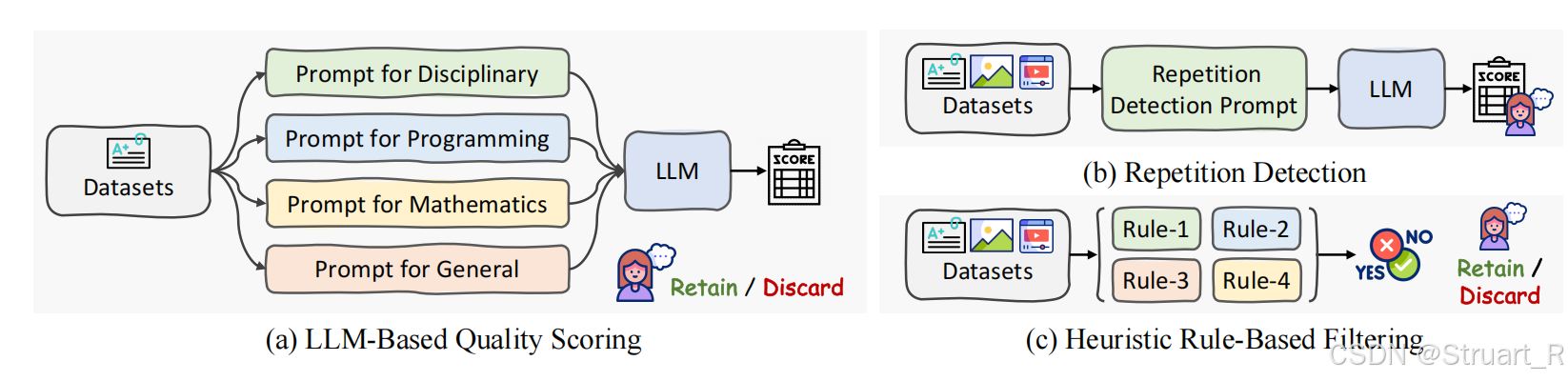

? ? ? ? InternVL2.5解決辦法,文本數據通過嚴格過濾訓練數據,使用LLM評分來剔除低質量樣本,多模態數據采用啟發式規則+人工審核的方式。

? ? ? ? 圖像數據

(1)動態切片機制:根據輸入圖像的寬高比和分辨率,動態劃分為448x448的像素切片,范圍在1-40,每一張圖片根據最接近的最優寬高比進行最小化失真,最優寬高比為預定義的35種組合(1:1,2:1,3:2等)

(2)多模態數據統一:由于在對話中可以輸入單圖,多圖,視頻數據,所以進行了統一,對于單圖數據,多圖數據均進行動態切片劃分,單圖分割為12個切片+全局縮略圖,多圖分割為總切片12個切片。視頻數據簡化操作,固定每幀分辨率448x448保證顯存承受壓力,由于幀數過多,放棄動態切片,用全局理解替換犧牲細節。

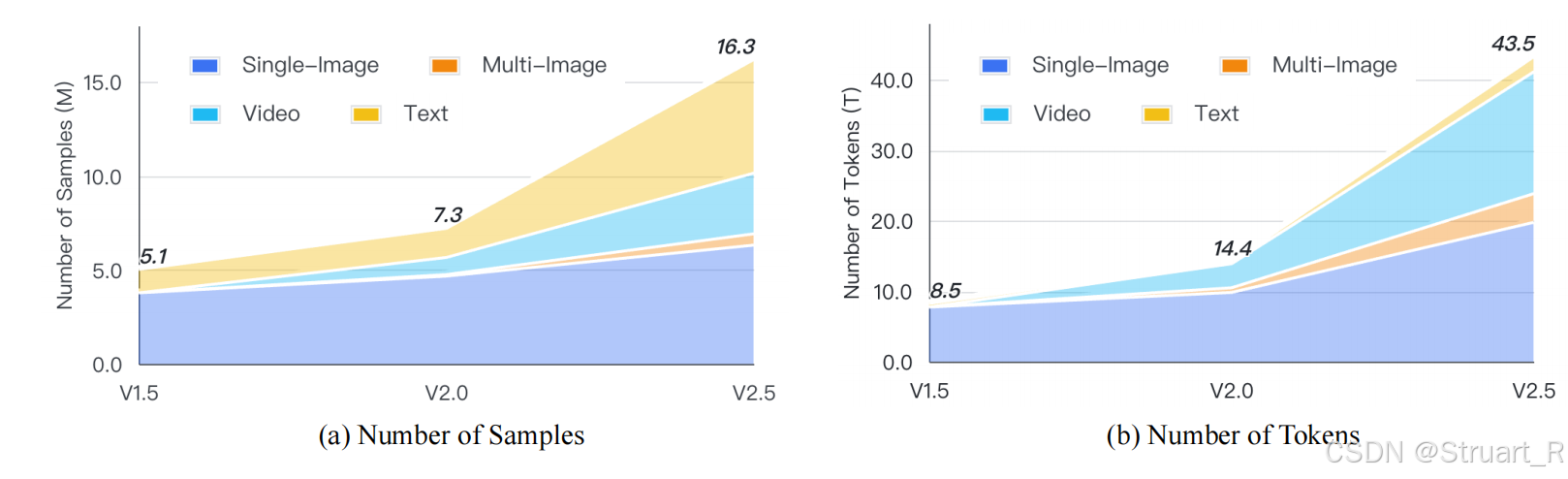

? ? ? ? 數據量從v1.5到v2.5是逐漸增長的。

? ? ? ? 通過這一設計InternVL2.5,OCR,多圖片理解,多模態理解和幻覺處理,視覺定位,多模態多語言性能,視頻理解等任務均達到SOTA。

? ? ? ? 另外InternViT2.5在圖像分類,圖像分割指標上也超過以往的1.0,1.2,1.5,2.0,主要是因為參數量,訓練數據量擴展。

四、InternVL3

1、概述

? ? ? ? 以往的InternVL系列都是先訓練LLM模塊,再將LLM改造成可以支持輸入多模態信息的MLLM的“先純文本預訓練->后多模態對齊”的分階段流程。而InternVL3是通過單階段聯合訓練范式的原生預訓練,解決了以往MLLM訓練后處理的視覺和語言一致性和復雜性挑戰,提升了性能和擴展性。這也是第一個原生多模態模型。

? ? ? ? 創新:可變視覺位置編碼,以適應更長的多模態上下文。后訓練策略SFT+MPO,test-time縮放原則提升了性能和效率。

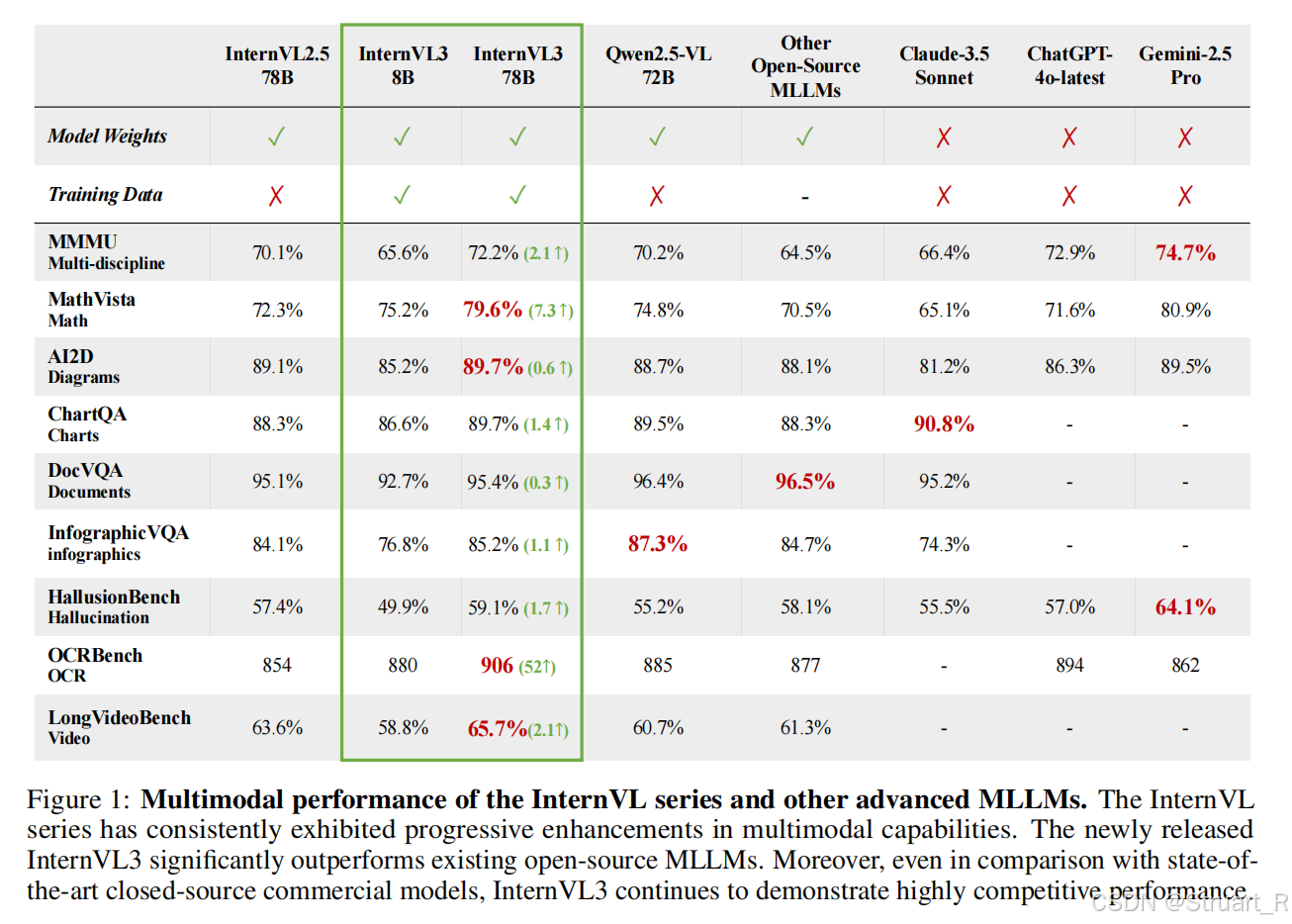

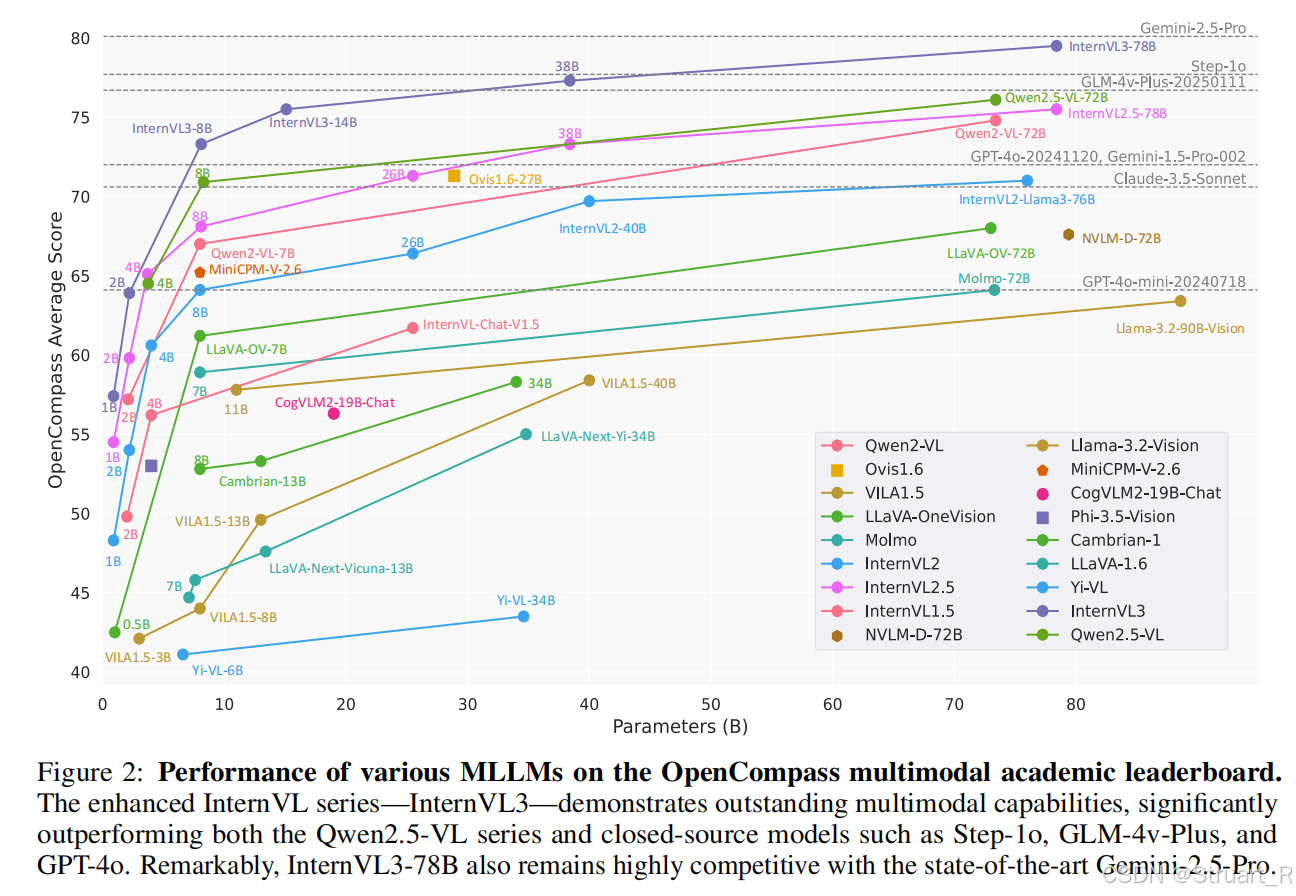

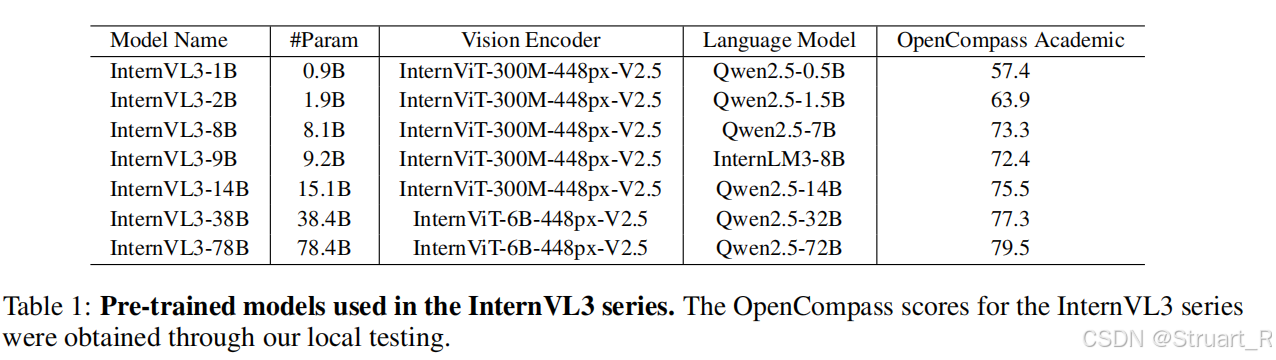

? ? ? ? InternVL3不僅在原有的多學科推理,文檔理解,圖像視頻理解,現實場景理解,幻覺檢測,視覺定位,多語言能力中領先InternVL2.5,同時在工具使用,空間推理,工業圖像分析,圖形用戶界面代理上也取得了新的進展。性能上與開源項目Qwen2.5-VL不相上下,與閉源項目Chatgpt-4o,Gemini-2.5 Pro,Claude3.5-sonnet旗鼓相當。

????????OpenCompass多模態學術排行榜上不同MLLMs的比較。

2、方法

? ? ? ? 整體架構

? ? ? ? 仍然沿用ViT-MLP-LLM的三階段架構。

? ? ? ? 視覺編碼器:采用兩種預訓練視覺模型作為基礎,InternViT-300M用于輕量級模型InternVL3-1B;InternViT-6B用于大型模型InternVL3-78B。采用高分辨率優化,Pixel Unshuffle將圖像分割成448x448像素圖塊,并編碼為256個tokens,顯著降低計算開銷。(這一波方法跟之前相同)

? ? ? ? 語言模型:基于開源LLM初始化,預訓練Qwen2.5-72B或InternLM3-8B。

? ? ? ? MLP:兩層全連接網絡,隨機初始化權重,并將ViT輸出的視覺嵌入投影到LLM嵌入空間中,實現模態對齊。

? ? ? ? 變量視覺位置編碼(V2PE)

? ? ? ? 由于MLLM中的傳統位置編碼對視覺令牌使用固定增量+1,導致長序列視頻,超出模型的位置窗口限制。V2PE中設置動態增量,對文本token仍然+1,視覺token+,其中

在訓練中從離散數據集中隨機采樣。

? ? ? ? 具體來說,MLLM中一組token記錄為,位置編碼記錄為

。

??????????????????????????????????????????????????????????????????????????????????????????????????

? ? ? ??函數關系在V2PE中滿足:

????????????????????????????????????????

? ? ? ? 其中

? ? ? ? 原生多模態預訓練方法

? ? ? ? 數據混合

(1)多模態數據:圖像-文本對,視頻幀序列,跨膜態文檔(醫學,圖標,GUI)

(2)純文本數據:開源語料,數學文本,知識文本

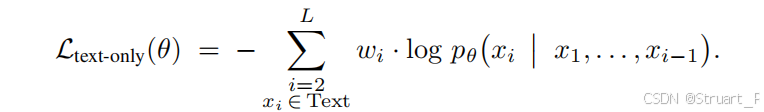

? ? ? ? 數據比例為純文本 vs 多模態=1:3(共200B tokens),平衡模態對齊與語言能力。所有輸入統一為序列。僅僅通過token計算自回歸損失,迫使視覺token編碼為語言預測的有效信號。

?????????由于token輸入中對于長文本或者短文本保證一定的理解,所以以往的方法設計了token平均(偏向長文本)或樣本平均(偏向短文本),從而存在梯度偏差,而本文采用了平方平均加權。權重定義為,

為樣本token數。

? ? ? ? 訓練過程中ViT+MLP+LLM同步更新,突破傳統凍結策略的限制,并全局采用text-only loss。

3、訓練后處理

? ? ? ? 原生多模態訓練之后,采用兩階段的后處理訓練策略提升模型性能。

? ? ? ? 監督微調??? ?

? ? ? ? 對數據采用隨機JPEG壓縮,模擬真實場景下圖像退化的問題,并繼續沿用平方平均加權,數據采用圖像、視頻、文本混合輸入,并且將訓練樣本數據量再一次提高(1630w->2170w)?,新增GUI操作,3D場景理解,科學圖標解析等數據領域。

? ? ? ? 混合偏好優化

? ? ? ? 由于SFT的訓練過程中訓練時采用真實標簽,推理時依賴模型自生成內容,會造成曝光偏差(exposure bias),所以基于300K的偏好對信息(覆蓋科學推理,科學問答,OCR復雜場景),并在正例中包含CoT,反例加入錯誤模式。

? ? ? ? 損失采用偏好損失(學習人類偏好),質量損失(獨立評估響應的絕對質量),生成損失三重融合(以往的LM loss,維持文本生成流暢性)。

4、測試時擴展

? ? ? ? 提升復雜任務的魯棒性,引入動態推理優化機制。

? ? ? ? 采用Best-of-N采樣策略,選用VisualPRM視覺過程獎勵模型作為評估模型,利用最優響應完成推理和評估任務。

? ? ? ? Best-of-N工作流程:對同一問題生成 ??N 個候選響應??(默認 N=8);用 ??VisualPRM 獎勵模型?? 對每個響應評分;選擇 ??最高分響應?? 作為最終輸出。

五、BLIP-3o

????????

)

:Spring Boot + AI + Vue3 + OSS + DashScope 實現高效語音識別系統(附完整源碼))

置信度研究的經典與前沿論文 :溫度縮放;語義熵;自一致性;事實與反思;檢索增強;黑盒引導;)

對北半球光伏數據進行時間序列預測)