一、M2DGR

該數據集主要針對的是地面機器人,文章正文提到,現在許多機器人在進行定位時,其視角以及移動速度與車或者無人機有著較大的差異,這一差異導致在地面機器人完成SLAM任務時并不能直接套用類似的數據集。針對這一問題該團隊設計了這樣的一個包含了多傳感器、多場景的數據集。

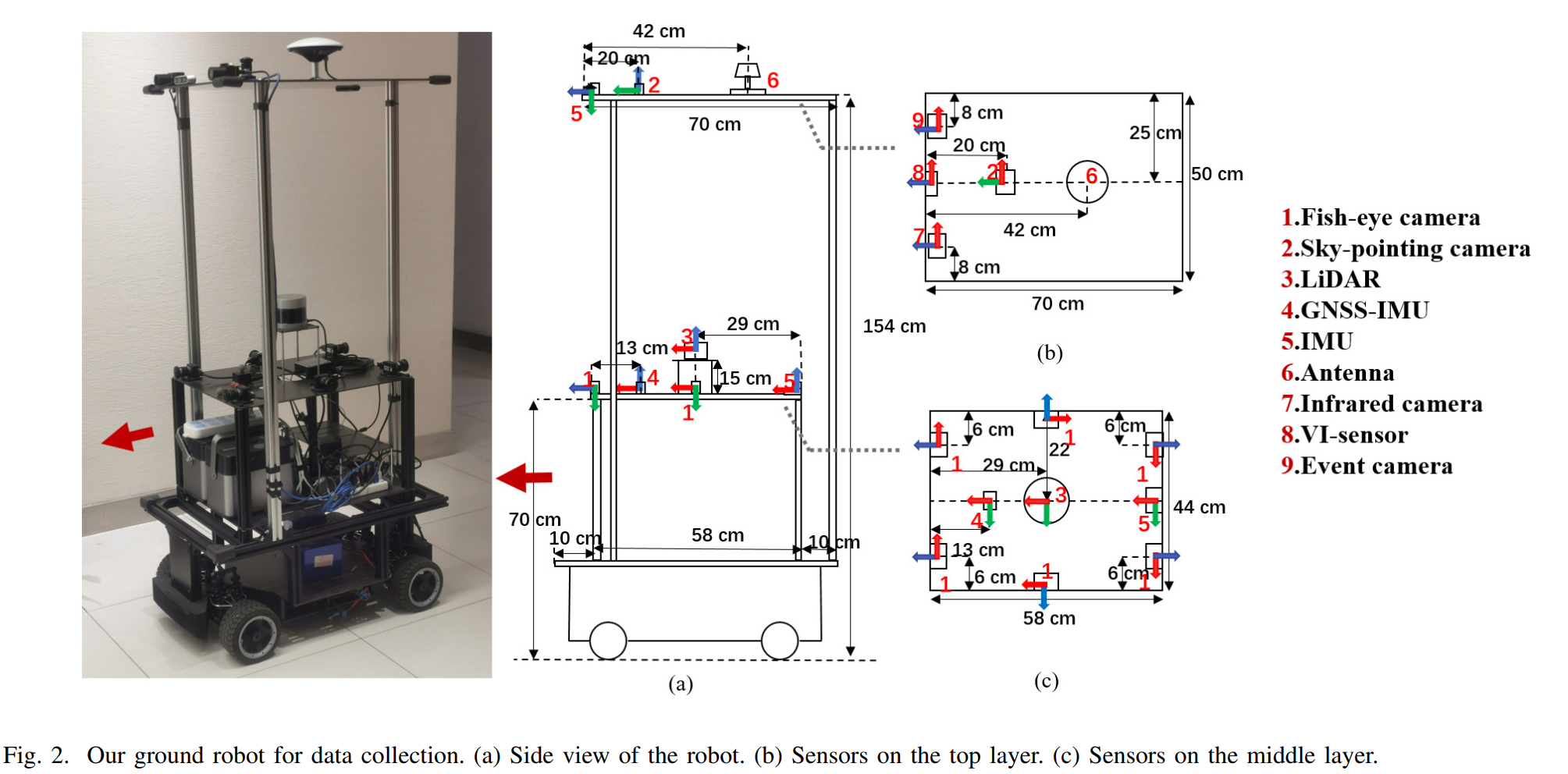

由于其主要針對的是地面機器人,所以創新點也是圍繞著這里進行的。文章使用了一個自己搭建的數據采集機器人,配備了六個朝向四周的魚眼相機、一個朝向天空的普通相機、一個紅外相機、一個事件相機、一個32線激光雷達、IMU以及定位設備。

標定與同步方面。文章使用了MATLAB的標定工具箱對相機的內參進行了標定,魚眼相機使用了Kannala Brandt model畸變模型機型標定。紅外相機使用了不同比熱容的標定板進行標定,這一標定方法出現在好多紅外相機的標定中,這種方法實際上就是用比熱容不同的材料來只做標定板的黑白格,這樣在加熱標定板的時候,黑白格會因為比熱容不同呈現出不同的溫度,從而就可以在紅外相機中表現出差異,利用這種方法人工尋找黑白格的交界處,就能完成標定。外參標定也是使用了各種工具箱,使用Autoware的工具箱可以標定激光雷達和相機,相機和IMU使用了Kalibr工具箱。傳感器之間沒有使用硬觸發,而是選擇系統時間來進行軟同步。

由于其針對的是地面機器人,所以設計的錄制場景同時包含了室內、室外以及室內外交替三類。室外場景選擇了RTK定位來獲得真值,室內的真值則是使用動捕系統。對于室內外交替的場景,真值是RTK與動補相結合的,個人推測采集機器人上面安裝的朝天的相機就是為了判斷是在室內還是室外。

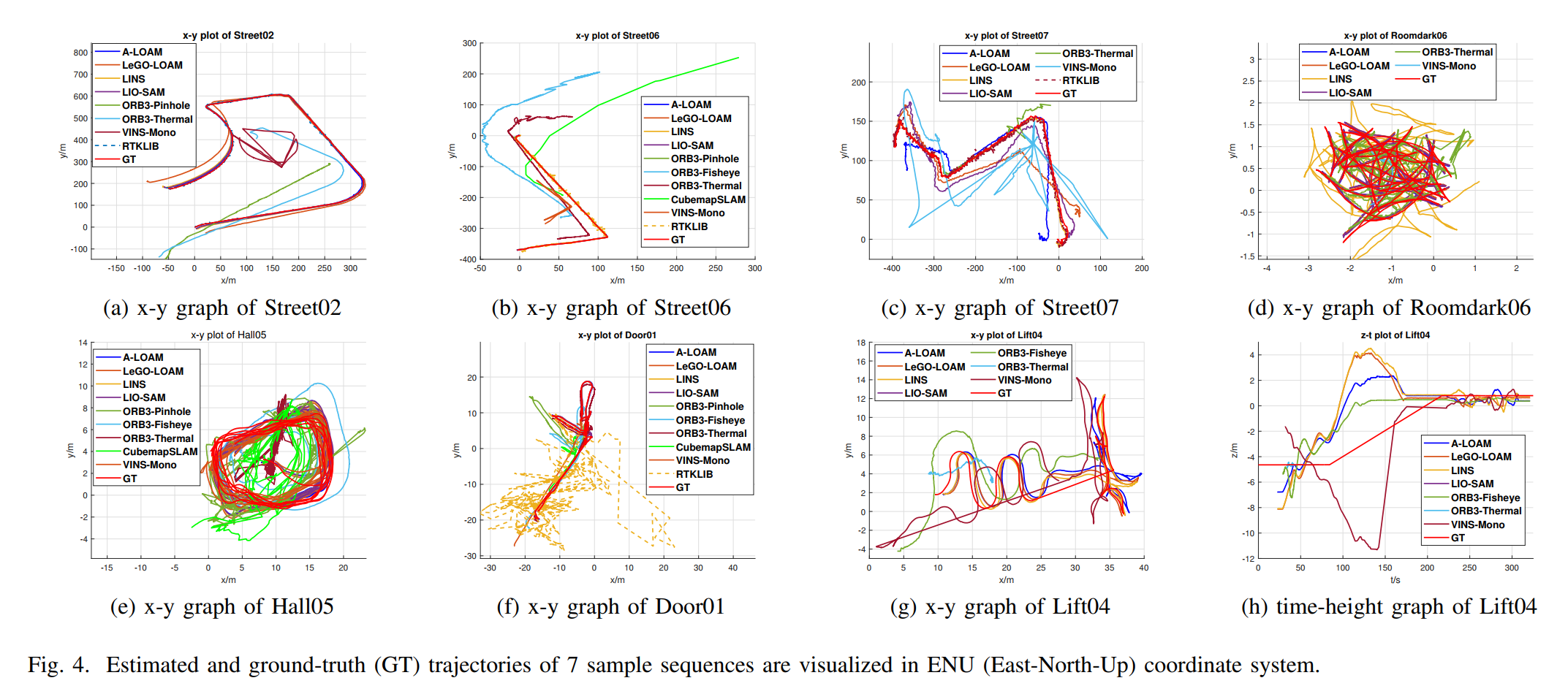

在驗證實驗部分,文章選擇了A-LOAM、LeGo-LOAM、lINS、LIO-SAM、ORBSLAM3、VINS-MONO進行了驗證。在一些數據集上表現和真值偏差還是很大的。

二、UrbanLoco

該數據集針對的是無人駕駛數據集缺少人口密集的城市場景這一問題,現有的數據集比如KITTI、Waymo等數據集,并不是在那種大都市場景下進行的錄制,在這類場景下高樓大廈會對GNSS信號產生影響,同時諸如汽車、行人等動態物體也會增多,這對于無人駕駛的定位來說是一個較大的挑戰。所以作者提出了這樣的一個大規模的城市定位數據集,不僅包含了多樣的場景以及動態物體,還使用了多傳感器進行錄制,為了衡量場景的復雜程度,作者還提出了一個城市化比例的概念。

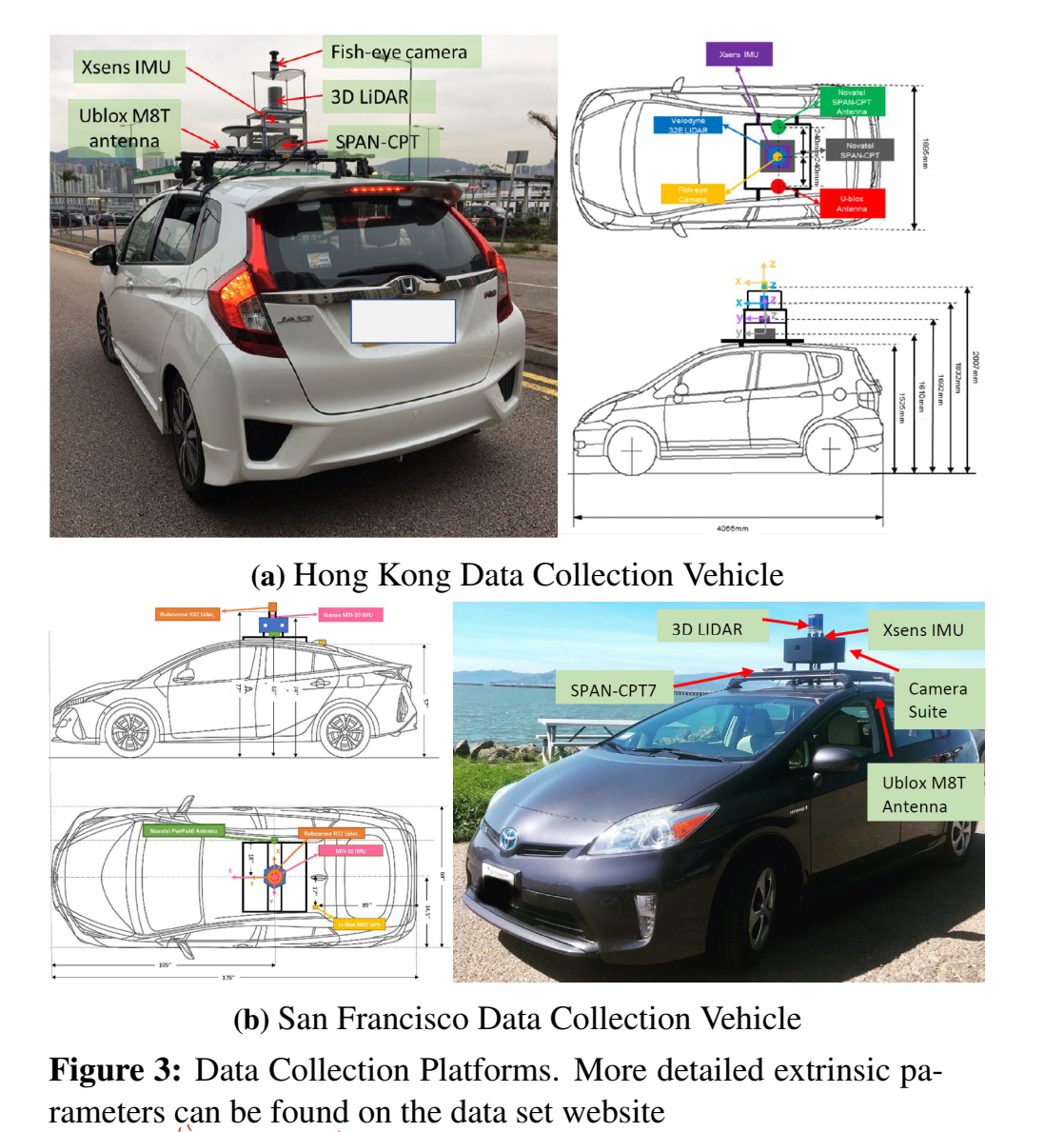

實驗采集車使用的是一輛改裝過的豐田飛度,在車頂加了一個架子用來放置傳感器,使用的傳感器包括一個激光雷達、相機、魚眼相機、IMU以及GNSS設備,錄制地點是香港和舊金山的街道。為了獲得軌跡真值作者選用的SPAN-CPT來融合IMU和RTK來完成真值。這里作者提到在魚眼相機僅用在了香港的數據采集,并且這一相機是朝天指向的,這樣做是為了去評估衛星的可見程度,從而改善GNSS的定位結果。

標定方面論文沒有介紹太多,只寫了用Kalibr工具箱來進行相機內參的標定,外參則是使用Autoware工具箱進行的。

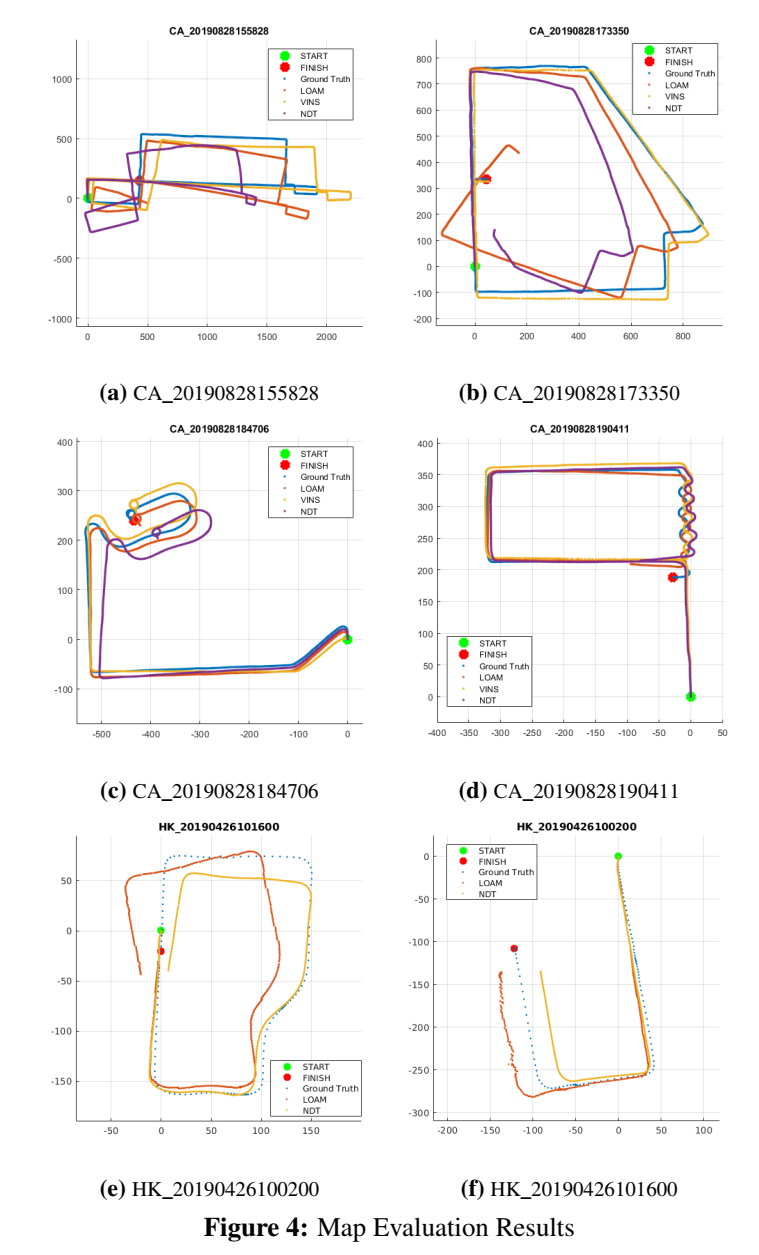

驗證實驗部分,作者選用了視覺、激光兩類SLAM框架進行驗證,選擇了LOAM、NDT、VINS-MONO進行測試。

思維導圖

![latex中\documentclass[preprint,review,12pt]{elsarticle}的詳細解釋](http://pic.xiahunao.cn/latex中\documentclass[preprint,review,12pt]{elsarticle}的詳細解釋)

征稿開啟!)

—— 循環語句)

![[藍橋杯 2020 省 B1] 整數拼接](http://pic.xiahunao.cn/[藍橋杯 2020 省 B1] 整數拼接)

)

)