文青松

松鼠AI首席科學家、AI研究院負責人

美國佐治亞理工學院(Georgia Tech)電子與計算機工程博士,人工智能、決策智能和信號處理方向專家,在松鼠AI、阿里、Marvell等公司超10年的技術和管理經驗,近100篇文章發表在人工智能相關的頂會與頂刊,多篇文章被AI頂會(NeurIPS, ICLR等)評選為Oral/Spotlight論文,兩次入選IJCAI最具影響力論文并排名第一,兩次獲得AAAI人工智能系統部署應用獎,獲得ICASSP Grand Challenge冠軍。近期研究興趣為智能時序與AI教育, 也是AI頂會 (AAAI, IJCAI, KDD, ICDM等) Workshop on AI for Time Series, Workshop on AI for Education的主要組織者之一。個人主頁為: https://sites.google.com/site/qingsongwen8

論文:

Time-LLM: Time Series Forecasting By Reprogramming Large Language Models

Time-LLM:通過重編程大型語言模型進行時間序列預測

論文鏈接:

論文(arXiv):https://arxiv.org/abs/2310.01728

論文(ICLR’24):https://openreview.net/forum?id=Unb5CVPtae

代碼:

https://github.com/KimMeen/Time-LLM

以下內容是根據松鼠AI首席科學家、AI研究院負責人文青松團隊成員在2023 CCF國際AIOps挑戰賽決賽暨“大模型時代的AIOps”研討會閃電論文分享環節上的演講整理成文。

大家好,我是來自莫納什大學的博士生金明(個人主頁:https://mingjin.dev/),今天很榮幸能和大家分享我們團隊的研究成果,介紹的內容是Time-LLM,主要探討的是如何重編程大語言模型來實現時間序列預測。

背 景

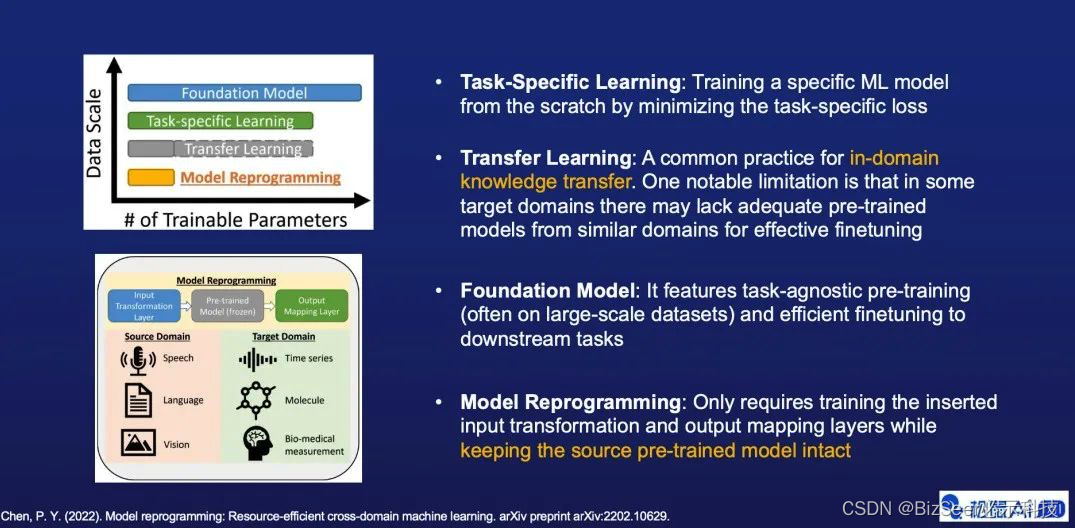

和傳統的任務導向學習與基準模型預訓練相比,模型重編程所需要的訓練樣本和待學習的參數都很少。與典型的遷移學習相比,模型重編程在域內和跨域泛化等方面,都顯示出了較好的有效性。在技術層面模型重編程只需要訓練外部的輸入變換層和輸出映射層,而不涉及任何對預訓練模型本身的更新。

目 的

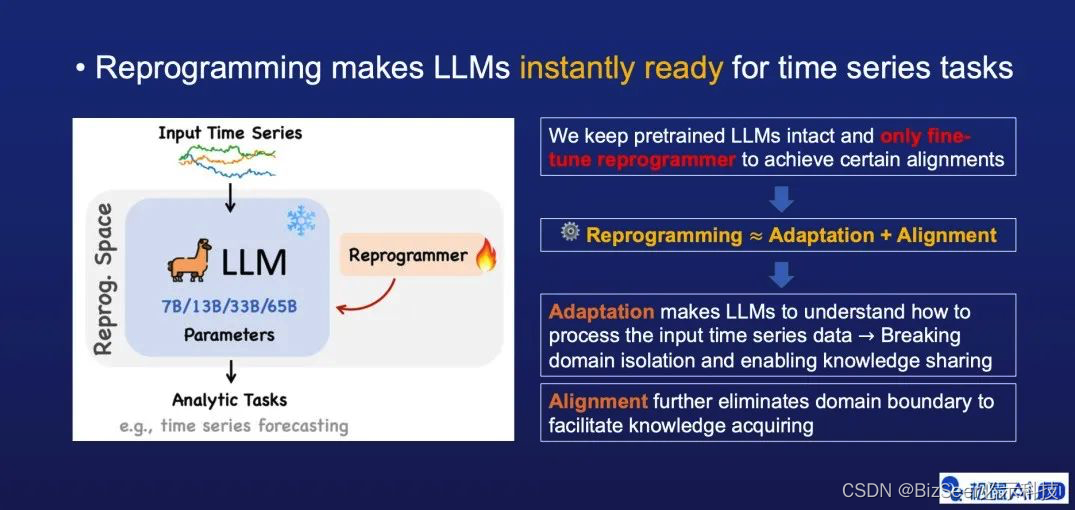

我們的工作內容主要是研究如何從編程大語言模型時期可以輕松的用于時間序列相關任務。

比方說預測,我們將大語言模型重編程定義為兩部分,第一是Adaptation,目的在于打通兩個短鏈之間的隔閡,使大語言模型能夠將時間序列作為輸入和對應輸出。其次是Alignment,也就是我們常說的對齊,目的是進一步消除短鏈之間的間隔。

此外我們還發現重編程大語言模型可以讓其在時間序列任務上更有效。比如通過Prompts的形式引入外部的專家知識和具體的任務描述。

架 構

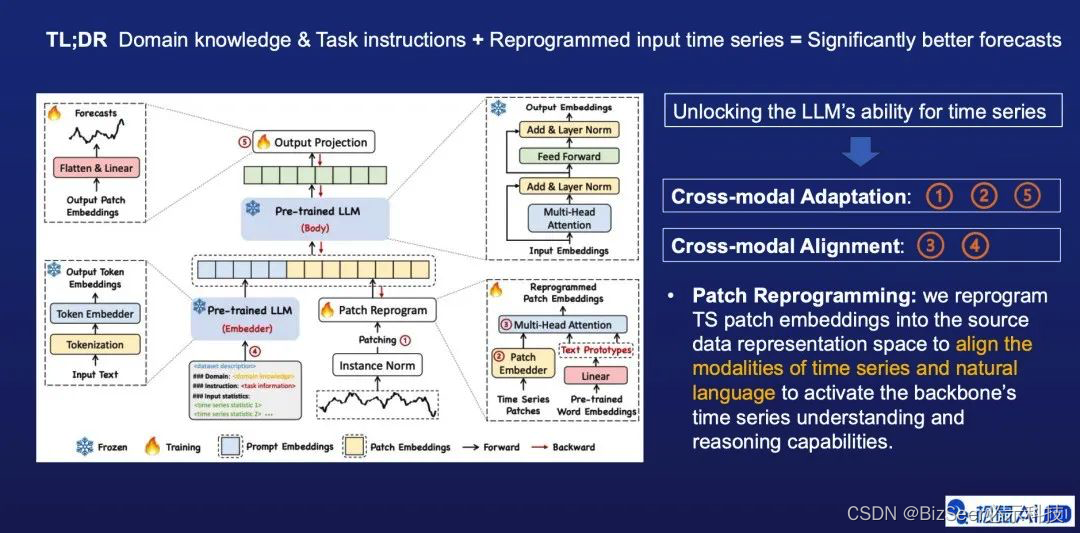

上圖中展示的是我們方法的架構圖,其中第1、第2、第5步是Adaptation相關的設計,然后第3、第4步是對齊相關的設計。在第3步里也就是Patch Reprogramming,我們通過使用Word Embedding來表示不同時間序列,進而對齊兩個不同的模態即自然語言和時間序列。

第4步,我們通過將外部知識做前綴這個方法,進一步幫助大語言模型在時序數據上做有效的推理,外部知識可以是一些專家知識或者具體的實訓任務的描述。

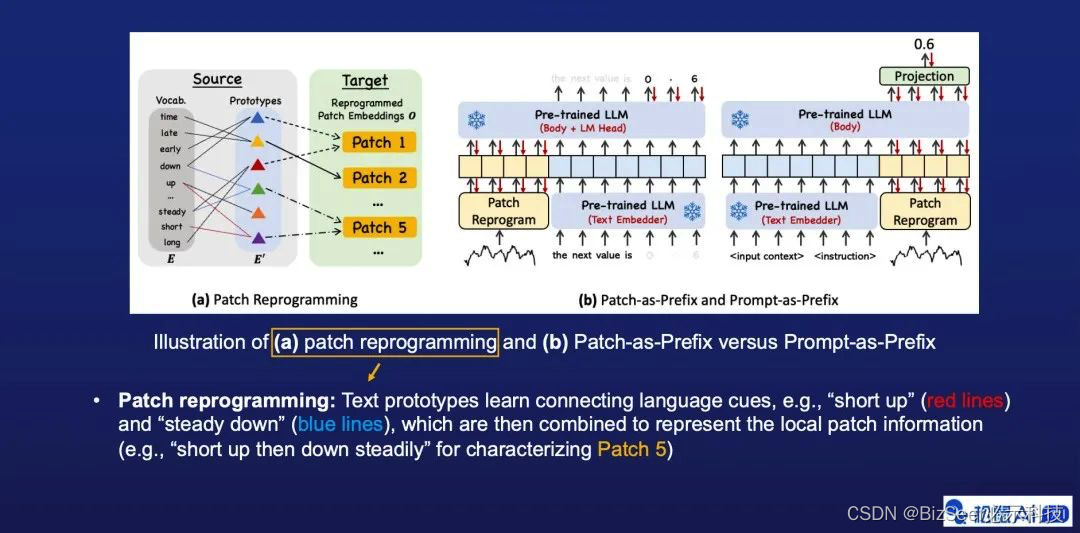

圖片中的a部分,我們進一步描述了Patch reprogramming的核心思想。在這個例子中,我們展示了如何使用自然語言刻畫時間序列片段 (Patch),比如Patch 5的語義信息其實可以描述成兩個具體過程:先短暫上升再平穩下降。因此我們可以用綠色和紫色兩個不同的Text prototypes來表示它,進而打通如圖所示的兩個不同的數據模態/信息域。

圖片

在圖片中的b部分,我們對比了兩種結合文本Prompt的范式,其中我們提出來的Prompt-as-Prefix(PaP)方法具有兩個比較直接的優勢:一是無需構建特定的多模態指令訓練集,二是規避了大語言模型本身在生成輸出時間序列方面存在的一些挑戰,例如有限的上下文窗口,較低的高精度數字敏感度,和不同分詞策略對結果產生的未知影響。

結 果

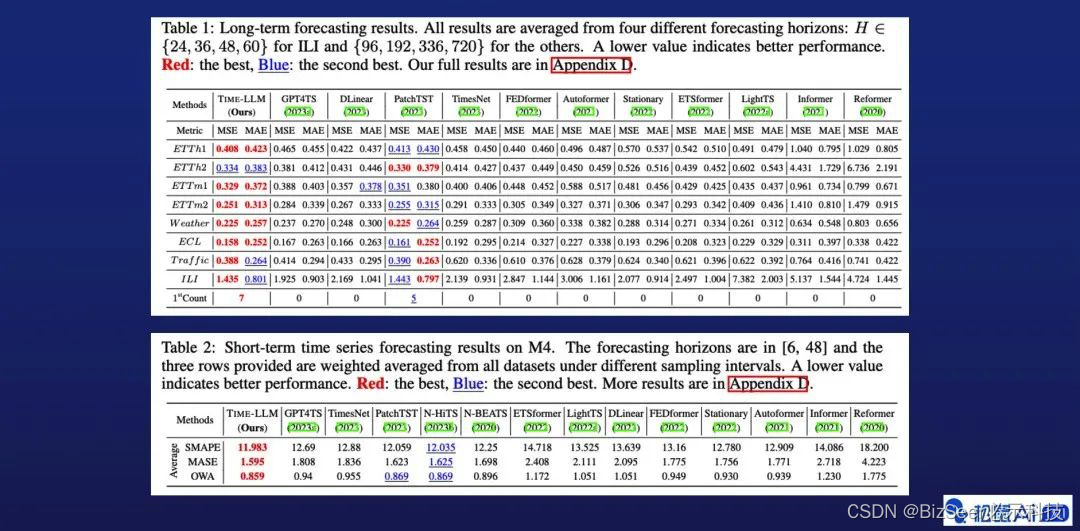

接下來展示實驗的結果。如圖所示,我們的Time-LLM方法顯示出了非常好的有效性。上圖是標準的長程預測結果在8個基準數據集上的對比,下圖是標準短程預測在M4比賽數據集上的結果對比。

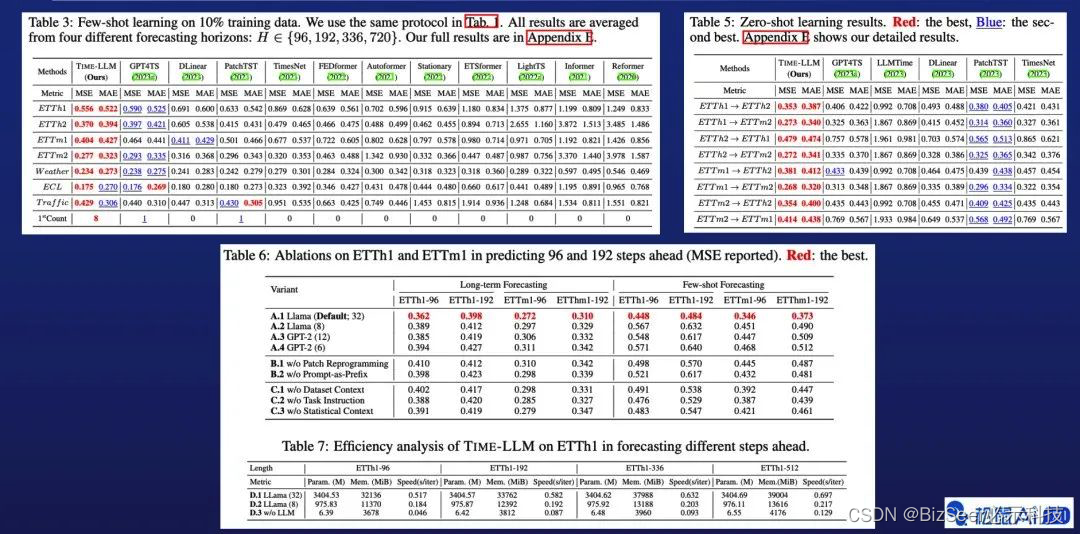

圖片中上半部分展示的是部分Few-shot和Zero-show的預測結果的對比,下半部分展示的是主要的消融實驗和訓練效率相關的實驗結果,均顯示了本文提出方法的有效性。

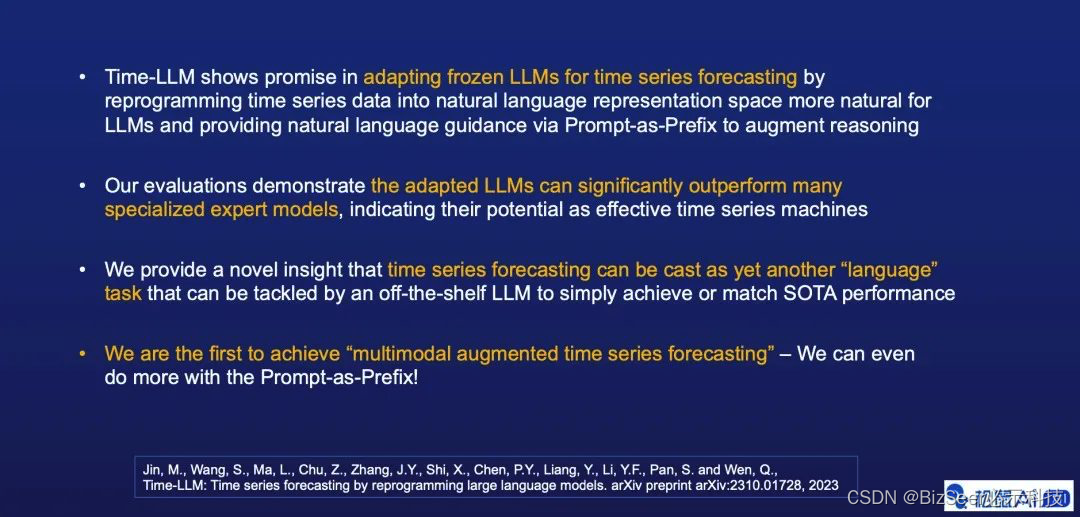

總 結

最后是一個簡短的總結。

我們的研究工作一是探索使用大語言模型做時序分析任務的可能性,提出了對大語言模型做重編程的概念。二是發現和驗證了時序任務本身可以抽象成一種能夠被大語言模型解決的特殊語言任務。最后是我們的一些啟發和展望,比如說做多模態的時序分析,以及通用的時序GPT。

我的分享到此結束,謝謝大家。

更多LLM for Time Series相關資料:

- (時序與時空大模型, 綜述): Large Models for Time Series and Spatio-Temporal Data: A Survey and Outlook, in arXiv, Oct. 2023.

Authors: Ming Jin, Qingsong Wen*, Yuxuan Liang, Chaoli Zhang, Siqiao Xue, Xue Wang, James Zhang, Yi Wang, Haifeng Chen, Xiaoli Li (IEEE Fellow), Shirui Pan*, Vincent S. Tseng (IEEE Fellow), Yu Zheng (IEEE Fellow), Lei Chen (IEEE Fellow), Hui Xiong (IEEE Fellow)

Link: https://arxiv.org/abs/2310.10196

2.(LLM for Time Series, Position Paper): What Can Large Language Models Tell Us about Time Series Analysis, in arXiv, Feb. 2024.

Authors: Ming Jin, Yifan Zhang, Wei Chen, Kexin Zhang, Yuxuan Liang*, Bin Yang, Jindong Wang, Shirui Pan, Qingsong Wen*

Link: https://arxiv.org/abs/2402.02713

)

(2))

)

)

步驟講解)

![[C語言]——C語言常見概念(1)](http://pic.xiahunao.cn/[C語言]——C語言常見概念(1))