MedicalGPT 訓練醫療大模型,實現了包括增量預訓練、有監督微調、RLHF(獎勵建模、強化學習訓練)和DPO(直接偏好優化)。

MedicalGPT: Training Your Own Medical GPT Model with ChatGPT Training Pipeline. 訓練醫療大模型,實現了包括增量預訓練、有監督微調、RLHF(獎勵建模、強化學習訓練)和DPO(直接偏好優化)。

🇨🇳中文 | 🌐English | 📖文檔/Docs | 🤖模型/Models

MedicalGPT: Training Medical GPT Model

📖 Introduction

MedicalGPT training medical GPT model with ChatGPT training pipeline, implemantation of Pretraining,

Supervised Finetuning, RLHF(Reward Modeling and Reinforcement Learning) and DPO(Direct Preference Optimization).

MedicalGPT 訓練醫療大模型,實現了包括增量預訓練、有監督微調、RLHF(獎勵建模、強化學習訓練)和DPO(直接偏好優化)。

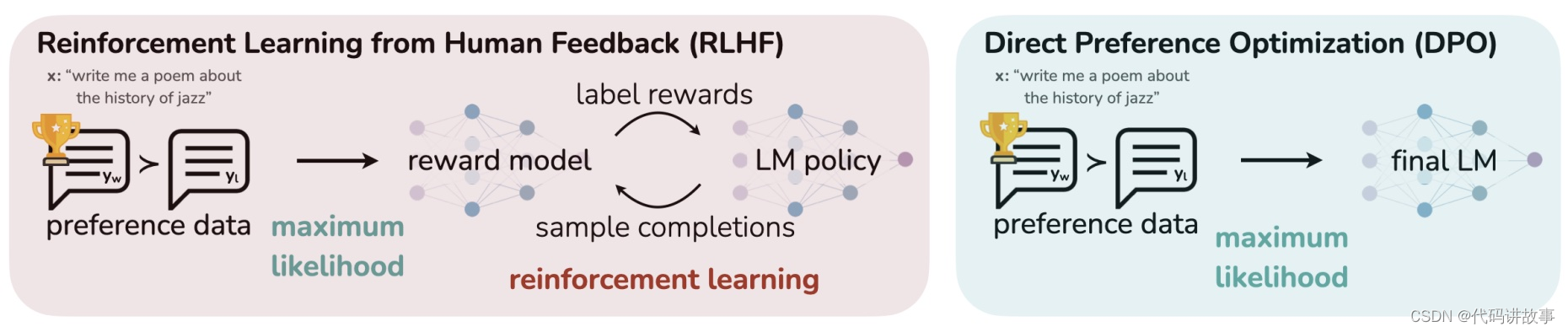

- RLHF training pipeline來自Andrej Karpathy的演講PDF State of GPT,視頻 Video

- DPO方法來自論文Direct Preference Optimization:Your Language Model is Secretly a Reward Model

🔥 News

[2024/01/26] v1.8版本:支持微調Mixtral混合專家MoE模型 Mixtral 8x7B。詳見Release-v1.8

[2024/01/14] v1.7版本:新增檢索增強生成(RAG)的基于文件問答ChatPDF功能,代碼chatpdf.py,可以基于微調后的LLM結合知識庫文件問答提升行業問答準確率。詳見Release-v1.7

[2023/10/23] v1.6版本:新增RoPE插值來擴展GPT模型的上下文長度;針對LLaMA模型支持了FlashAttention-2和LongLoRA 提出的 S 2 S^2 S2-Attn;支持了NEFTune給embedding加噪訓練方法。詳見Release-v1.6

[2023/08/28] v1.5版本: 新增DPO(直接偏好優化)方法,DPO通過直接優化語言模型來實現對其行為的精確控制,可以有效學習到人類偏好。詳見Release-v1.5

[2023/08/08] v1.4版本: 發布基于ShareGPT4數據集微調的中英文Vicuna-13B模型shibing624/vicuna-baichuan-13b-chat,和對應的LoRA模型shibing624/vicuna-baichuan-13b-chat-lora,詳見Release-v1.4

[2023/08/02] v1.3版本: 新增LLaMA, LLaMA2, Bloom, ChatGLM, ChatGLM2, Baichuan模型的多輪對話微調訓練;新增領域詞表擴充功能;新增中文預訓練數據集和中文ShareGPT微調訓練集,詳見Release-v1.3

[2023/07/13] v1.1版本: 發布中文醫療LLaMA-13B模型shibing624/ziya-llama-13b-medical-merged,基于Ziya-LLaMA-13B-v1模型,SFT微調了一版醫療模型,醫療問答效果有提升,發布微調后的完整模型權重,詳見Release-v1.1

[2023/06/15] v1.0版本: 發布中文醫療LoRA模型shibing624/ziya-llama-13b-medical-lora,基于Ziya-LLaMA-13B-v1模型,SFT微調了一版醫療模型,醫療問答效果有提升,發布微調后的LoRA權重,詳見Release-v1.0

[2023/06/05] v0.2版本: 以醫療為例,訓練領域大模型,實現了四階段訓練:包括二次預訓練、有監督微調、獎勵建模、強化學習訓練。詳見Release-v0.2

😊 Features

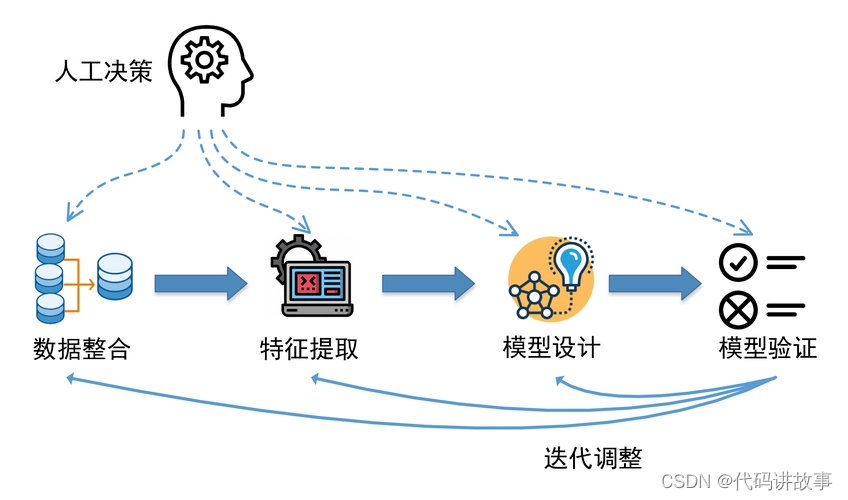

基于ChatGPT Training Pipeline,本項目實現了領域模型–醫療行業語言大模型的訓練:

- 第一階段:PT(Continue PreTraining)增量預訓練,在海量領域文檔數據上二次預訓練GPT模型,以適應領域數據分布(可選)

- 第二階段:SFT(Supervised Fine-tuning)有監督微調,構造指令微調數據集,在預訓練模型基礎上做指令精調,以對齊指令意圖,并注入領域知識

- 第三階段

- RLHF(Reinforcement Learning from Human Feedback)基于人類反饋對語言模型進行強化學習,分為兩步:

- RM(Reward Model)獎勵模型建模,構造人類偏好排序數據集,訓練獎勵模型,用來建模人類偏好,主要是"HHH"原則,具體是"helpful, honest, harmless"

- RL(Reinforcement Learning)強化學習,用獎勵模型來訓練SFT模型,生成模型使用獎勵或懲罰來更新其策略,以便生成更高質量、更符合人類偏好的文本

- DPO(Direct Preference Optimization)直接偏好優化方法,DPO通過直接優化語言模型來實現對其行為的精確控制,而無需使用復雜的強化學習,也可以有效學習到人類偏好,DPO相較于RLHF更容易實現且易于訓練,效果更好

- RLHF(Reinforcement Learning from Human Feedback)基于人類反饋對語言模型進行強化學習,分為兩步:

Release Models

| Model | Base Model | Introduction |

|---|---|---|

| shibing624/ziya-llama-13b-medical-lora | IDEA-CCNL/Ziya-LLaMA-13B-v1 | 在240萬條中英文醫療數據集shibing624/medical上SFT微調了一版Ziya-LLaMA-13B模型,醫療問答效果有提升,發布微調后的LoRA權重(單輪對話) |

| shibing624/ziya-llama-13b-medical-merged | IDEA-CCNL/Ziya-LLaMA-13B-v1 | 在240萬條中英文醫療數據集shibing624/medical上SFT微調了一版Ziya-LLaMA-13B模型,醫療問答效果有提升,發布微調后的完整模型權重(單輪對話) |

| shibing624/vicuna-baichuan-13b-chat-lora | baichuan-inc/Baichuan-13B-Chat | 在10萬條多語言ShareGPT GPT4多輪對話數據集shibing624/sharegpt_gpt4上SFT微調了一版baichuan-13b-chat多輪問答模型,日常問答和醫療問答效果有提升,發布微調后的LoRA權重 |

| shibing624/vicuna-baichuan-13b-chat | baichuan-inc/Baichuan-13B-Chat | 在10萬條多語言ShareGPT GPT4多輪對話數據集shibing624/sharegpt_gpt4上SFT微調了一版baichuan-13b-chat多輪問答模型,日常問答和醫療問答效果有提升,發布微調后的完整模型權重 |

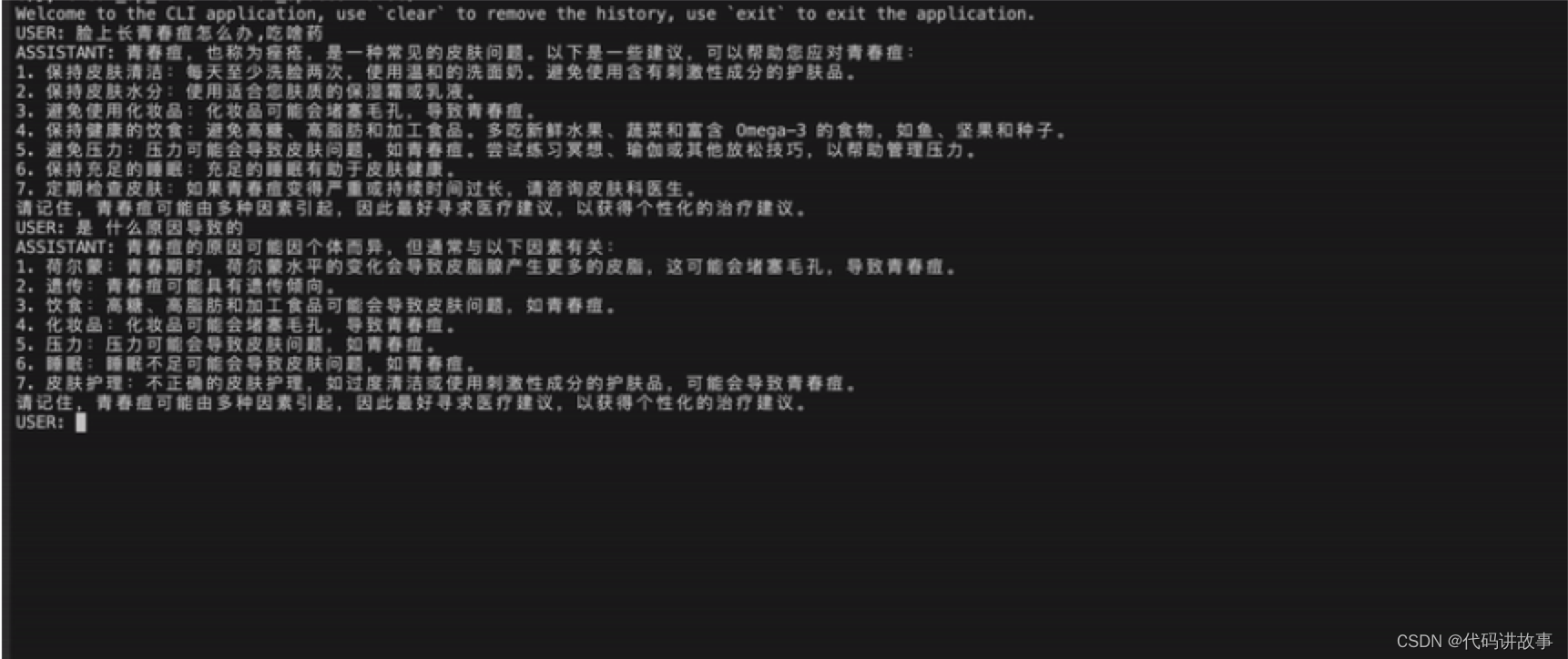

演示shibing624/vicuna-baichuan-13b-chat模型效果:

具體case見Inference Examples

?? Demo

我們提供了一個簡潔的基于gradio的交互式web界面,啟動服務后,可通過瀏覽器訪問,輸入問題,模型會返回答案。

啟動服務,命令如下:

CUDA_VISIBLE_DEVICES=0 python gradio_demo.py --model_type base_model_type --base_model path_to_llama_hf_dir --lora_model path_to_lora_dir

參數說明:

--model_type {base_model_type}:預訓練模型類型,如llama、bloom、chatglm等--base_model {base_model}:存放HF格式的LLaMA模型權重和配置文件的目錄,也可使用HF Model Hub模型調用名稱--lora_model {lora_model}:LoRA文件所在目錄,也可使用HF Model Hub模型調用名稱。若lora權重已經合并到預訓練模型,則刪除–lora_model參數--tokenizer_path {tokenizer_path}:存放對應tokenizer的目錄。若不提供此參數,則其默認值與–base_model相同--template_name:模板名稱,如vicuna、alpaca等。若不提供此參數,則其默認值是vicuna--only_cpu: 僅使用CPU進行推理--resize_emb:是否調整embedding大小,若不調整,則使用預訓練模型的embedding大小,默認不調整

💾 Install

Updating the requirements

From time to time, the requirements.txt changes. To update, use this command:

git clone https://github.com/shibing624/MedicalGPT

cd MedicalGPT

pip install -r requirements.txt --upgrade

Hardware Requirement

| 訓練方法 | 精度 | 7B | 13B | 30B | 65B | 8x7B |

|---|---|---|---|---|---|---|

| 全參數 | 16 | 160GB | 320GB | 600GB | 1200GB | 900GB |

| LoRA | 16 | 16GB | 32GB | 80GB | 160GB | 120GB |

| QLoRA | 8 | 10GB | 16GB | 40GB | 80GB | 80GB |

| QLoRA | 4 | 6GB | 12GB | 24GB | 48GB | 32GB |

🚀 Training Pipeline

Training Stage:

| Stage | Introduction | Python script | Shell script |

|---|---|---|---|

| Continue Pretraining | 增量預訓練 | pretraining.py | run_pt.sh |

| Supervised Fine-tuning | 有監督微調 | supervised_finetuning.py | run_sft.sh |

| Direct Preference Optimization | 直接偏好優化 | dpo_training.py | run_dpo.sh |

| Reward Modeling | 獎勵模型建模 | reward_modeling.py | run_rm.sh |

| Reinforcement Learning | 強化學習 | ppo_training.py | run_ppo.sh |

- 提供完整PT+SFT+DPO全階段串起來訓練的pipeline:run_training_dpo_pipeline.ipynb ,其對應的colab(https://colab.research.google.com/github/shibing624/MedicalGPT/blob/main/run_training_dpo_pipeline.ipynb),運行完大概需要15分鐘,我運行成功后的副本colab(https://colab.research.google.com/drive/1kMIe3pTec2snQvLBA00Br8ND1_zwy3Gr?usp=sharing)

- 提供完整PT+SFT+RLHF全階段串起來訓練的pipeline:run_training_ppo_pipeline.ipynb ,其對應的colab:(https://colab.research.google.com/github/shibing624/MedicalGPT/blob/main/run_training_ppo_pipeline.ipynb) ,運行完大概需要20分鐘,我運行成功后的副本colab(https://colab.research.google.com/drive/1RGkbev8D85gR33HJYxqNdnEThODvGUsS?usp=sharing)

- 提供基于知識庫文件的LLM問答功能(RAG):chatpdf.py

- 訓練參數說明 | 訓練參數說明wiki

- 數據集 | 數據集wiki

- 擴充詞表 | 擴充詞表wiki

- FAQ | FAQ_wiki

Supported Models

| Model Name | Model Size | Template |

|---|---|---|

| BLOOMZ | 560M/1.1B/1.7B/3B/7.1B/176B | vicuna |

| LLaMA | 7B/13B/33B/65B | alpaca |

| LLaMA2 | 7B/13B/70B | llama2 |

| Mistral | 7B/8x7B | mistral |

| Baichuan | 7B/13B | baichuan |

| Baichuan2 | 7B/13B | baichuan2 |

| InternLM | 7B | intern |

| Qwen | 1.8B/7B/14B/72B | chatml |

| XVERSE | 13B | xverse |

| ChatGLM | 6B | chatglm |

| ChatGLM2 | 6B | chatglm2 |

| ChatGLM3 | 6B | chatglm3 |

| Yi | 6B/34B | yi |

| DeepSeek | 7B/16B/67B | deepseek |

| Orion | 14B | orion |

The following models are tested:

bloom:

- bigscience/bloomz-560m

- bigscience/bloomz-1b7

- bigscience/bloomz-7b1

llama:

- shibing624/chinese-alpaca-plus-7b-hf

- shibing624/chinese-alpaca-plus-13b-hf

- minlik/chinese-llama-plus-7b-merged

- shibing624/chinese-llama-plus-13b-hf

- decapoda-research/llama-7b-hf

- IDEA-CCNL/Ziya-LLaMA-13B-v1

llama2:

- daryl149/llama-2-7b-chat-hf

- meta-llama/Llama-2-7b-chat-hf

- ziqingyang/chinese-alpaca-2-7b

mistral:

- mistralai/Mistral-7B-v0.1

- HuggingFaceH4/zephyr-7b-beta

chatglm:

- THUDM/chatglm-6b

- THUDM/chatglm2-6b

- THUDM/chatglm3-6b

baichuan:

- baichuan-inc/baichuan-7B

- baichuan-inc/Baichuan-13B-Base

- baichuan-inc/Baichuan-13B-Chat

xverse:

- xverse/XVERSE-13B-Chat

qwen:

- Qwen/Qwen-7B-Chat

yi:

- 01-ai/Yi-6B-200K

- 01-ai/Yi-6B-Chat

- 01-ai/Yi-34B

💻 Inference

訓練完成后,現在我們加載訓練好的模型,驗證模型生成文本的效果。

CUDA_VISIBLE_DEVICES=0 python inference.py \--model_type base_model_type \--base_model path_to_model_hf_dir \--tokenizer_path path_to_model_hf_dir \--lora_model path_to_lora \--interactive

參數說明:

--model_type {base_model_type}:預訓練模型類型,如llama、bloom、chatglm等--base_model {base_model}:存放HF格式的LLaMA模型權重和配置文件的目錄--tokenizer_path {base_model}:存放HF格式的LLaMA模型權重和配置文件的目錄--lora_model {lora_model}:LoRA解壓后文件所在目錄,也可使用HF Model Hub模型調用名稱。如果已經合并了LoRA權重到預訓練模型,則可以不提供此參數--tokenizer_path {tokenizer_path}:存放對應tokenizer的目錄。若不提供此參數,則其默認值與–base_model相同--template_name:模板名稱,如vicuna、alpaca等。若不提供此參數,則其默認值是vicuna--interactive:以交互方式啟動多輪問答,使用流式推理--data_file {file_name}:非交互方式啟動下,讀取file_name中的的內容進行batch預測--output_file {file_name}:非交互式方式下,將預測的結果以jsonl格式寫入file_name--resize_emb:是否調整embedding大小,若不調整,則使用預訓練模型的embedding大小,默認不調整--only_cpu:僅使用CPU進行推理--gpus {gpu_ids}:指定使用的GPU設備編號,默認為0。如使用多張GPU,以逗號分隔,如0,1,2

多卡推理

多卡數據并行,batch推理

CUDA_VISIBLE_DEVICES=0,1 torchrun --nproc_per_node 2 inference_multigpu_demo.py --model_type baichuan --base_model shibing624/vicuna-baichuan-13b-chat

Inference Examples

shibing624/vicuna-baichuan-13b-chat inference examples:

Model output case| Human | Assitant |

|---|---|

| 小孩發燒怎么辦 | 發燒是身體對感染或其他疾病的自然反應。以下是一些可以幫助緩解發燒癥狀的建議: 1. 保持身體水分充足:發燒時,身體會失去水分,因此需要保持水分充足。 2. 使用冰袋:將冰袋放在額頭或頸部可以幫助降低體溫。 3. 使用退燒藥:退燒藥可以幫助降低體溫。 4. 保持身體溫度:保持身體溫度可以幫助降低體溫。 5. 使用冷水或溫水擦拭身體:使用冷水或溫水擦拭身體可以幫助降低體溫。 6. 使用退燒藥:退燒藥可以幫助降低體溫。 7. 保持身體溫度:保持身體溫度可以幫助降低體溫。 8. 使用冷水或溫水擦拭身體:使用冷水或溫水擦拭身體可以幫助降低體溫。 9. 使用退燒藥:退燒藥可以幫助降低體溫。 10. 保持身體溫度:保持身體溫度可以幫助降低體溫。 |

| 一歲寶寶發燒能吃啥藥? | 1歲寶寶發燒時,可以考慮以下幾種藥物: 1. 退燒藥:如布洛芬(Ibuprofen)或對乙酰氨基酚(Paracetamol)。這些藥物可以幫助降低體溫,緩解發燒癥狀。 2. 抗生素:如果發燒是由細菌感染引起的,可以考慮使用抗生素。但請務必在醫生的建議下使用。 3. 抗病毒藥物:如果發燒是由病毒感染引起的,可以考慮使用抗病毒藥物。但請務必在醫生的建議下使用。 4. 解熱鎮痛藥:如阿司匹林(Aspirin)或對乙酰氨基酚(Paracetamol)。這些藥物可以幫助緩解發燒癥狀。 5. 抗組胺藥:如苯海拉明(Diphenhydramine)或非索非那定(Naproxen)。這些藥物可以幫助緩解發燒癥狀。 請務必在醫生的建議下使用這些藥物,并遵循藥物說明書上的用量和用法。同時,保持寶寶充足的水分攝入,并確保寶寶有足夠的休息。 |

| 肛門病變可能是什么疾病的癥狀 | 肛門病變可能由多種原因引起,包括感染、炎癥、腫瘤或其他疾病。一些常見的肛門病變包括: 1. 肛裂:這是一種肛門皮膚撕裂,通常由便秘或其他壓力因素引起。 2. 肛瘺:這是一種肛門感染,導致肛門皮膚和直腸之間形成瘺管。 3. 肛門疣:這是一種肛門皮膚上形成的疣狀病變,通常由人類乳頭狀瘤病毒(HPV)引起。 4. 肛門膿腫:這是一種肛門感染,導致肛門皮膚下形成膿腫。 5. 肛門腫瘤:這是一種肛門皮膚或直腸內形成的腫瘤。 6. 肛門潰瘍:這是一種肛門皮膚上形成的潰瘍,通常由感染或炎癥引起。 7. 肛門瘙癢:這是一種肛門皮膚瘙癢的癥狀,可能由感染、炎癥或其他疾病引起。 如果您有肛門病變的癥狀,請咨詢醫療保健專業人員以獲得適當的診斷和治療。 |

| 醫生,您好白帶增多泛黃怎么回事? | 您好,白帶增多和發黃可能是由多種原因引起的,包括感染、荷爾蒙變化、陰道干燥或其他婦科問題。以下是一些可能的原因: 1. 感染:白帶增多和發黃可能是由陰道或尿道感染引起的。感染可能由細菌、病毒或真菌引起。 2. 荷爾蒙變化:荷爾蒙變化,如月經周期或更年期,可能會導致白帶增多和發黃。 3. 陰道干燥:陰道干燥可能會導致白帶增多和發黃。 4. 其他婦科問題:其他婦科問題,如子宮頸炎、子宮內膜炎或子宮內膜異位癥,也可能導致白帶增多和發黃。 如果您擔心自己的白帶,建議您咨詢婦科醫生進行檢查和診斷。醫生可以根據您的癥狀和檢查結果確定原因并提供適當的治療。 |

| 藥流后有巧克力白帶是沒流干凈嗎 | 藥流后出現巧克力白帶并不一定意味著沒有流干凈。巧克力白帶是由于子宮內膜脫落和出血引起的,通常在藥流后的一段時間內會出現。 藥流后出現巧克力白帶的原因可能包括: 1. 子宮內膜脫落:藥流后,子宮內膜會脫落,導致出血。這種出血可能表現為巧克力白帶。 2. 感染:藥流后,子宮內膜和宮頸口可能存在創傷,容易受到細菌感染。感染可能導致巧克力白帶。 3. 激素水平變化:藥流后,激素水平可能發生變化,導致巧克力白帶。 如果巧克力白帶持續時間較長,或者伴有其他癥狀,如腹痛、發熱、分泌物異味等,建議及時就診,進行相關檢查,如婦科檢查、B超等,以確定是否存在感染或其他問題。在醫生的指導下進行相應的治療。 |

| 維胺酯維E乳膏能治理什么疾病 | 維胺酯維E乳膏是一種外用藥物,主要用于治療痤瘡、脂溢性皮炎等皮膚病。它可以幫助減少皮膚油脂分泌,減輕炎癥,促進皮膚修復。 需要注意的是,維胺酯維E乳膏并非萬能藥,對于某些皮膚病可能并不適用。在使用前,建議咨詢醫生或藥師,了解藥物的適應癥、禁忌癥、用法用量等信息。同時,使用藥物時應遵循醫囑,避免自行濫用。 |

| 痤瘡是什么原因導致的? | 痤瘡,也稱為粉刺,是由皮膚毛孔堵塞引起的。堵塞毛孔的原因有很多,包括: 1. 皮脂腺過度活躍:皮脂腺產生過多油脂,導致毛孔堵塞。 2. 毛孔堵塞:皮膚表面的死皮細胞、油脂和細菌堵塞毛孔。 3. 炎癥:痤瘡通常伴隨著炎癥,這可能是由于皮膚感染或免疫系統對痤瘡的反應引起的。 4. 遺傳因素:某些人可能更容易患痤瘡,這可能是由于遺傳因素引起的。 5. 荷爾蒙變化:痤瘡在青春期和月經期間更為常見,這可能是由于荷爾蒙變化引起的。 6. 生活方式因素:某些生活方式因素,如壓力、不良飲食和缺乏運動,也可能導致痤瘡。 7. 化妝品和護膚品:某些化妝品和護膚品可能導致痤瘡,特別是那些含有刺激性成分的產品。 8. 藥物:某些藥物,如口服避孕藥,也可能導致痤瘡。 要預防痤瘡,可以采取一些措施,如保持皮膚清潔、使用溫和的護膚品、避免過度使用化妝品和護膚品、保持健康的生活方式和飲食習慣、避免壓力和荷爾蒙變化。如果痤瘡嚴重,可能需要尋求皮膚科醫生的幫助。 |

| 臉上長青春痘怎么辦,能吃啥藥,需要注意啥 | 青春痘,又稱痤瘡,是一種常見的皮膚病。青春痘的治療需要綜合考慮飲食、生活習慣、藥物等多個方面。以下是一些建議: 1. 飲食: * 避免高糖、高脂、高油的食物,如快餐、甜點、油炸食品等。 * 多吃新鮮蔬菜、水果、全谷類食物,以增加纖維攝入,促進腸道蠕動。 * 避免攝入過多的咖啡因、酒精、辛辣食物等刺激性食物。 2. 生活習慣: * 保持良好的作息時間,保證充足的睡眠。 * 避免長時間使用電腦、手機等電子產品,以免輻射對皮膚造成刺激。 * 保持皮膚清潔,每天早晚使用溫和的潔面產品清潔皮膚。 * 避免擠壓青春痘,以免感染和留下疤痕。 3. 藥物: * 外用藥物:可以使用含有水楊酸、苯甲酸、壬二酸等成分的護膚品,幫助去除皮膚表面的角質,減少痘痘的形成。 * 口服藥物:如果青春痘嚴重,可以考慮口服抗生素、維生素B族、鋅等藥物,但需在醫生指導下使用。 4. 注意: * 不要隨意使用化妝品、護膚品,以免刺激皮膚。 * 不要過度清潔皮膚,以免破壞皮膚屏障。 * 保持心情舒暢,避免焦慮、抑郁等負面情緒。 總之,青春痘的治療需要綜合考慮飲食、生活習慣、藥物等多個方面。在治療過程中,要保持耐心和信心,遵循醫生的建議,逐步改善皮膚狀況。 |

| 由于輸精管堵塞會不會導致男性不育?,醫生您好,我同事這幾天不開心,我問她怎么了,她說她老公輸精管堵塞,所以一直沒孩子,不是不想要,請問輸精管堵塞會不會導致男性不育? | 輸精管堵塞可能會導致男性不育。輸精管是連接睪丸和尿道的一條管道,負責將精子從睪丸輸送到尿道。如果輸精管堵塞,精子就無法通過輸精管到達尿道,從而導致不育。 輸精管堵塞的原因有很多,包括先天性發育異常、炎癥、腫瘤、外傷等。輸精管堵塞的治療方法包括手術疏通、藥物治療等。如果輸精管堵塞嚴重,可能需要進行手術疏通。 需要注意的是,輸精管堵塞并不一定導致不育,因為還有其他途徑可以將精子輸送到女性體內。例如,精子可以通過附睪、前列腺等組織到達女性體內。因此,如果輸精管堵塞,建議及時就醫,尋求專業醫生的幫助。 |

| 心肌梗塞能治療嗎? | 心肌梗死是一種嚴重的疾病,如果及時治療,可以挽救生命并防止長期殘疾。治療心肌梗死的關鍵是盡早識別和治療。 心肌梗死的治療通常包括以下步驟: 1. 立即就醫:如果出現胸痛、呼吸急促或暈厥等癥狀,立即就醫。 2. 藥物治療:醫生可能會開處方藥物,如硝酸甘油或阿司匹林,以幫助緩解癥狀并防止進一步的損傷。 3. 溶栓治療:如果患者在到達醫院前出現心肌梗死,醫生可能會進行溶栓治療,通過注射溶解血栓的藥物來幫助恢復血流。 4. 手術治療:如果藥物治療或溶栓治療無效,醫生可能會建議進行手術,如冠狀動脈搭橋手術或心臟支架植入術。 5. 康復和預防:心肌梗死的治療通常包括康復計劃,以幫助患者恢復身體功能并預防未來的心臟事件。此外,患者還應遵循醫生的建議,以降低患心臟病的風險。 需要注意的是,心肌梗死的治療取決于患者的具體情況和癥狀。因此,如果您或您認識的人出現心肌梗死癥狀,請立即就醫。 |

| 怎么讓自己精力充沛,列5點建議 | 1. 保持充足的睡眠:睡眠對于保持精力充沛至關重要。確保每晚獲得7-9小時的高質量睡眠。 2. 均衡飲食:均衡飲食對于保持能量水平至關重要。確保攝入足夠的蛋白質、碳水化合物和健康脂肪。 3. 定期鍛煉:定期鍛煉可以幫助提高能量水平。嘗試每天進行至少30分鐘的有氧運動,如散步、跑步或騎自行車。 4. 管理壓力:壓力會消耗能量,因此管理壓力對于保持精力充沛至關重要。嘗試找到放松和減壓的方法,如冥想、瑜伽或深呼吸練習。 5. 保持水分:脫水會降低能量水平。確保每天喝足夠的水,并根據需要補充水分。 |

| 寫個春天的詩 | 春天, 是大地蘇醒的季節, 是萬物復蘇的季節, 是生命綻放的季節。 春天, 是陽光明媚的季節, 是鳥語花香的季節, 是綠意盎然的季節, 是希望無限的季節。 春天, 是人們歡笑的季節, 是孩子們嬉戲的季節, 是戀人們相擁的季節, 是人們追求夢想的季節。 |

| 南極洲為啥沒有北極熊? | 南極洲沒有北極熊,因為北極熊生活在北極地區,而南極洲位于南半球,氣候和環境與北極地區有很大不同。南極洲的氣候非常寒冷,常年被冰雪覆蓋,而北極熊則生活在北極地區,那里有豐富的海洋生物和陸地哺乳動物。此外,南極洲的生態系統也與北極地區不同,沒有北極熊所需的生存條件。 |

📚 Dataset

醫療數據集

- 240萬條中文醫療數據集(包括預訓練、指令微調和獎勵數據集):shibing624/medical

- 22萬條中文醫療對話數據集(華佗項目):shibing624/huatuo_medical_qa_sharegpt [本項目支持格式]

通用數據集

Pretraining datasets

- 16GB中英文無監督、平行語料Linly-AI/Chinese-pretraining-dataset

- 524MB中文維基百科語料wikipedia-cn-20230720-filtered

SFT datasets

- 10萬條多語言ShareGPT GPT4多輪對話數據集:shibing624/sharegpt_gpt4 [本項目支持格式]

- 9萬條英文ShareGPT多輪對話數集:anon8231489123/ShareGPT_Vicuna_unfiltered [本項目支持格式]

- 50萬條中文ChatGPT指令Belle數據集:BelleGroup/train_0.5M_CN

- 100萬條中文ChatGPT指令Belle數據集:BelleGroup/train_1M_CN

- 5萬條英文ChatGPT指令Alpaca數據集:50k English Stanford Alpaca dataset

- 2萬條中文ChatGPT指令Alpaca數據集:shibing624/alpaca-zh

- 69萬條中文指令Guanaco數據集(Belle50萬條+Guanaco19萬條):Chinese-Vicuna/guanaco_belle_merge_v1.0

- 5萬條英文ChatGPT多輪對話數據集:RyokoAI/ShareGPT52K

- 80萬條中文ChatGPT多輪對話數據集:BelleGroup/multiturn_chat_0.8M

- 116萬條中文ChatGPT多輪對話數據集:fnlp/moss-002-sft-data

- 3.8萬條中文ShareGPT多輪對話數據集:FreedomIntelligence/ShareGPT-CN

Reward Model datasets

- 原版的oasst1數據集:OpenAssistant/oasst1

- 2萬條多語言oasst1的reward數據集:tasksource/oasst1_pairwise_rlhf_reward[本項目支持格式]

- 11萬條英文hh-rlhf的reward數據集:Dahoas/full-hh-rlhf

- 9萬條英文reward數據集(來自Anthropic’s Helpful Harmless dataset):Dahoas/static-hh

- 7萬條英文reward數據集(來源同上):Dahoas/rm-static

- 7萬條繁體中文的reward數據集(翻譯自rm-static)liswei/rm-static-m2m100-zh

- 7萬條英文Reward數據集:yitingxie/rlhf-reward-datasets

- 3千條中文知乎問答偏好數據集:liyucheng/zhihu_rlhf_3k

?? LICENSE

本項目僅可應用于研究目的,項目開發者不承擔任何因使用本項目(包含但不限于數據、模型、代碼等)導致的危害或損失。詳細請參考免責聲明。

Medical項目代碼的授權協議為 The Apache License 2.0,代碼可免費用做商業用途,模型權重和數據只能用于研究目的。請在產品說明中附加MedicalGPT的鏈接和授權協議。

😇 Citation

如果你在研究中使用了MedicalGPT,請按如下格式引用:

@misc{MedicalGPT,title={MedicalGPT: Training Medical GPT Model},author={Ming Xu},year={2023},howpublished={\url{https://github.com/shibing624/MedicalGPT}},

}

😍 Contribute

項目代碼還很粗糙,如果大家對代碼有所改進,歡迎提交回本項目,在提交之前,注意以下兩點:

- 在

tests添加相應的單元測試 - 使用

python -m pytest來運行所有單元測試,確保所有單測都是通過的

之后即可提交PR。

💕 Acknowledgements

- Direct Preference Optimization:Your Language Model is Secretly a Reward Model

- tloen/alpaca-lora

- ymcui/Chinese-LLaMA-Alpaca

- hiyouga/LLaMA-Factory

- dvlab-research/LongLoRA

Thanks for their great work!

關聯項目推薦

- shibing624/ChatPDF:基于本地 LLM 做檢索知識問答(RAG)

- shibing624/chatgpt-webui:給 LLM 對話和檢索知識問答(RAG)提供一個簡單好用的Web UI界面

:meshflow算法 C++實現)

:深入理解 TreeMap:Java 中的有序鍵值映射表)

面試題 | 精選25項常問)

: postman的介紹和安裝)

![[07] 組件注冊](http://pic.xiahunao.cn/[07] 組件注冊)