1.命令行搞定

git clone https://github.com/waketzheng/carstino

cd carstino

python3 upgrade_py.py

2.離線安裝

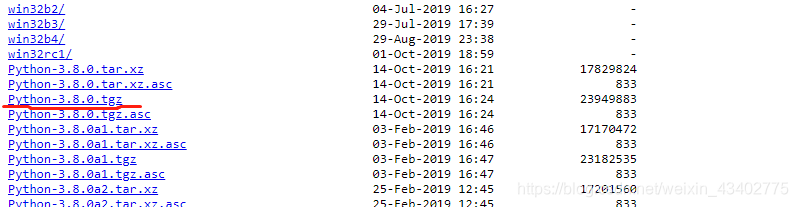

- 自己在官網下載安裝包

https://www.python.org/ftp/python/3.8.0/

- 解壓:

tar -zvf Python-3.8.0.tgz

- 安裝

cd Python-3.8.0

./configure --prefix=/usr/local/python3

make && make install

3. conda 安裝

conda install python=x.x

conda update python