文章目錄

- 算法介紹

- FP樹表示法

- 構建FP樹

- 實現代碼

- 建模資料

## 賽題思路

(賽題出來以后第一時間在CSDN分享)

https://blog.csdn.net/dc_sinor?type=blog

算法介紹

FP-Tree算法全稱是FrequentPattern Tree算法,就是頻繁模式樹算法,他與Apriori算法一樣也是用來挖掘頻繁項集的,不過不同的是,FP-Tree算法是Apriori算法的優化處理,他解決了Apriori算法在過程中會產生大量的候選集的問題,而FP-Tree算法則是發現頻繁模式而不產生候選集。但是頻繁模式挖掘出來后,產生關聯規則的步驟還是和Apriori是一樣的。

常見的挖掘頻繁項集算法有兩類,一類是Apriori算法,另一類是FP-growth。Apriori通過不斷的構造候選集、篩選候選集挖掘出頻繁項集,需要多次掃描原始數據,當原始數據較大時,磁盤I/O次數太多,效率比較低下。FPGrowth不同于Apriori的“試探”策略,算法只需掃描原始數據兩遍,通過FP-tree數據結構對原始數據進行壓縮,效率較高。

FP代表頻繁模式(Frequent Pattern) ,算法主要分為兩個步驟:FP-tree構建、挖掘頻繁項集。

FP樹表示法

FP樹通過逐個讀入事務,并把事務映射到FP樹中的一條路徑來構造。由于不同的事務可能會有若干個相同的項,因此它們的路徑可能部分重疊。路徑相互重疊越多,使用FP樹結構獲得的壓縮效果越好;如果FP樹足夠小,能夠存放在內存中,就可以直接從這個內存中的結構提取頻繁項集,而不必重復地掃描存放在硬盤上的數據。

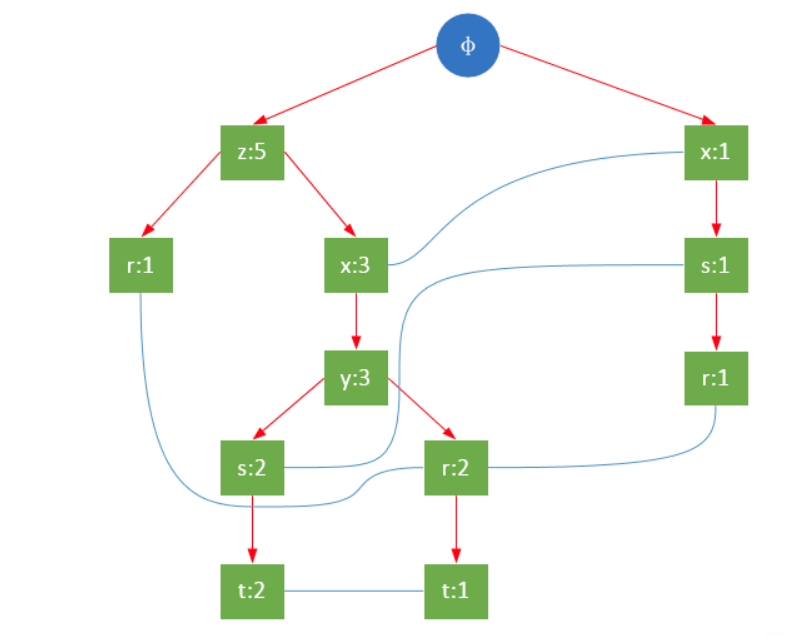

一顆FP樹如下圖所示:

通常,FP樹的大小比未壓縮的數據小,因為數據的事務常常共享一些共同項,在最好的情況下,所有的事務都具有相同的項集,FP樹只包含一條節點路徑;當每個事務都具有唯一項集時,導致最壞情況發生,由于事務不包含任何共同項,FP樹的大小實際上與原數據的大小一樣。

FP樹的根節點用φ表示,其余節點包括一個數據項和該數據項在本路徑上的支持度;每條路徑都是一條訓練數據中滿足最小支持度的數據項集;FP樹還將所有相同項連接成鏈表,上圖中用藍色連線表示。

為了快速訪問樹中的相同項,還需要維護一個連接具有相同項的節點的指針列表(headTable),每個列表元素包括:數據項、該項的全局最小支持度、指向FP樹中該項鏈表的表頭的指針。

構建FP樹

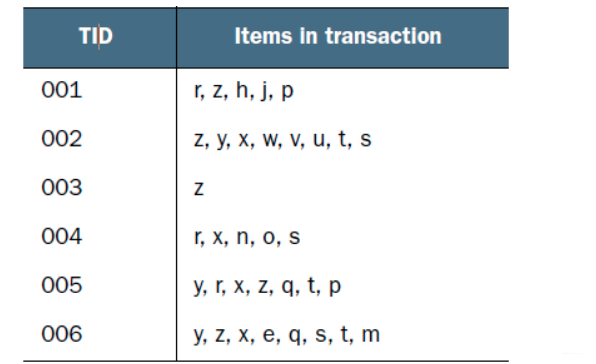

現在有如下數據:

FP-growth算法需要對原始訓練集掃描兩遍以構建FP樹。

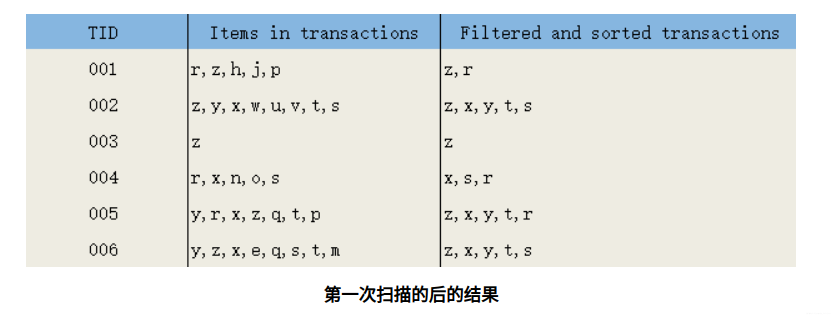

第一次掃描,過濾掉所有不滿足最小支持度的項;對于滿足最小支持度的項,按照全局最小支持度排序,在此基礎上,為了處理方便,也可以按照項的關鍵字再次排序。

第二次掃描,構造FP樹。

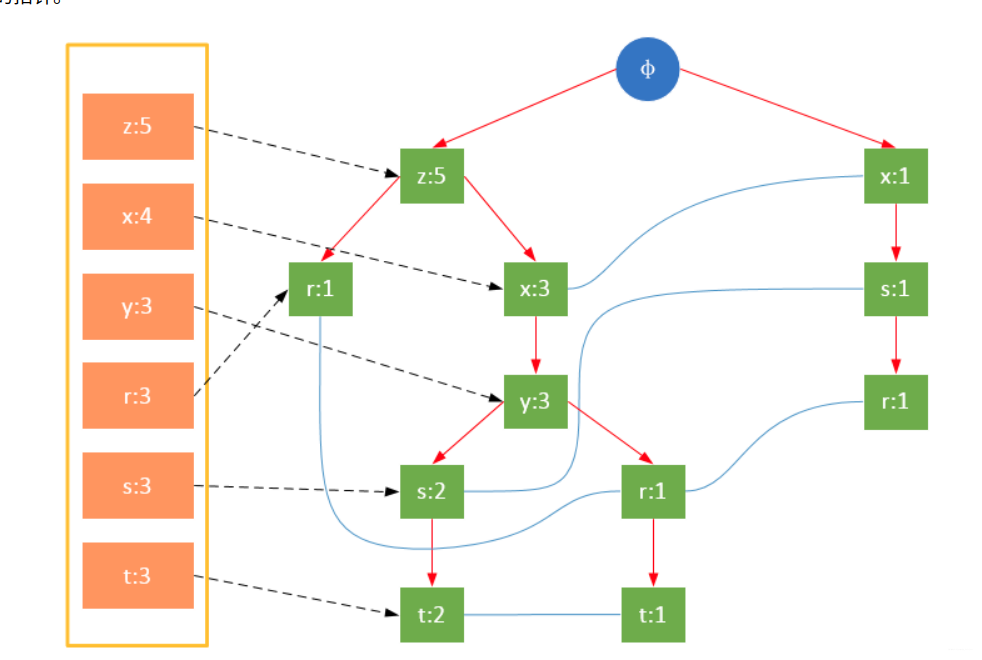

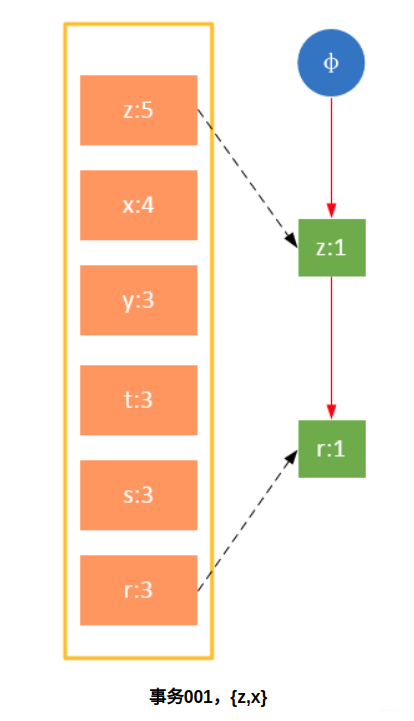

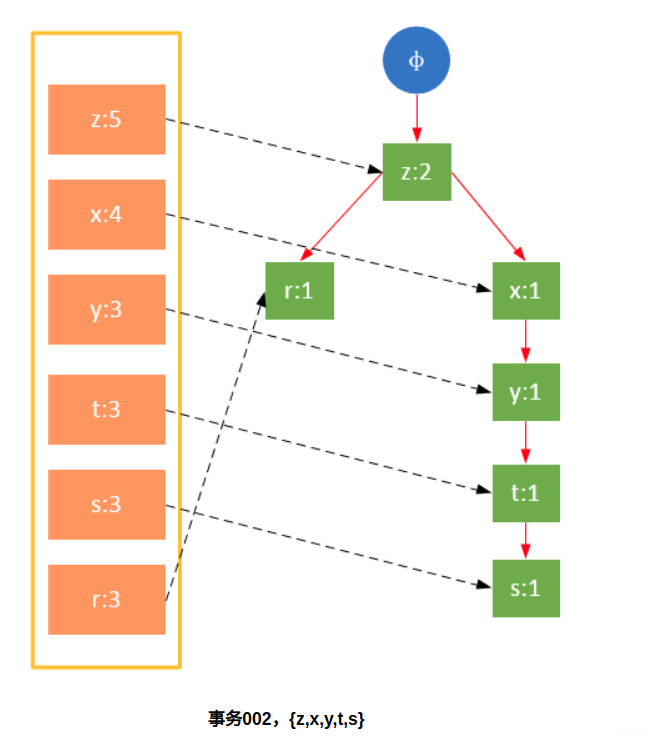

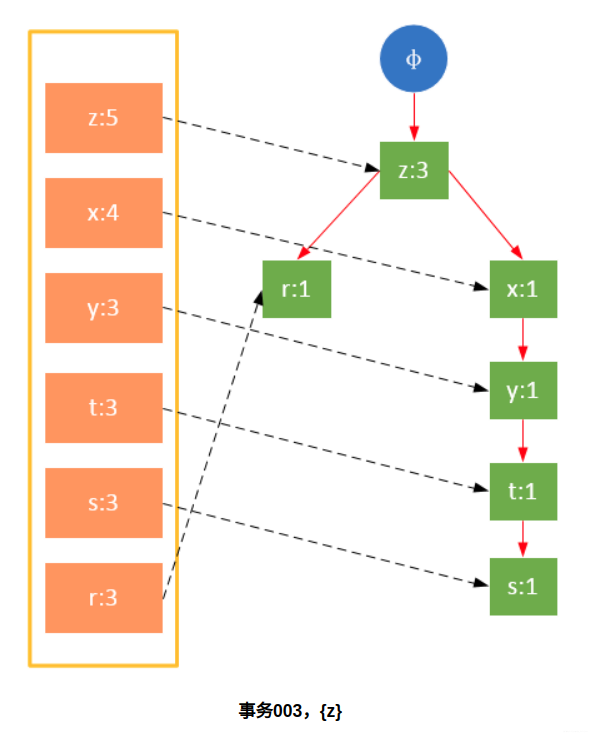

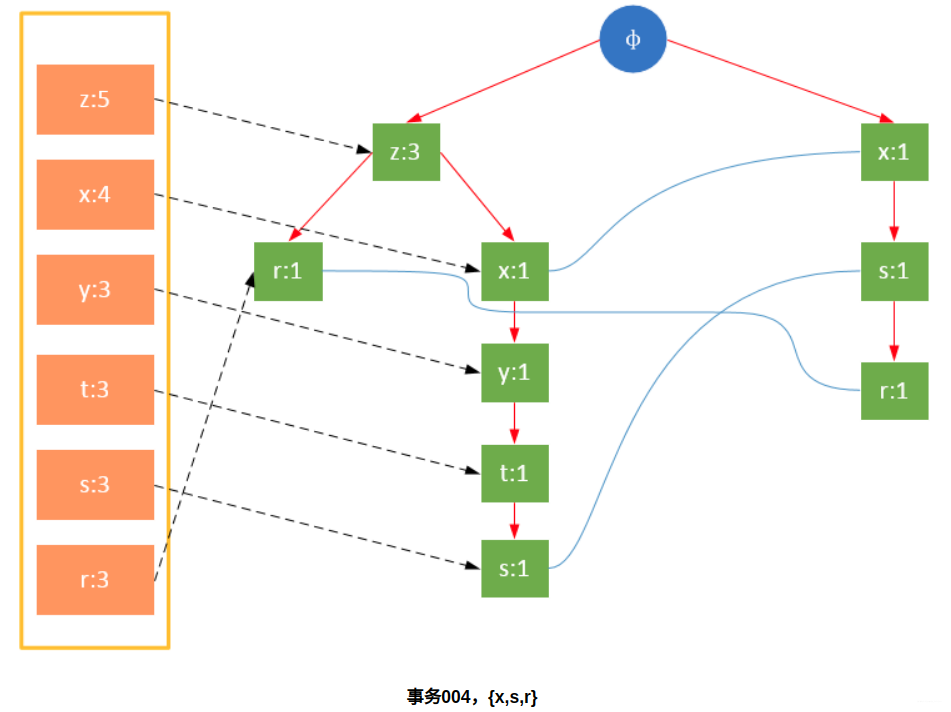

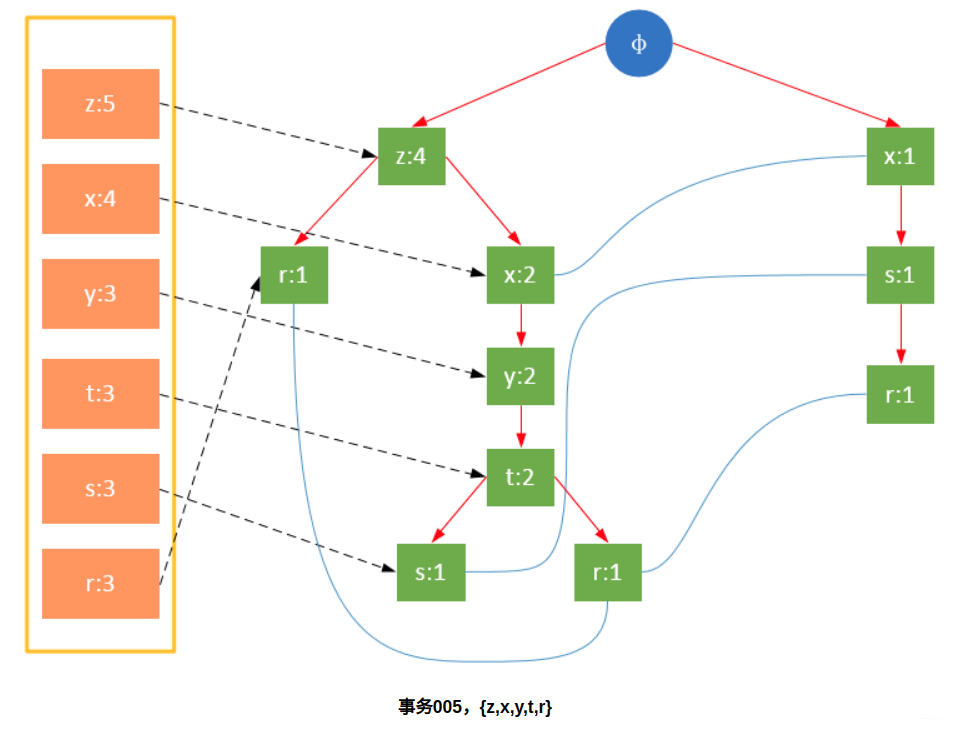

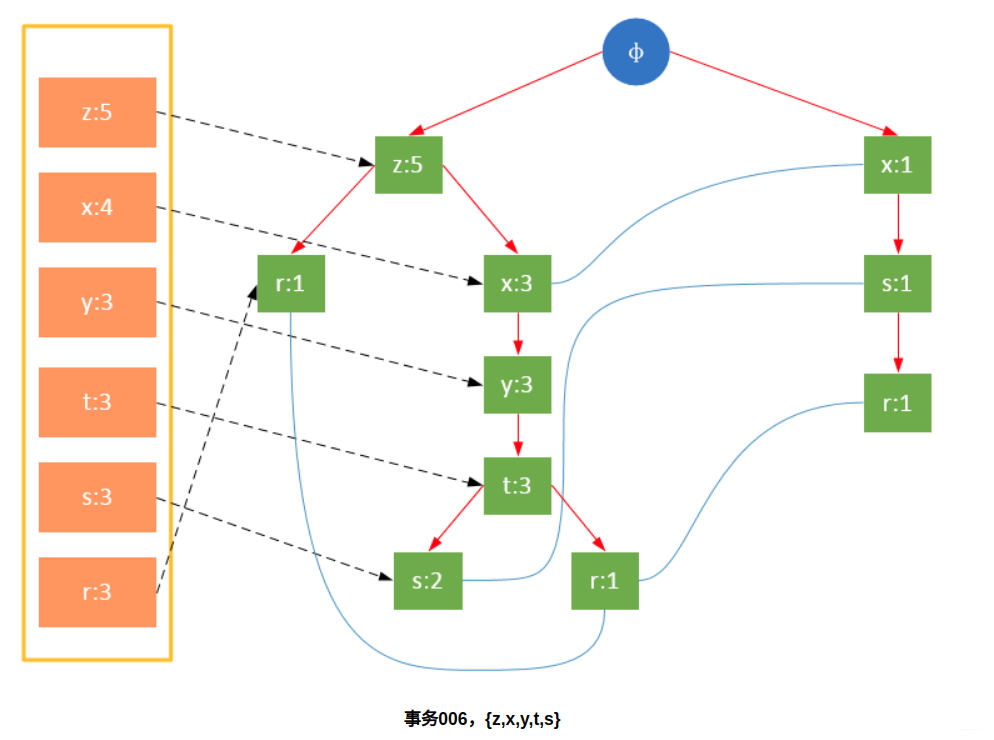

參與掃描的是過濾后的數據,如果某個數據項是第一次遇到,則創建該節點,并在headTable中添加一個指向該節點的指針;否則按路徑找到該項對應的節點,修改節點信息。具體過程如下所示:

從上面可以看出,headTable并不是隨著FPTree一起創建,而是在第一次掃描時就已經創建完畢,在創建FPTree時只需要將指針指向相應節點即可。從事務004開始,需要創建節點間的連接,使不同路徑上的相同項連接成鏈表。

實現代碼

def loadSimpDat():simpDat = [['r', 'z', 'h', 'j', 'p'],['z', 'y', 'x', 'w', 'v', 'u', 't', 's'],['z'],['r', 'x', 'n', 'o', 's'],['y', 'r', 'x', 'z', 'q', 't', 'p'],['y', 'z', 'x', 'e', 'q', 's', 't', 'm']]return simpDatdef createInitSet(dataSet):retDict = {}for trans in dataSet:fset = frozenset(trans)retDict.setdefault(fset, 0)retDict[fset] += 1return retDictclass treeNode:def __init__(self, nameValue, numOccur, parentNode):self.name = nameValueself.count = numOccurself.nodeLink = Noneself.parent = parentNodeself.children = {}def inc(self, numOccur):self.count += numOccurdef disp(self, ind=1):print(' ' * ind, self.name, ' ', self.count)for child in self.children.values():child.disp(ind + 1)def createTree(dataSet, minSup=1):headerTable = {}#此一次遍歷數據集, 記錄每個數據項的支持度for trans in dataSet:for item in trans:headerTable[item] = headerTable.get(item, 0) + 1#根據最小支持度過濾lessThanMinsup = list(filter(lambda k:headerTable[k] < minSup, headerTable.keys()))for k in lessThanMinsup: del(headerTable[k])freqItemSet = set(headerTable.keys())#如果所有數據都不滿足最小支持度,返回None, Noneif len(freqItemSet) == 0:return None, Nonefor k in headerTable:headerTable[k] = [headerTable[k], None]retTree = treeNode('φ', 1, None)#第二次遍歷數據集,構建fp-treefor tranSet, count in dataSet.items():#根據最小支持度處理一條訓練樣本,key:樣本中的一個樣例,value:該樣例的的全局支持度localD = {}for item in tranSet:if item in freqItemSet:localD[item] = headerTable[item][0]if len(localD) > 0:#根據全局頻繁項對每個事務中的數據進行排序,等價于 order by p[1] desc, p[0] descorderedItems = [v[0] for v in sorted(localD.items(), key=lambda p: (p[1],p[0]), reverse=True)]updateTree(orderedItems, retTree, headerTable, count)return retTree, headerTabledef updateTree(items, inTree, headerTable, count):if items[0] in inTree.children: # check if orderedItems[0] in retTree.childreninTree.children[items[0]].inc(count) # incrament countelse: # add items[0] to inTree.childreninTree.children[items[0]] = treeNode(items[0], count, inTree)if headerTable[items[0]][1] == None: # update header tableheaderTable[items[0]][1] = inTree.children[items[0]]else:updateHeader(headerTable[items[0]][1], inTree.children[items[0]])if len(items) > 1: # call updateTree() with remaining ordered itemsupdateTree(items[1:], inTree.children[items[0]], headerTable, count)def updateHeader(nodeToTest, targetNode): # this version does not use recursionwhile (nodeToTest.nodeLink != None): # Do not use recursion to traverse a linked list!nodeToTest = nodeToTest.nodeLinknodeToTest.nodeLink = targetNodesimpDat = loadSimpDat()

dictDat = createInitSet(simpDat)

myFPTree,myheader = createTree(dictDat, 3)

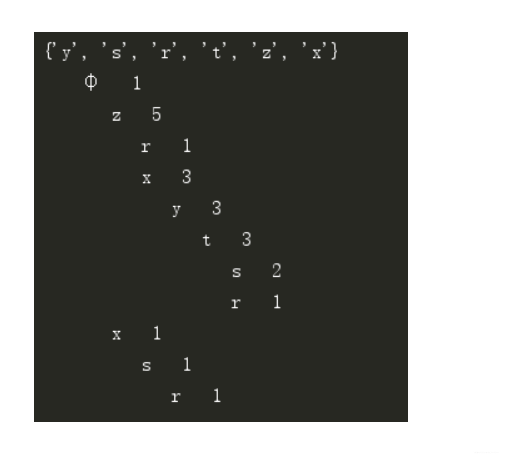

myFPTree.disp()

上面的代碼在第一次掃描后并沒有將每條訓練數據過濾后的項排序,而是將排序放在了第二次掃描時,這可以簡化代碼的復雜度。

控制臺信息:

建模資料

資料分享: 最強建模資料

九:自定義組件封裝下)

)

】)

簡單了解informer)

事務的并發問題和隔離級別)