基于Yolov5與LabelMe訓練自己數據的實例分割完整流程

- 1. Yolov5配置

- 2. 創建labelme虛擬環境

- 4. 接下來開始使用labelme繪制分割數據集

- 4.1 json to txt

- 4.2 劃分數據集(可分可不分)

- 5. 訓練

1. Yolov5配置

參照這邊文章:

https://blog.csdn.net/ruotianxia/article/details/132262747?spm=1001.2014.3001.5502

yolov5 各模型的百度網盤鏈接:

鏈接:https://pan.baidu.com/s/1ryXteXqMXCDy4V9dWqCmzw 提取碼:ca3x

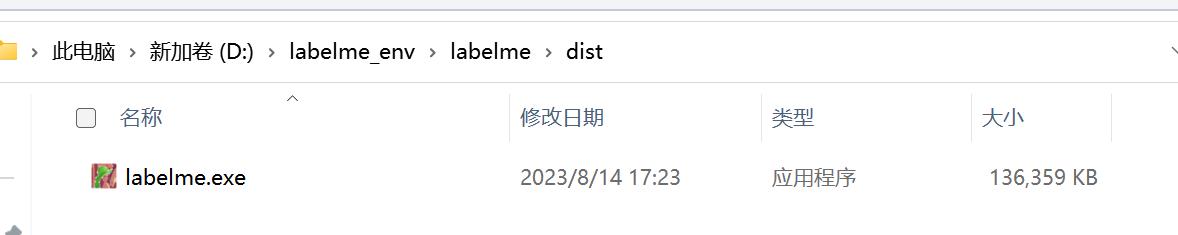

2. 創建labelme虛擬環境

conda create -n labelme python=3.9

# 激活labelme 環境,后續的安裝都在里面進行

conda activate labelme

# 下載label代碼

git clone https://github.com/wkentaro/labelme.git

cd labelme

conda install -c conda-forge pyside2 # 這條一定要安裝

pip install .

pip install pyinstaller

pyinstaller labelme.spec

# 編譯完成后,再cmd中輸入

labelme

即可打卡# 不從源碼安裝的話,直接按照官網上給的提示安裝就行,不用這么麻煩

# 安裝完成

如果有些因為網絡差下不下來,可以一個一個的安裝

# 網絡不好的情況下,安裝會出現中斷,將中斷處的依賴庫單獨使用清華鏡像下載,然后再繼續執行上一句

pip install -i https://pypi.tuna.tsinghua.edu.cn/simple PyQt5-Qt5

pip install -i https://pypi.tuna.tsinghua.edu.cn/simple networkx

pip install -i https://pypi.tuna.tsinghua.edu.cn/simple PyWavelets

pip install -i https://pypi.tuna.tsinghua.edu.cn/simple onnxruntime

pip install -i https://pypi.tuna.tsinghua.edu.cn/simple scikit_image

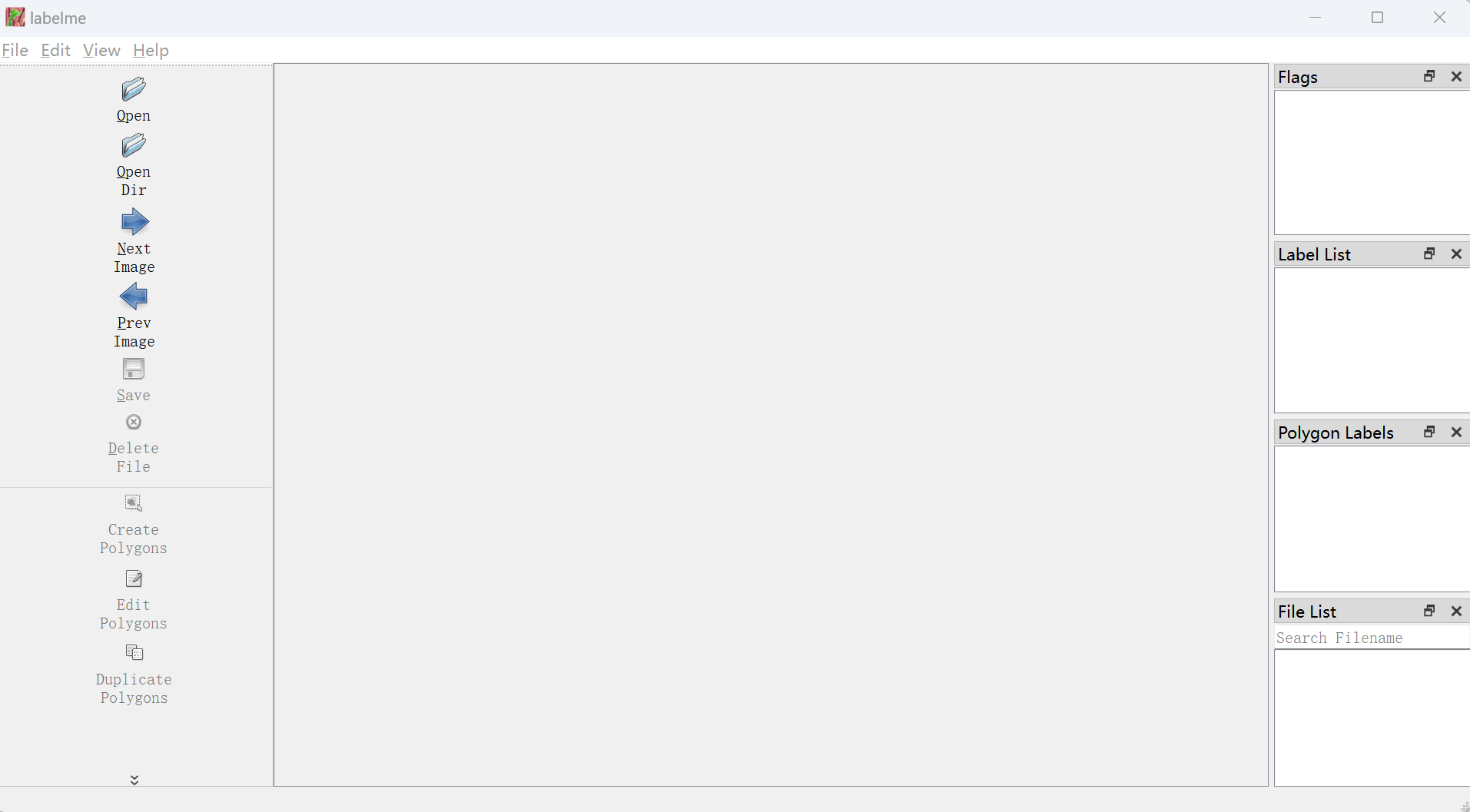

4. 接下來開始使用labelme繪制分割數據集

操作比較簡單,這里就不多說了,其保存的是json格式,需要轉換成yolo需要的txt.

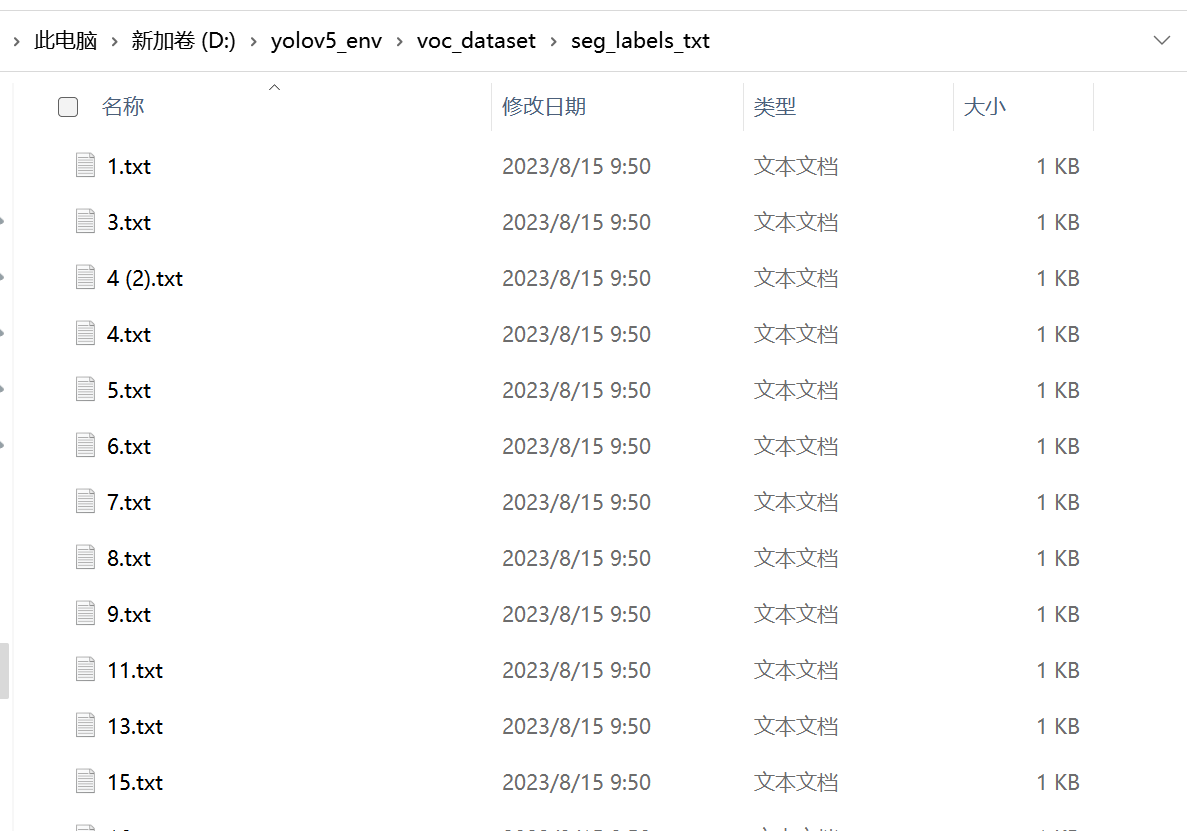

4.1 json to txt

https://blog.csdn.net/m0_51530640/article/details/129975257 參考文章

# -*- coding: utf-8 -*-

import json

import os

import argparse

from tqdm import tqdmdef convert_label_json(json_dir, save_dir, classes):json_paths = os.listdir(json_dir)classes = classes.split(',')for json_path in tqdm(json_paths):# for json_path in json_paths:path = os.path.join(json_dir, json_path)with open(path, 'r') as load_f:json_dict = json.load(load_f)h, w = json_dict['imageHeight'], json_dict['imageWidth']# save txt pathtxt_path = os.path.join(save_dir, json_path.replace('json', 'txt'))txt_file = open(txt_path, 'w')for shape_dict in json_dict['shapes']:label = shape_dict['label']label_index = classes.index(label)points = shape_dict['points']points_nor_list = []for point in points:points_nor_list.append(point[0] / w)points_nor_list.append(point[1] / h)points_nor_list = list(map(lambda x: str(x), points_nor_list))points_nor_str = ' '.join(points_nor_list)label_str = str(label_index) + ' ' + points_nor_str + '\n'txt_file.writelines(label_str)if __name__ == "__main__":"""python json2txt_nomalize.py --json-dir my_datasets/color_rings/jsons --save-dir my_datasets/color_rings/txts --classes "cat,dogs""""classes_name = 'scratch,dirty' # 中間不能帶空格parser = argparse.ArgumentParser(description='json convert to txt params')parser.add_argument('--json-dir', type=str, default='voc_dataset/seg_labels_json', help='json path dir')parser.add_argument('--save-dir', type=str, default='voc_dataset/seg_labels_txt', help='txt save dir')parser.add_argument('--classes', type=str, default=classes_name, help='classes')args = parser.parse_args()json_dir = args.json_dirsave_dir = args.save_dirclasses = args.classesconvert_label_json(json_dir, save_dir, classes)

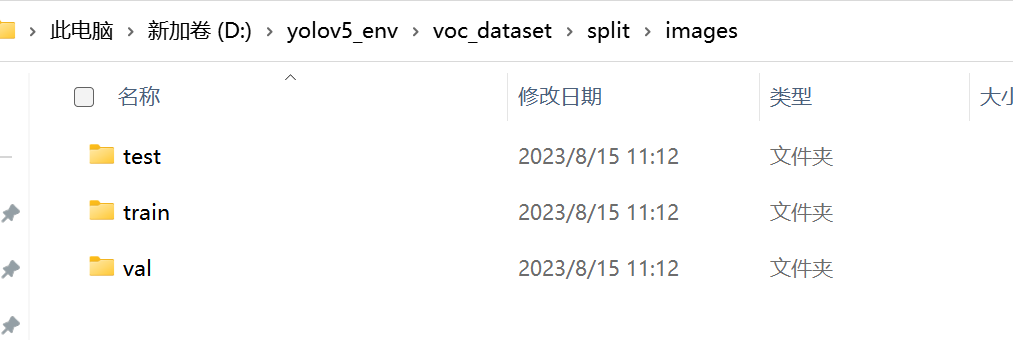

4.2 劃分數據集(可分可不分)

https://blog.csdn.net/m0_51530640/article/details/129975257 參考文章

# 將圖片和標注數據按比例切分為 訓練集和測試集

import shutil

import random

import os

import argparse# 檢查文件夾是否存在

def mkdir(path):if not os.path.exists(path):os.makedirs(path)def main(image_dir, txt_dir, save_dir):# 創建文件夾mkdir(save_dir)images_dir = os.path.join(save_dir, 'images')labels_dir = os.path.join(save_dir, 'labels')img_train_path = os.path.join(images_dir, 'train')img_test_path = os.path.join(images_dir, 'test')img_val_path = os.path.join(images_dir, 'val')label_train_path = os.path.join(labels_dir, 'train')label_test_path = os.path.join(labels_dir, 'test')label_val_path = os.path.join(labels_dir, 'val')mkdir(images_dir);mkdir(labels_dir);mkdir(img_train_path);mkdir(img_test_path);mkdir(img_val_path);mkdir(label_train_path);mkdir(label_test_path);mkdir(label_val_path);# 數據集劃分比例,訓練集75%,驗證集15%,測試集15%,按需修改train_percent = 0.8val_percent = 0.1test_percent = 0.1total_txt = os.listdir(txt_dir)num_txt = len(total_txt)list_all_txt = range(num_txt) # 范圍 range(0, num)num_train = int(num_txt * train_percent)num_val = int(num_txt * val_percent)num_test = num_txt - num_train - num_valtrain = random.sample(list_all_txt, num_train)# 在全部數據集中取出trainval_test = [i for i in list_all_txt if not i in train]# 再從val_test取出num_val個元素,val_test剩下的元素就是testval = random.sample(val_test, num_val)print("訓練集數目:{}, 驗證集數目:{},測試集數目:{}".format(len(train), len(val), len(val_test) - len(val)))for i in list_all_txt:name = total_txt[i][:-4]srcImage = os.path.join(image_dir, name + '.bmp')srcLabel = os.path.join(txt_dir, name + '.txt')if i in train:dst_train_Image = os.path.join(img_train_path, name + '.bmp')dst_train_Label = os.path.join(label_train_path, name + '.txt')shutil.copyfile(srcImage, dst_train_Image)shutil.copyfile(srcLabel, dst_train_Label)elif i in val:dst_val_Image = os.path.join(img_val_path, name + '.bmp')dst_val_Label = os.path.join(label_val_path, name + '.txt')shutil.copyfile(srcImage, dst_val_Image)shutil.copyfile(srcLabel, dst_val_Label)else:dst_test_Image = os.path.join(img_test_path, name + '.bmp')dst_test_Label = os.path.join(label_test_path, name + '.txt')shutil.copyfile(srcImage, dst_test_Image)shutil.copyfile(srcLabel, dst_test_Label)if __name__ == '__main__':"""python split_datasets.py --image-dir my_datasets/color_rings/imgs --txt-dir my_datasets/color_rings/txts --save-dir my_datasets/color_rings/train_data"""parser = argparse.ArgumentParser(description='split datasets to train,val,test params')parser.add_argument('--image-dir', type=str, default='voc_dataset/seg_images', help='image path dir')parser.add_argument('--txt-dir', type=str, default='voc_dataset/seg_labels_txt', help='txt path dir')parser.add_argument('--save-dir', default='voc_dataset/split', type=str, help='save dir')args = parser.parse_args()image_dir = args.image_dirtxt_dir = args.txt_dirsave_dir = args.save_dirmain(image_dir, txt_dir, save_dir)

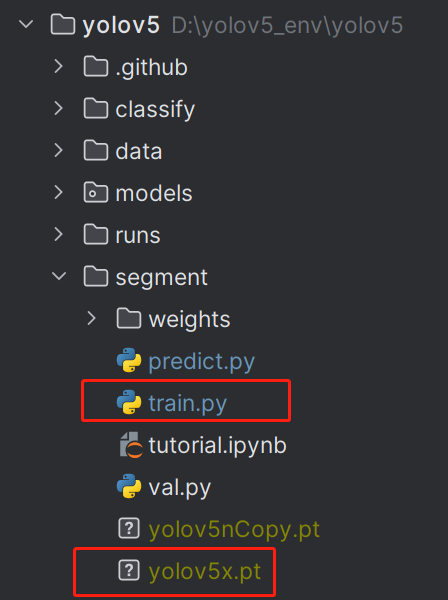

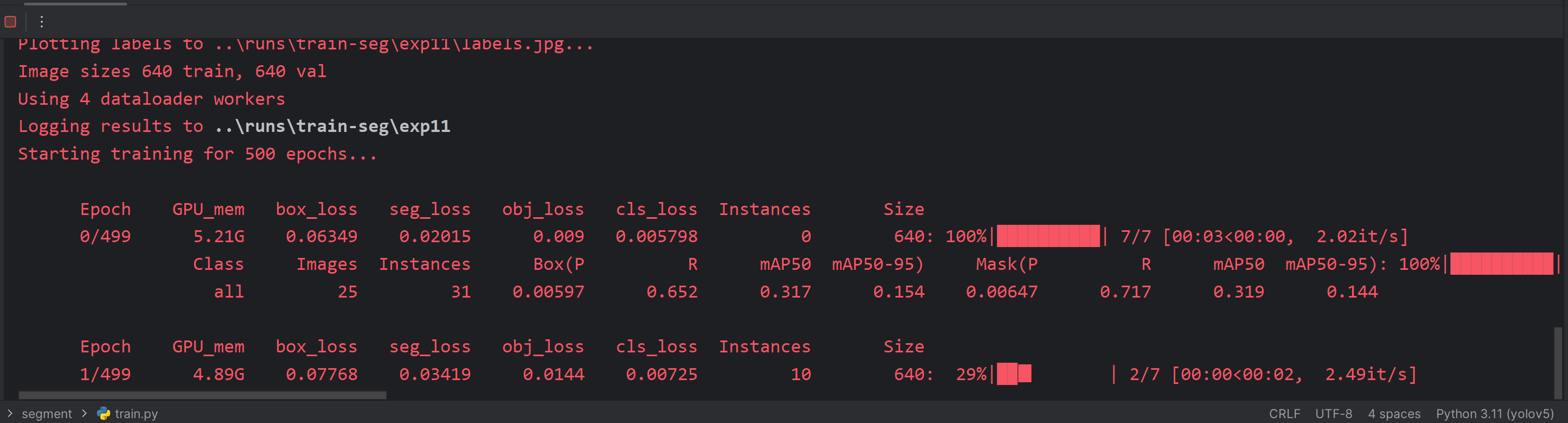

5. 訓練

訓練可以直接運行segment中的train,需要修改下文件的路徑,根據自己的需要進行修改。

注意需要再train.py的目錄下放置一個detection 訓練模型。

如果沒有分割好的數據集,代碼會自動下載coco128-seg。可以先熟悉下各文件的分布和訓練流程。

my-yolov5x-seg.yaml 修改類別數量

my-coco128-seg.yaml 修改數據路徑,類別名稱

hyp.scratch-low.yaml 修改訓練參數

parser.add_argument('--weights', type=str, default=ROOT / 'weights/best.pt', help='initial weights path')parser.add_argument('--cfg', type=str, default=ROOT / 'models/segment/my-yolov5x-seg.yaml', help='model.yaml path')parser.add_argument('--data', type=str, default=ROOT / 'data/my-coco128-seg.yaml', help='dataset.yaml path')parser.add_argument('--hyp', type=str, default=ROOT / 'data/hyps/hyp.scratch-low.yaml', help='hyperparameters path')

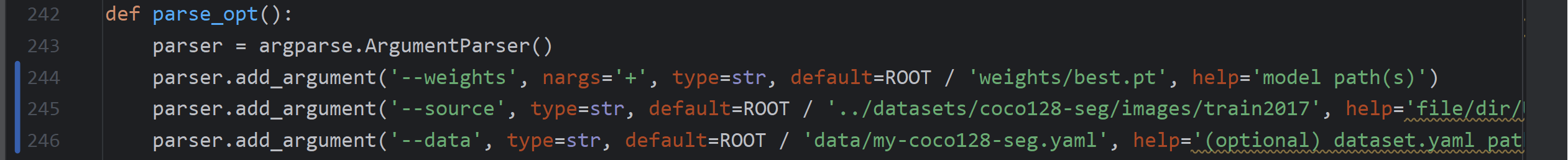

配置好后,直接運行trainpy就可以了。預測的話在predict中,同樣修改下文件路徑就可以預測圖片的結果。

predict.py 需要修改的內容如下:

預測時可以修改以下兩個參數,一個是置信度閾值,一個是iou閾值:

parser.add_argument('--conf-thres', type=float, default=0.006, help='confidence threshold')

parser.add_argument('--iou-thres', type=float, default=0.1, help='NMS IoU threshold')

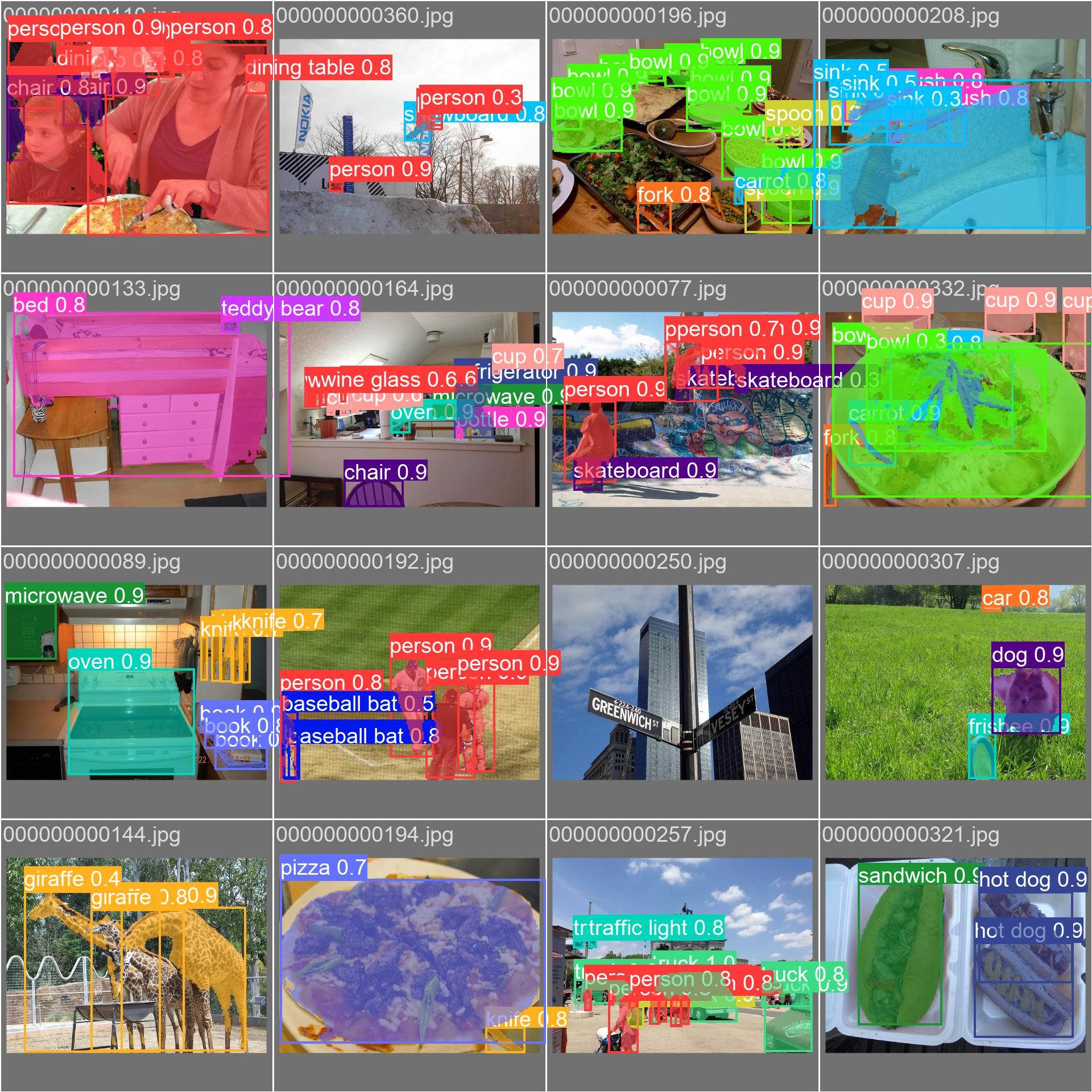

下面的是coco128訓練出的結果:

+ 樣式(CSS)+ 行為(JavaScript))