點擊上方藍字

關注我們

(本文閱讀時間:3分鐘)

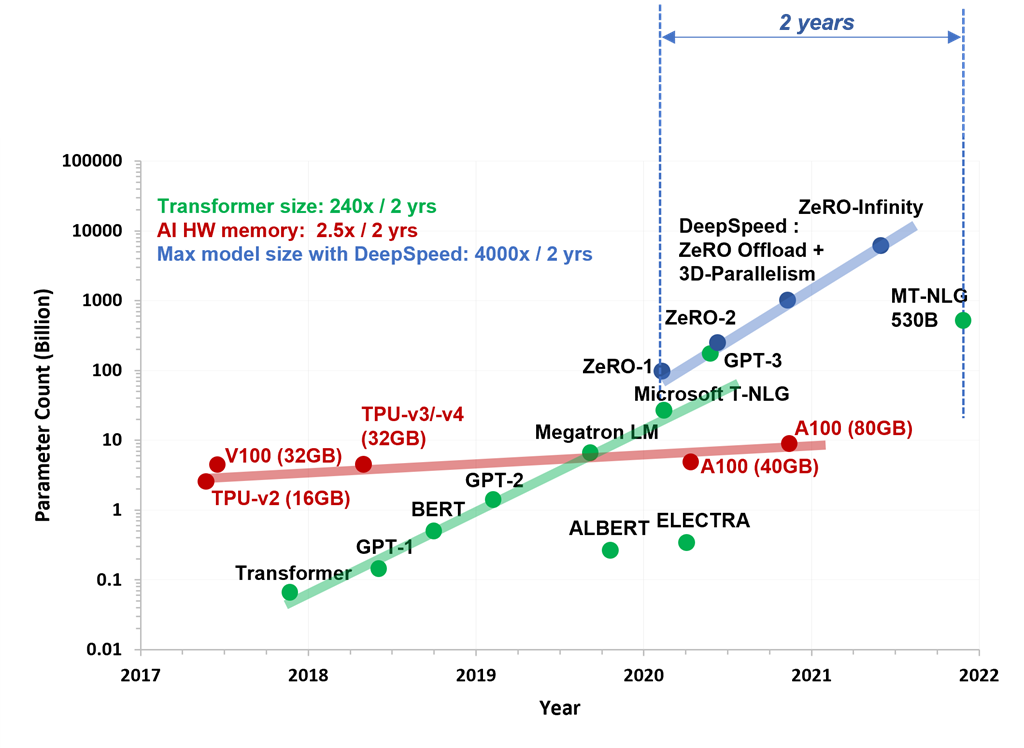

近年來,在大量數據上訓練的基于 transformer 的大規模深度學習模型在多項認知任務中取得了很好的成果,并且被使用到一些新產品和功能背后,進一步增強了人類的能力。在過去五年中,這些模型的規模增長了幾個數量級。從最初的 transformer 模型的幾百萬個參數一直到最新的 5300 億個參數的 Megatron-Turing (MT-NLG 530B) 模型(如圖所示),客戶對于前所未有的大規模訓練和微調大型模型的需求越來越強烈。

大模型和硬件能力全景圖??

Azure 機器學習 (AzureML)帶來了大量由 InfiniBand 互連提供支持的最新 GPU,以應對大規模 AI 訓練。我們已經在 Azure 上訓練了 Megatron/Turing 和 GPT-3這些模型。以前,為了訓練這些模型,用戶需要設置和維護一個復雜的分布式訓練基礎設施,通常涉及幾個手動的步驟,容易出錯,從而導致在可用性和性能方面的體驗不佳。

今天,我們很自豪地宣布在我們的軟件堆棧中取得突破——使用 DeepSpeed 和 1024 A100 來擴展 2T 參數模型的訓練,并在 1K+ GPU 規模上提供精簡的用戶體驗。我們將通過 AzureML(包括充分優化的 PyTorch 環境)為您帶來這些軟件創新,它為大規模訓練提供了出色的性能和易于使用的界面。

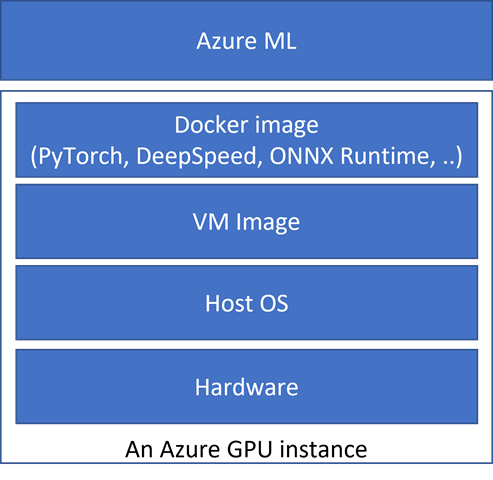

如下圖所示,微軟正在采用全棧優化方法,其中硬件、操作系統、VM image、Docker image(含優化后的PyTorch、DeepSpeed、ONNX 運行時和其他Python包)、面向用戶的Azure ML APIs都已經過優化、集成和測試,具有出色的性能和可擴展性。?

微軟針對 Azure 上可擴展分布式訓練的全棧優化

這個優化的堆棧使我們能夠使用DeepSpeed on Azure有效地擴展大型模型的訓練。與其他云場商發布的數據相比,我們支持 2 倍大的模型大小(2 萬億 vs. 1 萬億參數),擴展到 2 倍的 GPU(1024 vs. 512),以及高達 1.8 倍的計算吞吐量/GPU(150 TFLOPs vs. 81 TFLOPs)。

![]()

如果您想更深入地了解性能數據,以及Azure 和 DeepSpeed 如何使您輕松、高效地大規模訓練萬億參數模型,請掃碼或點擊最下方“閱讀原文”。原博客文末有豐富的相關資源!

長按識別二維碼

點擊「閱讀原文」前往原博客~

)

)

)

)