傳統安全風險

-

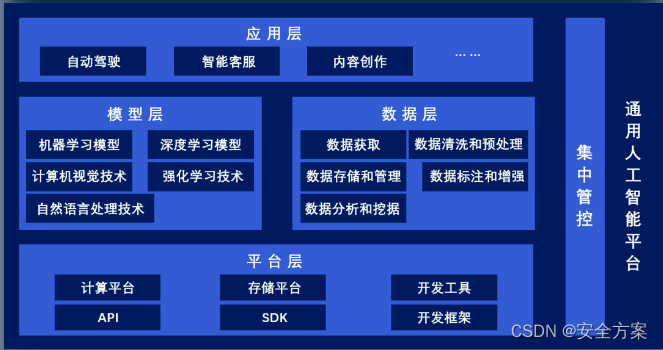

平臺基礎設施安全風險

-

模型與數據層安全風險

-

應用層安全風險

平臺基礎設施安全風險

(1)物理攻擊:機房管控不到位

(2)網絡攻擊

(3)計算環境:自身安全漏洞;未進行嚴格網絡隔離

模型與數據層安全風險

(1)供應鏈攻擊

(2)漏洞攻擊

(3)API 安全問題:API 的開放增加對外暴露面,導致更多外部威脅。

(4)運維安全問題

應用層安全風險

通用人工智能應用是基于人工智能底層服務提供的 API,以實現在各種實際場景下的落地。

除了一些大企業、研究機構具備人工智能全棧能力外,更多的企業依賴別人提供的底層服務能力來開發人工智能應用,從而面臨供應鏈攻擊、自身應用安全架構不合理、應用層漏洞以及各種合規風險。

數據泄露和濫用風險

-

模型和訓練數據保護難度提升

-

訓練數據泄露隱私、機密信息

-

訓練數據濫用,輸出不良信息

模型和訓練數據保護難度提升

(1)暴露面受攻擊風險

基于推廣和使用的考慮,往往將大模型部署在云端,并以 API 的方式將相關功能開放給其他用戶,以實現模型即服務(MaaS),這些算法模型、訓練數據勢必面臨著來自互聯網惡意用戶的攻擊、竊取的風險。

(2)逆向攻擊風險

通過模擬大量輸入請求得到大量模型輸出,從而逆向還原模型功能,達到竊取模型或者訓練數據的目的。

訓練數據泄露隱私、機密信息

(1)信息采集范圍更廣

在傳統互聯網應用當中,應用方采集用戶的手機號、姓名、性別、身份證號碼等個人信息以及操作記錄、消費記錄等行為信息,而通用人工智能應用除上述信息外,還廣泛采集其他具有強個人屬性的唯一生物特征信息,如聲紋、虹膜、指紋等。

(2)AI自學習泄露風險

例如員工在辦公環境中使用智能問答平臺時,容易將公司的商業機密信息輸入平臺尋找答案,而平臺在獲取到該信息后又用于自學習過程,繼而導致機密信息在其它場景下泄露。

訓練數據濫用,輸出不良信息

(1)內容審核不到位

目前全球互聯網流量每秒已超 PB 級別,傳統內容審核模式捉襟見肘。

(2)訓練數據不合規風險

如果為了節省成本,對采集的數據不清洗或清洗不徹底,濫用、誤用低質量、不完整的數據,導致輸出不良信息,引發監管處罰。

模型可靠性風險

-

數據源污染

-

模型魯棒性缺乏

-

算法的黑箱性

-

算法的偏見性

數據源污染

(1)訓練數據不可控

例如采集數據未清洗、清洗不到位,或者直接使用不可信第三方數據源。

(2)訓練數據特殊性,導致模型效率低下

由于大模型神經網絡訓練和推理需要使用高耗能的GPU和 TPU等加速硬件,如果用于訓練數據是一些特殊樣本,如海綿樣本,可造成大模型性能極低。

(3)數據源中被植入毒化數據、后門數據

攻擊者可在污染數據源中植入毒化數據、后門數據,從而導致大模型的決策偏離預期,甚至攻擊者可在不破壞模型原來準確率的同時入侵模型,使大模型在后續應用過程中做出符合攻擊者預期的決策。

模型魯棒性缺乏

(1)訓練數據無法覆蓋所有情況

大模型訓練需要完整的數據集,而訓練數據往往無法覆蓋到真實世界的各種異常場景,導致對于訓練中未出現的、真實世界的各種異常輸入,大模型無法做出準確的判斷與決策。

(2)攻擊者添加干擾噪聲

攻擊者可在輸入樣本中添加細微到人眼無法識別的干擾噪聲,從而在不引起注意的情況下,導致系統做出偏離預期的錯誤決策。

(3)攻擊者輸入偽造信息

攻擊者偽造具備個體唯一性特征的信息(指紋、虹膜、面容等),并作為智能身份認證系統的輸入,實現偽造攻擊。

算法的黑箱性

(1)算法結構隱層

AGI 核心基礎為深度學習,其算法結構存在多個隱層,導致輸入與輸出之間存在人類難以理解的因果關系、邏輯關系。

(2)算法模型自適應、自學習性等

具有自適應、自學習等特性,復雜程度超過人類大腦理解范疇,造成不可解釋性,給人工智能安全事件的溯源分析帶來了嚴峻挑戰。

算法的偏見性

(1)本身無判斷能力

人工智能模型算法追求的是統計的最優解,本身并不具備客觀公正的判斷能力。

(2)價值判斷具有地域、文化性

模型對于價值的判斷完全依賴于訓練數據,而倫理、道德、政治等復雜問題本身具有地域、文化特性。

濫用、誤用風險

-

危害社會穩定

-

降低企業創造積極性

-

侵犯個人基本權益

-

危害網絡空間安全

危害社會穩定

(1)生成虛假信息、負面信息

混淆視聽、左右公眾輿論,甚至改變熱點事件、政治事件的輿論走向,給社會帶來不穩定因素。

(2)深度偽造

制作虛假負面音頻、視頻等信息,嚴重擾亂社會正常秩序,并可用于欺詐、詐騙等違法犯罪活動。

降低企業創造積極性

部分大模型的訓練數據采集自公開數據,再加上版權保護法律的普遍滯后,新的人工智能創造物未得到法律有力保護,將嚴重影響企業投入人工智能創造的積極性。

侵犯個人基本權益

(1)個人隱私權益被侵犯

各種人工智能應用使用場景并未得到嚴格的規范與限制,濫用人工智能技術大量采集用戶的隱私信息,如指紋、人臉、虹膜等信息。

(2)個人人格尊嚴被侵犯

創建虛假人工智能聊天機器人,用于進行網絡欺詐或社交工程攻擊,獲取個人敏感信息或誘導用戶進行不恰當的行為。

(3)個人基本權益被侵犯

大模型設計、訓練之初誤用或濫用包含非客觀公正、帶歧視性的訓練數據,大模型的偏見性輸出很有可能給用戶帶來情感上的傷害。

危害網絡空間安全

(1)被廣泛應用于網絡攻擊各個環節

例如,ChatGPT 可用于快速收集目標資產信息,生成并發送大量釣魚郵件,也能基于目標資產指紋快速發現 NDay 漏洞,甚至可以通過掃描開源代碼、泄露的代碼自動檢測到 0Day 漏。

(2)自動構建漏洞利用代碼

基于大規模語言的預訓練模型還能根據漏洞原理自動構建漏洞利用代碼,從而實現快速入侵目標系統。

)

?))

)

)