Kubernetes集群中的Pod有時候會進入Terminating或Unknown狀態,本文列舉了6種可能的原因,幫助我們排查這種現象。原文: K8s Troubleshooting — Pod in Terminating or Unknown Status

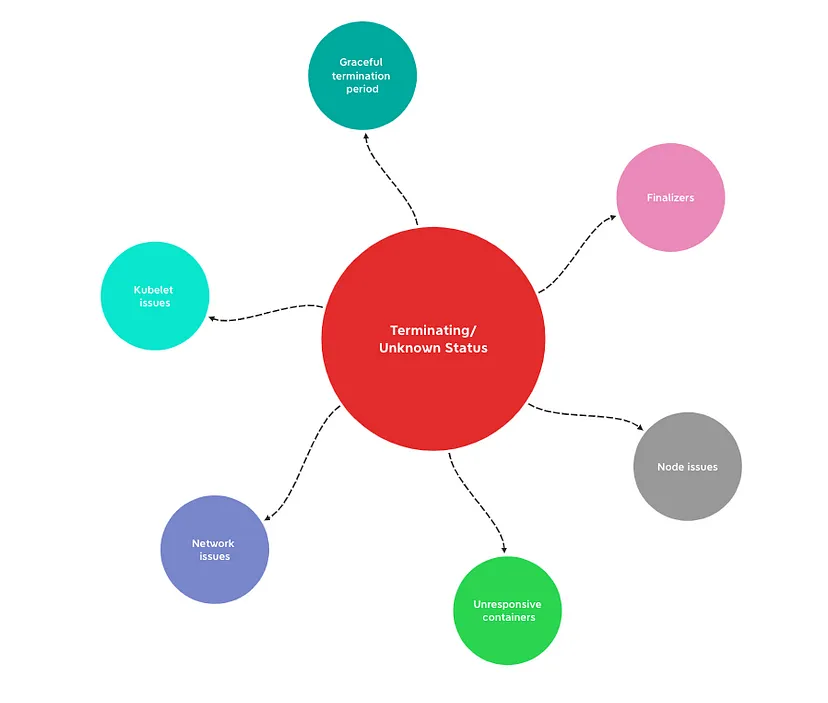

有時我們會看到K8S集群中的pod進入"Terminating"或"Unknown"狀態,pod進入這兩種狀態可能有以下原因:

-

優雅終止周期(Graceful termination period): 當pod被刪除時,會進入"Terminating"狀態,等待容器優雅關閉。如果容器關閉所需時間超過默認期限(默認30秒),則pod將保持在"Terminating"狀態。 -

Finalizers: Finalizer是一種允許在刪除資源之前清理資源的機制。如果pod有Finalizer,并且相關的清理操作被卡住或沒有響應,則pod將保持在"Terminating"狀態。 -

無響應容器(Unresponsive containers): 如果pod中的容器在終止過程中沒有響應SIGTERM信號,則可能導致pod卡在"Terminating"狀態。 -

節點問題(Node issues): 如果節點無響應、斷開連接或遇到其他問題,pod可能會進入"Unknown"狀態。在這種情況下,Kubernetes控制平面無法確定pod的實際狀態。 -

網絡問題(Network issues): 節點與Kubernetes控制平面之間的連接問題可能導致pod進入"Unknown"狀態。例如,如果控制平面無法與節點通信,則無法接收來自pod的狀態更新。 -

Kubelet問題: 如果節點上運行的Kubelet進程出現問題或崩潰,可能會導致無法將pod狀態上報給控制平面,從而造成pod進入"Unknown"狀態。

故障排查

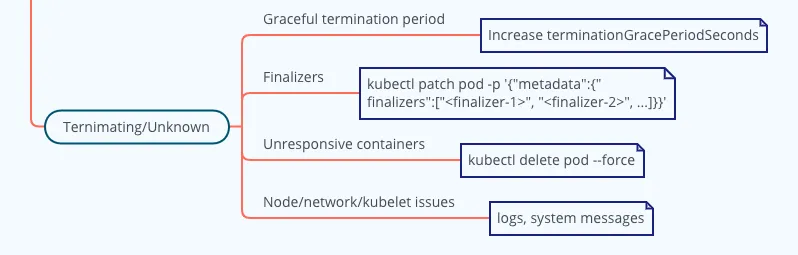

優雅終止周期(Graceful termination period)

K8S中的優雅終止周期是在刪除pod時,容器的優雅關閉時間。在此期間,容器接收SIGTERM信號,執行必要的清理工作,例如關閉連接,完成正在進行的任務,并在資源終止之前釋放資源,默認為30秒。

-

檢查pod狀態和事件: 通過 kubectl檢查pod的狀態和事件以獲取相關信息:

$?kubectl?describe?pod?<pod-name>?-n?<namespace>

-

檢查容器日志:

$?kubectl?logs?<pod-name>?-c?<container-name>?-n?<namespace>?--previous

-

調整優雅終止周期: 如果容器始終需要更多的時間來清理資源,可以通過在pod的YAML文件中設置 terminationGracePeriodSeconds字段來調整pod的終止周期。

apiVersion:?v1

kind:?Pod

metadata:

??name:?my-pod

spec:

??terminationGracePeriodSeconds:?60

??containers:

??-?name:?my-container

????image:?my-image

Finalizers

Finalizer允許在刪除資源之前清理資源,如果pod上存在Finalizer,并且相關的清理操作被卡住或沒有響應,則pod將保持在"Terminating"狀態。例如:

apiVersion:?v1

kind:?Pod

metadata:

??name:?my-finalizer-pod

??finalizers:

????-?example.com/cleanup

spec:

??containers:

??-?name:?busybox

????image:?busybox

????command:?["sh",?"-c",?"sleep?3600"]

檢查是否有finalizer,可以運行以下命令:

$?kubectl?get?pod?<pod-name>?-n?<namespace>?-o?json

如果確定不需要finalizer,或者確定可以將其安全刪除,可以使用kubectl patch命令。但是,這樣做要小心,因為可能會導致意想不到的副作用:

$?kubectl?patch?pod?<pod-name>?-n?<namespace>?-p?'{"metadata":{"finalizers":["<finalizer-1>",?"<finalizer-2>",?...]}}'

無響應容器(Unresponsive containers)

當容器消耗過多系統資源時,可能會進入無響應狀態。

-

用 kubectl describe命令查看Pod狀態和事件。

$?kubectl?describe?pod?<pod-name>?-n?<namespace>

-

檢查Pod/container日志:

$?kubectl?logs?<pod-name>?-c?<container-name>?-n?<namespace>

-

強制刪除pod: 可以強制刪除被卡住的pod

$?kubectl?delete?pod?<pod-name>?-n?<namespace>?--force?--grace-period=0

節點/網絡/Kubelet問題

執行以下步驟處理節點問題:

-

檢查節點狀態/事件: 檢查pod所在節點的狀態:

$?kubectl?describe?node?<node-name>

$?kubectl?get?events?--field-selector?involvedObject.kind=Node,involvedObject.name=<node-name>

-

檢查節點系統日志

$?journalctl?-u?kubelet

$?journalctl?-u?docker

$?journalctl?-u?containerd

$?cat?/var/log/messages

-

排空節點: 如果已經確定了節點問題,并且需要執行維護,可以排空節點以安全驅逐所有正在運行的pod,并將節點標記為不可調度:

$?kubectl?drain?<node-name>

結論

- END -你好,我是俞凡,在Motorola做過研發,現在在Mavenir做技術工作,對通信、網絡、后端架構、云原生、DevOps、CICD、區塊鏈、AI等技術始終保持著濃厚的興趣,平時喜歡閱讀、思考,相信持續學習、終身成長,歡迎一起交流學習。為了方便大家以后能第一時間看到文章,請朋友們關注公眾號"DeepNoMind",并設個星標吧,如果能一鍵三連(轉發、點贊、在看),則能給我帶來更多的支持和動力,激勵我持續寫下去,和大家共同成長進步!

本文由 mdnice 多平臺發布

實驗一:HTML5排版標簽使用)

-terraform創建阿里云資源)

)