具體請看智譜倉庫github:GitHub - THUDM/ChatGLM3: ChatGLM3 series: Open Bilingual Chat LLMs | 開源雙語對話語言模型

或者Huggingface:https://huggingface.co/THUDM/chatglm3-6b

1. 利用Anaconda建立一個虛擬環境:

conda create -n chatglm3 python=3.11 (版本太低安裝streamlit會出問題)

conda activate chatglm32. 安裝torch的GPU版:

根據自己本地計算機顯卡和系統選擇官方上相應的指令:

conda install pytorch torchvision torchaudio pytorch-cuda=12.1 -c pytorch -c nvidia這塊安裝時間較長,耐心等待,反復嘗試,直到安裝成功為止。其中,需要測試一下GPU的CUDA功能是否可以正常使用:

print(torch.version.cuda) #查看cuda版本

print(torch.cuda.is_available()) # 查看cuda是否可用

print(torch.cuda.device_count()) # 查看可行的cuda數目如果以上指令運行沒問題,顯示True,說明可以GPU可以正常使用。

3.開始安裝ChatGLM3,根據以上官網地址的說明進行如下操作:

? ? ?選擇D盤或者其他盤建立一個本地文件,利用管理員權限打開一個cmd窗口運行如下命令:

git clone https://github.com/THUDM/ChatGLM3

cd ChatGLM3然后使用 pip 安裝依賴:

pip install -r requirements.txt此外,使用 Code Interpreter 還需要安裝 Jupyter 內核:

ipython kernel install --name chatglm3-demo --user

然后,進入basic_demo目錄下,實現三種新的樣例測試

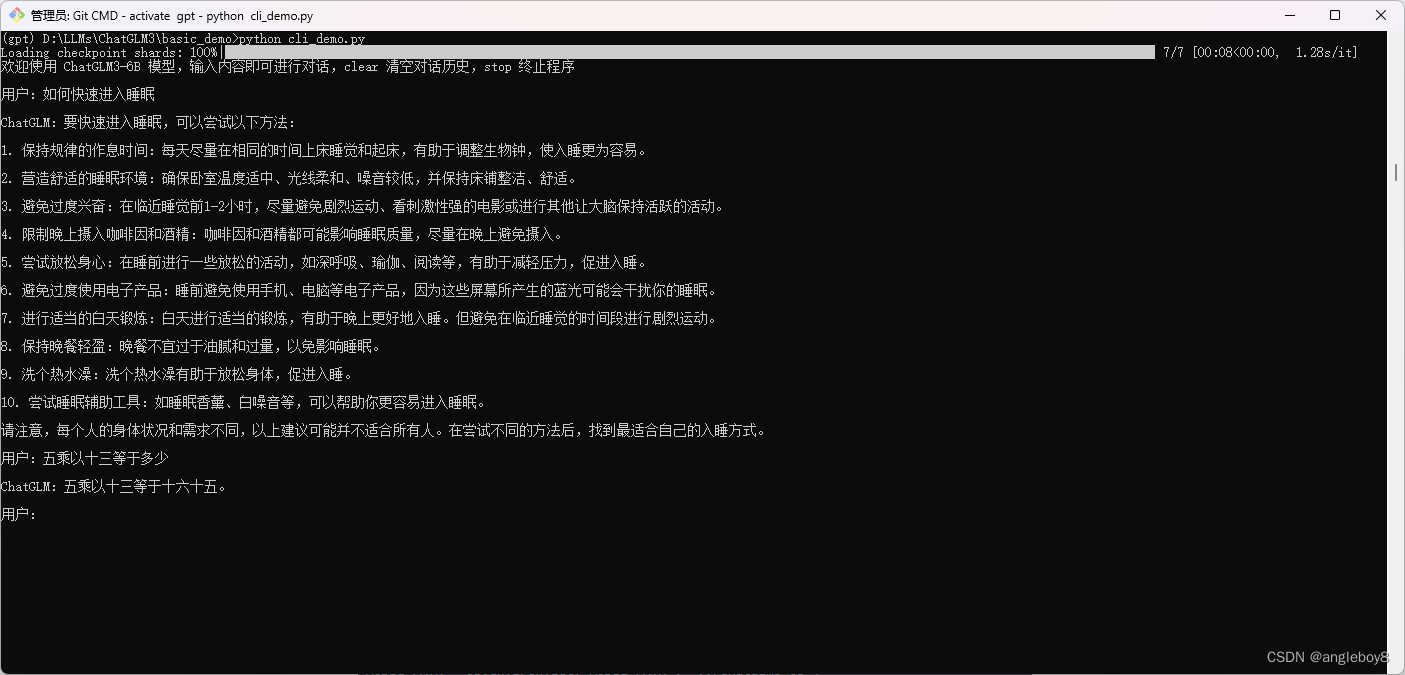

? ? 1)案例1——指令窗口

運行如下指令:

python cli_demo.py

指令對話窗口案例2:

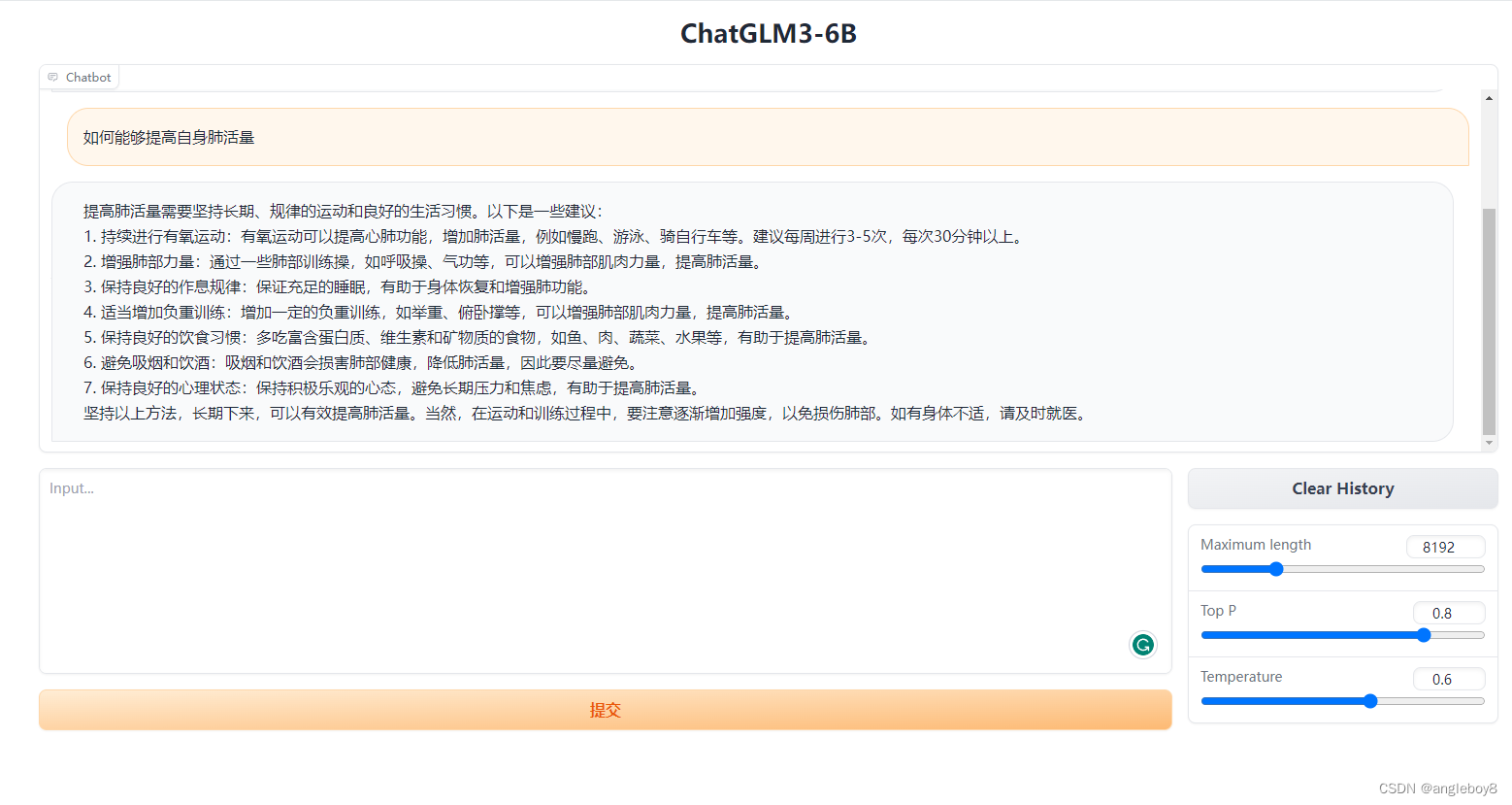

? ? 2)?案例2——Gradio

? ? ? ?運行如下命令:

python web_demo.py

注意:如果不輸出結果,是由于Gradio的版本過高,建議安裝pip install gradio==3.40版本。太低會報錯,比如3.39版本。

? ?3) 案例3——streamlit

? ? ? ?運行如下命令:

streamlit run web_demo2.py

其中,需要修改一下路徑,將下載好的模型放到本目錄下,將第6行程序改為

將MODEL_PATH = os.environ.get('MODEL_PATH', 'THUDM/chatglm3-6b')改為

MODEL_PATH = os.environ.get('MODEL_PATH', '../chatglm3-6b')這樣所有的程序和模型都在一起,方便管理。

程序啟動之后,瀏覽器顯示如下:

安裝過程中一些注意事項:

- 遇到“RuntimeError: nvrtc: error: failed to open nvrtc-builtins64_121.dll.

? Make sure that nvrtc-builtins64_121.dll is installed correctly.”

需要將虛擬環境下的“nvrtc-builtins64_121.dll”文件拷貝到C:\Windows\System32目錄下,即可解決。

)