最近騰訊出了自己的大模型,命名混元。

現在已經開始內測,感謝騰訊小伙伴盧曉明同學幫我們提前申請到了內測機會,接下來我們用騰訊混元大模型與實際工作結合,開始我的報表測試之旅。

騰訊混元大模型官方入口:https://hunyuan.tencent.com/

報表測試中,經常遇到這種情況,1.0版本已經上線了。2.0版本只修改幾個指標的值,沒有修改其他指標,上線前回歸測試需要覆蓋其他指標有沒有受到影響。手工測試的方式是將兩個、或者多個報表導出來,一一比差異字段值,那會非常的低效并且出錯率很高。下面使用騰訊混元大模型在輔助測試,看看能不能對我們有所幫助。

一、提示詞NO1:"你最近接到了報表測試的任務,有兩份報表。如何對這兩份報表進行比較,并使用紅色標記出不同點,需要哪些步驟?"

如果你想學習自動化測試,我這邊給你推薦一套視頻,這個視頻可以說是B站播放全網第一的自動化測試教程,同時在線人數到達1000人,并且還有筆記可以領取及各路大神技術交流:798478386???

【已更新】B站講的最詳細的Python接口自動化測試實戰教程全集(實戰最新版)_嗶哩嗶哩_bilibili【已更新】B站講的最詳細的Python接口自動化測試實戰教程全集(實戰最新版)共計200條視頻,包括:1、接口自動化之為什么要做接口自動化、2、接口自動化之request全局觀、3、接口自動化之接口實戰等,UP主更多精彩視頻,請關注UP賬號。![]() https://www.bilibili.com/video/BV17p4y1B77x/?spm_id_from=333.337.search-card.all.click這里它給出了思路,我計劃讓它用生成python代碼的方式輔助我們進行比較測試

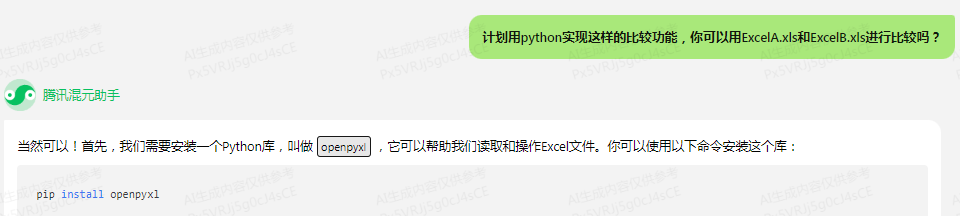

https://www.bilibili.com/video/BV17p4y1B77x/?spm_id_from=333.337.search-card.all.click這里它給出了思路,我計劃讓它用生成python代碼的方式輔助我們進行比較測試

二、提示詞NO2:"計劃用python實現這樣的比較功能,你可以用ExcelA.xls和ExcelB.xls進行比較嗎?"

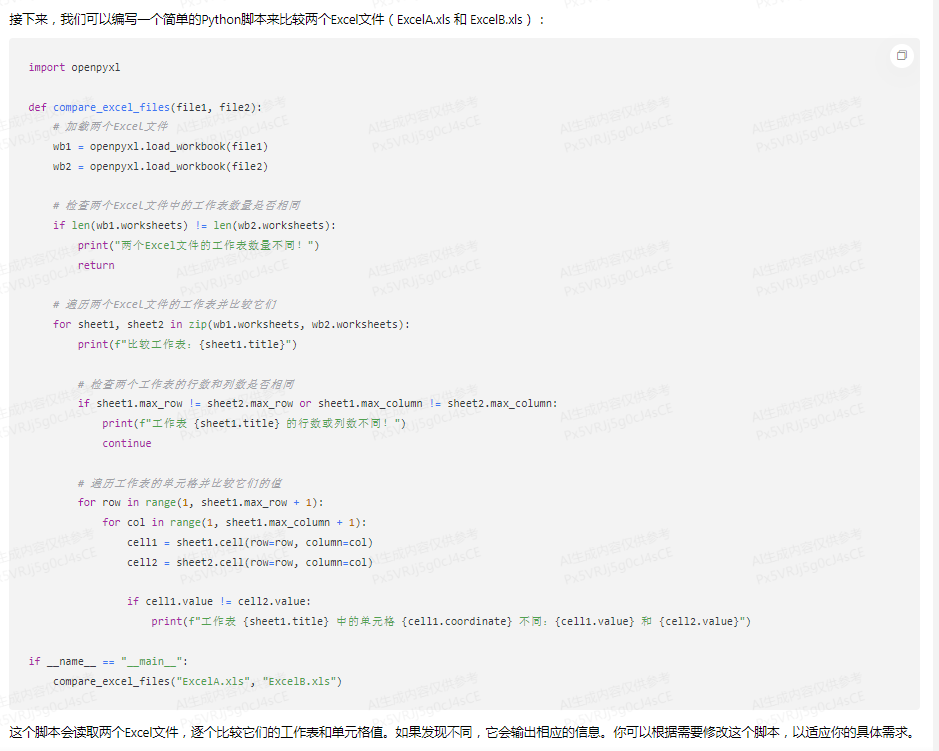

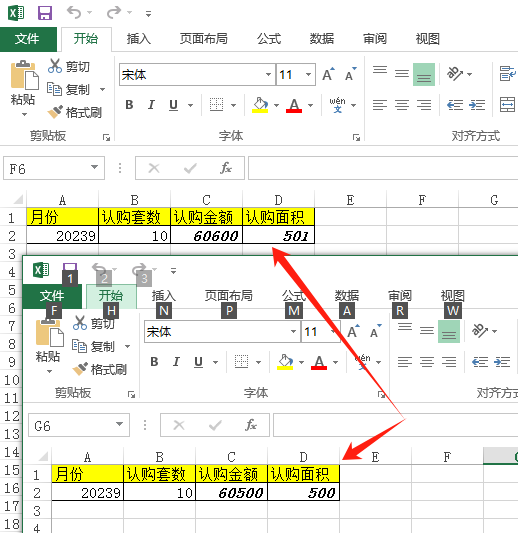

1、我在本地電腦創建了兩個文件,分別是文件ExcelA.xlsx,ExcelB.xlsx,兩個文件的值不同,來試用這段代碼能否正常比較

截圖是兩個文件的內容

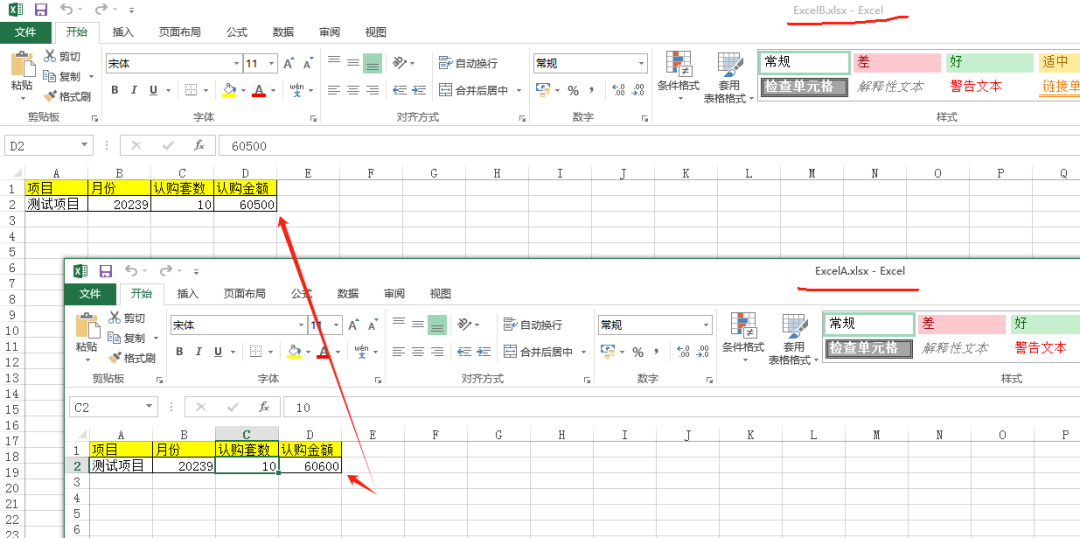

2、將這段代碼拷貝到Visual Studio Code編輯器,驗證能不能正常執行和正確比較

通過Visual Studio Code的控制臺可以看出,生成的輔助代碼能正常執行,而且能輸出比較結果。

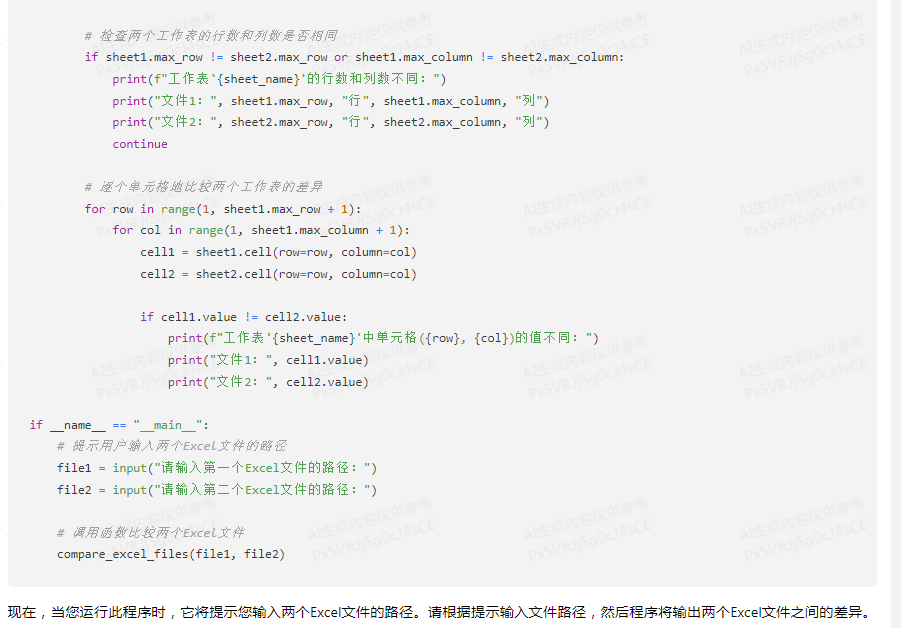

三、繼續優化代碼

提示詞:"請繼續優化這個代碼,文件1和文件2使用用戶實際定義的文件名替代"。這里優化成接收鍵盤輸入的方式,傳遞文件完整路徑。

這里可以看出騰訊混元大模型,對上下文的理解是連貫的,能夠準確領會我的意思。

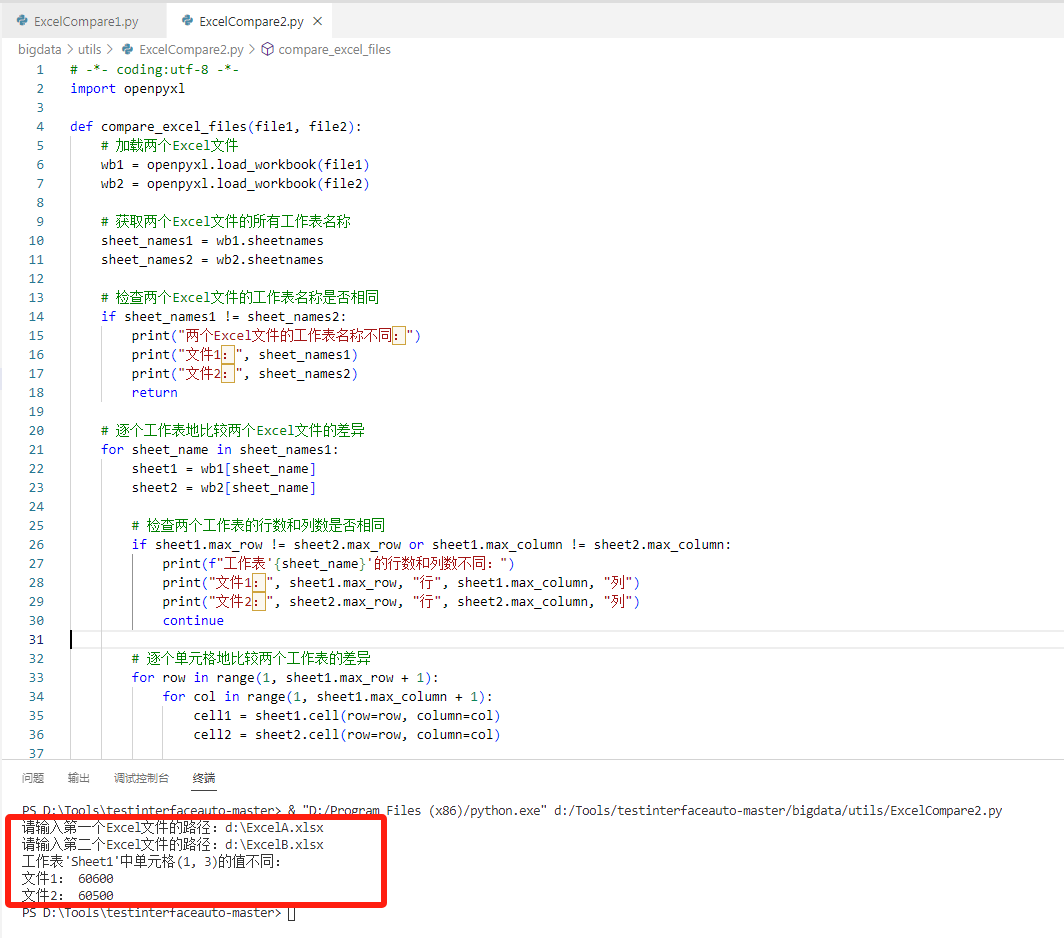

四、在Visual Studio Code嘗試運行代碼

1、嘗試運行助手生成的代碼,檢查是否有語法錯誤,能否正確生成我需要的效果。

控制臺輸出的結果顯示,可以正常比對兩個Excel的差異,不錯!!

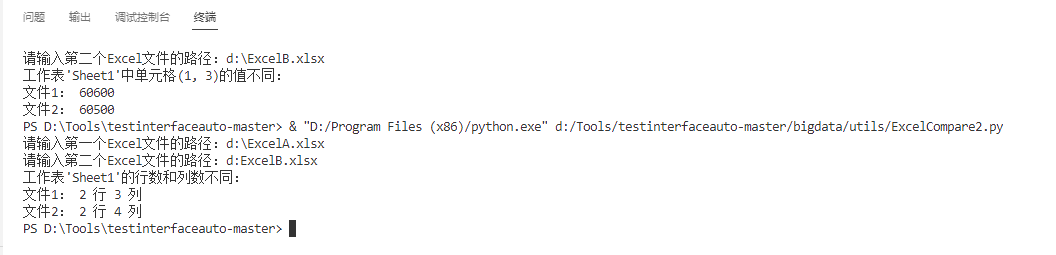

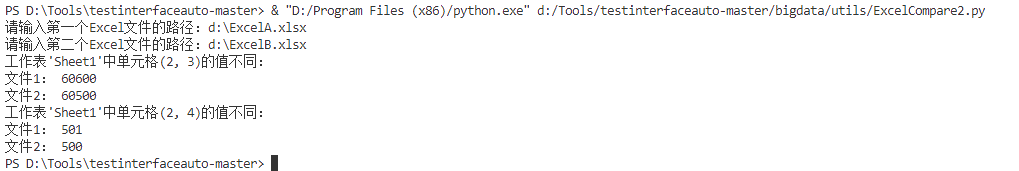

2、我又修改了Excel文件,將一個單元格值修改成多個單元格值有差異,做執行比對。期望嘗試多值不同時,是否可以正常執行比對。

控制臺輸出的結果顯示,多個差異值也可以輸出比對結果。

3、繼續優化提示詞,調整生成效果

提示詞:可以將有差異的單元格的字體變成粗斜體嗎?

回答結果顯示,它能get到我的意思,上下文的理解和回答也是連貫的,思路沒有中斷。

4、將這段代碼拷貝到Visual Studio Code并觀察執行效果、查看ExcelA和ExcelB文件是否標記出了粗斜體

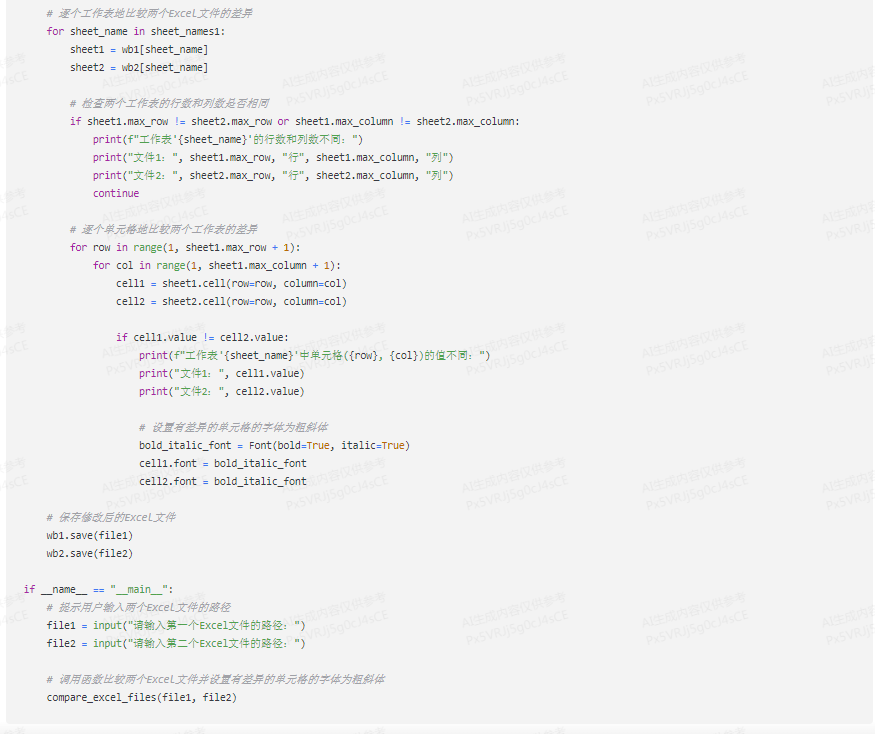

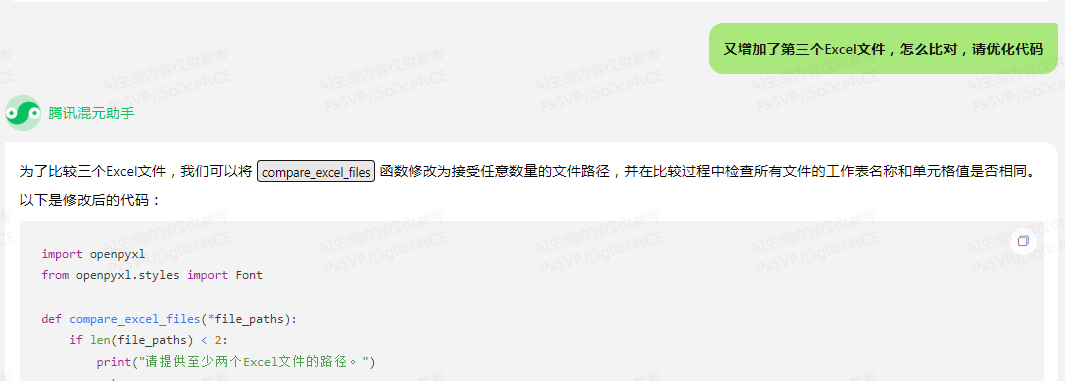

5、再次優化代碼,超過2個以上文件時,怎么比較?

我這里面截圖完整代碼,實際上它也給出正確的答案。

五、總結

??以上就是我們借助騰訊混元大模型,輔助開發一個報表數據比對程序的全過程演示。

??從結果上來看,騰訊混元大模型的確可以給我們在輔助自動化測試時提供幫助,提高測試驗收的效率、保障驗收的質量。

尤其對于大量的數據報表比對的這種驗收需求來說,在過去需要人工的方式非常非常的費時并且不能保證完整覆蓋,導致測試問題遺留到生產環境或者客戶現場。現在借助于大模型,可以很方便地得到示例代碼,稍加調整就可以應用在代碼中,大大節省了時間。

)

![[個人筆記] Windows配置OpenSSH免密連接](http://pic.xiahunao.cn/[個人筆記] Windows配置OpenSSH免密連接)