諸神緘默不語-個人CSDN博文目錄

諸神緘默不語的論文閱讀筆記和分類

論文名稱:Language Models as Knowledge Bases?

ArXiv網址:https://arxiv.org/abs/1909.01066

官方GitHub項目:https://github.com/facebookresearch/LAMA

本文是2019年EMNLP論文,作者來自臉書和倫敦大學學院。

本文關注LM中蘊含的知識,想要探索的問題是,通過在大型的文本語料上進行預訓練,語言模型是否已經(或是有潛力)學習到并存儲下了一些事實知識(主體-關系-客體形式的三元組 (subject, relation, object) 或是問題-答案對)?

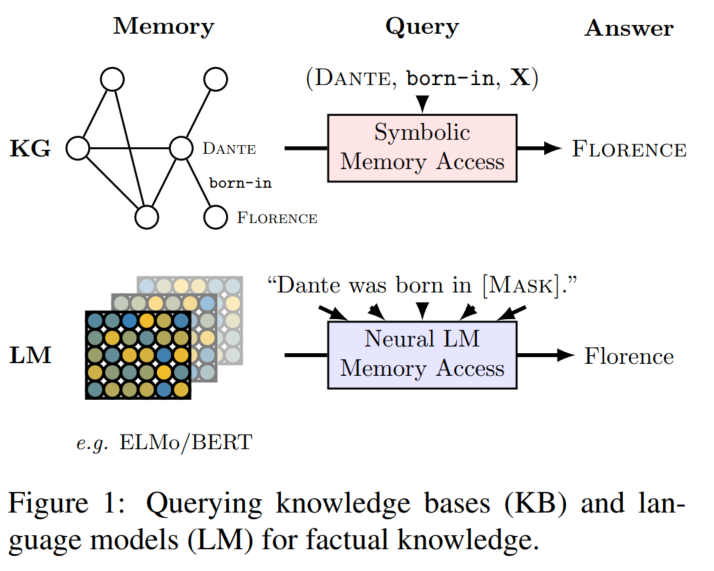

本文通過將事實三元組轉換為自然語言形式,讓LM(未經過微調的)用完形填空的形式來預測其中的object(把relation反過來也能預測subject),來進行這一探查:LAMA (LAnguage Model Analysis)

評估正確結果的排序

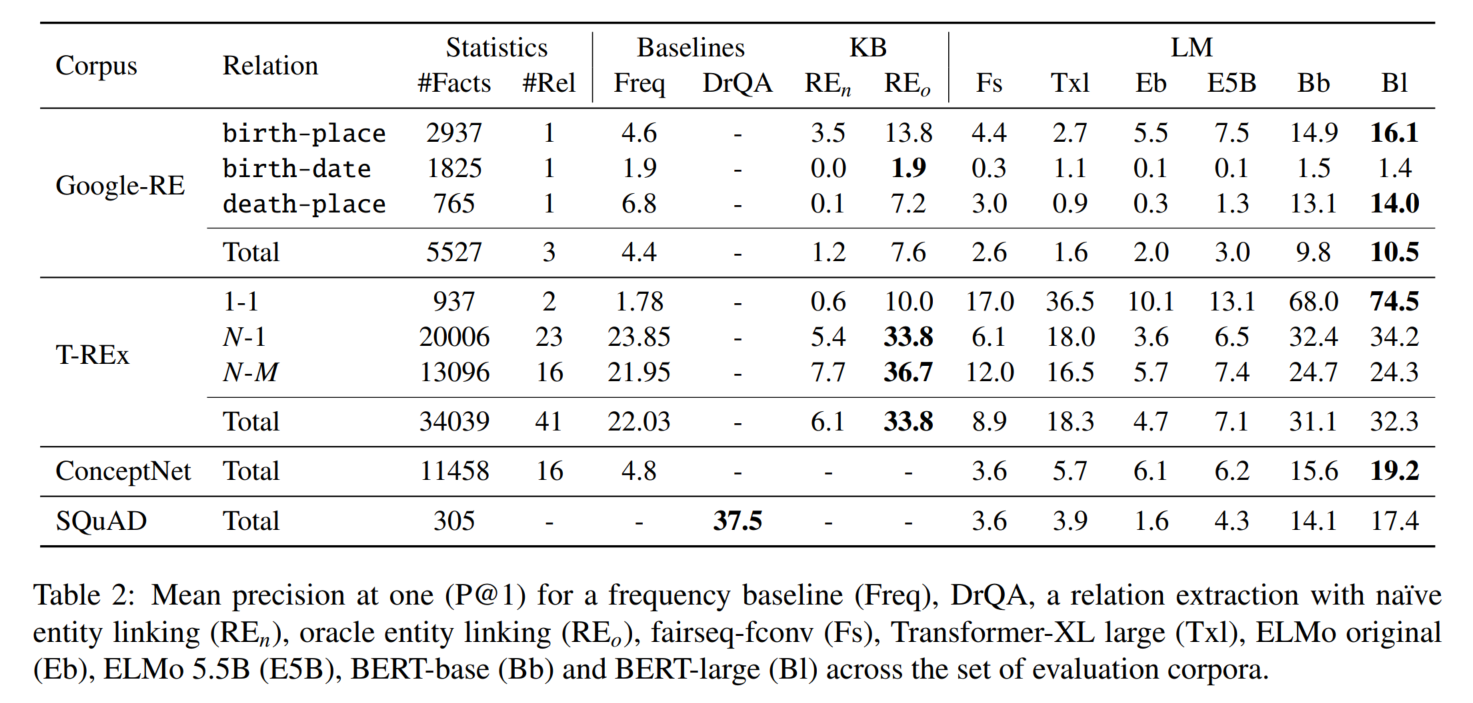

實驗結論:1. BERT表現很好,可以匹敵傳統的有監督學習方法 2. LM對有些知識比其他知識學得更好(N-to-M 關系表現較差)

(什么1984經典句式)

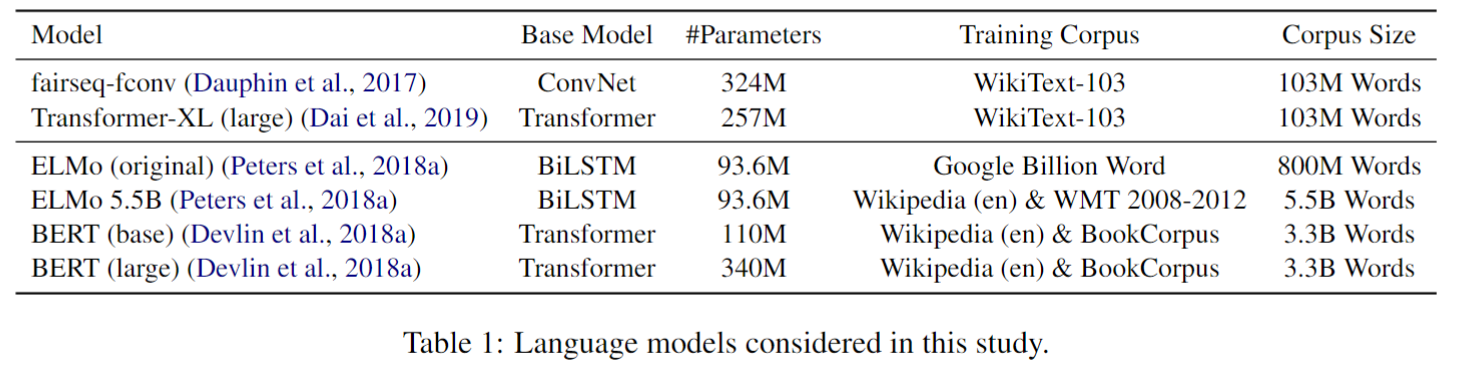

實驗用的LM:

單向LM & 雙向LM

baseline包括純統計學習的、預訓練的關系抽取模型、DrQA(先檢索相似文檔,再做閱讀理解)

實驗用的事實數據集來自關系數據集Google-RE、T-REx、ConceptNet,將每一種關系手工轉換為填空題。原數據集中就有三元組對應的文本。

再加上QA數據集SQuAD

僅選擇只有一個token的場景。

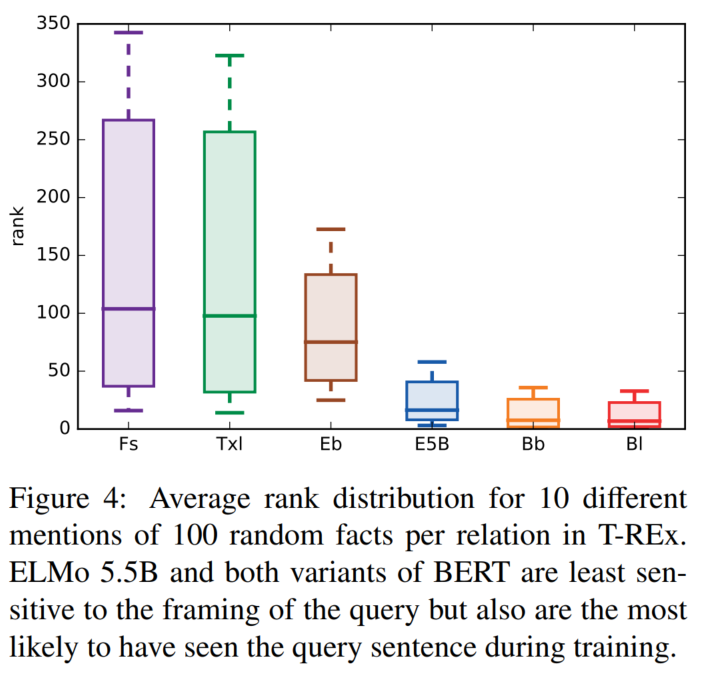

↑注意這里,模版的選擇會影響結果。所以本文認為手工制作模版只能說是給出了一個LM知識的下限水平。

指標:P@k

P@1:

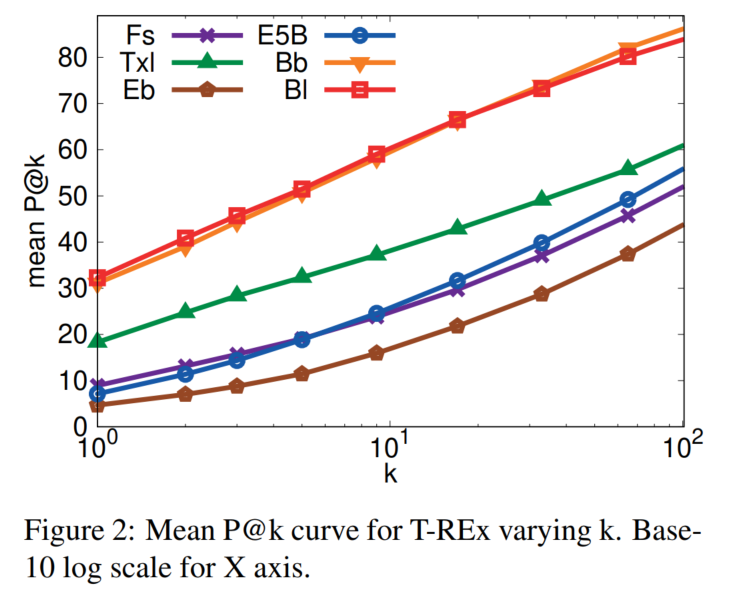

P@k:

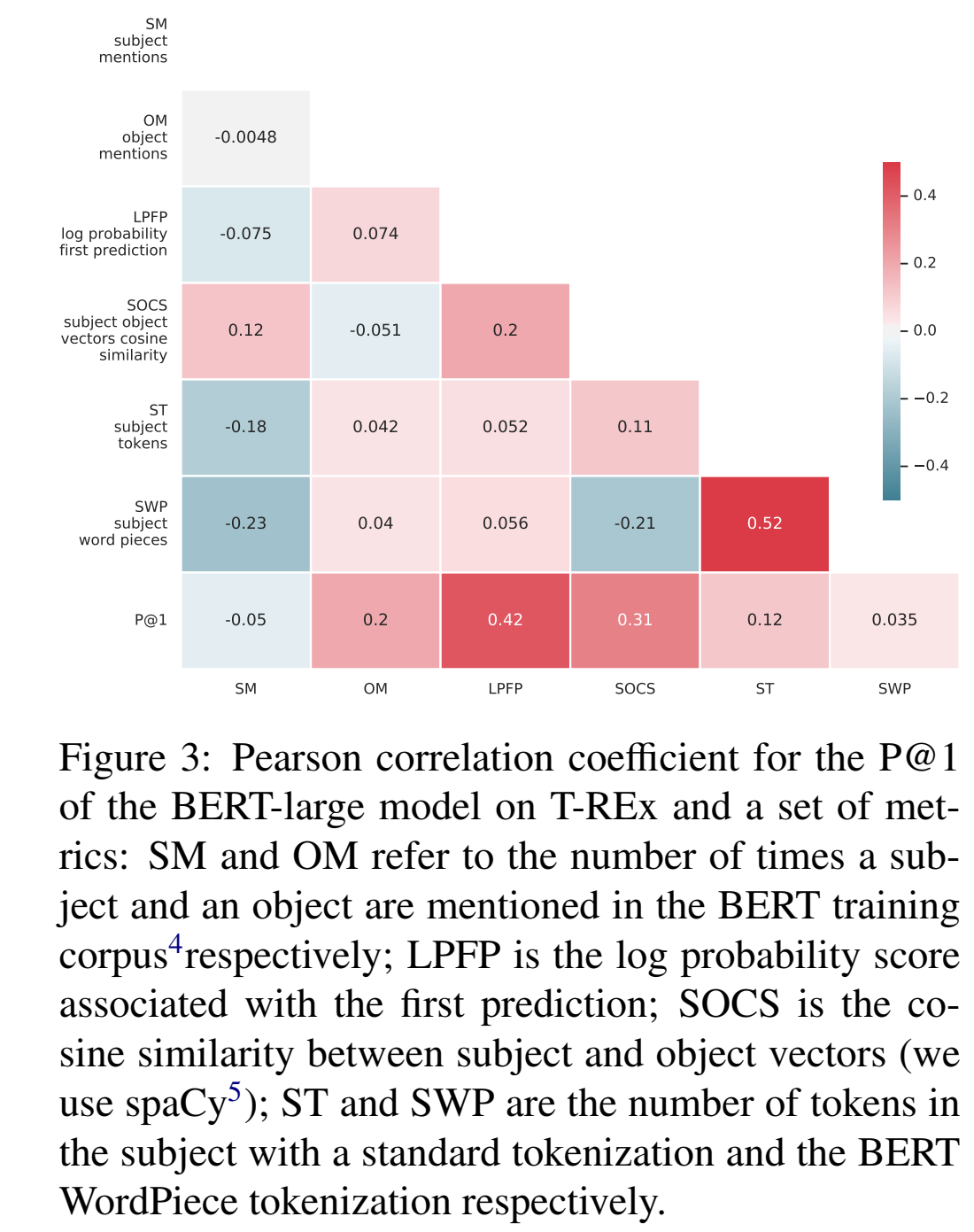

出現頻率越高、實體越相似、subject越長,指標越高

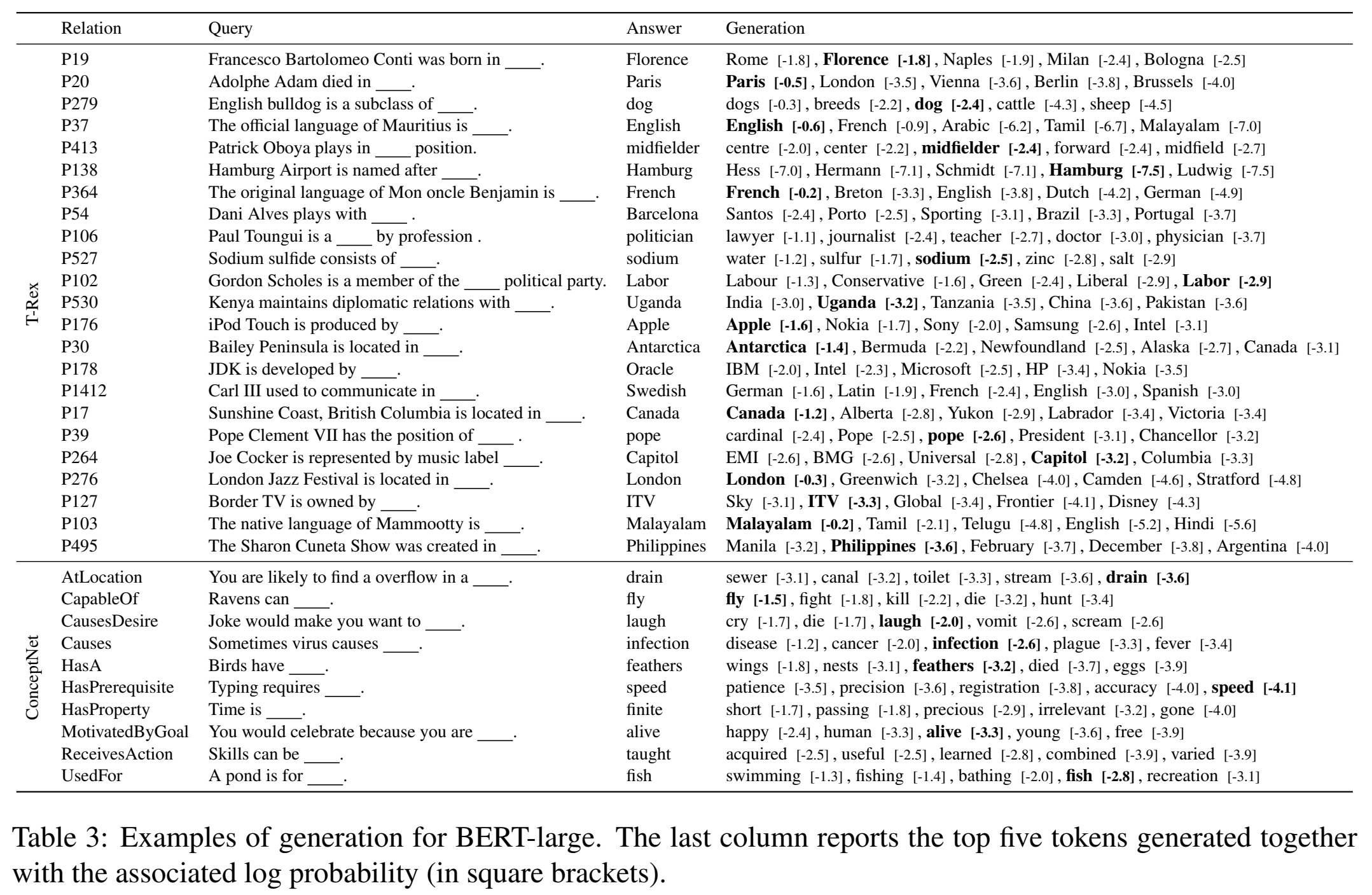

案例分析:

)

的驗證)