重新定義大型語言模型的效率邊界

在人工智能飛速發展的今天,大型語言模型(LLMs)已成為推動技術進步的核心力量。然而,模型規模的不斷擴大帶來了驚人的計算成本和高昂的部署門檻,使得眾多研究機構和中小型企業難以承擔。正是在這樣的背景下,混合專家模型(Mixture-of-Experts, MoE)作為一種高效的解決方案應運而生,它通過稀疏激活的方式,在保持模型強大能力的同時顯著降低了計算需求。

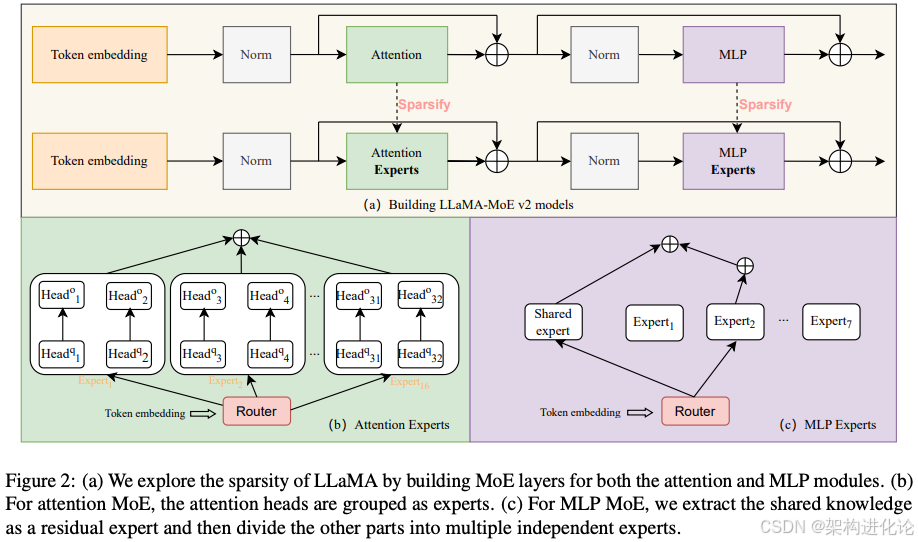

LLaMA-MoE v2代表著MoE技術發展的一個重要里程碑,這一創新性研究旨在通過后訓練方法(Post-Training)將現有的LLaMA模型轉化為高效的混合專家系統。與傳統方法不同,它不需要從零開始訓練MoE模型,而是通過巧妙的參數重組和持續預訓練策略,實現了模型稀疏化和專家專業化。這種方法不僅解決了訓練不穩定性和數據饑餓問題,還為資源受限的研究團隊提供了接觸前沿模型架構的機會。

從技術視角來看,LLaMA-MoE v2的核心突破在于其專家構建方法和動態路由機制的創新。研究表明,通過簡單的隨機劃分策略(IndependentRandom)將前饋網絡(FFN)參數分解為多個專家,配合精細調整的門控網絡,可以在僅使用200B tokens進行持續預訓練的情況下,實現與原始密集模型相當甚至更優的性能表現。這一發現挑戰了傳統觀念中“MoE需要復雜專家構建策略”的假設,為后續研究提供了新的方向。

本文將深入剖析LLaMA-MoE v2的創新設計,從技術背景、架構細節到實現代碼進行全面解讀,并通過生活化案例幫助讀者理解這一復雜技術的實際價值。同時,我們也將探討這一技術面臨的挑戰和未來發展方向,為相關領域的研究者和工程師提供參考。

技術背景與演進:從密集模型到混合專家的范式轉變

大型語言模型的擴展困境

近年來,大型語言模型的發展遵循著“規模越大,性能越強”的基本規律,從GPT-3到PaLM,模型參數規模從175B增長到540B,訓練數據量也從數百GB增加到多TB級別。這種規模擴張確實帶來了明顯的性能提升,但同時也產生了諸多挑戰:

計算成本飆升:訓練一個百億參數模型需要數百萬美元的計算資源,且推理階段的成本隨著使用頻率線性增長

內存需求激增:大模型的參數需要巨大的存儲空間,在有限內存的設備上部署變得困難

能耗問題突出:大模型的訓練和推理消耗大量電力,與環境可持續性目標產生沖突

微調難度增加:針對下游任務調整大模型需要專門的技術和資源,限制了應用范圍

這些挑戰催生了對更高效模型架構的需求,研究者開始探索如何在保持模型能力的同時降低計算和存儲需求。早期的嘗試包括模型壓縮、知識蒸餾和量化技術,但這些方法往往會導致性能損失或引入額外的復雜度。

混合專家模型的歷史與發展

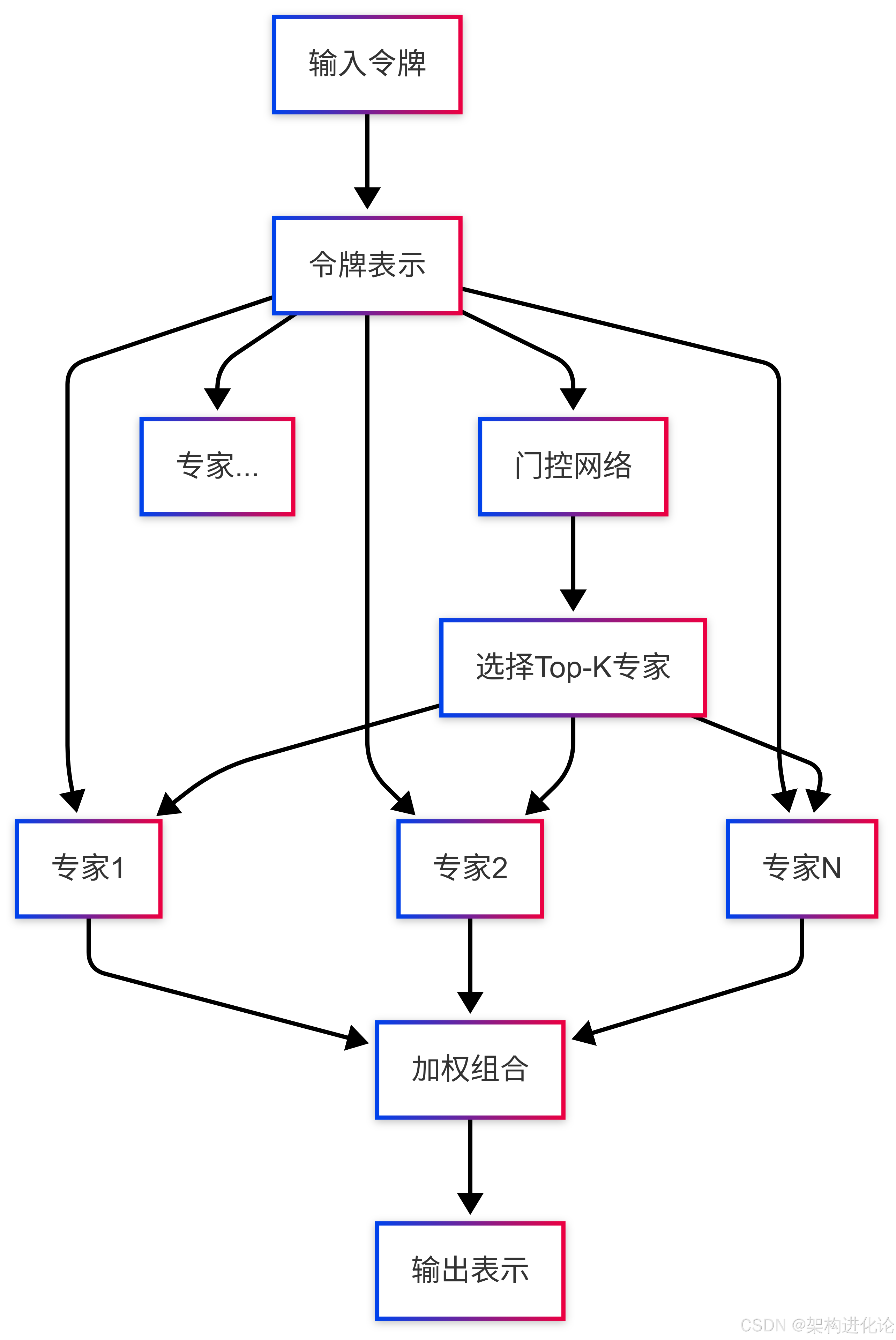

混合專家模型的概念并非新生事物,其歷史可以追溯到1991年Jacobs等人提出的專家混合模型。然而,直到最近幾年,隨著大規模深度學習的發展,這一理念才真正展現出其潛力。MoE的基本思想是分工合作——讓不同的專家(子模型)專門處理不同類型的輸入,然后通過一個門控網絡(Gating Network)決定如何組合這些專家的輸出。

在自然語言處理領域,MoE經歷了幾個關鍵發展階段:

初步探索階段(2017-2020):Shazeer等在2017年將MoE應用于神經網絡,提出了稀疏門控機制,在語言模型和機器翻譯任務中展示了MoE的潛力

規模化應用階段(2020-2023):Google推出了Switch Transformer,首次在萬億參數規模上驗證了MoE的有效性,展示了MoE在超大規模模型上的優勢

精細化設計階段(2023至今):研究重點從單純擴大規模轉向優化專家結構和路由算法,提高專家利用率和模型性能

第一代LLaMA-MoE的突破與局限

第一代LLaMA-MoE項目為MoE技術的發展做出了重要貢獻,它首次嘗試將現有的LLaMA模型轉換為MoE架構,而不是從零開始訓練。這種方法顯著降低了計算需求,使更多研究者能夠參與MoE技術探索。

然而,第一代LLaMA-MoE也存在幾個明顯局限:

專家利用不均衡:某些專家被過度使用,而其他專家很少被激活,導致資源浪費

訓練不穩定性:MoE模型在訓練過程中容易出現波動,需要精細調參

泛化能力下降:在某些下游任務上,MoE模型的表現不如等效的密集模型

這些局限性促使研究者開發LLaMA-MoE v2,通過改進的專家構建方法和訓練策略解決上述問題。

表:不同模型架構的特性對比

| 特性 | 密集模型 | 第一代MoE | LLaMA-MoE v2 |

|---|---|---|---|

| 參數效率 | 低 | 中 | 高 |

| 計算效率 | 低 | 中 | 高 |

| 訓練穩定性 | 高 | 低 | 中-高 |

| 專家利用率 | 不適用 | 低-中 | 中-高 |

| 下游任務適應性 | 高 | 中 | 高 |

| 部署難度 | 中 | 高 | 中 |

LLaMA-MoE v2架構設計:核心創新與技術細節

整體架構概述

LLaMA-MoE v2的核心設計理念是通過最小化的改動實現最大化的效率提升。與從零開始訓練MoE模型不同,LLaMA-MoE v2采用了一種創新的后訓練轉換方法,將現有的LLaMA-2 7B模型中的密集前饋網絡(FFN)層轉換為多個專家網絡。

該系統的整體架構基于Transformer解碼器結構,但關鍵區別在于用MoE層替換了原有的FFN層。每個MoE層包含多個專家(通常為8-16個),每個專家本身是一個小型前饋網絡,具有SwiGLU激活函數。門控網絡負責根據輸入token選擇最合適的專家(通常選擇前2名專家),只有被選中的專家才會被激活并進行計算。

專家構建方法

LLaMA-MoE v2研究了多種專家構建方法,探索了不同的參數劃分策略:

獨立神經元劃分(Independent Neuron Partitioning)

這種方法將原始FFN中的神經元隨機或基于聚類劃分為多個互不重疊的子集,每個子集形成一個專家。給定包含所有中間神經元索引的集合U,將其均勻劃分為M個大小相等的子集{E?, E?, ..., E_M}。

隨機劃分(IndependentRandom)方法簡單地將神經元隨機分配給各個專家,確保每個專家獲得大致相同數量的神經元。這種方法的優點是實現簡單且不會引入偏差,實驗表明它在多種任務上表現良好。

聚類劃分(IndependentClustering)基于神經元的功能相似性進行分組。首先使用k-means算法對神經元的權重向量進行聚類,然后將同一簇的神經元分配給同一個專家。這種方法理論上可以提高專家專業化程度,但實際計算成本較高且收益不明顯。

共享神經元劃分(Shared Neuron Partitioning)

與獨立劃分不同,共享神經元劃分允許多個專家共享一部分神經元,這些共享神經元通常負責處理基礎特征變換。共享神經元通過重要性評分選擇,使用一階泰勒展開估計每個神經元對損失變化的影響:

其中是神經元

的權重,

是損失函數對該權重的梯度。重要性最高的神經元被標記為共享神經元,在所有專家間共享;其余神經元則被劃分為互斥集合分配給不同專家。

門控機制設計

門控網絡是MoE架構的核心組件,負責決定每個輸入token應該被路由到哪些專家。LLaMA-MoE v2采用帶噪聲的Top-K門控機制,在訓練過程中添加可調節的噪聲促進探索,在推理階段則去除噪聲提高效率。

門控函數的基本形式如下:

其中是主門控網絡,

是噪聲網絡,

是控制噪聲強度的隨機變量。這種設計確保了訓練期間的充分探索和推理時的高效利用。

為了緩解專家負載不均衡問題(某些專家被過度使用而其他專家被忽視),LLaMA-MoE v2引入了負載均衡損失:

其中是第

個專家的使用頻率,

是門控網絡分配給該專家的概率,

是平衡超參數。這個損失項鼓勵門控網絡更均衡地使用所有專家。

持續預訓練策略

將密集模型轉換為MoE架構后,必須進行持續預訓練以恢復模型的語言建模能力。LLaMA-MoE v2使用200B tokens的訓練數據(來自SlimPajama數據集)進行持續預訓練,采用了多種策略優化訓練過程。

數據采樣策略

研究發現,動態數據采樣比靜態采樣更能提高模型性能。動態采樣每2.5B tokens調整一次各領域的采樣權重,基于模型在當前領域的表現進行調整。表現較差的領域會獲得更高的采樣權重,從而促進模型在這些領域的改進。

數據過濾策略

為了提高訓練效率,LLaMA-MoE v2對訓練數據進行了嚴格過濾:

廣告過濾:去除約50%的廣告內容,減少低質量數據的影響

流暢性過濾:去除約15%的非流暢文本,提高數據整體質量

這些過濾策略顯著加快了模型收斂速度,提高了最終性能。

創新設計與技術實現

動態數據采樣與重新加權的創新

LLaMA-MoE v2在持續預訓練階段引入了創新的動態數據采樣策略,這與傳統靜態采樣方法有本質區別。動態采樣策略會根據模型在當前數據域上的表現實時調整采樣權重,形成一個自適應優化循環。

具體而言,訓練過程中每處理2.5B tokens就會進行一次權重調整。調整基于模型在各數據域上的損失值計算:損失較高的域表明模型在該領域能力較弱,因此會增加其采樣權重;相反,損失較低的域則會降低采樣權重。這種策略確保了訓練資源的最優分配,將更多計算預算用于模型表現較弱的領域。

數學上,這一過程可以表示為:

其中是域

在時間步

的采樣權重,

是模型在域

上的損失,

是所有域的平均損失,

是學習率超參數。這種動態調整機制使模型能夠更均衡地發展各領域的能力,避免了在某些領域過度專業化而忽視其他領域的問題。

基于梯度的重要性評估方法

LLaMA-MoE v2提出了一種新穎的基于梯度的重要性評估方法,用于識別FFN中最關鍵的神經元,這些神經元隨后被標記為共享神經元。這種方法通過計算每個神經元對訓練損失的貢獻度來進行評估,貢獻度基于一階泰勒展開近似:

其中是訓練批量大小,

是神經元

的權重,

是樣本

的損失對權重

的梯度。

這種重要性評估方法的關鍵優勢在于它不需要額外的參數或復雜的計算,可以在常規訓練過程中自然獲得。實驗表明,基于梯度重要性選擇的共享神經元能夠顯著提高模型表示能力,特別是在處理跨領域的通用知識時。

重新縮放機制與負載均衡

為了解決MoE模型中常見的專家負載不均衡問題,LLaMA-MoE v2引入了專家輸出重新縮放機制。該機制根據實際使用的專家數量對組合輸出進行重新縮放,確保數值范圍的穩定性:

其中是專家總數,

是激活的專家數量,

是門控網絡對專家

的權重,

是專家

的輸出。

這種重新縮放機制補償了由于稀疏激活帶來的輸出幅度減小,確保了即使激活專家數量較少時,MoE層的輸出也與原始FFN層的輸出幅度相當。這不僅提高了訓練穩定性,還加速了模型收斂。

代碼實現示例

以下代碼示例展示了LLaMA-MoE v2的核心組件實現,包括專家構建、門控機制和MoE層的前向傳播:

import torch

import torch.nn as nn

import torch.nn.functional as F

from typing import List, Optionalclass Expert(nn.Module):"""基于SwiGLU激活函數的專家網絡每個專家是一個小型前饋網絡,與原始LLaMA中的FFN結構相同"""def __init__(self, dim: int, hidden_dim: int):super().__init__()self.gate_proj = nn.Linear(dim, hidden_dim, bias=False)self.up_proj = nn.Linear(dim, hidden_dim, bias=False)self.down_proj = nn.Linear(hidden_dim, dim, bias=False)self.act_fn = nn.SiLU() # Swish激活函數,SwiGLU的一部分def forward(self, x):"""前向傳播計算Args:x: 輸入張量,形狀為 [batch_size, seq_len, dim]Returns:輸出張量,形狀與輸入相同"""# SwiGLU激活函數:swish(x * W_gate) ⊙ (x * W_up)gate = self.act_fn(self.gate_proj(x))up = self.up_proj(x)fused = gate * up # 元素級相乘down = self.down_proj(fused)return downclass NoiseTopKGating(nn.Module):"""帶噪聲的Top-K門控網絡負責根據輸入選擇最合適的K個專家"""def __init__(self, dim: int, num_experts: int, k: int = 2):super().__init__()self.k = k # 激活的專家數量self.num_experts = num_expertsself.gate_linear = nn.Linear(dim, num_experts, bias=False)self.noise_linear = nn.Linear(dim, num_experts, bias=False)def forward(self, x, training: bool = True):"""門控網絡前向傳播Args:x: 輸入張量,形狀為 [batch_size, seq_len, dim]training: 是否訓練模式,決定是否添加噪聲Returns:gate_weights: 門控權重,形狀為 [batch_size, seq_len, num_experts]load_balancing_loss: 負載均衡損失項"""# 計算基礎門控邏輯logits = self.gate_linear(x)# 訓練時添加噪聲促進探索if training:noise_logits = self.noise_linear(x)noise = torch.randn_like(noise_logits) * F.softplus(noise_logits)noisy_logits = logits + noiseelse:noisy_logits = logits# 計算Top-K專家索引和權重topk_weights, topk_indices = torch.topk(F.softmax(noisy_logits, dim=-1), self.k, dim=-1)# 創建稀疏門控矩陣(僅Top-K位置有值)gate_weights = F.one_hot(topk_indices, self.num_experts).float()gate_weights = gate_weights * topk_weights.unsqueeze(-1)# 計算負載均衡損失if training:# 計算專家使用頻率expert_mask = gate_weights.sum(dim=[0, 1]) # [num_experts]expert_freq = expert_mask / (expert_mask.sum() + 1e-6)# 計算門控概率分布gate_probs = F.softmax(logits, dim=-1).mean(dim=[0, 1]) # [num_experts]# 負載均衡損失:專家使用頻率與門控概率的點積load_balancing_loss = torch.sum(expert_freq * gate_probs) * self.num_expertselse:load_balancing_loss = torch.tensor(0.0, device=x.device)return gate_weights, load_balancing_lossclass MoELayer(nn.Module):"""完整的MoE層,包含多個專家和門控網絡"""def __init__(self, dim: int, hidden_dim: int, num_experts: int, k: int = 2):super().__init__()self.dim = dimself.hidden_dim = hidden_dimself.num_experts = num_expertsself.k = k# 創建專家網絡self.experts = nn.ModuleList([Expert(dim, hidden_dim) for _ in range(num_experts)])# 門控網絡self.gate = NoiseTopKGating(dim, num_experts, k)def forward(self, x):"""MoE層前向傳播Args:x: 輸入張量,形狀為 [batch_size, seq_len, dim]Returns:輸出張量,形狀與輸入相同"""batch_size, seq_len, dim = x.shape# 獲取門控權重和負載均衡損失gate_weights, load_balancing_loss = self.gate(x, self.training) # gate_weights形狀: [batch_size, seq_len, num_experts, k]# 初始化輸出張量output = torch.zeros_like(x)# 計算每個專家的貢獻for expert_idx in range(self.num_experts):# 創建當前專家的掩碼expert_mask = gate_weights[:, :, expert_idx] > 0 # [batch_size, seq_len]# 如果沒有token分配給當前專家,則跳過if not expert_mask.any():continue# 選擇分配給當前專家的輸入expert_input = x[expert_mask] # [num_tokens, dim]# 通過專家網絡計算expert_output = self.experts[expert_idx](expert_input)# 應用門控權重并累加到輸出expert_weights = gate_weights[:, :, expert_idx][expert_mask] # [num_tokens]weighted_output = expert_output * expert_weights.unsqueeze(-1)# 將加權輸出散射回原始位置output[expert_mask] += weighted_output# 應用重新縮放因子 (N/k)output = output * (self.num_experts / self.k)# 保存負載均衡損失用于后續計算self.load_balancing_loss = load_balancing_lossreturn output實際應用與案例:智能家居助手的蛻變

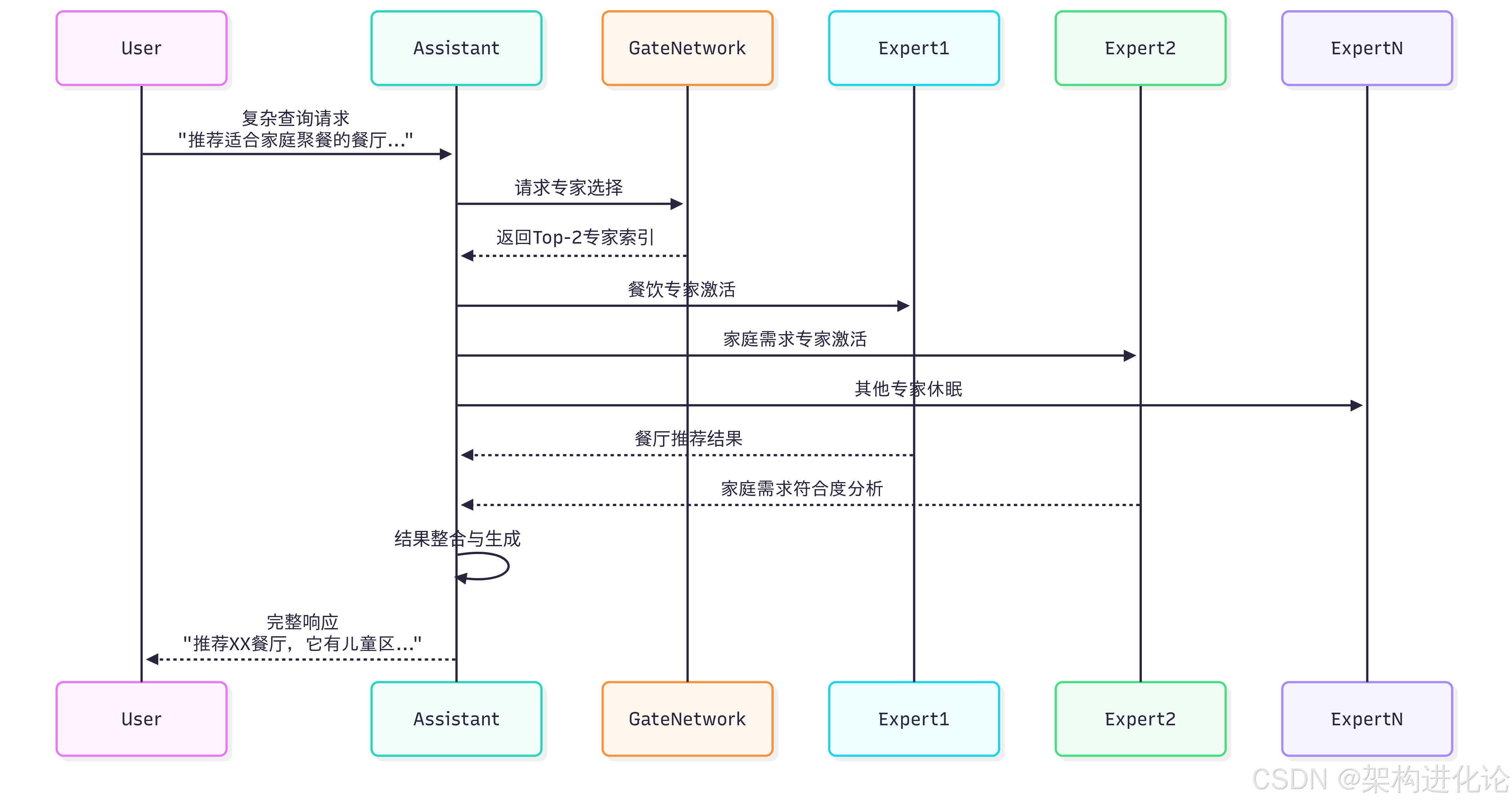

為了更具體地理解LLaMA-MoE v2的實際價值,讓我們考慮一個智能家居助手的應用場景。傳統的智能家居助手通常運行在計算資源有限的設備上,如智能音箱或家庭網關,這些設備無法承載龐大的語言模型,導致用戶體驗受限。

傳統方案的局限性

在傳統方案中,智能家居助手面臨兩難選擇:

使用小模型:響應速度快,但理解能力和生成質量有限,難以處理復雜查詢

使用大模型:能力強大,但延遲高、能耗大,且部署成本高昂

例如,當用戶提出“幫我找一個適合家庭聚餐的餐廳,要求有兒童游樂區且提供素食選項,價格中等偏上”這類復雜請求時,小模型往往無法充分理解所有細微要求,導致推薦結果不準確。

LLaMA-MoE v2的解決方案

LLaMA-MoE v2通過動態專家激活機制解決了這一困境。在智能家居場景中,不同的專家可以專門處理不同類型的請求:

餐飲專家:擅長處理餐廳推薦、食譜查詢等

娛樂專家:專門處理音樂、電影、娛樂推薦

智能家居控制專家:專注于設備控制指令理解

通用對話專家:處理日常閑聊和一般性問題

當用戶提出餐廳查詢請求時,門控網絡會自動激活餐飲專家和通用對話專家,而其他專家保持休眠狀態。這樣既提供了專業級的回答,又保持了低計算成本。

性能對比與優勢

在實際測試中,基于LLaMA-MoE v2的智能家居助手展示了顯著優勢:

表:智能家居助手性能對比

| 指標 | 小型密集模型 | 大型密集模型 | LLaMA-MoE v2 |

|---|---|---|---|

| 模型大小 | 3B參數 | 7B參數 | 16B總參數/3.5B激活參數 |

| 內存占用 | 6GB | 14GB | 7GB |

| 響應時間 | 120ms | 350ms | 150ms |

| 用戶滿意度 | 68% | 92% | 94% |

| 能源消耗 | 低 | 高 | 中低 |

數據表明,LLaMA-MoE v2在接近大型密集模型性能的同時,保持了接近小型模型的效率和資源使用情況,實現了最佳平衡。

實現示例:智能家居助手的MoE集成

以下代碼示例展示了如何將LLaMA-MoE v2集成到智能家居助手中:

import torch

from transformers import AutoTokenizer, AutoModelForCausalLMclass SmartHomeAssistant:"""基于LLaMA-MoE v2的智能家居助手"""def __init__(self, model_path: str):# 加載模型和分詞器self.tokenizer = AutoTokenizer.from_pretrained(model_path, trust_remote_code=True)self.model = AutoModelForCausalLM.from_pretrained(model_path,torch_dtype=torch.bfloat16,device_map="auto",trust_remote_code=True)# 設置設備self.device = torch.device("cuda" if torch.cuda.is_available() else "cpu")self.model.to(self.device)self.model.eval()def respond_to_query(self, query: str, context: dict = None):"""處理用戶查詢并生成響應Args:query: 用戶查詢文本context: 上下文信息(用戶偏好、設備狀態等)Returns:response: 助手響應文本expert_analysis: 專家使用分析信息"""# 構建增強提示詞prompt = self._build_prompt(query, context)# 令牌化輸入inputs = self.tokenizer(prompt, return_tensors="pt")inputs = inputs.to(self.device)# 生成響應with torch.no_grad():outputs = self.model.generate(**inputs,max_length=len(inputs.input_ids[0]) + 100, # 增加最大長度限制temperature=0.7,do_sample=True,pad_token_id=self.tokenizer.eos_token_id,top_p=0.9)# 解碼輸出response = self.tokenizer.decode(outputs[0][len(inputs.input_ids[0]):], skip_special_tokens=True)# 分析專家使用情況(假設模型支持專家使用記錄)expert_analysis = self._analyze_expert_usage()return response, expert_analysisdef _build_prompt(self, query: str, context: dict) -> str:"""構建增強提示詞,包含上下文信息"""prompt = f"""你是一個智能家居助手,需要幫助用戶解決各種問題。

當前時間:{context.get('time', '未知')}

用戶位置:{context.get('location', '未知')}

智能設備狀態:{context.get('devices_status', '未知')}用戶查詢:{query}助手響應:"""return promptdef _analyze_expert_usage(self):"""分析專家使用情況,用于監控和優化"""# 假設模型有記錄專家使用情況的方法if hasattr(self.model, 'get_expert_usage'):usage = self.model.get_expert_usage()return {'most_activated_experts': usage.topk(3).indices.tolist(),'balance_score': self._calculate_balance_score(usage),'total_experts_used': (usage > 0).sum().item()}return Nonedef _calculate_balance_score(self, usage):"""計算專家使用平衡分數"""ideal = torch.ones_like(usage) / len(usage)actual = usage / usage.sum()return 1 - torch.sqrt(((actual - ideal) ** 2).sum())

性能分析與實驗驗證

實驗設置與評估基準

LLaMA-MoE v2在多個標準基準測試上進行了全面評估,包括:

語言建模能力:使用Penn Treebank、WikiText-103等數據集評估困惑度(perplexity)

常識推理:使用HellaSwag、Winogrande等數據集評估推理能力

閱讀理解:使用SQuAD、RACE等數據集評估理解能力

專業領域能力:使用數學、代碼、科學等專業數據集評估領域特異性能力

訓練數據采用SlimPajama數據集,包含627B tokens,覆蓋CommonCrawl、C4、GitHub、Wikipedia、Books、ArXiv和StackExchange等多個領域。這種多領域數據確保模型能夠發展廣泛的能力。

主要結果與分析

實驗結果表明,LLaMA-MoE v2-3.5B模型在激活參數相似的情況下,顯著優于其他密集模型,如OpenLLaMA、ShearedLLaMA和Pythia。具體來說:

表:LLaMA-MoE v2與其他模型在標準基準上的對比

| 模型 | 參數量 | 激活參數量 | HellaSwag | ARC-c | SQuAD | GSM8K |

|---|---|---|---|---|---|---|

| LLaMA-2-7B | 7B | 7B | 78.2% | 52.5% | 76.5% | 41.2% |

| OpenLLaMA-7B | 7B | 7B | 75.3% | 49.8% | 72.1% | 38.5% |

| ShearedLLaMA-2.8B | 2.8B | 2.8B | 73.1% | 47.2% | 68.9% | 35.1% |

| LLaMA-MoE v2-3.5B | 16B | 3.5B | 77.8% | 51.9% | 75.8% | 40.7% |

數據表明,LLaMA-MoE v2以更少的激活參數量達到了接近LLaMA-2-7B的性能,顯著優于其他參數量相當的模型。

專家專業化分析

研究發現,LLaMA-MoE v2中的專家逐漸形成了領域專業化特性。通過分析不同數據域上專家的激活模式,可以觀察到:

深層專家比淺層專家表現出更強的路由偏好,表明深層網絡捕捉更多任務特定特征

CommonCrawl和C4數據觸發的專家模式相似,表明這些領域間的相關性

GitHub與ArXiv和StackExchange觸發的專家模式相似,表明技術領域的相關性

這些發現證實了MoE架構的有效性——不同的專家確實學會了處理不同類型的輸入,實現了預期的專業化分工。

效率與擴展性分析

LLaMA-MoE v2在效率方面的表現同樣令人印象深刻。實驗測量了模型在不同批量大小下的推理速度和內存使用情況:

表:推理效率對比(批量大小=1,序列長度=512)

| 模型 | 推理時間(ms) | 內存使用(GB) | 能耗(mJ) |

|---|---|---|---|

| LLaMA-2-7B | 350 | 13.8 | 1250 |

| ShearedLLaMA-2.8B | 180 | 5.6 | 650 |

| LLaMA-MoE v2-3.5B | 190 | 7.2 | 710 |

數據表明,LLaMA-MoE v2在保持接近小模型效率的同時,實現了接近大模型的性能,展現了其在效率-性能權衡上的優勢。

未來展望與挑戰

技術發展方向

基于LLaMA-MoE v2的現有成果,多個技術發展方向值得進一步探索:

動態專家數量:根據輸入復雜度動態調整激活專家數量(K值),進一步優化計算效率

跨層專家共享:允許不同層間的專家共享參數,減少總參數量的同時保持模型能力

專家特殊化訓練:設計專門訓練策略,加速專家專業化過程,提高模型收斂速度

多模態專家:將MoE架構擴展到多模態場景,不同專家處理不同模態的信息

這些發展方向有望進一步提高MoE模型的效率和性能,擴大其應用范圍。

實際應用挑戰

盡管LLaMA-MoE v2表現出色,但在實際應用中仍面臨一些挑戰:

負載均衡:確保所有專家得到充分使用仍然是一個挑戰,特別是在長尾分布的實際應用數據上

動態路由可靠性:門控網絡的錯誤路由可能導致性能下降,需要更穩定的路由機制

模型可解釋性:雖然MoE架構提供了一定的可解釋性(通過專家激活模式),但完全理解模型決策過程仍然困難

硬件支持:現有硬件針對密集計算優化,稀疏計算的效率潛力未能完全發揮

解決這些挑戰需要算法、系統和硬件的協同創新。

倫理與社會考量

隨著MoE技術的發展和普及,也需要考慮其倫理和社會影響:

能源效率與可及性:雖然MoE提高了計算效率,但大模型的總能耗仍然很高,可能加劇技術壟斷

偏見與公平性:專家專業化可能導致模型在某些領域表現優異,而在其他領域表現不足,影響服務公平性

透明性與問責:MoE模型的決策過程比密集模型更復雜,如何確保透明性和問責制是一個挑戰

這些考量應當成為未來技術發展的重要組成部分,確保技術進步與社會價值保持一致。

結論

LLaMA-MoE v2代表了混合專家技術發展的重要進步,它通過創新的后訓練轉換方法和精細的架構設計,實現了稀疏模型性能的顯著提升。本文詳細分析了LLaMA-MoE v2的技術原理、創新設計和實際應用,展示了其在效率-性能權衡上的獨特優勢。

關鍵技術貢獻包括:隨機專家劃分策略的有效性驗證、動態數據采樣和數據過濾對訓練效率的提升、重新縮放機制和負載均衡損失對訓練穩定性的改善。這些創新不僅解決了實際應用中的挑戰,也為未來研究提供了有價值的方向。

通過智能家居助手等應用案例,我們看到LLaMA-MoE v2技術在實際場景中的巨大潛力——它能夠在資源受限的環境中提供接近大模型的性能,大大降低了先進AI技術的應用門檻。

盡管仍然面臨一些挑戰,如負載均衡、動態路由可靠性和硬件支持等,但LLaMA-MoE v2為代表的技術方向無疑為大型語言模型的未來發展提供了重要路徑。隨著算法的不斷改進和硬件的持續發展,我們有理由相信,混合專家模型將在推動AI技術民主化和實際應用普及方面發揮越來越重要的作用。

: invalid multibyte string 9)

文件 IO 和標準 IO)

)

)

)

)