🌟 Hello,我是蔣星熠Jaxonic!

🌈 在浩瀚無垠的技術宇宙中,我是一名執著的星際旅人,用代碼繪制探索的軌跡。

🚀 每一個算法都是我點燃的推進器,每一行代碼都是我航行的星圖。

🔭 每一次性能優化都是我的天文望遠鏡,每一次架構設計都是我的引力彈弓。

🎻 在數字世界的協奏曲中,我既是作曲家也是首席樂手。讓我們攜手,在二進制星河中譜寫屬于極客的壯麗詩篇!

這篇文章想帶你跨越容器編排的光年距離,抵達 Kubernetes 的重力井:理解它為什么誕生、如何運轉、怎樣穩定落地生產。很多團隊對 k8s 的第一印象是“復雜”:Deployment、Service、Ingress、HPA、Operator、CRD、CNI、CSI、RBAC、Admission… 術語如流星雨般密集。但當我們把這些抽象拆解到工程動機——解耦、自治、聲明式狀態收斂、水平彈性與故障自愈——復雜性就會轉化為可組合的能力。本文采用“原理—實戰—可視化—工程對比—最佳實踐”的方式推進:先用一幅時序與架構圖說明控制面的閉環;再用從零部署到灰度發布的最短路徑演示;緊接著對 HPA/Gateway API/StatefulSet 等常見難點給出可落地的清單;最后以 SLO 與容量管理為錨點收束,給出上線演練清單和常見反模式。你會看到:k8s 并不是萬能銀彈,但它給了工程團隊在云原生星海中“穩定航行”的一整套儀器板。準備好點火了么?讓我們把每一次發布,都打造成一次有預案、有度量、有回滾閥門的“深空機動”。

目錄

- 核心認知:Kubernetes 的控制回路與聲明式模型

- 快速上手:一個最小可用的生產級工作負載

- 彈性與自愈:HPA/PodDisruptionBudget/探針策略

- 有狀態與數據:StatefulSet、持久化與滾動升級

- 北南向流量:Service/Ingress/Gateway API 實戰

- 安全與多租:RBAC、NetworkPolicy、限制與準入

- 可觀測與SLO:指標、日志、追蹤與容量規劃

- 工程對比與選擇:不同策略在成本/彈性/復雜度的取舍

- 上線演練清單與反模式

- 總結

- 參考鏈接與關鍵詞

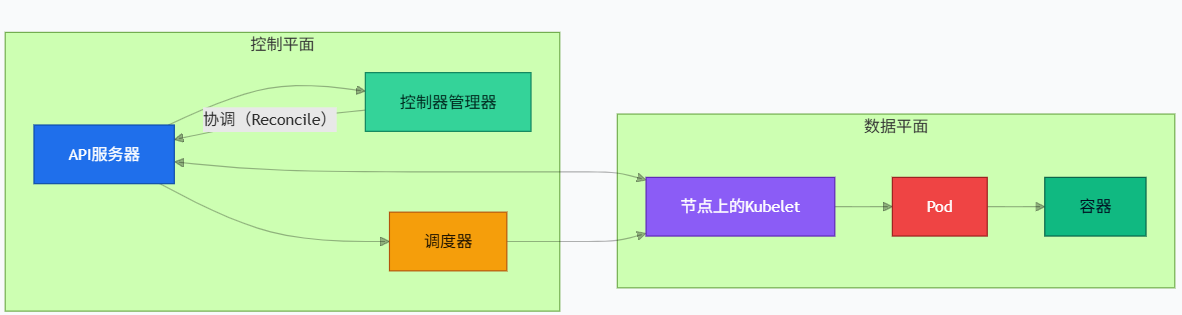

核心認知:Kubernetes 的控制回路與聲明式模型

Kubernetes 的精髓是“期望狀態”與“控制器閉環”。你聲明一個目標(副本數=3,鏡像版本=v2),Controller 不斷對比實際狀態,驅動系統收斂。控制面與數據面的分離讓集群具備了“可替換性”:網絡用 CNI、存儲用 CSI、入口用多種 Ingress/Gateway 實現。

圖1:控制環與組件關系圖(flowchart)—展示控制面如何驅動數據面收斂

要點:

- API Server 是“一切皆資源”的入口;對象存儲在 etcd。

- 各類控制器(如 DeploymentController)周期性對比期望/實際狀態并采取行動。

- Kubelet 負責節點級別 Pod 生命周期,配合 CNI/CSI 實現網絡與存儲。

快速上手:一個最小可用的生產級工作負載

意圖與要點:

- 使用 Deployment + Service + Readiness/Liveness 探針 + 資源配額 + 滾動更新策略。

- 通過 Kustomize 分層配置,便于區分 dev/staging/prod。

- 適度限制:requests/limits、安全上下文、pullPolicy。

# base/deployment.yaml

apiVersion: apps/v1

kind: Deployment

metadata:name: demo-web

spec:replicas: 3strategy:type: RollingUpdaterollingUpdate:maxUnavailable: 1maxSurge: 1selector:matchLabels:app: demo-webtemplate:metadata:labels:app: demo-webspec:containers:- name: webimage: ghcr.io/example/demo-web:v1.0.0ports:- containerPort: 8080resources:requests:cpu: "200m"memory: "256Mi"limits:cpu: "500m"memory: "512Mi"readinessProbe:httpGet:path: /healthzport: 8080initialDelaySeconds: 5periodSeconds: 5livenessProbe:httpGet:path: /livezport: 8080initialDelaySeconds: 15periodSeconds: 10securityContext:runAsNonRoot: trueallowPrivilegeEscalation: false

---

apiVersion: v1

kind: Service

metadata:name: demo-web

spec:selector:app: demo-webports:- port: 80targetPort: 8080protocol: TCPname: http

關鍵行點評:

- replicas=3:提供最小高可用冗余;maxUnavailable=1 保證滾更期間服務可用。

- requests/limits:為 HPA 與調度提供基礎;避免資源爭搶導致抖動。

- readinessProbe:控制是否對外提供流量;livenessProbe:異常自愈重啟。

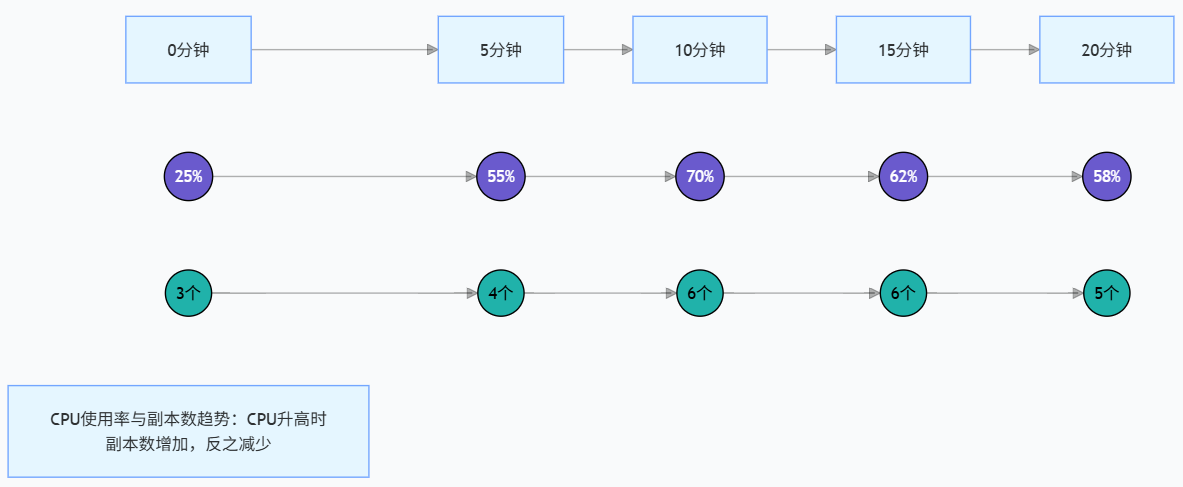

彈性與自愈:HPA/PodDisruptionBudget/探針策略

意圖與要點:

- HPA 基于 CPU/自定義指標自動擴縮容。

- PDB 限制維護期可中斷 Pod 數量,降低升級與節點維護對業務的沖擊。

- 探針策略配合優雅終止,減少 502/503。

# autoscale/hpa.yaml

apiVersion: autoscaling/v2

kind: HorizontalPodAutoscaler

metadata:name: demo-web

spec:scaleTargetRef:apiVersion: apps/v1kind: Deploymentname: demo-webminReplicas: 3maxReplicas: 10metrics:- type: Resourceresource:name: cputarget:type: UtilizationaverageUtilization: 60

---

# policy/pdb.yaml

apiVersion: policy/v1

kind: PodDisruptionBudget

metadata:name: demo-web-pdb

spec:minAvailable: 2selector:matchLabels:app: demo-web

關鍵行點評:

- HPA v2 支持多指標;averageUtilization=60 兼顧彈性與成本。

- PDB:minAvailable=2 確保維護/升級時仍保留 2 個實例對外服務。

有狀態與數據:StatefulSet、持久化與滾動升級

意圖與要點:

- 對有序副本(例如主從結構、分片)使用 StatefulSet,結合 Headless Service。

- 持久卷使用 StorageClass 進行動態供應;優先選擇具備快照/擴容能力的 CSI 驅動。

- 升級時控制有序性與停機窗口。

apiVersion: apps/v1

kind: StatefulSet

metadata:name: demo-db

spec:serviceName: "demo-db"replicas: 3selector:matchLabels:app: demo-dbtemplate:metadata:labels:app: demo-dbspec:containers:- name: dbimage: ghcr.io/example/demo-db:2.4.1ports:- containerPort: 5432volumeMounts:- name: datamountPath: /var/lib/dbdatavolumeClaimTemplates:- metadata:name: dataspec:accessModes: ["ReadWriteOnce"]storageClassName: fast-ssdresources:requests:storage: 50Gi

---

apiVersion: v1

kind: Service

metadata:name: demo-db

spec:clusterIP: None # Headless for stable DNSselector:app: demo-dbports:- port: 5432name: tcp

關鍵行點評:

- clusterIP: None 創建有穩定 DNS 記錄的 Headless Service,支持有序訪問。

- volumeClaimTemplates 保證每個副本都有獨立持久卷,數據不互相污染。

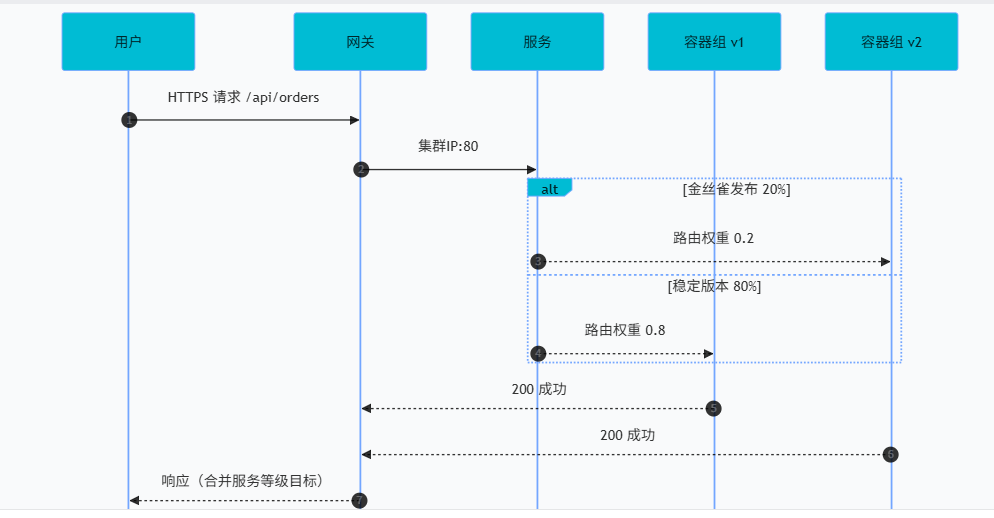

北南向流量:Service/Ingress/Gateway API 實戰

意圖與要點:

- Ingress 常用于 L7 路由;Gateway API 是更通用/可擴展的下一代標準。

- 通過 Canary/Traffic Split 實現灰度,支持權重或 Header 條件。

# gateway/gateway.yaml (Gateway API 示例,以 Istio/Gateway API 實現為例)

apiVersion: gateway.networking.k8s.io/v1

kind: Gateway

metadata:name: main-gw

spec:gatewayClassName: istiolisteners:- name: httpsprotocol: HTTPSport: 443tls:mode: TerminatecertificateRefs:- kind: Secretname: tls-cert

---

apiVersion: gateway.networking.k8s.io/v1

kind: HTTPRoute

metadata:name: web-route

spec:parentRefs:- name: main-gwrules:- matches:- path:type: PathPrefixvalue: /apibackendRefs:- name: demo-webport: 80weight: 80- name: demo-web-v2port: 80weight: 20

關鍵行點評:

- Gateway/HTTPRoute 解耦“基礎設施負責監聽”和“業務負責路由”。

- 通過 weight 實現 80/20 灰度,配合觀測與自動回滾策略。

可視化:請求路徑與流量灰度的時序

圖2:灰度發布請求流時序(sequenceDiagram)—展示 Gateway/Service/Pod 的路由權重

數據展示:資源使用與擴縮容趨勢

圖3:擴縮容趨勢(xychart-beta)—CPU 利用率與副本數隨時間變化

結構/規劃:K8s 知識地圖

圖4:知識體系思維導圖(mindmap)—縱覽組件與能力域

安全與多租:RBAC、NetworkPolicy、限制與準入

意圖與要點:

- 租戶最小權限:將 ClusterRole/Role 與 ServiceAccount 組合綁定。

- NetworkPolicy 默認拒止,按命名空間/標簽白名單通信。

- LimitRange 與 ResourceQuota 約束租戶資源,避免“吵鬧鄰居”。

# security/rbac.yaml

apiVersion: v1

kind: ServiceAccount

metadata:name: app-sanamespace: prod

---

apiVersion: rbac.authorization.k8s.io/v1

kind: Role

metadata:name: app-readernamespace: prod

rules:- apiGroups: [""]resources: ["configmaps", "secrets"]verbs: ["get", "list"]

---

apiVersion: rbac.authorization.k8s.io/v1

kind: RoleBinding

metadata:name: app-reader-bindingnamespace: prod

subjects:- kind: ServiceAccountname: app-sa

roleRef:kind: Rolename: app-readerapiGroup: rbac.authorization.k8s.io

---

# security/networkpolicy.yaml

apiVersion: networking.k8s.io/v1

kind: NetworkPolicy

metadata:name: default-denynamespace: prod

spec:podSelector: {}policyTypes: ["Ingress","Egress"]

關鍵行點評:

- 默認拒止 NetworkPolicy 后,再按需開放細粒度策略。

- 用 ServiceAccount 承載應用身份,禁用默認 token 自動掛載(可在 Pod spec 指定)。

可觀測與 SLO:指標、日志、追蹤與容量規劃

意圖與要點:

- 指標:Golden Signals(延遲/吞吐/錯誤率/飽和度)配合 HPA 指標。

- 日志:結構化日志 + 日志保留策略;避免在容器內寫文件。

- 追蹤:分布式追蹤打通入口到下游依賴。

- 容量:以 P95 為目標測容量,保留爆發冗余,搭配 PDB 與 Pod 優先級。

引用:

“你無法運營一艘看不見航跡的飛船。”——可觀測性是應急與優化的共同前提。

表格對比:Ingress vs Gateway API vs Service Mesh

| 方案 | 功能覆蓋 | 運維復雜度 | 灰度能力 | 標準化 | 場景建議 |

|---|---|---|---|---|---|

| Ingress | L7 路由、TLS 終止 | 低 | 中(依賴實現) | 中 | 傳統北向入口,簡單穩定 |

| Gateway API | 更通用路由模型、分離職責 | 中 | 高(權重/匹配豐富) | 高 | 逐步替代 Ingress 的統一抽象 |

| Service Mesh | 細粒度流控、可觀測、安全 | 高 | 很高(流量切分/熔斷/重試) | 中 | 大型微服務、強治理訴求 |

上線演練清單與反模式

上線演練清單(摘要):

- 鏡像:SBOM/漏洞掃描/只讀根文件系統/非 root。

- 資源:requests/limits 明確;HPA 閾值與最大副本數可控。

- 探針:readiness/liveness 語義明確;優雅退出與 preStop 鉤子。

- 流量:灰度權重/回滾策略/限流熔斷預案。

- 存儲:備份快照/恢復演練/只讀副本切換。

- 可觀測:儀表板/報警規則/容量基線。

- 安全:RBAC 最小權限/NetworkPolicy 默認拒止/鏡像簽名。

常見反模式:

- 無 requests/limits,導致“搶占—抖動—雪崩”。

- 把 liveness 當 readiness 用,導致頻繁重啟。

- StatefulSet 無備份策略直接升級。

- Ingress/Gateway 與應用耦合配置,缺少環境分層。

Mermaid 架構圖:組件與依賴分層

圖5:系統分層架構(architecture-beta)—控制面、數據面與擴展組件關系

結尾總結

把 Kubernetes 比作一次深空遠航,并不是為了神秘化它,而是提醒我們:這是一套需要紀律、度量與演練的工程系統。我們在聲明式的星圖上標注每一個目標副本、每一次滾動窗口、每一條 NetworkPolicy,就像在宇航計劃里寫下燃料預算與回收窗口。落地之道,在于把“能力”沉淀為“流程”:以 Kustomize 管理環境差異,以 HPA 與 PDB 穩定彈性邊界,以 Gateway API 統領北向流量,以 RBAC 與 NetworkPolicy 收緊多租安全,以可觀測性覆蓋指標/日志/追蹤,以容量管理兜住 P95 的尖峰。更重要的,是用演練塑造肌肉記憶——藍綠/金絲雀/回滾要像系好安全帶一樣自然。愿你在下一次發布時,既能縱覽全局,也能深入每一個容器的生命線;既能擁抱云端的彈性,也能敬畏狀態與數據的一致性。當你把這些原則內化為團隊的“飛行手冊”,k8s 不再是未知的黑箱,而是通往可預期、可擴展、可治理未來的可靠飛船。讓我們把每一個迭代,都變成一次優雅而克制的加速機動。

■ 我是蔣星熠Jaxonic!如果這篇文章在你的技術成長路上留下了印記

■ 👁 【關注】與我一起探索技術的無限可能,見證每一次突破

■ 👍 【點贊】為優質技術內容點亮明燈,傳遞知識的力量

■ 🔖 【收藏】將精華內容珍藏,隨時回顧技術要點

■ 💬 【評論】分享你的獨特見解,讓思維碰撞出智慧火花

■ 🗳 【投票】用你的選擇為技術社區貢獻一份力量

■ 技術路漫漫,讓我們攜手前行,在代碼的世界里摘取屬于程序員的那片星辰大海!

參考鏈接:

- Kubernetes 官方文檔:https://kubernetes.io/docs/

- Gateway API 文檔:https://gateway-api.sigs.k8s.io/

- CNCF 項目列表:https://landscape.cncf.io/

- Prometheus 指標指南:https://prometheus.io/docs/introduction/overview/

- Istio 官方文檔:https://istio.io/latest/docs/

)

)

)